Introduzione

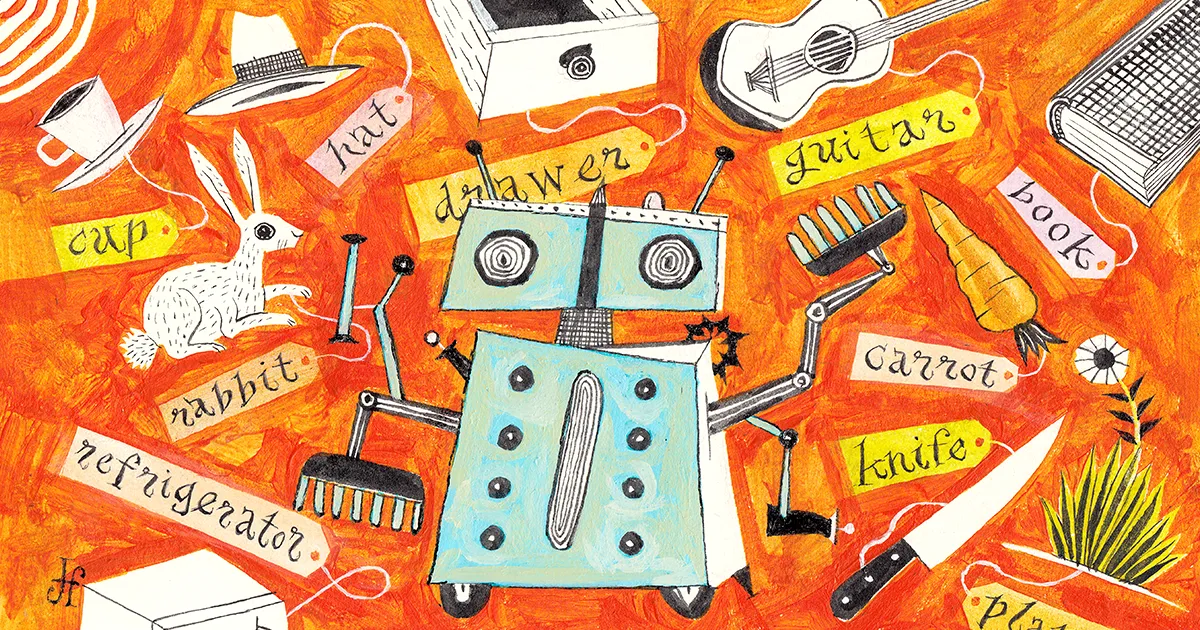

Immagina che il tuo vicino chiami per chiedere un favore: potresti per favore dare da mangiare al suo coniglio domestico delle fette di carota? Abbastanza facile, penseresti. Puoi immaginare la loro cucina, anche se non ci sei mai stato: carote in un frigorifero, un cassetto con vari coltelli. È conoscenza astratta: non sai che aspetto hanno esattamente le carote e i coltelli del tuo vicino, ma non darai un cucchiaio a un cetriolo.

I programmi di intelligenza artificiale non possono competere. Quello che ti sembra un compito facile è un'impresa enorme per gli algoritmi attuali.

Un robot addestrato dall'intelligenza artificiale può trovare un coltello e una carota specifici nascosti in una cucina familiare, ma in una cucina diversa mancheranno le abilità astratte per avere successo. "Non si generalizzano a nuovi ambienti", ha detto vincitore zhong, uno studente laureato in informatica presso l'Università di Washington. La macchina fallisce perché c'è semplicemente troppo da imparare e uno spazio troppo vasto da esplorare.

Il problema è che questi robot - e gli agenti di intelligenza artificiale in generale - non hanno una base di concetti su cui costruire. Non sanno cosa sia veramente un coltello o una carota, tanto meno come aprire un cassetto, sceglierne uno e tagliarne delle fette. Questa limitazione è dovuta in parte al fatto che molti sistemi di intelligenza artificiale avanzati vengono addestrati con un metodo chiamato apprendimento per rinforzo che è essenzialmente autoeducazione attraverso tentativi ed errori. Gli agenti di intelligenza artificiale addestrati con l'apprendimento per rinforzo possono eseguire molto bene il lavoro per cui sono stati addestrati, nell'ambiente in cui sono stati addestrati a farlo. Ma cambia il lavoro o l'ambiente e questi sistemi spesso falliranno.

Per aggirare questa limitazione, gli informatici hanno iniziato a insegnare alle macchine concetti importanti prima di liberarle. È come leggere un manuale prima di utilizzare un nuovo software: potresti provare a esplorare senza di esso, ma imparerai molto più velocemente con esso. "Gli esseri umani imparano attraverso una combinazione di azione e lettura", ha detto Karthik Narasimhan, informatico alla Princeton University. "Vogliamo che le macchine facciano lo stesso".

Nuovo lavoro di Zhong e altri mostra che l'innesco di un modello di apprendimento in questo modo può potenziare l'apprendimento in ambienti simulati, sia online che nel mondo reale con i robot. E non solo fa sì che gli algoritmi apprendano più velocemente, ma li guida verso abilità che altrimenti non imparerebbero mai. I ricercatori vogliono che questi agenti diventino generalisti, capaci di imparare qualsiasi cosa, dagli scacchi, allo shopping, alle pulizie. E man mano che le dimostrazioni diventano più pratiche, gli scienziati pensano che questo approccio potrebbe persino cambiare il modo in cui gli umani possono interagire con i robot.

"È stato un grande passo avanti", ha affermato Brian Ichter, ricercatore in robotica presso Google. "È abbastanza inimmaginabile quanto lontano sia arrivato in un anno e mezzo."

Premi scarsi

A prima vista, l'apprendimento automatico ha già avuto un notevole successo. La maggior parte dei modelli in genere utilizza insegnamento rafforzativo, in cui gli algoritmi apprendono ottenendo ricompense. Iniziano totalmente ignoranti, ma alla fine tentativi ed errori diventano tentativi e trionfi. Gli agenti di apprendimento per rinforzo possono facilmente padroneggiare giochi semplici.

Considera il videogioco Snake, in cui i giocatori controllano un serpente che cresce più a lungo mentre mangia mele digitali. Vuoi che il tuo serpente mangi il maggior numero di mele, rimanga entro i confini ed eviti di imbattersi nel suo corpo sempre più voluminoso. Tali chiari risultati giusti e sbagliati danno un feedback positivo a un agente macchina ben ricompensato, quindi un numero sufficiente di tentativi può portarlo da "noob" a High Score.

Ma supponiamo che le regole cambino. Forse lo stesso agente deve giocare su una griglia più ampia e in tre dimensioni. Mentre un giocatore umano potrebbe adattarsi rapidamente, la macchina non può, a causa di due punti deboli critici. Innanzitutto, lo spazio più ampio significa che il serpente impiega più tempo a inciampare nelle mele e l'apprendimento rallenta in modo esponenziale quando le ricompense diventano scarse. In secondo luogo, la nuova dimensione fornisce un'esperienza totalmente nuova e il rafforzamento dell'apprendimento fa fatica a generalizzare a nuove sfide.

Zhong dice che non dobbiamo accettare questi ostacoli. "Perché quando vogliamo giocare a scacchi" - un altro gioco che l'apprendimento per rinforzo ha imparato - "addestriamo un agente di apprendimento per rinforzo da zero?" Tali approcci sono inefficienti. L'agente vaga senza meta finché non si imbatte in una buona situazione, come uno scacco matto, e Zhong dice che richiede un'attenta progettazione umana per far sapere all'agente cosa significa che una situazione è buona. "Perché dobbiamo farlo quando abbiamo già così tanti libri su come giocare a scacchi?"

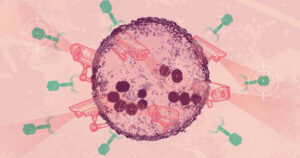

In parte, è perché le macchine hanno faticato a comprendere il linguaggio umano e decifrare le immagini in primo luogo. Affinché un robot possa completare attività basate sulla visione come trovare e affettare carote, ad esempio, deve sapere cos'è una carota: l'immagine di una cosa deve essere "radicata" in una comprensione più fondamentale di cosa sia quella cosa. Fino a poco tempo fa, non esisteva un buon modo per farlo, ma un boom nella velocità e nella portata del linguaggio e dell'elaborazione delle immagini ha reso possibili i nuovi successi.

New elaborazione del linguaggio naturale i modelli consentono alle macchine di apprendere essenzialmente il significato dietro parole e frasi - per radicarle nelle cose nel mondo - piuttosto che memorizzare semplicemente un significato semplice (e limitato) come un dizionario digitale.

La visione artificiale ha visto un'esplosione digitale simile. Intorno al 2009, ImageNet ha debuttato come database di immagini annotate per la ricerca sulla visione artificiale. Oggi ospita oltre 14 milioni di immagini di oggetti e luoghi. E programmi come quelli di OpenAI DALLA·E generare nuove immagini su comando che sembrano create dall'uomo, nonostante non abbiano un confronto esatto da cui attingere.

Mostra come solo ora le macchine abbiano accesso a dati online sufficienti per conoscere davvero il mondo, secondo Anima Anandkumar, informatico presso il California Institute of Technology e Nvidia. Ed è un segno che possono imparare dai concetti come facciamo noi e usarli per la generazione. "Siamo in un momento così bello ora", ha detto. "Perché una volta che possiamo ottenere la generazione, c'è molto di più che possiamo fare."

Gioco del sistema

Ricercatori come Zhong hanno deciso che le macchine non dovevano più intraprendere le loro esplorazioni completamente disinformate. Armati di sofisticati modelli linguistici, i ricercatori hanno potuto aggiungere una fase di pre-formazione in cui un programma apprende dalle informazioni online prima delle prove e degli errori.

Per testare l'idea, lui e i suoi colleghi hanno confrontato il pre-training con il tradizionale apprendimento per rinforzo cinque diverse impostazioni di gioco dove gli agenti macchina interpretavano i comandi del linguaggio per risolvere i problemi. Ogni ambiente simulato ha sfidato l'agente macchina in modo univoco. Uno ha chiesto all'agente di manipolare oggetti in una cucina 3D; un altro testo di lettura richiesto per apprendere una precisa sequenza di azioni per combattere i mostri. Ma l'ambientazione più complicata era un vero gioco, il 35enne NetHack, in cui l'obiettivo è navigare in un sofisticato dungeon per recuperare un amuleto.

Per le semplici impostazioni, il pre-allenamento automatizzato significava semplicemente mettere a terra i concetti importanti: questa è una carota, quello è un mostro. Per NetHack, l'agente si è allenato guardando gli umani giocare, utilizzando i playthrough caricati su Internet da giocatori umani. Questi playthrough non dovevano nemmeno essere così buoni: l'agente aveva solo bisogno di sviluppare l'intuizione su come si comportano gli umani. L'agente non doveva diventare un esperto, solo un giocatore normale. Costruirebbe l'intuizione osservando: cosa farebbe un essere umano in un dato scenario? L'agente decideva quali mosse avevano successo, formulando la propria carota e bastone.

"Attraverso la pre-formazione, formiamo buoni precedenti su come associare le descrizioni linguistiche a cose che stanno accadendo nel mondo", ha detto Zhong. L'agente giocherebbe meglio dall'inizio e imparerebbe più rapidamente durante il successivo apprendimento per rinforzo.

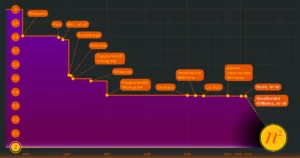

Di conseguenza, l'agente pre-addestrato ha superato quello addestrato tradizionalmente. "Otteniamo guadagni su tutta la linea in tutti e cinque questi ambienti", ha affermato Zhong. Le impostazioni più semplici hanno mostrato solo un leggero vantaggio, ma nei complicati dungeon di NetHack, l'agente ha imparato molte volte più velocemente e ha raggiunto un livello di abilità che l'approccio classico non poteva. "Potresti ottenere una performance 10x perché se non lo fai, allora non impari una buona politica", ha detto.

"Questi agenti generalisti rappresentano un grande passo avanti rispetto a ciò che fa l'apprendimento per rinforzo standard", ha affermato Anandkumar.

Il suo team pre-addestra anche gli agenti per farli apprendere più rapidamente, ottenendo progressi significativi sul videogioco più venduto al mondo, Minecraft. È noto come gioco "sandbox", nel senso che offre ai giocatori uno spazio virtualmente infinito in cui interagire e creare nuovi mondi. È inutile programmare individualmente una funzione di ricompensa per migliaia di compiti, quindi invece il modello del team ("MineDojo”) ha sviluppato la sua comprensione del gioco guardando i video di gioco con sottotitoli. Non c'è bisogno di codificare un buon comportamento.

"Stiamo ottenendo funzioni di ricompensa automatizzate", ha affermato Anandkumar. "Questo è il primo punto di riferimento con migliaia di attività e la capacità di eseguire l'apprendimento per rinforzo con attività a tempo indeterminato specificate tramite prompt di testo."

Oltre i giochi

I giochi sono stati un ottimo modo per dimostrare che i modelli di pre-formazione potevano funzionare, ma sono ancora mondi semplificati. Addestrare i robot a gestire il mondo reale, dove le possibilità sono praticamente infinite, è molto più difficile. "Abbiamo posto la domanda: c'è qualcosa nel mezzo?" disse Narasimhan. Così ha deciso di fare shopping online.

Il suo team ha creato WebShop. "È fondamentalmente come un maggiordomo dello shopping", ha detto Narasimhan. Gli utenti possono dire qualcosa come "Dammi una scarpa Nike bianca a meno di $ 100, e voglio che le recensioni affermino che sono molto comode per i più piccoli" e il programma trova e acquista la scarpa.

Come per i giochi di Zhong e Anandkumar, WebShop ha sviluppato un'intuizione allenandosi con immagini e testo, questa volta dalle pagine di Amazon. "Nel tempo, impara a comprendere la lingua e ad associarla alle azioni che deve intraprendere sul sito web."

A prima vista, un maggiordomo dello shopping potrebbe non sembrare così futuristico. Ma mentre un chatbot all'avanguardia può collegarti a una scarpa da ginnastica desiderata, interazioni come l'invio dell'ordine richiedono un set di abilità completamente diverso. E anche se i tuoi altoparlanti Alexa o Google Home da comodino possono effettuare ordini, si affidano a un software proprietario che esegue attività preordinate. WebShop naviga sul Web come fanno le persone: leggendo, digitando e facendo clic.

"È un passo avanti verso l'intelligenza generale", ha detto Narasimhan.

Introduzione

Ovviamente, far interagire i robot con il mondo reale ha le sue sfide. Considera una bottiglia, per esempio. Puoi riconoscerne uno dall'aspetto, sai che serve per immagazzinare liquidi e sai come manipolarlo con le mani. Le macchine reali potranno mai trasformare parole e immagini in una complessa intelligenza di movimento?

Narasimhan ha collaborato con Anirudha Majumdar, un robotico a Princeton, per scoprirlo. Hanno insegnato a un braccio robotico a manipolare strumenti che non aveva mai visto prima e lo hanno pre-addestrato utilizzando un linguaggio descrittivo tratto da modelli linguistici di successo. Il programma ha imparato più velocemente e ha funzionato meglio con quasi tutti gli strumenti e le azioni, rispetto ai programmi che apprendono attraverso l'esplorazione tradizionale, secondo sul risultato pubblicato sul server di prestampa arxiv.org lo scorso giugno.

Gli ingegneri hanno creato una libreria di comandi ancora più complessi nei laboratori di robotica di Google, anch'essi radicati nella pre-formazione per la creazione di contesti. "Il mondo delle possibilità che devi considerare è enorme", ha detto Karol Hausmann, un ricercatore del team di robotica di Google. "Quindi chiediamo al modello linguistico di scomporlo per noi."

Il team ha lavorato con un robot aiutante mobile, con un braccio a sette articolazioni, che hanno addestrato utilizzando le abilità linguistiche. Per ogni dato comando, come "aiutami a pulire la mia bevanda versata", il programma utilizza un modello linguistico per suggerire azioni da una libreria di 700 movimenti addestrati, come "afferrare" un tovagliolo di carta, "raccogliere" la lattina o " butta via” la lattina. E Hausman afferma di riconoscere i suoi limiti con frasi come “In realtà non sono in grado di cancellarlo. Ma posso portarti una spugna. Il team ha recentemente riportato i risultati di questo progetto, chiamato SayCan.

Un altro vantaggio di potenziare i robot con modelli linguistici è che tradurre sinonimi e parole in altre lingue diventa banale. Una persona può dire "gira", mentre un'altra dice "ruota" e il robot capisce entrambe le cose. "La cosa più folle che abbiamo provato è che capisce anche gli emoji", ha detto Fei Xiao, ricercatore presso Google.

I robot stanno imparando

SayCan è forse la dimostrazione più avanzata di apprendimento basato sul linguaggio nella robotica fino ad oggi. E i modelli linguistici e di immagine migliorano costantemente, creando tecniche di pre-formazione migliori e più complesse.

Ma Xia è attento a mitigare l'eccitazione. "Qualcuno ha detto quasi scherzosamente che abbiamo raggiunto il momento del 'robot GPT'", ha detto, riferendosi ai modelli linguistici rivoluzionari che comprendono un'ampia gamma di comandi umani. "Non ci siamo ancora arrivati, e c'è molto altro da esplorare."

Ad esempio, questi modelli possono fornire risposte errate o intraprendere azioni errate, che i ricercatori stanno cercando di capire. Anche i robot non hanno ancora imparato "personificazione”: Mentre gli esseri umani hanno un'intuizione fisica costruita sull'infanzia trascorsa a giocare con i giocattoli, i robot richiedono ancora interazioni nel mondo reale per sviluppare questo tipo di intuizione. "Per alcune impostazioni, ci sono molte dimostrazioni senza etichetta", ha detto Zhong - pensa ai database di interazioni con i videogiochi come Minecraft e NetHack. Nessun database può insegnare rapidamente ai robot il movimento intelligente.

Tuttavia, i progressi stanno avvenendo rapidamente. E più ricercatori ritengono che il risultato finale sarà una robotica più intelligente. Narasimhan traccia questa evoluzione uomo-robot dalle schede perforate alla tecnologia successiva. "Avevamo tastiere e mouse e poi touch screen", ha detto. Il linguaggio radicato è il prossimo. Parlerai al tuo computer per risposte e commissioni. "L'intero sogno di assistenti davvero capaci non si è ancora realizzato", ha detto. "Ma penso che accadrà molto presto."

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://www.quantamagazine.org/machines-learn-better-if-we-teach-them-the-basics-20230201/

- 3d

- a

- capacità

- WRI

- ABSTRACT

- Accetta

- accesso

- Secondo

- il raggiungimento

- operanti in

- Action

- azioni

- effettivamente

- adattare

- Avanzate

- Agente

- agenti

- AI

- Alexa

- Algoritmi

- Tutti

- già

- Amazon

- ed

- Un altro

- risposte

- approccio

- approcci

- ARM

- armato

- in giro

- Italia

- Associate

- Tentativi

- Automatizzata

- fondamentalmente

- Nozioni di base

- perché

- diventare

- diventa

- prima

- dietro

- essendo

- CREDIAMO

- Segno di riferimento

- bestseller

- Meglio

- fra

- Big

- tavola

- stile di vita

- Libri

- boom

- bots

- confini

- Rompere

- sfondamento

- Brian

- portare

- costruire

- costruito

- Acquista

- California

- detto

- Bandi

- Può ottenere

- capace

- Carte

- attento

- sfidato

- sfide

- il cambiamento

- chatbot

- Scacchi

- Scegli

- classico

- Pulizia

- pulire campo

- più vicino

- collaborato

- colleghi

- combinazione

- Venire

- confortevole

- rispetto

- confronto

- competere

- completamento di una

- complesso

- complicato

- computer

- Informatica

- Visione computerizzata

- concetti

- Prendere in considerazione

- costantemente

- di controllo

- potuto

- Portata

- creare

- creato

- Creazione

- critico

- Corrente

- taglio

- bordo tagliente

- dati

- Banca Dati

- banche dati

- Data

- ha debuttato

- deciso

- Decifrare

- Design

- desiderato

- Nonostante

- sviluppare

- sviluppato

- DID

- diverso

- digitale

- Dimensioni

- dimensioni

- non

- fare

- Dont

- giù

- hotel

- durante

- ogni

- facilmente

- mangiare

- bordo

- imbarcarsi

- che abilita

- Senza fine

- abbastanza

- Ambiente

- ambienti

- errore

- errori

- essenzialmente

- Anche

- alla fine

- EVER

- Ogni

- evoluzione

- di preciso

- esempio

- Eccitazione

- eseguire

- esperienza

- esperto

- esplorazione

- esplora

- Esplorazione

- in modo esponenziale

- FAIL

- fallisce

- familiare

- FAST

- più veloce

- favorire

- feedback

- combattere

- Trovate

- ricerca

- trova

- Nome

- modulo

- formulando

- Fondazione

- da

- function

- funzioni

- fondamentale

- futuristico

- Guadagni

- gioco

- Giochi

- Generale

- intelligenza generale

- generare

- ELETTRICA

- ottenere

- ottenere

- GitHub

- Dare

- dato

- dà

- Sguardo

- scopo

- buono

- laurea

- grande

- Griglia

- Terra

- innovativo

- cresce

- Guide

- Metà

- maniglia

- Mani

- accadere

- successo

- avendo

- Alta

- possesso

- Casa

- Come

- Tutorial

- HTTPS

- Enorme

- umano

- Gli esseri umani

- idea

- Immagine

- immagini

- importante

- miglioramento

- in

- In altre

- sempre più

- Individualmente

- inefficiente

- Infinito

- informazioni

- esempio

- invece

- Istituto

- Intelligence

- Intelligente

- interagire

- interazioni

- Internet

- IT

- elementi

- Lavoro

- Sapere

- conoscenze

- conosciuto

- Labs

- Dipingere

- Lingua

- Le Lingue

- superiore, se assunto singolarmente.

- Cognome

- IMPARARE

- imparato

- apprendimento

- Livello

- Biblioteca

- limitazione

- limiti

- Limitato

- LINK

- più a lungo

- Guarda

- una

- lotto

- macchina

- machine learning

- macchine

- fatto

- make

- Manuale

- molti

- carta geografica

- Mastercard

- significato

- si intende

- metodo

- forza

- milione

- Minecraft

- Mobile

- modello

- modelli

- momento

- Scopri di più

- maggior parte

- movimento

- si muove

- Navigare

- Bisogno

- New

- GENERAZIONE

- NIKE

- Nvidia

- oggetti

- ostacoli

- ONE

- online

- acquisti online

- aprire

- minimo

- ordini

- Altro

- Altri

- altrimenti

- Outperform

- proprio

- Carta

- parte

- Persone

- performance

- Forse

- persona

- Frasi

- Fisico

- posto

- Partner

- sistemazione

- Platone

- Platone Data Intelligence

- PlatoneDati

- Giocare

- giocatore

- giocatori

- gioco

- per favore

- politica

- positivo

- possibilità

- possibile

- postato

- Pratico

- in pratica

- piuttosto

- Problema

- problemi

- lavorazione

- Programma

- Programmi

- Progressi

- progetto

- proprio

- fornire

- fornisce

- Quantamagazine

- domanda

- rapidamente

- Coniglio

- a raggiunto

- Lettura

- di rose

- mondo reale

- recentemente

- riconoscere

- Basic

- Segnalati

- richiedere

- necessario

- richiede

- riparazioni

- ricercatori

- colpevole

- Risultati

- Recensioni

- Premiare

- Rewards

- robot

- robotica

- robot

- norme

- running

- Suddetto

- stesso

- Scala

- Scienze

- Scienziato

- scienziati

- schermi

- Secondo

- sembra

- Sequenza

- set

- regolazione

- impostazioni

- Shopping

- mostrare attraverso le sue creazioni

- Spettacoli

- segno

- significativa

- simile

- Un'espansione

- semplificata

- semplicemente

- situazione

- abilità

- abilità

- rallenta

- più intelligente

- sneaker

- So

- Software

- RISOLVERE

- alcuni

- qualcosa

- sofisticato

- lo spazio

- parlare

- Altoparlanti

- specificato

- velocità

- esaurito

- Standard

- inizia a

- Regione / Stato

- soggiorno

- step

- Ancora

- Tornare al suo account

- Lotte

- studente

- inciampa

- successivo

- avere successo

- di successo

- tale

- Sovralimentare

- SISTEMI DI TRATTAMENTO

- Fai

- prende

- Task

- task

- team

- tecniche

- Tecnologia

- test

- Il

- Le nozioni di base

- il mondo

- loro

- cosa

- cose

- migliaia

- tre

- Attraverso

- tempo

- volte

- a

- oggi

- pure

- strumenti

- COMPLETAMENTE

- toccare

- verso

- tradizionale

- tradizionalmente

- Treni

- allenato

- Training

- prova

- studi clinici

- TURNO

- tipicamente

- per

- capire

- e una comprensione reciproca

- capisce

- disinformato

- Università

- caricato

- us

- uso

- utenti

- vario

- Fisso

- Video

- videogiochi

- Video

- potenzialmente

- visione

- Washington

- guardare

- sito web

- WebP

- Sito web

- Che

- quale

- while

- bianca

- tutto

- interamente

- largo

- volere

- asciugandosi

- entro

- senza

- parole

- Lavora

- lavorato

- mondo

- Il mondo di

- sarebbe

- Wrong

- anno

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro

- Zhong