La crescita e i progressi dell'IA sono stati esponenziali negli ultimi anni. Rapporti statista che entro il 2024 il mercato globale dell'IA genererà entrate sbalorditive di circa 3000 miliardi di dollari, rispetto ai 126 miliardi di dollari del 2015. Tuttavia, i leader tecnologici ora ci avvertono dei vari rischi dell'IA.

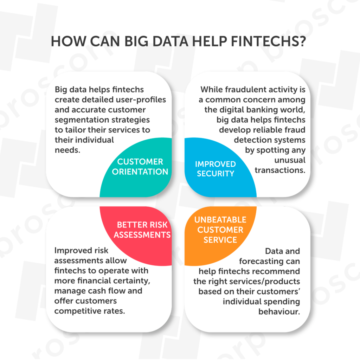

In particolare, la recente ondata di IA generativa modelli come ChatGPT ha introdotto nuove funzionalità in vari settori sensibili ai dati, come sanità, istruzione, finanziare, ecc. Questi sviluppi supportati dall'IA sono vulnerabili a causa di molte carenze dell'IA che gli agenti malintenzionati possono esporre.

Discutiamo cosa dicono gli esperti di intelligenza artificiale sui recenti sviluppi ed evidenziamo i potenziali rischi dell'IA. Toccheremo anche brevemente come questi rischi possono essere gestiti.

Leader tecnologici e le loro preoccupazioni relative ai rischi dell'IA

Geoffrey Hinton

Geoffrey Hinton, un famoso leader della tecnologia AI (e padrino di questo campo), che ha recentemente lasciato Google, ha espresso le sue preoccupazioni sul rapido sviluppo dell'IA e sui suoi potenziali pericoli. Hinton ritiene che i chatbot AI possano diventare "abbastanza spaventosi" se superano l'intelligenza umana.

Hiton dice:

“In questo momento, quello che stiamo vedendo è che cose come GPT-4 eclissano una persona nella quantità di conoscenza generale che ha, e le eclissa di gran lunga. In termini di ragionamento, non è così buono, ma fa già ragionamenti semplici. E dato il ritmo dei progressi, ci aspettiamo che le cose migliorino abbastanza velocemente. Quindi dobbiamo preoccuparcene”.

Inoltre, crede che i "cattivi attori" possano usare l'IA per "cose cattive", come consentire ai robot di avere i loro sotto-obiettivi. Nonostante le sue preoccupazioni, Hinton ritiene che l'IA possa portare benefici a breve termine, ma dovremmo anche investire molto nella sicurezza e nel controllo dell'IA.

Elon Musk

Il coinvolgimento di Elon Musk nell'intelligenza artificiale è iniziato con il suo primo investimento in DeepMind nel 2010, alla co-fondazione OpenAI e incorporando l'intelligenza artificiale nei veicoli autonomi di Tesla.

Sebbene sia entusiasta dell'IA, solleva spesso preoccupazioni sui rischi dell'IA. Musk afferma che i potenti sistemi di intelligenza artificiale possono essere più pericolosi per la civiltà delle armi nucleari. In un'intervista a Fox News nell'aprile 2023, ha detto:

“L'intelligenza artificiale è più pericolosa, ad esempio, della progettazione di aeromobili gestita male o della manutenzione della produzione o della cattiva produzione di automobili. Nel senso che ha il potenziale - tuttavia, quella probabilità può essere considerata piccola - ma non è banale e ha il potenziale di distruzione della civiltà".

Inoltre, Musk sostiene le normative governative sull'intelligenza artificiale per garantire la sicurezza da potenziali rischi, sebbene "non sia così divertente".

Metti in pausa i giganteschi esperimenti di intelligenza artificiale: una lettera aperta supportata da migliaia di esperti di intelligenza artificiale

Future of Life Institute ha pubblicato una lettera aperta il 22 marzo 2023. La lettera chiede una sospensione temporanea di sei mesi Sviluppo di sistemi di intelligenza artificiale più avanzati di GPT-4. Gli autori esprimono le loro preoccupazioni per il ritmo con cui i sistemi di IA vengono sviluppati ponendo gravi sfide socioeconomiche.

Inoltre, la lettera afferma che gli sviluppatori di intelligenza artificiale dovrebbero collaborare con i responsabili politici per documentare i sistemi di governance dell'IA. A giugno 2023, la lettera è stata firmata da oltre 31,000 sviluppatori, esperti e leader tecnologici di intelligenza artificiale. Tra i firmatari degni di nota figurano Elon Musk, Steve Wozniak (co-fondatore di Apple), Emad Mostaque (CEO, Stability AI), Yoshua Bengio (vincitore del Premio Turing) e molti altri.

Contro argomentazioni sull'arresto dello sviluppo dell'IA

Due importanti leader dell'IA, Andrew Ng e Yann LeCun, si sono opposti al divieto di sei mesi sullo sviluppo di sistemi di intelligenza artificiale avanzati e hanno considerato la pausa una cattiva idea.

Ng afferma che sebbene l'IA presenti alcuni rischi, come pregiudizi, concentrazione del potere, ecc., Ma il valore creato dall'IA in campi come l'istruzione, l'assistenza sanitaria e il coaching reattivo è enorme.

Yann LeCun afferma che la ricerca e lo sviluppo non dovrebbero essere fermati, sebbene i prodotti AI che raggiungono l'utente finale possano essere regolamentati.

Quali sono i potenziali pericoli e i rischi immediati dell'IA?

1. Trasferimento di lavoro

Gli esperti di intelligenza artificiale ritengono che i sistemi di intelligenza artificiale intelligenti possano sostituire le attività cognitive e creative. La banca d'investimento Goldman Sachs lo stima in giro 300 milioni di posti di lavoro sarà automatizzato dall'IA generativa.

Quindi, dovrebbero esserci regolamenti sullo sviluppo dell'IA in modo che non causi una grave recessione economica. Dovrebbero esserci programmi educativi per il miglioramento delle competenze e la riqualificazione dei dipendenti per affrontare questa sfida.

2. Sistemi di IA prevenuti

pregiudizi prevalente tra gli esseri umani su genere, razza o colore può inavvertitamente permeare i dati utilizzati per l'addestramento dei sistemi di intelligenza artificiale, rendendo successivamente i sistemi di intelligenza artificiale distorti.

Ad esempio, nel contesto del reclutamento di posti di lavoro, un sistema di intelligenza artificiale distorto può scartare i curriculum di persone provenienti da specifiche origini etniche, creando discriminazioni nel mercato del lavoro. In applicazione della legge, la polizia predittiva distorta potrebbe prendere di mira in modo sproporzionato quartieri o gruppi demografici specifici.

Pertanto, è essenziale disporre di una strategia dati completa che affronti i rischi dell'IA, in particolare i bias. I sistemi di intelligenza artificiale devono essere valutati e controllati frequentemente per mantenerli equi.

3. Applicazioni AI critiche per la sicurezza

Veicoli autonomi, diagnosi e cure mediche, sistemi aeronautici, controllo delle centrali nucleari, ecc., sono tutti esempi di applicazioni IA critiche per la sicurezza. Questi sistemi di intelligenza artificiale dovrebbero essere sviluppati con cautela perché anche errori minori potrebbero avere gravi conseguenze per la vita umana o per l'ambiente.

Ad esempio, il malfunzionamento del software AI chiamato Sistema di aumento delle caratteristiche di manovra (MCAS) è attribuito in parte allo schianto dei due Boeing 737 MAX, prima nell'ottobre 2018 e poi nel marzo 2019. Purtroppo, i due incidenti hanno ucciso 346 persone.

Come possiamo superare i rischi dei sistemi di intelligenza artificiale? – Sviluppo AI responsabile e conformità alle normative

AI responsabile (RAI) significa sviluppare e implementare sistemi di intelligenza artificiale equi, responsabili, trasparenti e sicuri che garantiscano la privacy e seguano le normative legali e le norme sociali. L'implementazione della RAI può essere complessa dato l'ampio e rapido sviluppo dei sistemi di IA.

Tuttavia, le grandi aziende tecnologiche hanno sviluppato framework RAI, come ad esempio:

-

L'intelligenza artificiale responsabile di Microsoft

-

Principi di intelligenza artificiale di Google

-

L'AI affidabile di IBM

I laboratori di intelligenza artificiale di tutto il mondo possono trarre ispirazione da questi principi o sviluppare i propri framework di intelligenza artificiale responsabili per creare sistemi di intelligenza artificiale affidabili.

Conformità normativa AI

Poiché i dati sono parte integrante dei sistemi di intelligenza artificiale, le organizzazioni e i laboratori basati sull'intelligenza artificiale devono rispettare le seguenti normative per garantire la sicurezza, la privacy e la protezione dei dati.

-

GDPR (Regolamento generale sulla protezione dei dati) – un quadro di protezione dei dati da parte dell'UE.

-

CCPA (legge sulla privacy dei consumatori della California) – uno statuto dello stato della California per i diritti alla privacy e la protezione dei consumatori.

-

HIPAA (legge sulla portabilità e la responsabilità dell'assicurazione sanitaria) – una legislazione statunitense che salvaguarda i dati medici dei pazienti.

-

Legge dell'UE sull'IAe Linee guida etiche per un'IA affidabile – un regolamento sull'IA della Commissione europea.

Esistono varie leggi regionali e locali emanate da diversi paesi per proteggere i propri cittadini. Le organizzazioni che non riescono a garantire la conformità normativa sui dati possono comportare gravi sanzioni. Ad esempio, il GDPR ha fissato una multa di 20 milioni di euro o il 4% dell'utile annuo per violazioni gravi quali trattamento illecito dei dati, consenso non comprovato dei dati, violazione dei diritti degli interessati o trasferimento dei dati non protetto a un'entità internazionale.

Sviluppo e normative dell'IA: presente e futuro

Con il passare dei mesi, i progressi dell'IA raggiungono livelli senza precedenti. Tuttavia, i regolamenti e i quadri di governance relativi all'IA sono in ritardo. Devono essere più robusti e specifici.

I leader tecnologici e gli sviluppatori di intelligenza artificiale hanno lanciato allarmi sui rischi dell'IA se non adeguatamente regolamentati. La ricerca e lo sviluppo nell'IA possono portare ulteriore valore in molti settori, ma è chiaro che un'attenta regolamentazione è ormai imperativa.

Link: https://www.unite.ai/tech-leaders-highlighting-the-risks-of-ai-the-urgency-of-robust-ai-regulation/?utm_source=pocket_saves

Fonte: https://www.unite.ai

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- EVM Finance. Interfaccia unificata per la finanza decentralizzata. Accedi qui.

- Quantum Media Group. IR/PR amplificato. Accedi qui.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Fonte: https://www.fintechnews.org/tech-leaders-highlighting-the-risks-of-ai-the-urgency-of-robust-ai-regulation/

- :ha

- :È

- :non

- 000

- 2015

- 2018

- 2019

- 2023

- 2024

- 31

- 7

- a

- WRI

- responsabilità

- responsabile

- operanti in

- Legge

- indirizzi

- adeguatamente

- Avanzate

- avanzamenti

- agenti

- AI

- Governance dell'IA

- aereo

- Tutti

- Consentire

- già

- anche

- Sebbene il

- tra

- quantità

- an

- ed

- annuale

- Apple

- applicazioni

- Aprile

- SONO

- argomenti

- in giro

- AS

- sottoposto a revisione contabile

- gli autori

- Automatizzata

- autonomo

- veicoli autonomi

- aviazione

- Backed

- sfondi

- Vasca

- Bandire

- Banca

- bbc

- BE

- perché

- diventare

- stato

- ha iniziato

- essendo

- CREDIAMO

- crede

- vantaggi

- Meglio

- pregiudizio

- parziale

- Big

- grande tecnologia

- Miliardo

- Boeing

- brevemente

- portare

- ampio

- ma

- by

- CA

- California

- Bandi

- Materiale

- funzionalità

- auto

- attento

- Causare

- cautamente

- CDC

- ceo

- Challenge

- sfide

- caratteristiche

- chatbots

- ChatGPT

- cittadini

- Civilization

- pulire campo

- Co-fondatore

- istruire

- conoscitivo

- colore

- commissione

- Aziende

- rispetto

- complesso

- conformità

- ottemperare

- componente

- globale

- concentrazione

- preoccupazioni

- consenso

- Conseguenze

- considerato

- Consumer

- privacy dei consumatori

- Protezione del consumatore

- contesto

- di controllo

- potuto

- paesi

- Crash

- creato

- Creazione

- Creative

- Pericoloso

- pericoli

- dati

- elaborazione dati

- protezione dati

- la sicurezza dei dati

- strategia di dati

- affare

- DeepMind

- demografico

- distribuzione

- Design

- Nonostante

- sviluppare

- sviluppato

- sviluppatori

- in via di sviluppo

- Mercato

- sviluppi

- diverso

- discutere

- do

- documento

- documento ai

- effettua

- non

- DISCESA

- dovuto

- Presto

- EC

- Economico

- crisi economica

- Istruzione

- educativo

- Elon

- Elon Musk

- dipendenti

- garantire

- entusiasta

- entità

- Ambiente

- errori

- essential

- stime

- eccetera

- etica

- EU

- Europa

- europeo

- Commissione europea

- valutato

- Anche

- Ogni

- Esempi

- attenderti

- esperimenti

- esperti

- gli esperti credono

- esponenziale

- esprimere

- FAIL

- fiera

- famoso

- FAST

- pochi

- campo

- campi

- sottile

- Nome

- seguire

- i seguenti

- Nel

- Forbes

- Contesto

- quadri

- frequentemente

- da

- ti divertirai

- ulteriormente

- GDPR

- Sesso

- Generale

- dati generali

- Regolamento generale sulla protezione dei dati

- generare

- generativo

- AI generativa

- ottenere

- gigante

- dato

- globali

- globo

- goldman

- Goldman Sachs

- buono

- la governance

- Enti Pubblici

- Gruppo

- Crescita

- linee guida

- zoppicante

- Avere

- he

- Salute e benessere

- assicurazione sanitaria

- assistenza sanitaria

- pesantemente

- altezza

- Highlight

- mettendo in evidenza

- il suo

- Come

- Tuttavia

- HTTPS

- umano

- intelligenza umana

- IBM

- idea

- if

- immediato

- imperativo

- Implementazione

- in

- includere

- incorporando

- individui

- Ispirazione

- esempio

- Istituto

- assicurazione

- integrale

- Intelligence

- Intelligente

- Internazionale

- Colloquio

- ai miglioramenti

- introdotto

- Investire

- investimento

- coinvolgimento

- IT

- SUO

- Lavoro

- jpg

- giugno

- mantenere

- conoscenze

- Labs

- in ritardo di sviluppo

- Legislazione

- leader

- capi

- a sinistra

- Legale

- Legislazione

- lettera

- Vita

- piace

- locale

- Lunghi

- manutenzione

- make

- Fare

- gestito

- molti

- Marzo

- Rappresentanza

- max

- max-width

- Maggio..

- si intende

- medicale

- dati medici

- Microsoft

- milione

- minore

- modelli

- Mese

- mese

- Scopri di più

- Muschio

- devono obbligatoriamente:

- Bisogno

- New

- notevole

- adesso

- nucleare

- Energia nucleare

- ottobre

- of

- on

- ONE

- aprire

- opposto

- or

- organizzazioni

- ancora

- Superare

- proprio

- Pace

- parte

- particolarmente

- Di passaggio

- passato

- pausa

- Persone

- persona

- Platone

- Platone Data Intelligence

- PlatoneDati

- polizia

- politici

- pone

- potenziale

- energia

- potente

- presenti

- atleta

- principi

- Privacy

- premio

- lavorazione

- Produzione

- Prodotti

- Programmi

- Progressi

- prominente

- protegge

- protezione

- pubblicato

- Gara

- solleva

- veloce

- tasso

- raggiungere

- raggiungendo

- recente

- recentemente

- reclutamento

- considerare

- regionale

- regolamentati

- Regolamento

- normativa

- normativo

- Conformità normativa

- relazionato

- parente

- sostituire

- riparazioni

- ricerca e sviluppo

- responsabile

- di risposta

- colpevole

- Le vendite

- destra

- diritti

- rischi

- robot

- robusto

- s

- Sachs

- garanzie

- Sicurezza

- Suddetto

- dire

- detto

- dice

- Settori

- sicuro

- problemi di

- vedendo

- senso

- grave

- set

- grave

- a breve scadenza

- carenze

- dovrebbero

- firmatari

- firmato

- Un'espansione

- SIX

- Sei mesi

- piccole

- So

- sociale

- socio-economico

- Software

- alcuni

- specifico

- Stabilità

- Regione / Stato

- stati

- Steve

- Steve Wozniak

- fermato

- Strategia

- Successivamente

- tale

- supporti

- superare

- sistema

- SISTEMI DI TRATTAMENTO

- Fai

- Target

- task

- Tech

- tech

- temporaneo

- condizioni

- di

- che

- Il

- loro

- Li

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cose

- questo

- a

- toccare

- Training

- trasferimento

- trasparente

- trattamento

- enorme

- di fiducia

- affidabili sul mercato

- Turing

- seconda

- noi

- inaudito

- urgenza

- us

- uso

- utilizzato

- APPREZZIAMO

- vario

- Veicoli

- VIOLAZIONE

- Vulnerabile

- identificazione dei warning

- Wave

- Modo..

- we

- Armi

- Che

- quale

- OMS

- volere

- vincitore

- con

- Lavora

- preoccuparsi

- anni

- youtube

- zefiro