Meta ha introdotto il Segment Anything Model, che mira a stabilire un nuovo standard per la "segmentazione degli oggetti" basata sulla visione artificiale, la capacità dei computer di comprendere la differenza tra i singoli oggetti in un'immagine o in un video. La segmentazione sarà la chiave per rendere l'AR veramente utile, consentendo una comprensione completa del mondo che circonda l'utente.

La segmentazione degli oggetti è il processo di identificazione e separazione degli oggetti in un'immagine o in un video. Con l'aiuto dell'IA, questo processo può essere automatizzato, rendendo possibile l'identificazione e l'isolamento degli oggetti in tempo reale. Questa tecnologia sarà fondamentale per creare un'esperienza AR più utile, dando al sistema la consapevolezza di vari oggetti nel mondo intorno all'utente.

La sfida

Immagina, ad esempio, di indossare un paio di occhiali AR e di voler avere due monitor virtuali mobili a sinistra ea destra del tuo monitor reale. A meno che tu non dica manualmente al sistema dove si trova il tuo monitor reale, deve essere in grado di capire come appare un monitor in modo che quando vede il tuo monitor possa posizionare i monitor virtuali di conseguenza.

Ma i monitor sono disponibili in tutte le forme, dimensioni e colori. A volte i riflessi o gli oggetti occlusi rendono ancora più difficile il riconoscimento da parte di un sistema di visione artificiale.

Avere un sistema di segmentazione veloce e affidabile in grado di identificare ogni oggetto nella stanza intorno a te (come il tuo monitor) sarà la chiave per sbloccare tonnellate di casi d'uso AR in modo che la tecnologia possa essere veramente utile.

La segmentazione degli oggetti basata sulla visione artificiale è stata un'area di ricerca in corso da molti anni, ma uno dei problemi chiave è che per aiutare i computer a capire cosa stanno guardando, è necessario addestrare un modello di intelligenza artificiale dandogli molto immagini da cui imparare.

Tali modelli possono essere abbastanza efficaci nell'identificare gli oggetti su cui sono stati addestrati, ma se faranno fatica su oggetti che non hanno mai visto prima. Ciò significa che una delle maggiori sfide per la segmentazione degli oggetti è semplicemente disporre di un insieme di immagini sufficientemente ampio da cui i sistemi possano apprendere, ma raccogliere tali immagini e annotarle in un modo che le renda utili per l'addestramento non è un compito da poco.

SAM Io sono

Meta ha recentemente pubblicato un lavoro su un nuovo progetto chiamato the Segmenta qualsiasi modello (SAM). È sia un modello di segmentazione che un enorme set di immagini di formazione che l'azienda sta rilasciando affinché altri possano basarsi.

Il progetto mira a ridurre la necessità di competenze di modellazione specifiche per attività. SAM è un modello di segmentazione generale in grado di identificare qualsiasi oggetto in qualsiasi immagine o video, anche per oggetti e tipi di immagine che non ha visto durante l'addestramento.

SAM consente la segmentazione sia automatica che interattiva, consentendogli di identificare i singoli oggetti in una scena con semplici input da parte dell'utente. SAM può essere "richiesta" con clic, caselle e altri prompt, dando agli utenti il controllo su ciò che il sistema sta tentando di identificare in un dato momento.

È facile vedere come questo suggerimento basato su punti potrebbe funzionare alla grande se abbinato al tracciamento oculare su un visore AR. In effetti questo è esattamente uno dei casi d'uso che Meta ha dimostrato con il sistema:

Ecco un altro esempio di utilizzo di SAM su video in prima persona catturati da Gli occhiali Project Aria di Meta:

Puoi prova subito SAM nel tuo browser.

Come SAM sa così tanto

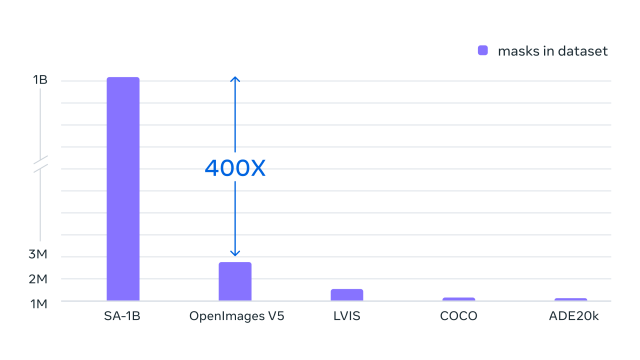

Parte delle straordinarie capacità di SAM derivano dai suoi dati di addestramento che contengono ben 10 milioni di immagini e 1 miliardo di forme di oggetti identificati. È molto più completo dei set di dati contemporanei, secondo Meta, dando a SAM molta più esperienza nel processo di apprendimento e consentendogli di segmentare un'ampia gamma di oggetti.

Meta chiama il set di dati SAM SA-1B e la società lo è rilasciando l'intero set per altri ricercatori su cui basarsi.

Meta spera che questo lavoro sulla segmentazione tempestiva e il rilascio di questo enorme set di dati di addestramento accelereranno la ricerca sulla comprensione di immagini e video. L'azienda prevede che il modello SAM possa essere utilizzato come componente in sistemi più grandi, consentendo applicazioni versatili in aree come AR, creazione di contenuti, domini scientifici e sistemi di IA generali.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://www.roadtovr.com/meta-shows-progress-ai-segmentation-ar-sam-model-sa-1b/

- :È

- $10 milioni

- 1

- 10

- a

- abilità

- capacità

- capace

- accelerare

- Secondo

- di conseguenza

- AI

- mira

- Tutti

- Consentire

- consente

- ed

- Un altro

- applicazioni

- AR

- ar esperienza

- Occhiali AR

- Cuffie AR

- RISERVATA

- aree

- aria

- in giro

- AS

- At

- il tentativo

- Automatizzata

- Automatico

- consapevolezza

- bar

- basato

- BE

- prima

- essendo

- fra

- Maggiore

- Miliardo

- scatole

- ampio

- del browser

- costruire

- by

- detto

- Bandi

- Materiale

- sfide

- Raccolta

- Venire

- azienda

- componente

- globale

- computer

- contiene

- musica

- contenuto

- creazione di contenuti

- di controllo

- potuto

- accoppiato

- Creazione

- creazione

- critico

- dati

- dataset

- dimostrato

- differenza

- domini

- durante

- ogni

- Efficace

- consentendo

- abbastanza

- Intero

- Anche

- di preciso

- esempio

- aspetta

- esperienza

- competenza

- FAST

- galleggiante

- Nel

- da

- Generale

- dato

- Dare

- andando

- grande

- Avere

- avendo

- Auricolare

- Aiuto

- spera

- Come

- HTTPS

- i

- identificato

- identificare

- identificazione

- Immagine

- immagini

- impressionante

- in

- individuale

- esempio

- interattivo

- introdotto

- sicurezza

- IT

- SUO

- Le

- grandi

- superiore, se assunto singolarmente.

- IMPARARE

- apprendimento

- piace

- cerca

- SEMBRA

- make

- FA

- Fare

- manualmente

- molti

- massiccio

- max-width

- si intende

- Meta

- milione

- modello

- modelli

- momento

- Monitorare

- monitor

- Scopri di più

- Bisogno

- rete

- New

- oggetto

- oggetti

- of

- on

- ONE

- in corso

- minimo

- Altro

- Altri

- posto

- Platone

- Platone Data Intelligence

- PlatoneDati

- possibile

- processi

- Progressi

- progetto

- pubblicato

- gamma

- di rose

- tempo reale

- recentemente

- riconoscere

- ridurre

- rilasciare

- affidabile

- riparazioni

- ricercatori

- Prenotazione sale

- Sam

- scena

- scientifico

- vede

- segmento

- segmentazione

- separazione

- set

- forme

- Condividi

- Spettacoli

- semplicemente

- Dimensioni

- piccole

- So

- Lotta

- sistema

- SISTEMI DI TRATTAMENTO

- Task

- Tech

- Tecnologia

- che

- Il

- il mondo

- Li

- a

- tonnellate

- Treni

- allenato

- Training

- Tipi di

- capire

- e una comprensione reciproca

- sblocco

- casi d'uso

- Utente

- utenti

- vario

- versatile

- versione

- Video

- virtuale

- Modo..

- Che

- quale

- volere

- con

- Lavora

- mondo

- anni

- Tu

- Trasferimento da aeroporto a Sharm

- te stesso

- zefiro

![[Industry Direct] Festeggiamo 8 anni di Pimax con un'offerta speciale sulle nostre migliori cuffie finora | Strada verso la realtà virtuale [Industry Direct] Festeggiamo 8 anni di Pimax con un'offerta speciale sulle nostre migliori cuffie finora | Strada verso la realtà virtuale](https://platoblockchain.com/wp-content/uploads/2023/12/industry-direct-celebrating-8-years-of-pimax-with-a-special-offer-on-our-best-headset-yet-road-to-vr-300x175.png)