I recenti modelli di linguaggi di grandi dimensioni (LLM) hanno consentito enormi progressi nella comprensione del linguaggio naturale. Tuttavia, sono inclini a generare spiegazioni sicure ma prive di senso, il che rappresenta un ostacolo significativo alla creazione di fiducia con gli utenti. In questo post, mostriamo come incorporare il feedback umano sulle catene di ragionamento errate per il ragionamento multi-hop per migliorare le prestazioni su queste attività. Invece di raccogliere le catene di ragionamento da zero chiedendo agli umani, apprendiamo invece dal ricco feedback umano sulle catene di ragionamento generate dal modello utilizzando le capacità di suggerimento dei LLM. Raccogliamo due di questi set di dati di feedback umano sotto forma di (correzione, spiegazione, tipo di errore) per i set di dati StrategyQA e Sports Understanding e valutiamo diversi algoritmi comuni per imparare da tale feedback. I nostri metodi proposti si comportano in modo competitivo rispetto ai suggerimenti della catena di pensiero utilizzando il Flan-T5 di base, e il nostro è migliore nel giudicare la correttezza della propria risposta.

Panoramica della soluzione

Con l'inizio dei modelli di linguaggio di grandi dimensioni, il campo ha visto enormi progressi su vari benchmark di elaborazione del linguaggio naturale (NLP). Tra questi, i progressi sono stati sorprendenti su compiti relativamente più semplici come risposte a domande brevi o fattuali, rispetto a compiti più difficili che richiedono ragionamenti come risposte a domande multi-hop. Le prestazioni di alcune attività che utilizzano gli LLM possono essere simili a ipotesi casuali su scale più piccole, ma migliorano significativamente su scale più grandi. Nonostante ciò, le capacità di suggerimento degli LLM hanno il potenziale per fornire alcuni fatti rilevanti necessari per rispondere alla domanda.

Tuttavia, tali modelli potrebbero non generare in modo affidabile catene di ragionamento o spiegazioni corrette. Quelle spiegazioni sicure ma prive di senso sono ancora più diffuse quando gli LLM vengono addestrati utilizzando l'apprendimento per rinforzo dal feedback umano (RLHF), dove può verificarsi l'hacking della ricompensa.

Motivati da questo, proviamo ad affrontare la seguente domanda di ricerca: possiamo migliorare il ragionamento degli LLM imparando dal feedback umano sulle catene di ragionamento generate dal modello? La figura seguente fornisce una panoramica del nostro approccio: per prima cosa chiediamo al modello di generare catene di ragionamento per domande multi-hop, quindi raccogliamo diversi feedback umani su queste catene per la diagnosi e proponiamo algoritmi di addestramento per imparare dai dati raccolti.

Raccogliamo diversi feedback umani su due set di dati di ragionamento multi-hop, StrategyQA e Sports Understanding da BigBench. Per ogni domanda e catena di ragionamento generata dal modello, raccogliamo la catena di ragionamento corretta, il tipo di errore nella catena di ragionamento generata dal modello e una descrizione (in linguaggio naturale) del motivo per cui tale errore è presentato nella catena di ragionamento fornita. Il set di dati finale contiene feedback per 1,565 campioni da StrategyQA e 796 esempi per Sports Understanding.

Proponiamo più algoritmi di addestramento per imparare dai feedback raccolti. In primo luogo, proponiamo una variante dell'autoconsistenza nel suggerimento della catena di pensiero, considerandone una variante ponderata che può essere appresa dal feedback. In secondo luogo, proponiamo il raffinamento iterativo, in cui raffiniamo iterativamente la catena di ragionamento generata dal modello finché non è corretta. Dimostriamo empiricamente sui due set di dati che la messa a punto di un LLM, vale a dire Flan-T5 utilizzando gli algoritmi proposti, si comporta in modo comparabile alla linea di base di apprendimento nel contesto. Ancora più importante, dimostriamo che il modello messo a punto è migliore nel giudicare se la propria risposta è corretta rispetto al modello base Flan-T5.

Raccolta dei dati

In questa sezione, descriviamo i dettagli del feedback che abbiamo raccolto e il protocollo di annotazione seguito durante la raccolta dei dati. Abbiamo raccolto feedback per le generazioni di modelli sulla base di due set di dati basati sul ragionamento: StrategyQA e Sports Understanding da BigBench. Abbiamo utilizzato GPT-J per generare la risposta per StrategyQA e Flan-T5 per generare la risposta per il set di dati Sports Understanding. In ogni caso, al modello sono stati suggeriti k esempi contestuali contenenti domanda, risposta e spiegazione, seguiti dalla domanda del test.

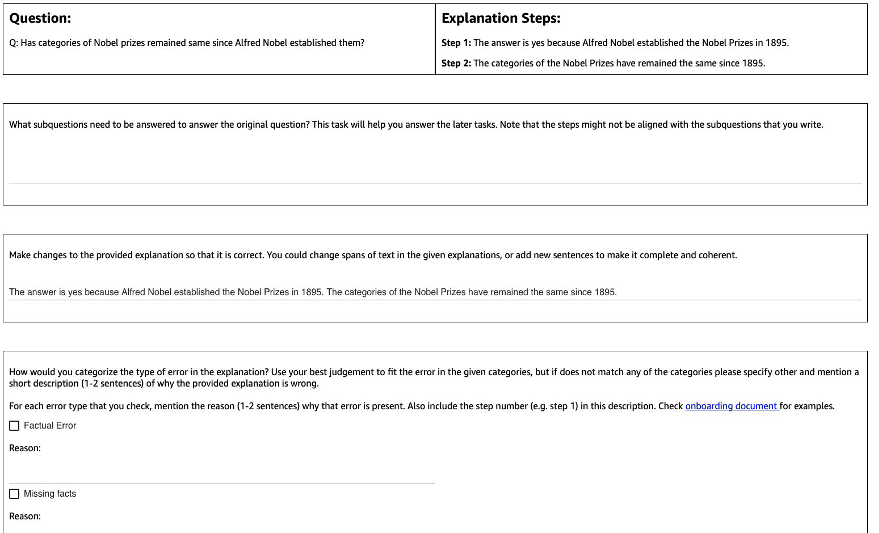

La figura seguente mostra l'interfaccia che abbiamo utilizzato. Agli annotatori viene data la domanda, la risposta generata dal modello e la spiegazione suddivisa in passaggi.

Per ogni domanda, abbiamo raccolto i seguenti feedback:

- Sottodomande – Gli annotatori scompongono la domanda originale in sottodomande più semplici necessarie per rispondere alla domanda originale. Questa attività è stata aggiunta dopo un progetto pilota in cui abbiamo scoperto che l'aggiunta di questa attività aiuta a preparare gli annotatori e a migliorare la qualità del resto delle attività.

- Correzione – Agli annotatori viene fornita una casella di testo in formato libero precompilata con la risposta e la spiegazione generate dal modello e viene chiesto di modificarla per ottenere la risposta e la spiegazione corrette.

- Tipo di errore – Tra i tipi di errore più comuni che abbiamo riscontrato nelle generazioni del modello (Factual Error, Missing Facts, Irrelevant Facts e Logical Inconsistency), agli annotatori è stato chiesto di scegliere uno o più tipi di errore che si applicano alla risposta e alla spiegazione fornite.

- Descrizione dell'errore – Gli annotatori sono stati istruiti non solo a classificare gli errori, ma anche a fornire una giustificazione completa per la loro categorizzazione, inclusa l'individuazione del passaggio esatto in cui si è verificato l'errore e come si applica alla risposta e alla spiegazione fornita.

Abbiamo usato Amazon SageMaker Ground Truth Plus nella nostra raccolta di dati. La raccolta dei dati è avvenuta in più turni. Per prima cosa abbiamo condotto due piccoli progetti pilota rispettivamente di 30 e 200 esempi, dopodiché il team di annotatori ha ricevuto un feedback dettagliato sull'annotazione. Abbiamo quindi condotto la raccolta dei dati su due batch per StrategyQA e su un batch per Sports Understanding, fornendo feedback periodici per tutto il tempo: un totale di 10 annotatori hanno lavorato all'attività per un periodo di quasi 1 mese.

Abbiamo raccolto feedback su un totale di 1,565 esempi per StrategyQA e 796 esempi per Sports Understanding. La tabella seguente illustra la percentuale di esempi privi di errori nella generazione del modello e la percentuale di esempi che contenevano un tipo di errore specifico. Vale la pena notare che alcuni esempi possono avere più di un tipo di errore.

| Tipo di errore | StrategiaQA | Comprensione sportiva |

| Nessuna | 17.6% | 31.28% |

| Errore di fatto | 27.6% | 38.1% |

| Fatti mancanti | 50.4% | 46.1% |

| Fatti irrilevanti | 14.6% | 3.9% |

| Incoerenza Logica | 11.2% | 5.2% |

Algoritmi di apprendimento

Per ogni domanda qe risposta e spiegazione generate dal modello m, abbiamo raccolto i seguenti feedback: risposta corretta e spiegazione c, tipo di errore presente in m (denotato da t) e la descrizione dell'errore d, come descritto nella sezione precedente.

Abbiamo utilizzato i seguenti metodi:

- Apprendimento multitasking – Una semplice linea di base per imparare dai diversi feedback disponibili è trattare ciascuno di essi come un'attività separata. Più concretamente, perfezioniamo Flan-T5 (text to text) con l'obiettivo massimizzare p(c|q) + p(t|q, m) + p(d|q, m). Per ogni termine nell'obiettivo, utilizziamo un'istruzione separata appropriata per l'attività (ad esempio, "Prevedi l'errore nella risposta data"). Convertiamo anche la variabile categoriale t in una frase in linguaggio naturale. Durante l'inferenza, usiamo l'istruzione per il termine p(c|q) ("Prevedi la risposta corretta per la domanda data") per generare la risposta per la domanda del test.

- Autoconsistenza ponderata – Motivati dal successo dell'autocoerenza nel suggerimento della catena di pensiero, ne proponiamo una variante ponderata. Invece di trattare ogni spiegazione campionata dal modello come corretta e considerare il voto aggregato, consideriamo invece prima se la spiegazione è corretta e poi aggreghiamo di conseguenza. Per prima cosa ottimizziamo Flan-T5 con lo stesso obiettivo dell'apprendimento multitasking. Durante l'inferenza, data una domanda di prova q, campioniamo più risposte possibili con le istruzioni per p(c|q)): a1, a2, .., an. Per ogni risposta campionata ai, usiamo l'istruzione per il termine p(t|q,m) ("Prevedi errore nella risposta data") per identificare se contiene errori ti = argmax p(t|q, a_i). Ogni risposta ai viene assegnato un peso di 1 se è corretto, altrimenti viene assegnato un peso inferiore a 1 (tunable hyperparameter). La risposta finale si ottiene considerando un voto ponderato su tutte le risposte a1 a an.

- Perfezionamento iterativo – Nei metodi proposti in precedenza, il modello genera direttamente la risposta corretta c condizionato dalla domanda q. Qui proponiamo di affinare la risposta generata dal modello m ottenere la risposta corretta a una data domanda. Più specificamente, per prima cosa ottimizziamo Flan-T5 (testo su testo con l'obiettivo) con massimizzare p(t; c|q, m), Dove ; denota la concatenazione (tipo di errore t seguito dalla risposta corretta c). Un modo per visualizzare questo obiettivo è che il modello venga prima addestrato per identificare l'errore in una data generazione me quindi per rimuovere l'errore per ottenere la risposta corretta c. Durante l'inferenza, possiamo utilizzare il modello in modo iterativo finché non genera la risposta corretta, data una domanda di prova q, otteniamo prima la generazione del modello iniziale m (utilizzando Flan-T5 pre-addestrato). Quindi generiamo in modo iterativo il tipo di errore ti e la potenziale risposta corretta ci fino a quando ti = nessun errore (in pratica impostiamo un numero massimo di iterazioni ad un iperparametro), nel qual caso la risposta finale corretta sarà CI-1 (ottenuto da p(ti; ci | q, ci-1)).

Risultati

Per entrambi i set di dati, confrontiamo tutti gli algoritmi di apprendimento proposti con la baseline di apprendimento contestuale. Tutti i modelli vengono valutati sul set di sviluppo di StrategyQA e Sports Understanding. La tabella seguente mostra i risultati.

| metodo | StrategiaQA | Comprensione sportiva |

| Flan-T5 Apprendimento nel contesto della catena di pensiero a 4 scatti | 67.39 ± 2.6% | 58.5% |

| Apprendimento multitasking | 66.22 ± 0.7% | 54.3 ± 2.1% |

| Autocoerenza ponderata | 61.13 ± 1.5% | 51.3 ± 1.9% |

| Perfezionamento iterativo | 61.85 ± 3.3% | 57.0 ± 2.5% |

Come osservato, alcuni metodi hanno prestazioni paragonabili alla linea di base dell'apprendimento contestuale (multitasking per StrategyQA e perfezionamento iterativo per Sports Understanding), che dimostra il potenziale di raccogliere feedback continui dagli esseri umani sugli output del modello e utilizzarlo per migliorare i modelli linguistici. Questo è diverso dal lavoro recente come RLHF, dove il feedback è limitato a categorico e solitamente binario.

Come mostrato nella tabella seguente, indaghiamo su come i modelli adattati con feedback umano sugli errori di ragionamento possono aiutare a migliorare la calibrazione o la consapevolezza di spiegazioni sicuramente sbagliate. Questo viene valutato richiedendo al modello di prevedere se la sua generazione contiene errori.

| metodo | Correzione degli errori | StrategiaQA |

| Flan-T5 Apprendimento nel contesto della catena di pensiero a 4 scatti | Non | 30.17% |

| Modello ottimizzato multitasking | Sì | 73.98% |

Più in dettaglio, richiediamo al modello linguistico la propria risposta generata e la catena di ragionamento (per la quale abbiamo raccolto il feedback), quindi lo richiediamo nuovamente per prevedere l'errore nella generazione. Utilizziamo le istruzioni appropriate per l'attività ("Identificare l'errore nella risposta"). Il modello riceve un punteggio corretto se prevede "nessun errore" o "corretto" nella generazione se gli annotatori hanno etichettato l'esempio come privo di errori o se prevede uno qualsiasi dei tipi di errore nella generazione (insieme a "errato" o " errato") quando gli annotatori lo hanno etichettato come contenente un errore. Si noti che non valutiamo la capacità del modello di identificare correttamente il tipo di errore, ma piuttosto se è presente un errore. La valutazione viene eseguita su un set di 173 esempi aggiuntivi dal set di sviluppo StrategyQA che sono stati raccolti, che non vengono visualizzati durante la messa a punto. Quattro esempi di questi sono riservati per richiedere il modello di lingua (prima riga nella tabella precedente).

Si noti che non mostriamo il risultato della linea di base 0-shot perché il modello non è in grado di generare risposte utili. Osserviamo che l'utilizzo del feedback umano per la correzione degli errori sulle catene di ragionamento può migliorare la previsione del modello se commette errori o meno, il che può migliorare la consapevolezza o la calibrazione delle spiegazioni sbagliate.

Conclusione

In questo post, abbiamo mostrato come curare i set di dati di feedback umano con correzioni di errori granulari, che è un modo alternativo per migliorare le capacità di ragionamento degli LLM. I risultati sperimentali confermano che il feedback umano sugli errori di ragionamento può migliorare le prestazioni e la calibrazione su domande multi-hop impegnative.

Se stai cercando un feedback umano per migliorare i tuoi modelli linguistici di grandi dimensioni, visita Etichettatura dei dati di Amazon SageMaker e la console Ground Truth Plus.

Informazioni sugli autori

Erran Li è il responsabile della scienza applicata presso i servizi humain-in-the-loop, AWS AI, Amazon. I suoi interessi di ricerca sono il deep learning 3D e l'apprendimento della rappresentazione della visione e del linguaggio. In precedenza è stato scienziato senior presso Alexa AI, capo del machine learning presso Scale AI e capo scienziato presso Pony.ai. Prima di allora, era con il team di percezione di Uber ATG e il team della piattaforma di apprendimento automatico di Uber lavorando sull'apprendimento automatico per la guida autonoma, sui sistemi di apprendimento automatico e sulle iniziative strategiche dell'IA. Ha iniziato la sua carriera presso i Bell Labs ed è stato professore a contratto presso la Columbia University. Ha co-insegnato tutorial presso ICML'17 e ICCV'19 e ha co-organizzato diversi workshop presso NeurIPS, ICML, CVPR, ICCV sull'apprendimento automatico per la guida autonoma, la visione 3D e la robotica, i sistemi di apprendimento automatico e l'apprendimento automatico avverso. Ha un dottorato di ricerca in informatica presso la Cornell University. È ACM Fellow e IEEE Fellow.

Erran Li è il responsabile della scienza applicata presso i servizi humain-in-the-loop, AWS AI, Amazon. I suoi interessi di ricerca sono il deep learning 3D e l'apprendimento della rappresentazione della visione e del linguaggio. In precedenza è stato scienziato senior presso Alexa AI, capo del machine learning presso Scale AI e capo scienziato presso Pony.ai. Prima di allora, era con il team di percezione di Uber ATG e il team della piattaforma di apprendimento automatico di Uber lavorando sull'apprendimento automatico per la guida autonoma, sui sistemi di apprendimento automatico e sulle iniziative strategiche dell'IA. Ha iniziato la sua carriera presso i Bell Labs ed è stato professore a contratto presso la Columbia University. Ha co-insegnato tutorial presso ICML'17 e ICCV'19 e ha co-organizzato diversi workshop presso NeurIPS, ICML, CVPR, ICCV sull'apprendimento automatico per la guida autonoma, la visione 3D e la robotica, i sistemi di apprendimento automatico e l'apprendimento automatico avverso. Ha un dottorato di ricerca in informatica presso la Cornell University. È ACM Fellow e IEEE Fellow.

Nitish Joshi era uno stagista di scienze applicate presso AWS AI, Amazon. È uno studente di dottorato in informatica presso il Courant Institute of Mathematical Sciences della New York University sotto la guida del Prof. He He. Lavora su Machine Learning e Natural Language Processing ed è stato affiliato al gruppo di ricerca Machine Learning for Language (ML2). Era ampiamente interessato alla solida comprensione del linguaggio: sia nella costruzione di modelli robusti ai cambiamenti di distribuzione (ad esempio attraverso l'aumento dei dati umani nel ciclo) sia nella progettazione di modi migliori per valutare/misurare la robustezza dei modelli. È stato anche curioso dei recenti sviluppi nell'apprendimento contestuale e della comprensione di come funziona.

Nitish Joshi era uno stagista di scienze applicate presso AWS AI, Amazon. È uno studente di dottorato in informatica presso il Courant Institute of Mathematical Sciences della New York University sotto la guida del Prof. He He. Lavora su Machine Learning e Natural Language Processing ed è stato affiliato al gruppo di ricerca Machine Learning for Language (ML2). Era ampiamente interessato alla solida comprensione del linguaggio: sia nella costruzione di modelli robusti ai cambiamenti di distribuzione (ad esempio attraverso l'aumento dei dati umani nel ciclo) sia nella progettazione di modi migliori per valutare/misurare la robustezza dei modelli. È stato anche curioso dei recenti sviluppi nell'apprendimento contestuale e della comprensione di come funziona.

Kumar Chellapilla è General Manager e Director presso Amazon Web Services e guida lo sviluppo di servizi ML/AI come sistemi human-in-loop, AI DevOps, Geospatial ML e ADAS/Autonomous Vehicle development. Prima di AWS, Kumar è stato Director of Engineering presso Uber ATG e Lyft Level 5 e ha guidato i team utilizzando l'apprendimento automatico per sviluppare capacità di guida autonoma come la percezione e la mappatura. Ha anche lavorato all'applicazione di tecniche di apprendimento automatico per migliorare la ricerca, i consigli e i prodotti pubblicitari su LinkedIn, Twitter, Bing e Microsoft Research.

Kumar Chellapilla è General Manager e Director presso Amazon Web Services e guida lo sviluppo di servizi ML/AI come sistemi human-in-loop, AI DevOps, Geospatial ML e ADAS/Autonomous Vehicle development. Prima di AWS, Kumar è stato Director of Engineering presso Uber ATG e Lyft Level 5 e ha guidato i team utilizzando l'apprendimento automatico per sviluppare capacità di guida autonoma come la percezione e la mappatura. Ha anche lavorato all'applicazione di tecniche di apprendimento automatico per migliorare la ricerca, i consigli e i prodotti pubblicitari su LinkedIn, Twitter, Bing e Microsoft Research.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoAiStream. Intelligenza dei dati Web3. Conoscenza amplificata. Accedi qui.

- Coniare il futuro con Adryenn Ashley. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- :ha

- :È

- :non

- :Dove

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- abilità

- capacità

- WRI

- di conseguenza

- ACM

- aggiunto

- l'aggiunta di

- aggiuntivo

- indirizzo

- contraddittorio

- Pubblicità

- affiliato

- Dopo shavasana, sedersi in silenzio; saluti;

- ancora

- AI

- Alexa

- Algoritmi

- Tutti

- lungo

- anche

- alternativa

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- tra

- an

- ed

- rispondere

- risposte

- in qualsiasi

- applicato

- APPLICA

- AMMISSIONE

- approccio

- opportuno

- SONO

- AS

- addetto

- At

- autonomo

- disponibile

- consapevolezza

- AWS

- base

- basato

- Linea di base

- BE

- perché

- stato

- prima

- Campana

- parametri di riferimento

- Meglio

- Bing

- entrambi

- Scatola

- in linea di massima

- Costruzione

- modelli di costruzione

- ma

- by

- Materiale

- funzionalità

- Career

- Custodie

- certo

- catena

- Catene

- impegnativo

- capo

- classificare

- Chiudi

- raccogliere

- Raccolta

- collezione

- COLUMBIA

- Uncommon

- paragonabile

- confrontare

- rispetto

- globale

- computer

- Informatica

- condotto

- fiducioso

- con fiducia

- Prendere in considerazione

- considerando

- consolle

- contiene

- contesto

- convertire

- cornell

- Correzioni

- corroborare

- curioso

- dati

- dataset

- deep

- apprendimento profondo

- dimostrare

- dimostra

- descrivere

- descritta

- descrizione

- progettazione

- Nonostante

- dettaglio

- dettagliati

- dettagli

- Dev

- sviluppare

- Mercato

- sviluppi

- diverso

- direttamente

- Direttore

- distribuzione

- paesaggio differenziato

- do

- fatto

- Dont

- guida

- durante

- e

- ogni

- abilitato

- Ingegneria

- errore

- errori

- stabilire

- valutare

- valutato

- valutazione

- Anche

- esempio

- Esempi

- spiegazione

- feedback

- compagno

- campo

- figura

- finale

- Nome

- seguito

- i seguenti

- Nel

- modulo

- essere trovato

- quattro

- da

- raccolta

- Generale

- generare

- generato

- genera

- la generazione di

- ELETTRICA

- generazioni

- ML geospaziale

- Dare

- dato

- Dare

- Terra

- Gruppo

- pirateria informatica

- Avere

- avendo

- he

- capo

- Aiuto

- aiuta

- qui

- il suo

- Come

- Tutorial

- Tuttavia

- HTTPS

- umano

- Gli esseri umani

- identificare

- IEEE

- if

- illustra

- competenze

- in

- Compreso

- incorporare

- inizialmente

- iniziative

- invece

- Istituto

- interessato

- interessi

- Interfaccia

- ai miglioramenti

- indagare

- IT

- iterazioni

- SUO

- jpg

- Labs

- Lingua

- grandi

- superiore, se assunto singolarmente.

- Leads

- IMPARARE

- imparato

- apprendimento

- Guidato

- Livello

- Limitato

- LLM

- logico

- cerca

- Lyft

- macchina

- machine learning

- FA

- direttore

- mappatura

- matematico

- massimo

- Maggio..

- metodi

- Microsoft

- mancante

- errore

- errori

- ML

- ml2

- modello

- modelli

- Mese

- Scopri di più

- maggior parte

- motivato

- multiplo

- cioè

- Naturale

- Elaborazione del linguaggio naturale

- New

- New York

- nlp

- no

- numero

- obiettivo

- osservare

- ostacolo

- ottenere

- ottenuto

- si è verificato

- of

- on

- ONE

- in corso

- esclusivamente

- inizio

- or

- i

- altrimenti

- nostro

- su

- ancora

- panoramica

- proprio

- percentuale

- pubblica

- Eseguire

- performance

- esegue

- periodo

- periodico

- scegliere

- pilota

- posto

- piattaforma

- Platone

- Platone Data Intelligence

- PlatoneDati

- più

- pone

- possibile

- Post

- potenziale

- pratica

- predire

- predizione

- predice

- Preparare

- presenti

- presentata

- atleta

- precedente

- in precedenza

- Precedente

- lavorazione

- Prodotti

- Insegnante

- Progressi

- proporzione

- offre

- proposto

- protocollo

- fornire

- purché

- fornisce

- qualità

- domanda

- Domande

- casuale

- piuttosto

- recente

- raccomandazioni

- raffinare

- relativamente

- pertinente

- rimuovere

- rappresentazione

- richiedere

- necessario

- riparazioni

- riservato

- rispettivamente

- REST

- colpevole

- Risultati

- Premiare

- Ricco

- robotica

- robusto

- robustezza

- round

- RIGA

- sagemaker

- stesso

- Scala

- scala ai

- bilancia

- Scienze

- SCIENZE

- Scienziato

- Cerca

- Secondo

- Sezione

- visto

- AUTO

- auto-guida

- anziano

- condanna

- separato

- Servizi

- set

- alcuni

- Turni

- Corti

- mostrare attraverso le sue creazioni

- mostrato

- Spettacoli

- significativa

- significativamente

- simile

- Un'espansione

- piccole

- inferiore

- alcuni

- specifico

- in particolare

- dividere

- Sports

- iniziato

- step

- Passi

- Strategico

- studente

- il successo

- tale

- SISTEMI DI TRATTAMENTO

- tavolo

- Task

- task

- team

- le squadre

- tecniche

- test

- di

- che

- Il

- loro

- Li

- poi

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- quelli

- Attraverso

- a

- Totale

- allenato

- Training

- trattare

- trattare

- enorme

- Affidati ad

- Verità

- esercitazioni

- seconda

- Digitare

- Tipi di

- Uber

- e una comprensione reciproca

- Università

- uso

- utilizzato

- utenti

- utilizzando

- generalmente

- Variante

- vario

- veicolo

- Visualizza

- visione

- Visita

- Votazione

- Prima

- Modo..

- modi

- we

- sito web

- servizi web

- peso

- sono stati

- quando

- se

- quale

- perché

- volere

- con

- Lavora

- lavorato

- lavoro

- lavori

- Corsi

- valore

- Wrong

- York

- Trasferimento da aeroporto a Sharm

- zefiro