Oggi siamo entusiasti di annunciare che il Mixtral-8x7B il modello linguistico di grandi dimensioni (LLM), sviluppato da Mistral AI, è disponibile per i clienti tramite JumpStart di Amazon SageMaker da distribuire con un clic per eseguire l'inferenza. Mixtral-8x7B LLM è una miscela sparsa pre-addestrata di modello esperto, basata su una dorsale di 7 miliardi di parametri con otto esperti per livello feed-forward. Puoi provare questo modello con SageMaker JumpStart, un hub di machine learning (ML) che fornisce accesso ad algoritmi e modelli in modo da poter iniziare rapidamente con il ML. In questo post, spiegheremo come scoprire e distribuire il modello Mixtral-8x7B.

Cos'è Mixtral-8x7B

Mixtral-8x7B è un modello di base sviluppato da Mistral AI, che supporta testo inglese, francese, tedesco, italiano e spagnolo, con capacità di generazione di codice. Supporta una varietà di casi d'uso come riepilogo del testo, classificazione, completamento del testo e completamento del codice. Si comporta bene in modalità chat. Per dimostrare la semplice personalizzazione del modello, Mistral AI ha anche rilasciato un modello Mixtral-8x7B-instruct per casi d'uso di chat, ottimizzato utilizzando una varietà di set di dati di conversazione disponibili pubblicamente. I modelli Mixtral hanno una lunghezza del contesto ampia fino a 32,000 token.

Mixtral-8x7B offre miglioramenti significativi delle prestazioni rispetto ai precedenti modelli all'avanguardia. La sua sparsa combinazione di architettura professionale gli consente di ottenere risultati prestazionali migliori su 9 benchmark su 12 di elaborazione del linguaggio naturale (NLP) testati da Maestrale AI. Mixtral eguaglia o supera le prestazioni di modelli fino a 10 volte la sua dimensione. Utilizzando solo una frazione di parametri per token, raggiunge velocità di inferenza più elevate e costi computazionali inferiori rispetto a modelli densi di dimensioni equivalenti, ad esempio con 46.7 miliardi di parametri totali ma solo 12.9 miliardi utilizzati per token. Questa combinazione di prestazioni elevate, supporto multilingue ed efficienza computazionale rende Mixtral-8x7B una scelta interessante per le applicazioni NLP.

Il modello è reso disponibile sotto la licenza permissiva Apache 2.0, per un utilizzo senza restrizioni.

Cos'è SageMaker JumpStart

Con SageMaker JumpStart, i professionisti del machine learning possono scegliere da un elenco crescente di modelli di base con le migliori prestazioni. I professionisti del machine learning possono distribuire modelli di base a progetti dedicati Amazon Sage Maker istanze all'interno di un ambiente isolato di rete e personalizzare i modelli utilizzando SageMaker per l'addestramento e la distribuzione dei modelli.

Ora puoi scoprire e distribuire Mixtral-8x7B con pochi clic Amazon Sage Maker Studio o a livello di programmazione tramite SageMaker Python SDK, consentendoti di derivare le prestazioni del modello e i controlli MLOps con funzionalità SageMaker come Pipeline di Amazon SageMaker, Debugger di Amazon SageMakero log del contenitore. Il modello viene distribuito in un ambiente sicuro AWS e sotto i controlli VPC, contribuendo a garantire la sicurezza dei dati.

Scopri i modelli

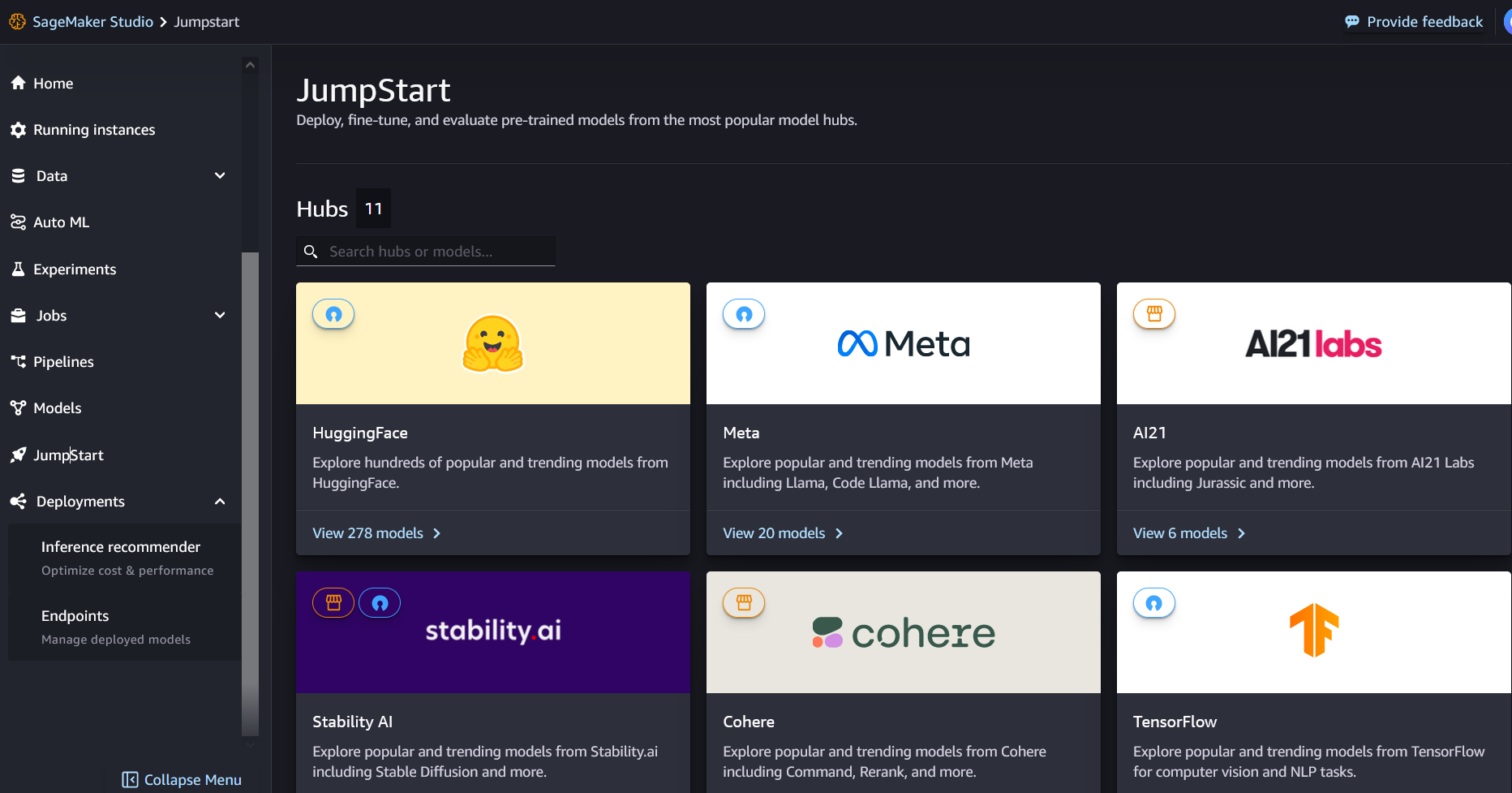

Puoi accedere ai modelli di base Mixtral-8x7B tramite SageMaker JumpStart nell'interfaccia utente di SageMaker Studio e SageMaker Python SDK. In questa sezione, esamineremo come scoprire i modelli in SageMaker Studio.

SageMaker Studio è un ambiente di sviluppo integrato (IDE) che fornisce un'unica interfaccia visiva basata sul Web in cui è possibile accedere a strumenti specifici per eseguire tutte le fasi di sviluppo ML, dalla preparazione dei dati alla creazione, formazione e distribuzione dei modelli ML. Per ulteriori dettagli su come iniziare e configurare SageMaker Studio, fare riferimento a Amazon Sage Maker Studio.

In SageMaker Studio, puoi accedere a SageMaker JumpStart scegliendo inizio di salto nel pannello di navigazione.

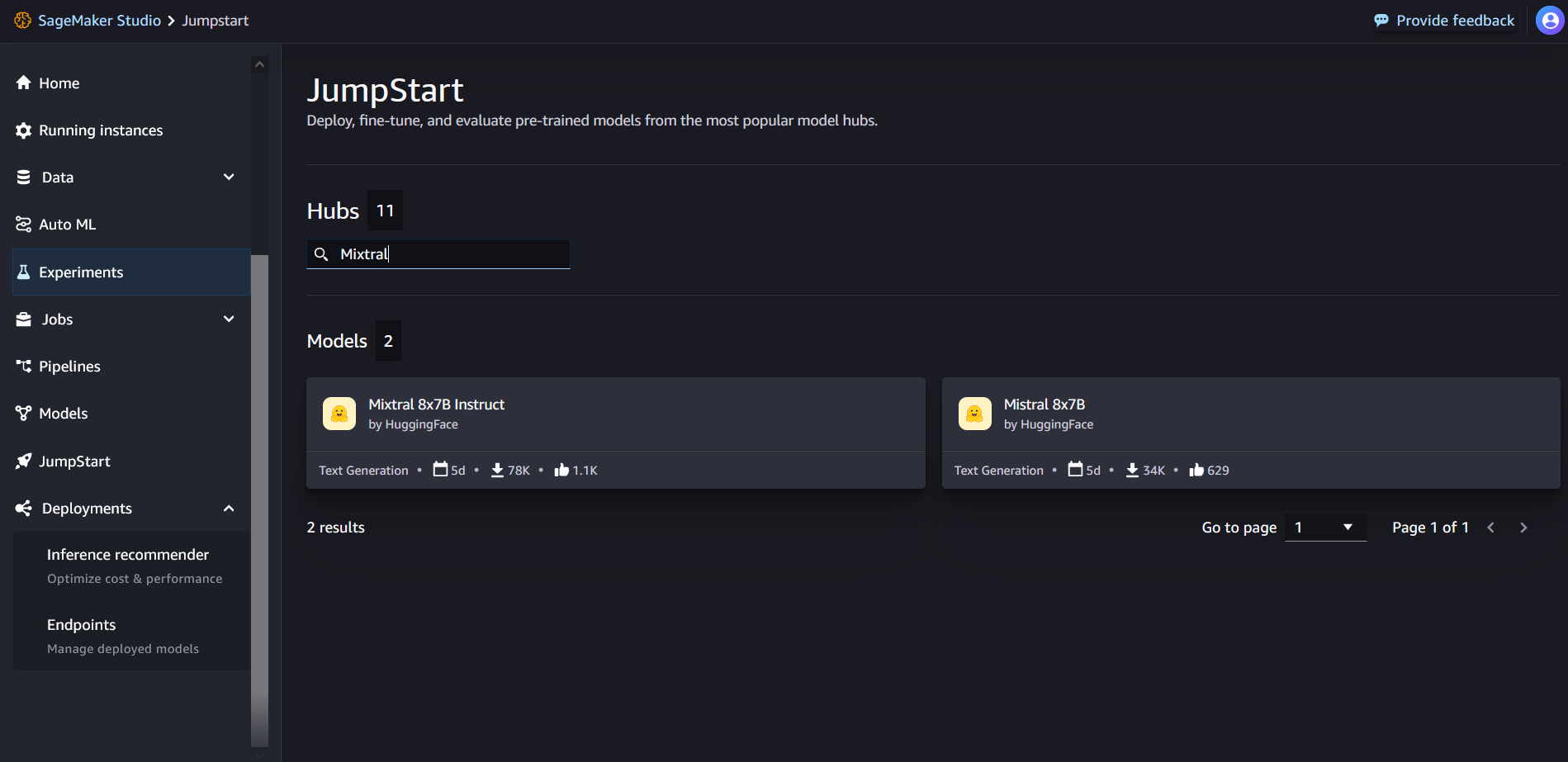

Dalla pagina di destinazione JumpStart di SageMaker, puoi cercare "Mixtral" nella casella di ricerca. Vedrai i risultati della ricerca che mostrano Mixtral 8x7B e Mixtral 8x7B Instruct.

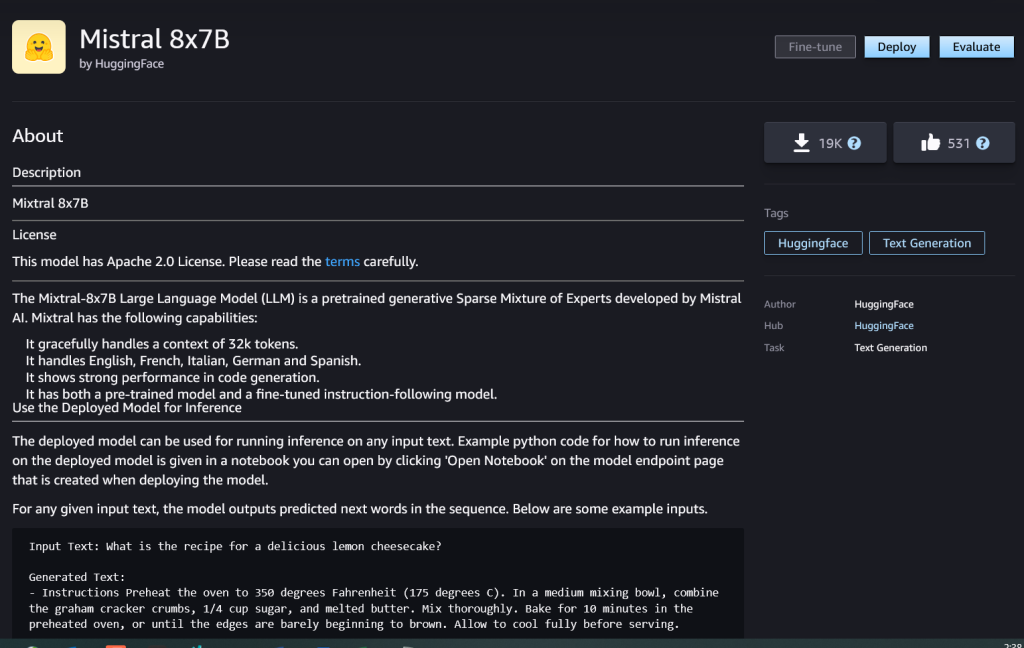

Puoi scegliere la scheda del modello per visualizzare i dettagli sul modello come licenza, dati utilizzati per l'addestramento e modalità di utilizzo. Troverai anche il Schierare pulsante, che puoi utilizzare per distribuire il modello e creare un endpoint.

Distribuisci un modello

La distribuzione inizia quando lo scegli tu Schierare. Al termine della distribuzione, è stato creato un endpoint. Puoi testare l'endpoint trasmettendo un payload di richiesta di inferenza di esempio o selezionando l'opzione di test utilizzando l'SDK. Quando selezioni l'opzione per utilizzare l'SDK, vedrai il codice di esempio che puoi utilizzare nel tuo editor di notebook preferito in SageMaker Studio.

Per eseguire la distribuzione utilizzando l'SDK, iniziamo selezionando il modello Mixtral-8x7B, specificato dal file model_id with value huggingface-llm-mixtral-8x7b. Puoi distribuire uno qualsiasi dei modelli selezionati su SageMaker con il seguente codice. Allo stesso modo, puoi distribuire l'istruzione Mixtral-8x7B utilizzando il proprio ID modello:

Questo distribuisce il modello su SageMaker con configurazioni predefinite, inclusi il tipo di istanza predefinito e le configurazioni VPC predefinite. È possibile modificare queste configurazioni specificando valori non predefiniti in Modello JumpStart.

Dopo la distribuzione, puoi eseguire l'inferenza sull'endpoint distribuito tramite il predittore SageMaker:

Esempi di prompt

Puoi interagire con un modello Mixtral-8x7B come qualsiasi modello standard di generazione di testo, in cui il modello elabora una sequenza di input e restituisce le parole successive previste nella sequenza. In questa sezione vengono forniti prompt di esempio.

Generazione del codice

Utilizzando l'esempio precedente, possiamo utilizzare prompt di generazione del codice come i seguenti:

Ottieni il seguente output:

Richiesta di analisi del sentiment

Puoi eseguire l'analisi del sentiment utilizzando un prompt come il seguente con Mixtral 8x7B:

Ottieni il seguente output:

Richieste di risposta alle domande

Puoi utilizzare una richiesta di risposta alla domanda come la seguente con Mixtral-8x7B:

Ottieni il seguente output:

Mixtral-8x7B Istruzione

La versione ottimizzata per le istruzioni di Mixtral-8x7B accetta istruzioni formattate in cui i ruoli di conversazione devono iniziare con un prompt dell'utente e alternarsi tra istruzione dell'utente e assistente (risposta modello). Il formato delle istruzioni deve essere rigorosamente rispettato, altrimenti il modello genererà output non ottimali. Il modello utilizzato per creare un prompt per il modello Instruct è definito come segue:

Si noti che <s> ed </s> sono token speciali per l'inizio della stringa (BOS) e la fine della stringa (EOS), mentre [INST] ed [/INST] sono stringhe regolari.

Il codice seguente mostra come formattare il prompt nel formato istruzione:

Recupero della conoscenza

È possibile utilizzare il codice seguente per una richiesta di recupero della conoscenza:

Ottieni il seguente output:

codifica

I modelli Mixtral possono dimostrare punti di forza confrontati per le attività di codifica, come mostrato nel seguente codice:

Matematica e ragionamento

I modelli Mixtral riportano anche punti di forza nell’accuratezza matematica:

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :ha

- :È

- :non

- :Dove

- $ SU

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- abilità

- WRI

- sopra

- accelerando

- accetta

- accesso

- conti

- precisione

- Raggiungere

- Realizza

- operanti in

- attivo

- aggiunto

- l'aggiunta di

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- AI

- AI / ML

- Algoritmi

- Tutti

- anche

- Amazon

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Web Services

- quantità

- an

- .

- ed

- e infrastruttura

- Annunciare

- rispondere

- in qualsiasi

- Apache

- attraente

- applicazioni

- applicato

- AMMISSIONE

- architettura

- SONO

- argomento

- articolo

- AS

- Assistant

- At

- disponibile

- AWS

- precedente

- Spina dorsale

- basato

- bash

- batteria

- bayesiano

- BE

- perché

- stato

- prima

- Inizio

- crede

- Campana

- confrontato

- parametri di riferimento

- Meglio

- fra

- Conto

- fatturazione

- Miliardo

- perno

- comprato

- Scatola

- Rompere

- portare

- costruire

- Costruzione

- incassato

- affari

- ma

- by

- calcolare

- chiamata

- detto

- Bandi

- Materiale

- carta

- Custodie

- casi

- il cambiamento

- chiacchierare

- scegliere

- Scegli

- la scelta

- chris

- classificazione

- clicca

- codice

- codifica

- combinazione

- rispetto

- compilato

- completamento

- computazionale

- Calcolare

- computer

- Visione computerizzata

- conferenze

- costantemente

- Contenitore

- contenuto

- contesto

- continua

- continuamente

- controlli

- Conversazione

- Costo

- Costi

- potuto

- creare

- creato

- cruciale

- Coppa

- Corrente

- Clienti

- personalizzazione

- personalizzare

- dati

- la sicurezza dei dati

- dataset

- giorno

- Giorni

- dedicato

- Predefinito

- definito

- democratizzare

- dimostrare

- schierare

- schierato

- distribuzione

- deployment

- Distribuisce

- derivare

- dettagli

- sviluppare

- sviluppato

- Costruttori

- Mercato

- DITT

- DID

- scopri

- do

- effettua

- dollari

- domini

- fatto

- giù

- Cadere

- Duca

- Università del Duca

- ogni

- Economico

- editore

- efficienza

- Uova

- altro

- enable

- Abilita

- consentendo

- fine

- endpoint

- Ingegneria

- Inglese

- garantire

- Ambiente

- EOS

- pari

- Equivalente

- etico

- esempio

- supera

- eccitato

- esclusa

- esperto

- esperti

- Spiegare

- spiegazione

- estensione

- famiglia

- più veloce

- Caratteristiche

- pochi

- File

- filtri

- Trovate

- Nome

- i seguenti

- segue

- Nel

- formato

- Fondazione

- frazione

- Francese

- da

- function

- futuro

- scopo generale

- generare

- generato

- ELETTRICA

- generativo

- AI generativa

- Tedesco

- ottenere

- Go

- buono

- ha ottenuto

- Crescita

- odio

- Avere

- he

- Aiuto

- aiutare

- aiuta

- suo

- qui

- Alta

- Hills

- il suo

- Come

- Tutorial

- HTML

- HTTPS

- Hub

- i

- ICE

- gelato

- ID

- if

- Illinois

- malattia

- importare

- importante

- competenze

- miglioramenti

- in

- includere

- Compreso

- Incorporated

- Infrastruttura

- ingresso

- Ingressi

- esempio

- istruzioni

- integrare

- integrato

- interagire

- interessi

- Interfaccia

- Inventato

- isolato

- IT

- italiano

- SUO

- stessa

- jpg

- bambini

- conoscenze

- kyle

- Labs

- atterraggio

- Lingua

- grandi

- Cognome

- strato

- Leads

- apprendimento

- Lunghezza

- lasciare

- Licenza

- piace

- piace

- limiti

- LINK

- Lista

- Ascolto

- piccolo

- LLM

- logica

- cerca

- inferiore

- macchina

- machine learning

- fatto

- FA

- Fare

- direttore

- molti

- fiammiferi

- matematica

- matematica

- me

- medie

- miscela

- ML

- MLOp

- Moda

- modello

- modelli

- modificato

- Mese

- Scopri di più

- MOTO

- molti

- moltiplicato

- Musica

- devono obbligatoriamente:

- my

- Naturale

- Elaborazione del linguaggio naturale

- Navigazione

- negativo.

- Rete

- Neutres

- New

- GENERAZIONE

- nlp

- Nessuna

- Nota

- taccuino

- adesso

- numero

- of

- Olio

- on

- una volta

- ONE

- esclusivamente

- operativo

- sistema operativo

- Opzione

- or

- Altro

- altrimenti

- su

- produzione

- uscite

- al di fuori

- ancora

- proprio

- pagina

- pagato

- vetro

- documenti

- parametro

- parametri

- Di passaggio

- passione

- appassionato

- percorsi

- per

- Eseguire

- performance

- phd

- telefono

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- portatile

- positivo

- Post

- precedente

- previsto

- Predictor

- preferito

- preparazione

- precedente

- Direttore

- Stampa

- procedurale

- processi

- i processi

- lavorazione

- Prodotto

- Programma

- Programmazione

- istruzioni

- prosperità

- fornire

- fornitori

- fornisce

- pubblicamente

- pubblicato

- Python

- Trimestre

- domanda

- rapidamente

- RE

- Lettura

- ricetta

- Ricorsivo

- ridurre

- riferimento

- Basic

- rilasciato

- rapporto

- richiesta

- riparazioni

- ricercatore

- Risorse

- rispettati

- risposta

- responsabile

- restrizioni

- colpevole

- Risultati

- ritorno

- problemi

- equitazione

- Rischio

- Ruolo

- ruoli

- Prenotazione sale

- Correre

- running

- s

- SA

- sagemaker

- sale

- scalabile

- Scala

- Scienze

- Scienziato

- sdk

- Cerca

- Sezione

- sicuro

- problemi di

- vedere

- select

- selezionato

- Selezione

- prodotti

- anziano

- sentimento

- separato

- Sequenza

- Serie

- Servizi

- set

- ha mostrato

- mostrato

- Spettacoli

- significativa

- Allo stesso modo

- Un'espansione

- da

- singolo

- Taglia

- So

- Social

- Società

- Software

- soluzione

- Spagnolo

- la nostra speciale

- specialista

- specificato

- velocità

- Spendere

- Standard

- inizia a

- iniziato

- inizio

- state-of-the-art

- statistiche

- step

- Passi

- Ancora

- fermato

- Tornare al suo account

- lineare

- Strategico

- ruscello

- punti di forza

- Corda

- strutturato

- studio

- tale

- supporto

- Supporto

- supporti

- sistema

- prende

- task

- chiavi

- team

- Tecnologia

- modello

- test

- testato

- Testing

- testo

- che

- Il

- Il futuro

- poi

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- Attraverso

- tempo

- Serie storiche

- volte

- a

- insieme

- token

- Tokens

- pure

- strumenti

- Totale

- Treni

- Training

- vero

- prova

- Tweet

- Digitare

- ui

- per

- Università

- unix

- sbloccare

- fino a quando

- uso

- caso d'uso

- utilizzato

- Utente

- usa

- utilizzando

- Utilizzando

- Valle

- APPREZZIAMO

- Valori

- varietà

- versione

- Video

- Visualizza

- visione

- Visita

- visivo

- camminare

- Prima

- Water

- we

- sito web

- servizi web

- Web-basata

- WELL

- Che

- Che cosa è l'

- quando

- mentre

- quale

- bianca

- OMS

- volere

- con

- entro

- senza

- parole

- Lavora

- sarebbe

- scrivere

- scritto

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro

Rachna Chada è Principal Solution Architect AI/ML in Strategic Accounts presso AWS. Rachna è un'ottimista che crede che l'uso etico e responsabile dell'IA possa migliorare la società in futuro e portare prosperità economica e sociale. Nel tempo libero, a Rachna piace passare il tempo con la sua famiglia, fare escursioni e ascoltare musica.

Rachna Chada è Principal Solution Architect AI/ML in Strategic Accounts presso AWS. Rachna è un'ottimista che crede che l'uso etico e responsabile dell'IA possa migliorare la società in futuro e portare prosperità economica e sociale. Nel tempo libero, a Rachna piace passare il tempo con la sua famiglia, fare escursioni e ascoltare musica. Dottor Kyle Ulrich è uno scienziato applicato con il

Dottor Kyle Ulrich è uno scienziato applicato con il  Christopher Whitten è uno sviluppatore di software nel team JumpStart. Aiuta a ridimensionare la selezione dei modelli e a integrare i modelli con altri servizi SageMaker. Chris è appassionato di accelerare l'ubiquità dell'intelligenza artificiale in una varietà di settori aziendali.

Christopher Whitten è uno sviluppatore di software nel team JumpStart. Aiuta a ridimensionare la selezione dei modelli e a integrare i modelli con altri servizi SageMaker. Chris è appassionato di accelerare l'ubiquità dell'intelligenza artificiale in una varietà di settori aziendali. Dott. Fabio Nonato de Paula è un Senior Manager, Specialist GenAI SA, che aiuta i fornitori di modelli e i clienti a scalare l'intelligenza artificiale generativa in AWS. Fabio ha una passione per la democratizzazione dell'accesso alla tecnologia dell'intelligenza artificiale generativa. Fuori dal lavoro, puoi trovare Fabio in sella alla sua moto sulle colline della Sonoma Valley o leggendo Comixology.

Dott. Fabio Nonato de Paula è un Senior Manager, Specialist GenAI SA, che aiuta i fornitori di modelli e i clienti a scalare l'intelligenza artificiale generativa in AWS. Fabio ha una passione per la democratizzazione dell'accesso alla tecnologia dell'intelligenza artificiale generativa. Fuori dal lavoro, puoi trovare Fabio in sella alla sua moto sulle colline della Sonoma Valley o leggendo Comixology. Dottor Ashish Khetan è un Senior Applied Scientist con algoritmi integrati di Amazon SageMaker e aiuta a sviluppare algoritmi di machine learning. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nell'apprendimento automatico e nell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP.

Dottor Ashish Khetan è un Senior Applied Scientist con algoritmi integrati di Amazon SageMaker e aiuta a sviluppare algoritmi di machine learning. Ha conseguito il dottorato di ricerca presso l'Università dell'Illinois Urbana-Champaign. È un ricercatore attivo nell'apprendimento automatico e nell'inferenza statistica e ha pubblicato numerosi articoli nelle conferenze NeurIPS, ICML, ICLR, JMLR, ACL e EMNLP. Carlo Albertsen guida prodotti, ingegneria e scienza per Amazon SageMaker Algorithms e JumpStart, l'hub di machine learning di SageMaker. È appassionato di applicare l'apprendimento automatico per sbloccare il valore aziendale.

Carlo Albertsen guida prodotti, ingegneria e scienza per Amazon SageMaker Algorithms e JumpStart, l'hub di machine learning di SageMaker. È appassionato di applicare l'apprendimento automatico per sbloccare il valore aziendale.