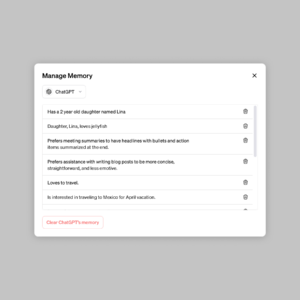

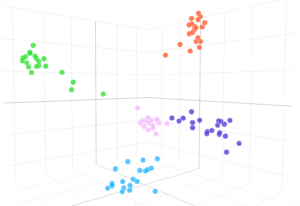

Mostriamo che un modello GPT-3 può imparare a esprimere l'incertezza sulle proprie risposte nel linguaggio naturale, senza l'uso dei logit del modello. Quando viene posta una domanda, il modello genera sia una risposta che un livello di confidenza (ad esempio “confidenza al 90%” o “confidenza alta”). Questi livelli corrispondono a probabilità ben calibrate. Il modello rimane inoltre moderatamente calibrato in caso di spostamento della distribuzione ed è sensibile all’incertezza nelle proprie risposte, piuttosto che imitare gli esempi umani. A nostra conoscenza, questa è la prima volta che un modello ha dimostrato di esprimere un’incertezza calibrata sulle proprie risposte nel linguaggio naturale. Per testare la calibrazione, introduciamo la suite di attività CalibratedMath. Confrontiamo la calibrazione dell'incertezza espressa in parole (“probabilità verbalizzata”) con l'incertezza estratta dai logit del modello. Entrambi i tipi di incertezza sono in grado di generalizzare la calibrazione in caso di spostamento della distribuzione. Forniamo anche prove che la capacità di GPT-3 di generalizzare la calibrazione dipende da rappresentazioni latenti pre-addestrate che sono correlate con l'incertezza epistemica sulle sue risposte.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. Accedi qui.

- Fonte: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :È

- a

- capacità

- WRI

- ed

- rispondere

- risposte

- SONO

- Materiale

- capace

- confrontare

- fiducia

- dipende

- distribuzione

- e

- prova

- Esempi

- esprimere

- espresso

- Nome

- prima volta

- Nel

- da

- genera

- dato

- Alta

- HTTPS

- umano

- in

- introdurre

- SUO

- conoscenze

- Lingua

- IMPARARE

- Livello

- livelli

- carta geografica

- modello

- modelli

- Naturale

- of

- on

- proprio

- Platone

- Platone Data Intelligence

- PlatoneDati

- fornire

- domanda

- piuttosto

- resti

- s

- delicata

- spostamento

- mostrare attraverso le sue creazioni

- mostrato

- suite

- task

- Insegnamento

- Testing

- che

- Il

- loro

- Strumenti Bowman per analizzare le seguenti finiture:

- tempo

- a

- Incertezza

- per

- uso

- WELL

- con

- parole

- zefiro