La piaga della creazione dannosa di deepfake si è diffusa ben oltre il regno delle celebrità e dei personaggi pubblici, e un nuovo rapporto sulle immagini intime non consensuali (NCII) rileva che la pratica non fa che crescere man mano che i generatori di immagini si evolvono e proliferano.

La “svestizione dell’intelligenza artificiale” è in aumento, a rapporto ha detto venerdì la società di analisi dei social media Graphika, descrivendo la pratica come utilizzo IA generativa strumenti ottimizzati per rimuovere gli indumenti dalle immagini caricate dagli utenti.

La community di gaming e streaming di Twitch si è trovata alle prese con il problema all'inizio di quest'anno, quando il noto broadcaster Brandon 'Atrioc' Ewing ha accidentalmente rivelato di aver guardato deepfake porno generato dall'intelligenza artificiale di streamer donne che chiamava sue amiche, secondo un rapporto by Kotaku.

Ewing è tornato sulla piattaforma a marzo, contrito e riferendo sulle settimane di lavoro che aveva intrapreso per mitigare il danno che aveva causato. Ma l’incidente ha spalancato le porte a un’intera comunità online.

Il rapporto di Graphika mostra che l'incidente è stato solo una goccia nel mare.

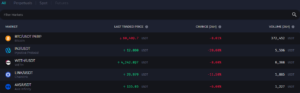

"Utilizzando i dati forniti da Meltwater, abbiamo misurato il numero di commenti e post su Reddit e X contenenti collegamenti di riferimento a 34 siti Web e 52 canali Telegram che forniscono servizi NCII sintetici", ha scritto l'analista di intelligence di Graphika Santiago Lakatos. “Questi sono stati complessivamente 1,280 nel 2022 rispetto agli oltre 32,100 finora quest’anno, rappresentando un aumento del 2,408% in volume su base annua”.

Graphika, con sede a New York, afferma che l'esplosione di NCII dimostra che gli strumenti si sono spostati da forum di discussione di nicchia a un'industria artigianale.

“Questi modelli consentono a un numero maggiore di fornitori di creare NCII fotorealistici su larga scala in modo semplice ed economico”, ha affermato Graphika. “Senza tali fornitori, i loro clienti avrebbero bisogno di ospitare, mantenere ed eseguire i propri modelli di diffusione delle immagini personalizzati, un processo lungo e talvolta costoso”.

Graphika avverte che l'aumento della popolarità degli strumenti di svestizione dell'intelligenza artificiale potrebbe portare non solo alla falsità pornografico materiale, ma anche molestie mirate, sextortion e generazione di materiale pedopornografico (CSAM).

Secondo la Graphika rapporto, gli sviluppatori di strumenti di svestizione basati sull'intelligenza artificiale fanno pubblicità sui social media per condurre potenziali utenti ai loro siti Web, chat private di Telegram o server Discord dove possono essere trovati gli strumenti.

"Alcuni fornitori sono espliciti nelle loro attività, affermando di fornire servizi di 'svestizione' e pubblicando foto di persone che sostengono siano state 'svestite' come prova", ha scritto Graphika. "Altri sono meno espliciti e si presentano come servizi artistici basati sull'intelligenza artificiale o gallerie fotografiche Web3, includendo termini chiave associati all'NCII sintetico nei loro profili e post."

Mentre le IA che si spogliano in genere si concentrano sulle immagini, l'IA è stata utilizzata anche per creare video deepfake che utilizzano le sembianze di celebrità, inclusa la personalità di YouTube Mr. Bestia e iconico attore di Hollywood Tom Hanks.

Ad alcuni attori piace Scarlett Johansson e attore indiano Anil Kapoor si stanno rivolgendo al sistema legale per combattere la continua minaccia dei deepfake basati sull’intelligenza artificiale. Tuttavia, mentre gli artisti tradizionali possono ricevere più attenzione da parte dei media, animatori per adulti dicono che le loro voci vengono ascoltate raramente.

"È davvero difficile", la leggendaria interprete adulta e responsabile PR di Star Factory, Tanya Tate, detto decrypt prima. "Se qualcuno è nel mainstream, sono sicuro che è molto più facile."

Anche senza l’avvento dell’intelligenza artificiale e della tecnologia deepfake, Tate ha spiegato che i social media sono già pieni di account falsi che utilizzano la sua somiglianza e i suoi contenuti. A non aiutare le cose è il continuo stigma che le lavoratrici del sesso devono affrontare, costringendo loro e i loro fan a rimanere nell’ombra.

Nel mese di ottobre, la società di controllo di Internet con sede nel Regno Unito, Internet Watch Foundation (IWF), in un rapporto separato, ha osservato che oltre 20,254 immagini di abusi sui minori sono state trovate su un singolo forum del darkweb in un solo mese. L’IWF ha avvertito che la pornografia infantile generata dall’intelligenza artificiale potrebbe “sopraffare" Internet.

Grazie ai progressi nell’imaging AI generativo, l’IWF lo avverte deepfake la pornografia è avanzata al punto che distinguere tra immagini generate dall’intelligenza artificiale e immagini autentiche è diventato sempre più complesso, lasciando le forze dell’ordine a dare la caccia a fantasmi online invece che a reali vittime di abusi.

"Quindi c'è quella cosa in corso per cui non puoi fidarti se le cose sono reali o no", ha detto Dan Sexton, CTO della Internet Watch Foundation decifrareT. "Le cose che ci diranno se le cose sono reali o meno non lo sono al 100% e quindi non puoi fidarti neanche di loro."

Per quanto riguarda Ewing, Kotaku ha riferito che lo streamer è tornato dicendo che stava lavorando con giornalisti, tecnici, ricercatori e donne colpite dall'incidente dopo la sua trasgressione in Gennaio. Ewing ha anche detto di aver inviato fondi allo studio legale di Ryan Morrison con sede a Los Angeles, MorrisonCooper, per fornire servizi legali a qualsiasi donna su Twitch che avesse bisogno del loro aiuto per inviare avvisi di rimozione ai siti che pubblicavano le loro immagini.

Ewing ha aggiunto di aver ricevuto ricerche sulla profondità del problema del deepfake dalla misteriosa ricercatrice del deepfake Genevieve Oh.

"Ho cercato di trovare i 'punti positivi' nella lotta contro questo tipo di contenuti", ha detto Ewing.

A cura di Ryan Ozawa.

Rimani aggiornato sulle notizie crittografiche, ricevi aggiornamenti quotidiani nella tua casella di posta.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://decrypt.co/209181/ai-undressing-deepfake-nude-services-skyrocket-in-popularity