Il machine learning (ML) aiuta le organizzazioni ad aumentare i ricavi, guidare la crescita aziendale e ridurre i costi ottimizzando le funzioni aziendali principali su più verticali, come la previsione della domanda, il punteggio di credito, i prezzi, la previsione dell'abbandono dei clienti, l'identificazione delle migliori offerte successive, la previsione delle spedizioni in ritardo e migliorare la qualità della produzione. I cicli di sviluppo del ML tradizionali richiedono mesi e richiedono scarse competenze in data science e ingegneria ML. Le idee degli analisti per i modelli ML spesso si trovano in lunghi backlog in attesa della larghezza di banda del team di data science, mentre i data scientist si concentrano su progetti ML più complessi che richiedono il loro set completo di competenze.

Per aiutare a rompere questo stallo, abbiamo ha introdotto Amazon SageMaker Canvas, una soluzione ML senza codice che può aiutare le aziende ad accelerare la consegna di soluzioni ML fino a poche ore o giorni. SageMaker Canvas consente agli analisti di utilizzare facilmente i dati disponibili in data lake, data warehouse e data store operativi; costruire modelli ML; e usali per fare previsioni in modo interattivo e per il punteggio batch su set di dati in blocco, il tutto senza scrivere una singola riga di codice.

In questo post, mostriamo come SageMaker Canvas consente la collaborazione tra data scientist e analisti aziendali, ottenendo un time to market più rapido e accelerando lo sviluppo di soluzioni ML. Gli analisti ottengono il proprio spazio di lavoro ML senza codice in SageMaker Canvas, senza dover diventare un esperto di ML. Gli analisti possono quindi condividere i loro modelli da Canvas con pochi clic, con i quali i data scientist potranno lavorare Amazon Sage Maker Studio, un ambiente di sviluppo integrato (IDE) di machine learning end-to-end. Lavorando insieme, gli analisti aziendali possono portare le loro conoscenze di dominio ei risultati della sperimentazione, mentre i data scientist possono creare in modo efficace pipeline e semplificare il processo.

Diamo un'occhiata a come sarebbe il flusso di lavoro.

Gli analisti aziendali costruiscono un modello, quindi lo condividono

Per capire come SageMaker Canvas semplifichi la collaborazione tra analisti aziendali e data scientist (o ingegneri ML), affrontiamo innanzitutto il processo come analista aziendale. Prima di iniziare, fare riferimento a Annuncio di Amazon SageMaker Canvas: una funzionalità visiva e senza codice di machine learning per analisti aziendali per istruzioni su come costruire e testare il modello con SageMaker Canvas.

Per questo post, utilizziamo una versione modificata di Set di dati per il rilevamento di frodi con carta di credito da Kaggle, un noto set di dati per un problema di classificazione binaria. Il set di dati è originariamente molto sbilanciato: ha pochissime voci classificate come una classe negativa (transazioni anomale). Indipendentemente dalla distribuzione delle funzioni di destinazione, possiamo comunque utilizzare questo set di dati, poiché SageMaker Canvas gestisce questo squilibrio mentre esegue il training e l'ottimizzazione di un modello automaticamente. Questo set di dati è costituito da circa 9 milioni di celle. Puoi anche scaricare un versione ridotta di questo set di dati. La dimensione del set di dati è molto più piccola, a circa 500,000 celle, perché è stato sottocampionato casualmente e quindi sovracampionato con la tecnica SMOTE per garantire che durante questo processo vengano perse meno informazioni possibili. L'esecuzione di un intero esperimento con questo set di dati ridotto ti costa $ 0 con il livello gratuito di SageMaker Canvas.

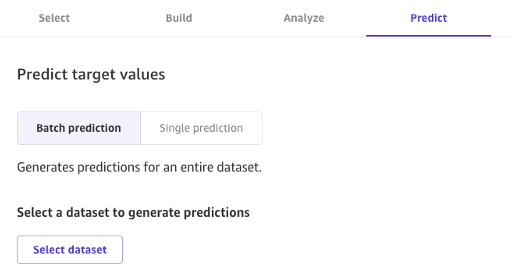

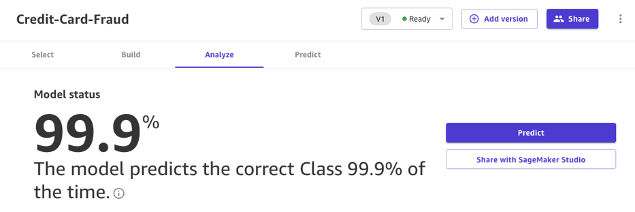

Dopo che il modello è stato creato, gli analisti possono usarlo per fare previsioni direttamente in Canvas per singole richieste o per un intero set di dati di input in blocco.

I modelli creati con Canvas Standard Build possono anche essere facilmente condivisi con un clic di un pulsante con data scientist e ingegneri ML che utilizzano SageMaker Studio. Ciò consente a un data scientist di convalidare le prestazioni del modello che hai creato e fornire feedback. Gli ingegneri ML possono ritirare il tuo modello e integrarlo con i flussi di lavoro e i prodotti esistenti disponibili per la tua azienda e i tuoi clienti. Tieni presente che, al momento della scrittura, non è possibile condividere un modello creato con Canvas Quick Build o un modello di previsione di serie temporali.

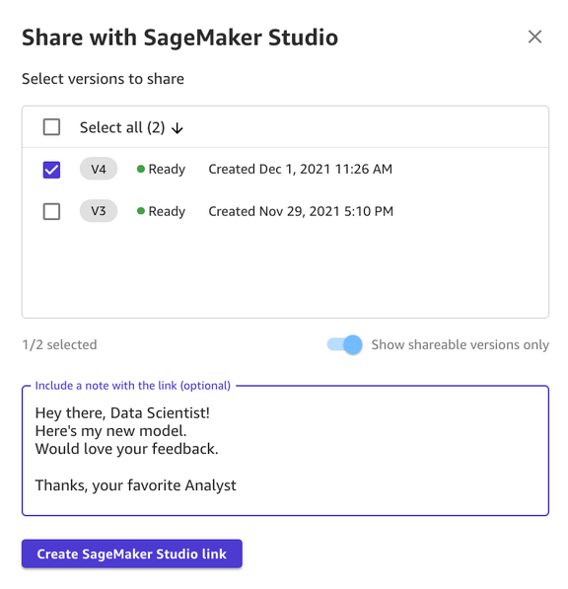

La condivisione di un modello tramite l'interfaccia utente Canvas è semplice:

- Nella pagina che mostra i modelli che hai creato, scegli un modello.

- Scegli Condividi.

- Scegli una o più versioni del modello che desideri condividere.

- Facoltativamente, includi una nota che fornisca più contesto sul modello o sull'aiuto che stai cercando.

- Scegli Crea collegamento a SageMaker Studio.

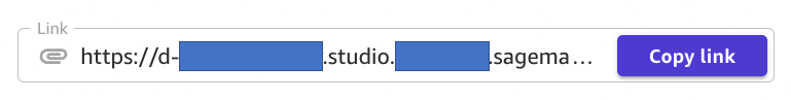

- Copia il link generato.

E questo è tutto! Ora puoi condividere il collegamento con i tuoi colleghi tramite Slack, e-mail o qualsiasi altro metodo di tua preferenza. Il data scientist deve trovarsi nello stesso dominio SageMaker Studio per poter accedere al tuo modello, quindi assicurati che sia il caso dell'amministratore della tua organizzazione.

I data scientist accedono alle informazioni sul modello da SageMaker Studio

Ora interpretiamo il ruolo di uno scienziato di dati o di un ingegnere di ML e vediamo le cose dal loro punto di vista utilizzando SageMaker Studio.

Il collegamento condiviso dall'analista ci porta in SageMaker Studio, il primo IDE basato su cloud per il flusso di lavoro ML end-to-end.

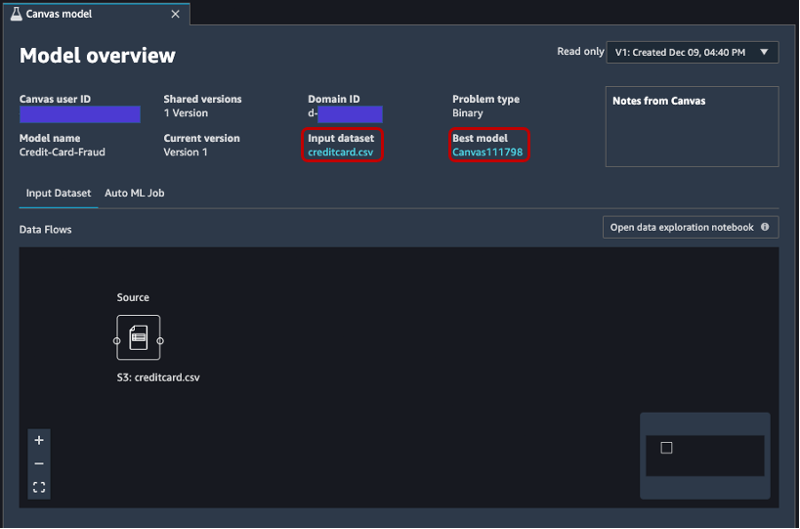

La scheda si apre automaticamente e mostra una panoramica del modello creato dall'analista in SageMaker Canvas. È possibile visualizzare rapidamente il nome del modello, il tipo di problema ML, la versione del modello e l'utente che ha creato il modello (sotto il campo ID utente Canvas). Hai anche accesso ai dettagli sul set di dati di input e sul miglior modello che SageMaker è stato in grado di produrre. Ne parleremo più avanti nel post.

Sulla Set di dati di input scheda, puoi anche vedere il flusso di dati dall'origine al set di dati di input. In questo caso, viene utilizzata solo un'origine dati e non sono state applicate operazioni di join, quindi viene mostrata un'unica origine. Puoi analizzare statistiche e dettagli sul set di dati scegliendo Aprire il taccuino di esplorazione dei dati. Questo quaderno consente di esplorare i dati disponibili prima dell'addestramento del modello e contiene un'analisi della variabile target, un campione dei dati di input, statistiche e descrizioni di colonne e righe, nonché altre informazioni utili per il data scientist saperne di più sul set di dati. Per ulteriori informazioni su questo rapporto, fare riferimento a Rapporto sull'esplorazione dei dati.

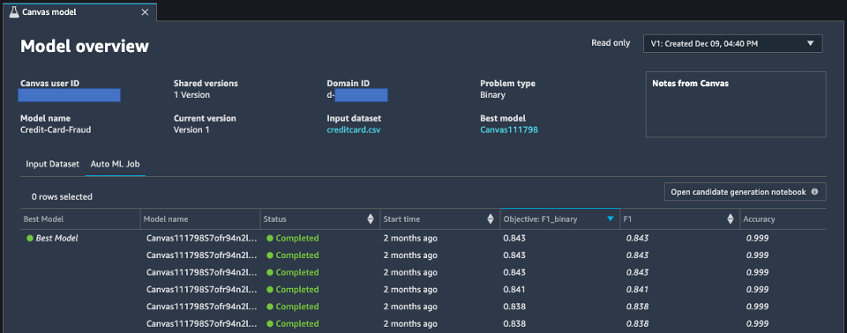

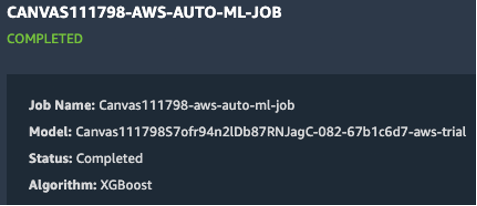

Dopo aver analizzato il dataset di input, passiamo alla seconda scheda della panoramica del modello, Lavoro AutoML. Questa scheda contiene una descrizione del lavoro AutoML quando hai selezionato l'opzione Standard Build in SageMaker Canvas.

La tecnologia AutoML alla base di SageMaker Canvas elimina il pesante lavoro di creazione di modelli ML. Crea, addestra e ottimizza automaticamente il miglior modello ML in base ai tuoi dati utilizzando un approccio automatizzato, consentendoti al contempo di mantenere il pieno controllo e visibilità. Questa visibilità sui modelli candidati generati e sugli iperparametri utilizzati durante il processo AutoML è contenuta nel taccuino di generazione dei candidati, disponibile in questa scheda.

I Lavoro AutoML la scheda contiene anche un elenco di ogni modello creato come parte del processo AutoML, ordinato in base alla metrica dell'obiettivo F1. Per evidenziare il miglior modello tra i lavori di formazione avviati, viene utilizzato un tag con un cerchio verde nel Miglior modello colonna. Puoi anche visualizzare facilmente altre metriche utilizzate durante la fase di formazione e valutazione, come il punteggio di precisione e l'Area Under the Curve (AUC). Per ulteriori informazioni sui modelli che è possibile addestrare durante un lavoro AutoML e le metriche utilizzate per valutare le prestazioni del modello addestrato, fare riferimento a Supporto del modello, metriche e convalida.

Per saperne di più sul modello, ora puoi fare clic con il pulsante destro del mouse sul modello migliore e scegliere Apri nei dettagli del modello. In alternativa, puoi scegliere il Miglior modello collegamento nella parte superiore del Panoramica del modello sezione che hai visitato per la prima volta.

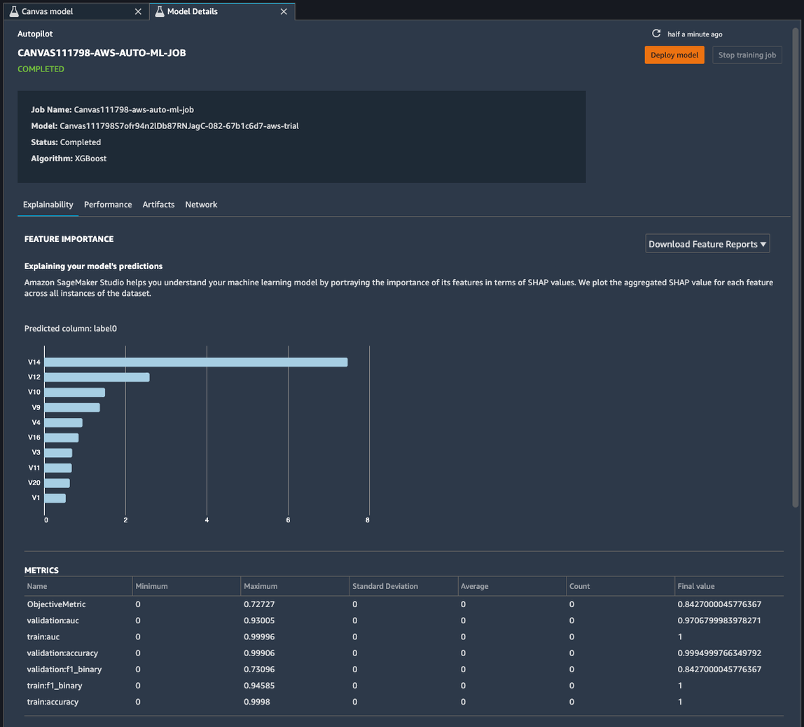

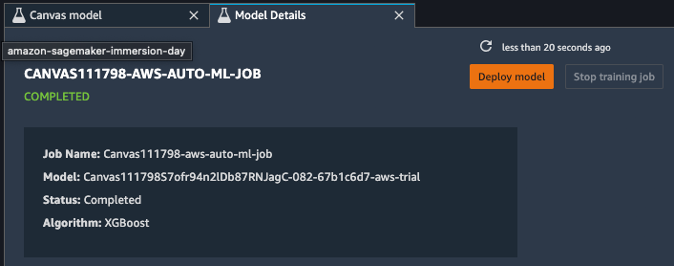

La pagina dei dettagli del modello contiene una miriade di informazioni utili sul modello che ha funzionato meglio con questi dati di input. Concentriamoci prima sul riepilogo nella parte superiore della pagina. Lo screenshot di esempio precedente mostra che, su centinaia di esecuzioni di training del modello, un modello XGBoost ha ottenuto le migliori prestazioni sul set di dati di input. Al momento della stesura di questo articolo, SageMaker Canvas può addestrare tre tipi di algoritmi ML: apprendimento lineare, XGBoost e un perceptron multistrato (MLP), ciascuno con un'ampia varietà di pipeline di preelaborazione e iperparametri. Per ulteriori informazioni su ciascun algoritmo, fare riferimento a pagina algoritmi supportati.

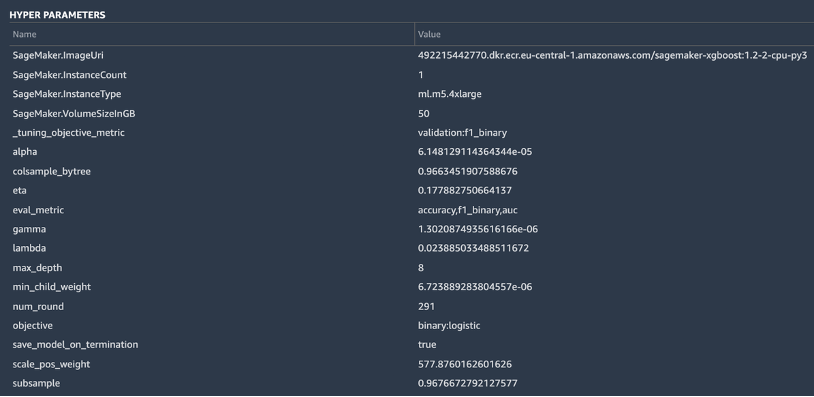

SageMaker include anche una funzionalità esplicativa grazie a un'implementazione scalabile ed efficiente di KernelSHAP, basato sul concetto di un valore Shapley dal campo della teoria dei giochi cooperativi che assegna a ciascuna caratteristica un valore di importanza per una particolare previsione. Ciò consente la trasparenza su come il modello è arrivato alle sue previsioni ed è molto utile definire l'importanza delle funzionalità. È possibile scaricare un rapporto di spiegazione completo che includa l'importanza delle funzionalità in formato PDF, notebook o dati grezzi. In tale report viene visualizzato un insieme più ampio di metriche nonché un elenco completo di iperparametri utilizzati durante il processo AutoML. Per ulteriori informazioni su come SageMaker fornisce strumenti di spiegazione integrati per soluzioni AutoML e algoritmi ML standard, vedere Utilizza strumenti di spiegazione integrati e migliora la qualità del modello utilizzando Amazon SageMaker Autopilot.

Infine, le altre schede in questa vista mostrano informazioni sui dettagli delle prestazioni (matrice di confusione, curva di richiamo di precisione, curva ROC), artefatti utilizzati per gli input e generati durante il lavoro AutoML e dettagli di rete.

A questo punto, il data scientist ha due scelte: distribuire direttamente il modello o creare una pipeline di formazione che può essere pianificata o attivata manualmente o automaticamente. Le sezioni seguenti forniscono alcune informazioni su entrambe le opzioni.

Distribuisci direttamente il modello

Se il data scientist è soddisfatto dei risultati ottenuti dal lavoro AutoML, può distribuire direttamente il modello da Dettagli del modello pagina. È semplice come scegliere Distribuisci modello accanto al nome del modello.

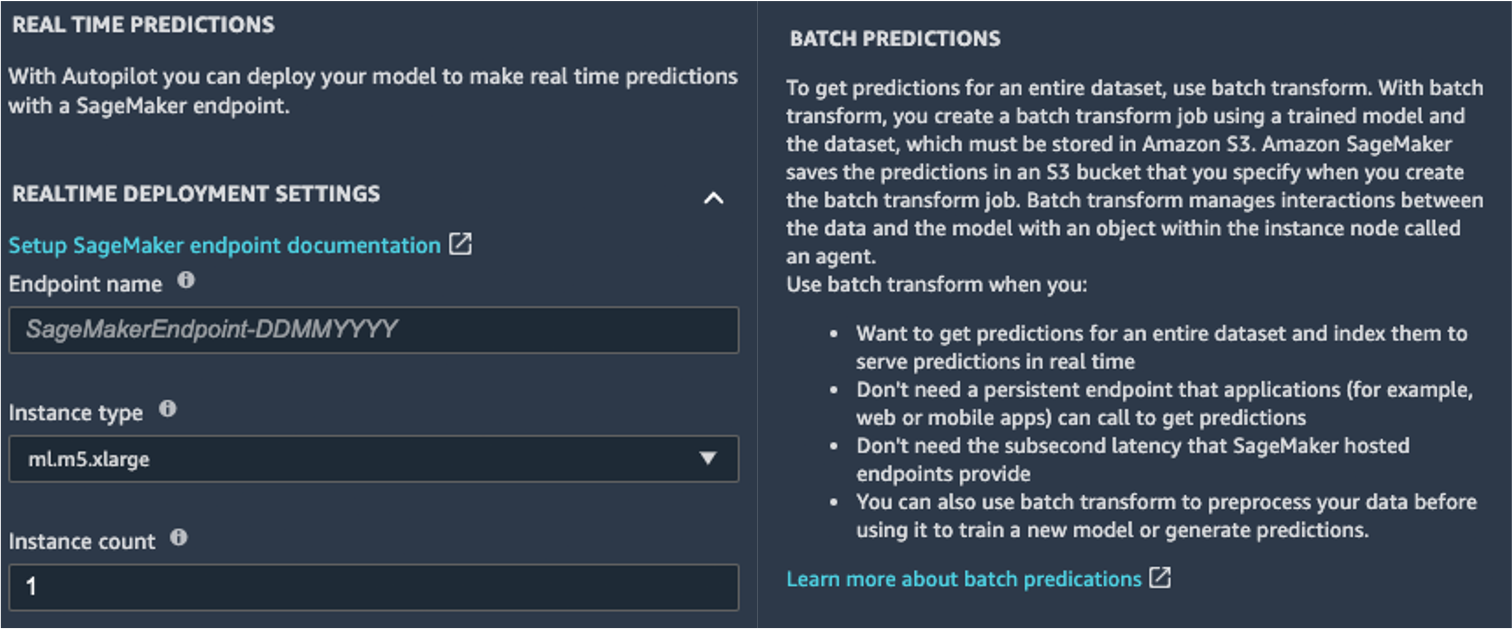

SageMaker ti mostra due opzioni per la distribuzione: un endpoint in tempo reale, alimentato da Endpoint Amazon SageMakere inferenza batch, alimentato da Trasformazione batch di Amazon SageMaker.

SageMaker fornisce anche altre modalità di inferenza. Per saperne di più, vedere Distribuire modelli per l'inferenza.

Per abilitare la modalità previsioni in tempo reale, è sufficiente assegnare all'endpoint un nome, un tipo di istanza e un conteggio di istanze. Poiché questo modello non richiede risorse di calcolo pesanti, puoi utilizzare un'istanza basata su CPU con un conteggio iniziale di 1. Puoi saperne di più sui diversi tipi di istanze disponibili e sulle relative specifiche sul Pagina dei prezzi di Amazon SageMaker (nel Prezzi su richiesta sezione, scegli il file Inferenza in tempo reale scheda). Se non sai quale istanza dovresti scegliere per la tua distribuzione, puoi anche chiedere a SageMaker di trovare quella migliore per te in base ai tuoi KPI utilizzando il Raccomandatore di inferenza di SageMaker. Puoi anche fornire parametri facoltativi aggiuntivi, in merito all'acquisizione o meno di dati di richieste e risposte da o verso l'endpoint. Questo può rivelarsi utile se stai pianificando monitorare il tuo modello. Puoi anche scegliere quale contenuto desideri fornire come parte della tua risposta, sia che si tratti solo della previsione o della probabilità di previsione, della probabilità di tutte le classi e delle etichette target.

Per eseguire un processo di assegnazione del punteggio batch ottenendo previsioni per un intero set di input contemporaneamente, è possibile avviare il processo di trasformazione batch dal Console di gestione AWS o tramite SageMaker Python SDK. Per ulteriori informazioni sulla trasformazione batch, fare riferimento a Usa la trasformazione in batch e i quaderni di esempio.

Definire una pipeline di formazione

Molto raramente, se non mai, i modelli ML possono essere considerati statici e immutabili, perché si discostano dalla linea di base su cui sono stati addestrati. I dati del mondo reale si evolvono nel tempo e da essi emergono più modelli e approfondimenti, che possono essere catturati o meno dal modello originale addestrato sui dati storici. Per risolvere questo problema, puoi impostare una pipeline di addestramento che riqualifica automaticamente i tuoi modelli con gli ultimi dati disponibili.

Nella definizione di questa pipeline, una delle opzioni del data scientist consiste nell'utilizzare ancora una volta AutoML per la pipeline di addestramento. È possibile avviare un processo AutoML a livello di codice richiamando l'API create_auto_ml_job() da SDK AWS Boto3. Puoi chiamare questa operazione da un AWS Lambda funzione all'interno di un Funzioni AWS Step flusso di lavoro o da un LambdaStep in Pipeline di Amazon SageMaker.

In alternativa, il data scientist può utilizzare la conoscenza, gli artefatti e gli iperparametri ottenuti dal lavoro AutoML per definire una pipeline di formazione completa. Hai bisogno delle seguenti risorse:

- L'algoritmo che ha funzionato meglio per il caso d'uso – Hai già ottenuto queste informazioni dal riepilogo del modello generato da Canvas. Per questo caso d'uso, è l'algoritmo integrato di XGBoost. Per istruzioni su come utilizzare SageMaker Python SDK per addestrare l'algoritmo XGBoost con SageMaker, fare riferimento a Usa XGBoost con SageMaker Python SDK.

- Gli iperparametri derivati dal lavoro AutoML – Questi sono disponibili nel Spiegabilità sezione. Puoi usarli come input durante la definizione del lavoro di formazione con SageMaker Python SDK.

- Il codice di progettazione delle funzionalità fornito nella sezione Artefatti – Puoi utilizzare questo codice sia per la preelaborazione dei dati prima dell'addestramento (ad esempio, tramite Amazon SageMaker Processing), sia prima dell'inferenza (ad esempio, come parte di una pipeline di inferenza SageMaker).

Puoi combinare queste risorse come parte di una pipeline SageMaker. Omettiamo i dettagli di implementazione in questo post: resta sintonizzato per ulteriori contenuti in arrivo su questo argomento.

Conclusione

SageMaker Canvas ti consente di utilizzare ML per generare previsioni senza dover scrivere alcun codice. Un analista aziendale può iniziare autonomamente a utilizzarlo con set di dati locali, oltre ai dati già archiviati Servizio di archiviazione semplice Amazon (Amazon S3), Amazon RedShift, o Fiocco di neve. Con pochi clic, possono preparare e unire i loro set di dati, analizzare l'accuratezza stimata, verificare quali colonne hanno un impatto, addestrare il modello con le migliori prestazioni e generare nuove previsioni individuali o batch, il tutto senza la necessità di coinvolgere un esperto di data scientist. Quindi, se necessario, possono condividere il modello con un team di data scientist o ingegneri MLOps, che importano i modelli in SageMaker Studio e collaborano con l'analista per fornire una soluzione di produzione.

Gli analisti aziendali possono ottenere informazioni dettagliate dai propri dati in modo indipendente senza una laurea in ML e senza dover scrivere una singola riga di codice. I data scientist ora possono avere più tempo per lavorare su progetti più impegnativi che possono utilizzare meglio la loro vasta conoscenza di AI e ML.

Riteniamo che questa nuova collaborazione apra le porte alla creazione di molte soluzioni ML più potenti per la tua azienda. Ora hai analisti che producono preziose informazioni sul business, consentendo ai data scientist e agli ingegneri ML di aiutarti a perfezionare, ottimizzare ed estendere secondo necessità.

Risorse addizionali

- Per ulteriori informazioni su come SageMaker può aiutare ulteriormente gli analisti aziendali, fare riferimento a Amazon SageMaker per analisti aziendali.

- Per saperne di più su come SageMaker consente ai data scientist di sviluppare, addestrare e distribuire i loro modelli ML, dai un'occhiata Amazon SageMaker per data scientist.

- Per ulteriori informazioni su come SageMaker può aiutare gli ingegneri MLOps a semplificare il ciclo di vita di ML utilizzando MLOps, fare riferimento a Amazon SageMaker per ingegneri MLOps.

Informazioni sugli autori

Davide Gallitelli è uno Specialist Solutions Architect per AI/ML nella regione EMEA. Ha sede a Bruxelles e lavora a stretto contatto con i clienti in tutto il Benelux. È uno sviluppatore sin da quando era molto giovane, iniziando a programmare all'età di 7 anni. Ha iniziato a studiare AI/ML all'università e da allora se ne è innamorato.

Davide Gallitelli è uno Specialist Solutions Architect per AI/ML nella regione EMEA. Ha sede a Bruxelles e lavora a stretto contatto con i clienti in tutto il Benelux. È uno sviluppatore sin da quando era molto giovane, iniziando a programmare all'età di 7 anni. Ha iniziato a studiare AI/ML all'università e da allora se ne è innamorato.

Marco Roy è un Principal Machine Learning Architect per AWS, che aiuta i clienti a progettare e realizzare soluzioni AI / ML. Il lavoro di Mark copre un'ampia gamma di casi d'uso del ML, con un interesse primario per la visione artificiale, il deep learning e la scalabilità del ML in tutta l'azienda. Ha aiutato aziende in molti settori, tra cui assicurazioni, servizi finanziari, media e intrattenimento, sanità, servizi pubblici e produzione. Mark detiene sei certificazioni AWS, inclusa la certificazione di specialità ML. Prima di entrare in AWS, Mark è stato architetto, sviluppatore e leader tecnologico per oltre 25 anni, di cui 19 nei servizi finanziari.

Marco Roy è un Principal Machine Learning Architect per AWS, che aiuta i clienti a progettare e realizzare soluzioni AI / ML. Il lavoro di Mark copre un'ampia gamma di casi d'uso del ML, con un interesse primario per la visione artificiale, il deep learning e la scalabilità del ML in tutta l'azienda. Ha aiutato aziende in molti settori, tra cui assicurazioni, servizi finanziari, media e intrattenimento, sanità, servizi pubblici e produzione. Mark detiene sei certificazioni AWS, inclusa la certificazione di specialità ML. Prima di entrare in AWS, Mark è stato architetto, sviluppatore e leader tecnologico per oltre 25 anni, di cui 19 nei servizi finanziari.

- Coinsmart. Il miglior scambio di bitcoin e criptovalute d'Europa.

- Platoblockchain. Web3 Metaverse Intelligence. Conoscenza amplificata. ACCESSO LIBERO.

- Criptofalco. Radar Altcoin. Prova gratuita.

- Fonte: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- codice-ml-e-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- Chi siamo

- accelerare

- accelerando

- accesso

- Secondo

- operanti in

- aggiuntivo

- Admin

- AI

- algoritmo

- Algoritmi

- Tutti

- Consentire

- già

- Amazon

- .

- analista

- api

- approccio

- RISERVATA

- in giro

- Automatizzata

- disponibile

- AWS

- Linea di base

- diventare

- MIGLIORE

- sistema

- Bruxelles

- costruire

- Costruzione

- costruisce

- incassato

- affari

- chiamata

- casi

- Certificazione

- scelte

- Cerchio

- classificazione

- codice

- collaborazione

- Colonna

- arrivo

- Aziende

- azienda

- complesso

- Calcolare

- concetto

- confusione

- contiene

- contenuto

- di controllo

- cooperativa

- Nucleo

- Costi

- credito

- curva

- Clienti

- dati

- scienza dei dati

- scienziato di dati

- consegna

- Richiesta

- schierare

- deployment

- Design

- rivelazione

- sviluppare

- Costruttori

- Mercato

- diverso

- distribuzione

- non

- dominio

- giù

- facilmente

- efficiente

- endpoint

- ingegnere

- Ingegneria

- Ingegneri

- Impresa

- Intrattenimento

- Ambiente

- stimato

- esempio

- esperimento

- esplorazione

- estendere

- più veloce

- caratteristica

- feedback

- finanziario

- servizi finanziari

- Nome

- flusso

- Focus

- i seguenti

- formato

- frode

- Gratis

- pieno

- function

- funzionalità

- gioco

- generare

- ottenere

- Dare

- Green

- Crescita

- avendo

- assistenza sanitaria

- Aiuto

- aiuta

- Highlight

- vivamente

- storico

- detiene

- Come

- Tutorial

- HTTPS

- centinaia

- importanza

- competenze

- includere

- Compreso

- Aumento

- individuale

- industrie

- informazioni

- intuizioni

- assicurazione

- integrare

- integrato

- interesse

- IT

- Lavoro

- Offerte di lavoro

- join

- conoscenze

- per il tuo brand

- con i più recenti

- lanciare

- IMPARARE

- apprendimento

- linea

- LINK

- Lista

- piccolo

- locale

- Lunghi

- cerca

- amore

- macchina

- machine learning

- gestione

- manualmente

- consigliato per la

- marchio

- Rappresentanza

- Matrice

- Media

- Metrica

- milione

- ML

- modello

- modelli

- mese

- cambiano

- Rete

- taccuino

- Offerte

- apre

- Operazioni

- Opzione

- Opzioni

- minimo

- organizzazione

- organizzazioni

- Altro

- performance

- prestazioni

- fase

- pianificazione

- Giocare

- Punto di vista

- possibile

- potente

- predizione

- Previsioni

- prezzi

- primario

- Direttore

- Problema

- processi

- produrre

- Produzione

- Prodotti

- progetti

- fornire

- fornisce

- traino

- qualità

- rapidamente

- gamma

- Crudo

- tempo reale

- ridurre

- rapporto

- richiedere

- Risorse

- risposta

- Risultati

- Le vendite

- Correre

- running

- scalabile

- scala

- Scienze

- Scienziato

- scienziati

- sdk

- selezionato

- Serie

- Servizi

- set

- Condividi

- condiviso

- Un'espansione

- SIX

- Taglia

- abilità

- allentato

- So

- Soluzioni

- RISOLVERE

- inizia a

- iniziato

- statistica

- conservazione

- negozi

- studio

- supporto

- Target

- team

- Tecnologia

- Testing

- L’ORIGINE

- per tutto

- tempo

- insieme

- strumenti

- top

- tradizionale

- Training

- forma

- Le transazioni

- Trasformare

- Trasparenza

- ui

- capire

- Università

- us

- uso

- APPREZZIAMO

- Visualizza

- visibilità

- visione

- Che

- se

- OMS

- entro

- senza

- Lavora

- lavorato

- lavoro

- lavori

- scrittura

- anni