Quando un cliente ha un prodotto pronto per la produzione elaborazione intelligente dei documenti (IDP), riceviamo spesso richieste per una revisione ben architettata. Per creare una soluzione aziendale, le risorse degli sviluppatori, i costi, il tempo e l'esperienza dell'utente devono essere bilanciati per ottenere il risultato aziendale desiderato. IL Framework ben progettato di AWS fornisce alle organizzazioni un modo sistematico per apprendere le migliori pratiche operative e architetturali per progettare e gestire carichi di lavoro affidabili, sicuri, efficienti, convenienti e sostenibili nel cloud.

La lente personalizzata IDP Well-Architected segue il Canone di architettura AWS, esaminando la soluzione con sei pilastri con la granularità di uno specifico caso d'uso di intelligenza artificiale o machine learning (ML) e fornendo la guida per affrontare le sfide comuni. La lente personalizzata IDP Well-Architected nella Strumento ben progettato contiene domande riguardanti ciascuno dei pilastri. Rispondendo a queste domande potrai identificare i potenziali rischi e risolverli seguendo il tuo piano di miglioramento.

Questo post si concentra su Pilastro dell’efficienza della prestazione del carico di lavoro degli sfollati interni. Ci immergiamo profondamente nella progettazione e nell'implementazione della soluzione per ottimizzare il throughput, la latenza e le prestazioni complessive. Inizieremo discutendo alcuni indicatori comuni che dovresti condurre in una revisione ben architettata e introducendo gli approcci fondamentali con i principi di progettazione. Successivamente esamineremo ciascuna area di interesse da un punto di vista tecnico.

Per seguire questo post, dovresti avere familiarità con i post precedenti di questa serie (Parte 1 ed Parte 2) e le linee guida in Linee guida per l'elaborazione intelligente dei documenti su AWS. Queste risorse introducono i servizi AWS comuni per i carichi di lavoro IDP e i flussi di lavoro suggeriti. Con queste conoscenze, ora sei pronto per saperne di più sulla produzione del tuo carico di lavoro.

Indicatori comuni

Di seguito sono riportati gli indicatori comuni che dovresti condurre una revisione del quadro ben architettato per il pilastro Efficienza delle prestazioni:

- Alta latenza – Quando la latenza del riconoscimento ottico dei caratteri (OCR), del riconoscimento delle entità o del flusso di lavoro end-to-end richiede più tempo rispetto al benchmark precedente, ciò potrebbe indicare che la progettazione dell'architettura non copre il test di carico o la gestione degli errori.

- Strozzamenti frequenti – Potresti riscontrare limitazioni da parte di servizi AWS come Testo Amazon causa limiti di richiesta. Ciò significa che l'architettura deve essere modificata rivedendo il flusso di lavoro dell'architettura, l'implementazione sincrona e asincrona, il calcolo delle transazioni al secondo (TPS) e altro ancora.

- Difficoltà di debug – Quando si verifica un errore nell'elaborazione del documento, potresti non disporre di un modo efficace per identificare dove si trova l'errore nel flusso di lavoro, a quale servizio è correlato e perché si è verificato l'errore. Ciò significa che il sistema non ha visibilità su log ed errori. Prendi in considerazione la possibilità di rivisitare la progettazione della registrazione dei dati di telemetria e di aggiungere alla soluzione l'infrastruttura come codice (IaC), ad esempio le pipeline di elaborazione dei documenti.

| Descrizione | Divario architettonico | |

| Alta latenza | La latenza dell'OCR, del riconoscimento delle entità o del flusso di lavoro end-to-end supera il benchmark precedente |

|

| Throttling frequente | Limitazione da parte di servizi AWS come Amazon Textract a causa dei limiti delle richieste |

|

| Difficile da eseguire il debug | Nessuna visibilità sulla posizione, sulla causa e sul motivo degli errori di elaborazione dei documenti |

|

Principi di progettazione

In questo post, discutiamo tre principi di progettazione: delega di attività AI complesse, architetture IaC e architetture serverless. Quando incontri un compromesso tra due implementazioni, puoi rivisitare i principi di progettazione con le priorità aziendali della tua organizzazione in modo da poter prendere decisioni in modo efficace.

- Delegare compiti complessi di intelligenza artificiale – Puoi consentire un'adozione più rapida dell'intelligenza artificiale nella tua organizzazione scaricando il ciclo di vita di sviluppo del modello ML su servizi gestiti e sfruttando lo sviluppo del modello e l'infrastruttura forniti da AWS. Invece di richiedere ai team IT e di data science di creare e mantenere modelli di intelligenza artificiale, puoi utilizzare servizi di intelligenza artificiale pre-addestrati in grado di automatizzare le attività per te. Ciò consente ai tuoi team di concentrarsi su lavori di valore più elevato che differenziano la tua azienda, mentre il fornitore di servizi cloud gestisce la complessità della formazione, dell'implementazione e del ridimensionamento dei modelli di intelligenza artificiale.

- Architetture IaC – Quando si esegue una soluzione IDP, la soluzione include più servizi AI per eseguire il flusso di lavoro end-to-end in ordine cronologico. È possibile progettare la soluzione con pipeline del flusso di lavoro utilizzando Funzioni AWS Step per migliorare la tolleranza agli errori, l'elaborazione parallela, la visibilità e la scalabilità. Questi vantaggi possono consentirti di ottimizzare l’utilizzo e il costo dei servizi di intelligenza artificiale sottostanti.

- serverless architetture – IDP è spesso una soluzione basata sugli eventi, avviata dai caricamenti degli utenti o dai lavori pianificati. La soluzione può essere scalata orizzontalmente aumentando le tariffe delle chiamate per i servizi AI, AWS Lambdae altri servizi coinvolti. Un approccio serverless fornisce scalabilità senza un provisioning eccessivo delle risorse, evitando spese inutili. Il monitoraggio alla base della progettazione serverless aiuta a rilevare i problemi di prestazioni.

Figura 1. Il vantaggio derivante dall'applicazione dei principi di progettazione.

Tenendo presenti questi tre principi di progettazione, le organizzazioni possono stabilire una base efficace per l'adozione di AI/ML su piattaforme cloud. Delegando la complessità, implementando un'infrastruttura resiliente e progettando su larga scala, le organizzazioni possono ottimizzare le proprie soluzioni AI/ML.

Nelle sezioni seguenti, discutiamo come affrontare le sfide comuni relative alle aree di interesse tecnico.

Aree di interesse

Quando esaminiamo l'efficienza delle prestazioni, esaminiamo la soluzione partendo da cinque aree di interesse: progettazione dell'architettura, gestione dei dati, gestione degli errori, monitoraggio del sistema e monitoraggio del modello. Con queste aree di interesse, puoi condurre una revisione dell'architettura da diversi aspetti per migliorare l'efficacia, l'osservabilità e la scalabilità dei tre componenti di un progetto, dati, modello o obiettivo aziendale AI/ML.

Progetto di architettura

Rispondendo alle domande in quest'area di interesse, esaminerai il flusso di lavoro esistente per vedere se segue le migliori pratiche. Il flusso di lavoro suggerito fornisce un modello comune che le organizzazioni possono seguire e previene i costi di tentativi ed errori.

Basato sul architettura proposta, il flusso di lavoro segue le sei fasi di acquisizione, classificazione, estrazione, arricchimento, revisione, convalida e consumo dei dati. Negli indicatori comuni di cui abbiamo parlato in precedenza, due su tre provengono da problemi di progettazione architettonica. Questo perché quando inizi un progetto con un approccio improvvisato, potresti incontrare dei vincoli di progetto quando provi ad allineare la tua infrastruttura alla tua soluzione. Con la revisione del progetto architettonico, il progetto improvvisato può essere disaccoppiato in fasi e ciascuna di esse può essere rivalutata e riordinata.

Puoi risparmiare tempo, denaro e manodopera implementando classificazioni nel tuo flusso di lavoro e i documenti vanno alle applicazioni e alle API downstream in base al tipo di documento. Ciò migliora l'osservabilità del processo documentale e rende la soluzione semplice da mantenere quando si aggiungono nuovi tipi di documenti.

Gestione dati

Le prestazioni di una soluzione IDP includono latenza, velocità effettiva ed esperienza utente end-to-end. Il modo in cui gestire il documento e le informazioni estratte nella soluzione è la chiave per la coerenza, la sicurezza e la privacy dei dati. Inoltre, la soluzione deve gestire elevati volumi di dati con bassa latenza e throughput elevato.

Nell'esaminare le domande di quest'area di interesse, esaminerai il flusso di lavoro del documento. Ciò include l'acquisizione di dati, la preelaborazione dei dati, la conversione di documenti in tipi di documenti accettati da Amazon Textract, la gestione dei flussi di documenti in entrata, l'instradamento di documenti per tipo e l'implementazione di policy di controllo e conservazione degli accessi.

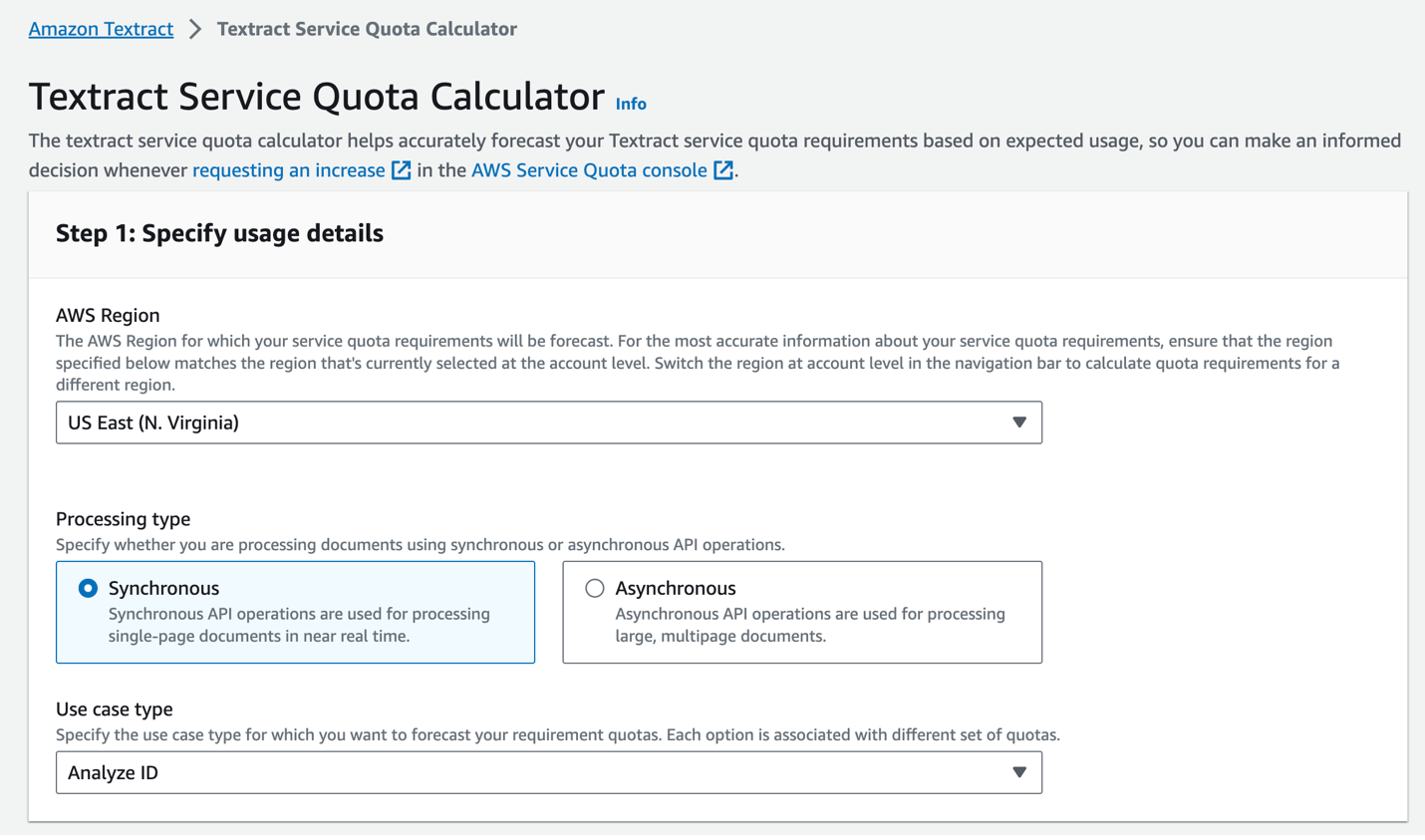

Ad esempio, memorizzando un documento nelle diverse fasi elaborate, è possibile, se necessario, riportare l'elaborazione al passaggio precedente. Il ciclo di vita dei dati garantisce l'affidabilità e la conformità per il carico di lavoro. Utilizzando il Calcolatore delle quote del servizio Amazon Textract (vedi lo screenshot seguente), funzionalità asincrone su Amazon Textract, Lambda, Step Functions, Servizio Amazon Simple Queue (Amazon SQS) e Servizio di notifica semplice Amazon (Amazon SNS), le organizzazioni possono automatizzare e ridimensionare le attività di elaborazione dei documenti per soddisfare esigenze specifiche di carico di lavoro.

Figura 2. Calcolatore della quota del servizio Amazon Textract.

Gestione degli errori

Una gestione efficace degli errori è fondamentale per tenere traccia dello stato del processo dei documenti e fornisce al team operativo il tempo necessario per reagire a eventuali comportamenti anomali, come volumi di documenti imprevisti, nuovi tipi di documenti o altri problemi non pianificati da servizi di terze parti. Dal punto di vista dell'organizzazione, una corretta gestione degli errori può migliorare il tempo di attività e le prestazioni del sistema.

È possibile suddividere la gestione degli errori in due aspetti chiave:

- Configurazione del servizio AWS – È possibile implementare la logica dei nuovi tentativi con backoff esponenziale per gestire errori temporanei come la limitazione. Quando si avvia l'elaborazione chiamando un'operazione asincrona Start*, ad esempio Avvia DocumentTextDetection, puoi specificare che lo stato di completamento della richiesta venga pubblicato in un argomento SNS nel file Canale di notifica configurazione. Ciò ti aiuta a evitare limiti di limitazione sulle chiamate API a causa del polling delle API Get*. Puoi anche implementare gli allarmi in Amazon Cloud Watch e si attiva per avvisare quando si verificano picchi di errori insoliti.

- Miglioramento del rapporto errori – Ciò include messaggi dettagliati con un livello di dettaglio adeguato per tipo di errore e descrizioni delle risposte di gestione degli errori. Con la corretta configurazione della gestione degli errori, i sistemi possono essere più resilienti implementando modelli comuni come il nuovo tentativo automatico di errori intermittenti, l'utilizzo di interruttori automatici per gestire i guasti a cascata e il monitoraggio dei servizi per ottenere informazioni dettagliate sugli errori. Ciò consente alla soluzione di bilanciare i limiti di tentativi e impedisce cicli di circuito infiniti.

Monitoraggio del modello

Le prestazioni dei modelli ML vengono monitorate per verificarne il degrado nel tempo. Man mano che i dati e le condizioni del sistema cambiano, le prestazioni del modello e i parametri di efficienza vengono monitorati per garantire che venga eseguita la riqualificazione quando necessario.

Il modello ML in un flusso di lavoro IDP può essere un modello OCR, un modello di riconoscimento delle entità o un modello di classificazione. Il modello può provenire da un servizio AI AWS, un modello open source in poi Amazon Sage Maker, Roccia Amazzonicao altri servizi di terze parti. È necessario comprendere le limitazioni e i casi d'uso di ciascun servizio per identificare modi per migliorare il modello con feedback umano e migliorare le prestazioni del servizio nel tempo.

Un approccio comune consiste nell'utilizzare i log di servizio per comprendere diversi livelli di precisione. Questi log possono aiutare il team di data science a identificare e comprendere qualsiasi esigenza di riqualificazione del modello. La tua organizzazione può scegliere il meccanismo di riqualificazione: può essere trimestrale, mensile o basato su parametri scientifici, ad esempio quando la precisione scende al di sotto di una determinata soglia.

L'obiettivo del monitoraggio non è solo rilevare i problemi, ma chiudere il ciclo per perfezionare continuamente i modelli e mantenere le prestazioni della soluzione IDP man mano che l'ambiente esterno si evolve.

monitoraggio dell'impianto

Dopo aver distribuito la soluzione IDP in produzione, è importante monitorare i parametri chiave e le prestazioni di automazione per identificare le aree di miglioramento. Le metriche dovrebbero includere metriche aziendali e metriche tecniche. Ciò consente all'azienda di valutare le prestazioni del sistema, identificare i problemi e apportare miglioramenti a modelli, regole e flussi di lavoro nel tempo per aumentare il tasso di automazione per comprendere l'impatto operativo.

Dal punto di vista aziendale, parametri come l’accuratezza dell’estrazione per campi importanti, il tasso di automazione complessivo che indica la percentuale di documenti elaborati senza intervento umano e il tempo medio di elaborazione per documento sono fondamentali. Queste metriche aziendali aiutano a quantificare l'esperienza dell'utente finale e i guadagni in termini di efficienza operativa.

Le metriche tecniche, inclusi i tassi di errore ed eccezione che si verificano durante il flusso di lavoro, sono essenziali da monitorare dal punto di vista ingegneristico. I parametri tecnici possono anche monitorare a ogni livello dall'inizio alla fine e fornire una visione completa di un carico di lavoro complesso. È possibile suddividere i parametri in diversi livelli, ad esempio livello della soluzione, livello del flusso di lavoro end-to-end, livello del tipo di documento, livello del documento, livello di riconoscimento dell'entità e livello OCR.

Ora che hai esaminato tutte le domande di questo pilastro, puoi valutare gli altri pilastri e sviluppare un piano di miglioramento per il carico di lavoro IDP.

Conclusione

In questo post abbiamo discusso degli indicatori comuni di cui potresti aver bisogno per eseguire una revisione del Well-Architected Framework per il pilastro Efficienza delle prestazioni per il tuo carico di lavoro IDP. Abbiamo quindi esaminato i principi di progettazione per fornire una panoramica di alto livello e discutere l'obiettivo della soluzione. Seguendo questi suggerimenti in riferimento alla lente personalizzata IDP Well-Architected ed esaminando le domande per area di interesse, ora dovresti avere un piano di miglioramento del progetto.

Informazioni sugli autori

Mia Chang è un ML Specialist Solutions Architect per Amazon Web Services. Lavora con clienti nell'area EMEA e condivide le best practice per l'esecuzione di carichi di lavoro AI/ML sul cloud con il suo background in matematica applicata, informatica e AI/ML. Si concentra su carichi di lavoro specifici della PNL e condivide la sua esperienza come relatrice di conferenze e autrice di libri. Nel tempo libero le piacciono le escursioni, i giochi da tavolo e la preparazione del caffè.

Mia Chang è un ML Specialist Solutions Architect per Amazon Web Services. Lavora con clienti nell'area EMEA e condivide le best practice per l'esecuzione di carichi di lavoro AI/ML sul cloud con il suo background in matematica applicata, informatica e AI/ML. Si concentra su carichi di lavoro specifici della PNL e condivide la sua esperienza come relatrice di conferenze e autrice di libri. Nel tempo libero le piacciono le escursioni, i giochi da tavolo e la preparazione del caffè.

Brijesh Pati è un Enterprise Solutions Architect presso AWS. Il suo obiettivo principale è aiutare i clienti aziendali ad adottare le tecnologie cloud per i loro carichi di lavoro. Ha esperienza nello sviluppo di applicazioni e nell'architettura aziendale e ha lavorato con clienti di vari settori come sport, finanza, energia e servizi professionali. I suoi interessi includono architetture serverless e AI/ML.

Brijesh Pati è un Enterprise Solutions Architect presso AWS. Il suo obiettivo principale è aiutare i clienti aziendali ad adottare le tecnologie cloud per i loro carichi di lavoro. Ha esperienza nello sviluppo di applicazioni e nell'architettura aziendale e ha lavorato con clienti di vari settori come sport, finanza, energia e servizi professionali. I suoi interessi includono architetture serverless e AI/ML.

Rui Cardoso è un architetto di soluzioni partner presso Amazon Web Services (AWS). Si sta concentrando su AI/ML e IoT. Lavora con i partner AWS e li supporta nello sviluppo di soluzioni in AWS. Quando non lavora, gli piace andare in bicicletta, fare escursioni e imparare cose nuove.

Rui Cardoso è un architetto di soluzioni partner presso Amazon Web Services (AWS). Si sta concentrando su AI/ML e IoT. Lavora con i partner AWS e li supporta nello sviluppo di soluzioni in AWS. Quando non lavora, gli piace andare in bicicletta, fare escursioni e imparare cose nuove.

Tim Condel è un architetto senior di soluzioni specializzato in intelligenza artificiale (AI) e machine learning (ML) presso Amazon Web Services (AWS). Il suo focus è l'elaborazione del linguaggio naturale e la visione artificiale. A Tim piace prendere le idee dei clienti e trasformarle in soluzioni scalabili.

Tim Condel è un architetto senior di soluzioni specializzato in intelligenza artificiale (AI) e machine learning (ML) presso Amazon Web Services (AWS). Il suo focus è l'elaborazione del linguaggio naturale e la visione artificiale. A Tim piace prendere le idee dei clienti e trasformarle in soluzioni scalabili.

Sherry Ding è un architetto senior di soluzioni specializzato in intelligenza artificiale (AI) e machine learning (ML) presso Amazon Web Services (AWS). Ha una vasta esperienza nell'apprendimento automatico con un dottorato di ricerca in informatica. Lavora principalmente con clienti del settore pubblico su varie sfide aziendali legate all'intelligenza artificiale/ML, aiutandoli ad accelerare il loro percorso di apprendimento automatico sul cloud AWS. Quando non aiuta i clienti, le piacciono le attività all'aria aperta.

Sherry Ding è un architetto senior di soluzioni specializzato in intelligenza artificiale (AI) e machine learning (ML) presso Amazon Web Services (AWS). Ha una vasta esperienza nell'apprendimento automatico con un dottorato di ricerca in informatica. Lavora principalmente con clienti del settore pubblico su varie sfide aziendali legate all'intelligenza artificiale/ML, aiutandoli ad accelerare il loro percorso di apprendimento automatico sul cloud AWS. Quando non aiuta i clienti, le piacciono le attività all'aria aperta.

Suyin Wang è un AI/ML Specialist Solutions Architect presso AWS. Ha un background formativo interdisciplinare in machine learning, servizi di informazione finanziaria ed economia, oltre ad anni di esperienza nella creazione di applicazioni di data science e machine learning che hanno risolto problemi aziendali reali. Le piace aiutare i clienti a identificare le giuste domande aziendali e a creare le giuste soluzioni AI/ML. Nel tempo libero ama cantare e cucinare.

Suyin Wang è un AI/ML Specialist Solutions Architect presso AWS. Ha un background formativo interdisciplinare in machine learning, servizi di informazione finanziaria ed economia, oltre ad anni di esperienza nella creazione di applicazioni di data science e machine learning che hanno risolto problemi aziendali reali. Le piace aiutare i clienti a identificare le giuste domande aziendali e a creare le giuste soluzioni AI/ML. Nel tempo libero ama cantare e cucinare.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/build-well-architected-idp-solutions-with-a-custom-lens-part-4-performance-efficiency/

- :ha

- :È

- :non

- :Dove

- 1

- 10

- 100

- 32

- 7

- 8

- a

- WRI

- accelerare

- accettato

- accesso

- precisione

- Raggiungere

- attività

- l'aggiunta di

- Inoltre

- indirizzo

- Rettificato

- adottare

- Adozione

- Vantaggio

- vantaggi

- AI

- Modelli AI

- Servizi di intelligenza artificiale

- AI / ML

- Mettere in guardia

- allineare

- Tutti

- consente

- lungo

- anche

- Amazon

- Testo Amazon

- Amazon Web Services

- Amazon Web Services (AWS)

- an

- ed

- e infrastruttura

- in qualsiasi

- api

- API

- Applicazioni

- Sviluppo di applicazioni

- applicazioni

- applicato

- AMMISSIONE

- approccio

- approcci

- opportuno

- architettonico

- architettura

- SONO

- RISERVATA

- aree

- artificiale

- intelligenza artificiale

- Intelligenza artificiale (AI)

- AS

- aspetti

- valutare

- assist

- At

- autore

- automatizzare

- automaticamente

- Automazione

- media

- evitare

- AWS

- sfondo

- Equilibrio

- balanced

- basato

- BE

- perché

- comportamenti

- dietro

- sotto

- Segno di riferimento

- beneficio

- MIGLIORE

- best practice

- fra

- tavola

- Giochi da tavolo

- libro

- Rompere

- costruire

- Costruzione

- affari

- ma

- by

- calcolo

- chiamata

- chiamata

- Bandi

- Materiale

- catturare

- Custodie

- casi

- Causare

- sfide

- il cambiamento

- carattere

- riconoscimento del personaggio

- Scegli

- classificazione

- chiusura

- Cloud

- codice

- Caffè

- Venire

- Uncommon

- azienda

- completamento

- complesso

- complessità

- conformità

- componenti

- globale

- computer

- Informatica

- Visione computerizzata

- condizioni

- Segui il codice di Condotta

- Convegno

- Configurazione

- Prendere in considerazione

- consumo

- contiene

- continuamente

- di controllo

- conversione

- Costo

- costo effettivo

- Costi

- coprire

- critico

- costume

- cliente

- Clienti

- dati

- gestione dei dati

- scienza dei dati

- decisioni

- disaccoppiato

- deep

- Laurea

- schierare

- distribuzione

- Design

- Principi di progettazione

- progettazione

- desiderato

- dettaglio

- dettagliati

- sviluppare

- Costruttori

- in via di sviluppo

- Mercato

- diverso

- le difficoltà

- discutere

- discusso

- discutere

- immersione

- documento

- processo documentale

- documenti

- non

- giù

- Gocce

- dovuto

- ogni

- In precedenza

- Economia

- Istruzione

- Efficace

- in maniera efficace

- efficienza

- efficiente

- enable

- fine

- da un capo all'altro

- energia

- Ingegneria

- accrescere

- Migliora

- arricchimento

- garantire

- assicura

- Impresa

- entità

- Ambiente

- errore

- errori

- essential

- stabilire

- valutare

- si evolve

- esempio

- supera

- eccezione

- esistente

- spese

- esperienza

- esponenziale

- estensivo

- Conclamata Esperienza

- esterno

- estrazione

- Fallimento

- fallimenti

- familiare

- più veloce

- Caratteristiche

- feedback

- campi

- figura

- finanziare

- finanziario

- informazioni finanziarie

- cinque

- Focus

- si concentra

- messa a fuoco

- seguire

- i seguenti

- segue

- Nel

- Fondazione

- Contesto

- Gratis

- da

- funzioni

- fondamentale

- Guadagno

- Guadagni

- Giochi

- dato

- Go

- scopo

- andando

- guida

- linee guida

- maniglia

- Maniglie

- Manovrabilità

- Avere

- he

- Aiuto

- aiutare

- aiuta

- suo

- Alta

- alto livello

- il suo

- orizzontalmente

- Come

- Tutorial

- HTML

- http

- HTTPS

- umano

- idee

- identificare

- if

- Impact

- realizzare

- implementazione

- implementazioni

- Implementazione

- importante

- competenze

- miglioramento

- miglioramenti

- in

- includere

- inclusi

- Compreso

- In arrivo

- Aumento

- crescente

- industrie

- informazioni

- Infrastruttura

- avviato

- intuizione

- Intelligence

- Intelligente

- Elaborazione intelligente dei documenti

- interessi

- intervento

- ai miglioramenti

- introdurre

- coinvolto

- IoT

- sicurezza

- IT

- SUO

- Offerte di lavoro

- viaggio

- jpg

- ad appena

- mantenere

- Le

- conoscenze

- lavoro

- Lingua

- Latenza

- IMPARARE

- apprendimento

- Livello

- livelli

- ciclo di vita

- piace

- limiti

- limiti

- caricare

- collocato

- località

- registrazione

- logica

- più a lungo

- ama

- Basso

- macchina

- machine learning

- principalmente

- mantenere

- make

- FA

- gestire

- gestito

- gestione

- matematica

- Maggio..

- si intende

- Soddisfare

- messaggi

- Metrica

- mente

- ML

- modello

- modelli

- soldi

- Monitorare

- monitorati

- monitoraggio

- mensile

- Scopri di più

- multiplo

- devono obbligatoriamente:

- Naturale

- Elaborazione del linguaggio naturale

- Bisogno

- di applicazione

- esigenze

- New

- notifica

- adesso

- si è verificato

- verificano

- OCR

- of

- di frequente

- on

- aprire

- open source

- operativo

- operazione

- operativa

- riconoscimento ottico dei caratteri

- OTTIMIZZA

- or

- minimo

- organizzazione

- organizzazioni

- Altro

- su

- Risultato

- ancora

- complessivo

- panoramica

- Parallel

- supremo

- parte

- partner

- partner

- Cartamodello

- modelli

- per

- percentuale

- Eseguire

- performance

- eseguita

- esecuzione

- prospettiva

- phd

- Pilastro

- pilastri

- piano

- Piattaforme

- Platone

- Platone Data Intelligence

- PlatoneDati

- Termini e Condizioni

- Post

- Post

- potenziale

- pratiche

- prevenzione

- impedisce

- precedente

- primario

- principi

- Privacy

- problemi

- processi

- Elaborato

- lavorazione

- Produzione

- professionale

- progetto

- corretto

- fornire

- purché

- fornitore

- fornisce

- fornitura

- la percezione

- pubblicato

- Domande

- tasso

- piuttosto

- Reagire

- pronto

- mondo reale

- ragione

- ricevere

- riconoscimento

- riferimento

- raffinare

- per quanto riguarda

- Saluti

- relazionato

- problemi di

- affidabile

- rapporto

- richiesta

- richieste

- elastico

- risolvere

- Risorse

- risposte

- ritenzione

- invertire

- recensioni

- rivisto

- revisione

- destra

- rischi

- instradamento

- norme

- running

- Risparmi

- Scalabilità

- scalabile

- Scala

- scala

- in programma

- Lavori pianificati

- Scienze

- Secondo

- sezioni

- settore

- sicuro

- problemi di

- vedere

- anziano

- Serie

- serverless

- servizio

- Servizi

- flessibile.

- azioni

- lei

- dovrebbero

- lato

- Un'espansione

- SIX

- So

- soluzione

- Soluzioni

- alcuni

- Fonte

- Speaker

- specialista

- specifico

- picchi

- Sports

- tappe

- inizia a

- Stato dei servizi

- step

- memorizzare

- lineare

- flussi

- tale

- supporto

- sostenibile

- sistema

- SISTEMI DI TRATTAMENTO

- attrezzatura

- prende

- presa

- task

- team

- le squadre

- Consulenza

- Tecnologie

- Testing

- di

- che

- Il

- loro

- Li

- poi

- Strumenti Bowman per analizzare le seguenti finiture:

- cose

- di parti terze standard

- questo

- tre

- soglia

- Attraverso

- per tutto

- portata

- Tim

- tempo

- a

- tolleranza

- argomento

- tps

- pista

- Tracking

- Training

- Le transazioni

- cerca

- Svolta

- seconda

- Digitare

- Tipi di

- sottostante

- capire

- Inaspettato

- inutile

- uptime

- Impiego

- uso

- caso d'uso

- Utente

- Esperienza da Utente

- utilizzando

- convalida

- vario

- Visualizza

- visibilità

- visione

- volumi

- vs

- camminava

- Modo..

- modi

- we

- sito web

- servizi web

- quando

- quale

- while

- perché

- volere

- con

- senza

- Lavora

- lavorato

- flusso di lavoro

- flussi di lavoro

- lavoro

- lavori

- anni

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro