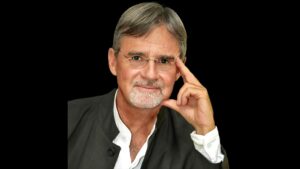

Dall'utilizzo di supercomputer per sfruttare nuovi tipi di materiali all'addestramento di modelli di apprendimento automatico per studiare proprietà complesse su scala nanometrica, La scienziata computazionale australiana Amanda Barnard funziona all'interfaccia tra informatica e scienza dei dati. Un professore senior del Scuola di Informatica presso l'Università Nazionale Australiana, Barnard è anche vicedirettore e responsabile della scienza computazionale. Oggigiorno utilizza una varietà di metodi computazionali per risolvere problemi nelle scienze fisiche, ma Barnard ha iniziato la sua carriera come fisico, conseguendo il dottorato in fisica teorica della materia condensata nel 2003.

Dopo aver trascorso gli anni successivi come postdoc presso l' Centro per i materiali su scala nanometrica presso l'Argonne National Laboratory negli Stati Uniti, ha iniziato ad ampliare i suoi interessi di ricerca per comprendere molti aspetti della scienza computazionale, compreso l'uso dell'apprendimento automatico nelle nanotecnologie, nella scienza dei materiali, nella chimica e nella medicina.

Un compagno di entrambi i Istituto australiano di fisica e la Società Reale di Chimica, nel 2022 Barnard è stato nominato a Membro dell'Ordine dell'Australia. Ha anche vinto numerosi premi, tra cui il Premio Feynman 2014 per le nanotecnologie (Teoria) e il Medaglia 2019 dell'Association of Molecular Modellers of Australasia. Parla con Hamish Johnston del suo interesse nell'applicazione dell'apprendimento automatico a una serie di problemi e delle sfide e dei vantaggi derivanti dall'amministrazione universitaria.

Puoi raccontarci qualcosa di ciò che fai come scienziato computazionale?

La scienza computazionale prevede la progettazione e l'utilizzo di modelli matematici per analizzare problemi computazionalmente impegnativi in molte aree della scienza e dell'ingegneria. Ciò include progressi nell’infrastruttura computazionale e negli algoritmi che consentono ai ricercatori di questi diversi domini di eseguire esperimenti computazionali su larga scala. In un certo senso, la scienza computazionale implica la ricerca sul calcolo ad alte prestazioni e non solo la ricerca che utilizza un computer ad alte prestazioni.

Dedichiamo la maggior parte del nostro tempo agli algoritmi e cerchiamo di capire come implementarli in modo da sfruttare al meglio l'hardware avanzato; e quell'hardware cambia continuamente. Ciò include simulazioni convenzionali basate su modelli matematici sviluppati specificamente in diversi ambiti scientifici, siano essi fisica, chimica o altro. Trascorriamo anche molto tempo utilizzando metodi da machine learning (ML) e intelligenza artificiale (AI), la maggior parte dei quali sono stati sviluppati da scienziati informatici, rendendola una ricerca molto interdisciplinare. Ciò consente di utilizzare tutta una serie di nuovi approcci in tutte queste diverse aree scientifiche.

L'apprendimento automatico ci consente di riconquistare gran parte della complessità che abbiamo perso quando deriviamo quelle bellissime teorie

La simulazione è nata dagli aspetti teorici di ogni area scientifica che, con alcuni convenienti livelli di astrazione, hanno permesso di risolvere le equazioni. Ma quando sviluppammo quelle teorie, si trattava quasi di una semplificazione eccessiva del problema, fatta o per ricerca di eleganza matematica o semplicemente per motivi pratici. Il machine learning ci consente di recuperare gran parte della complessità che abbiamo perso quando deriviamo quelle bellissime teorie. Ma sfortunatamente, non tutto il ML funziona bene con la scienza, quindi gli scienziati computazionali trascorrono molto tempo cercando di capire come applicare questi algoritmi che non sono mai stati pensati per essere utilizzati per questo tipo di set di dati per superare alcuni dei problemi che sono sperimentato all'interfaccia. E questa è una delle aree entusiasmanti che mi piacciono.

Hai iniziato la tua carriera come fisico. Cosa ti ha spinto a passare alla scienza computazionale?

La fisica è un ottimo punto di partenza praticamente per qualsiasi cosa. Ma ero sempre sulla strada della scienza computazionale senza rendermene conto. Durante il mio primo progetto di ricerca da studente, ho utilizzato metodi computazionali e ne sono rimasto subito affascinato. Ho amato la programmazione, dalla scrittura del codice fino ai risultati finali, e così ho capito subito che i supercomputer erano destinati a diventare il mio strumento scientifico. È stato emozionante pensare a cosa potrebbe fare uno scienziato dei materiali se potesse realizzare ogni volta campioni perfetti. O cosa potrebbe fare un chimico se potesse rimuovere tutte le contaminazioni e ottenere reazioni perfette. Cosa potremmo fare se potessimo esplorare ambienti difficili o pericolosi senza il rischio di ferire qualcuno? E, cosa ancora più importante, cosa accadrebbe se potessimo fare tutte queste cose contemporaneamente, su richiesta, ogni volta che ci proviamo?

La bellezza dei supercomputer è che sono l’unico strumento che ci consente di raggiungere questo livello quasi perfetto. Ciò che mi affascina di più è che non solo posso riprodurre ciò che i miei colleghi possono fare in laboratorio, ma anche fare tutto ciò che loro non possono fare in laboratorio. Quindi, fin dai primi giorni, la mia fisica computazionale era su un computer. La mia chimica computazionale si è poi evoluta fino ai materiali, all'informatica dei materiali e ora praticamente esclusivamente al machine learning. Ma mi sono sempre concentrato sui metodi in ciascuna di queste aree, e penso che una base di fisica mi permetta di pensare in modo molto creativo su come affrontare tutte queste altre aree dal punto di vista computazionale.

In cosa differisce il machine learning dalle classiche simulazioni computerizzate?

La maggior parte della mia ricerca ora riguarda il machine learning, probabilmente l’80%. Faccio ancora alcune simulazioni convenzionali, tuttavia, poiché mi danno qualcosa di molto diverso. Le simulazioni sono fondamentalmente un approccio dal basso verso l’alto. Iniziamo con la comprensione di un sistema o di un problema, eseguiamo una simulazione e alla fine otteniamo alcuni dati. Il ML, al contrario, è un approccio top-down. Iniziamo con i dati, eseguiamo un modello e infine arriviamo a comprendere meglio il sistema o il problema. La simulazione si basa su regole determinate dalle nostre teorie scientifiche consolidate, mentre il machine learning si basa su esperienze e storia. Le simulazioni sono spesso in gran parte deterministiche, sebbene esistano alcuni esempi di metodi stocastici come Monte Carlo. Il ML è in gran parte stocastico, sebbene ci siano alcuni esempi anche deterministici.

Con le simulazioni, sono in grado di fare un'ottima estrapolazione. Molte delle teorie alla base delle simulazioni ci consentono di esplorare aree di uno “spazio di configurazione” (le coordinate che determinano tutti i possibili stati di un sistema) o aree di un problema per il quale non disponiamo di dati o informazioni. D'altra parte, il machine learning è davvero bravo a interpolare e a colmare tutte le lacune ed è ottimo per l'inferenza.

In effetti, i due metodi si basano su logiche molto diverse. La simulazione si basa su una logica "if-then-else", il che significa che se ho un certo problema o un certo insieme di condizioni, otterrò una risposta deterministica altrimenti, computazionalmente, probabilmente andrà in crash se ottieni sbagliato. Il ML, al contrario, si basa su una logica “stima-miglioramento-ripetizione”, il che significa che fornirà sempre una risposta. Questa risposta è sempre migliorabile, ma potrebbe non essere sempre corretta, quindi questa è un'altra differenza.

Le simulazioni sono intradisciplinari: hanno un rapporto molto stretto con la conoscenza del dominio e si basano sull'intelligenza umana. D’altro canto, il machine learning è interdisciplinare: utilizzando modelli sviluppati al di fuori del dominio originale, è agnostico rispetto alla conoscenza del dominio e fa molto affidamento sull’intelligenza artificiale. Per questo mi piace combinare i due approcci.

Puoi dirci qualcosa in più su come utilizzi il machine learning nella tua ricerca?

Prima dell’avvento del machine learning, gli scienziati dovevano comprendere a fondo le relazioni tra input e output. Dovevamo avere la struttura del modello predeterminata prima di poterlo risolvere. Ciò significava che dovevamo avere un'idea della risposta prima di poterla cercare.

Possiamo sviluppare la struttura di un'espressione o di un'equazione e risolverla allo stesso tempo. Ciò accelera il metodo scientifico ed è un altro motivo per cui mi piace utilizzare l'apprendimento automatico

Quando si utilizza il machine learning, le macchine utilizzano tecniche statistiche e informazioni storiche per programmarsi sostanzialmente da sole. Significa che possiamo sviluppare la struttura di un'espressione o di un'equazione e risolverla allo stesso tempo. Ciò accelera il metodo scientifico ed è un altro motivo per cui mi piace usarlo.

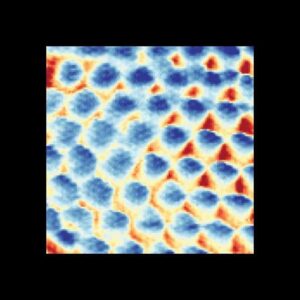

Le tecniche ML che utilizzo sono diverse. Esistono molti tipi e tipi diversi di ML, proprio come esistono molti tipi diversi di fisica computazionale o metodi di fisica sperimentale. Utilizzo l'apprendimento non supervisionato, che si basa interamente su variabili di input, e cerca di sviluppare "modelli nascosti" o cercare di trovare dati rappresentativi. Ciò è utile per i materiali nella nanoscienza, quando non abbiamo fatto esperimenti per misurare magari una proprietà, ma sappiamo abbastanza delle condizioni di input che abbiamo inserito per sviluppare il materiale.

L'apprendimento non supervisionato può essere utile per trovare gruppi di strutture, denominati cluster, che presentano somiglianze nello spazio ad alta dimensione, o strutture pure e rappresentative (archetipi o prototipi) che descrivono il set di dati nel suo insieme. Possiamo anche trasformare i dati per mapparli in uno spazio di dimensione inferiore e rivelare più somiglianze che prima non erano evidenti, in un modo simile a quello che potremmo cambiare nello spazio reciproco in fisica.

Utilizzo anche il machine learning supervisionato per trovare relazioni e tendenze, come le relazioni struttura-proprietà, che sono importanti nei materiali e nella nanoscienza. Ciò include la classificazione, dove abbiamo un'etichetta discreta. Supponiamo di avere già diverse categorie di nanoparticelle e, in base alle loro caratteristiche, di volerle assegnare automaticamente a una categoria o a un'altra e di assicurarci di poter separare facilmente queste classi basandosi solo sui dati di input.

Utilizzo anche l'apprendimento statistico e l'apprendimento semi-supervisionato. L'apprendimento statistico, in particolare, è utile nella scienza, sebbene non sia ancora ampiamente utilizzato. Pensiamo a ciò come a un'inferenza causale utilizzata molto nella diagnostica medica e che può essere applicata per diagnosticare efficacemente come un materiale, ad esempio, potrebbe essere creato, piuttosto che semplicemente il motivo per cui è stato creato.

Il tuo gruppo di ricerca comprende persone con una vasta gamma di interessi scientifici. Puoi darci un assaggio di alcune delle cose che stanno studiando?

Quando ho iniziato a studiare fisica, non avrei mai pensato di essere circondato da un gruppo così straordinario di persone intelligenti provenienti da diverse aree scientifiche. Il cluster di scienze computazionali dell'Università Nazionale Australiana comprende scienziati ambientali, scienziati della terra, biologi computazionali e bioinformatici. Ci sono anche ricercatori che studiano genomica, neuroscienze computazionali, chimica quantistica, scienza dei materiali, fisica del plasma, astrofisica, astronomia, ingegneria e – io – nanotecnologia. Quindi siamo un gruppo eterogeneo.

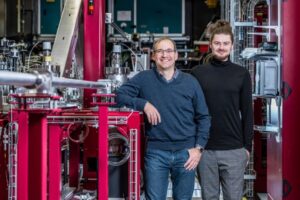

Il nostro gruppo include Giuseppe Barca, che sta sviluppando algoritmi su cui si basano i pacchetti software di chimica quantistica utilizzati in tutto il mondo. La sua ricerca si concentra su come possiamo sfruttare nuovi processori, come gli acceleratori, e su come possiamo ripensare al modo in cui le grandi molecole possono essere partizionate e frammentate in modo da poter combinare strategicamente flussi di lavoro massicciamente paralleli. Ci sta anche aiutando a utilizzare i supercomputer in modo più efficiente, risparmiando energia. E negli ultimi due anni ha detenuto il record mondiale nel miglior algoritmo di scalabilità della chimica quantistica.

Anche su piccola scala – in termini di scienza – lo è Min Bui, che è un bioinformatico che lavora allo sviluppo di nuovi modelli statistici nell'area dei sistemi filogenomici [un campo multidisciplinare che combina la ricerca evolutiva con la biologia dei sistemi e l'ecologia, utilizzando metodi della scienza delle reti]. Questi includono modelli di partizionamento, modelli sensibili agli isomorfismi e modelli ad albero di distribuzione. Le applicazioni di questo includono aree di enzimi fotosintetici o dati di trascrizione della filogenesi profonda degli insetti, e ha svolto lavori esaminando le alghe, nonché batteri e virus come l'HIV e SARS-CoV-2 (che causa COVID-19).

All'estremità più ampia della scala c'è il matematico Quanling Deng, la cui ricerca si concentra sulla modellazione matematica e sulla simulazione di mezzi su larga scala, come gli oceani e la dinamica dell'atmosfera, nonché i banchi di ghiaccio antartici.

La parte migliore è quando scopriamo che un problema di un dominio è in realtà già stato risolto in un altro, e ancora meglio quando ne scopriamo uno sperimentato in più domini in modo da poter scalare in modo super lineare. È fantastico quando una soluzione ha più aree di impatto. E quanto spesso troveresti un neuroscienziato computazionale che lavora insieme a un fisico del plasma? Semplicemente non succede normalmente.

Oltre a lavorare con il tuo gruppo di ricerca, sei anche vicedirettore della School of Computing dell'Australian National University. Puoi parlarci un po’ di quel ruolo?

È in gran parte un ruolo amministrativo. Quindi, oltre a lavorare con uno straordinario gruppo di scienziati informatici in scienze dei dati, aree fondamentali delle lingue, sviluppo di software, sicurezza informatica, visione artificiale, robotica e così via, posso anche creare opportunità per nuove persone di unirsi alla scuola e di essere la migliore versione di se stessi. Gran parte del mio lavoro nel ruolo di leadership riguarda le persone. E questo include il reclutamento, la cura del nostro programma di permanenza in carica e anche del nostro programma di sviluppo professionale. Ho anche avuto l'opportunità di avviare alcuni nuovi programmi per aree che ritenevo richiedessero attenzione.

Uno di questi esempi è stato durante la pandemia globale di COVID. Molti di noi sono rimasti chiusi e non hanno potuto accedere ai nostri laboratori, il che ci ha portato a chiederci cosa possiamo fare. Ho colto l'occasione per sviluppare un programma chiamato the Borsa di studio congiunta del Giubileo, che supporta i ricercatori che lavorano all'interfaccia tra l'informatica e un altro dominio, dove risolvono grandi sfide nelle loro aree, ma utilizzano anche la conoscenza di quel dominio per informare nuovi tipi di informatica. Il programma ha sostenuto cinque di questi ricercatori in diverse aree nel 2021.

Sono anche il presidente della Programma per donne pioniere, che offre borse di studio, incarichi di docenza e borse di studio per sostenere le donne che entrano nel mondo dell'informatica e garantire che abbiano successo durante tutta la loro carriera con noi.

E, naturalmente, uno dei miei altri ruoli come vicedirettore è occuparmi delle strutture informatiche della nostra scuola. Cerco modi in cui possiamo diversificare la nostra pipeline di risorse per superare momenti difficili, come durante il COVID, quando non potevamo ordinare nuove attrezzature. Mi occuperò anche di come possiamo essere più efficienti dal punto di vista energetico, perché l'informatica utilizza un'enorme quantità di energia.

Deve essere un momento molto entusiasmante per le persone che fanno ricerca nel machine learning, poiché la tecnologia sta trovando tanti usi diversi. Quali nuove applicazioni del machine learning aspetti con maggiore ansia nella tua ricerca?

Beh, probabilmente alcuni di quelli di cui hai già sentito parlare, vale a dire l'intelligenza artificiale. Sebbene esistano rischi associati all’intelligenza artificiale, ci sono anche enormi opportunità, e penso che l’intelligenza artificiale generativa sarà particolarmente importante nei prossimi anni per la scienza, a condizione che riusciamo a superare alcuni dei problemi che la rendono “allucinante” [quando un sistema di intelligenza artificiale , come un modello linguistico di grandi dimensioni, genera informazioni false, basate su un set di dati di addestramento o su una logica contestuale, o su una combinazione di entrambi].

Non importa in quale area della scienza operiamo, siamo limitati dal tempo che abbiamo, dal denaro, dalle risorse e dalle attrezzature a cui abbiamo accesso. Significa che stiamo compromettendo la nostra scienza per adattarci a questi limiti invece di concentrarci sul loro superamento

Ma non importa in quale area della scienza operiamo, sia computazionale che sperimentale, soffriamo tutti per una serie di restrizioni. Siamo limitati dal tempo che abbiamo, dal denaro, dalle risorse e dalle attrezzature a cui abbiamo accesso. Significa che stiamo compromettendo la nostra scienza per adattarci a questi limiti invece di concentrarci sul loro superamento. Credo davvero che l'infrastruttura non debba dettare ciò che facciamo, dovrebbe essere il contrario.

Penso che l’intelligenza artificiale generativa sia arrivata al momento giusto per permetterci di superare finalmente alcuni di questi problemi perché ha un grande potenziale per colmare le lacune e fornirci un’idea di quale scienza avremmo potuto fare, se avessimo avuto tutte le risorse necessarie. le risorse necessarie.

In effetti, l’intelligenza artificiale potrebbe consentirci di ottenere di più facendo di meno ed evitare alcune insidie come i pregiudizi di selezione. Questo è davvero un grosso problema quando si applica il machine learning ai set di dati scientifici. Dobbiamo fare molto più lavoro per garantire che i metodi generativi producano scienza significativa, non allucinazioni. Ciò è particolarmente importante se costituiranno la base per modelli pre-addestrati di grandi dimensioni. Ma penso che questa sarà un'era scientifica davvero entusiasmante in cui lavoreremo in collaborazione con l'intelligenza artificiale, piuttosto che limitarsi a svolgere un compito per noi.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://physicsworld.com/a/from-bottom-up-to-top-down-computational-scientist-amanda-barnard-on-the-beauty-of-simulations-machine-learning-and-how-the-two-intersect/

- :ha

- :È

- :non

- :Dove

- $ SU

- 2021

- 2022

- a

- capace

- WRI

- astrazione

- accelera

- acceleratori

- accesso

- Raggiungere

- operanti in

- effettivamente

- amministrazione

- amministrativo

- Avanzate

- avanzamenti

- Avvento

- Dopo shavasana, sedersi in silenzio; saluti;

- AI

- aip

- algoritmo

- Algoritmi

- Tutti

- da solo

- a fianco di

- già

- anche

- Sebbene il

- sempre

- am

- stupefacente

- quantità

- an

- analizzare

- ed

- Un altro

- rispondere

- in qualsiasi

- chiunque

- nulla

- apparente

- applicazioni

- applicato

- APPLICA

- AMMISSIONE

- designato

- approccio

- approcci

- SONO

- RISERVATA

- aree

- in giro

- artificiale

- intelligenza artificiale

- AS

- aspetti

- associato

- Associazione

- astronomia

- At

- Atmosfera

- attenzione

- Australiano

- automaticamente

- evitare

- premi

- batteri

- basato

- fondamentalmente

- BE

- bellissimo

- Bellezza ed estetica

- perché

- stato

- prima

- ha iniziato

- CREDIAMO

- MIGLIORE

- Meglio

- fra

- Al di là di

- pregiudizio

- Big

- biologia

- Po

- Dezen Dezen

- entrambi

- allargare

- Mazzo

- ma

- by

- detto

- Materiale

- Career

- categoria

- Categoria

- cause

- certo

- Chair

- sfide

- il cambiamento

- cambiando

- caratteristiche

- chimica

- classi

- classificazione

- clicca

- Chiudi

- Cluster

- codice

- codifica

- colleghi

- combinazione

- combinare

- combina

- Venire

- arrivo

- complesso

- complessità

- compromettendo

- computer

- Informatica

- Visione computerizzata

- informatica

- concetto

- condizioni

- contestuale

- contrasto

- Comodo

- convenzionale

- potuto

- Portata

- Covidien

- COVID-19

- Crash

- creare

- creato

- Cybersecurity

- Pericoloso

- dati

- scienza dei dati

- set di dati

- set di dati

- Giorni

- deep

- Richiesta

- esigente

- vice

- descrivere

- progettazione

- destinata

- Determinare

- determinato

- sviluppare

- sviluppato

- in via di sviluppo

- Mercato

- differire

- differenza

- diverso

- Direttore

- scopri

- paesaggio differenziato

- diversificare

- do

- effettua

- non

- fare

- dominio

- domini

- fatto

- giù

- durante

- dinamica

- ogni

- Presto

- terra

- facilmente

- in maniera efficace

- efficiente

- in modo efficiente

- o

- altro

- enable

- abilitato

- Abilita

- circondare

- fine

- energia

- Ingegneria

- enorme

- garantire

- entrare

- interamente

- ambientale

- ambienti

- equazioni

- usate

- epoca

- sviluppate

- Anche

- Ogni

- qualunque cosa

- si è evoluta

- esempio

- Esempi

- coinvolgenti

- esclusivamente

- esperto

- Esperienze

- esperimenti

- esplora

- espressione

- strutture

- falso

- compagno

- borse di studio

- pochi

- campo

- figura

- riempire

- riempimento

- finale

- Infine

- Trovate

- ricerca

- Nome

- in forma

- flusso

- concentrato

- si concentra

- messa a fuoco

- Nel

- modulo

- Avanti

- Fondazione

- frammentato

- da

- fondamentalmente

- lacune

- genera

- generativo

- AI generativa

- genomica

- ottenere

- Dare

- globali

- andando

- buono

- grandi sfide

- grande

- Gruppo

- Gruppo

- ha avuto

- cura

- accadere

- Hardware

- Avere

- he

- udito

- pesantemente

- Eroe

- aiutare

- suo

- Alte prestazioni

- il suo

- storico

- storia

- HIV

- Come

- Tutorial

- Tuttavia

- HTTPS

- umano

- intelligenza umana

- i

- MALATO

- IBM

- ICE

- idea

- if

- Immagine

- Impact

- realizzare

- importante

- in

- includere

- inclusi

- Compreso

- far sapere

- informazioni

- Infrastruttura

- ingresso

- Ingressi

- immediatamente

- Istituto

- strumento

- Intelligence

- destinato

- interesse

- interessi

- Interfaccia

- ai miglioramenti

- problema

- sicurezza

- IT

- join

- giunto

- jpg

- ad appena

- Sapere

- conoscenze

- laboratorio

- Discografica

- Labs

- Lingua

- Le Lingue

- grandi

- larga scala

- maggiormente

- superiore, se assunto singolarmente.

- portare

- Leadership

- apprendimento

- a sinistra

- meno

- livelli

- Leva

- piace

- limiti

- logica

- Guarda

- cerca

- SEMBRA

- perso

- lotto

- amato

- macchina

- machine learning

- macchine

- fatto

- make

- FA

- Fare

- molti

- carta geografica

- massicciamente

- materiale

- Materiale

- matematico

- Importanza

- max-width

- Maggio..

- me

- significativo

- si intende

- significava

- misurare

- Media

- medicale

- medicina

- metodo

- metodi

- forza

- ML

- modello

- modellismo

- Modellazione e simulazione

- modelli

- molecolare

- soldi

- Scopri di più

- maggior parte

- cambiano

- molti

- multidisciplinare

- multiplo

- devono obbligatoriamente:

- my

- cioè

- nanotecnologia

- il

- necessaria

- Bisogno

- di applicazione

- Rete

- Neuroscienze

- mai

- New

- GENERAZIONE

- no

- normalmente

- adesso

- numero

- of

- di frequente

- on

- ONE

- quelli

- esclusivamente

- aprire

- Opportunità

- Opportunità

- or

- minimo

- i

- Altro

- nostro

- su

- produzione

- al di fuori

- Superare

- superamento

- Packages

- pandemia

- Parallel

- parte

- particolare

- particolarmente

- passato

- sentiero

- Persone

- perfetta

- Eseguire

- esecuzione

- Forse

- Fisico

- Scienze fisiche

- Fisica

- Mondo della fisica

- conduttura

- Plasma

- Platone

- Platone Data Intelligence

- PlatoneDati

- punto

- possibile

- potenziale

- piuttosto

- in precedenza

- premio

- probabilmente

- Problema

- problemi

- processori

- produzione

- Insegnante

- programma

- programmi

- progetto

- proprietà

- proprietà

- prototipi

- fornire

- purché

- ricerca

- metti

- Quantistico

- gamma

- piuttosto

- reazioni

- realizzando

- veramente

- ragione

- ricevente

- record

- reclutamento

- di cui

- rapporto

- Relazioni

- fare affidamento

- rimuovere

- rappresentante

- riparazioni

- ricercatori

- Risorse

- limitato

- restrizioni

- Risultati

- rivelare

- Rewards

- destra

- Rischio

- rischi

- robotica

- Ruolo

- ruoli

- norme

- Correre

- sake

- stesso

- SARS-CoV-2

- dire

- Scala

- scala

- di moto

- Scienze

- SCIENZE

- scientifico

- Scienziato

- scienziati

- prodotti

- anziano

- separato

- set

- Set

- lei

- dovrebbero

- fermare

- simile

- somiglianze

- simulazione

- contemporaneamente

- piccole

- smart

- So

- Società

- Software

- lo sviluppo del software

- soluzione

- RISOLVERE

- Soluzione

- alcuni

- qualcosa

- lo spazio

- Parla

- in particolare

- spendere

- Spendere

- inizia a

- iniziato

- Di partenza

- stati

- statistiche

- Ancora

- strategicamente

- La struttura

- studente

- Studio

- Studiando

- di successo

- tale

- sofferenza

- Super

- supercomputer

- supporto

- supportato

- supporti

- sicuro

- circondato

- sistema

- SISTEMI DI TRATTAMENTO

- Rubinetto

- Task

- tecniche

- Tecnologia

- dire

- condizioni

- di

- che

- Il

- L'area

- il mondo

- loro

- Li

- si

- poi

- teorico

- teoria

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- cose

- think

- questo

- quelli

- pensiero

- Attraverso

- per tutto

- miniature

- tempo

- volte

- a

- ha preso

- difficile

- Training

- Trasformare

- tendenze

- provato

- vero

- veramente

- seconda

- Tipi di

- incapace

- per

- sostegno

- capire

- e una comprensione reciproca

- purtroppo

- Università

- us

- uso

- utilizzato

- usa

- utilizzando

- varietà

- versione

- molto

- potenzialmente

- virus

- visione

- volere

- Prima

- Modo..

- modi

- we

- WELL

- sono stati

- Che

- quando

- mentre

- se

- quale

- while

- OMS

- tutto

- di chi

- perché

- largo

- Vasta gamma

- ampiamente

- volere

- con

- senza

- Donna

- Ha vinto

- chiedendosi

- Lavora

- flussi di lavoro

- lavoro

- lavori

- mondo

- sarebbe

- scrittura

- Wrong

- anni

- ancora

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro