In un mondo sempre più incentrato sui dati, le aziende devono concentrarsi sulla raccolta di preziose informazioni fisiche e sulla generazione delle informazioni di cui hanno bisogno ma che non possono acquisire facilmente. L'accesso ai dati, la regolamentazione e la conformità sono una crescente fonte di attrito per l'innovazione nell'analisi e nell'intelligenza artificiale (AI).

Per settori altamente regolamentati come i servizi finanziari, la sanità, le scienze della vita, l'automotive, la robotica e la produzione, il problema è ancora maggiore. Causa barriere alla progettazione del sistema, alla condivisione dei dati (interna ed esterna), alla monetizzazione, all'analisi e all'apprendimento automatico (ML).

I dati sintetici sono uno strumento che affronta molte sfide relative ai dati, in particolare problemi di intelligenza artificiale e analisi come protezione della privacy, conformità alle normative, accessibilità, scarsità di dati e bias. Ciò include anche la condivisione dei dati e il time to data (e quindi il time to market).

I dati sintetici sono generati algoritmicamente. Rispecchia le proprietà e i modelli statistici dei dati di origine. Ma soprattutto non contiene dati sensibili, privati o personali.

Fai domande sui dati sintetici e ottieni le stesse risposte che otterresti dai dati reali.

Nei nostri post precedente, abbiamo dimostrato come utilizzare reti contraddittorie come Generative Adversarial Networks (GANS) per generare set di dati tabulari per migliorare la formazione del modello di frode creditizia.

Affinché le parti interessate aziendali adottino dati sintetici per i loro progetti di ML e analisi, è imperativo non solo assicurarsi che i dati sintetici generati si adattino allo scopo e alle applicazioni a valle previste, ma anche che siano in grado di misurare e dimostrare la qualità di i dati generati.

Con l'aumento degli obblighi legali ed etici nel preservare la privacy, uno dei punti di forza dei dati sintetici è la capacità di rimuovere informazioni sensibili e originali durante la loro sintesi. Pertanto, oltre alla qualità, abbiamo bisogno di metriche per valutare il rischio di fughe di informazioni private, se presenti, e valutare che il processo di generazione non stia "memorizzando" o copiando nessuno dei dati originali.

Per ottenere tutto ciò, possiamo mappare la qualità dei dati sintetici in dimensioni, che aiutano gli utenti, le parti interessate e noi a comprendere meglio i dati generati.

Le tre dimensioni della valutazione della qualità dei dati sintetici

I dati sintetici generati vengono misurati rispetto a tre dimensioni chiave:

- Fidelity

- Utilità

- Privacy

Queste sono alcune delle domande su qualsiasi dato sintetico generato a cui dovrebbe rispondere un rapporto sulla qualità dei dati sintetici:

- Quanto sono simili questi dati sintetici rispetto al set di addestramento originale?

- Quanto sono utili questi dati sintetici per le nostre applicazioni a valle?

- Sono trapelate informazioni dai dati di addestramento originali ai dati sintetici?

- Qualche dato considerato sensibile nel mondo reale (da altri set di dati non utilizzati per l'addestramento del modello) è stato inavvertitamente sintetizzato dal nostro modello?

Le metriche che traducono ciascuna di queste dimensioni per gli utenti finali sono piuttosto flessibili. Dopo tutto, i dati da generare possono variare in termini di distribuzioni, dimensioni e comportamenti. Dovrebbero anche essere facili da comprendere e interpretare.

In definitiva, le metriche devono essere completamente basate sui dati e non richiedere alcuna conoscenza preliminare o informazioni specifiche del dominio. Tuttavia, se l'utente desidera applicare regole e vincoli specifici applicabili a uno specifico dominio aziendale, dovrebbe essere in grado di definirli durante il processo di sintesi per assicurarsi che la fedeltà specifica del dominio sia soddisfatta.

Esaminiamo ciascuna di queste metriche in modo più dettagliato nelle sezioni seguenti.

Metriche per comprendere la fedeltà

In qualsiasi progetto di data science, dobbiamo capire se una determinata popolazione campione è rilevante per il problema che stiamo risolvendo. Allo stesso modo, per il processo di valutazione della pertinenza dei dati sintetici generati, dobbiamo valutarli in termini di fedeltà rispetto all'originale.

Le rappresentazioni visive di queste metriche le rendono più facili da comprendere. Potremmo illustrare se la cardinalità e il rapporto delle categorie sono stati rispettati, le correlazioni tra le diverse variabili sono state mantenute e così via.

Visualizzare i dati non solo aiuta a valutare la qualità dei dati sintetici, ma si inserisce anche come uno dei primi passi nel ciclo di vita della scienza dei dati per una migliore comprensione dei dati.

Analizziamo più in dettaglio alcune metriche di fedeltà.

Confronti statistici esplorativi

All'interno dei confronti statistici esplorativi, le caratteristiche dei set di dati originali e sintetici vengono esplorate utilizzando misure statistiche chiave, come la media, la mediana, la deviazione standard, i valori distinti, i valori mancanti, i minimi, i massimi, gli intervalli quartili per le caratteristiche continue e il numero di record per categoria, valori mancanti per categoria e caratteri più ricorrenti per gli attributi categoriali.

Questo confronto dovrebbe essere condotto tra il set di dati di controllo originale e i dati sintetici. Questa valutazione rivelerebbe se i set di dati confrontati sono statisticamente simili. In caso contrario, capiremo quali caratteristiche e misure sono diverse. Dovresti prendere in considerazione la riqualificazione e la rigenerazione dei dati sintetici con parametri diversi se si nota una differenza significativa.

Questo test funge da screening iniziale per assicurarsi che i dati sintetici abbiano una ragionevole fedeltà al set di dati originale e possano quindi essere utilmente sottoposti a test più rigorosi.

Punteggio di somiglianza dell'istogramma

Il punteggio di somiglianza dell'istogramma misura le distribuzioni marginali di ciascuna caratteristica dei set di dati sintetici e originali.

Il punteggio di somiglianza è compreso tra zero e uno, con un punteggio pari a uno che indica che le distribuzioni dei dati sintetici si sovrappongono perfettamente alle distribuzioni dei dati originali.

Un punteggio vicino a uno darebbe agli utenti la certezza che il set di dati di controllo e il set di dati sintetici sono statisticamente simili.

Punteggio di informazioni reciproche

Il punteggio di informazioni reciproche misura la dipendenza reciproca di due caratteristiche, numeriche o categoriche, indicando quante informazioni possono essere ottenute da una caratteristica osservandone un'altra.

Le informazioni reciproche possono misurare le relazioni non lineari, fornendo una comprensione più completa della qualità dei dati sintetici in quanto ci consente di comprendere l'estensione della conservazione delle relazioni della variabile.

Un punteggio pari a uno indica che la dipendenza reciproca tra le caratteristiche è stata perfettamente catturata nei dati sintetici.

Punteggio di correlazione

Il punteggio di correlazione misura quanto bene le correlazioni nel set di dati originale sono state acquisite nei dati sintetici.

Le correlazioni tra due o più colonne sono estremamente importanti per le applicazioni ML, che aiutano a scoprire le relazioni tra le caratteristiche e la variabile di destinazione e aiutano a creare un modello ben addestrato.

Il punteggio di correlazione è compreso tra zero e uno, con un punteggio pari a uno che indica che le correlazioni sono state perfettamente abbinate.

A differenza dei dati tabulari strutturati, che incontriamo comunemente nei problemi con i dati, alcuni tipi di dati strutturati hanno un comportamento particolare in cui le osservazioni passate hanno una probabilità di influenzare l'osservazione successiva. Questi sono noti come serie temporali o dati sequenziali, ad esempio un set di dati con misurazioni orarie della temperatura ambiente.

Questo comportamento significa che è necessario definire determinate metriche in grado di misurare in modo specifico la qualità di questi set di dati di serie temporali

Punteggio di autocorrelazione e autocorrelazione parziale

Sebbene simile alla correlazione, l'autocorrelazione mostra la relazione di una serie temporale al suo valore attuale in relazione ai suoi valori precedenti. La rimozione degli effetti dei ritardi temporali precedenti produce un'autocorrelazione parziale. Pertanto, il punteggio di autocorrelazione misura quanto bene i dati sintetici hanno catturato le autocorrelazioni significative, o correlazioni parziali, dal set di dati originale.

Metriche per comprendere l'utilità

Ora potremmo esserci statisticamente resi conto che i dati sintetici sono simili al set di dati originale. Inoltre, dobbiamo anche valutare quanto bene il set di dati sintetizzato se la cava su problemi di data science comuni quando viene addestrato su diversi algoritmi ML.

Usando quanto segue utilità metriche, miriamo a costruire la fiducia che possiamo effettivamente ottenere prestazioni sulle applicazioni a valle per quanto riguarda il rendimento dei dati originali.

Punteggio di previsione

La misurazione delle prestazioni dei dati sintetici rispetto ai dati reali originali può essere eseguita tramite modelli ML. Il punteggio del modello a valle acquisisce la qualità dei dati sintetici confrontando le prestazioni dei modelli ML addestrati sui set di dati sintetici e originali e convalidati sui dati di test trattenuti dal set di dati originale. Questo fornisce un Punteggio Train Synthetic Test Real (TSTR). e Treno Reale Prova Reale (TRTR) punteggio rispettivamente.

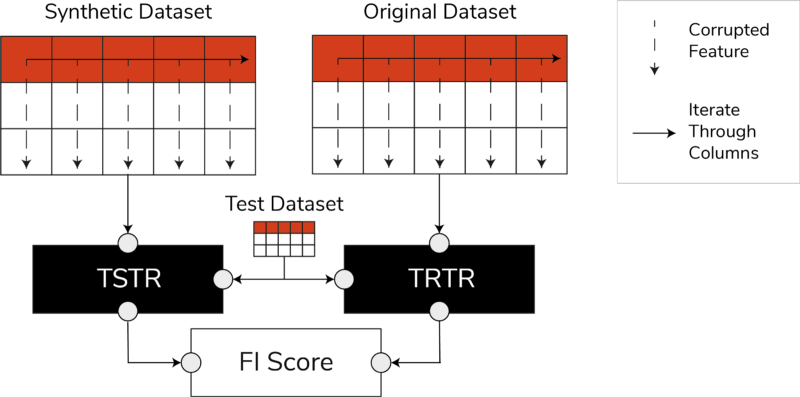

Punteggi TSTR, TRTR e punteggio di importanza delle caratteristiche (immagine per autore)

Il punteggio incorpora un'ampia gamma degli algoritmi ML più affidabili per attività di regressione o classificazione. L'utilizzo di diversi classificatori e regressori assicura che il punteggio sia più generalizzabile nella maggior parte degli algoritmi, in modo che i dati sintetici possano essere considerati utili in futuro.

Alla fine, se il punteggio TSTR e il punteggio TRTR sono comparabili, ciò indica che i dati sintetici hanno la qualità per essere utilizzati per addestrare modelli ML efficaci per applicazioni del mondo reale.

Punteggio di importanza della caratteristica

Altamente correlato al punteggio di previsione, il punteggio di importanza della caratteristica (FI) lo estende aggiungendo interpretabilità ai punteggi TSTR e TRTR.

Il punteggio F1 confronta i cambiamenti e la stabilità dell'ordine di importanza della caratteristica ottenuti con il punteggio di previsione. Un insieme sintetico di dati è considerato di grande utilità se produce lo stesso ordine di importanza delle caratteristiche dei dati reali originali.

Punteggio Q

Per assicurarci che un modello addestrato sui nostri dati appena generati produca le stesse risposte alle stesse domande di un modello addestrato utilizzando i dati originali, utilizziamo il Qscore. Questo misura le prestazioni a valle dei dati sintetici eseguendo molte query basate su aggregazioni casuali sui set di dati sintetici e originali (e di controllo).

L'idea qui è che entrambe queste query dovrebbero restituire risultati simili.

Un QScore elevato garantisce che le applicazioni downstream che utilizzano operazioni di query e aggregazione possano fornire un valore quasi uguale a quello del set di dati originale.

Metriche per comprendere la privacy

Con Privacy regolamenti già in vigore, è un obbligo etico e un requisito legale per garantire che le informazioni sensibili siano protette.

Prima che questi dati sintetici possano essere condivisi liberamente e utilizzati per applicazioni a valle, dobbiamo considerare le metriche sulla privacy che possono aiutare le parti interessate a capire dove si trovano i dati sintetici generati rispetto ai dati originali in termini di portata delle informazioni trapelate. Inoltre, dobbiamo prendere decisioni critiche su come i dati sintetici possono essere condivisi e utilizzati.

Punteggio esatto della corrispondenza

Una valutazione diretta e intuitiva della privacy consiste nel cercare copie dei dati reali tra i record sintetici. Il punteggio esatto della corrispondenza conta il numero di record reali che possono essere trovati nel set sintetico.

Il punteggio dovrebbe essere zero, a indicare che nessuna informazione reale è presente così com'è nei dati sintetici. Questa metrica funge da meccanismo di screening prima di valutare ulteriori metriche sulla privacy.

Punteggio sulla privacy dei vicini

Inoltre, il punteggio sulla privacy dei vicini misura il rapporto tra record sintetici che potrebbero essere troppo simili a quelli reali. Ciò significa che, sebbene non siano copie dirette, sono potenziali punti di fuga della privacy e una fonte di informazioni utili per gli attacchi di inferenza.

Il punteggio viene calcolato conducendo una ricerca dei vicini più vicini ad alta dimensione sui dati sintetici sovrapposti ai dati originali.

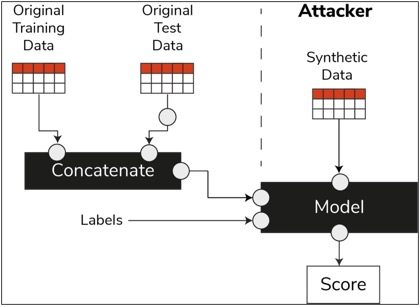

Punteggio di inferenza dell'appartenenza

Nel ciclo di vita della scienza dei dati, una volta che un modello è stato addestrato, non ha più bisogno di accedere ai campioni di addestramento e può fare previsioni su dati invisibili. Allo stesso modo, nel nostro caso, una volta addestrato il modello del sintetizzatore, è possibile generare campioni di dati sintetici senza la necessità dei dati originali.

Attraverso un tipo di attacco chiamato "attacco di inferenza di appartenenza", gli aggressori possono tentare di rivelare i dati utilizzati per creare i dati sintetici, senza avere accesso ai dati originali. Ciò si traduce in un compromesso della privacy.

Il punteggio di inferenza di appartenenza misura la probabilità che un attacco di inferenza di appartenenza abbia successo.

Un punteggio basso suggerisce la fattibilità dell'inferenza che un particolare record era un membro del set di dati di addestramento che ha portato alla creazione dei dati sintetici. In altre parole, gli attacchi possono dedurre i dettagli di un record individuale, compromettendo così la privacy.

Un punteggio di inferenza di appartenenza elevato indica che è improbabile che un utente malintenzionato determini se un determinato record faceva parte del set di dati originale utilizzato per creare i dati sintetici. Ciò significa anche che nessuna informazione individuale è stata compromessa attraverso i dati sintetici.

Il concetto di tenuta

Un'importante best practice che dobbiamo seguire è assicurarci che i dati sintetici siano sufficientemente generali e non si adattino eccessivamente ai dati originali su cui sono stati addestrati. Nel tipico flusso di data science, durante la creazione di modelli ML come un classificatore Random Forest, mettiamo da parte i dati di test, addestriamo i modelli utilizzando i dati di addestramento e valutiamo le metriche su dati di test invisibili.

Allo stesso modo, per i dati sintetici, teniamo da parte un campione dei dati originali, generalmente indicato come set di dati di controllo o dati di test trattenuti non visualizzati, e valutiamo i dati sintetici generati rispetto al set di dati di controllo.

Il set di dati di controllo dovrebbe essere una rappresentazione dei dati originali, ma non visibile quando sono stati generati i dati sintetici. Pertanto, è fondamentale disporre di punteggi simili per tutte le metriche quando si confrontano i set di dati originali con quelli di controllo e sintetici.

Quando si ottengono punteggi simili, possiamo stabilire che i punti dati sintetici non sono il risultato della memorizzazione dei punti dati originali, pur conservando la stessa fedeltà e utilità.

Conclusioni

Il mondo sta iniziando a comprendere l'importanza strategica dei dati sintetici. In qualità di data scientist e generatori di dati, è nostro dovere creare fiducia nei dati sintetici che generiamo e assicurarci che sia per uno scopo.

I dati sintetici si stanno evolvendo in un must nel toolkit di sviluppo della scienza dei dati. MIT Technology Review ha noto dati sintetici come una delle tecnologie rivoluzionarie del 2022. Non possiamo immaginare di costruire modelli di intelligenza artificiale di valore eccellente senza dati sintetici, afferma Gartner.

Secondo McKinsey, i dati sintetici riducono al minimo i costi e le barriere che altrimenti avresti nello sviluppo di algoritmi o nell'accesso ai dati.

La generazione di dati sintetici riguarda la conoscenza delle applicazioni a valle e la comprensione dei compromessi tra le diverse dimensioni per la qualità dei dati sintetici.

Sommario

Come utente dei dati sintetici, è essenziale definire il contesto del caso d'uso per il quale ogni campione di dati sintetici verrà utilizzato in futuro. Proprio come con i dati reali, la qualità dei dati sintetici dipende dal caso d'uso previsto, nonché dai parametri scelti per la sintesi.

Ad esempio, mantenere i valori anomali nei dati sintetici come nei dati originali è utile per un caso d'uso di rilevamento delle frodi. Tuttavia, non è utile in un caso d'uso sanitario con problemi di privacy, poiché i valori anomali in genere potrebbero essere perdite di informazioni.

Inoltre, esiste un compromesso tra fedeltà, utilità e privacy. I dati non possono essere ottimizzati per tutti e tre contemporaneamente. Queste metriche consentono alle parti interessate di dare la priorità a ciò che è essenziale per ogni caso d'uso e gestire le aspettative dai dati sintetici generati.

In definitiva, quando vediamo i valori di ciascuna metrica e quando soddisfano le aspettative, le parti interessate possono essere sicure delle soluzioni che costruiscono utilizzando i dati sintetici.

I casi d'uso per i dati sintetici strutturati coprono un'ampia gamma di applicazioni, dai dati di test per lo sviluppo di software alla creazione di bracci di controllo sintetici negli studi clinici.

Contatta per esplorare queste opportunità o crea un PoC per dimostrarne il valore.

Faris Haddad è Data & Insights Lead nel team di AABG Strategic Pursuits. Aiuta le aziende a diventare data-driven con successo.

Faris Haddad è Data & Insights Lead nel team di AABG Strategic Pursuits. Aiuta le aziende a diventare data-driven con successo.

- Avanzato (300)

- AI

- oh arte

- generatore d'arte

- un robot

- Apprendimento automatico di Amazon

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- Apprendimento automatico di AWS

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- Istruzioni tecniche

- zefiro