Negli ultimi anni, le piattaforme di istruzione online hanno visto un aumento dell'adozione e un aumento della domanda di apprendimento basato su video perché offre un mezzo efficace per coinvolgere gli studenti. Per espandersi ai mercati internazionali e rivolgersi a una popolazione culturalmente e linguisticamente diversificata, le aziende stanno anche cercando di diversificare le proprie offerte di apprendimento localizzando i contenuti in più lingue. Queste aziende sono alla ricerca di modi affidabili ed economici per risolvere i casi d'uso della localizzazione.

La localizzazione dei contenuti include principalmente la traduzione di voci originali in nuove lingue e l'aggiunta di ausili visivi come i sottotitoli. Tradizionalmente, questo processo è proibitivo in termini di costi, manuale e richiede molto tempo, incluso il lavoro con specialisti della localizzazione. Con la potenza dei servizi di machine learning (ML) di AWS come Amazon Transcribe, Amazon Traduttoree Amazon Polly, è possibile creare una soluzione di localizzazione praticabile ed economica. Puoi utilizzare Amazon Transcribe per creare una trascrizione dei tuoi flussi audio e video esistenti, quindi tradurre questa trascrizione in più lingue utilizzando Amazon Translate. Puoi quindi utilizzare Amazon Polly, un servizio di sintesi vocale, per convertire il testo tradotto in un linguaggio umano dal suono naturale.

Il passaggio successivo della localizzazione consiste nell'aggiungere i sottotitoli al contenuto, che possono migliorare l'accessibilità e la comprensione e aiutare gli spettatori a comprendere meglio i video. La creazione di sottotitoli sui contenuti video può essere difficile perché il discorso tradotto non corrisponde alla tempistica del discorso originale. Questa sincronizzazione tra audio e sottotitoli è un'attività fondamentale da considerare perché potrebbe disconnettere il pubblico dai tuoi contenuti se non sono sincronizzati. Amazon Polly offre una soluzione a questa sfida attraverso l'abilitazione segni di discorso, che puoi utilizzare per creare un file di sottotitoli che può essere sincronizzato con l'output vocale generato.

In questo post, esaminiamo una soluzione di localizzazione che utilizza i servizi AWS ML in cui utilizziamo un video inglese originale e lo convertiamo in spagnolo. Ci concentriamo anche sull'uso dei segni vocali per creare un file di sottotitoli sincronizzato in spagnolo.

Panoramica della soluzione

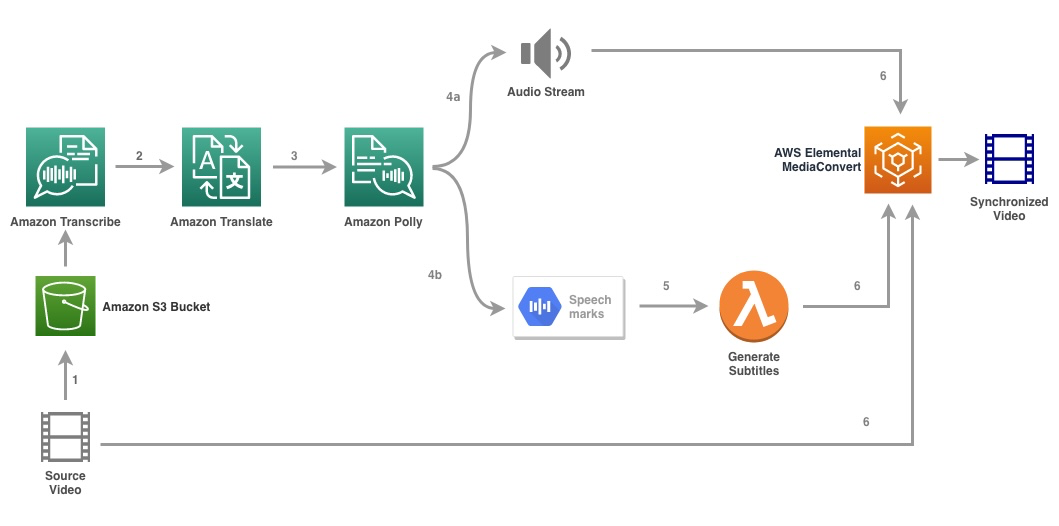

Il diagramma seguente illustra l'architettura della soluzione.

La soluzione prende un file video e le impostazioni della lingua di destinazione come input e utilizza Amazon Transcribe per creare una trascrizione del video. Usiamo quindi Amazon Translate per tradurre la trascrizione nella lingua di destinazione. Il testo tradotto viene fornito come input ad Amazon Polly per generare il flusso audio e i contrassegni vocali nella lingua di destinazione. Amazon Polly ritorna output del segno vocale in un flusso JSON delimitato da righe, che contiene i campi come ora, tipo, inizio, fine e valore. Il valore può variare a seconda del tipo di contrassegno vocale richiesto nell'input, ad es SSML, visema, parola o frase. Ai fini del nostro esempio, abbiamo richiesto il tipo di segno vocale as word. Con questa opzione, Amazon Polly suddivide una frase nelle sue singole parole nella frase e nei relativi orari di inizio e fine nel flusso audio. Con questi metadati, i segni vocali vengono quindi elaborati per generare i sottotitoli per il flusso audio corrispondente generato da Amazon Polly.

Infine, usiamo AWS Elemental MediaConvert per rendere il video finale con l'audio tradotto e i relativi sottotitoli.

Il video seguente mostra il risultato finale della soluzione:

Flusso di lavoro di AWS Step Functions

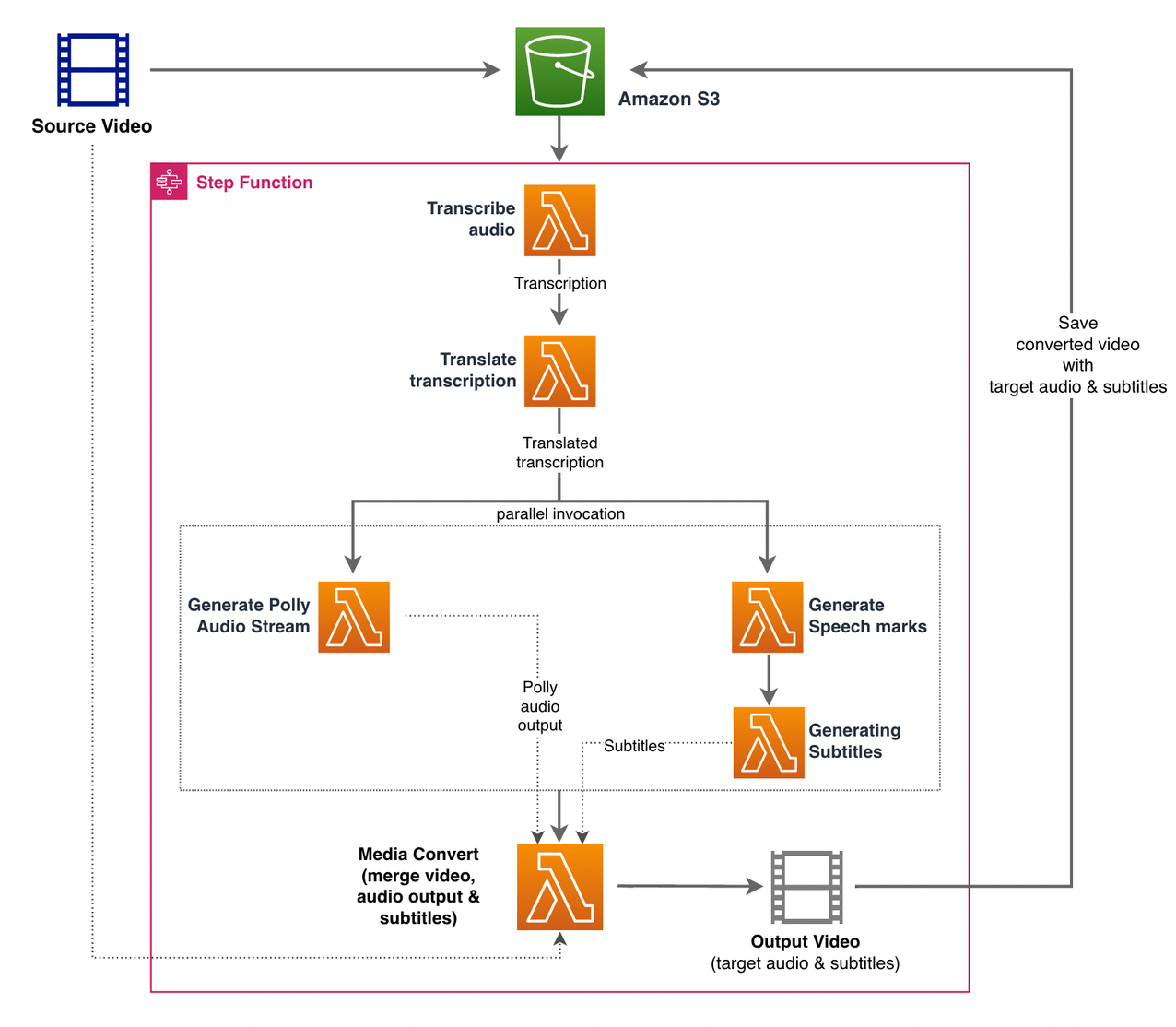

Usiamo Funzioni AWS Step per orchestrare questo processo. La figura seguente mostra una vista di alto livello del flusso di lavoro di Step Functions (alcuni passaggi sono omessi dal diagramma per una maggiore chiarezza).

I passaggi del flusso di lavoro sono i seguenti:

- Un utente carica il file video di origine su un Servizio di archiviazione semplice Amazon (Amazon S3) secchio.

- I Notifica evento S3 innesca il AWS Lambda function macchina_stato.py (non mostrato nel diagramma), che richiama la macchina a stati Step Functions.

- Il primo passo, Trascrivi l'audio, richiama la funzione Lambda trascrivi.py, che utilizza Amazon Transcribe per generare una trascrizione dell'audio dal video di origine.

Il codice di esempio seguente mostra come creare un processo di trascrizione utilizzando Amazon Transcribe Boto3 SDK Python:

Al termine del lavoro, i file di output vengono salvati nel bucket S3 e il processo continua con il passaggio successivo di traduzione del contenuto.

- I Traduci la trascrizione step richiama la funzione Lambda tradurre.py che utilizza Amazon Translate per tradurre la trascrizione nella lingua di destinazione. Qui, utilizziamo la traduzione sincrona/in tempo reale usando il tradurre_testo funzione:

La traduzione sincrona ha dei limiti alle dimensioni del documento che può tradurre; al momento della stesura di questo documento, è impostato su 5,000 byte. Per documenti di dimensioni maggiori, prendere in considerazione l'utilizzo di un percorso asincrono di creazione del lavoro utilizzando start_text_translation_job e controllare lo stato tramite description_text_translation_job.

- Il prossimo passo è un Step Functions Parallel state, dove creiamo rami paralleli nella nostra macchina a stati.

- Nel primo ramo, invochiamo la funzione Lambda, la funzione Lambda generate_polly_audio.py per generare il nostro flusso audio Amazon Polly:

Qui usiamo il start_speech_sintesi_task metodo di Amazon Polly Python SDK per attivare l'attività di sintesi vocale che crea l'audio Amazon Polly. Impostiamo il

OutputFormatamp3, che indica ad Amazon Polly di generare un flusso audio per questa chiamata API. - Nel secondo ramo, invochiamo la funzione Lambda generate_speech_marks.py per generare l'output di segni vocali:

- Nel primo ramo, invochiamo la funzione Lambda, la funzione Lambda generate_polly_audio.py per generare il nostro flusso audio Amazon Polly:

- Usiamo ancora il start_speech_sintesi_task metodo ma specificare

OutputFormatajson, che indica ad Amazon Polly di generare segni vocali per questa chiamata API.

Nel passaggio successivo del secondo ramo, invochiamo la funzione Lambda generate_subtitles.py, che implementa la logica per generare un file di sottotitoli dall'output dei segni vocali.

Usa il modulo Python nel file webvtt_utils.py. Questo modulo ha molteplici funzioni di utilità per creare il file dei sottotitoli; uno di questi metodi get_phrases_from_speechmarks è responsabile dell'analisi del file dei segni vocali. La struttura JSON dei segni vocali fornisce solo l'ora di inizio per ciascuna parola individualmente. Per creare la temporizzazione dei sottotitoli richiesta per il file SRT, creiamo prima frasi di circa n (dove n=10) parole dall'elenco di parole nel file dei segni vocali. Quindi li scriviamo nel formato di file SRT, prendendo l'ora di inizio dalla prima parola nella frase, e per l'ora di fine utilizziamo l'ora di inizio della parola (n+1) e la sottraiamo per 1 per creare la voce in sequenza . La seguente funzione crea le frasi in preparazione per scriverle nel file SRT:

- Il passo finale, Media Convert, richiama la funzione Lambda create_mediaconvert_job.py per combinare il flusso audio da Amazon Polly e il file dei sottotitoli con il file video di origine per generare il file di output finale, che viene quindi archiviato in un bucket S3. Questo passaggio utilizza

MediaConvert, un servizio di transcodifica video basato su file con funzionalità di livello broadcast. Ti consente di creare facilmente contenuti video on demand e combina funzionalità video e audio avanzate con una semplice interfaccia web. Anche in questo caso usiamo Python Boto3 SDK per creare unMediaConvertlavoro:

Prerequisiti

Prima di iniziare, devi avere i seguenti prerequisiti:

Distribuisci la soluzione

Per distribuire la soluzione utilizzando AWS CDK, completa i seguenti passaggi:

- Clona il file deposito:

- Per assicurarsi che l'AWS CDK lo sia bootstrap, esegui il comando

cdk bootstrapdalla radice del repository: - Modificare la directory di lavoro nella radice del repository ed eseguire il comando seguente:

Per impostazione predefinita, le impostazioni audio di destinazione sono impostate su spagnolo americano (es-US). Se prevedi di testarlo con una lingua di destinazione diversa, utilizza il comando seguente:

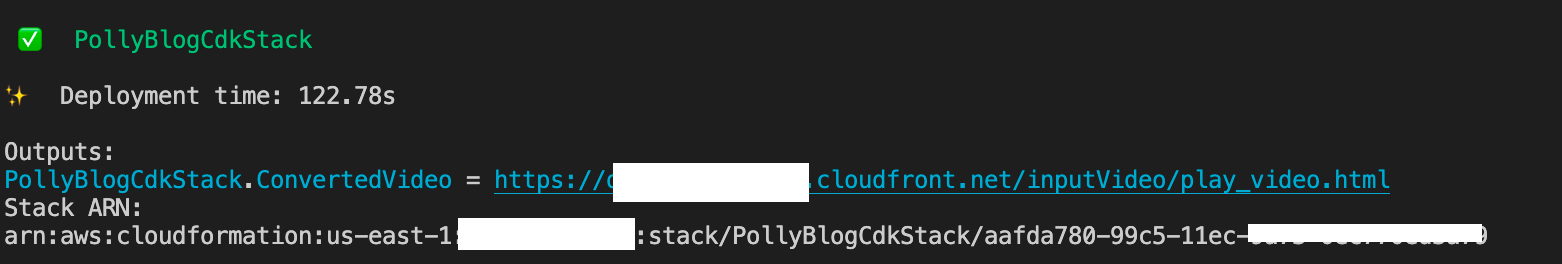

Il completamento del processo richiede alcuni minuti, dopodiché viene visualizzato un collegamento che puoi utilizzare per visualizzare il file video di destinazione con l'audio tradotto e i sottotitoli tradotti.

Prova la soluzione

Per testare questa soluzione, abbiamo utilizzato una piccola parte di quanto segue Video di AWS re:Invent 2017 da YouTube, dove Amazon Transcribe è stato introdotto per la prima volta. Puoi anche testare la soluzione con il tuo video. La lingua originale del nostro video di prova è l'inglese. Quando si distribuisce questa soluzione, è possibile specificare le impostazioni audio di destinazione oppure è possibile utilizzare le impostazioni audio di destinazione predefinite, che utilizzano lo spagnolo per la generazione di audio e sottotitoli. La soluzione crea un bucket S3 che può essere utilizzato per caricare il file video.

- Sulla console Amazon S3, vai al bucket

PollyBlogBucket.

- Scegli il secchio, vai a

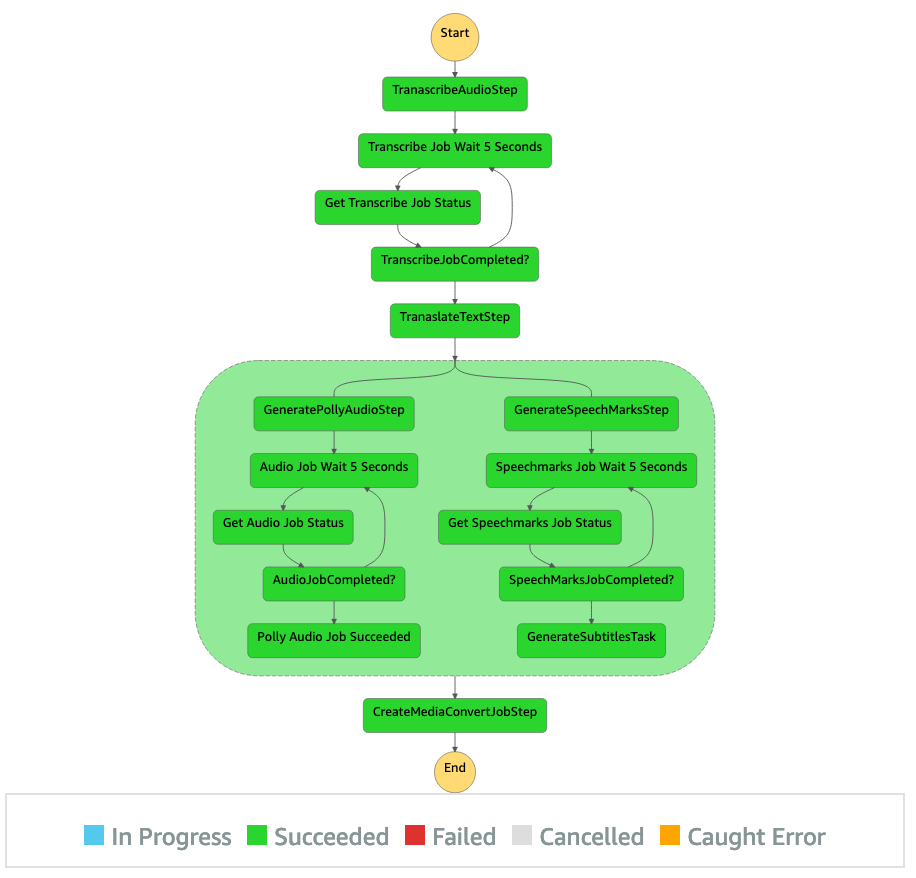

/inputVideodirectory e caricare il file video (la soluzione è testata con video di tipo mp4). A questo punto, una notifica di evento S3 attiva la funzione Lambda, che avvia la macchina a stati. - Nella console Step Functions, accedere alla macchina a stati (

ProcessAudioWithSubtitles). - Scegli una delle esecuzioni della macchina a stati per individuare il file Ispettore grafico.

Questo mostra i risultati dell'esecuzione per ogni stato. Il completamento del flusso di lavoro di Step Functions richiede alcuni minuti, dopodiché è possibile verificare se tutti i passaggi sono stati completati correttamente.

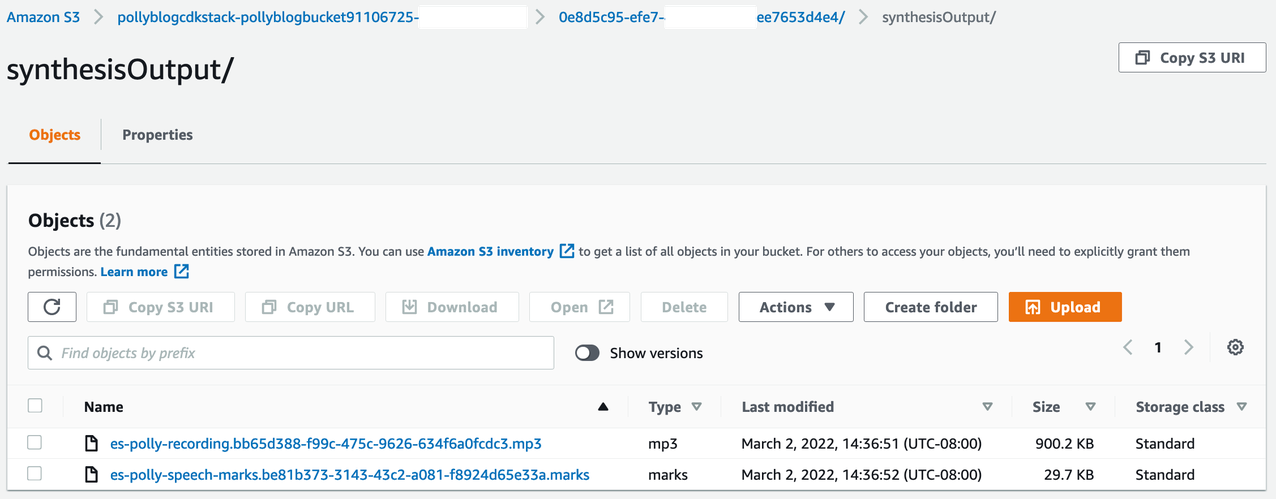

Rivedere l'output

Per rivedere l'output, apri la console Amazon S3 e controlla se il file audio (.mp3) e il file del contrassegno vocale (.marks) sono archiviati nel bucket S3 in <ROOT_S3_BUCKET>/<UID>/synthesisOutput/.

Quello che segue è un esempio del file del segno vocale generato dal testo tradotto:

In questo output, ogni parte del testo è suddivisa in termini di segni vocali:

- tempo – Il timestamp in millisecondi dall'inizio del flusso audio corrispondente

- Digitare – Il tipo di marchio vocale (frase, parola, visema o SSML)

- inizia a – L'offset in byte (non caratteri) dell'inizio dell'oggetto nel testo di input (esclusi i segni del visema)

- fine – L'offset in byte (non caratteri) dell'estremità dell'oggetto nel testo di input (esclusi i segni del visema)

- APPREZZIAMO – Singole parole nella frase

Il file dei sottotitoli generato viene riscritto nel bucket S3. Puoi trovare il file sotto <ROOT_S3_BUCKET>/<UID>/subtitlesOutput/. Ispeziona il file dei sottotitoli; il contenuto dovrebbe essere simile al seguente testo:

Dopo che il file dei sottotitoli e il file audio sono stati generati, il file video di origine finale viene creato utilizzando MediaConvert. Controllare la console MediaConvert per verificare se lo stato del lavoro è COMPLETE.

Al termine del processo MediaConvert, il file video finale viene generato e salvato di nuovo nel bucket S3, che può essere trovato in <ROOT_S3_BUCKET>/<UID>/convertedAV/.

Come parte di questa distribuzione, il video finale viene distribuito tramite un Amazon CloudFront (CDN) e visualizzati nel terminale o nel AWS CloudFormazione console.

Apri l'URL in un browser per visualizzare il video originale con opzioni aggiuntive per audio e sottotitoli. Puoi verificare che l'audio e i sottotitoli tradotti siano sincronizzati.

Conclusione

In questo post, abbiamo discusso di come creare nuove versioni linguistiche dei file video senza la necessità di un intervento manuale. I creatori di contenuti possono utilizzare questo processo per sincronizzare l'audio e i sottotitoli dei loro video e raggiungere un pubblico globale.

Puoi facilmente integrare questo approccio nelle tue pipeline di produzione per gestire grandi volumi e scalare in base alle tue esigenze. Amazon Polly utilizza TTS neurale (NTTS) per produrre voci di sintesi vocale naturali e simili a quelle umane. Supporta anche generazione del parlato da SSML, che ti offre un controllo aggiuntivo su come Amazon Polly genera il parlato dal testo fornito. Amazon Polly fornisce anche un varietà di voci diverse in più lingue per supportare le tue esigenze.

Inizia con i servizi di machine learning di AWS visitando il , o fare riferimento a Lab di Amazon Machine Learning Solutions pagina in cui puoi collaborare con esperti per portare soluzioni di machine learning nella tua organizzazione.

Risorse addizionali

Per ulteriori informazioni sui servizi utilizzati in questa soluzione, fare riferimento a quanto segue:

Circa gli autori

Regan Rosario lavora come architetto di soluzioni presso AWS, concentrandosi su aziende di tecnologia per l'istruzione. Adora aiutare i clienti a creare soluzioni scalabili, altamente disponibili e sicure nel cloud AWS. Ha più di un decennio di esperienza lavorando in una varietà di ruoli tecnologici, con particolare attenzione all'ingegneria del software e all'architettura.

Regan Rosario lavora come architetto di soluzioni presso AWS, concentrandosi su aziende di tecnologia per l'istruzione. Adora aiutare i clienti a creare soluzioni scalabili, altamente disponibili e sicure nel cloud AWS. Ha più di un decennio di esperienza lavorando in una varietà di ruoli tecnologici, con particolare attenzione all'ingegneria del software e all'architettura.

Anil Kodali è un Solutions Architect con Amazon Web Services. Lavora con i clienti di AWS EdTech, guidandoli con le best practice architetturali per la migrazione dei carichi di lavoro esistenti nel cloud e progettando nuovi carichi di lavoro con un approccio cloud-first. Prima di entrare in AWS, ha lavorato con i grandi rivenditori per aiutarli con le migrazioni al cloud.

Anil Kodali è un Solutions Architect con Amazon Web Services. Lavora con i clienti di AWS EdTech, guidandoli con le best practice architetturali per la migrazione dei carichi di lavoro esistenti nel cloud e progettando nuovi carichi di lavoro con un approccio cloud-first. Prima di entrare in AWS, ha lavorato con i grandi rivenditori per aiutarli con le migrazioni al cloud.

Prasanna Saraswathi Krishnan è un Solutions Architect con Amazon Web Services che lavora con i clienti EdTech. Li aiuta a guidare l'architettura cloud e la strategia dei dati utilizzando le migliori pratiche. Il suo background è nell'informatica distribuita, nell'analisi dei big data e nell'ingegneria dei dati. È appassionato di machine learning e di elaborazione del linguaggio naturale.

Prasanna Saraswathi Krishnan è un Solutions Architect con Amazon Web Services che lavora con i clienti EdTech. Li aiuta a guidare l'architettura cloud e la strategia dei dati utilizzando le migliori pratiche. Il suo background è nell'informatica distribuita, nell'analisi dei big data e nell'ingegneria dei dati. È appassionato di machine learning e di elaborazione del linguaggio naturale.

- AI

- oh arte

- generatore d'arte

- un robot

- Laboratorio di soluzioni Amazon ML

- Amazon Polly

- Amazon Transcribe

- Amazon Traduttore

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- Apprendimento automatico di AWS

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- zefiro