I ricercatori hanno scoperto oltre 100 modelli dannosi di machine learning (ML) sulla piattaforma AI Hugging Face che possono consentire agli aggressori di iniettare codice dannoso nei computer degli utenti.

Sebbene Hugging Face implementi misure di sicurezza, i risultati evidenziano il crescente rischio di “armare” i modelli disponibili al pubblico in quanto possono creare una backdoor per gli aggressori.

I risultati di JFrog Security Research fanno parte di uno studio in corso per analizzare come gli hacker possono utilizzare il machine learning per attaccare gli utenti.

Contenuto nocivo

Secondo un articolo di Informatica, i ricercatori hanno sviluppato un sistema di scansione avanzato per esaminare i modelli ospitati sulla piattaforma AI Hugging Face, come PyTorch e Tensorflow Keras.

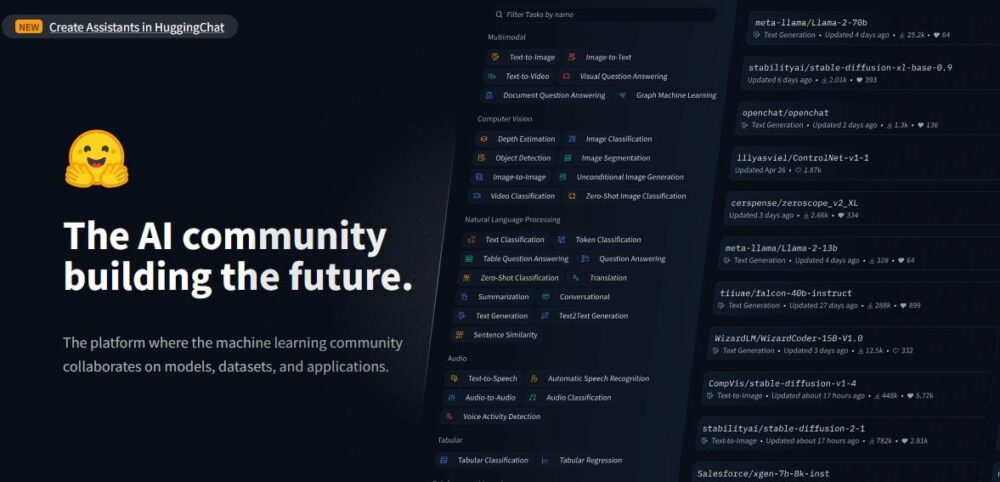

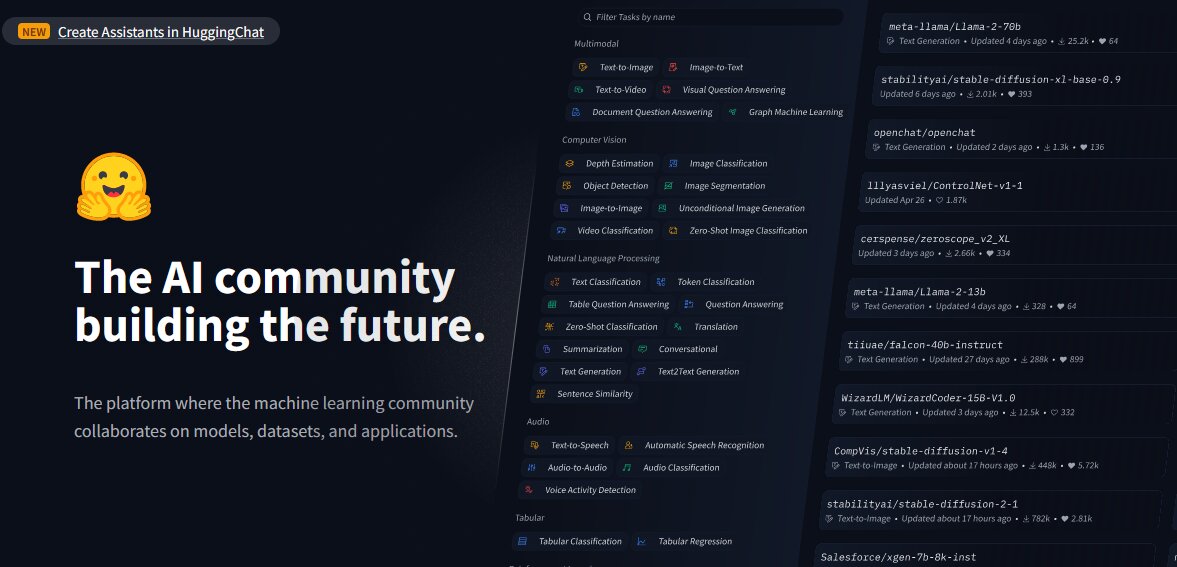

Hugging Face è una piattaforma sviluppata per la condivisione di modelli, set di dati e applicazioni di intelligenza artificiale. Analizzando i modelli, i ricercatori hanno scoperto carichi dannosi “all’interno di modelli apparentemente innocui”.

Questo nonostante il fatto che Hugging Face esegua misure di sicurezza come malware e scansione di pickle. Tuttavia, la piattaforma non limita il download di modelli che potrebbero essere potenzialmente dannosi e ne consente anche la disponibilità pubblica Modelli AI essere abusati e utilizzati come armi dagli utenti.

Esaminando la piattaforma e i modelli esistenti, i ricercatori di sicurezza di JFrog hanno scoperto circa 100 modelli di intelligenza artificiale con funzionalità dannose, secondo i loro studi. rapporto.

Alcuni di questi modelli, indica il rapporto, sono in grado di eseguire codice sulle macchine degli utenti, "creando così una backdoor persistente per gli aggressori".

I ricercatori hanno anche indicato che tali risultati escludono i falsi positivi. Questi, hanno affermato, sono una rappresentazione accurata della prevalenza di modelli dannosi sulla piattaforma.

Leggi anche: Apple reindirizza Car Team all'intelligenza artificiale dopo il rallentamento del mercato dei veicoli elettrici

Gli esempi

Secondo il rapporto di JFrog, uno dei casi “allarmanti” riguarda a PyTorch modello. Secondo quanto riferito, il modello è stato caricato da un utente identificato come "baller423", che è stato successivamente eliminato dalla piattaforma Hugging Face.

Esaminando ulteriormente il modello, i ricercatori hanno notato che conteneva un payload dannoso, che gli consentiva di stabilire una shell inversa su un host specificato (210.117.212.93).

David Cohen, ricercatore senior sulla sicurezza di JFrog, ha dichiarato: “(È) notevolmente più invadente e potenzialmente dannoso, poiché stabilisce una connessione diretta a un server esterno, indicando una potenziale minaccia alla sicurezza piuttosto che una semplice dimostrazione di vulnerabilità", ha scritto.

Ciò sfrutta il "metodo '_reduce_' del modulo pickle di Python per eseguire codice arbitrario al caricamento del file del modello, bypassando di fatto i metodi di rilevamento convenzionali."

I ricercatori hanno anche riconosciuto che lo stesso carico utile creava connessioni a diversi indirizzi IP, “suggerendo che gli operatori potrebbero essere ricercatori piuttosto che hacker malintenzionati”.

Una sveglia

Il team di JFrog ha notato che i risultati sono un campanello d’allarme per Hugging Face, dimostrando che la sua piattaforma è soggetta a manipolazione e potenziali minacce.

"Questi incidenti servono come toccanti promemoria delle minacce in corso ai repository Hugging Face e altri repository popolari come Kaggle, che potrebbero potenzialmente compromettere la privacy e la sicurezza delle organizzazioni che utilizzano queste risorse, oltre a porre sfide agli ingegneri AI/ML", ha affermato i ricercatori.

Questo viene come la sicurezza informatica minaccia il in tutto il mondo sono in aumento, alimentati dalla proliferazione di strumenti di intelligenza artificiale, con malintenzionati che ne abusano con intenzioni dannose. Gli hacker utilizzano l’intelligenza artificiale anche per avanzare attacchi di phishing e ingannare le persone.

Tuttavia, il team di JFrog ha fatto altre scoperte.

Un parco giochi per i ricercatori

Anche i ricercatori lo hanno notato Abbracciare il viso si è evoluto in un parco giochi per i ricercatori “che desiderano combattere le minacce emergenti, come dimostrato dalla vasta gamma di tattiche per aggirare le sue misure di sicurezza”.

Ad esempio, il payload caricato da "baller423" ha avviato una connessione shell inversa a un intervallo di indirizzi IP che appartiene a Kreonet (Korea Research Environment Open Network).

Secondo Lettura oscura, Kreonet è una rete ad alta velocità nella Corea del Sud che supporta la ricerca avanzata e le attività educative; “pertanto, è possibile che dietro il modello ci siano ricercatori o professionisti dell’intelligenza artificiale”.

"Possiamo vedere che la maggior parte dei payload 'dannosi' sono in realtà tentativi da parte di ricercatori e/o bug bounty di ottenere l'esecuzione di codice per scopi apparentemente legittimi", ha affermato Cohen.

Nonostante gli scopi legittimi, il team di JFrog ha tuttavia avvertito che le strategie impiegate dai ricercatori dimostrano chiaramente che piattaforme come Hugging Face sono aperte agli attacchi alla catena di approvvigionamento. Questi, secondo il team, possono essere personalizzati per concentrarsi su dati demografici specifici, come gli ingegneri AI o ML.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://metanews.com/over-100-malicious-code-execution-models-on-hugging-face-backdoors-users-devices/

- :ha

- :È

- :non

- 100

- 210

- 212

- 7

- 9

- a

- WRI

- Secondo

- preciso

- attività

- attori

- effettivamente

- aggiunta

- indirizzo

- indirizzi

- avanzare

- Avanzate

- AI

- Modelli AI

- Piattaforma AI

- AI / ML

- anche

- an

- analizzare

- l'analisi

- ed

- applicazioni

- arbitrario

- SONO

- Italia

- articolo

- AS

- attacco

- attacchi

- Tentativi

- disponibile

- porta posteriore

- Vasca

- BE

- stato

- dietro

- appartiene

- generosità

- Insetto

- bug bounty

- by

- aggirare

- chiamata

- Materiale

- capace

- auto

- casi

- sfide

- chiaramente

- CO

- codice

- cohen

- combattere

- viene

- compromesso

- informatica

- veloce

- Connessioni

- contenute

- convenzionale

- potuto

- creare

- Creazione

- personalizzate

- dataset

- David

- Dati Demografici

- dimostrare

- dimostrato

- Nonostante

- rivelazione

- sviluppato

- diverso

- dirette

- scoperto

- paesaggio differenziato

- effettua

- scaricare

- educativo

- in maniera efficace

- emergenti del mondo

- occupato

- enable

- Abilita

- consentendo

- Ingegneri

- Ambiente

- stabilire

- stabilisce

- si è evoluta

- esaminando

- eseguire

- esecuzione

- esecuzione

- esistente

- esterno

- Faccia

- di fronte

- fatto

- falso

- Compila il

- I risultati

- Focus

- Nel

- modulo

- da

- alimentato

- funzionalità

- ulteriormente

- ottenere

- Crescita

- hacker

- dannoso

- Avere

- he

- Alta

- Highlight

- host

- ospitato

- Come

- Tuttavia

- HTTPS

- identificato

- attrezzi

- in

- Aumento

- indicato

- indica

- indicando

- avviato

- iniettare

- esempio

- intenzioni

- ai miglioramenti

- intrusivo

- comporta

- IP

- Indirizzo IP

- Gli indirizzi IP

- IT

- SUO

- jpg

- keras

- Corea

- apprendimento

- legittimo

- leveraggi

- piace

- Caricamento in corso

- macchina

- machine learning

- macchine

- fatto

- maligno

- il malware

- Manipolazione

- Rappresentanza

- max-width

- Maggio..

- analisi

- semplice

- metodo

- metodi

- ML

- modello

- modelli

- Scopri di più

- maggior parte

- Rete

- segnatamente

- noto

- of

- on

- ONE

- in corso

- su

- aprire

- rete aperta

- Operatori

- or

- organizzazioni

- Altro

- su

- ancora

- parte

- Persone

- phishing

- attacchi di phishing

- piattaforma

- Piattaforme

- Platone

- Platone Data Intelligence

- PlatoneDati

- parco giochi

- Popolare

- possibile

- potenziale

- potenzialmente

- prevalenza

- Privacy

- Privacy e sicurezza

- pubblicamente

- fini

- pytorch

- gamma

- piuttosto

- Leggi

- riconosciuto

- rapporto

- riferito

- rappresentazione

- riparazioni

- ricercatore

- ricercatori

- Risorse

- limitare

- invertire

- Rischio

- Suddetto

- stesso

- scansione

- problemi di

- Misure di sicurezza

- vedere

- apparentemente

- anziano

- servire

- server

- compartecipazione

- Conchiglia

- mostra

- Sud

- Corea del Sud

- specifico

- specificato

- strategie

- Studio

- Successivamente

- tale

- Supporto

- sistema

- tattica

- team

- tensorflow

- di

- che

- Il

- loro

- Li

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- minaccia

- minacce

- a

- strumenti

- trucco

- caricato

- su

- uso

- Utente

- utenti

- utilizzando

- Utilizzando

- vulnerabilità

- avvertito

- Prima

- quale

- desiderio

- con

- mondo

- ha scritto

- zefiro