Questo post illustra le sfide più comuni che i clienti devono affrontare durante la ricerca di documenti interni e fornisce indicazioni concrete su come utilizzare i servizi AWS per creare un bot conversazionale generativo con intelligenza artificiale che renda più utili le informazioni interne.

I dati non strutturati rappresentano l’80% di tutti i dati presenti all'interno delle organizzazioni, costituiti da archivi di manuali, PDF, domande frequenti, e-mail e altri documenti che crescono quotidianamente. Oggi le aziende fanno affidamento su archivi di informazioni interne in continua crescita e i problemi sorgono quando la quantità di dati non strutturati diventa ingestibile. Spesso gli utenti si ritrovano a leggere e controllare molte diverse fonti interne per trovare le risposte di cui hanno bisogno.

I forum interni di domande e risposte possono aiutare gli utenti a ottenere risposte altamente specifiche ma richiedono anche tempi di attesa più lunghi. Nel caso delle FAQ interne specifiche dell'azienda, i lunghi tempi di attesa si traducono in una minore produttività dei dipendenti. I forum di domande e risposte sono difficili da scalare poiché si basano su risposte scritte manualmente. Con l’intelligenza artificiale generativa, attualmente c’è un cambiamento di paradigma nel modo in cui gli utenti cercano e trovano informazioni. Il prossimo passo logico è utilizzare l’intelligenza artificiale generativa per condensare documenti di grandi dimensioni in informazioni di piccole dimensioni per un più facile utilizzo da parte degli utenti. Invece di dedicare molto tempo alla lettura del testo o all'attesa di risposte, gli utenti possono generare riepiloghi in tempo reale basati su molteplici archivi esistenti di informazioni interne.

Panoramica della soluzione

La soluzione consente ai clienti di recuperare risposte selezionate alle domande poste sui documenti interni utilizzando un modello di trasformazione per generare risposte a domande sui dati su cui non è stato addestrato, una tecnica nota come prompt zero-shot. Adottando questa soluzione i clienti potranno ottenere i seguenti vantaggi:

- Trova risposte precise alle domande in base alle fonti esistenti di documenti interni

- Riduci il tempo che gli utenti dedicano alla ricerca di risposte utilizzando Large Language Models (LLM) per fornire risposte quasi immediate a domande complesse utilizzando documenti con le informazioni più aggiornate

- Cerca le domande con risposta precedente attraverso una dashboard centralizzata

- Riduci lo stress causato dal dedicare tempo alla lettura manuale delle informazioni per cercare risposte

Recupero della generazione aumentata (RAG)

Retrieval Augmented Generation (RAG) riduce alcune delle carenze delle query basate su LLM trovando le risposte dalla knowledge base e utilizzando LLM per riassumere i documenti in risposte concise. Per favore leggi questo settimana per imparare come implementare l'approccio RAG Amazon Kendra. I seguenti rischi e limitazioni sono associati alle query basate su LLM che un approccio RAG con Amazon Kendra affronta:

- Allucinazioni e tracciabilità: gli LLMS vengono addestrati su grandi set di dati e generano risposte sulle probabilità. Ciò può portare a risposte imprecise, note come allucinazioni.

- Silos di dati multipli: per fare riferimento a dati provenienti da più fonti all'interno della risposta, è necessario impostare un ecosistema di connettori per aggregare i dati. L'accesso a più repository è manuale e richiede molto tempo.

- Sicurezza: la sicurezza e la privacy sono considerazioni fondamentali quando si distribuiscono bot conversazionali basati su RAG e LLM. Nonostante l'utilizzo Amazon Comprehend per filtrare i dati personali che potrebbero essere forniti tramite le query degli utenti, esiste la possibilità che emergano involontariamente informazioni personali o sensibili, a seconda dei dati importati. Ciò significa che il controllo dell’accesso al chatbot è fondamentale per prevenire l’accesso involontario a informazioni sensibili.

- Rilevanza dei dati: gli LLMS vengono addestrati sui dati fino a una certa data, il che significa che le informazioni spesso non sono aggiornate. Il costo associato ai modelli di addestramento sui dati recenti è elevato. Per garantire risposte precise e aggiornate, le organizzazioni hanno la responsabilità di aggiornare e arricchire regolarmente il contenuto dei documenti indicizzati.

- Costo: il costo associato all'implementazione di questa soluzione dovrebbe essere una considerazione per le aziende. Le aziende devono valutare attentamente i propri requisiti di budget e prestazioni quando implementano questa soluzione. L'esecuzione di LLM può richiedere notevoli risorse computazionali, che possono aumentare i costi operativi. Questi costi possono diventare una limitazione per le applicazioni che devono operare su larga scala. Tuttavia, uno dei vantaggi di AWS Cloud è la flessibilità di pagare solo per ciò che utilizzi. AWS offre un modello di prezzi semplice, coerente e con pagamento in base al consumo, pertanto ti vengono addebitate solo le risorse che consumi.

Utilizzo di Amazon SageMaker JumpStart

Per i modelli linguistici basati su trasformatore, le organizzazioni possono trarre vantaggio dall'utilizzo Amazon Sage Maker JumpStart, che offre una raccolta di modelli di machine learning predefiniti. Amazon SageMaker JumpStart offre un'ampia gamma di modelli fondamentali per la generazione di testo e la risposta alle domande (Q&A) che possono essere facilmente distribuiti e utilizzati. Questa soluzione integra un modello FLAN T5-XL Amazon SageMaker JumpStart, ma ci sono diversi aspetti da tenere presenti quando scelta di un modello di fondazione.

Integrare la sicurezza nel nostro flusso di lavoro

Seguendo le migliori pratiche del Pilastro Sicurezza del Quadro ben architettato, Amazzonia Cognito viene utilizzato per l'autenticazione. I pool di utenti di Amazon Cognito possono essere integrati con provider di identità di terze parti che supportano diversi framework utilizzati per il controllo degli accessi, tra cui Open Authorization (OAuth), OpenID Connect (OIDC) o Security Assertion Markup Language (SAML). L'identificazione degli utenti e delle loro azioni consente alla soluzione di mantenere la tracciabilità. La soluzione utilizza anche il file Rilevamento delle informazioni di identificazione personale (PII) di Amazon Comprehend funzionalità per identificare e oscurare automaticamente le PII. Le PII oscurate includono indirizzi, numeri di previdenza sociale, indirizzi e-mail e altre informazioni sensibili. Questa progettazione garantisce che qualsiasi PII fornita dall'utente tramite la query di input venga oscurata. Le PII non vengono archiviate, utilizzate da Amazon Kendra o fornite a LLM.

Procedura dettagliata della soluzione

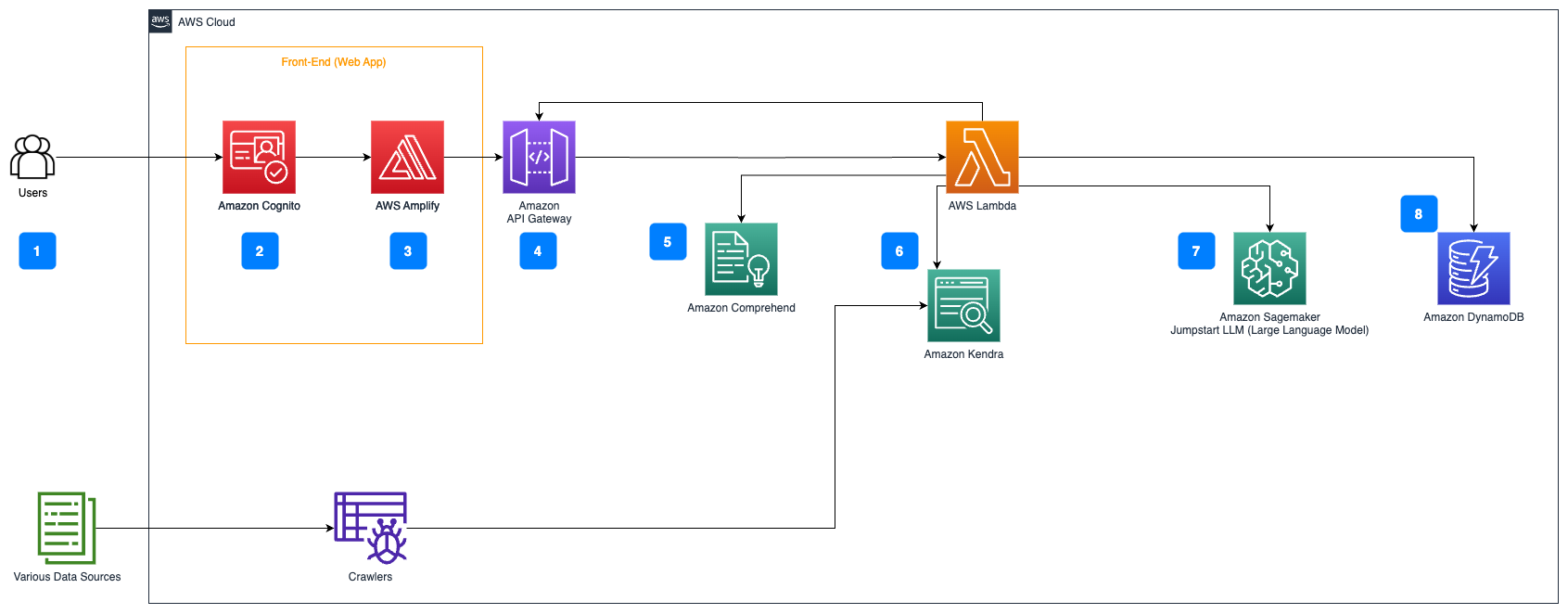

I seguenti passaggi descrivono il flusso di lavoro del flusso di risposta alle domande sui documenti:

- Gli utenti inviano una query tramite un'interfaccia web.

- Amazzonia Cognito viene utilizzato per l'autenticazione, garantendo un accesso sicuro all'applicazione web.

- Il front-end dell'applicazione Web è ospitato su AWS Amplifica.

- Gateway API Amazon ospita un'API REST con vari endpoint per gestire le richieste degli utenti autenticate tramite Amazon Cognito.

- Redazione PII con Amazon Comprehend:

- Elaborazione delle query utente: quando un utente invia una query o un input, viene prima passato attraverso Amazon Comprehend. Il servizio analizza il testo e identifica eventuali entità PII presenti all'interno della query.

- Estrazione PII: Amazon Comprehend estrae le entità PII rilevate dalla query dell'utente.

- Recupero di informazioni rilevanti con Amazon Kendra:

- Amazon Kendra viene utilizzato per gestire un indice di documenti che contiene le informazioni utilizzate per generare risposte alle query dell'utente.

- Il Recupero QA LangChain il modulo viene utilizzato per creare una catena di conversazioni che contenga informazioni rilevanti sulle query dell'utente.

- Integrazione con JumpStart di Amazon SageMaker:

- La funzione AWS Lambda utilizza la libreria LangChain e si connette all'endpoint JumpStart di Amazon SageMaker con una query ricca di contesto. L'endpoint Amazon SageMaker JumpStart funge da interfaccia del LLM utilizzato per l'inferenza.

- Memorizzazione delle risposte e restituzione all'utente:

- La risposta da LLM è archiviata in Amazon DynamoDB insieme alla query dell'utente, al timestamp, a un identificatore univoco e ad altri identificatori arbitrari per l'elemento come la categoria della domanda. La memorizzazione della domanda e della risposta come elementi distinti consente alla funzione AWS Lambda di ricreare facilmente la cronologia delle conversazioni di un utente in base al momento in cui sono state poste le domande.

- Infine, la risposta viene inviata all'utente tramite una richiesta HTTP tramite la risposta di integrazione dell'API REST di Amazon API Gateway.

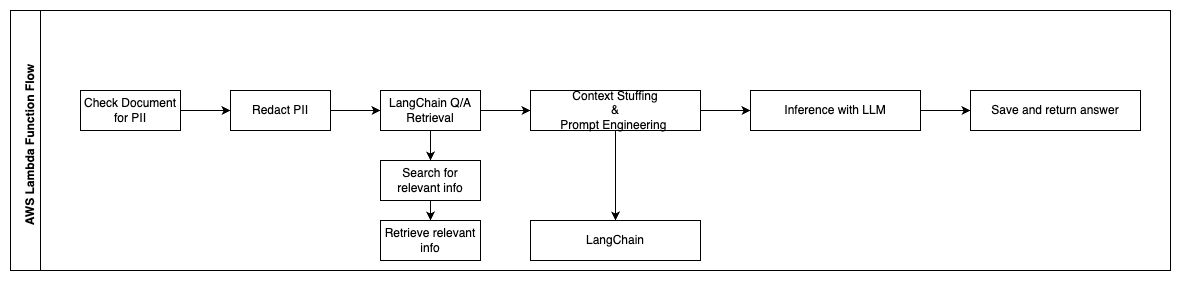

I passaggi seguenti descrivono le funzioni AWS Lambda e il loro flusso attraverso il processo:

- Controlla e oscura eventuali PII/informazioni sensibili

- Catena di recupero QA LangChain

- Cerca e recupera informazioni pertinenti

- Riempimento del contesto e ingegneria rapida

- Inferenza con LLM

- Restituisci la risposta e salvala

Utilizzo Tipico

Esistono molti casi d'uso aziendali in cui i clienti possono utilizzare questo flusso di lavoro. La sezione seguente spiega come utilizzare il flusso di lavoro in diversi settori e settori verticali.

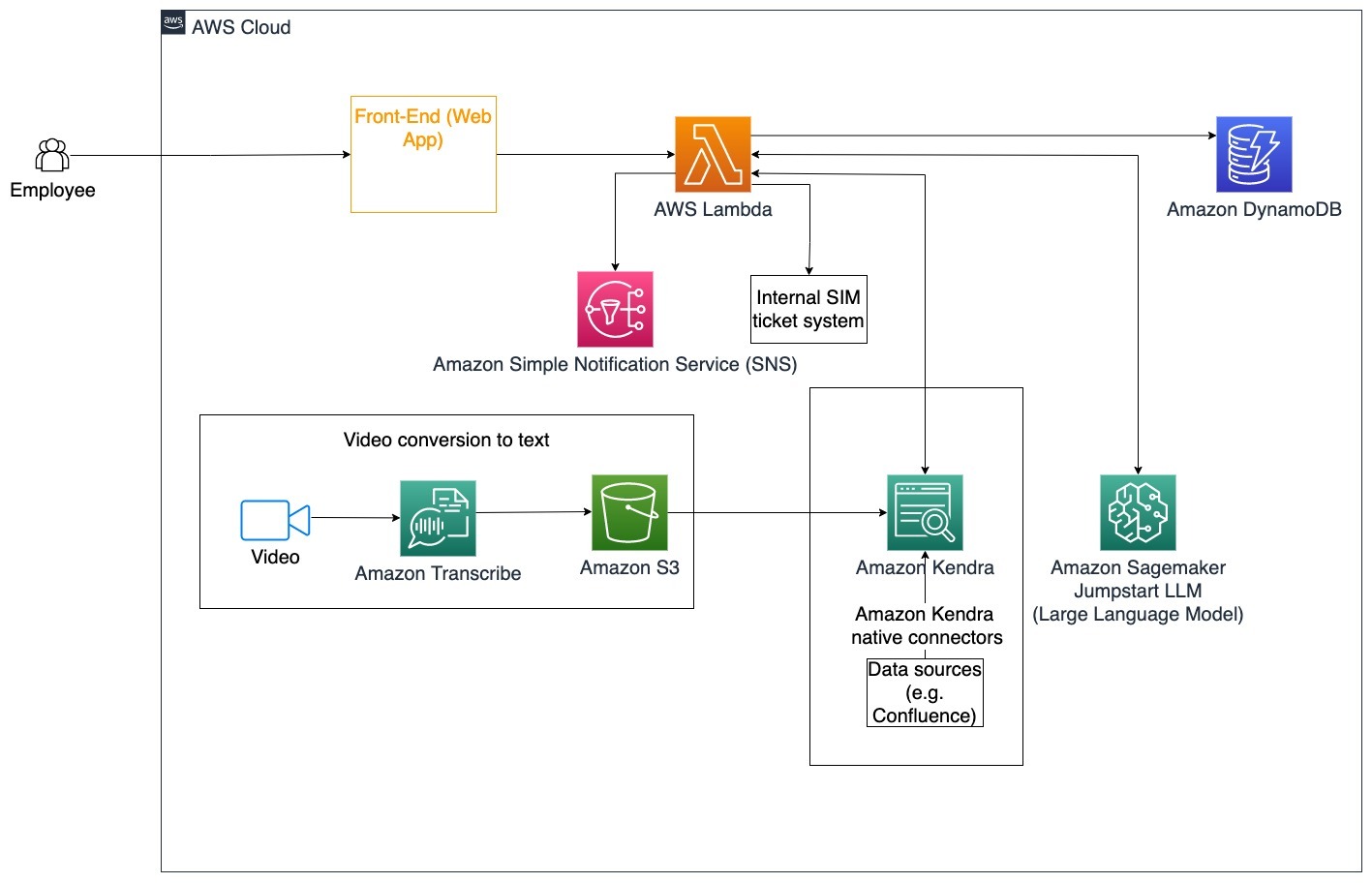

Assistenza ai dipendenti

Una formazione aziendale ben progettata può migliorare la soddisfazione dei dipendenti e ridurre il tempo necessario per l’inserimento di nuovi dipendenti. Con la crescita delle organizzazioni e l'aumento della complessità, i dipendenti hanno difficoltà a comprendere le numerose fonti di documenti interni. I documenti interni in questo contesto includono linee guida aziendali, politiche e procedure operative standard. Per questo scenario, un dipendente ha una domanda su come procedere e modificare un ticket di emissione di ticket interno. Il dipendente può accedere e utilizzare il bot conversazionale di intelligenza artificiale generativa (AI) per chiedere ed eseguire i passaggi successivi per un ticket specifico.

Caso d'uso specifico: Automatizza la risoluzione dei problemi per i dipendenti in base alle linee guida aziendali.

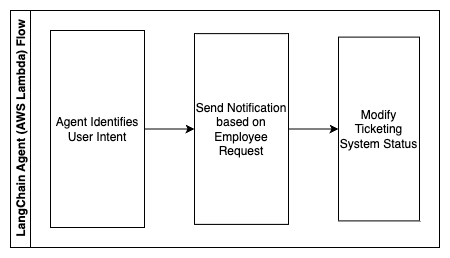

I passaggi seguenti descrivono le funzioni AWS Lambda e il loro flusso attraverso il processo:

- Agente LangChain per identificare l'intento

- Invia notifica in base alla richiesta del dipendente

- Modifica lo stato del biglietto

In questo diagramma dell'architettura è possibile inserire video di formazione aziendale Amazon Transcribe per raccogliere un registro di questi script video. Inoltre, i contenuti di formazione aziendale archiviati in varie fonti (ad esempio Confluence, Microsoft SharePoint, Google Drive, Jira, ecc.) possono essere utilizzati per creare indici tramite connettori Amazon Kendra. Leggi questo articolo per saperne di più sulla raccolta di native connettori puoi utilizzare in Amazon Kendra come punto di origine. Il crawler di Amazon Kendra è quindi in grado di utilizzare sia gli script video di formazione aziendale sia la documentazione archiviata in queste altre fonti per assistere il bot conversazionale nel rispondere a domande specifiche sulle linee guida di formazione aziendale dell'azienda. L'agente LangChain verifica le autorizzazioni, modifica lo stato del ticket e invia una notifica alle persone corrette utilizzando Amazon Simple Notification Service (AmazonSNS).

Squadre di assistenza clienti

Risolvere rapidamente le domande dei clienti migliora l'esperienza del cliente e incoraggia la fedeltà al marchio. Una base di clienti fedeli aiuta a incrementare le vendite, il che contribuisce ai profitti e aumenta il coinvolgimento dei clienti. I team di assistenza clienti spendono molte energie facendo riferimento a molti documenti interni e software di gestione delle relazioni con i clienti per rispondere alle domande dei clienti su prodotti e servizi. I documenti interni in questo contesto possono includere script generici per le chiamate di assistenza clienti, playbook, linee guida per l'escalation e informazioni aziendali. Il bot conversazionale con intelligenza artificiale generativa aiuta con l'ottimizzazione dei costi perché gestisce le query per conto del team di assistenza clienti.

Caso d'uso specifico: Gestire una richiesta di cambio olio in base alla cronologia dei servizi e al piano di servizio clienti acquistato.

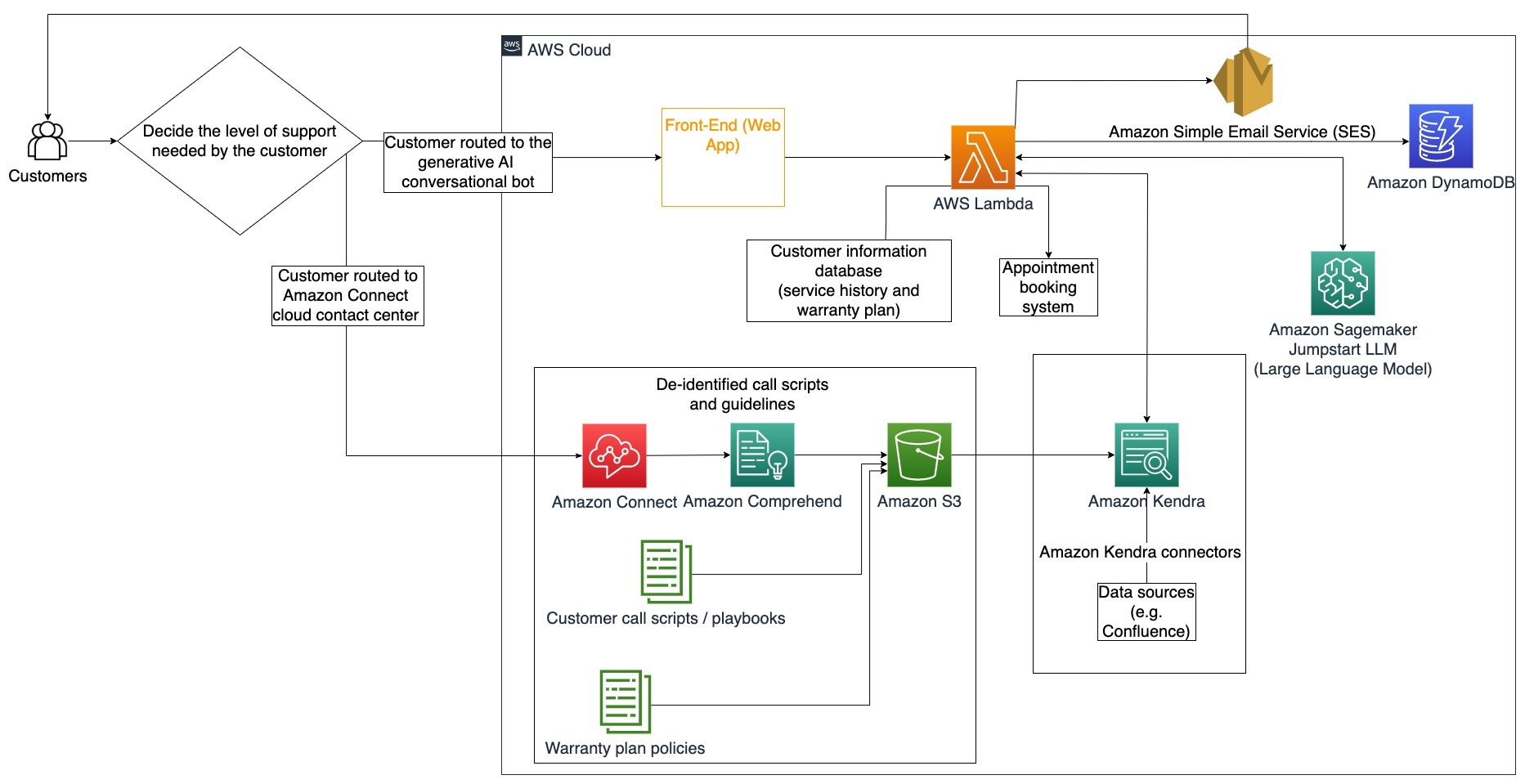

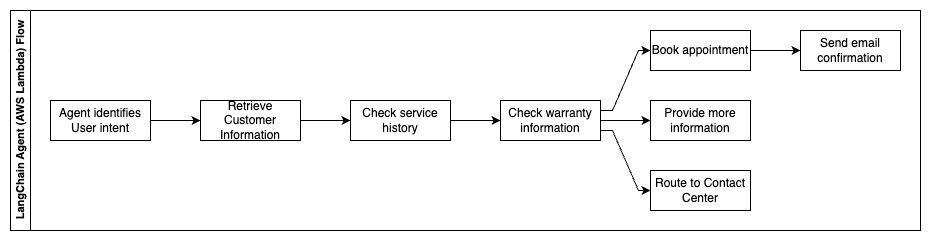

In questo diagramma dell'architettura, il cliente viene indirizzato al bot conversazionale con intelligenza artificiale generativa o al Amazon Connect centralino. Questa decisione può essere basata sul livello di supporto necessario o sulla disponibilità degli agenti dell'assistenza clienti. L'agente LangChain identifica l'intento del cliente e verifica l'identità. L'agente LangChain controlla anche la cronologia dei servizi e il piano di supporto acquistato.

I passaggi seguenti descrivono le funzioni AWS Lambda e il loro flusso attraverso il processo:

- L'agente LangChain identifica l'intento

- Recuperare le informazioni sul cliente

- Controlla la cronologia del servizio clienti e le informazioni sulla garanzia

- Prenota un appuntamento, fornisci ulteriori informazioni o raggiungi il contact center

- Invia e-mail di conferma

Amazon Connect viene utilizzato per raccogliere i registri vocali e delle chat e Amazon Comprehend viene utilizzato per rimuovere le informazioni di identificazione personale (PII) da questi registri. Il crawler di Amazon Kendra è quindi in grado di utilizzare i registri vocali e di chat redatti, gli script delle chiamate dei clienti e le policy del piano di supporto del servizio clienti per creare l'indice. Una volta presa la decisione, il bot conversazionale con intelligenza artificiale generativa decide se prenotare un appuntamento, fornire ulteriori informazioni o indirizzare il cliente al contact center per ulteriore assistenza. Per l'ottimizzazione dei costi, l'agente LangChain può anche generare risposte utilizzando meno token e un modello linguistico di grandi dimensioni meno costoso per le domande dei clienti con priorità inferiore.

Servizi finanziari

Le società di servizi finanziari fanno affidamento sull’uso tempestivo delle informazioni per rimanere competitive e rispettare le normative finanziarie. Utilizzando un bot conversazionale con intelligenza artificiale generativa, analisti e consulenti finanziari possono interagire con informazioni testuali in modo conversazionale e ridurre il tempo e gli sforzi necessari per prendere decisioni più informate. Al di fuori degli investimenti e delle ricerche di mercato, un bot conversazionale con intelligenza artificiale generativa può anche aumentare le capacità umane gestendo attività che tradizionalmente richiederebbero più tempo e impegno umano. Ad esempio, un istituto finanziario specializzato in prestiti personali può aumentare la velocità con cui i prestiti vengono elaborati garantendo al tempo stesso una maggiore trasparenza ai clienti.

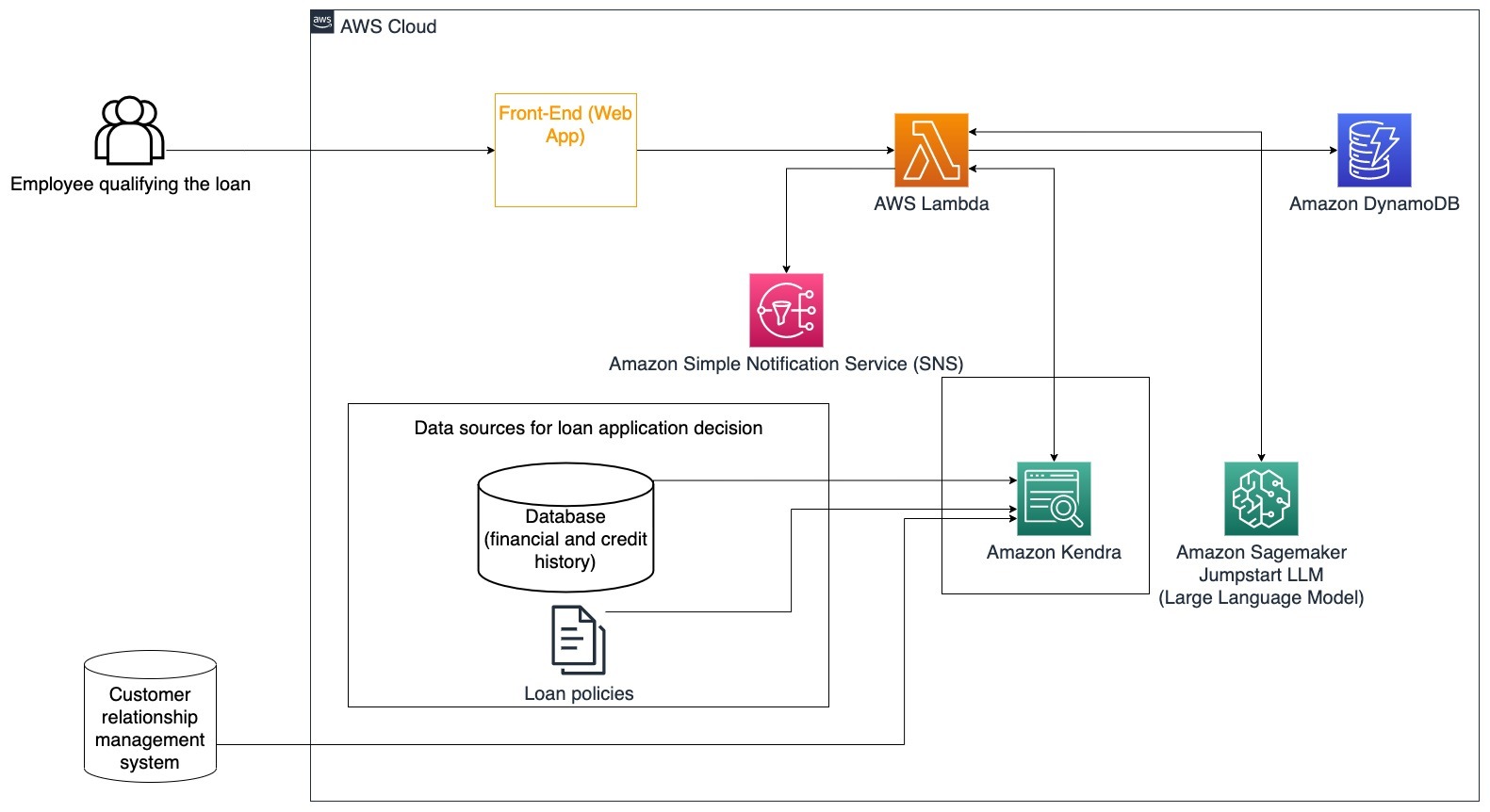

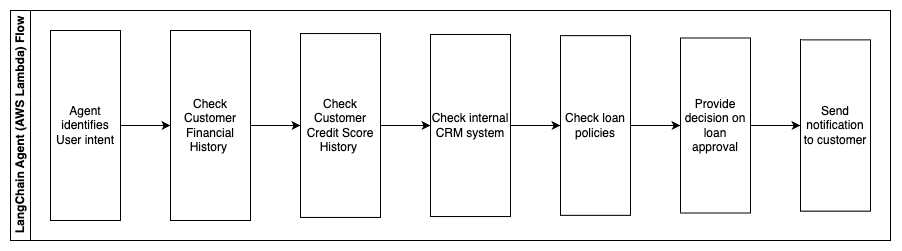

Caso d'uso specifico: Utilizza la storia finanziaria del cliente e le precedenti richieste di prestito per decidere e spiegare la decisione di prestito.

I passaggi seguenti descrivono le funzioni AWS Lambda e il loro flusso attraverso il processo:

- Agente LangChain per identificare l'intento

- Controllare la cronologia finanziaria e del punteggio di credito del cliente

- Controllare il sistema di gestione delle relazioni con i clienti interni

- Controllare le politiche di prestito standard e suggerire la decisione per i dipendenti che qualificano il prestito

- Invia notifica al cliente

Questa architettura incorpora i dati finanziari dei clienti archiviati in un database e i dati archiviati in uno strumento di gestione delle relazioni con i clienti (CRM). Questi punti dati vengono utilizzati per orientare una decisione basata sulle politiche di prestito interne dell'azienda. Il cliente può porre domande chiarificatrici per capire a quali prestiti ha diritto e le condizioni dei prestiti che può accettare. Se il bot conversazionale con intelligenza artificiale generativa non è in grado di approvare una richiesta di prestito, l’utente può comunque porre domande sul miglioramento dei punteggi di credito o su opzioni di finanziamento alternative.

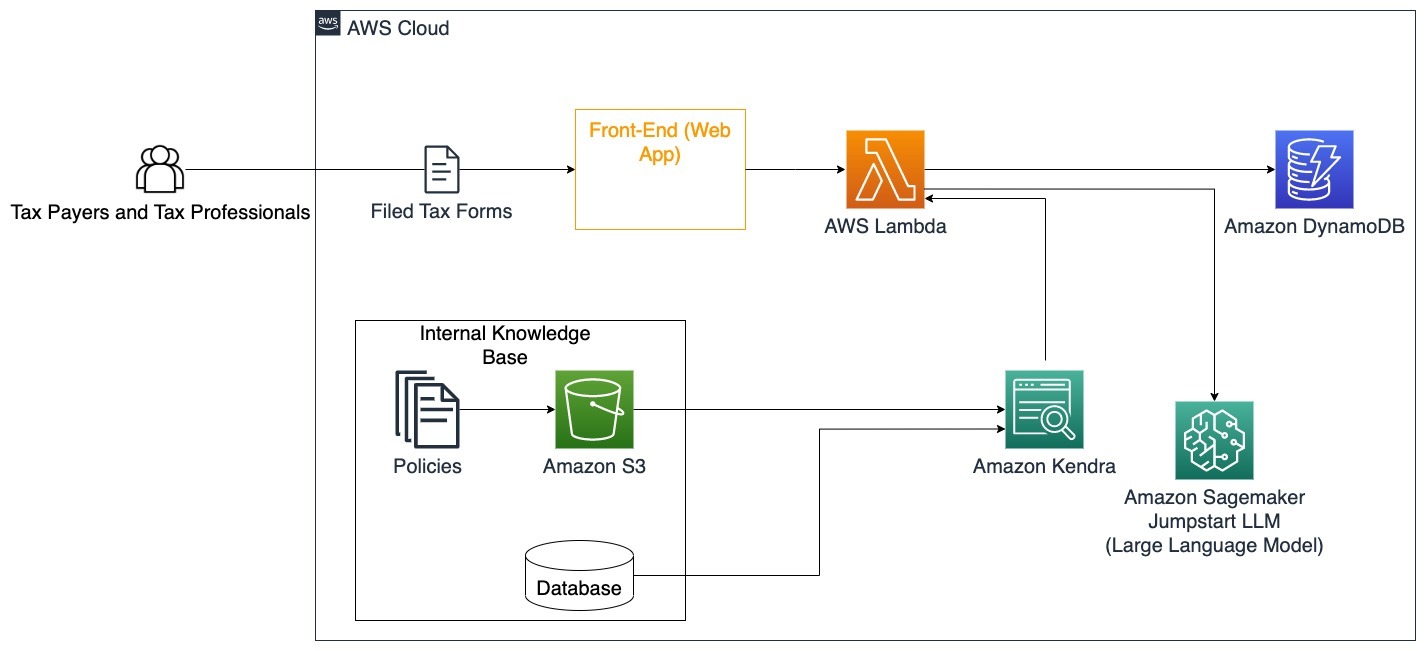

Enti Pubblici

I robot conversazionali generati dall’intelligenza artificiale possono apportare grandi vantaggi alle istituzioni governative accelerando la comunicazione, l’efficienza e i processi decisionali. I bot conversazionali con intelligenza artificiale generativa possono anche fornire accesso immediato alle basi di conoscenza interne per aiutare i dipendenti governativi a recuperare rapidamente informazioni, politiche e procedure (ad esempio criteri di ammissibilità, processi di richiesta, servizi e supporto ai cittadini). Una soluzione è un sistema interattivo che consente ai contribuenti e ai professionisti fiscali di trovare facilmente dettagli e vantaggi relativi alle imposte. Può essere utilizzato per comprendere le domande degli utenti, riassumere i documenti fiscali e fornire risposte chiare attraverso conversazioni interattive.

Gli utenti possono porre domande come:

- Come funziona l'imposta di successione e quali sono le soglie fiscali?

- Può spiegare il concetto di imposta sul reddito?

- Quali sono le implicazioni fiscali in caso di vendita di un secondo immobile?

Inoltre, gli utenti possono avere la comodità di inviare moduli fiscali a un sistema, che può aiutare a verificare la correttezza delle informazioni fornite.

Questa architettura illustra come gli utenti possono caricare moduli fiscali compilati nella soluzione e utilizzarli per la verifica interattiva e indicazioni su come completare accuratamente le informazioni necessarie.

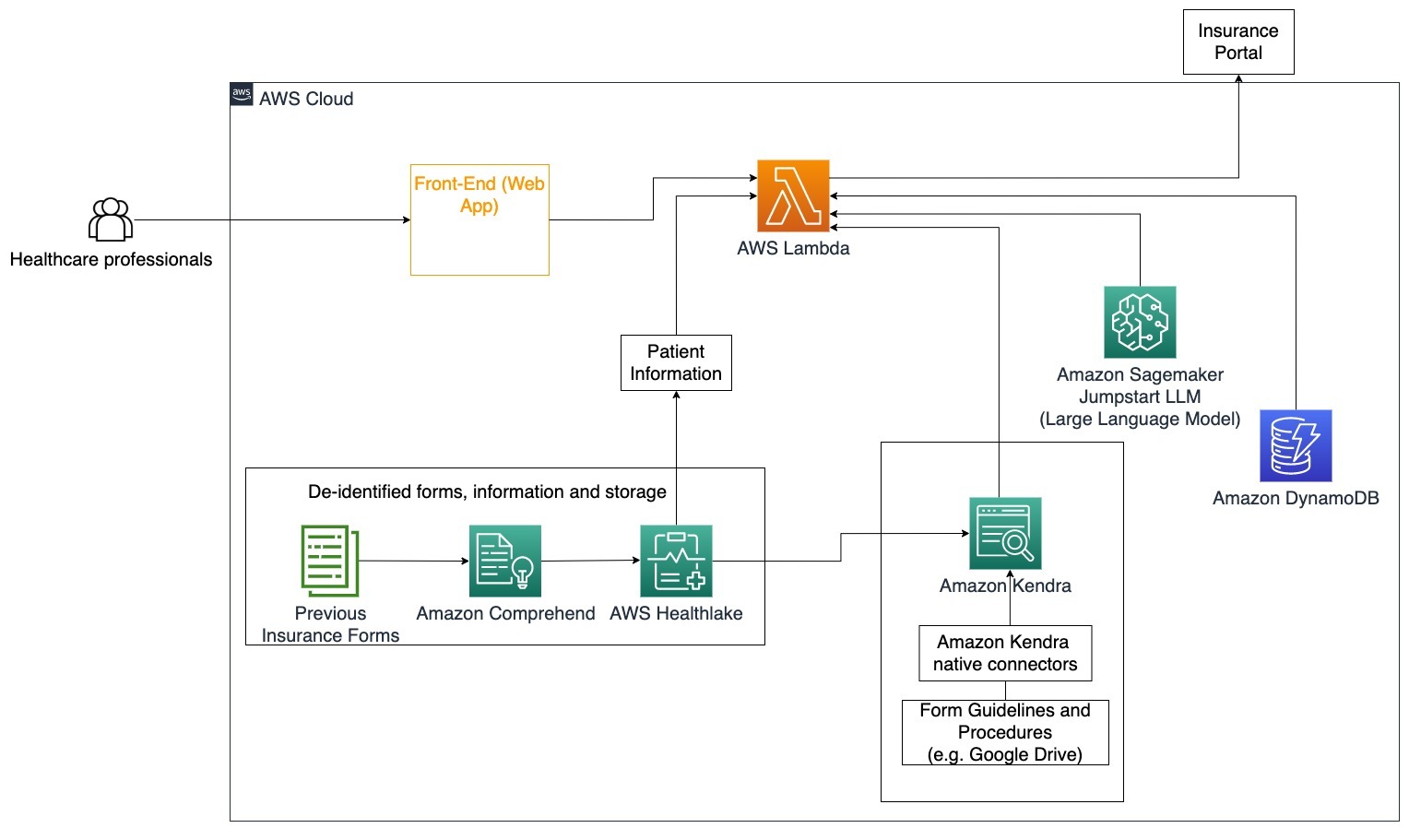

SANITARIETÀ

Le aziende sanitarie hanno l'opportunità di automatizzare l'uso di grandi quantità di informazioni interne sui pazienti, affrontando anche domande comuni relative a casi d'uso come opzioni di trattamento, richieste di indennizzi assicurativi, studi clinici e ricerca farmaceutica. L'utilizzo di un bot conversazionale con intelligenza artificiale generativa consente la generazione rapida e accurata di risposte sulle informazioni sanitarie dalla base di conoscenza fornita. Ad esempio, alcuni operatori sanitari dedicano molto tempo alla compilazione di moduli per presentare richieste di indennizzo assicurativo.

In contesti simili, gli amministratori e i ricercatori degli studi clinici hanno bisogno di trovare informazioni sulle opzioni di trattamento. Un bot conversazionale con intelligenza artificiale generativa può utilizzare i connettori predefiniti in Amazon Kendra per recuperare le informazioni più rilevanti da milioni di documenti pubblicati attraverso la ricerca continua condotta da aziende farmaceutiche e università.

Caso d'uso specifico: Riduci gli errori e il tempo necessario per compilare e inviare moduli assicurativi.

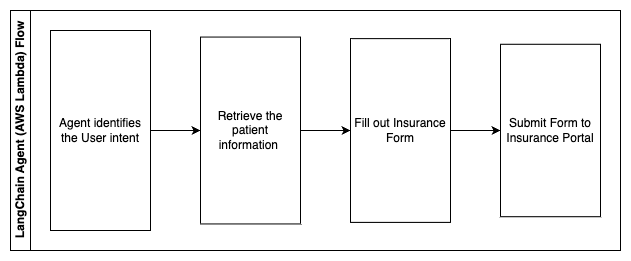

In questo diagramma dell'architettura, un operatore sanitario è in grado di utilizzare il bot conversazionale con intelligenza artificiale generativa per capire quali moduli devono essere compilati per l'assicurazione. L'agente LangChain è quindi in grado di recuperare i moduli corretti e aggiungere le informazioni necessarie per un paziente, oltre a fornire risposte per parti descrittive dei moduli basate su polizze assicurative e moduli precedenti. L'operatore sanitario può modificare le risposte fornite dal LLM prima di approvare e consegnare il modulo al portale assicurativo.

I passaggi seguenti descrivono le funzioni AWS Lambda e il loro flusso attraverso il processo:

- Agente LangChain per identificare l'intento

- Recuperare le informazioni necessarie sul paziente

- Compila il modulo di assicurazione in base alle informazioni del paziente e alle linee guida del modulo

- Invia il modulo al portale assicurativo dopo l'approvazione dell'utente

AWS HealthLake viene utilizzato per archiviare in modo sicuro i dati sanitari, inclusi i moduli assicurativi precedenti e le informazioni sui pazienti, mentre Amazon Comprehend viene utilizzato per rimuovere le informazioni di identificazione personale (PII) dai moduli assicurativi precedenti. Il crawler di Amazon Kendra è quindi in grado di utilizzare l'insieme di moduli assicurativi e linee guida per creare l'indice. Una volta che i moduli sono stati compilati dall'IA generativa, i moduli esaminati dal professionista medico possono essere inviati al portale assicurativo.

Costo stimato

Il costo della distribuzione della soluzione di base come prova di concetto è mostrato nella tabella seguente. Poiché la soluzione di base è considerata una prova di concetto, Amazon Kendra Developer Edition è stata utilizzata come opzione a basso costo poiché il carico di lavoro non sarebbe stato in produzione. La nostra ipotesi per Amazon Kendra Developer Edition era di 730 ore attive al mese.

Per Amazon SageMaker, abbiamo presupposto che il cliente avrebbe utilizzato l'istanza ml.g4dn.2xlarge per l'inferenza in tempo reale, con un singolo endpoint di inferenza per istanza. Puoi trovare ulteriori informazioni sui prezzi di Amazon SageMaker e sui tipi di istanze di inferenza disponibili qui.

| Servizi | Risorse consumate | Stima dei costi mensili in USD |

| AWS Amplifica | 150 minuti di costruzione 1 GB di dati serviti 500,000 richieste |

15.71 |

| Gateway API Amazon | 1 milione di chiamate API REST | 3.5 |

| AWS Lambda | 1 milione di richieste Durata 5 secondi per richiesta 2 GB di memoria allocata |

160.23 |

| Amazon DynamoDB | 1 milioni di letture 1 milione di scritture 100GB di Spazio |

26.38 |

| Amazon SageMaker | Inferenza in tempo reale con ml.g4dn.2xlarge | 676.8 |

| Amazon Kendra | Developer Edition con 730 ore/mese 10,000 documenti scansionati 5,000 query/giorno |

821.25 |

| . | . | Costo totale: 1703.87 |

*Amazon Cognito dispone di un livello gratuito di 50,000 utenti attivi mensili che utilizzano pool di utenti Cognito o 50 utenti attivi mensili che utilizzano provider di identità SAML 2.0

Ripulire

Per risparmiare sui costi, elimina tutte le risorse distribuite come parte del tutorial. Puoi eliminare qualsiasi endpoint SageMaker che potresti aver creato tramite la console SageMaker. Ricorda, l'eliminazione di un indice Amazon Kendra non rimuove i documenti originali dal tuo spazio di archiviazione.

Conclusione

In questo post ti abbiamo mostrato come semplificare l'accesso alle informazioni interne riepilogando da più repository in tempo reale. Dopo i recenti sviluppi degli LLM disponibili in commercio, le possibilità dell’intelligenza artificiale generativa sono diventate più evidenti. In questo post, abbiamo mostrato come utilizzare i servizi AWS per creare un chatbot serverless che utilizza l'intelligenza artificiale generativa per rispondere alle domande. Questo approccio incorpora un livello di autenticazione e il rilevamento PII di Amazon Comprehend per filtrare qualsiasi informazione sensibile fornita nella query dell'utente. Che si tratti di individui del settore sanitario che comprendono le sfumature per presentare richieste di indennizzo assicurativo o che le risorse umane comprendano normative specifiche a livello aziendale, sono molteplici i settori e i settori verticali che possono trarre vantaggio da questo approccio. Un modello base JumpStart di Amazon SageMaker è il motore dietro il chatbot, mentre viene utilizzato un approccio di context stuffing che utilizza la tecnica RAG per garantire che le risposte facciano riferimento in modo più accurato ai documenti interni.

Per ulteriori informazioni sull'utilizzo dell'intelligenza artificiale generativa su AWS, fare riferimento a Annuncio di nuovi strumenti per creare con l'IA generativa su AWS. Per indicazioni più approfondite sull'utilizzo della tecnica RAG con i servizi AWS, fare riferimento a Crea rapidamente applicazioni di intelligenza artificiale generativa ad alta precisione sui dati aziendali utilizzando Amazon Kendra, LangChain e modelli di linguaggio di grandi dimensioni. Poiché l'approccio in questo blog è indipendente dal LLM, qualsiasi LLM può essere utilizzato per l'inferenza. Nel nostro prossimo post, illustreremo le modalità per implementare questa soluzione utilizzando Amazon Bedrock e Amazon Titan LLM.

Informazioni sugli autori

Abhishek Maligehalli Shivalingaiah è un Senior AI Services Solution Architect presso AWS. È appassionato di creazione di applicazioni utilizzando l'intelligenza artificiale generativa, Amazon Kendra e la PNL. Ha circa 10 anni di esperienza nella creazione di soluzioni di dati e intelligenza artificiale per creare valore per clienti e imprese. Ha persino creato un chatbot (personale) per divertirsi e rispondere alle domande sulla sua carriera e sul suo percorso professionale. Al di fuori del lavoro gli piace realizzare ritratti di familiari e amici e adora creare opere d'arte.

Abhishek Maligehalli Shivalingaiah è un Senior AI Services Solution Architect presso AWS. È appassionato di creazione di applicazioni utilizzando l'intelligenza artificiale generativa, Amazon Kendra e la PNL. Ha circa 10 anni di esperienza nella creazione di soluzioni di dati e intelligenza artificiale per creare valore per clienti e imprese. Ha persino creato un chatbot (personale) per divertirsi e rispondere alle domande sulla sua carriera e sul suo percorso professionale. Al di fuori del lavoro gli piace realizzare ritratti di familiari e amici e adora creare opere d'arte.

Medha Aiyah è un Associate Solutions Architect presso AWS, con sede ad Austin, Texas. Si è recentemente laureata presso l'Università del Texas a Dallas nel dicembre 2022 con un master in informatica con una specializzazione in sistemi intelligenti incentrata su AI/ML. È interessata a saperne di più su AI/ML e sull'utilizzo dei servizi AWS per scoprire soluzioni di cui i clienti possono trarre vantaggio.

Medha Aiyah è un Associate Solutions Architect presso AWS, con sede ad Austin, Texas. Si è recentemente laureata presso l'Università del Texas a Dallas nel dicembre 2022 con un master in informatica con una specializzazione in sistemi intelligenti incentrata su AI/ML. È interessata a saperne di più su AI/ML e sull'utilizzo dei servizi AWS per scoprire soluzioni di cui i clienti possono trarre vantaggio.

Hugo Tse è un Associate Solutions Architect presso AWS con sede a Seattle, Washington. Ha conseguito un Master in Informatica presso l'Arizona State University e una laurea in Economia presso l'Università di Chicago. È membro dell'Information Systems Audit and Control Association (ISACA) e dell'International Information System Security Certification Consortium (ISC)2. Gli piace aiutare i clienti a trarre vantaggio dalla tecnologia.

Hugo Tse è un Associate Solutions Architect presso AWS con sede a Seattle, Washington. Ha conseguito un Master in Informatica presso l'Arizona State University e una laurea in Economia presso l'Università di Chicago. È membro dell'Information Systems Audit and Control Association (ISACA) e dell'International Information System Security Certification Consortium (ISC)2. Gli piace aiutare i clienti a trarre vantaggio dalla tecnologia.

Ayman Ishimwe è un Associate Solutions Architect presso AWS con sede a Seattle, Washington. Ha conseguito un Master in Ingegneria del software e IT presso l'Università di Oakland. Ha una precedente esperienza nello sviluppo di software, in particolare nella creazione di microservizi per applicazioni web distribuite. La sua passione è aiutare i clienti a creare soluzioni robuste e scalabili sui servizi cloud AWS seguendo le migliori pratiche.

Ayman Ishimwe è un Associate Solutions Architect presso AWS con sede a Seattle, Washington. Ha conseguito un Master in Ingegneria del software e IT presso l'Università di Oakland. Ha una precedente esperienza nello sviluppo di software, in particolare nella creazione di microservizi per applicazioni web distribuite. La sua passione è aiutare i clienti a creare soluzioni robuste e scalabili sui servizi cloud AWS seguendo le migliori pratiche.

Shervin Suresh è un Associate Solutions Architect presso AWS con sede ad Austin, Texas. Ha conseguito un master in ingegneria del software con specializzazione in cloud computing e virtualizzazione e una laurea in ingegneria informatica presso la San Jose State University. La sua passione è sfruttare la tecnologia per contribuire a migliorare la vita di persone di ogni provenienza.

Shervin Suresh è un Associate Solutions Architect presso AWS con sede ad Austin, Texas. Ha conseguito un master in ingegneria del software con specializzazione in cloud computing e virtualizzazione e una laurea in ingegneria informatica presso la San Jose State University. La sua passione è sfruttare la tecnologia per contribuire a migliorare la vita di persone di ogni provenienza.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Automobilistico/VE, Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Grafico Prime. Migliora il tuo gioco di trading con ChartPrime. Accedi qui.

- BlockOffset. Modernizzare la proprietà della compensazione ambientale. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :ha

- :È

- :non

- :Dove

- $ SU

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- capace

- WRI

- Accetta

- accesso

- Accedendo

- conti

- preciso

- con precisione

- azioni

- attivo

- aggiungere

- Inoltre

- indirizzi

- indirizzamento

- amministratori

- Adottando

- consulenti

- Dopo shavasana, sedersi in silenzio; saluti;

- Agente

- agenti

- aggregato

- AI

- Servizi di intelligenza artificiale

- AI / ML

- Tutti

- consente

- lungo

- anche

- alternativa

- Amazon

- Gateway API Amazon

- Amazzonia Cognito

- Amazon Comprehend

- Amazon Kendra

- Amazon Sage Maker

- JumpStart di Amazon SageMaker

- Amazon Web Services

- quantità

- importi

- an

- Gli analisti

- analisi

- ed

- rispondere

- risposte

- in qualsiasi

- api

- apparente

- Applicazioni

- applicazioni

- appuntamento

- approccio

- approvare

- architettura

- SONO

- sorgere

- Arizona

- in giro

- articolo

- artificiale

- intelligenza artificiale

- Intelligenza artificiale (AI)

- opere d'arte

- AS

- chiedere

- aspetti

- valutare

- assistere

- Assistenza

- Associate

- associato

- Associazione

- assunzione

- At

- revisione

- aumentata

- austin

- autenticato

- Autenticazione

- autorizzazione

- automatizzare

- automaticamente

- disponibilità

- disponibile

- AWS

- AWS Lambda

- precedente

- sfondi

- base

- basato

- BE

- Orso

- perché

- diventare

- diventa

- stato

- prima

- per conto

- dietro

- beneficio

- vantaggi

- MIGLIORE

- best practice

- Meglio

- Blog

- libro

- Bot

- entrambi

- bots

- Parte inferiore

- marca

- budget limitato.

- costruire

- Costruzione

- costruito

- affari

- aziende

- ma

- by

- chiamata

- Materiale

- funzionalità

- Career

- attentamente

- Custodie

- casi

- Categoria

- ha causato

- centro

- centralizzata

- certo

- Certificazione

- catena

- sfide

- il cambiamento

- carico

- chatbot

- verifica

- Controlli

- Chicago

- pulire campo

- Info su

- test clinici

- Cloud

- il cloud computing

- servizi cloud

- raccogliere

- collezione

- commercialmente

- Uncommon

- Comunicazione

- Aziende

- azienda

- Società

- competitivo

- Completato

- completando

- complesso

- complessità

- ottemperare

- comprendere

- computer

- Ingegneria Informatica

- Informatica

- informatica

- concentrazione

- concetto

- conciso

- condotto

- confluenza

- Connettiti

- collega

- considerazione

- Considerazioni

- considerato

- coerente

- Consistente

- consolle

- consorzio

- consumare

- consumo

- contatti

- centralino

- contiene

- contenuto

- contesto

- continuamente

- contribuisce

- di controllo

- controllo

- comodità

- Conversazione

- discorsivo

- Conversazioni

- Aziende

- correggere

- Costo

- Costi

- crawler

- creare

- Creare valore

- creato

- Creazione

- credito

- criteri

- critico

- CRM

- cruciale

- a cura

- Corrente

- Attualmente

- cliente

- Il coinvolgimento del cliente

- esperienza del cliente

- Servizio clienti

- Assistenza clienti

- Clienti

- alle lezioni

- Dallas

- dati

- punti dati

- set di dati

- Banca Dati

- Data

- Dicembre

- decide

- decisione

- Decision Making

- decisioni

- Laurea

- consegnato

- Dipendente

- schierato

- distribuzione

- descrivere

- Design

- Nonostante

- dettagli

- rilevato

- rivelazione

- Costruttori

- Mercato

- sviluppi

- diverso

- difficile

- scopri

- distribuito

- documentazione

- documenti

- effettua

- non

- guidare

- durata

- e

- più facile

- facilmente

- Economia

- ecosistema

- edizione

- efficienza

- sforzo

- o

- eleggibilità

- Dipendente

- dipendenti

- Abilita

- incoraggia

- endpoint

- energia

- Fidanzamento

- motore

- Ingegneria

- arricchendo

- garantire

- assicura

- assicurando

- Impresa

- aziende

- entità

- errori

- intensificazione

- stima

- eccetera

- Anche

- esempio

- eseguire

- esistente

- costoso

- esperienza

- Spiegare

- Spiega

- estrazione

- estratti

- Faccia

- famiglia

- caratteristica

- Federale

- meno

- figura

- Compila il

- riempire

- pieno

- riempimento

- filtro

- finanziario

- dati finanziari

- storia finanziaria

- istituzione finanziaria

- finanziamento

- Trovate

- ricerca

- Nome

- Flessibilità

- flusso

- messa a fuoco

- i seguenti

- Nel

- modulo

- forme

- forum

- essere trovato

- Fondazione

- quadri

- Gratis

- amici

- da

- ti divertirai

- function

- funzioni

- ulteriormente

- Guadagno

- porta

- generare

- ELETTRICA

- generativo

- AI generativa

- ottenere

- dato

- dà

- Dare

- Enti Pubblici

- molto

- Crescere

- Crescita

- cresce

- guida

- linee guida

- maniglia

- Maniglie

- Manovrabilità

- Avere

- avendo

- he

- Salute e benessere

- informazioni sulla salute

- assistenza sanitaria

- Aiuto

- aiutare

- aiuta

- suo

- Alta

- vivamente

- il suo

- storia

- detiene

- ospitato

- padroni di casa

- ORE

- Come

- Tutorial

- Tuttavia

- hr

- HTML

- HTTPS

- umano

- i

- identificatore

- identificatori

- identifica

- identificare

- identificazione

- Identità

- if

- illustra

- realizzare

- Implementazione

- implicazioni

- competenze

- migliora

- miglioramento

- in

- Uno sguardo approfondito sui miglioramenti dei pneumatici da corsa di Bridgestone.

- impreciso

- includere

- inclusi

- Compreso

- Reddito

- tassa sul reddito

- Aumento

- Aumenta

- Index

- indicizzati

- indici

- individui

- industrie

- far sapere

- informazioni

- Sistemi di informazione

- tecnologie dell'informazione

- informati

- eredità

- ingresso

- esempio

- immediato

- invece

- Istituzione

- istituzioni

- assicurazione

- integrato

- Integra

- integrazione

- Intelligence

- Intelligente

- intento

- interagire

- interattivo

- interessato

- Interfaccia

- interno

- Internazionale

- ai miglioramenti

- investimento

- problema

- IT

- elementi

- viaggio

- jpg

- mantenere

- conoscenze

- conosciuto

- Lingua

- grandi

- strato

- portare

- IMPARARE

- apprendimento

- meno

- Livello

- leveraging

- Biblioteca

- limitazione

- limiti

- linea

- Lives

- LLM

- prestito

- Prestiti e finanziamenti

- ceppo

- logico

- Lunghi

- a lungo

- più a lungo

- Guarda

- lotto

- ama

- a basso costo

- inferiore

- leale

- lealtà

- macchina

- machine learning

- fatto

- mantenere

- make

- FA

- Fare

- gestire

- gestione

- modo

- Manuale

- manualmente

- molti

- Rappresentanza

- ricerche di mercato

- master

- Maggio..

- si intende

- medicale

- membro

- Memorie

- microservices

- Microsoft

- milione

- milioni

- mente

- ML

- modello

- modelli

- Moduli

- Mese

- mensile

- Scopri di più

- maggior parte

- multiplo

- nativo

- necessaria

- Bisogno

- di applicazione

- esigenze

- New

- GENERAZIONE

- nlp

- notifica

- numeri

- Oakland

- OAuth

- of

- Offerte

- di frequente

- Olio

- on

- Procedura di Onboarding

- una volta

- ONE

- in corso

- esclusivamente

- aprire

- operare

- operativo

- operativa

- Opportunità

- ottimizzazione

- Opzione

- Opzioni

- or

- minimo

- organizzazioni

- i

- Altro

- nostro

- su

- contorno

- al di fuori

- ancora

- paradigma

- parte

- Ricambi

- Passato

- appassionato

- paziente

- Paga le

- Persone

- per

- performance

- permessi

- cronologia

- dati personali

- Personalmente

- Pharmaceutical

- Pilastro

- piano

- Platone

- Platone Data Intelligence

- PlatoneDati

- per favore

- punto

- punti

- Termini e Condizioni

- Piscine

- Portale

- ritratti

- possibilità

- possibilità

- Post

- alimentato

- pratiche

- presenti

- prevenire

- precedente

- in precedenza

- prezzi

- modello di prezzo

- Precedente

- priorità

- Privacy

- problemi

- procedure

- procedere

- processi

- Elaborato

- i processi

- lavorazione

- Produzione

- della produttività

- Prodotti

- professionale

- Scelto dai professionisti

- proprietà

- fornire

- purché

- fornitori

- fornitura

- pubblicato

- acquistati

- Domande e risposte

- qualificarsi

- qualifica

- query

- domanda

- Domande

- Presto

- rapidamente

- gamma

- tasso

- Leggi

- Lettura

- tempo reale

- recente

- recentemente

- ridurre

- riduce

- riferimento

- riferimento

- per quanto riguarda

- regolarmente

- normativa

- rapporto

- rilevanza

- pertinente

- fare affidamento

- resti

- ricorda

- rimuovere

- richiesta

- richieste

- richiedere

- necessario

- Requisiti

- riparazioni

- ricercatori

- Risoluzione

- risolvere

- Risorse

- risposta

- risposte

- responsabilità

- REST

- colpevole

- di ritorno

- rivisto

- destra

- rischi

- robusto

- strada

- running

- s

- sagemaker

- vendite

- San

- San Jose

- soddisfazione

- Risparmi

- scalabile

- Scala

- scenario

- Scienze

- Punto

- script

- Cerca

- ricerca

- Seattle

- Secondo

- secondo

- Sezione

- sicuro

- in modo sicuro

- problemi di

- Vendita

- inviare

- anziano

- delicata

- inviato

- serverless

- serve

- servizio

- Servizi

- set

- Set

- impostazioni

- alcuni

- lei

- spostamento

- carenze

- dovrebbero

- in mostra

- ha mostrato

- mostrato

- silos

- simile

- Un'espansione

- semplificare

- da

- singolo

- dimensioni

- inferiore

- So

- Social

- Software

- lo sviluppo del software

- Ingegneria del software

- soluzione

- Soluzioni

- alcuni

- Fonte

- fonti

- specializzata

- specifico

- in particolare

- spendere

- Spendere

- Standard

- Regione / Stato

- Stato dei servizi

- soggiorno

- step

- Passi

- Ancora

- conservazione

- Tornare al suo account

- memorizzati

- memorizzare

- stress

- ripieno

- sostanziale

- tale

- suggerire

- riassumere

- supporto

- sistema

- SISTEMI DI TRATTAMENTO

- tavolo

- prende

- task

- imposta

- team

- le squadre

- Tecnologia

- condizioni

- Texas

- testo

- testuale

- che

- Il

- le informazioni

- loro

- si

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- di parti terze standard

- questo

- Attraverso

- biglietto

- biglietteria

- fila

- tempo

- richiede tempo

- tempestivo

- volte

- timestamp

- titano

- a

- oggi

- Tokens

- strumenti

- Tracciabilità

- tradizionalmente

- allenato

- Training

- trasformatore

- Trasparenza

- trattamento

- prova

- studi clinici

- lezione

- Tipi di

- incapace

- capire

- e una comprensione reciproca

- unico

- Università

- Università

- University of Chicago

- up-to-date

- aggiornato

- aggiornamento

- uso

- caso d'uso

- utilizzato

- Utente

- utenti

- usa

- utilizzando

- utilizzare

- utilizzati

- Utilizzando

- APPREZZIAMO

- vario

- Convalida

- verificare

- verticali

- via

- Video

- Video

- Voce

- aspettare

- In attesa

- Prima

- Washington

- modi

- we

- sito web

- applicazione web

- applicazioni web

- servizi web

- WELL

- sono stati

- Che

- quando

- se

- quale

- while

- OMS

- largo

- Vasta gamma

- con

- entro

- Lavora

- flusso di lavoro

- lavoro

- sarebbe

- scritto

- anni

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro