Nella nostra ricerca per limitare il potenziale distruttivo dell’intelligenza artificiale, un nuovo articolo dell’Università di Cambridge ha suggerito di integrare kill switch e blocchi remoti, come quelli sviluppati per fermare il lancio non autorizzato di armi nucleari, nell’hardware che lo alimenta.

La carta [PDF], che include voci di numerose istituzioni accademiche e diverse di OpenAI, sostiene che la regolamentazione dell'hardware su cui si basano questi modelli potrebbe essere il modo migliore per prevenirne l'uso improprio.

“Il calcolo rilevante per l’intelligenza artificiale è un punto di intervento particolarmente efficace: è rilevabile, escludibile e quantificabile e viene prodotto attraverso una catena di approvvigionamento estremamente concentrata”, sostengono i ricercatori.

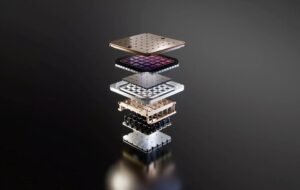

L’addestramento dei modelli più prolifici, che si ritiene superino un trilione di parametri, richiede un’immensa infrastruttura fisica: decine di migliaia di GPU o acceleratori e settimane o addirittura mesi di tempo di elaborazione. Ciò, dicono i ricercatori, rende difficile nascondere l’esistenza e il relativo rendimento di queste risorse.

Inoltre, i chip più avanzati utilizzati per addestrare questi modelli sono prodotti da un numero relativamente piccolo di aziende, come Nvidia, AMD e Intel, consentendo ai politici di limitare la vendita di questi beni a persone o paesi di interesse.

Questi fattori, insieme ad altri come i vincoli della catena di approvvigionamento sulla produzione di semiconduttori, offrono ai politici i mezzi per comprendere meglio come e dove viene implementata l’infrastruttura di intelligenza artificiale, chi è e chi non può accedervi e imporre sanzioni per il suo uso improprio, sostiene il documento. .

Controllare l'infrastruttura

Il documento evidenzia numerosi modi in cui i politici potrebbero avvicinarsi alla regolamentazione dell’hardware dell’IA. Molti dei suggerimenti – compresi quelli volti a migliorare la visibilità e limitare la vendita di acceleratori di intelligenza artificiale – sono già in fase di attuazione a livello nazionale.

L’anno scorso il presidente degli Stati Uniti Joe Biden ha presentato una proposta ordine esecutivo mirato a identificare le aziende che sviluppano grandi modelli di intelligenza artificiale a duplice uso, nonché i fornitori di infrastrutture in grado di farlo addestrandoli. Se non lo conosci, il termine "dual-use" si riferisce a tecnologie che possono svolgere una doppia funzione in applicazioni civili e militari.

Più recentemente, il Dipartimento del Commercio degli Stati Uniti proposto regolamento che imporrebbe ai fornitori di servizi cloud americani di attuare politiche più rigorose di “conosci il tuo cliente” per impedire a persone o paesi interessati di aggirare le restrizioni all’esportazione.

Questo tipo di visibilità è prezioso, notano i ricercatori, poiché potrebbe aiutare a evitare un’altra corsa agli armamenti, come quella innescata dalla controversia sul gap missilistico, in cui rapporti errati hanno portato a un massiccio accumulo di missili balistici. Sebbene preziosi, avvertono che l’attuazione di questi requisiti di reporting rischia di invadere la privacy dei clienti e persino di portare alla fuga di dati sensibili.

Nel frattempo, sul fronte commerciale, il Dipartimento del Commercio ha continuato a farlo intensificare restrizioni, limitando la performance degli acceleratori venduti alla Cina. Ma, come abbiamo riportato in precedenza, sebbene questi sforzi abbiano reso più difficile per paesi come la Cina mettere le mani sui gettoni americani, essi sono tutt’altro che perfetti.

Per affrontare queste limitazioni, i ricercatori hanno proposto di implementare un registro globale per le vendite di chip di intelligenza artificiale che li monitorerebbe nel corso del loro ciclo di vita, anche dopo che hanno lasciato il paese di origine. Un registro di questo tipo, suggeriscono, potrebbe incorporare un identificatore univoco in ciascun chip, il che potrebbe aiutare a combattere contrabbando di componenti.

All'estremità più estrema dello spettro, i ricercatori hanno suggerito che i kill switch potrebbero essere integrati nel silicio per impedirne l'uso in applicazioni dannose.

In teoria, ciò potrebbe consentire alle autorità di regolamentazione di rispondere più rapidamente agli abusi di tecnologie sensibili interrompendo l’accesso ai chip da remoto, ma gli autori avvertono che ciò non è privo di rischi. Ciò implica che, se implementato in modo errato, un simile kill switch potrebbe diventare un bersaglio per i criminali informatici.

Un’altra proposta richiederebbe a più parti di approvare attività di formazione sull’intelligenza artificiale potenzialmente rischiose prima che possano essere implementate su larga scala. “Le armi nucleari utilizzano meccanismi simili chiamati collegamenti di azione permissivi”, hanno scritto.

Per le armi nucleari, questi blocchi di sicurezza sono progettati per impedire a una persona di agire in modo ribelle e lanciare un primo attacco. Per l'intelligenza artificiale, tuttavia, l'idea è che se un individuo o un'azienda volesse addestrare un modello oltre una certa soglia nel cloud, dovrebbe prima ottenere l'autorizzazione per farlo.

Sebbene si tratti di uno strumento potente, i ricercatori osservano che ciò potrebbe ritorcersi contro, impedendo lo sviluppo dell’intelligenza artificiale auspicabile. La tesi sembra essere che, mentre l’uso delle armi nucleari ha un risultato abbastanza chiaro, l’intelligenza artificiale non è sempre così in bianco e nero.

Ma se questo sembra un po’ troppo distopico per i vostri gusti, il documento dedica un’intera sezione alla riallocazione delle risorse dell’intelligenza artificiale per il miglioramento della società nel suo complesso. L’idea è che i politici potrebbero unirsi per rendere il calcolo dell’intelligenza artificiale più accessibile a gruppi che difficilmente lo useranno per scopi malvagi, un concetto descritto come “allocazione”.

Cosa c’è di sbagliato nel regolamentare lo sviluppo dell’IA?

Perché prendersi tutto questo disturbo? Ebbene, gli autori dell'articolo presuppongono che l'hardware fisico sia intrinsecamente più facile da controllare.

Rispetto all’hardware, “altri input e output dello sviluppo dell’intelligenza artificiale – dati, algoritmi e modelli addestrati – sono beni immateriali facilmente condivisibili e non rivali, che li rendono intrinsecamente difficili da controllare”, si legge nel documento.

La tesi è che una volta che un modello viene pubblicato, allo scoperto o trapelato, non è possibile rimettere il genio nella bottiglia e fermarne la diffusione in rete.

I ricercatori hanno inoltre sottolineato che gli sforzi volti a prevenire l’uso improprio dei modelli si sono rivelati inaffidabili. In un esempio, gli autori hanno evidenziato la facilità con cui i ricercatori sono stati in grado di smantellare le protezioni in Meta's Llama 2 intese a impedire che il modello generasse un linguaggio offensivo.

Portato alle estreme conseguenze, si teme che un modello a duplice uso sufficientemente avanzato possa essere utilizzato per accelerare il processo sviluppo di armi chimiche o biologiche.

Il documento ammette che la regolamentazione dell’hardware AI non è una soluzione miracolosa e non elimina la necessità di regolamentazione in altri aspetti del settore.

Tuttavia, la partecipazione di diversi ricercatori di OpenAI è difficile da ignorare considerando quella del CEO Sam Altman tentativi per controllare la narrativa sulla regolamentazione dell’IA. ®

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://go.theregister.com/feed/www.theregister.com/2024/02/16/boffins_propose_regulating_ai_hardware/

- :ha

- :È

- :non

- :Dove

- $ SU

- 7

- a

- capace

- abusi

- AC

- accademico

- accelerare

- acceleratori

- accesso

- accessibile

- operanti in

- Action

- indirizzo

- Avanzate

- Dopo shavasana, sedersi in silenzio; saluti;

- AI

- Modelli AI

- Addestramento AI

- Mirato

- Algoritmi

- Tutti

- assegnazione

- consentire

- permesso

- Consentire

- lungo

- già

- anche

- sempre

- AMD

- americano

- an

- ed

- Un altro

- applicazioni

- approccio

- SONO

- discutere

- argomento

- braccia

- in giro

- artificiale

- intelligenza artificiale

- AS

- aspetti

- At

- autorizzazione

- gli autori

- evitare

- precedente

- BE

- diventare

- prima

- essendo

- creduto

- MIGLIORE

- Meglio

- Miglioramento

- Biden

- Nero

- costruire

- ma

- by

- detto

- cambridge

- Materiale

- capace

- Custodie

- ceo

- certo

- catena

- chimico

- Cina

- patata fritta

- Chips

- civile

- Cloud

- CO

- combattere

- Venire

- Commercio

- Aziende

- azienda

- componenti

- Calcolare

- concentrato

- concetto

- Problemi della Pelle

- considerando

- vincoli

- continua

- di controllo

- polemica

- potuto

- paesi

- nazione

- Portata

- cliente

- taglio

- i criminali informatici

- dati

- Shirts Department

- schierato

- descritta

- progettato

- sviluppato

- in via di sviluppo

- Mercato

- difficile

- do

- doesn

- fare

- doppio

- distopico

- ogni

- alleviare

- più facile

- facilmente

- Efficace

- sforzi

- o

- eliminato

- occupato

- fine

- imporre

- Intero

- Anche

- esempio

- superare

- esecuzione

- esistenza

- export

- estremo

- estremamente

- Fattori

- familiare

- lontano

- più veloce

- temuto

- si sente

- Nome

- Nel

- Avanti

- da

- anteriore

- divario

- la generazione di

- Genio

- ottenere

- ottenere

- globali

- Go

- andando

- merce

- GPU

- Gruppo

- Mani

- Hard

- Più forte

- Hardware

- Avere

- Aiuto

- nascondere

- Evidenziato

- evidenzia

- Come

- Tuttavia

- HTTPS

- idea

- identificatore

- identificazione

- if

- ignorare

- immenso

- realizzare

- implementato

- Implementazione

- competenze

- in

- In altre

- inclusi

- Compreso

- incorporare

- in modo non corretto

- individuale

- industria

- Infrastruttura

- intrinsecamente

- Ingressi

- istituzioni

- intangibile

- Intel

- Intelligence

- intervento

- ai miglioramenti

- ISN

- IT

- SUO

- JOE

- Joe Biden

- jpg

- Uccidere

- Genere

- Lingua

- grandi

- lanciare

- lancio

- portare

- Guidato

- a sinistra

- Livello

- ciclo di vita

- piace

- LIMITE

- limiti

- limitativo

- Collegamento

- piccolo

- Lama

- Serrature

- fatto

- make

- FA

- Fare

- maligno

- consigliato per la

- molti

- massiccio

- Maggio..

- si intende

- significava

- meccanismi di

- Meta

- forza

- Militare

- Applicazioni militari

- missili

- uso improprio

- modello

- modelli

- mese

- Scopri di più

- maggior parte

- multiplo

- NARRATIVA

- il

- Bisogno

- rete

- New

- no

- Nota

- nucleare

- numero

- numerose

- Nvidia

- osservare

- of

- MENO

- offensivo

- offrire

- on

- una volta

- ONE

- aprire

- OpenAI

- or

- origine

- Altro

- Altri

- nostro

- su

- Risultato

- uscite

- ancora

- Carta

- parametri

- partecipazione

- particolarmente

- parti

- sanzioni

- perfetta

- performance

- persona

- persone

- Fisico

- Platone

- Platone Data Intelligence

- PlatoneDati

- gioco

- punto

- Termini e Condizioni

- politici

- potente

- potenziale

- potenzialmente

- potenze

- Presidente

- presidente joe biden

- piuttosto

- prevenire

- prevenzione

- in precedenza

- Privacy

- lavorazione

- Prodotto

- prolifico

- proposta

- proposto

- comprovata

- fornitori

- pubblicato

- metti

- Mettendo

- quantificabile

- ricerca

- Gara

- RE

- recentemente

- si riferisce

- registro

- Regolare

- regolazione

- Regolamento

- Regolatori

- parente

- relativamente

- fare affidamento

- a distanza

- da remoto

- Segnalati

- Reportistica

- Report

- richiedere

- Requisiti

- richiede

- ricercatori

- Risorse

- Rispondere

- limitare

- restrizioni

- Rischio

- rischi

- Rischioso

- s

- garanzie

- vendita

- vendite

- Sam

- Sam Altman

- dire

- Scala

- Sezione

- problemi di

- sembra

- semiconduttore

- delicata

- servire

- alcuni

- segno

- Silicio

- Argento

- simile

- piccole

- So

- Società

- venduto

- Spettro

- diffondere

- inizia a

- Fermare

- sosta

- sciopero

- rigoroso

- tale

- suggerire

- fornire

- supply chain

- Interruttore

- Target

- task

- sapori

- Tecnologie

- decine

- che

- Il

- loro

- Li

- teoria

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- quelli

- migliaia

- soglia

- tempo

- a

- insieme

- pure

- pista

- commercio

- Treni

- allenato

- Training

- innescato

- Trilione

- guaio

- non autorizzato

- capire

- unico

- Università

- Università di Cambridge

- improbabile

- us

- Presidente degli Stati Uniti

- uso

- utilizzato

- Prezioso

- Ve

- fornitori

- via

- visibilità

- VOCI

- ricercato

- Modo..

- modi

- we

- Armi

- Settimane

- WELL

- sono stati

- quale

- while

- bianca

- OMS

- tutto

- con

- senza

- sarebbe

- Wrong

- ha scritto

- anno

- Tu

- Trasferimento da aeroporto a Sharm

- zefiro