Amazon Sage Maker Gestione dati è uno strumento di preparazione dei dati basato sull'interfaccia utente che aiuta a eseguire l'analisi, la preelaborazione e la visualizzazione dei dati con funzionalità per pulire, trasformare e preparare i dati più rapidamente. I modelli di flusso predefiniti di Data Wrangler aiutano a velocizzare la preparazione dei dati per data scientist e professionisti del machine learning (ML), aiutandoti ad accelerare e comprendere i modelli di best practice per i flussi di dati utilizzando set di dati comuni.

È possibile utilizzare i flussi di Data Wrangler per eseguire le seguenti attività:

- Visualizzazione dati – Esame delle proprietà statistiche per ciascuna colonna del set di dati, costruzione di istogrammi, studio dei valori anomali

- Pulizia dei dati – Rimozione di duplicati, eliminazione o riempimento di voci con valori mancanti, rimozione di valori anomali

- Arricchimento dei dati e ingegneria delle funzionalità – Elaborazione di colonne per creare funzionalità più espressive, selezionando un sottoinsieme di funzionalità per l'addestramento

Questo post ti aiuterà a comprendere Data Wrangler utilizzando i seguenti flussi predefiniti di esempio GitHub. Il repository presenta la trasformazione dei dati tabulari, le trasformazioni dei dati delle serie temporali e le trasformazioni dei set di dati uniti. Ciascuno richiede un diverso tipo di trasformazioni a causa della loro natura di base. I dati tabellari o trasversali standard vengono raccolti in un momento specifico. Al contrario, i dati delle serie temporali vengono acquisiti ripetutamente nel tempo, con ciascun punto dati successivo che dipende dai suoi valori passati.

Diamo un'occhiata a un esempio di come possiamo utilizzare il flusso di dati di esempio per dati tabulari.

Prerequisiti

Data Wrangler è un file Amazon Sage Maker funzionalità disponibile all'interno Amazon Sage Maker Studio, quindi dobbiamo seguire il processo di onboarding di Studio per avviare l'ambiente e i notebook di Studio. Sebbene sia possibile scegliere tra alcuni metodi di autenticazione, il modo più semplice per creare un dominio Studio è seguire il Avvio rapido Istruzioni. L'Avvio rapido utilizza le stesse impostazioni predefinite di configurazione standard dello Studio. Puoi anche scegliere di eseguire l'onboarding utilizzando Centro di identità AWS IAM (successore di AWS Single Sign-On) per l'autenticazione (vedi Integrazione nel dominio Amazon SageMaker utilizzando IAM Identity Center).

Importa il set di dati e i file di flusso in Data Wrangler utilizzando Studio

I seguenti passaggi descrivono come importare i dati in SageMaker per essere utilizzati da Data Wrangler:

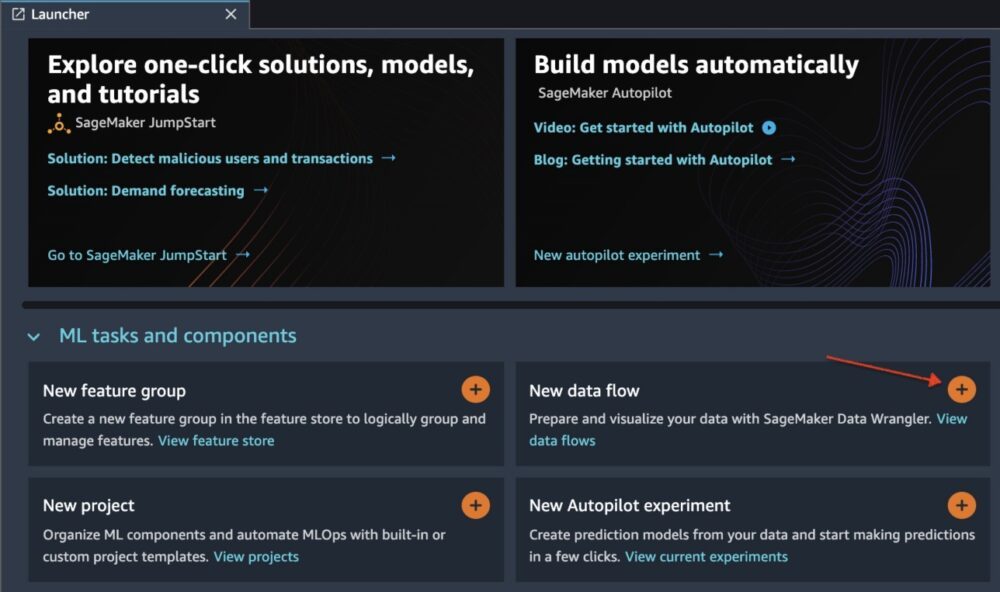

Inizializza Data Wrangler tramite l'interfaccia utente di Studio scegliendo Nuovo flusso di dati.

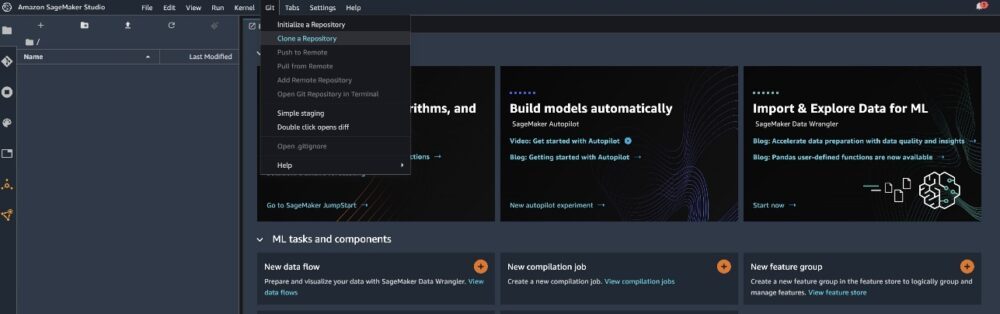

Clona il file Repository GitHub per scaricare i file di flusso nel tuo ambiente Studio.

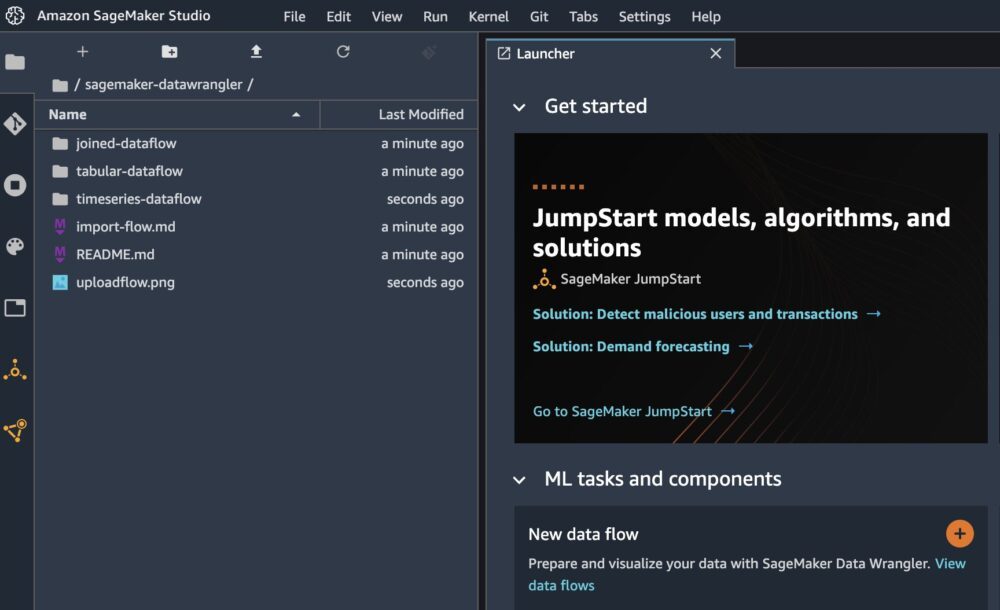

Una volta completato il clone, dovresti essere in grado di vedere il contenuto del repository nel riquadro di sinistra.

Scegli il file Hotel-Prenotazioni-Classificazione.flusso per importare il file di flusso in Data Wrangler.

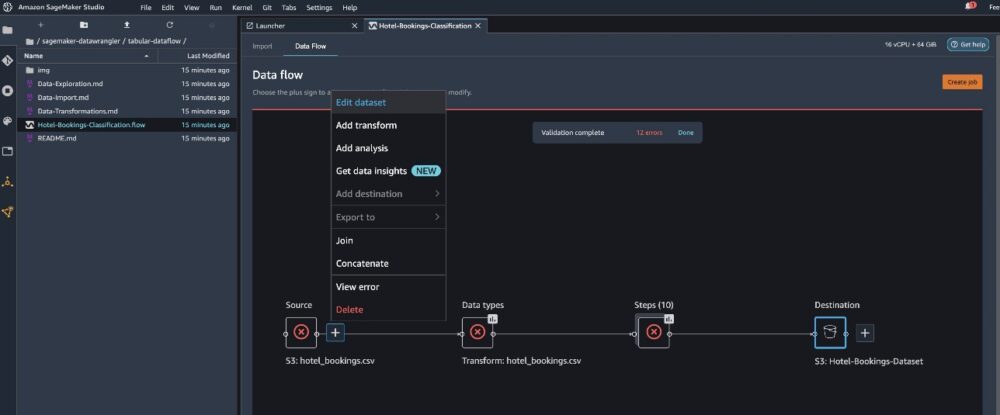

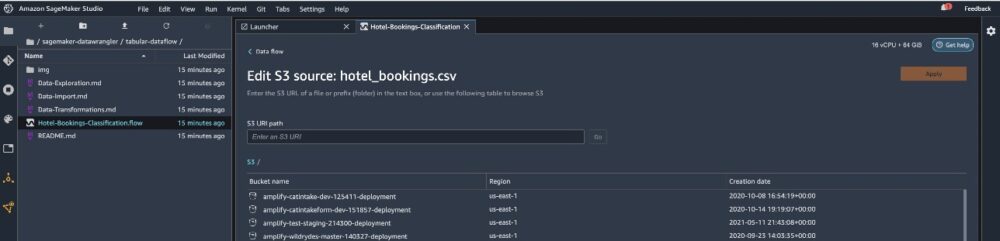

Se utilizzi la serie temporale o il flusso di dati unito, il flusso verrà visualizzato con un nome diverso. Dopo che il flusso è stato importato, dovresti vedere lo screenshot seguente. Questo ci mostra errori perché dobbiamo assicurarci che il file di flusso punti all'origine dati corretta in Servizio di archiviazione semplice Amazon (Amazon S3).

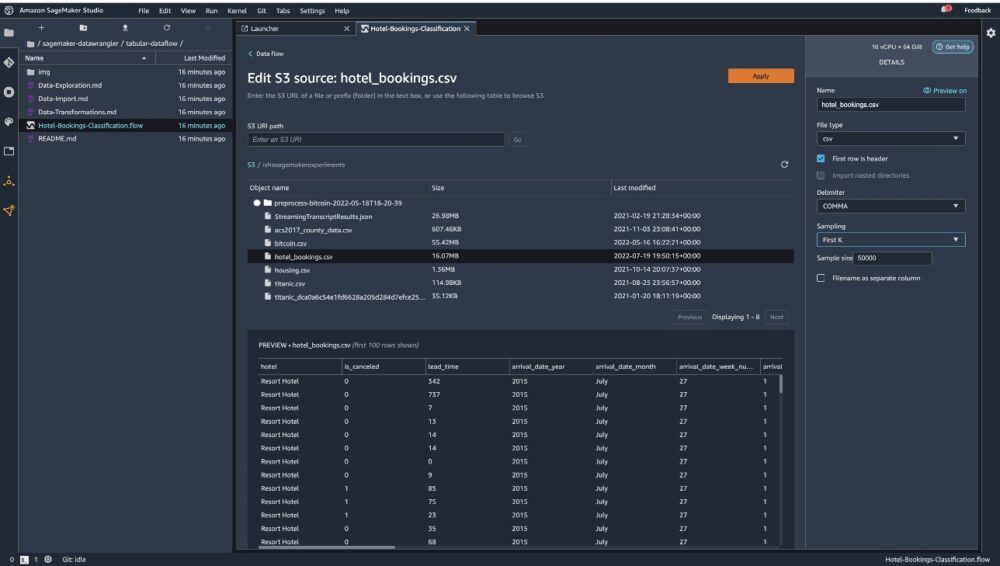

Scegli Modifica set di dati per visualizzare tutti i tuoi bucket S3. Quindi, scegli il set di dati hotel_bookings.csv dal tuo bucket S3 per correre attraverso il flusso di dati tabellari.

Tieni presente che se stai utilizzando il file flusso di dati unito, potrebbe essere necessario importare più set di dati in Data Wrangler

Nel riquadro di destra, assicurati VIRGOLA viene scelto come delimitatore e Campionamento è impostato su Primo K. Il nostro set di dati è abbastanza piccolo da poter eseguire le trasformazioni di Data Wrangler sull'intero set di dati, ma volevamo evidenziare come è possibile importare il set di dati. Se disponi di un set di dati di grandi dimensioni, valuta la possibilità di utilizzare il campionamento. Scegliere Importare per importare questo set di dati in Data Wrangler.

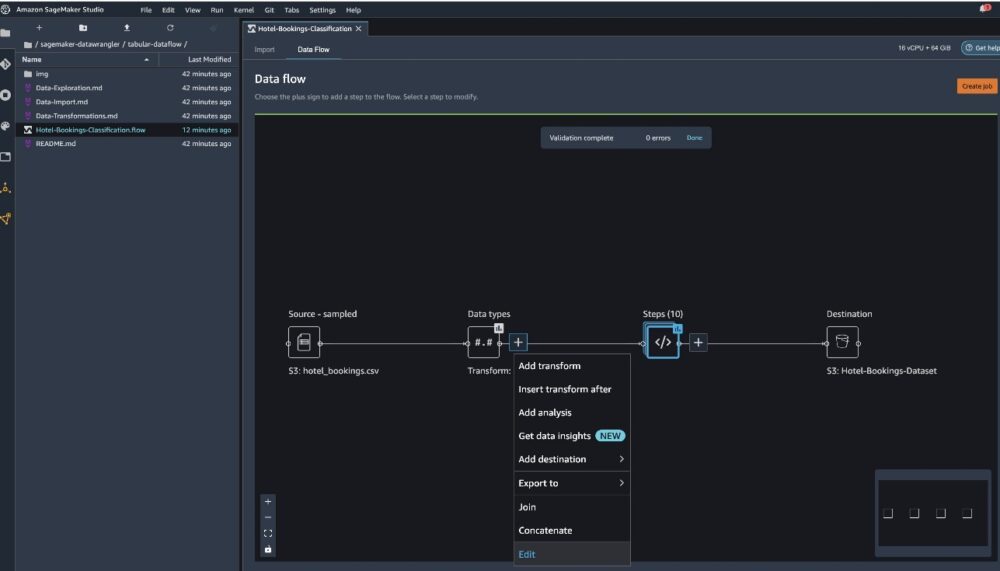

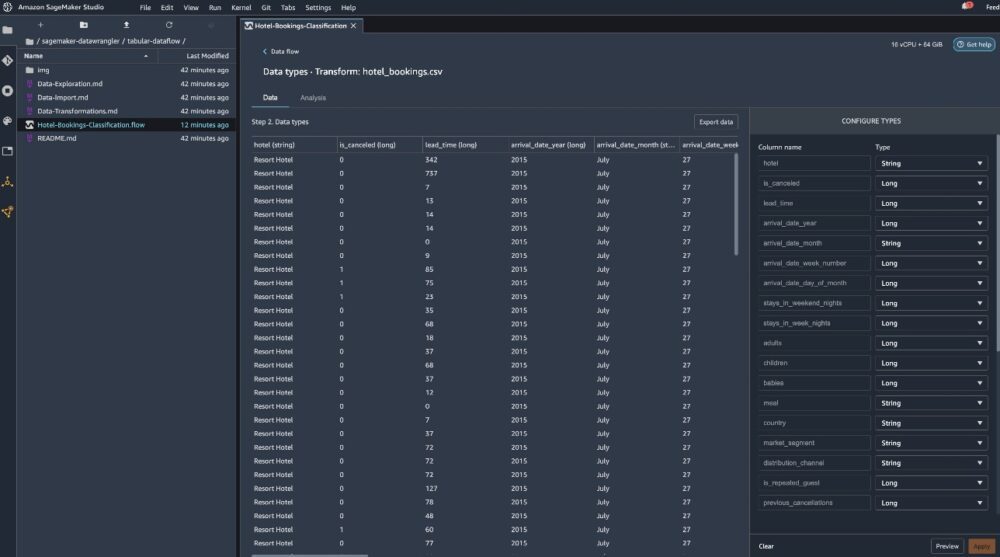

Dopo l'importazione del set di dati, Data Wrangler convalida automaticamente il set di dati e rileva i tipi di dati. Puoi vedere che gli errori sono scomparsi perché stiamo indicando il set di dati corretto. L'editor del flusso ora mostra due blocchi che mostrano che i dati sono stati importati da un'origine e i tipi di dati riconosciuti. Se necessario, puoi anche modificare i tipi di dati.

Lo screenshot seguente mostra i nostri tipi di dati.

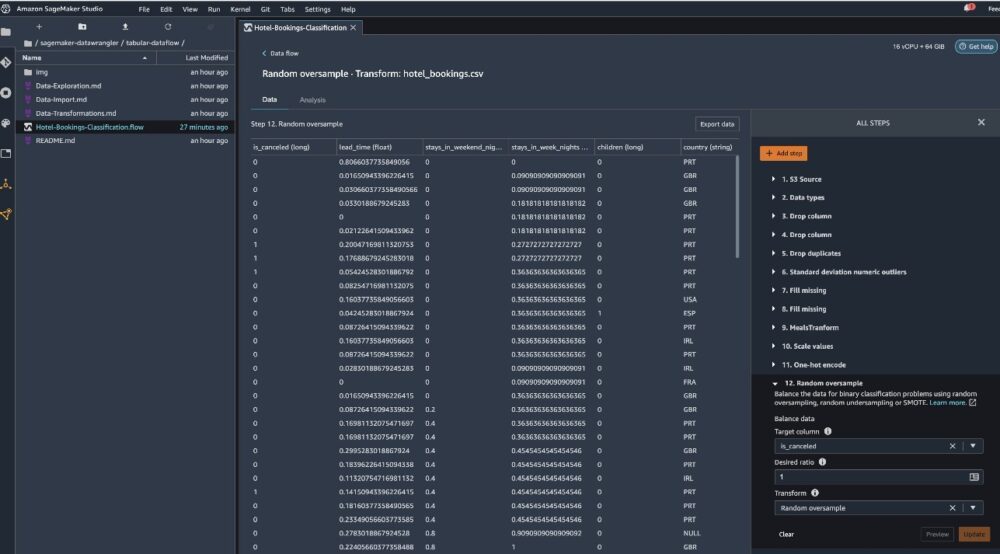

Diamo un'occhiata ad alcune delle trasformazioni eseguite come parte di questo flusso tabellare. Se stai utilizzando il serie temporali or congiunto flussi di dati, controlla alcune trasformazioni comuni su Repository GitHub. Abbiamo eseguito alcune analisi esplorative di base dei dati utilizzando report di approfondimento dei dati che hanno studiato la perdita del target e la collinearità delle caratteristiche nel set di dati, analisi di riepilogo delle tabelle e capacità di modellazione rapida. Esplora i passaggi su Repository GitHub.

Ora eliminiamo le colonne in base ai consigli forniti da Data Insights e Quality Report.

- Per perdite target, lasciar cadere stato_prenotazione.

- Per le colonne ridondanti, rilasciare giorni_in_lista_d'attesa, hotel, tipo_camera_riservata, data_arrivo_mese, data_status_prenotazione, bambini, ed data_arrivo_giorno_del_mese.

- In base ai risultati della correlazione lineare, eliminare le colonne data_arrivo_numero_settimana ed data_arrivo_anno perché i valori di correlazione per queste coppie di caratteristiche (colonne) sono maggiori della soglia consigliata di 0.90.

- Sulla base dei risultati della correlazione non lineare, diminuire stato_prenotazione. Questa colonna era già contrassegnata per essere eliminata in base all'analisi delle perdite target.

- Elabora valori numerici (scala min-max) per lead_time, soggiorni_nelle_notti_del_fine settimana, soggiorni_nelle_notti_dei_giorni_feriali, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, ed spazi_parcheggio_auto_richiesti.

- Variabili categoriali di codifica one-hot come pasto, ospite_ripetuto, segmento_di_mercato, tipo_stanza_assegnata, tipo_deposito, ed tipo di cliente.

- Bilancia la variabile target Sovracampionamento casuale per lo squilibrio delle classi. Utilizza la funzionalità di modellazione rapida per gestire valori anomali e mancanti.

Esporta su Amazon S3

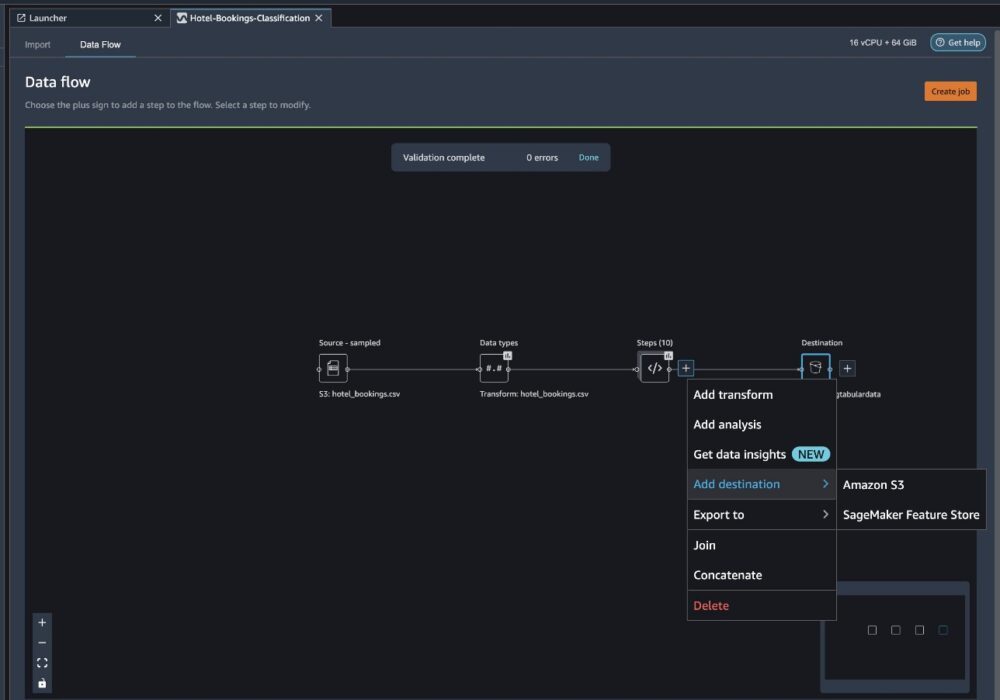

Ora abbiamo attraversato le diverse trasformazioni e siamo pronti per esportare i dati su Amazon S3. Questa opzione crea un processo di elaborazione SageMaker, che esegue il flusso di elaborazione di Data Wrangler e salva il set di dati risultante in un bucket S3 specificato. Segui i passaggi successivi per configurare l'esportazione su Amazon S3:

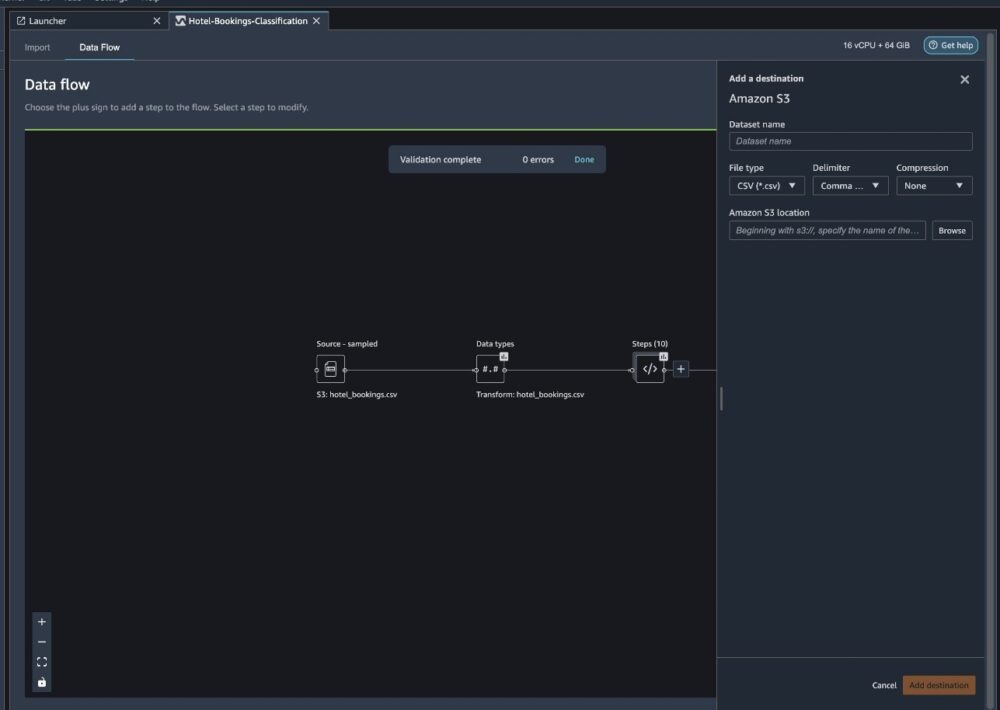

Scegli il segno più accanto a una raccolta di elementi di trasformazione e scegli Aggiungi destinazione, poi Amazon S3.

- Nel Nome del set di dati, inserire ad esempio un nome per il nuovo set di dati

NYC_export. - Nel Tipo di filescegli CSV.

- Nel delimitatorescegli Virgola.

- Nel Compressionescegli Nessuna.

- Nel Posizione Amazon S3, utilizza lo stesso nome del bucket creato in precedenza.

- Scegli Aggiungi destinazione.

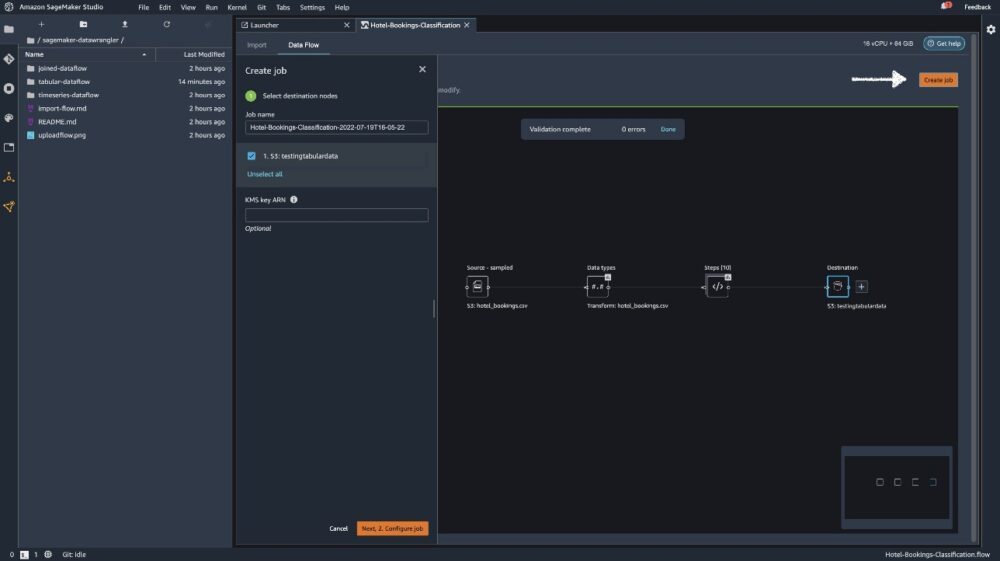

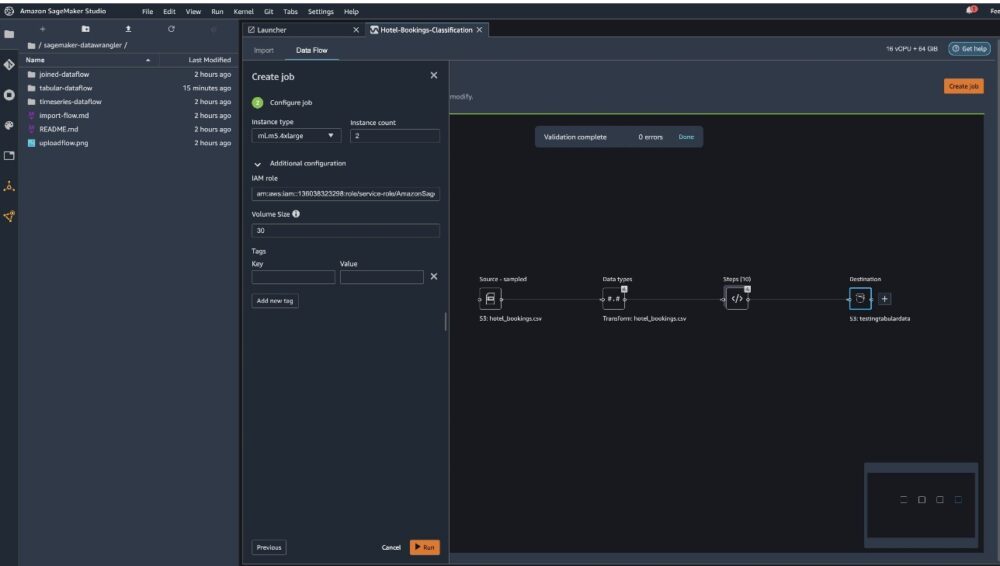

Scegli Crea lavoro.

Nel Nome del lavoro, inserisci un nome o mantieni l'opzione generata automaticamente e scegli destinazione. Abbiamo una sola destinazione, S3:testingtabulardata, ma potresti avere più destinazioni da diverse fasi del tuo flusso di lavoro. Lasciare il ARN della chiave KMS campo vuoto e scegli Avanti.

Ora devi configurare la capacità di calcolo per un lavoro. Puoi mantenere tutti i valori predefiniti per questo esempio.

- Nel Tipo di istanza, utilizzare ml.m5.4xlarge.

- Nel Conteggio istanze, usa 2.

- Puoi esplorare Configurazione aggiuntiva, ma mantieni le impostazioni predefinite.

- Scegli Correre.

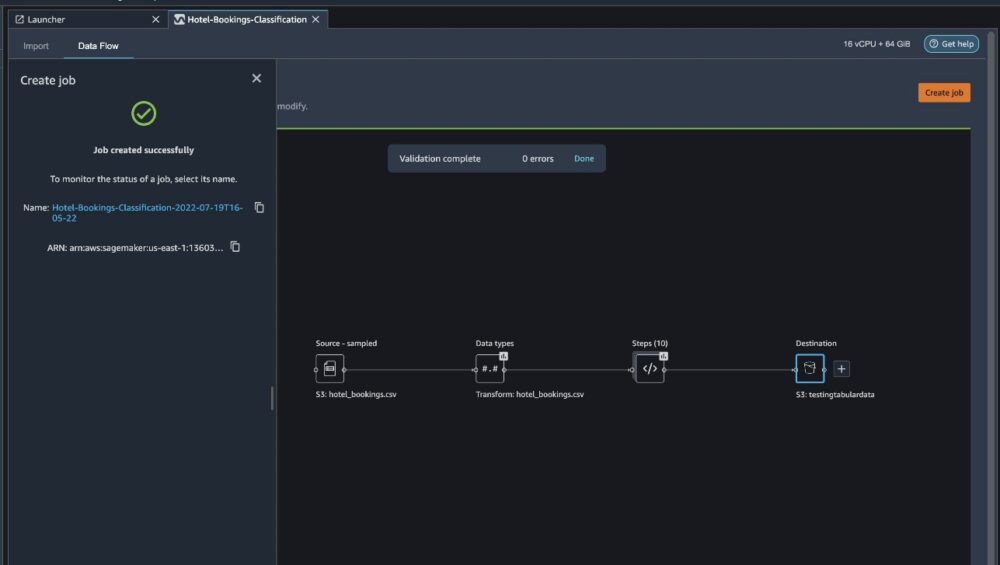

Ora il tuo lavoro è iniziato e ci vuole del tempo per elaborare 6 GB di dati secondo il nostro flusso di elaborazione Data Wrangler. Il costo per questo lavoro sarà di circa $ 2 USD, perché ml.m5.4xlarge costa $ 0.922 USD l'ora e ne stiamo utilizzando due.

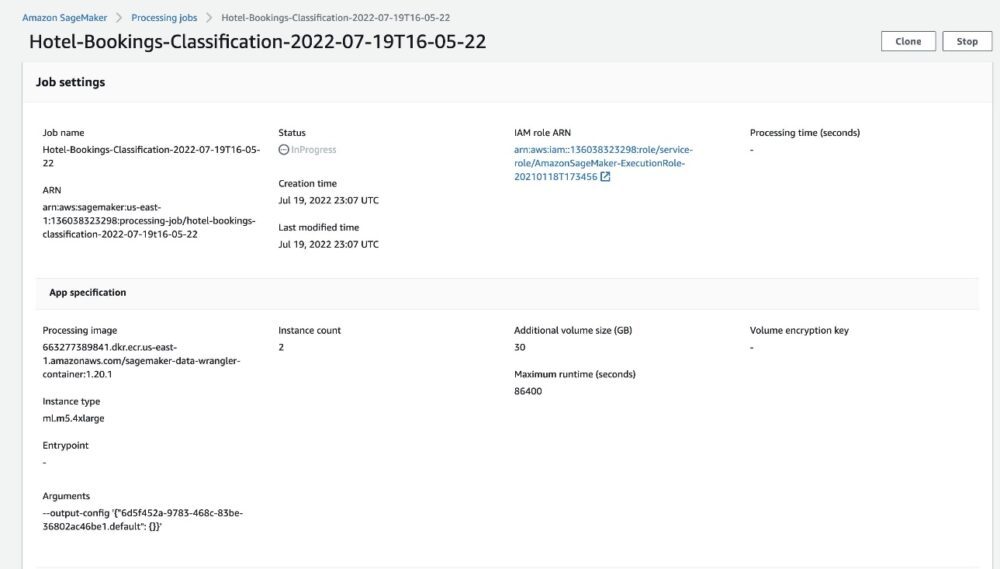

Se scegli il nome del lavoro, verrai reindirizzato a una nuova finestra con i dettagli del lavoro.

Nella pagina dei dettagli del lavoro, puoi vedere tutti i parametri dei passaggi precedenti.

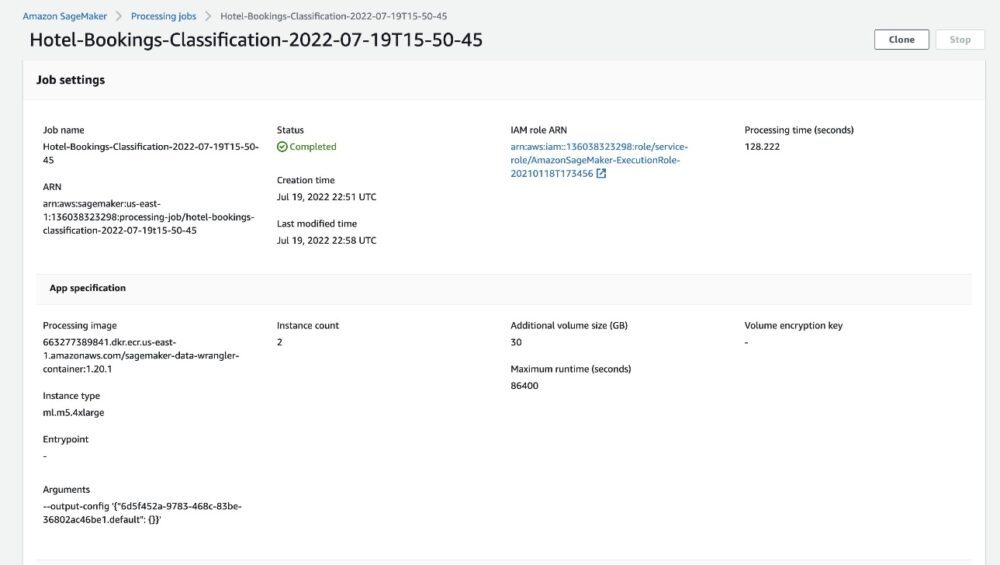

Quando lo stato del lavoro cambia in Completato, puoi anche controllare il Tempo di elaborazione (secondi) valore. Il completamento di questo processo di elaborazione richiede circa 5-10 minuti.

Una volta completato il lavoro, i file di output del training e del test sono disponibili nelle cartelle di output S3 corrispondenti. È possibile trovare la posizione di output dalle configurazioni del lavoro di elaborazione.

Una volta completato il lavoro di elaborazione di Data Wrangler, possiamo controllare i risultati salvati nel nostro bucket S3. Non dimenticare di aggiornare il job_name variabile con il nome del lavoro.

Ora puoi utilizzare questi dati esportati per eseguire modelli ML.

ripulire

Elimina i tuoi bucket S3 e il tuo Flusso di Data Wrangler per eliminare le risorse sottostanti ed evitare costi indesiderati al termine dell'esperimento.

Conclusione

In questo post, abbiamo mostrato come importare il flusso di dati tabulari precostruito in Data Wrangler, collegarlo al nostro set di dati ed esportare i risultati su Amazon S3. Se i tuoi casi d'uso richiedono la manipolazione di dati di serie temporali o l'unione di più set di dati, puoi seguire gli altri flussi di esempio predefiniti nella sezione Repository GitHub.

Dopo aver importato un flusso di lavoro di preparazione dei dati predefinito, puoi integrarlo con Amazon SageMaker Processing, Pipeline di Amazon SageMakere Negozio di funzionalità Amazon SageMaker per semplificare l'attività di elaborazione, condivisione e archiviazione dei dati di addestramento ML. Puoi anche esportare questo flusso di dati di esempio in uno script Python e creare una pipeline di preparazione dei dati ML personalizzata, accelerando così la velocità di rilascio.

Ti invitiamo a dare un'occhiata al nostro Repository GitHub per fare pratica pratica e trovare nuovi modi per migliorare la precisione del modello! Per saperne di più su SageMaker, visitare il Guida per sviluppatori Amazon SageMaker.

Informazioni sugli autori

Isha Dua è un Senior Solutions Architect con sede nella San Francisco Bay Area. Aiuta i clienti di AWS Enterprise a crescere comprendendo i loro obiettivi e le loro sfide e li guida su come progettare le loro applicazioni in modo cloud-native, assicurandosi che siano resilienti e scalabili. È appassionata di tecnologie di apprendimento automatico e sostenibilità ambientale.

Isha Dua è un Senior Solutions Architect con sede nella San Francisco Bay Area. Aiuta i clienti di AWS Enterprise a crescere comprendendo i loro obiettivi e le loro sfide e li guida su come progettare le loro applicazioni in modo cloud-native, assicurandosi che siano resilienti e scalabili. È appassionata di tecnologie di apprendimento automatico e sostenibilità ambientale.

- AI

- oh arte

- generatore d'arte

- un robot

- Amazon Sage Maker

- Gestore di dati di Amazon SageMaker

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- Apprendimento automatico di AWS

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- zefiro