Roccia Amazzonica fornisce un'ampia gamma di modelli di Amazon e fornitori di terze parti, tra cui Anthropic, AI21, Meta, Cohere e Stability AI, e copre un'ampia gamma di casi d'uso, tra cui generazione di testo e immagini, incorporamento, chat, agenti di alto livello con ragionamento e orchestrazione e altro ancora. Basi di conoscenza per Amazon Bedrock ti consente di creare applicazioni RAG (Retrieval Augmented Generation) performanti e personalizzate su archivi di vettori AWS e di terze parti utilizzando sia modelli AWS che di terze parti. Knowledge Base per Amazon Bedrock automatizza la sincronizzazione dei tuoi dati con il tuo archivio vettoriale, inclusa la differenziazione dei dati quando vengono aggiornati, il caricamento dei documenti e la suddivisione in blocchi, nonché l'incorporamento semantico. Ti consente di personalizzare perfettamente i tuoi prompt RAG e le strategie di recupero: forniamo l'attribuzione della fonte e gestiamo automaticamente la gestione della memoria. Knowledge Base è completamente serverless, quindi non è necessario gestire alcuna infrastruttura e, quando utilizzi Knowledge Base, ti vengono addebitati solo i modelli, i database vettoriali e lo spazio di archiviazione che utilizzi.

RAG è una tecnica popolare che combina l'uso di dati privati con modelli linguistici di grandi dimensioni (LLM). RAG inizia con un passaggio iniziale per recuperare i documenti rilevanti da un archivio dati (più comunemente un indice vettoriale) in base alla query dell'utente. Utilizza quindi un modello linguistico per generare una risposta considerando sia i documenti recuperati che la query originale.

In questo post, mostriamo come creare un flusso di lavoro RAG utilizzando Knowledge Base per Amazon Bedrock per un caso d'uso di scoperta di farmaci.

Panoramica delle basi di conoscenza per Amazon Bedrock

Le basi di conoscenza per Amazon Bedrock supportano un'ampia gamma di tipi di file comuni, tra cui .txt, .docx, .pdf, .csv e altri. Per consentire un recupero efficace dai dati privati, una pratica comune consiste nel suddividere innanzitutto questi documenti in blocchi gestibili. Knowledge Base ha implementato una strategia di suddivisione in blocchi predefinita che funziona bene nella maggior parte dei casi per consentirti di iniziare più rapidamente. Se desideri un maggiore controllo, Knowledge Base ti consente di controllare la strategia di suddivisione in blocchi attraverso una serie di opzioni preconfigurate. Puoi controllare la dimensione massima del token e la quantità di sovrapposizione da creare tra i blocchi per fornire un contesto coerente all'incorporamento. Knowledge Base per Amazon Bedrock gestisce il processo di sincronizzazione dei dati dal tuo Servizio di archiviazione semplice Amazon (Amazon S3), lo divide in parti più piccole, genera incorporamenti vettoriali e memorizza gli incorporamenti in un indice vettoriale. Questo processo prevede la gestione intelligente delle differenze, della produttività e degli errori.

In fase di esecuzione, viene utilizzato un modello di incorporamento per convertire la query dell'utente in un vettore. Viene quindi eseguita una query sull'indice del vettore per trovare documenti simili alla query dell'utente confrontando i vettori del documento con il vettore della query dell'utente. Nella fase finale, i documenti semanticamente simili recuperati dall'indice del vettore vengono aggiunti come contesto per la query dell'utente originale. Quando si genera una risposta per l'utente, i documenti semanticamente simili vengono richiesti nel modello di testo, insieme all'attribuzione della fonte per la tracciabilità.

Le basi di conoscenza per Amazon Bedrock supportano più database vettoriali, inclusi Amazon OpenSearch senza server, Amazon Aurora, Pigna e Redis Enterprise Cloud. Le API Retrieve e RetrieveAndGenerate consentono alle tue applicazioni di eseguire query direttamente sull'indice utilizzando una sintassi unificata e standard senza dover apprendere API separate per ogni diverso database vettoriale, riducendo la necessità di scrivere query di indice personalizzate sul tuo archivio vettoriale. L'API Retrieve accetta la query in entrata, la converte in un vettore di incorporamento ed interroga l'archivio backend utilizzando gli algoritmi configurati a livello di database vettoriale; l'API RetrieveAndGenerate utilizza un LLM configurato dall'utente fornito da Amazon Bedrock e genera la risposta finale in linguaggio naturale. Il supporto nativo alla tracciabilità informa l'applicazione richiedente sulle fonti utilizzate per rispondere ad una domanda. Per le implementazioni aziendali, supporta le basi di conoscenza Servizio di gestione delle chiavi AWS (AWS KMS), crittografia AWS CloudTrail integrazione e altro ancora.

Nelle sezioni seguenti, dimostriamo come creare un flusso di lavoro RAG utilizzando le basi di conoscenza per Amazon Bedrock, supportate dal motore vettoriale OpenSearch Serverless, per analizzare un set di dati di sperimentazione clinica non strutturata per un caso d'uso di scoperta di farmaci. Questi dati sono ricchi di informazioni ma possono essere molto eterogenei. La corretta gestione della terminologia e dei concetti specializzati in diversi formati è essenziale per individuare informazioni approfondite e garantire l’integrità analitica. Con le Knowledge Base per Amazon Bedrock, puoi accedere a informazioni dettagliate tramite query semplici e naturali.

Crea una base di conoscenza per Amazon Bedrock

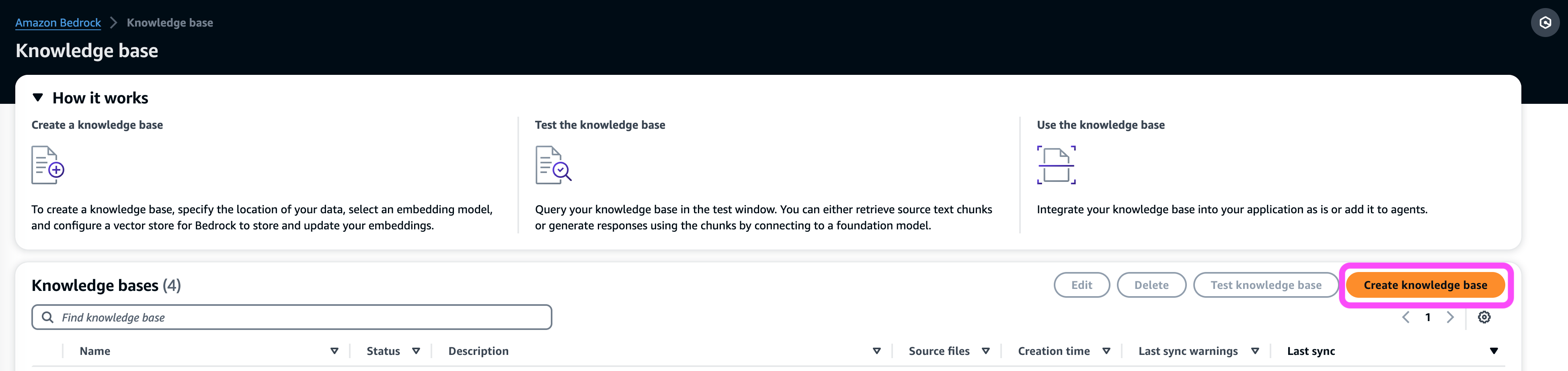

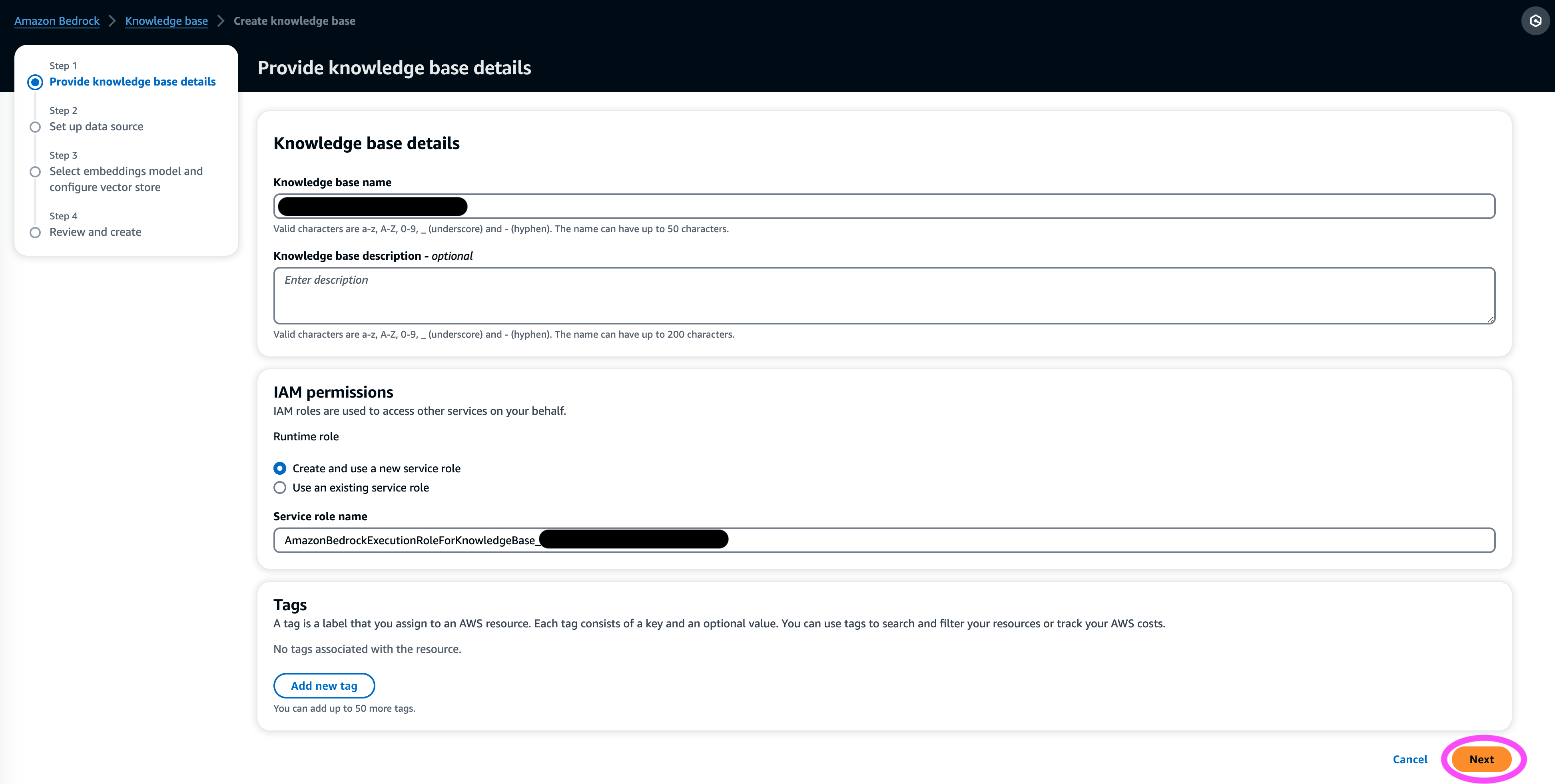

In questa sezione viene presentata una dimostrazione del processo di creazione di una knowledge base per Amazon Bedrock tramite la console. Completa i seguenti passaggi:

- Sulla console Amazon Bedrock, sotto Orchestrazione nel pannello di navigazione, scegli Knowledge Base.

- Scegli Crea una base di conoscenza.

- Nel Dettagli della base di conoscenza sezione, immettere un nome e una descrizione facoltativa.

- Nel Autorizzazioni IAM sezione, selezionare Crea e utilizza un nuovo ruolo del servizio.

- Nel Ruolo del nome del servizio, inserisci un nome per il tuo ruolo, che deve iniziare con

AmazonBedrockExecutionRoleForKnowledgeBase_. - Scegli Avanti.

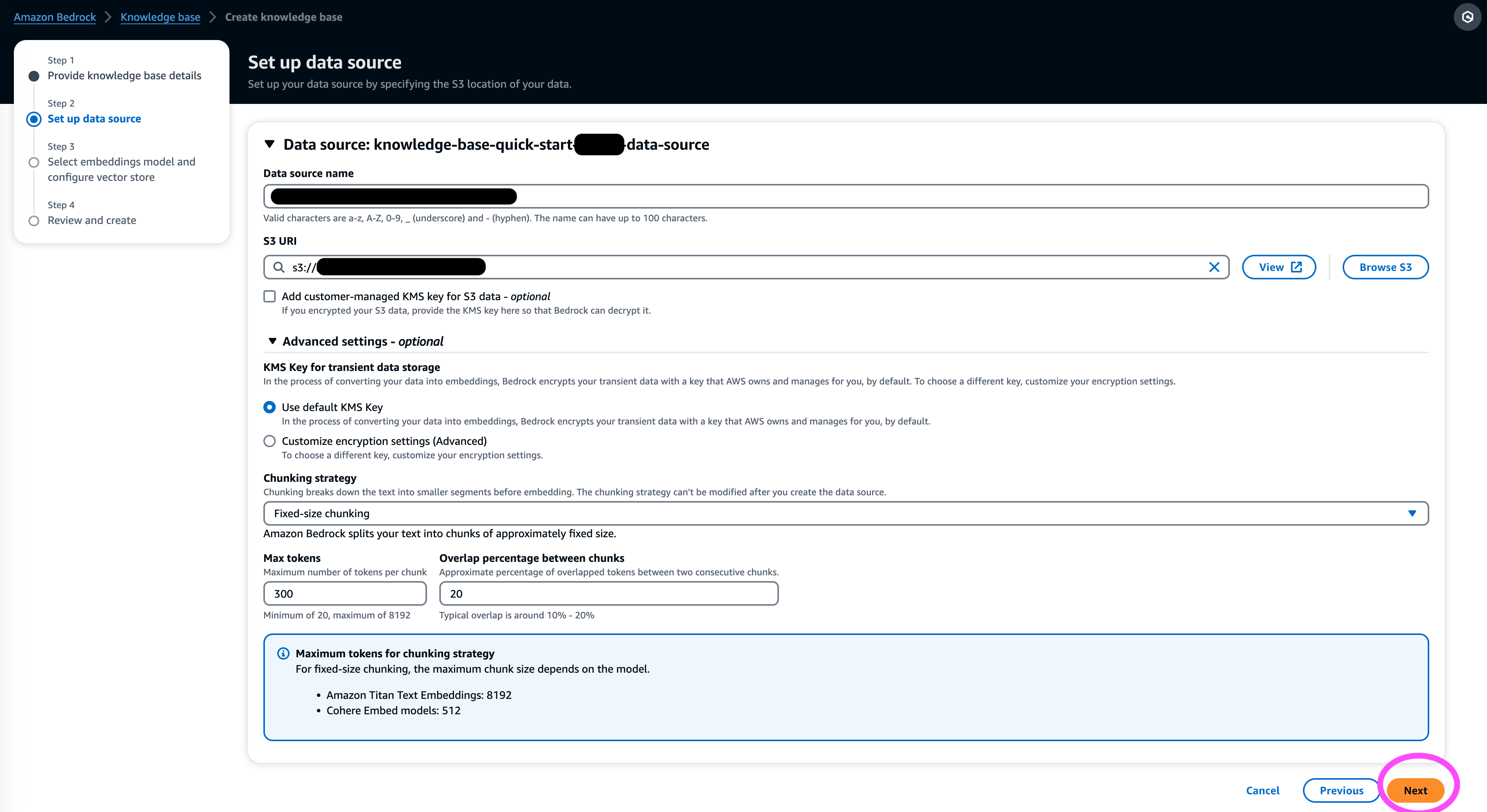

- Nel Fonte di dati sezione, inserisci un nome per l'origine dati e l'URI S3 in cui si trova il set di dati. Le basi di conoscenza supportano i seguenti formati di file:

- Testo normale (.txt)

- Ribasso (.md)

- Linguaggio di markup ipertestuale (.html)

- Documento Microsoft Word (.doc/.docx)

- Valori separati da virgole (.csv)

- Foglio di calcolo Microsoft Excel (.xls/.xlsx)

- Formato documento portatile (.pdf)

- Sotto impostazioni aggiuntive¸ scegli la tua strategia di suddivisione preferita (per questo post, scegliamo Chunking a dimensione fissa) e specificare la dimensione del blocco e la sovrapposizione in percentuale. In alternativa è possibile utilizzare le impostazioni predefinite.

- Scegli Avanti.

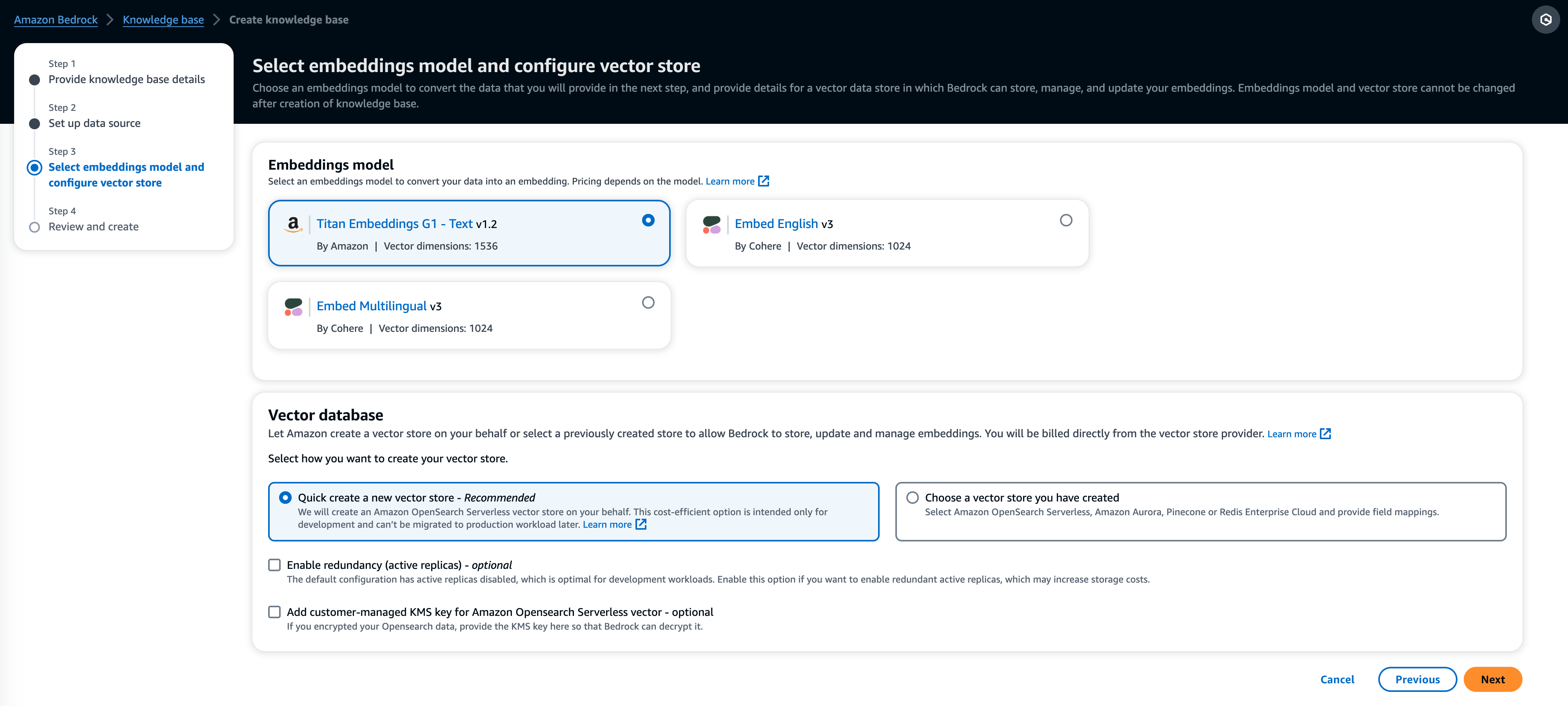

- Nel Modello degli incastri sezione, scegli il modello Titan Embeddings di Amazon Bedrock.

- Nel Banca dati vettoriale sezione, selezionare Crea rapidamente un nuovo archivio vettoriale, che gestisce il processo di creazione di un archivio vettoriale.

- Scegli Avanti.

- Rivedi le impostazioni e scegli Crea una base di conoscenza.

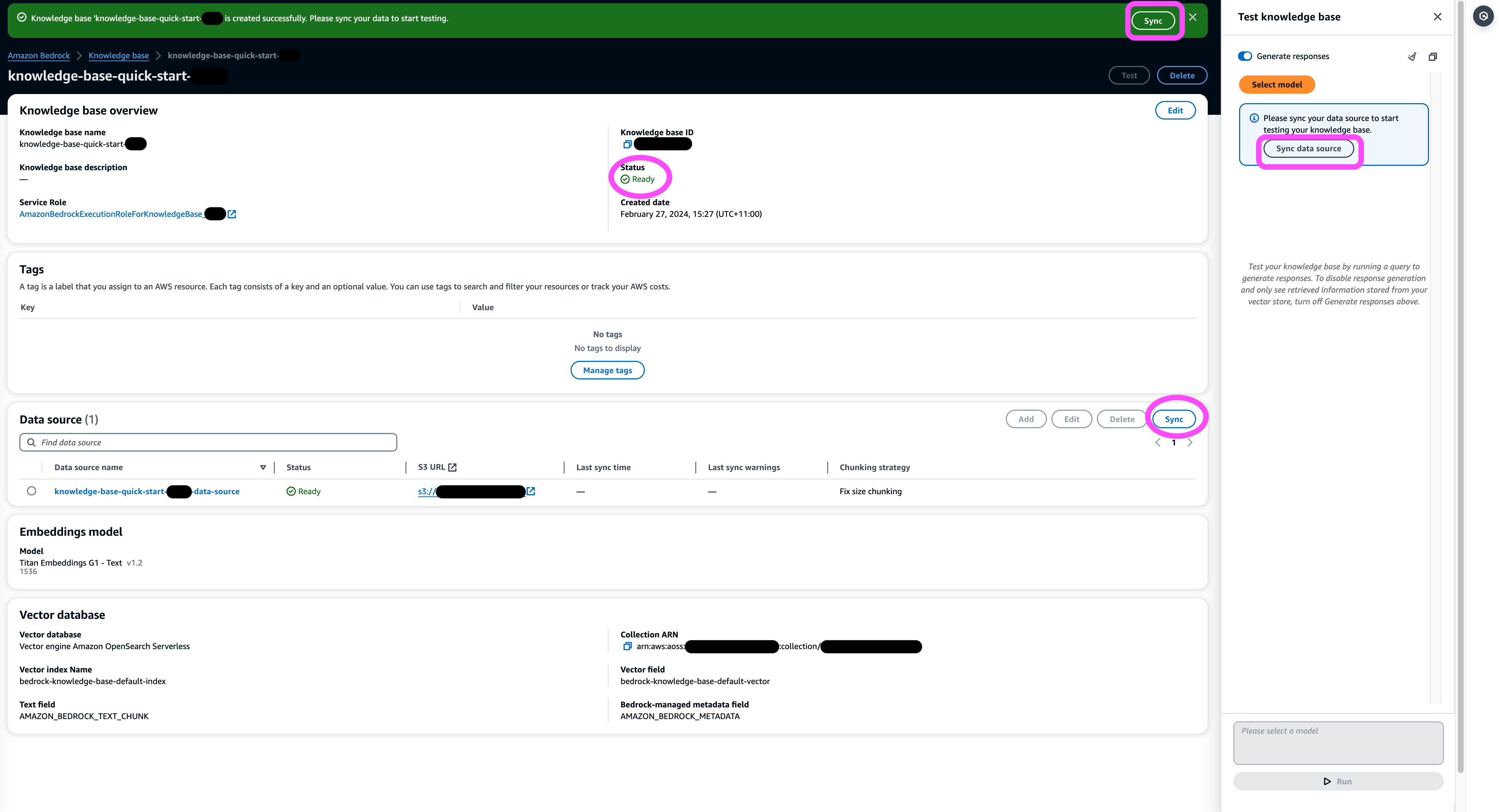

- Attendi il completamento della creazione della knowledge base e conferma che il suo stato è Pronto.

- Nel Fonte di dati oppure sul banner nella parte superiore della pagina o nel popup nella finestra di test, scegli Sincronizza per attivare il processo di caricamento dei dati dal bucket S3, suddividendoli in blocchi della dimensione specificata, generando incorporamenti di vettori utilizzando il modello di incorporamento del testo selezionato e archiviandoli nell'archivio di vettori gestito da Knowledge Base per Amazon Bedrock.

La funzione di sincronizzazione supporta l'acquisizione, l'aggiornamento e l'eliminazione dei documenti dall'indice vettoriale in base alle modifiche ai documenti in Amazon S3. Puoi anche usare il StartIngestionJob API per attivare la sincronizzazione tramite l'SDK AWS.

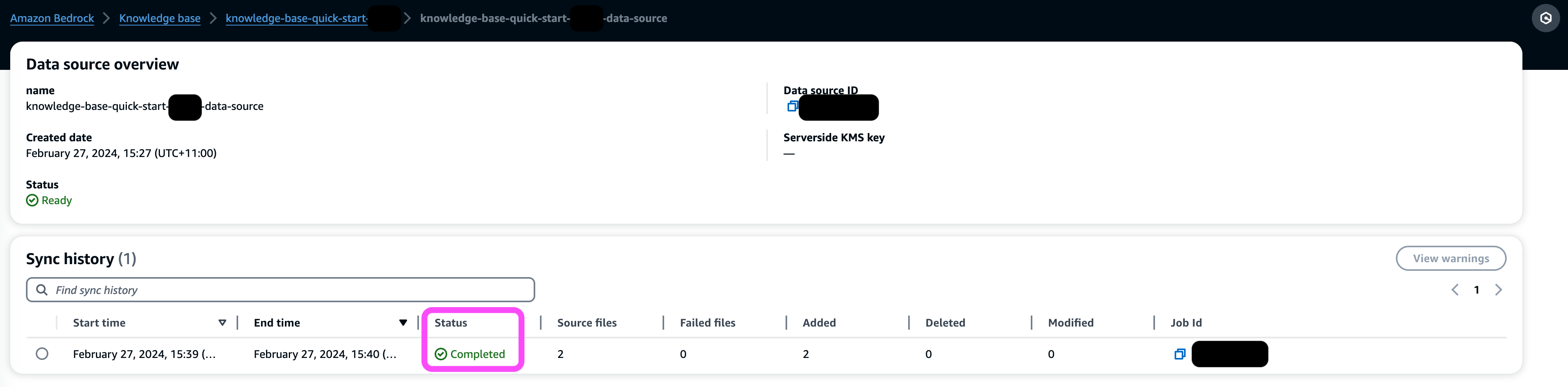

Una volta completata la sincronizzazione, la cronologia della sincronizzazione mostra lo stato Completato.

Interroga la base di conoscenza

In questa sezione, dimostriamo come accedere a informazioni dettagliate nella knowledge base tramite query semplici e naturali. Utilizziamo un set di dati sintetici non strutturati costituito da file PDF, il numero di pagina di ciascuno compreso tra 10 e 100 pagine, simulando un piano di sperimentazione clinica di un nuovo medicinale proposto, inclusi metodi di analisi statistica e moduli di consenso dei partecipanti. Utilizziamo le Knowledge Base per Amazon Bedrock retrieve_and_generate ed retrieve API con Integrazione di Amazon Bedrock LangChain.

Prima di poter scrivere script che utilizzano l'API Amazon Bedrock, dovrai installare la versione appropriata dell'SDK AWS nel tuo ambiente. Per gli script Python, questo sarà il file SDK AWS per Python (Boto3):

Inoltre, abilita l'accesso al modello Amazon Titan Embeddings e Anthropic Claude v2 o v1. Per ulteriori informazioni, fare riferimento a Accesso al modello.

Genera domande utilizzando Amazon Bedrock

Possiamo utilizzare Anthropic Claude 2.1 per Amazon Bedrock per proporre un elenco di domande da porre sul set di dati della sperimentazione clinica:

Utilizza l'API Amazon Bedrock RetrieveAndGenerate

Per un'esperienza RAG completamente gestita, puoi utilizzare le Knowledge Base native per Amazon Bedrock RetrieveAndGenerate API per ottenere direttamente le risposte:

La fonte di informazioni citata può essere ottenuta tramite il seguente codice (con parte dell'output oscurato per brevità):

Passando l'ID di sessione del RetrieveAndGenerate API, puoi preservare il contesto della conversazione e porre domande di follow-up. Ad esempio, senza il contesto, se chiedi maggiori dettagli alla risposta precedente, potrebbe non essere in grado di rispondere correttamente:

Ma passando l'ID di sessione, la pipeline RAG è in grado di identificare il contesto corrispondente e restituire risposte pertinenti:

La tabella seguente mostra le risposte recuperate a tutte le domande corrispondenti.

| Question | Risposta |

| Qual è lo scopo dello studio? Assicurati di comprendere gli obiettivi della ricerca e cosa comporteranno le procedure di studio. | Lo scopo dello studio è verificare se il litio è efficace nel prevenire ripetute violenze suicide autodirette in pazienti con depressione o disturbo bipolare. |

| Quali sono i rischi e i potenziali benefici? Il modulo dovrebbe spiegare tutti i rischi prevedibili, gli effetti collaterali o i disagi che potresti riscontrare durante la partecipazione. | I possibili rischi o disagi includono: domande del colloquio che causano disagio, effetti collaterali dei farmaci al litio come nausea, feci molli, sete, alterazioni della minzione, tremori, mal di testa, sudorazione, affaticamento, diminuzione della concentrazione, eruzioni cutanee, alterazioni della tiroide, peggioramento dell'acne /psoriasi, tossicità da litio e rischi se il farmaco viene interrotto improvvisamente. I potenziali benefici sono che i test potrebbero portare a nuove informazioni per aiutare il partecipante, e il litio potrebbe aiutare a prevenire ripetute violenze suicide autodirette per chi soffre di depressione o disturbo bipolare. |

| Cosa comporterà la partecipazione? Ottieni dettagli su quali test, farmaci, cambiamenti nello stile di vita o procedure che sottoporrai, quanto tempo ci vorrà e quanto durerà lo studio. | La partecipazione comporterà il completamento di un'intervista e di questionari riguardanti il pensiero, i comportamenti, il trattamento della salute mentale, i farmaci, l'uso di alcol e droghe, il supporto domestico e sociale e la comprensione dello studio di ricerca. Questa operazione richiede circa due ore e può essere eseguita in più sessioni, di persona e per telefono. Se idonei per lo studio completo, ci saranno circa 20 visite di studio nell'arco di un anno. Ciò comporterà l'assunzione dei farmaci in studio, il controllo dei segni vitali, il completamento di questionari, la revisione degli effetti collaterali e il proseguimento della normale assistenza medica e di salute mentale. |

| Ci sono costi o pagamenti? Chiedi se sarai responsabile di eventuali costi relativi allo studio o verrai pagato per la partecipazione. | Sì, ci sono costi e pagamenti discussi nei risultati della ricerca. Non ti verrà addebitato alcun trattamento o procedura che fa parte dello studio. Tuttavia, dovrai comunque pagare i consueti ticket VA per cure e farmaci non correlati allo studio. Non sarai pagato per la partecipazione, ma lo studio rimborserà le spese relative alla partecipazione come trasporto, parcheggio, ecc. Vengono forniti gli importi e la procedura di rimborso. |

| Come sarà protetta la mia privacy? Il modulo dovrebbe spiegare come le tue informazioni sanitarie personali saranno mantenute riservate prima, durante e dopo lo studio. | La tua privacy sarà protetta conducendo interviste in privato, conservando appunti scritti in archivi e uffici chiusi a chiave, archiviando informazioni elettroniche in file crittografati e protetti da password e ottenendo un certificato di riservatezza dal Dipartimento della salute e dei servizi umani per impedire la divulgazione di informazioni che ti identificano . Le informazioni che ti identificano potrebbero essere condivise con i medici responsabili delle tue cure o per controlli e valutazioni da parte di agenzie governative, ma i discorsi e i documenti sullo studio non ti identificheranno. |

Esegui query utilizzando l'API Amazon Bedrock Retrieve

Per personalizzare il flusso di lavoro RAG, puoi utilizzare l'API Retrieve per recuperare i blocchi rilevanti in base alla query e trasmetterli a qualsiasi LLM fornito da Amazon Bedrock. Per utilizzare l'API Retrieve, definirla come segue:

Recupera il contesto corrispondente (con parte dell'output oscurato per brevità):

Estrai il contesto per il modello di prompt:

Importa i moduli Python e imposta il modello di richiesta di risposta alle domande nel contesto, quindi genera la risposta finale:

Query utilizzando l'integrazione Amazon Bedrock LangChain

Per creare un'applicazione di domande e risposte personalizzata end-to-end, Knowledge Base per Amazon Bedrock fornisce l'integrazione con LangChain. Per impostare il LangChain Retriever, fornire l'ID della knowledge base e specificare il numero di risultati da restituire dalla query:

Ora configura LangChain RetrievalQA e genera risposte dalla knowledge base:

Ciò genererà risposte corrispondenti simili a quelle elencate nella tabella precedente.

ripulire

Assicurati di eliminare le seguenti risorse per evitare di incorrere in costi aggiuntivi:

Conclusione

Amazon Bedrock fornisce un'ampia gamma di servizi profondamente integrati per potenziare le applicazioni RAG di tutte le scale, semplificando l'avvio dell'analisi dei dati aziendali. Le basi di conoscenza per Amazon Bedrock si integrano con i modelli base di Amazon Bedrock per creare pipeline di incorporamento di documenti scalabili e servizi di recupero di documenti per alimentare un'ampia gamma di applicazioni interne e rivolte ai clienti. Siamo entusiasti del futuro che ci aspetta e il tuo feedback svolgerà un ruolo fondamentale nel guidare il progresso di questo prodotto. Per ulteriori informazioni sulle funzionalità di Amazon Bedrock e sulle basi di conoscenza, fare riferimento a Base di conoscenza per Amazon Bedrock.

Informazioni sugli autori

Marco Roy è Principal Machine Learning Architect per AWS e aiuta i clienti a progettare e creare soluzioni AI/ML. Il lavoro di Mark copre un'ampia gamma di casi d'uso del machine learning, con un interesse primario per la visione artificiale, il deep learning e la scalabilità del machine learning in tutta l'azienda. Ha aiutato aziende in molti settori, tra cui assicurazioni, servizi finanziari, media e intrattenimento, sanità, servizi pubblici e produzione. Mark detiene sei certificazioni AWS, inclusa la certificazione di specialità ML. Prima di entrare in AWS, Mark è stato architetto, sviluppatore e leader tecnologico per oltre 25 anni, di cui 19 nei servizi finanziari.

Marco Roy è Principal Machine Learning Architect per AWS e aiuta i clienti a progettare e creare soluzioni AI/ML. Il lavoro di Mark copre un'ampia gamma di casi d'uso del machine learning, con un interesse primario per la visione artificiale, il deep learning e la scalabilità del machine learning in tutta l'azienda. Ha aiutato aziende in molti settori, tra cui assicurazioni, servizi finanziari, media e intrattenimento, sanità, servizi pubblici e produzione. Mark detiene sei certificazioni AWS, inclusa la certificazione di specialità ML. Prima di entrare in AWS, Mark è stato architetto, sviluppatore e leader tecnologico per oltre 25 anni, di cui 19 nei servizi finanziari.

Mani Khanuja è un Tech Lead – Generative AI Specialists, autore del libro – Applied Machine Learning and High Performance Computing on AWS e membro del Consiglio di amministrazione della Women in Manufacturing Education Foundation. Conduce progetti di machine learning (ML) in vari settori come la visione artificiale, l'elaborazione del linguaggio naturale e l'intelligenza artificiale generativa. Aiuta i clienti a creare, addestrare e distribuire modelli di machine learning di grandi dimensioni su larga scala. Partecipa a conferenze interne ed esterne come re:Invent, Women in Manufacturing West, webinar su YouTube e GHC 23. Nel tempo libero le piace fare lunghe corse lungo la spiaggia.

Mani Khanuja è un Tech Lead – Generative AI Specialists, autore del libro – Applied Machine Learning and High Performance Computing on AWS e membro del Consiglio di amministrazione della Women in Manufacturing Education Foundation. Conduce progetti di machine learning (ML) in vari settori come la visione artificiale, l'elaborazione del linguaggio naturale e l'intelligenza artificiale generativa. Aiuta i clienti a creare, addestrare e distribuire modelli di machine learning di grandi dimensioni su larga scala. Partecipa a conferenze interne ed esterne come re:Invent, Women in Manufacturing West, webinar su YouTube e GHC 23. Nel tempo libero le piace fare lunghe corse lungo la spiaggia.

Dott. Baichuan Sun, che attualmente ricopre il ruolo di Sr. AI/ML Solution Architect presso AWS, si concentra sull'intelligenza artificiale generativa e applica le sue conoscenze nella scienza dei dati e nell'apprendimento automatico per fornire soluzioni aziendali pratiche basate sul cloud. Con esperienza nella consulenza gestionale e nell'architettura di soluzioni AI, affronta una serie di sfide complesse, tra cui la visione artificiale robotica, la previsione di serie temporali e la manutenzione predittiva, tra le altre. Il suo lavoro si basa su un solido background di gestione di progetti, ricerca e sviluppo di software e attività accademiche. Al di fuori del lavoro, il dottor Sun ama l'equilibrio tra viaggiare e trascorrere del tempo con la famiglia e gli amici.

Dott. Baichuan Sun, che attualmente ricopre il ruolo di Sr. AI/ML Solution Architect presso AWS, si concentra sull'intelligenza artificiale generativa e applica le sue conoscenze nella scienza dei dati e nell'apprendimento automatico per fornire soluzioni aziendali pratiche basate sul cloud. Con esperienza nella consulenza gestionale e nell'architettura di soluzioni AI, affronta una serie di sfide complesse, tra cui la visione artificiale robotica, la previsione di serie temporali e la manutenzione predittiva, tra le altre. Il suo lavoro si basa su un solido background di gestione di progetti, ricerca e sviluppo di software e attività accademiche. Al di fuori del lavoro, il dottor Sun ama l'equilibrio tra viaggiare e trascorrere del tempo con la famiglia e gli amici.

Derrick Choo è un Senior Solutions Architect presso AWS focalizzato sull'accelerazione del percorso dei clienti verso il cloud e sulla trasformazione del loro business attraverso l'adozione di soluzioni basate sul cloud. La sua esperienza riguarda lo sviluppo di applicazioni full stack e di machine learning. Aiuta i clienti a progettare e costruire soluzioni end-to-end che coprono interfacce utente frontend, applicazioni IoT, integrazioni API e dati e modelli di machine learning. Nel tempo libero gli piace trascorrere del tempo con la sua famiglia e sperimentare con la fotografia e la videografia.

Derrick Choo è un Senior Solutions Architect presso AWS focalizzato sull'accelerazione del percorso dei clienti verso il cloud e sulla trasformazione del loro business attraverso l'adozione di soluzioni basate sul cloud. La sua esperienza riguarda lo sviluppo di applicazioni full stack e di machine learning. Aiuta i clienti a progettare e costruire soluzioni end-to-end che coprono interfacce utente frontend, applicazioni IoT, integrazioni API e dati e modelli di machine learning. Nel tempo libero gli piace trascorrere del tempo con la sua famiglia e sperimentare con la fotografia e la videografia.

Franco Winkler è un Senior Solutions Architect e uno specialista di intelligenza artificiale generativa presso AWS con sede a Singapore, specializzato in machine learning e intelligenza artificiale generativa. Collabora con aziende globali native digitali per progettare prodotti e servizi scalabili, sicuri ed economici su AWS. Nel tempo libero trascorre del tempo con suo figlio e sua figlia e viaggia per godersi le onde dell'ASEAN.

Franco Winkler è un Senior Solutions Architect e uno specialista di intelligenza artificiale generativa presso AWS con sede a Singapore, specializzato in machine learning e intelligenza artificiale generativa. Collabora con aziende globali native digitali per progettare prodotti e servizi scalabili, sicuri ed economici su AWS. Nel tempo libero trascorre del tempo con suo figlio e sua figlia e viaggia per godersi le onde dell'ASEAN.

Nihir Chadderwala è un Senior AI/ML Solutions Architect nel team Global Healthcare and Life Sciences. La sua esperienza consiste nella creazione di Big Data e soluzioni basate sull'intelligenza artificiale per i problemi dei clienti, in particolare nel settore biomedico, delle scienze della vita e della sanità. È anche entusiasta dell’intersezione tra scienza dell’informazione quantistica e intelligenza artificiale e gli piace imparare e contribuire a questo spazio. Nel tempo libero gli piace giocare a tennis, viaggiare e conoscere la cosmologia.

Nihir Chadderwala è un Senior AI/ML Solutions Architect nel team Global Healthcare and Life Sciences. La sua esperienza consiste nella creazione di Big Data e soluzioni basate sull'intelligenza artificiale per i problemi dei clienti, in particolare nel settore biomedico, delle scienze della vita e della sanità. È anche entusiasta dell’intersezione tra scienza dell’informazione quantistica e intelligenza artificiale e gli piace imparare e contribuire a questo spazio. Nel tempo libero gli piace giocare a tennis, viaggiare e conoscere la cosmologia.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/use-rag-for-drug-discovery-with-knowledge-bases-for-amazon-bedrock/

- :ha

- :È

- :non

- :Dove

- $ SU

- 1

- 10

- 100

- 11

- 120

- 121

- 13

- 14

- 150

- 160

- 19

- 20

- 23

- 25

- 29

- 35%

- 40

- 41

- 5 Domande

- 7

- 8

- 9

- a

- capace

- Chi siamo

- accademico

- accelerando

- accesso

- operanti in

- aggiunto

- aggiuntivo

- indirizzi

- Rettificato

- Adozione

- Dopo shavasana, sedersi in silenzio; saluti;

- contro

- agenzie

- agenti

- avanti

- AI

- AI-alimentato

- AI / ML

- alcol

- Algoritmi

- Tutti

- consentire

- consente

- lungo

- anche

- Amazon

- Amazon Web Services

- tra

- quantità

- importi

- an

- .

- Analitico

- analizzare

- l'analisi

- ed

- rispondere

- rispondere

- risposte

- Antropico

- in qualsiasi

- api

- API

- Applicazioni

- applicazioni

- applicato

- si applica

- opportuno

- architettura

- SONO

- AS

- Asean

- chiedere

- valutare

- addetto

- Assistant

- associato

- At

- audit

- aumentata

- autore

- automatizza

- automaticamente

- evitare

- lontano

- AWS

- Backed

- BACKEND

- sfondo

- Equilibrio

- bandiera

- base

- basato

- BE

- Beach

- stato

- prima

- comportamenti

- vantaggi

- Big

- Big Data

- biomedico

- nascita

- sangue

- tavola

- Consiglio di Amministrazione

- libro

- entrambi

- ampio

- costruire

- Costruzione

- affari

- ma

- by

- Materiale

- funzionalità

- che

- Custodie

- casi

- causando

- a livello internazionale

- Certificazione

- certificazioni

- Catene

- sfide

- Modifiche

- carico

- oneri

- chiacchierare

- controllato

- Scegli

- citato

- Info su

- Cloud

- codice

- COERENTE

- combina

- viene

- Uncommon

- comunemente

- Aziende

- azienda

- rispetto

- confronto

- completamento di una

- completamente

- completando

- complesso

- computer

- Visione computerizzata

- informatica

- concentrazione

- concetti

- conciso

- condotto

- conduzione

- conferenze

- riservato

- riservatezza

- configurato

- Confermare

- consenso

- considerando

- Consistente

- consolle

- consulting

- contenuto

- contesto

- contesti

- continua

- continua

- contribuendo

- di controllo

- Conversazione

- convertire

- correttamente

- Corrispondente

- Cosmologia

- costo effettivo

- Costi

- potuto

- copertura

- Copertine

- creare

- creato

- Creazione

- creazione

- CSP

- Attualmente

- costume

- cliente

- Clienti

- personalizzare

- personalizzate

- dati

- scienza dei dati

- Banca Dati

- banche dati

- figlia

- Giorni

- diminuita

- deep

- apprendimento profondo

- profondamente

- Predefinito

- definire

- dimostrazione

- dimostrare

- Shirts Department

- schierare

- Depressione

- descrizione

- Design

- dettagliati

- dettagli

- individuare

- Costruttori

- Mercato

- diverso

- digitale

- direttamente

- Amministrazione

- Divulgazione

- scoperta

- discusso

- disordine

- do

- Dottori

- documento

- documenti

- dominio

- domini

- don

- fatto

- Dont

- dosi

- dr

- droga

- durante

- ogni

- In precedenza

- Istruzione

- effetto

- Efficace

- effetti

- efficacia

- o

- Elaborare

- Elettronico

- eleggibile

- altro

- incorporamento

- impiega

- enable

- crittografato

- crittografia

- fine

- da un capo all'altro

- motore

- godere

- garantire

- entrare

- Impresa

- Intrattenimento

- Ambiente

- particolarmente

- essential

- eccetera

- valutare

- valutazioni

- esempio

- Excel

- eccitato

- spese

- esperienza

- sperimentazione

- competenza

- Spiegare

- esterno

- fatto

- Fallimento

- famiglia

- più veloce

- fatica

- feedback

- Compila il

- File

- finale

- finanziario

- servizi finanziari

- Trovare

- Nome

- concentrato

- si concentra

- seguito

- i seguenti

- segue

- Nel

- prevedibile

- modulo

- formato

- forme

- Fondazione

- Gratis

- amici

- da

- Frontend

- pieno

- Stack completo

- completamente

- function

- ulteriormente

- futuro

- generare

- genera

- la generazione di

- ELETTRICA

- generativo

- AI generativa

- ottenere

- globali

- digitale globale

- Go

- Obiettivi

- va

- Enti Pubblici

- agenzie governative

- terra

- garantito

- guidare

- maniglia

- Manovrabilità

- Avere

- avendo

- he

- mal di testa

- Salute e benessere

- Assistenza sanitaria

- informazioni sulla salute

- assistenza sanitaria

- Aiuto

- aiutato

- aiutare

- aiuta

- suo

- Alta

- alto livello

- il suo

- storia

- detiene

- Casa

- ORE

- Come

- Tutorial

- Tuttavia

- HTML

- http

- HTTPS

- umano

- ID

- identifica

- identificare

- if

- Immagine

- implementazioni

- implementato

- importare

- in

- includere

- Compreso

- In arrivo

- Index

- industrie

- informazioni

- Informa

- Infrastruttura

- inizialmente

- ingresso

- intuizioni

- install

- assicurazione

- integrato

- Integra

- integrazione

- integrazioni

- interezza

- Intelligente

- interazione

- interesse

- interfacce

- interno

- intersezione

- Colloquio

- Domande di un'intervista

- interviste

- ai miglioramenti

- coinvolgere

- IoT

- IT

- SUO

- accoppiamento

- viaggio

- jpg

- ad appena

- conservazione

- tenere

- Le

- Sapere

- Conoscere

- conoscenze

- Lingua

- grandi

- Cognome

- portare

- leader

- Leads

- IMPARARE

- apprendimento

- Consente di

- Livello

- livelli

- Vita

- Life Sciences

- stile di vita

- piace

- piace

- Lista

- elencati

- LLM

- Caricamento in corso

- località

- bloccato

- Lunghi

- macchina

- machine learning

- manutenzione

- make

- Fare

- gestire

- maneggevole

- gestito

- gestione

- gestisce

- consigliato per la

- molti

- marchio

- Marco

- massimo

- Maggio..

- me

- Media

- medicale

- ricerca medica

- medicazione

- farmaci

- medicina

- membro

- Memorie

- mentale

- Salute mentale

- Meta

- metodi

- forza

- ML

- modello

- modelli

- moduli

- monitorati

- mensile

- Scopri di più

- maggior parte

- molti

- multiplo

- devono obbligatoriamente:

- my

- Nome

- nativo

- Naturale

- Elaborazione del linguaggio naturale

- Navigazione

- Bisogno

- New

- no

- Nessuna

- normale

- Note

- numero

- numeri

- ottenere

- ottenuto

- ottenendo

- of

- uffici

- on

- ONE

- quelli

- esclusivamente

- Opzioni

- or

- orchestrazione

- i

- Altro

- Altri

- risultati

- produzione

- al di fuori

- ancora

- sovrapposizione

- pagina

- pagine

- pagato

- vetro

- documenti

- parcheggio

- parte

- partecipante

- partecipanti

- partecipante

- partecipazione

- passare

- Di passaggio

- Password

- pazienti

- Paga le

- pagamenti

- Persone

- percentuale

- performance

- periodo

- persona

- cronologia

- telefono

- fotografia

- pezzi

- conduttura

- piano

- Platone

- Platone Data Intelligence

- PlatoneDati

- Giocare

- gioco

- Popolare

- possibile

- Post

- potenziale

- energia

- Pratico

- pratica

- preferito

- Gravidanza

- prevenire

- prevenzione

- precedente

- primario

- Direttore

- Precedente

- Privacy

- un bagno

- problemi

- procedure

- processi

- lavorazione

- Prodotto

- Prodotti

- Progressi

- progetto

- gestione del progetto

- progetti

- istruzioni

- corretto

- offre

- proposto

- protetta

- fornire

- purché

- fornitori

- fornisce

- scopo

- Python

- Domande e risposte

- Quantistico

- informazione quantistica

- query

- domanda

- domanda

- Domande

- R&D

- straccio

- gamma

- che vanno

- eruzione cutanea

- RE

- ricevere

- riducendo

- riferimento

- regione

- relazionato

- pertinente

- ripetuto

- richiedendo

- riparazioni

- Risorse

- risposta

- responsabile

- colpevole

- Risultati

- richiamo

- ritorno

- revisione

- Ricco

- Rischio

- rischi

- robotica

- Ruolo

- corre

- runtime

- dire

- scalabile

- Scala

- bilancia

- scala

- Scienze

- SCIENZE

- Punto

- script

- sdk

- senza soluzione di continuità

- Cerca

- Sezione

- sezioni

- sicuro

- select

- selezionato

- auto-diretto

- semantico

- anziano

- separato

- Serie

- serverless

- servizio

- Servizi

- servizio

- Sessione

- sessioni

- set

- regolazione

- impostazioni

- condiviso

- lei

- dovrebbero

- Spettacoli

- lato

- segno

- Segni

- simile

- Un'espansione

- Singapore

- siede

- SIX

- Taglia

- Pelle

- inferiore

- So

- Social

- Software

- solido

- soluzione

- Soluzioni

- alcuni

- è composta da

- Fonte

- fonti

- lo spazio

- campata

- Parla

- specialista

- specialisti

- specializzata

- Specialità

- specifico

- in particolare

- specificato

- Spendere

- spende

- dividere

- Si divide

- Foglio di calcolo

- Stabilità

- pila

- Standard

- inizia a

- iniziato

- Di partenza

- inizio

- statistiche

- statistica

- Stato dei servizi

- step

- Passi

- Ancora

- fermato

- sosta

- conservazione

- Tornare al suo account

- negozi

- memorizzare

- lineare

- Strategia

- Studio

- tale

- suicidio

- Dom.

- supporto

- supporti

- sicuro

- sync.

- dati

- sintassi

- sintetico

- sistema

- tavolo

- Fai

- preso

- prende

- presa

- trattativa

- team

- Tech

- per l'esame

- Tecnologia

- modello

- tennis

- terminologia

- test

- test

- testo

- che

- I

- Il futuro

- L’ORIGINE

- loro

- Li

- si

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- Pensiero

- di parti terze standard

- questo

- quelli

- Attraverso

- portata

- tempo

- Serie storiche

- titano

- a

- insieme

- token

- top

- top 5

- Tracciabilità

- Treni

- trasformazione

- trasporti

- Di viaggio

- viaggia

- trattamento

- trattamenti

- prova

- innescare

- prova

- seconda

- Digitare

- Tipi di

- per

- capire

- e una comprensione reciproca

- unificato

- non strutturati

- aggiornato

- aggiornamento

- uso

- caso d'uso

- utilizzato

- Utente

- usa

- utilizzando

- solito

- generalmente

- utilità

- v1

- Valori

- vario

- notevolmente

- versione

- via

- Violenza

- visione

- Visite

- importantissima

- volere

- Prima

- onde

- we

- sito web

- servizi web

- Webinars

- Settimane

- WELL

- ovest

- Che

- Che cosa è l'

- quando

- se

- quale

- OMS

- largo

- Vasta gamma

- volere

- finestra

- con

- senza

- Donna

- Word

- Lavora

- flusso di lavoro

- lavoro

- lavori

- sarebbe

- scrivere

- scritto

- anno

- anni

- Tu

- Trasferimento da aeroporto a Sharm

- youtube

- zefiro