Mentre il mondo si affretta a utilizzare l’ultima ondata di tecnologie di intelligenza artificiale, un pezzo di hardware high-tech è diventato un prodotto sorprendentemente popolare: l’unità di elaborazione grafica, o GPU.

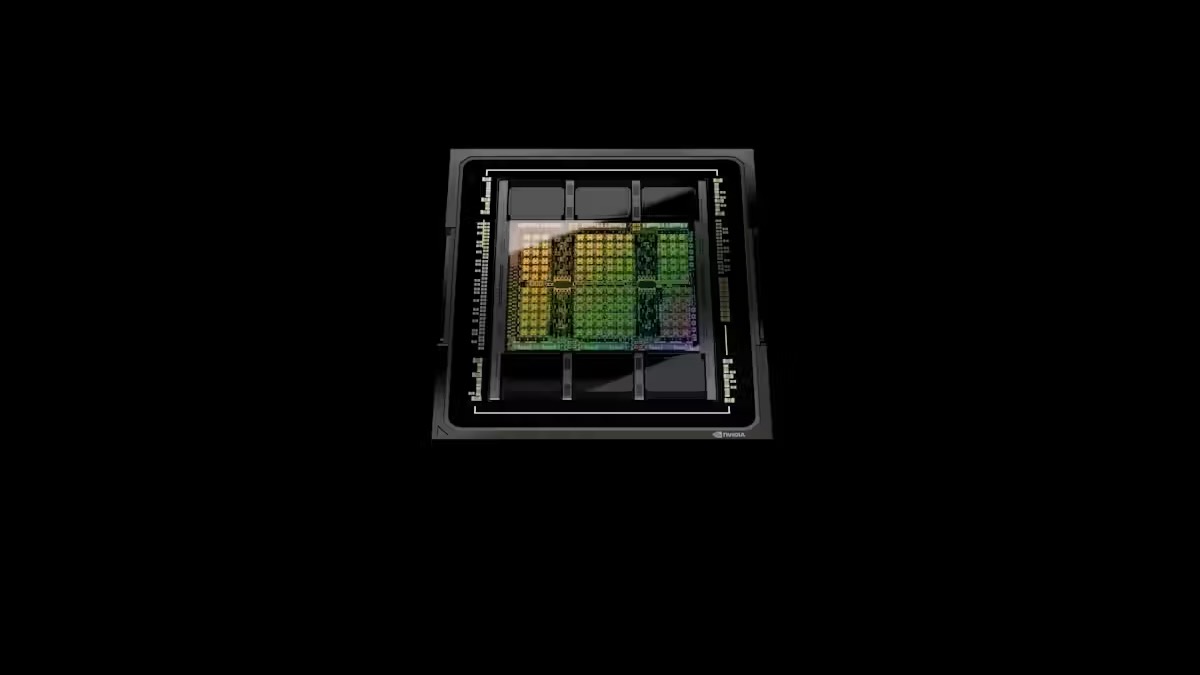

Una GPU top di gamma può essere venduta decine di migliaia di dollari, e il produttore leader Nvidia ha visto la sua valutazione di mercato salire oltre i 2 trilioni di dollari mentre la domanda per i suoi prodotti aumenta.

Le GPU non sono solo prodotti AI di fascia alta. Esistono GPU meno potenti anche nei telefoni, nei laptop e nelle console di gioco.

A questo punto probabilmente ti starai chiedendo: cos'è veramente una GPU? E cosa li rende così speciali?

Cos'è una GPU?

Le GPU sono state originariamente progettate principalmente per generare e visualizzare rapidamente scene e oggetti 3D complessi, come quelli coinvolti nei videogiochi e progettazione assistita da computer Software. Le GPU moderne gestiscono anche attività come decomprime flussi video.

Il “cervello” della maggior parte dei computer è un chip chiamato unità di elaborazione centrale (CPU). Le CPU possono essere utilizzate per generare scene grafiche e decomprimere video, ma in genere sono molto più lente e meno efficienti in queste attività rispetto alle GPU. Le CPU sono più adatte per attività di calcolo generali, come l'elaborazione di testi e la navigazione di pagine web.

In che modo le GPU sono diverse dalle CPU?

Una tipica CPU moderna è composta da 8 e 16″colori”, ognuno dei quali può elaborare attività complesse in modo sequenziale.

Le GPU, d'altra parte, hanno migliaia di core relativamente piccoli, progettati per funzionare tutti contemporaneamente ("in parallelo") per ottenere un'elaborazione complessiva veloce. Ciò li rende particolarmente adatti per attività che richiedono un gran numero di operazioni semplici che possono essere eseguite contemporaneamente, anziché una dopo l'altra.

Le GPU tradizionali sono disponibili in due versioni principali.

Innanzitutto, ci sono i chip autonomi, che spesso vengono forniti come schede aggiuntive per computer desktop di grandi dimensioni. In secondo luogo ci sono le GPU combinate con una CPU nello stesso pacchetto di chip, che si trovano spesso nei laptop e nelle console di gioco come la PlayStation 5. In entrambi i casi, la CPU controlla ciò che fa la GPU.

Perché le GPU sono così utili per l'intelligenza artificiale?

Si scopre che le GPU possono essere riproposte per fare di più che generare scene grafiche.

Molte delle tecniche di machine learning dietro intelligenza artificiale, come reti neurali profonde, fanno molto affidamento su varie forme di moltiplicazione di matrici.

Questa è un'operazione matematica in cui insiemi di numeri molto grandi vengono moltiplicati e sommati insieme. Queste operazioni sono adatte all'elaborazione parallela e quindi possono essere eseguite molto rapidamente dalle GPU.

Qual è il futuro delle GPU?

L'abilità delle GPU in termini di numeri è in costante aumento a causa dell'aumento del numero di core e delle loro velocità operative. Questi miglioramenti sono principalmente guidati dai miglioramenti nella produzione di chip da parte di aziende come TSMC in Taiwan.

La dimensione dei singoli transistor – i componenti di base di qualsiasi chip di computer – sta diminuendo, consentendo di collocare più transistor nella stessa quantità di spazio fisico.

Tuttavia, questa non è tutta la storia. Sebbene le GPU tradizionali siano utili per le attività di calcolo legate all'intelligenza artificiale, non sono ottimali.

Proprio come le GPU sono state originariamente progettate per accelerare i computer fornendo elaborazione specializzata per la grafica, esistono acceleratori progettati per accelerare le attività di apprendimento automatico. Questi acceleratori vengono spesso definiti GPU per data center.

Alcuni degli acceleratori più popolari, realizzati da aziende come AMD e Nvidia, sono nati come GPU tradizionali. Nel corso del tempo, i loro progetti si sono evoluti per gestire meglio varie attività di apprendimento automatico, ad esempio supportando il più efficiente "galleggiamento del cervello"formato numerico.

Altri acceleratori, come quello di Google unità di elaborazione tensoriale e quello di Tenstorrent Tensix core, sono stati progettati da zero per accelerare le reti neurali profonde.

Le GPU dei data center e altri acceleratori IA in genere sono dotati di una memoria significativamente maggiore rispetto alle schede aggiuntive GPU tradizionali, il che è fondamentale per l'addestramento di modelli IA di grandi dimensioni. Più grande è il modello AI, più capace e preciso è.

Per accelerare ulteriormente la formazione e gestire modelli di intelligenza artificiale ancora più grandi, come ChatGPT, è possibile raggruppare molte GPU del data center per formare un supercomputer. Ciò richiede un software più complesso per sfruttare adeguatamente la potenza di calcolo dei numeri disponibile. Un altro approccio è quello di creare un unico acceleratore molto grande, come il "processore su scala wafer"Prodotto da Cerebras.

I chip specializzati sono il futuro?

Anche le CPU non sono rimaste ferme. Le recenti CPU di AMD e Intel dispongono di istruzioni di basso livello integrate che accelerano l'elaborazione dei numeri richiesta dalle reti neurali profonde. Questa funzionalità aggiuntiva aiuta principalmente con attività di “inferenza”, ovvero utilizzando modelli di intelligenza artificiale già sviluppati altrove.

Per addestrare innanzitutto i modelli IA sono ancora necessari grandi acceleratori simili a GPU.

È possibile creare acceleratori sempre più specializzati per specifici algoritmi di machine learning. Recentemente, ad esempio, una società chiamata Groq ha prodotto un “unità di elaborazione del linguaggio" (LPU) progettato specificamente per l'esecuzione di modelli linguistici di grandi dimensioni sulla falsariga di ChatGPT.

Tuttavia, la creazione di questi processori specializzati richiede notevoli risorse ingegneristiche. La storia mostra che l’utilizzo e la popolarità di un dato algoritmo di machine learning tende a raggiungere il picco e poi a diminuire, quindi l’hardware specializzato e costoso potrebbe diventare rapidamente obsoleto.

Per il consumatore medio, tuttavia, è improbabile che ciò costituisca un problema. È probabile che le GPU e gli altri chip dei prodotti che utilizzi continuino a diventare silenziosamente più veloci.

Questo articolo è ripubblicato da The Conversation sotto una licenza Creative Commons. Leggi il articolo originale.

Immagine di credito: Nvidia

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://singularityhub.com/2024/03/13/what-is-a-gpu-the-chips-powering-the-ai-boom-and-why-theyre-worth-trillions/

- :ha

- :È

- :non

- :Dove

- $ SU

- 16

- 3d

- 8

- a

- accelerare

- acceleratori

- preciso

- Raggiungere

- Aggiungi su

- aggiuntivo

- Dopo shavasana, sedersi in silenzio; saluti;

- AI

- Modelli AI

- algoritmo

- Algoritmi

- Tutti

- Consentire

- lungo

- già

- anche

- AMD

- quantità

- ed

- Un altro

- in qualsiasi

- approccio

- SONO

- articolo

- AS

- At

- disponibile

- media

- basic

- BE

- diventare

- stato

- dietro

- Meglio

- fra

- boom

- entrambi

- navigazione

- incassato

- ma

- by

- detto

- Materiale

- capace

- Carte

- casi

- centro

- centrale

- ChatGPT

- patata fritta

- Chips

- COM

- combinato

- Venire

- merce

- Popolo

- Aziende

- azienda

- rispetto

- complesso

- componenti

- calcolo

- computer

- computer

- notevole

- console

- Consumer

- controlli

- creare

- Creazione

- Creative

- credito

- cruciale

- dati

- Banca dati

- deep

- Richiesta

- progettato

- disegni

- tavolo

- sviluppato

- diverso

- Dsiplay

- do

- effettua

- fatto

- spinto

- dovuto

- ogni

- efficiente

- o

- altrove

- Ingegneria

- Intero

- Anche

- EVER

- si è evoluta

- esempio

- costoso

- lontano

- FAST

- più veloce

- Nome

- Nel

- modulo

- formato

- forme

- essere trovato

- da

- funzionalità

- ulteriormente

- futuro

- gioco

- Giochi

- gaming

- Generale

- generare

- ottenere

- dato

- GPU

- GPU

- grafiche

- Terra

- cura

- maniglia

- Hardware

- cintura da arrampicata

- Avere

- pesantemente

- aiuta

- quindi

- High-End

- storia

- HOT

- Tuttavia

- HTTPS

- miglioramenti

- in

- crescente

- individuale

- istruzioni

- Intel

- coinvolto

- IT

- SUO

- jpeg

- ad appena

- mantenere

- Lingua

- computer portatili

- grandi

- superiore, se assunto singolarmente.

- con i più recenti

- principale

- apprendimento

- meno

- Licenza

- probabile

- Linee

- macchina

- machine learning

- fatto

- Principale

- principalmente

- make

- FA

- modo

- Costruttore

- consigliato per la

- molti

- Rappresentanza

- matematico

- Matrice

- Maggio..

- Memorie

- modello

- modelli

- moderno

- Scopri di più

- più efficiente

- maggior parte

- Più popolare

- moltiplicato

- di applicazione

- reti

- neurale

- reti neurali

- GENERAZIONE

- adesso

- numero

- numeri

- Nvidia

- oggetti

- of

- di frequente

- on

- ONE

- operativo

- operazione

- Operazioni

- ottimale

- or

- originariamente

- Altro

- su

- antiquato

- ancora

- complessivo

- pacchetto

- pagine

- Parallel

- passato

- Corrente di

- eseguita

- telefoni

- Fisico

- pezzo

- posto

- Platone

- Platone Data Intelligence

- PlatoneDati

- playstation

- PlayStation 5

- Popolare

- popolarità

- possibile

- energia

- potente

- Accensione

- principalmente

- probabilmente

- Problema

- processi

- lavorazione

- processori

- Prodotto

- Prodotti

- propriamente

- fornitura

- abilità

- rapidamente

- tranquillamente

- piuttosto

- Leggi

- veramente

- recente

- recentemente

- di cui

- relativamente

- fare affidamento

- richiedere

- necessario

- richiede

- Risorse

- Reuters

- Aumento

- running

- stesso

- Scene

- Secondo

- visto

- venda

- Set

- Spettacoli

- significativamente

- Un'espansione

- singolo

- Taglia

- piccole

- So

- Software

- lo spazio

- la nostra speciale

- specializzata

- specifico

- in particolare

- velocità

- velocità

- standalone

- in piedi

- iniziato

- costantemente

- Ancora

- Storia

- flussi

- tale

- adatto

- riassunto

- supercomputer

- Supporto

- sovratensioni

- sorprendentemente

- Taiwan

- prende

- task

- tecniche

- Tecnologie

- tende

- di

- che

- Il

- Il futuro

- il mondo

- loro

- Li

- poi

- Là.

- Strumenti Bowman per analizzare le seguenti finiture:

- di

- questo

- quelli

- migliaia

- tempo

- a

- insieme

- pure

- tradizionale

- Treni

- Training

- triliardi

- si

- seconda

- tipico

- tipicamente

- per

- unità

- improbabile

- Impiego

- uso

- utilizzato

- utile

- utilizzando

- Valorizzazione

- vario

- molto

- Video

- video games

- Video

- Wave

- sito web

- sono stati

- Che

- Che cosa è l'

- quale

- while

- perché

- wikipedia

- con

- chiedendosi

- Word

- Lavora

- mondo

- valore

- Tu

- zefiro