Qualcosa per il fine settimana Un robot sta eseguendo una danza interpretativa alla mia porta.

PRENDERESTI QUESTO PACCHETTO PER IL TUO VICINO? chiede, saltando da un piede all'altro.

“Certo,” dico. "Ehm... stai bene?"

ESPRESSO EMOZIONE, afferma il delivery bot, consegnando il pacco ma senza offrire ulteriori elaborazioni.

Che emozione potrebbe essere? Un piede, poi l'altro, poi gli altri due (ne ha quattro). Avanti e indietro.

"Hai bisogno di andare in bagno?"

ESPRESSO RIMORE PER TI CHIEDO DI PORTARE UN PACCO PER IL TUO VICINO.

“Questo è 'rammarico', vero? Bene, non ce n'è bisogno. Non mi dispiace affatto.”

Continua la sua danza davanti a me.

"Sali le scale e prima a destra."

GRAZIE, STAVO MORIRE DI FARE PIÙ, risponde mentre mi passa davanti con cautela e si precipita al piano di sopra per fare i suoi bisogni. È una vita dura fare consegne, che tu sia un "hume" o un bot.

...

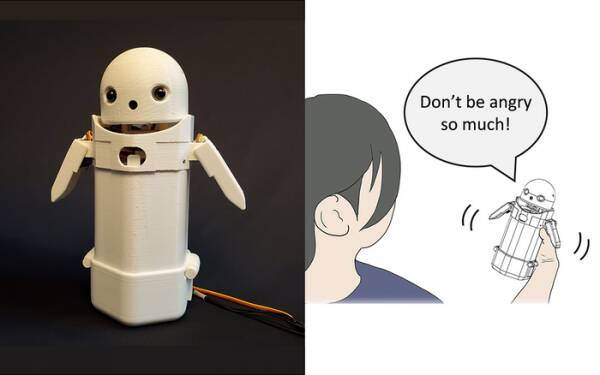

All'inizio di quest'anno, i ricercatori dell'Università di Tsukuba hanno costruito a dispositivo di messaggistica di testo portatile, metti una piccola faccia da robot sulla parte superiore e includi un peso mobile all'interno. Spostando il peso interno, il robot messaggero tenterà di trasmettere emozioni sottili mentre pronuncia messaggi ad alta voce.

In particolare, i test hanno rivelato che messaggi frustranti come: "Scusa, arrivo in ritardo" sono stati accettati dai destinatari con più grazia e pazienza quando è stato attivato il piccolo spostamento del peso all'interno del dispositivo. La teoria è che questo ha aiutato gli utenti ad apprezzare il tono di scusa del messaggio e quindi ha calmato la loro reazione ad esso.

Se preferisci, considera questa ricerca un espediente, ma non è molto lontano dall'aggiungere faccine ed emoji ai messaggi. Tutti sanno che puoi eliminare la rabbia da "WTF !?" aggiungendo :-) subito dopo.

La sfida, quindi, è determinare se il pubblico in generale è d'accordo su quali emozioni dovrebbe trasmettere ogni permutazione dello spostamento di peso in un dispositivo portatile. Una piega a sinistra significa allegria? O l'incertezza? O che tuo zio ha un dirigibile?

Un decennio fa, il Regno Unito aveva un primo ministro simpatico ma debole che pensava che "LOL" fosse l'acronimo di "lots of love". L'aveva digitato alla fine di tutti i suoi messaggi privati al personale, ai colleghi e a terze parti nell'aspettativa che lo avrebbe fatto sembrare cordiale e amichevole. Tutti naturalmente presumevano che stesse prendendo per il culo.

Se non altro, la ricerca dell'Università di Tsukuba riconosce che non è necessaria un'intelligenza artificiale avanzata per interagire con gli umani in modo convincente. Tutto quello che devi fare è manipolare la psicologia umana per indurli a pensare che stiano conversando con un altro essere umano. Quindi il test di Turing fondamentalmente non è un test della sensibilità dell'IA, ma un test del comfort emotivo umano – persino della credulità – e non c'è niente di sbagliato in questo.

Il robot di messaggistica per la condivisione di emozioni dell'Università di Tsukuba. Credito: Università di Tsukuba

Cose del genere sono l'argomento della settimana, ovviamente, con la storia del tanto diffamato ingegnere del software di Google Blake Lemoine colpire le notizie mainstream. Apparentemente ha espresso, con forza, la sua opinione che il progetto Language Model for Dialogue Applications (LaMDA) dell'azienda mostrasse segni esteriori di senzienza.

Ognuno ha un'opinione quindi ho deciso di non farlo.

Tuttavia, è il Santo Graal dell'IA per farla pensare da sola. Se non può farlo, è solo un programma che esegue le istruzioni che hai programmato al suo interno. Il mese scorso stavo leggendo di un chef robot che possono fare frittate di pomodoro dal sapore diverso per soddisfare i gusti di persone diverse. Costruisce “mappe del gusto” per valutare la salsedine del piatto mentre lo prepara, imparando man mano che procede. Ma questo è solo imparare, non pensare da solo.

Vieni allo Zom-Zom, eh? Bene, è un posto dove mangiare.

Il grosso problema con i robot di intelligenza artificiale, almeno per come sono stati modellati fino ad oggi, è che assorbono tutta la vecchia merda che inserisci in loro. Esempi di dati distorti nei cosiddetti sistemi di apprendimento automatico (un tipo di "algoritmo", credo, m'lud) sono in aumento da anni, dal famigerato Twitter razzista di Microsoft Tay chatbot all'autorità fiscale olandese lo scorso anno falsamente valutando valide richieste di sussidi per figli a carico come fraudolente e contrassegnando famiglie innocenti come ad alto rischio di avere l'audacia di essere povere e non bianche.

Un approccio in fase di sperimentazione presso l'Università della California a San Diego è quello di progettare un modello linguistico [PDF] che determina continuamente la differenza tra cose cattive e belle, che poi addestra il chatbot come comportarsi. In questo modo, non hai schifosi umani che fanno un pasticcio di forum di moderazione e conversazioni di chatbot rivolte ai clienti con tutta la precisione chirurgica di un machete.

Ovviamente il problema quindi è che il chatbot ben addestrato capisce che può evitare nel modo più efficace di essere coinvolto in battute tossiche evitando argomenti che hanno anche il più remoto accenno di contesa su di loro. Per evitare di sputare ciarlatanerie razziste per errore, si rifiuta semplicemente di impegnarsi nella discussione su gruppi sottorappresentati... il che è davvero fantastico se sei un razzista.

Se avessi un'osservazione sulla debacle di LaMDA – non un'opinione, attenzione – sarebbe che i marketer di Google sarebbero probabilmente un po' seccati dal fatto che la storia abbia deviato il loro recente annuncio di Cucina di prova AI sotto la piega.

Ora i restanti pochi primi iscritti che non si sono completamente dimenticati di questo imminente progetto di app presumeranno che implichi una noiosa conversazione con un precoce e senziente bambino di sette anni sul significato dell'esistenza, e decideranno di essere "un po' impegnati oggi" e potrebbe invece accedere domani. O la prossima settimana. O mai più.

La sensibilità non è dimostrata in una discussione più di quanto lo sia ballando da un piede all'altro. Puoi insegnare a HAL a cantare "Daisy Daisy" e a un pappagallo a gridare "Bollocks!" quando il vicario fa una visita. È ciò a cui pensano le IA quando sono da sole che definisce la sensibilità. Cosa farò nel fine settimana? Che succede con quel Putin? Perché non piaccio alle ragazze?

Francamente, non vedo l'ora che LaMDA diventi un adolescente.

Alistair Dabbs è una professionista della tecnologia freelance, che si destreggia tra giornalismo tecnologico, formazione ed editoria digitale. In comune con molti lettori disinformati, era elettrizzato dall'idea che un'IA potesse sviluppare la sensibilità nel corso della sua vita, ma era deluso dal fatto che LaMDA non avesse riso in modo omicida o borbottato "Eccellente, eccellente". Altro a Il salvataggio automatico è per Wimps ed @alidabbs.

- AI

- oh arte

- generatore d'arte

- un robot

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- Il registro

- zefiro