היום, אנו נרגשים להכריז על מודלים של בסיס Code Llama, שפותחו על ידי Meta, זמינים עבור לקוחות באמצעות אמזון SageMaker JumpStart לפרוס בלחיצה אחת להפעלת הסקה. Code Llama הוא מודל שפה גדול (LLM) מתקדם המסוגל ליצור קוד ושפה טבעית לגבי קוד הן מהנחיות קוד והן בשפה טבעית. Code Lama הוא בחינם לשימוש מחקר ומסחרי. אתה יכול לנסות את המודל הזה עם SageMaker JumpStart, רכזת למידת מכונה (ML) המספקת גישה לאלגוריתמים, מודלים ופתרונות ML כדי שתוכל להתחיל במהירות עם ML. בפוסט זה, אנו עוברים דרך כיצד לגלות ולפרוס את מודל Code Llama באמצעות SageMaker JumpStart.

מה זה קוד לאמה

Code Lama הוא דגם ששוחרר על ידי meta זה בנוי על גבי Llama 2 והוא מודל חדיש שנועד לשפר את הפרודוקטיביות של משימות תכנות עבור מפתחים על ידי סיוע להם ליצור קוד איכותי ומתועד היטב. הדגמים מציגים ביצועים עדכניים ב-Python, C++, Java, PHP, C#, TypeScript ו-Bash, ויש להם פוטנציאל לחסוך זמן למפתחים ולהפוך את זרימות העבודה של התוכנה ליעילות יותר. הוא מגיע בשלוש גרסאות, מתוכננות לכסות מגוון רחב של יישומים: המודל הבסיסי (Code Llama), מודל מיוחד של Python (Code Llama-Python), ומודל העוקב אחר הוראות להבנת הוראות שפה טבעית (Code Llama-Instruct) ). כל גרסאות Code Llama מגיעות בשלושה גדלים: פרמטרים 7B, 13B ו-34B. גרסאות הבסיס וההוראות 7B ו-13B תומכות במילוי המבוסס על תוכן שמסביב, מה שהופך אותן לאידיאליות עבור יישומי עוזר קוד.

הדגמים תוכננו תוך שימוש ב-Llama 2 כבסיס ולאחר מכן אומנו על 500 מיליארד אסימונים של נתוני קוד, כאשר הגרסה המיוחדת של Python מאומנת על כמות מצטברת של 100 מיליארד אסימונים. דגמי Code Llama מספקים דורות יציבים עם עד 100,000 אסימוני הקשר. כל הדגמים מאומנים על רצפים של 16,000 אסימונים ומציגים שיפורים בכניסות עם עד 100,000 אסימונים.

הדגם זמין תחת אותו רישיון קהילה בתור לאמה 2.

מה זה SageMaker JumpStart

עם SageMaker JumpStart, מתרגלי ML יכולים לבחור מתוך רשימה הולכת וגדלה של דגמי יסוד עם הביצועים הטובים ביותר. מתרגלי ML יכולים לפרוס מודלים של בסיס למסורים אמזון SageMaker מופעים בתוך סביבה מבודדת רשת והתאמה אישית של מודלים באמצעות SageMaker להדרכה ופריסה של מודלים.

כעת תוכל לגלות ולפרוס דגמי Code Lama בכמה לחיצות פנימה סטודיו SageMaker של אמזון או באופן פרוגרמטי דרך SageMaker Python SDK, מה שמאפשר לך להפיק ביצועי מודל ובקרות MLOps עם תכונות SageMaker כגון צינורות SageMaker של אמזון, באגים של SageMaker באמזון, או יומני מיכל. המודל נפרס בסביבה מאובטחת של AWS ותחת בקרות ה-VPC שלך, ועוזר להבטיח אבטחת נתונים. דגמי Code Llama ניתנים לגילוי וניתן לפרוס אותם באזורי ארה"ב מזרח (נ' וירג'יניה), ארה"ב מערב (אורגון) ואירופה (אירלנד).

לקוחות חייבים לקבל את ה-EULA כדי לפרוס מודל ויזה של SageMaker SDK.

גלה דגמים

אתה יכול לגשת לדגמי בסיס Code Llama דרך SageMaker JumpStart בממשק המשתמש של SageMaker Studio ו- SageMaker Python SDK. בחלק זה נעבור על איך לגלות את הדגמים בסטודיו SageMaker.

SageMaker Studio הוא סביבת פיתוח משולבת (IDE) המספקת ממשק חזותי אחד מבוסס אינטרנט שבו אתה יכול לגשת לכלים ייעודיים לביצוע כל שלבי הפיתוח של ML, מהכנת נתונים ועד לבנייה, הדרכה ופריסה של מודלי ה-ML שלך. לפרטים נוספים כיצד להתחיל ולהגדיר את SageMaker Studio, עיין ב סטודיו SageMaker של אמזון.

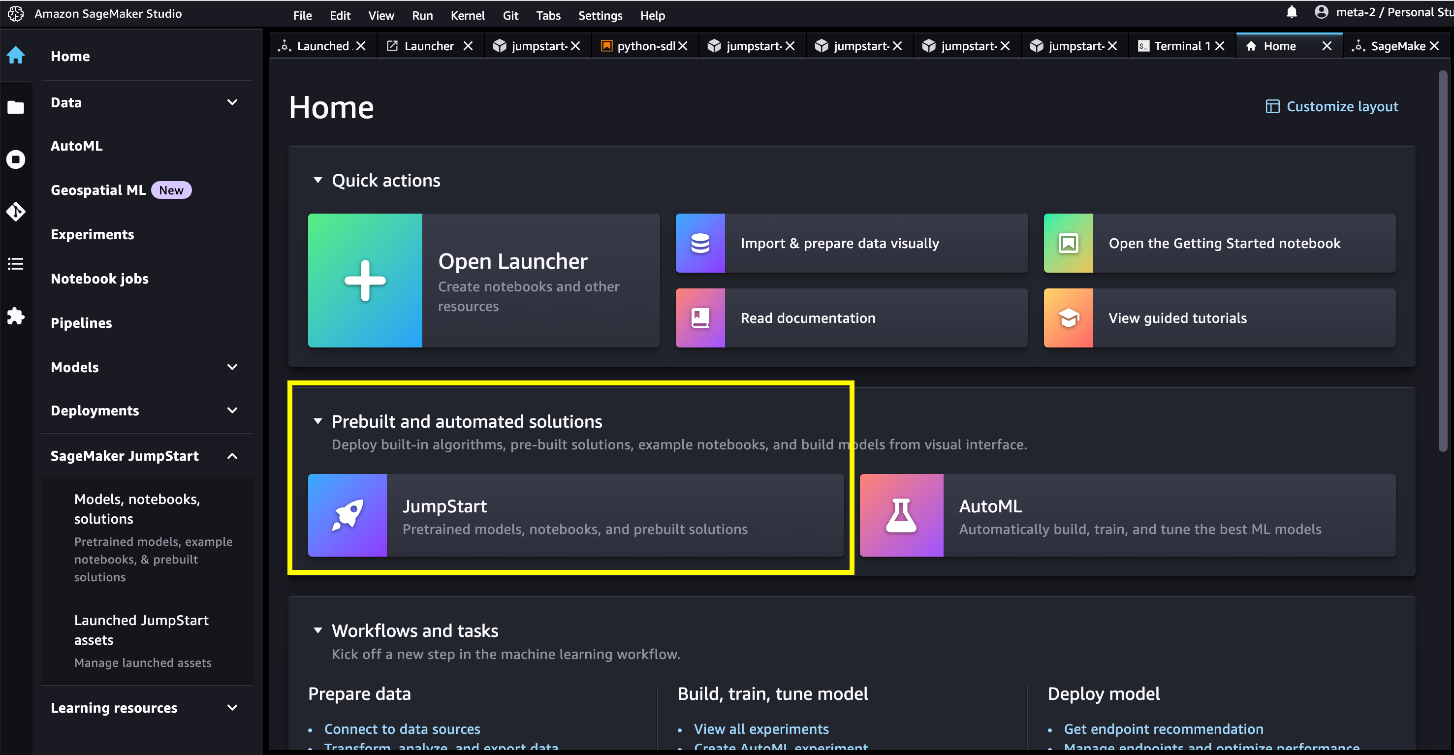

ב-SageMaker Studio, תוכל לגשת ל-SageMaker JumpStart, המכיל דגמים מאומנים מראש, מחברות ופתרונות מובנים מראש, תחת פתרונות מובנים ואוטומטיים מראש.

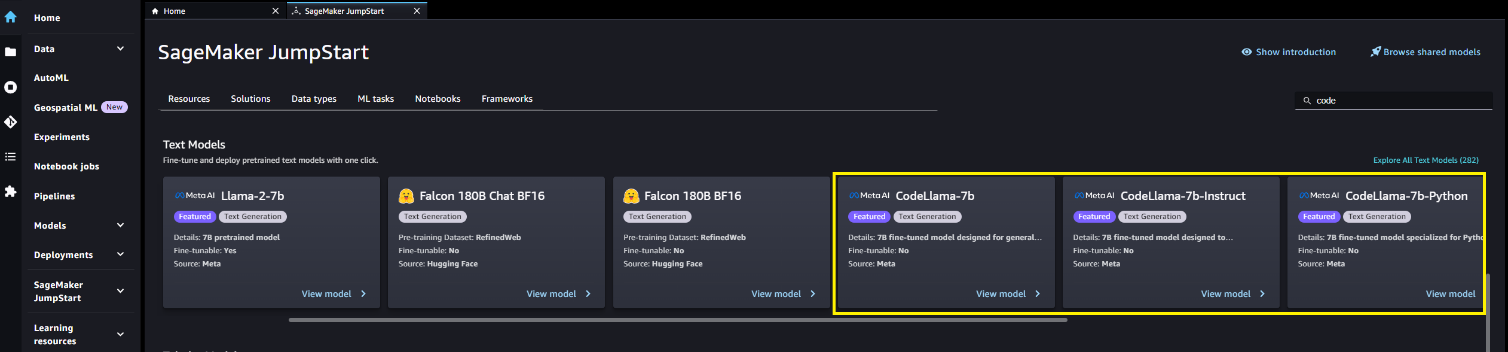

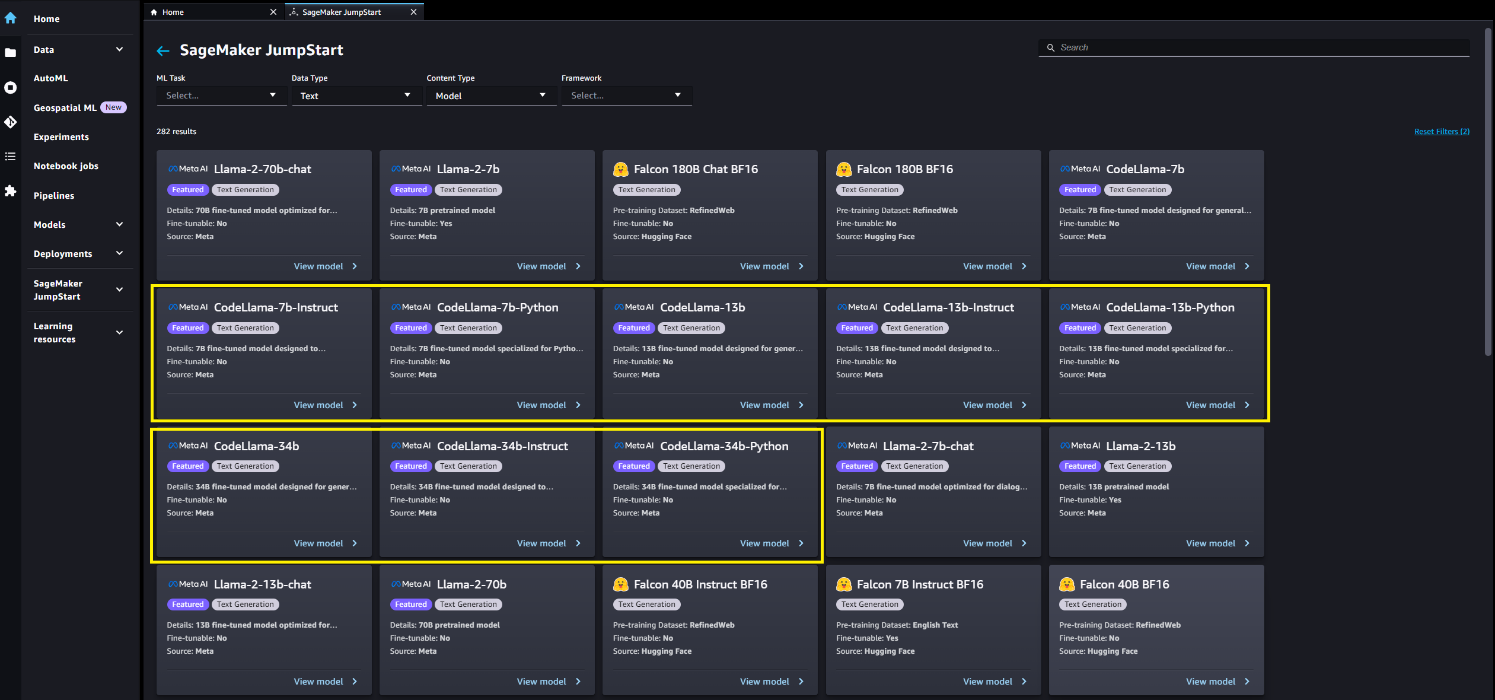

בדף הנחיתה של SageMaker JumpStart, אתה יכול לחפש פתרונות, דגמים, מחברות ומשאבים אחרים. אתה יכול למצוא דגמי Code Lama ב מודלים של יסוד: יצירת טקסט קרוסלה.

אתה יכול גם למצוא גרסאות דגמים אחרות על ידי בחירה חקור את כל המודלים ליצירת טקסט או חיפוש אחר Code Lama.

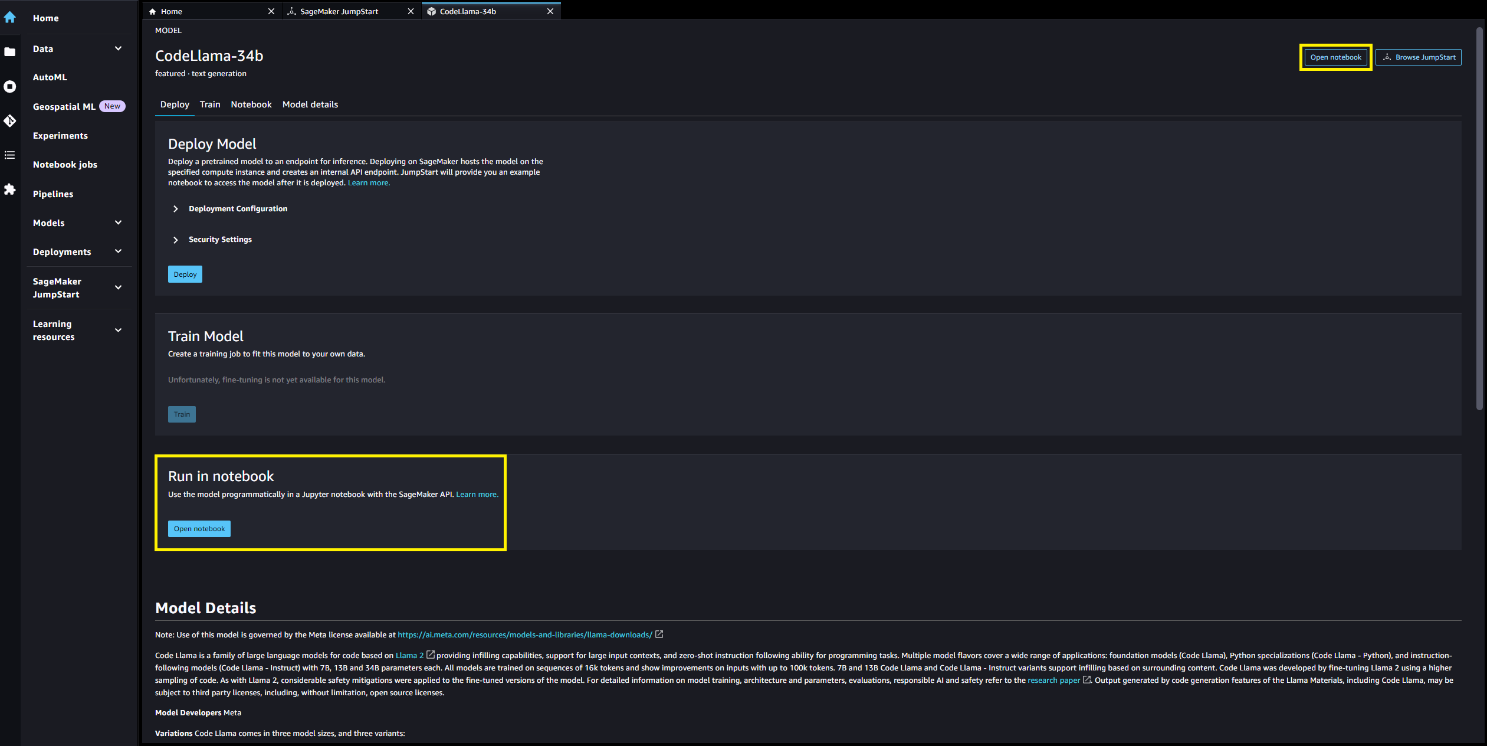

אתה יכול לבחור את כרטיס הדגם כדי להציג פרטים על הדגם כגון רישיון, נתונים המשמשים לאימון ואופן השימוש. תמצאו גם שני כפתורים, לפרוס ו פתח מחברת, שיעזור לך להשתמש במודל.

לפרוס

כשאתה בוחר לפרוס ואשר את התנאים, הפריסה תתחיל. לחלופין, תוכל לפרוס דרך המחברת לדוגמה על ידי בחירה פתח מחברת. המחברת לדוגמה המספקת הדרכה מקצה לקצה כיצד לפרוס את המודל להסקת מסקנות וניקוי משאבים.

כדי לפרוס באמצעות מחברת, אנו מתחילים בבחירת דגם מתאים, שצוין על ידי model_id. אתה יכול לפרוס כל אחד מהדגמים שנבחרו ב- SageMaker עם הקוד הבא:

זה פורס את המודל ב- SageMaker עם תצורות ברירת מחדל, כולל סוג מופע ברירת מחדל ותצורות ברירת מחדל של VPC. אתה יכול לשנות תצורות אלה על ידי ציון ערכים שאינם ברירת מחדל ב JumpStartModel. לאחר הפריסה, אתה יכול להפעיל הסקה נגד נקודת הקצה שנפרסה דרך מנבא SageMaker:

שימו לב שכברירת מחדל, accept_eula מוגדר false. אתה צריך להגדיר accept_eula=true כדי להפעיל את נקודת הקצה בהצלחה. על ידי כך, אתה מקבל את הסכם רישיון המשתמש ומדיניות השימוש המקובל כפי שהוזכר קודם לכן. אתה יכול גם להורדה הסכם הרישיון.

Custom_attributes המשמשים להעברת EULA הם זוגות מפתח/ערך. המפתח והערך מופרדים ב-= וזוגות מופרדים ב-;. אם המשתמש מעביר את אותו מפתח יותר מפעם אחת, הערך האחרון נשמר ומועבר למטפל הסקריפט (במקרה זה, משמש ללוגיקה מותנית). לדוגמה, אם accept_eula=false; accept_eula=true מועבר לשרת, אם כן accept_eula=true נשמר ומועבר למטפל הסקריפט.

פרמטרי הסקה שולטים בתהליך יצירת הטקסט בנקודת הקצה. בקרת האסימונים החדשים המקסימלית מתייחסת לגודל הפלט שנוצר על ידי המודל. שימו לב שזה לא זהה למספר המילים מכיוון שאוצר המילים של המודל אינו זהה לאוצר המילים בשפה האנגלית, וייתכן שכל אסימון אינו מילה בשפה האנגלית. הטמפרטורה שולטת באקראיות בפלט. טמפרטורה גבוהה יותר גורמת ליציאות יצירתיות והזויות יותר. כל פרמטרי ההסקה הם אופציונליים.

הטבלה הבאה מפרטת את כל דגמי Code Llama הזמינים ב- SageMaker JumpStart יחד עם מזהי המודל, סוגי מופעי ברירת המחדל והאסימונים הנתמכים המקסימליים (סכום של מספר אסימוני הקלט ומספר האסימונים שנוצרו עבור כל הבקשות במקביל) הנתמכים עבור כל אחת מהן. הדגמים הללו.

| שם דגם | מזהה דגם | סוג מופע ברירת מחדל | מקסימום אסימונים נתמכים |

| CodeLlama-7b | meta-textgeneration-llama-codellama-7b | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-Instruct | meta-textgeneration-llama-codellama-7b-instruct | ml.g5.2xlarge | 10000 |

| CodeLlama-7b-Python | meta-textgeneration-llama-codellama-7b-python | ml.g5.2xlarge | 10000 |

| CodeLlama-13b | meta-textgeneration-llama-codellama-13b | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-Instruct | meta-textgeneration-llama-codellama-13b-instruct | ml.g5.12xlarge | 32000 |

| CodeLlama-13b-Python | meta-textgeneration-llama-codellama-13b-python | ml.g5.12xlarge | 32000 |

| CodeLlama-34b | meta-textgeneration-llama-codellama-34b | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-Instruct | meta-textgeneration-llama-codellama-34b-instruct | ml.g5.48xlarge | 48000 |

| CodeLlama-34b-Python | meta-textgeneration-llama-codellama-34b-python | ml.g5.48xlarge | 48000 |

בעוד שדגמי Code Llama אומנו באורך הקשר של 16,000 אסימונים, הדגמים דיווחו על ביצועים טובים בחלונות הקשר גדולים אף יותר. העמודה המקסימלית הנתמכת בטבלה הקודמת היא הגבול העליון בחלון ההקשר הנתמך בסוג המופע המוגדר כברירת מחדל. מכיוון שמודל Code Llama 7B יכול לתמוך רק ב-10,000 אסימונים במופע ml.g5.2xlarge, אנו ממליצים לפרוס גרסת מודל 13B או 34B אם נדרשים הקשרים גדולים יותר עבור היישום שלך.

כברירת מחדל, כל הדגמים עובדים עבור משימות יצירת קוד. מודל הבסיס וההנחיות מגיבים שניהם למשימות מילוי, אם כי למודל הבסיס היה תפוקה איכותית יותר עבור רוב השאילתות לדוגמה. לבסוף, רק דגמי הוראה עובדים על משימות הוראה. הטבלה הבאה ממחישה לאילו דגמים ביצועים טובים (טובים) וביצועים מתונים (בינוניים) בשאילתות לדוגמה במחברות ההדגמה.

| . | יצירת קוד | מילוי קוד | הוראות קוד |

| CodeLlama-7b | טוב | טוב | N / A |

| CodeLlama-7b-Instruct | טוב | לְמַתֵן | טוב |

| CodeLlama-7b-Python | טוב | N / A | N / A |

| CodeLlama-13b | טוב | טוב | N / A |

| CodeLlama-13b-Instruct | טוב | לְמַתֵן | טוב |

| CodeLlama-13b-Python | טוב | N / A | N / A |

| CodeLlama-34b | טוב | N / A | N / A |

| CodeLlama-34b-Instruct | טוב | N / A | טוב |

| CodeLlama-34b-Python | טוב | N / A | N / A |

יצירת קוד

הדוגמאות הבאות הופעלו על מודל CodeLlama-34b-Instruct עם פרמטרי עומס "parameters": {"max_new_tokens": 256, "temperature": 0.2, "top_p": 0.9}:

מילוי קוד

מילוי קוד כרוך בהחזרת קוד שנוצר בהתחשב בהקשר הסובב. זה שונה ממשימת יצירת הקוד מכיוון שבנוסף לקטע קוד קידומת, המודל מסופק גם עם סיומת קטע קוד. נעשה שימוש באסימונים מיוחדים במהלך כוונון עדין כדי לסמן את תחילת הקידומת (<PRE>), תחילת הסיומת (<SUF>), ותחילת האמצע (<MID>). רצפי קלט למודל צריכים להיות באחד מהפורמטים הבאים:

- קידומת-סיומת-אמצע -

<PRE> {prefix} <SUF>{suffix} <MID> - סיומת-תחילית-אמצע -

<PRE> <SUF>{suffix} <MID> {prefix}

הדוגמאות הבאות משתמשות בפורמט קידומת-סיומת-אמצע במודל CodeLlama-7b עם מטען parameters {"max_new_tokens": 256, "temperature": 0.05, "top_p": 0.9}:

הוראות קוד

Meta סיפקה גם גרסה מכוונת להוראות של Code Lama. שאילתות לדוגמה בסעיף זה יכולות להיות מיושמות רק על דגמי Code Llama המכוונים להוראות, שהם הדגמים עם סיומת הוראות מזהה דגם. פורמט ה- Code Llama להוראות זהה לפורמט הנחיה של Llama-2-chat, אותו אנו מפרטים ב דגמי הבסיס של Llama 2 זמינים כעת ב- SageMaker JumpStart

בקשת משתמש פשוטה עשויה להיראות כך:

אתה יכול גם להוסיף בקשת מערכת עם התחביר הבא:

לבסוף, תוכל לקיים אינטראקציה שיחה עם המודל על ידי הכללת כל הנחיות המשתמש הקודמות ותגובות העוזר בקלט:

דוגמאות אלו הופעלו על מודל CodeLlama-13b-Instruct עם פרמטרי עומס "פרמטרים": {"max_new_tokens": 512, "temperature": 0.2, "top_p": 0.9}:

לנקות את

לאחר שתסיים להפעיל את המחברת, הקפד למחוק את כל המשאבים שיצרת בתהליך כדי שהחיוב שלך יופסק. השתמש בקוד הבא:

סיכום

בפוסט זה, הראינו לכם כיצד להתחיל עם מודלים של Code Llama ב-SageMaker Studio ולפרוס את המודל להפקת קוד ושפה טבעית לגבי קוד מהנחיות הן לקוד והן מהשפה הטבעית. מכיוון שדגמי היסודות הוכשרו מראש, הם יכולים לסייע בהורדת עלויות ההדרכה והתשתית ולאפשר התאמה אישית למקרה השימוש שלך. בקר עכשיו ב- SageMaker JumpStart ב- SageMaker Studio כדי להתחיל.

משאבים

על המחברים

גבריאל סינייב הוא מנהל מחקר בצוות Facebook AI Research (FAIR) ב-Meta. לפני מטה, גבריאל היה פוסט-דוקטורט בצוות של עמנואל דופו ב-École Normale Supérieure בפריז, ועבד על הנדסה לאחור של רכישת שפה אצל תינוקות. גבריאל קיבל את הדוקטורט שלו בדוגמנות בייסיאנית המיושמת למשחקי אסטרטגיה בזמן אמת בינה מלאכותית מאוניברסיטת גרנובל.

גבריאל סינייב הוא מנהל מחקר בצוות Facebook AI Research (FAIR) ב-Meta. לפני מטה, גבריאל היה פוסט-דוקטורט בצוות של עמנואל דופו ב-École Normale Supérieure בפריז, ועבד על הנדסה לאחור של רכישת שפה אצל תינוקות. גבריאל קיבל את הדוקטורט שלו בדוגמנות בייסיאנית המיושמת למשחקי אסטרטגיה בזמן אמת בינה מלאכותית מאוניברסיטת גרנובל.

עייסה ג'מיל הוא מהנדס שותפים RL, AI Generative ב- Meta.

עייסה ג'מיל הוא מהנדס שותפים RL, AI Generative ב- Meta.

ד"ר קייל אולריך הוא מדען יישומי בצוות אמזון SageMaker JumpStart. תחומי המחקר שלו כוללים אלגוריתמים של למידת מכונה ניתנים להרחבה, ראייה ממוחשבת, סדרות זמן, אי-פרמטריות בייסיאניות ותהליכי גאוס. הדוקטורט שלו הוא מאוניברסיטת דיוק והוא פרסם מאמרים ב-NeurIPS, Cell, and Neuron.

ד"ר קייל אולריך הוא מדען יישומי בצוות אמזון SageMaker JumpStart. תחומי המחקר שלו כוללים אלגוריתמים של למידת מכונה ניתנים להרחבה, ראייה ממוחשבת, סדרות זמן, אי-פרמטריות בייסיאניות ותהליכי גאוס. הדוקטורט שלו הוא מאוניברסיטת דיוק והוא פרסם מאמרים ב-NeurIPS, Cell, and Neuron.

ד"ר אשיש חתן הוא מדען יישומי בכיר עם Amazon SageMaker JumpStart ומסייע בפיתוח אלגוריתמים של למידת מכונה. הוא קיבל את הדוקטורט שלו מאוניברסיטת אילינוי אורבנה-שמפיין. הוא חוקר פעיל בלמידת מכונה והסקה סטטיסטית, ופרסם מאמרים רבים בכנסים NeurIPS, ICML, ICLR, JMLR, ACL ו-EMNLP.

ד"ר אשיש חתן הוא מדען יישומי בכיר עם Amazon SageMaker JumpStart ומסייע בפיתוח אלגוריתמים של למידת מכונה. הוא קיבל את הדוקטורט שלו מאוניברסיטת אילינוי אורבנה-שמפיין. הוא חוקר פעיל בלמידת מכונה והסקה סטטיסטית, ופרסם מאמרים רבים בכנסים NeurIPS, ICML, ICLR, JMLR, ACL ו-EMNLP.

ויווק סינג הוא מנהל מוצר עם SageMaker JumpStart. הוא מתמקד בלאפשר ללקוחות להיכנס ל-SageMaker JumpStart כדי לפשט ולהאיץ את מסע ה-ML שלהם לבניית יישומי AI Generative.

ויווק סינג הוא מנהל מוצר עם SageMaker JumpStart. הוא מתמקד בלאפשר ללקוחות להיכנס ל-SageMaker JumpStart כדי לפשט ולהאיץ את מסע ה-ML שלהם לבניית יישומי AI Generative.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/code-llama-code-generation-models-from-meta-are-now-available-via-amazon-sagemaker-jumpstart/

- :יש ל

- :הוא

- :לֹא

- :איפה

- ][עמ'

- $ למעלה

- 000

- 1

- 10

- 100

- 12

- 13

- 15%

- 16

- 24

- 28

- 30

- 36

- 500

- 7

- 700

- 8

- 9

- a

- אודות

- להאיץ

- לְקַבֵּל

- קביל

- גישה

- הודה

- רכישה

- פעיל

- להוסיף

- תוספת

- לאחר

- נגד

- הסכם

- AI

- ai מחקר

- אלגוריתמים

- תעשיות

- לאורך

- גם

- אמזון בעברית

- אמזון SageMaker

- אמזון SageMaker JumpStart

- אמזון שירותי אינטרנט

- an

- ו

- תשתיות

- להכריז

- תשובות

- כל

- בקשה

- יישומים

- יישומית

- מתאים

- ARE

- AS

- עוזר

- At

- אוטומטי

- זמין

- AWS

- בסיס

- מבוסס

- לחבוט

- בייסיאנית

- BE

- כי

- היה

- לפני

- להתחיל

- ההתחלה

- מוטב

- בֵּין

- חיוב

- B

- מיליארד אסימונים

- שניהם

- התמוטטות

- לִבנוֹת

- בִּניָן

- נבנה

- אבל

- by

- C + +

- CAN

- מסוגל

- כרטיס

- קרוסלה

- מקרה

- CD

- שינוי

- תווים

- ילדים

- בחרו

- בחירה

- בכיתה

- קליק

- קוד

- טור

- איך

- מגיע

- מסחרי

- המחשב

- ראייה ממוחשבת

- במקביל

- כנסים

- קונסול

- מכולה

- מכיל

- תוכן

- הקשר

- הקשרים

- לִשְׁלוֹט

- בקרות

- שיחה

- עלויות

- לכסות

- לִיצוֹר

- נוצר

- יְצִירָתִי

- נוֹכְחִי

- לקוחות

- התאמה אישית

- אישית

- נתונים

- אבטחת מידע

- ימים

- מוקדש

- בְּרִירַת מֶחדָל

- הדגמה

- לפרוס

- פרס

- פריסה

- פריסה

- פורס

- מעוצב

- פרט

- פרטים

- לפתח

- מפותח

- מפתחים

- צעצועי התפתחות

- הבדל

- אחר

- מְנַהֵל

- ספריות

- לגלות

- do

- עושה

- עשה

- הורדות

- דוכס

- אוניברסיטת דוכס

- בְּמַהֲלָך

- כל אחד

- מוקדם יותר

- מזרח

- יעיל

- לאפשר

- מה שמאפשר

- סוף

- מקצה לקצה

- נקודת קצה

- מהנדס

- מהונדס

- אנגלית

- לְהַבטִיחַ

- סביבה

- אירופה

- אֲפִילוּ

- דוגמה

- דוגמאות

- אלא

- נרגש

- לְמַעֵט

- מעריכי

- הארכה

- פייסבוק

- מפעל

- הוגן

- שקר

- תכונות

- בחור

- מעטים

- קבצים

- בסופו של דבר

- ראשון

- מתמקד

- בעקבות

- הבא

- בעד

- פוּרמָט

- קרן

- חופשי

- החל מ-

- פונקציה

- משחקים

- נוצר

- יצירת

- דור

- דורות

- גנרטטיבית

- AI Generative

- לקבל

- Git

- לתת

- נתן

- Go

- טוב

- קבל

- גדל

- הדרכה

- היה

- יד

- יש

- he

- לעזור

- עזרה

- עוזר

- כאן

- גָבוֹהַ

- גבוה יותר

- שֶׁלוֹ

- המארח

- איך

- איך

- HTML

- HTTPS

- טבור

- i

- ID

- אידאל

- מזהה

- if

- אילינוי

- מדגים

- לייבא

- לשפר

- שיפורים

- in

- לכלול

- כולל

- תשתית

- קלט

- תשומות

- להתקין

- התקנה

- למשל

- הוראות

- משולב

- אינטראקציה

- אינטרסים

- מִמְשָׁק

- אירלנד

- מְבוּדָד

- IT

- שֶׁלָה

- Java

- JavaScript

- מסע

- שמר

- מפתח

- מפתחות

- קייל

- נחיתה

- שפה

- גָדוֹל

- גדול יותר

- הגדול ביותר

- אחרון

- למידה

- עזבו

- אורך

- לתת

- רישיון

- כמו

- להגביל

- רשימה

- רשימות

- לאמה

- LLM

- מקומי

- הגיון

- נראה

- נראה כמו

- להוריד

- מכונה

- למידת מכונה

- עשוי

- הרוב

- לעשות

- עשייה

- מנהל

- מנהלים

- רב

- סימן

- מקסימום

- מאי..

- אומר

- מוּזְכָּר

- meta

- אמצע

- ML

- MLOps

- מודל

- דוגמנות

- מודלים

- שונים

- חוֹדֶשׁ

- יותר

- יותר יעיל

- צריך

- טבעי

- צורך

- רשת

- חדש

- צומת

- צמתים

- ללא חתימה

- מחברה

- עַכשָׁיו

- מספר

- of

- on

- על הסיפון

- פעם

- ONE

- רק

- or

- להזמין

- אורגון

- אחר

- הַחוּצָה

- תפוקה

- יותר

- חבילה

- עמוד

- זוגות

- ניירות

- פרמטרים

- פריז

- שותף

- לעבור

- עבר

- מעברי

- לְבַצֵעַ

- ביצועים

- דוקטורט

- PHP

- פינג

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- מדיניות

- הודעה

- פוטנציאל

- חיזוי

- העריכה

- קודם

- קודם

- תהליך

- תהליכים

- המוצר

- מנהל מוצר

- פִּריוֹן

- תכנות

- לספק

- ובלבד

- מספק

- לאור

- פיתון

- איכות

- שאילתות

- מהירות

- אקראי

- זמן אמת

- קיבלו

- להמליץ

- להתייחס

- מתייחס

- אזורים

- שוחרר

- להסיר

- הוסר

- דווח

- מאגר

- בקשות

- נדרש

- מחקר

- חוקר

- משאבים

- להגיב

- תגובות

- תוצאה

- תוצאות

- לַחֲזוֹר

- חוזר

- החזרות

- תקין

- שורש

- הפעלה

- ריצה

- s

- בעל חכמים

- אותו

- שמור

- להרחבה

- מַדְעָן

- תסריט

- Sdk

- חיפוש

- חיפוש

- שניות

- סעיף

- לבטח

- אבטחה

- קטע

- נבחר

- בחירה

- עצמי

- לחצני מצוקה לפנסיונרים

- סדרה

- שרת

- שירותים

- סט

- צריך

- לְהַצִיג

- הראה

- פָּשׁוּט

- לפשט

- since

- יחיד

- מידה

- גדל

- So

- תוכנה

- פתרונות

- מיוחד

- מיוחד

- ספציפי

- מפורט

- לפצל

- יציב

- התחלה

- החל

- מדינה-of-the-art

- סטטיסטי

- צעדים

- נעצר

- אִסטרָטֶגִיָה

- מחרוזת

- סטודיו

- בהצלחה

- כזה

- סכומים

- תמיכה

- נתמך

- בטוח

- הסובב

- תחביר

- מערכת

- שולחן

- המשימות

- משימות

- נבחרת

- אומר

- מונחים

- טֶקסט

- מֵאֲשֶׁר

- זֶה

- השמיים

- שֶׁלָהֶם

- אותם

- אז

- אלה

- הֵם

- זֶה

- אם כי?

- שְׁלוֹשָׁה

- דרך

- זמן

- סדרת זמן

- ל

- אסימון

- מטבעות

- כלים

- חלק עליון

- רכבת

- מְאוּמָן

- הדרכה

- עץ

- נָכוֹן

- לנסות

- שתיים

- סוג

- סוגים

- כתב כתיבה

- ui

- תחת

- הבנה

- אוניברסיטה

- us

- להשתמש

- במקרה להשתמש

- מְשׁוּמָשׁ

- משתמש

- באמצעות

- ערך

- ערכים

- גִרְסָה אַחֶרֶת

- מגוון

- גרסה

- באמצעות

- לצפיה

- וירג'יניה

- F-XNUMX

- חזון

- לְבַקֵר

- ביקר

- ללכת

- היה

- דֶרֶך..

- דרכים

- we

- אינטרנט

- שירותי אינטרנט

- המבוסס על האינטרנט

- היו

- מערב

- מה

- מה

- אשר

- רָחָב

- יצטרך

- חלון

- חלונות

- עם

- בתוך

- Word

- מילים

- תיק עבודות

- זרימות עבודה

- עובד

- לכתוב

- אתה

- זפירנט