דוחות רדיולוגיה הם מסמכים מקיפים וארוכים המתארים ומפרשים את תוצאות בדיקת הדמיה רדיולוגית. בזרימת עבודה טיפוסית, הרדיולוג מפקח, קורא ומפרש את התמונות, ולאחר מכן מסכם בתמציתיות את הממצאים העיקריים. הסיכום (או רושם) הוא החלק החשוב ביותר בדוח מכיוון שהוא עוזר לקלינאים ולמטופלים להתמקד בתכנים הקריטיים של הדוח המכילים מידע לקבלת החלטות קליניות. יצירת רושם ברור ומשפיע כרוכה בהרבה יותר מאמץ מאשר רק חידוש הממצאים. לכן התהליך כולו הוא מייגע, גוזל זמן ונוטה לטעות. לעתים קרובות זה לוקח שנים של הַדְרָכָה לרופאים לצבור מספיק מומחיות בכתיבת סיכומי דוחות רדיולוגיה תמציתיים ואינפורמטיביים, תוך הדגשה נוספת של המשמעות של אוטומציה של התהליך. בנוסף, יצירה אוטומטית של סיכום ממצאי דוחות הוא קריטי לדיווח רדיולוגי. הוא מאפשר תרגום דוחות לשפה קריא אנושית, ובכך מקל על נטל הקריאה של המטופלים באמצעות דוחות ארוכים ומעורפלים.

כדי לפתור בעיה זו, אנו מציעים שימוש בבינה מלאכותית גנרטיבית, סוג של בינה מלאכותית שיכולה ליצור תוכן ורעיונות חדשים, כולל שיחות, סיפורים, תמונות, סרטונים ומוזיקה. בינה מלאכותית גנרטיבית מופעלת על ידי מודלים של למידת מכונה (ML) - מודלים גדולים מאוד שהוכשרו מראש על כמויות עצומות של נתונים ומכונה בדרך כלל מודלים בסיסיים (FMs). ההתקדמות האחרונה ב-ML (במיוחד ההמצאה של ארכיטקטורת הרשת העצבית המבוססת על שנאים) הובילה לעליית מודלים המכילים מיליארדי פרמטרים או משתנים. הפתרון המוצע בפוסט זה משתמש בכוונון עדין של מודלים של שפה גדולה (LLMs) שהוכשרו מראש כדי לסייע ביצירת סיכומים המבוססים על ממצאים בדוחות רדיולוגיה.

פוסט זה מדגים אסטרטגיה לכוונון עדין של LLMs הזמינים לציבור עבור המשימה של סיכום דוחות רדיולוגיה באמצעות שירותי AWS. LLMs הפגינו יכולות יוצאות דופן בהבנת שפה טבעית וביצירת שפה טבעית, המשמשים כמודלי יסוד שניתן להתאים לתחומים ומשימות שונות. ישנם יתרונות משמעותיים לשימוש במודל מיומן מראש. זה מפחית את עלויות החישוב, מפחית טביעות פחמן, ומאפשר לך להשתמש בדגמים חדישים מבלי להכשיר אחד מאפס.

הפתרון שלנו משתמש ב- FLAN-T5 XL FM, באמצעות אמזון SageMaker JumpStart, שהוא מרכז ML המציע אלגוריתמים, מודלים ופתרונות ML. אנו מדגימים כיצד להשיג זאת באמצעות מחברת ב סטודיו SageMaker של אמזון. כוונון עדין של מודל מאומן מראש כרוך באימון נוסף על נתונים ספציפיים כדי לשפר ביצועים במשימה שונה אך קשורה. פתרון זה כולל כוונון עדין של דגם FLAN-T5 XL, שהוא גרסה משופרת של T5 (Text-to-Text Transfer Transformer) LLMs למטרות כלליות. T5 ממסגר מחדש משימות עיבוד שפה טבעית (NLP) לפורמט טקסט לטקסט מאוחד, בניגוד ל ברטמודלים בסגנון שיכולים להוציא רק תווית מחלקה או טווח של הקלט. הוא מותאם למשימת סיכום של 91,544 דוחות רדיולוגיה בטקסט חופשי שהתקבלו מה- מערך נתונים של MIMIC-CXR.

סקירה כללית של הפיתרון

בחלק זה, אנו דנים במרכיבי המפתח של הפתרון שלנו: בחירת האסטרטגיה למשימה, כוונון עדין של LLM והערכת התוצאות. אנו גם ממחישים את ארכיטקטורת הפתרון ואת השלבים ליישום הפתרון.

זהה את האסטרטגיה למשימה

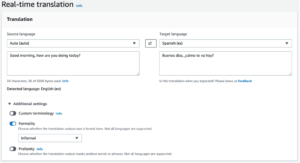

ישנן אסטרטגיות שונות לגשת למשימה של אוטומציה של סיכום דוחות קליניים. לדוגמה, נוכל להשתמש במודל שפה מיוחד שהוכשר מראש על דוחות קליניים מאפס. לחלופין, נוכל לכוונן ישירות מודל שפה לשימוש כללי זמין לציבור לביצוע המשימה הקלינית. ייתכן שיהיה צורך להשתמש במודל אגנוסטיק תחום מכוונן בהגדרות שבהן אימון א מודל שפה מאפס הוא יקר מדי. בפתרון זה, אנו מדגימים את הגישה האחרונה של שימוש במודל FLAN -T5 XL, אותו אנו מכווננים עבור המשימה הקלינית של סיכום דוחות רדיולוגיה. התרשים הבא ממחיש את זרימת העבודה של המודל.

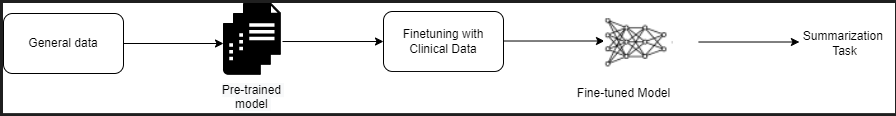

דוח רדיולוגיה טיפוסי מאורגן היטב ותמציתי. לדוחות כאלה יש לרוב שלושה חלקים מרכזיים:

- רקע - מספק מידע כללי על הדמוגרפיה של המטופל עם מידע חיוני על המטופל, היסטוריה קלינית, והיסטוריה רפואית רלוונטית ופרטים על נהלי הבדיקה

- ממצאים - מציג אבחון ותוצאות מפורטות של הבחינה

- הדפסה - מסכם בתמציתיות את הממצאים הבולטים ביותר או את הפרשנות של הממצאים עם הערכה של מובהקות ואבחנה פוטנציאלית על סמך החריגות שנצפו

באמצעות סעיף הממצאים בדוחות הרדיולוגיה, הפתרון מייצר את סעיף ההתרשמות, המתאים לסיכום הרופאים. האיור הבא הוא דוגמה לדוח רדיולוגיה.

כוונן LLM למטרות כלליות עבור משימה קלינית

בפתרון זה, אנו מכווננים דגם FLAN-T5 XL (כוונון כל הפרמטרים של הדגם ואופטימיזציה שלהם למשימה). אנו מכווננים את המודל באמצעות מערך הנתונים של התחום הקליני MIMIC-CXR, שהוא מערך נתונים זמין לציבור של צילומי חזה. כדי לכוונן מודל זה באמצעות SageMaker Jumpstart, יש לספק דוגמאות מסווגות בצורה של זוגות של {prompt, completion}. במקרה זה, אנו משתמשים בזוגות של {Findings, Impression} מהדוחות המקוריים במערך הנתונים של MIMIC-CXR. להסקת מסקנות, אנו משתמשים בהנחיה כפי שמוצג בדוגמה הבאה:

![]()

המודל מכוון עדין על מחשוב מואץ ml.p3.16xlarge מופע עם 64 מעבדים וירטואליים וזיכרון של 488 GiB. לצורך אימות, 5% ממערך הנתונים נבחרו באקראי. הזמן שחלף של עבודת האימון של SageMaker עם כוונון עדין היה 38,468 שניות (כ-11 שעות).

הערך את התוצאות

בסיום ההכשרה, חשוב להעריך את התוצאות. לניתוח כמותי של הרושם שנוצר, אנו משתמשים אדום (Recall-Oriented Understudy for Gisting Evaluation), המדד הנפוץ ביותר להערכת סיכום. מדד זה משווה סיכום שהופק אוטומטית מול הפניה או קבוצה של הפניות (מייצור אנושי) סיכום או תרגום. ROUGE1 מתייחס לחפיפה של אוניגרמים (כל מילה) בין המועמד (תפוקת המודל) לסיכומי הפניה. ROUGE2 מתייחס לחפיפה של ביגרמות (שתי מילים) בין המועמד לסיכומי הפניה. ROUGEL הוא מדד ברמת המשפט ומתייחס לרצף המשנה המשותף הארוך ביותר (LCS) בין שני קטעי טקסט. הוא מתעלם משורות חדשות בטקסט. ROUGELsum הוא מדד ברמת סיכום. עבור מדד זה, קווים חדשים בטקסט אינם מתעלמים אלא מתפרשים כגבולות משפטים. לאחר מכן מחשבים את ה-LCS בין כל צמד משפטי עזר ומשפטים מועמדים, ולאחר מכן מחושב איחוד-LCS. עבור צבירה של ציונים אלה על קבוצה נתונה של משפטי התייחסות ומועמדים, הממוצע מחושב.

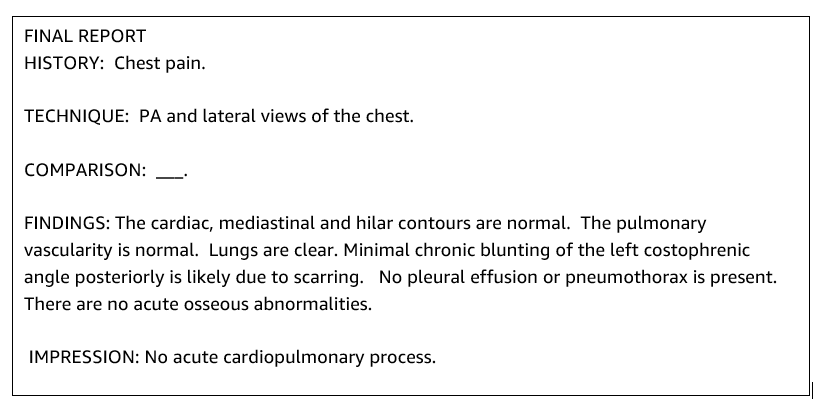

הדרכה ואדריכלות

ארכיטקטורת הפתרון הכוללת כפי שמוצג באיור הבא מורכבת בעיקר מסביבת פיתוח מודלים המשתמשת ב-SageMaker Studio, פריסת מודל עם נקודת קצה של SageMaker ולוח מחוונים לדיווח באמצעות אמזון קוויקסייט.

בסעיפים הבאים, אנו מדגימים כוונון עדין של LLM זמין ב- SageMaker JumpStart לסיכום של משימה ספציפית לתחום באמצעות SageMaker Python SDK. בפרט, אנו דנים בנושאים הבאים:

- שלבים להגדרת סביבת הפיתוח

- סקירה כללית של מערכי הנתונים של דוחות הרדיולוגיה שעל פיהם המודל מכוונן ומוערך

- הדגמה של כוונון עדין של דגם FLAN-T5 XL באמצעות SageMaker JumpStart באופן תכנותי עם SageMaker Python SDK

- הסקת מסקנות והערכה של המודלים שהוכשרו מראש ומכווננים היטב

- השוואה בין תוצאות ממודלים שעברו הכשרה מראש ודגמים מכוונים

הפתרון זמין ב הפקת התרשמות דוח רדיולוגיה באמצעות AI גנראטיבי עם מודל שפה גדול ב-AWS GitHub ריפו.

תנאים מוקדמים

כדי להתחיל, אתה צריך חשבון AWS שבו אתה יכול להשתמש ב- SageMaker Studio. תצטרך ליצור פרופיל משתמש עבור SageMaker Studio אם עדיין אין לך כזה.

סוג מופע האימון המשמש בפוסט זה הוא ml.p3.16xlarge. שים לב שסוג המופע p3 דורש הגדלת מכסת שירות.

השמיים מערך נתונים של MIMIC CXR ניתן לגשת באמצעות הסכם שימוש בנתונים, המחייב רישום משתמש והשלמת תהליך אישור.

הגדר את סביבת הפיתוח

כדי להגדיר את סביבת הפיתוח שלך, אתה יוצר דלי S3, תגדיר מחברת, יוצר נקודות קצה ופריסה את המודלים ויוצר לוח מחוונים של QuickSight.

צור דלי S3

צור דלי S3 נקרא llm-radiology-bucket לארח את מערכי ההדרכה וההערכה. זה ישמש גם לאחסון חפץ המודל במהלך פיתוח המודל.

הגדר מחברת

בצע את הצעדים הבאים:

- הפעל את SageMaker Studio מקונסולת SageMaker או מה- ממשק שורת הפקודה של AWS (AWS CLI).

למידע נוסף על כניסה לדומיין, ראה נכלל ב-Amazon SageMaker Domain.

- ליצור חדש מחברת SageMaker Studio לניקוי נתוני הדוח וכיוונון עדין של המודל. אנו משתמשים במופע מחברת ml.t3.medium 2vCPU+4GiB עם ליבת Python 3.

- בתוך המחברת, התקן את החבילות הרלוונטיות כגון

nest-asyncio,IPyWidgets(עבור ווידג'טים אינטראקטיביים עבור מחברת Jupyter), ו-SageMaker Python SDK:

להסקת הדגמים שעברו הכשרה מוקדמת ומכווננת עדינה, ליצור נקודת קצה ולפרוס כל מודל במחברת באופן הבא:

- צור אובייקט מודל ממחלקת Model שניתן לפרוס לנקודת קצה HTTPS.

- צור נקודת קצה HTTPS עם אובייקט הדגם המובנה מראש

deploy()שיטה:

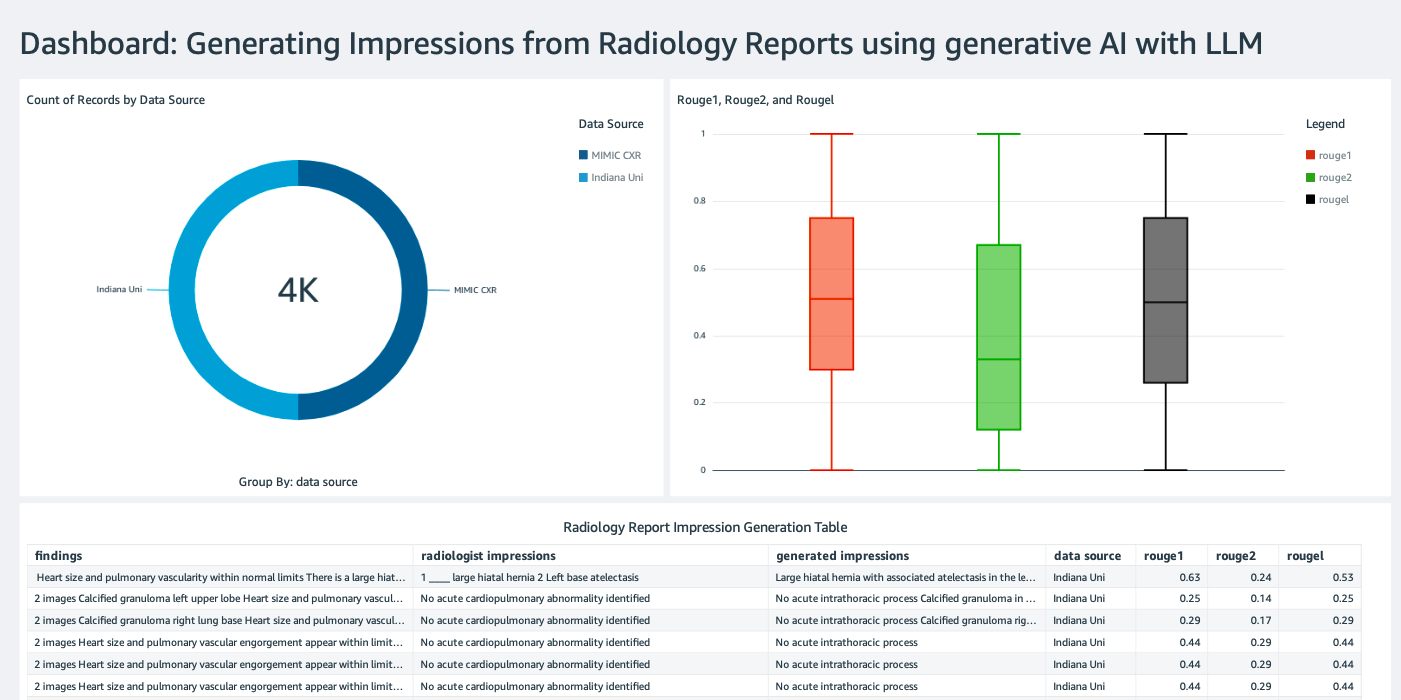

צור לוח מחוונים של QuickSight

צור לוח מחוונים של QuickSight עם מקור נתונים של Athena עם תוצאות מסקנות ב שירות אחסון פשוט של אמזון (Amazon S3) כדי להשוות את תוצאות ההסקה עם האמת הבסיסית. צילום המסך הבא מציג את לוח המחוונים לדוגמה שלנו.

מערכי נתונים של דוחות רדיולוגיה

הדגם מכוון כעת, כל הפרמטרים של הדגם מכוונים לפי 91,544 דוחות שהורדו מה- מערך נתונים של MIMIC-CXR v2.0. מכיוון שהשתמשנו רק בנתוני הטקסט של דוח הרדיולוגיה, הורדנו רק קובץ דוח דחוס אחד (mimic-cxr-reports.zip) מאתר MIMIC-CXR. כעת אנו מעריכים את המודל המכוונן לפי 2,000 דוחות (המכונה dev1 מערך הנתונים) מהנפרד החזיק קבוצת משנה של מערך נתונים זה. אנו משתמשים בעוד 2,000 דוחות רדיולוגיה (המכונה dev2) להערכת הדגם המכוונן מאוסף רנטגן החזה מבית רשת בתי החולים של אוניברסיטת אינדיאנה. כל מערכי הנתונים נקראים כקובצי JSON ומועלים לדלי S3 החדש שנוצר llm-radiology-bucket. שים לב שכל מערכי הנתונים כברירת מחדל אינם מכילים מידע בריאותי מוגן (PHI); כל המידע הרגיש מוחלף בשלושה קווים תחתונים עוקבים (___) על ידי הספקים.

כוונן עם SageMaker Python SDK

עבור כוונון עדין, ה model_id מוגדר כ- huggingface-text2text-flan-t5-xl מרשימת דגמי SageMaker JumpStart. ה training_instance_type מוגדר כ-ml.p3.16xlarge וה- inference_instance_type כמו ml.g5.2xlarge. נתוני האימון בפורמט JSON נקראים מדלי S3. השלב הבא הוא להשתמש ב-model_id שנבחר כדי לחלץ את URIs המשאבים של SageMaker JumpStart, כולל image_uri ( מרשם מיכל אלסטי של אמזון (Amazon ECR) URI עבור תמונת Docker), model_uri (חפץ הדגם המאומן מראש Amazon S3 URI), ו script_uri (תסריט ההדרכה):

כמו כן, מיקום פלט מוגדר כתיקיה בתוך דלי S3.

רק היפרפרמטר אחד, עידנים, משתנה ל-3, והשאר כולם מוגדרים כברירת מחדל:

מדדי האימון כגון eval_loss (עבור אובדן אימות), loss (עבור אובדן אימונים), ו epoch למעקב מוגדרים ומפורטים:

אנו משתמשים ב-URI של משאב JumpStart של SageMaker (image_uri, model_uri, script_uri) זוהה קודם לכן כדי ליצור מעריך ולכוונן אותו במערך ההדרכה על ידי ציון הנתיב S3 של מערך הנתונים. כיתת האומד דורשת entry_point פָּרָמֶטֶר. במקרה זה, JumpStart משתמש transfer_learning.py. עבודת ההדרכה לא מצליחה לפעול אם ערך זה לא מוגדר.

עבודת הכשרה זו עשויה להימשך שעות; לכן, מומלץ להגדיר את פרמטר ההמתנה ל-False ולנטר את מצב עבודת ההדרכה במסוף SageMaker. להשתמש ב TrainingJobAnalytics פונקציה לעקוב אחר מדדי האימון בחותמות זמן שונות:

פרוס נקודות קצה של מסקנות

על מנת לערוך השוואות, אנו פורסים נקודות קצה של מסקנות הן עבור המודלים שהוכשרו מראש והן עבור המודלים המכוונים היטב.

ראשית, אחזר את ה-URI של תמונת ההסקה של Docker באמצעות model_id, והשתמש ב-URI זה כדי ליצור מופע מודל SageMaker של המודל שהוכשר מראש. פרוס את המודל שהוכשר מראש על ידי יצירת נקודת קצה HTTPS עם אובייקט המודל שנבנה מראש deploy() שיטה. על מנת להפעיל מסקנות דרך SageMaker API, הקפידו לעבור את מחלקת Predictor.

חזור על השלב הקודם כדי ליצור מופע מודל SageMaker של המודל המכוונן וליצור נקודת קצה לפריסת המודל.

העריכו את המודלים

ראשית, הגדר את אורך הטקסט המסוכם, מספר פלטי המודל (צריך להיות גדול מ-1 אם יש צורך ליצור סיכומים מרובים), ומספר האלומות עבור חיפוש קרן.

בנה את בקשת ההסקה כמטען של JSON והשתמש בה כדי לשאול את נקודות הקצה עבור המודלים שהוכשרו מראש ומכווננים.

מחשב את המצטבר ציוני ROUGE (ROUGE1, ROUGE2, ROUGEL, ROUGELsum) כפי שתואר קודם לכן.

השוו את התוצאות

הטבלה הבאה מתארת את תוצאות ההערכה עבור dev1 ו dev2 מערכי נתונים. תוצאת ההערכה על dev1 (2,000 ממצאים מדוח הרדיולוגיה של MIMIC CXR) מראים שיפור של כ-38 נקודות אחוז בממוצע המצטבר ROUGE1 ו- ROUGE2 ציונים בהשוואה למודל שהוכשר מראש. עבור dev2, נצפה שיפור של 31 נקודות אחוז ו-25 נקודות אחוז בציוני ROUGE1 ו- ROUGE2. בסך הכל, כוונון עדין הוביל לשיפור של 38.2 נקודות אחוז ו-31.3 נקודות אחוז בציוני ROUGELsum עבור dev1 ו dev2 מערכי נתונים, בהתאמה.

|

הערכה מערך נתונים |

מודל שהוכשר מראש | דגם מכוון | ||||||

| ROUGE1 | ROUGE2 | רוגל | ROUGELsum | ROUGE1 | ROUGE2 | רוגל | ROUGELsum | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

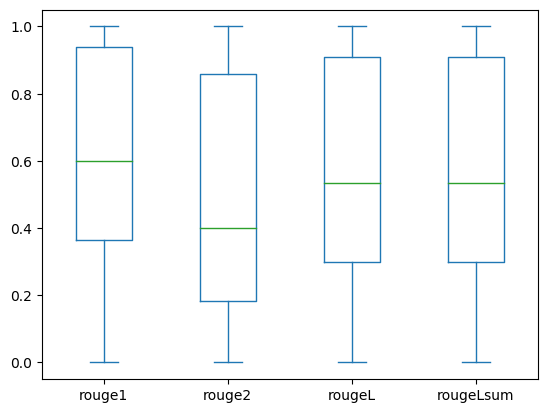

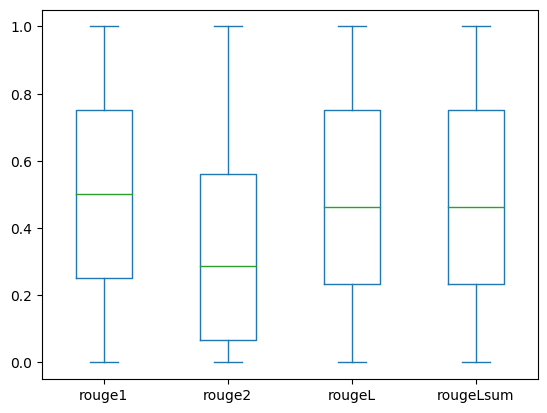

עלילות התיבה הבאות מתארות את התפלגות ציוני ROUGE עבור dev1 ו dev2 מערכי נתונים שהוערכו באמצעות המודל המכוונן.

|

|

(א): dev1 |

(ב): dev2 |

הטבלה הבאה מראה שלציוני ROUGE עבור מערכי הנתונים של ההערכה יש בערך אותו חציון וממוצע, ולכן הם מופצים באופן סימטרי.

| מערכי נתונים | מבנה הפרטיטורה | לִסְפּוֹר | ממוצע | סטיית תקן | מינימום | אחוזון של 25%. | אחוזון של 50%. | אחוזון של 75%. | מַקסִימוּם |

dev1 |

ROUGE1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsum | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROUGE 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

לנקות את

כדי להימנע מחיובים עתידיים, מחק את המשאבים שיצרת עם הקוד הבא:

סיכום

בפוסט זה, הדגמנו כיצד לכוונן מודל FLAN-T5 XL עבור משימת סיכום ספציפית לתחום קליני באמצעות SageMaker Studio. כדי להגביר את הביטחון, השווינו את התחזיות עם האמת הבסיסית והערכנו את התוצאות באמצעות מדדי ROUGE. הדגמנו כי מודל המכוון למשימה ספציפית מחזיר תוצאות טובות יותר מאשר מודל שהוכשר מראש במשימת NLP גנרית. ברצוננו לציין שכוונון עדין של LLM למטרות כלליות מבטל את עלות ההכשרה המוקדמת לחלוטין.

למרות שהעבודה המוצגת כאן מתמקדת בדוחות רנטגן של החזה, יש לה פוטנציאל להתרחב למערכי נתונים גדולים יותר עם אנטומיות ושיטות מגוונות, כגון MRI ו-CT, שעבורם דוחות רדיולוגיה עשויים להיות מורכבים יותר עם ממצאים מרובים. במקרים כאלה, רדיולוגים יכולים ליצור רשמים לפי סדר קריטיות ולכלול המלצות מעקב. יתר על כן, הגדרת לולאת משוב עבור יישום זה תאפשר לרדיולוגים לשפר את ביצועי המודל לאורך זמן.

כפי שהראינו בפוסט זה, המודל המכוונן יוצר הופעות עבור דוחות רדיולוגיה עם ציוני ROUGE גבוהים. אתה יכול לנסות לכוונן LLMs על דוחות רפואיים אחרים ספציפיים לתחום ממחלקות שונות.

על המחברים

ד"ר אדוואלה אקינפדרין הוא מדען נתונים בכיר במדעי הבריאות והחיים ב-AWS. המומחיות שלו היא בשיטות AI/ML הניתנות לשחזור ומקצה לקצה, יישומים מעשיים, וסיוע ללקוחות שירותי בריאות גלובליים לגבש ולפתח פתרונות ניתנים להרחבה לבעיות בינתחומיות. יש לו שני תארים מתקדמים בפיזיקה ותואר דוקטור בהנדסה.

ד"ר אדוואלה אקינפדרין הוא מדען נתונים בכיר במדעי הבריאות והחיים ב-AWS. המומחיות שלו היא בשיטות AI/ML הניתנות לשחזור ומקצה לקצה, יישומים מעשיים, וסיוע ללקוחות שירותי בריאות גלובליים לגבש ולפתח פתרונות ניתנים להרחבה לבעיות בינתחומיות. יש לו שני תארים מתקדמים בפיזיקה ותואר דוקטור בהנדסה.

פרייה פאדטה הוא אדריכל פתרונות שותפים בכיר עם מומחיות נרחבת בתחומי הבריאות ומדעי החיים ב-AWS. Priya מניעה אסטרטגיות יציאה לשוק עם שותפים ומניעה פיתוח פתרונות להאצת פיתוח מבוסס AI/ML. היא נלהבת מהשימוש בטכנולוגיה כדי לשנות את תעשיית הבריאות כדי להביא לתוצאות טובות יותר של טיפול בחולים.

פרייה פאדטה הוא אדריכל פתרונות שותפים בכיר עם מומחיות נרחבת בתחומי הבריאות ומדעי החיים ב-AWS. Priya מניעה אסטרטגיות יציאה לשוק עם שותפים ומניעה פיתוח פתרונות להאצת פיתוח מבוסס AI/ML. היא נלהבת מהשימוש בטכנולוגיה כדי לשנות את תעשיית הבריאות כדי להביא לתוצאות טובות יותר של טיפול בחולים.

אקטה וואליה בהולאר, PhD, הוא יועץ בכיר בינה מלאכותית/ML ביחידה העסקית של שירותי בריאות ומדעי החיים של AWS (HCLS). יש לה ניסיון רב ביישום AI/ML בתחום הבריאות, במיוחד ברדיולוגיה. מחוץ לעבודה, כשהיא לא דנה בבינה מלאכותית ברדיולוגיה, היא אוהבת לרוץ ולטייל.

אקטה וואליה בהולאר, PhD, הוא יועץ בכיר בינה מלאכותית/ML ביחידה העסקית של שירותי בריאות ומדעי החיים של AWS (HCLS). יש לה ניסיון רב ביישום AI/ML בתחום הבריאות, במיוחד ברדיולוגיה. מחוץ לעבודה, כשהיא לא דנה בבינה מלאכותית ברדיולוגיה, היא אוהבת לרוץ ולטייל.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. רכב / רכבים חשמליים, פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- ChartPrime. הרם את משחק המסחר שלך עם ChartPrime. גישה כאן.

- BlockOffsets. מודרניזציה של בעלות על קיזוז סביבתי. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- יכול

- אודות

- להאיץ

- מוּאָץ

- נצפה

- להשיג

- לצבור

- בנוסף

- התקדמות

- נגד

- - צבירה

- הסכם

- AI

- AI / ML

- אלגוריתמים

- תעשיות

- מאפשר

- כְּבָר

- גם

- בסך הכל

- אמזון בעברית

- אמזון SageMaker

- אמזון שירותי אינטרנט

- כמויות

- an

- אנליזה

- ו

- אחר

- כל

- API

- בקשה

- גישה

- בערך

- ארכיטקטורה

- ARE

- טענה

- AS

- הערכה

- At

- מכני עם סלילה אוטומטית

- באופן אוטומטי

- אוטומציה

- זמין

- מְמוּצָע

- לְהִמָנַע

- AWS

- בסיס

- מבוסס

- BE

- כי

- לפני

- להיות

- הטבות

- מוטב

- בֵּין

- גדול

- מיליארדים

- שניהם

- גבולות

- אריזה מקורית

- ניטל

- עסקים

- אבל

- by

- נקרא

- CAN

- מועמד

- יכולות

- פַּחמָן

- אשר

- מקרה

- מקרים

- השתנה

- חיובים

- בחירה

- בכיתה

- ניקוי

- ברור

- קליני

- קלינאים

- קוד

- אוסף

- Common

- בדרך כלל

- לְהַשְׁווֹת

- לעומת

- להשלים

- השלמה

- מורכב

- רכיבים

- מַקִיף

- חישוב

- מחשוב

- תמציתית

- אמון

- רצופים

- מורכב

- קונסול

- יועץ

- להכיל

- מכולה

- תוכן

- תוכן

- לעומת זאת

- שיחות

- מתכתב

- עלות

- יקר

- עלויות

- יכול

- זוג

- לִיצוֹר

- נוצר

- יוצרים

- קריטי

- ביקורתיות

- מנהג

- לקוחות

- לוח מחוונים

- נתונים

- מדען נתונים

- מערכי נתונים

- קבלת החלטות

- בְּרִירַת מֶחדָל

- מוגדר

- תואר

- דמוגרפיה

- להפגין

- מופגן

- מדגים

- מחלקות

- לפרוס

- פרס

- פריסה

- לתאר

- מְתוּאָר

- מְפוֹרָט

- פרטים

- לפתח

- צעצועי התפתחות

- אחר

- ישירות

- לדון

- דנים

- מופץ

- הפצה

- סַוָר

- רופאים

- מסמכים

- תחום

- תחומים

- לא

- לצייר

- נהיגה

- כוננים

- בְּמַהֲלָך

- כל אחד

- מוקדם יותר

- מאמץ

- או

- מבטל

- אחר

- לאפשר

- מאפשר

- מקצה לקצה

- נקודת קצה

- הנדסה

- משופר

- מספיק

- שלם

- סביבה

- תקופה

- תקופות

- שגיאה

- במיוחד

- חיוני

- להעריך

- העריך

- הערכה

- הערכה

- בחינה

- דוגמה

- דוגמאות

- לבצע

- מורחב

- ניסיון

- מומחיות

- נרחב

- ניסיון רב

- תמצית

- נכשל

- שקר

- מָשׁוֹב

- תרשים

- שלח

- קבצים

- ממצאים

- להתמקד

- מתמקד

- הבא

- כדלקמן

- בעד

- טופס

- פוּרמָט

- קרן

- החל מ-

- פונקציה

- נוסף

- יתר על כן

- עתיד

- כללי

- מטרה כללית

- ליצור

- נוצר

- מייצר

- דור

- גנרטטיבית

- AI Generative

- לקבל

- נתן

- גלוֹבָּלִי

- ללכת לשוק

- בוגר

- יותר

- קרקע

- יש

- יש

- he

- בְּרִיאוּת

- מידע בריא

- בריאות

- תעשיית הבריאות

- לעזור

- עזרה

- עוזר

- כאן

- גָבוֹהַ

- הדגשה

- טיול

- שֶׁלוֹ

- היסטוריה

- המארח

- שעות

- איך

- איך

- HTML

- http

- HTTPS

- טבור

- חיבוק פנים

- בן אנוש

- ID

- רעיונות

- מזוהה

- if

- מדגים

- תמונה

- תמונות

- הדמיה

- בר - השפעה

- ליישם

- יישומים

- לייבא

- חשוב

- לשפר

- השבחה

- in

- לכלול

- כולל

- להגדיל

- תעשייה

- מידע

- אִינפוֹרמָטִיבִי

- קלט

- להתקין

- למשל

- אינטראקטיבי

- פענוח

- אל תוך

- הַמצָאָה

- IT

- עבודה

- מקומות תעסוקה

- ג'סון

- רק

- רק אחד

- שמור

- מפתח

- תווית

- שפה

- גָדוֹל

- לשגר

- למידה

- הוביל

- אורך

- החיים

- מדעי חיים

- כמו

- אוהב

- להגביל

- קו

- רשימה

- ברשימה

- LLM

- ממוקם

- מיקום

- את

- מכונה

- למידת מכונה

- לעשות

- מאי..

- אומר

- רפואי

- בינוני

- זכרון

- שיטה

- שיטות

- מטרי

- מדדים

- יכול

- דקות

- ML

- מודל

- מודלים

- צג

- יותר

- רוב

- MRI

- הרבה

- מספר

- כלי נגינה

- צריך

- שם

- טבעי

- עיבוד שפה טבעית

- הכרחי

- צורך

- רשת

- רשת עצבית

- חדש

- חדש

- הבא

- NLP

- מחברה

- עַכשָׁיו

- מספר

- אובייקט

- מושג

- of

- הצעה

- לעתים קרובות

- on

- Onboarding

- ONE

- רק

- מיטוב

- or

- להזמין

- מְקוֹרִי

- אחר

- שלנו

- הַחוּצָה

- תוצאות

- תפוקה

- בחוץ

- יותר

- מקיף

- לעקוף

- סקירה

- חבילות

- זוג

- זוגות

- פרמטר

- פרמטרים

- חלק

- מסוים

- שותף

- שותפים

- לעבור

- לוהט

- נתיב

- חולה

- חולים

- אחוזים

- לְבַצֵעַ

- ביצועים

- דוקטורט

- פיסיקה

- חתיכות

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- נקודה

- נקודות

- הודעה

- פוטנציאל

- מופעל

- מעשי

- התחזיות

- חיזוי

- מוצג

- מתנות

- בראש ובראשונה

- בעיה

- בעיות

- תהליך

- תהליך

- מיוצר

- מקצועי

- פּרוֹפִיל

- להציע

- מוּצָע

- מוּגָן

- ובלבד

- ספקים

- מספק

- בפומבי

- פיתון

- כמותי

- חומר עיוני

- קריאה

- לאחרונה

- המלצות

- מוּמלָץ

- מפחית

- אזכור

- מכונה

- מתייחס

- regex

- הַרשָׁמָה

- קָשׁוּר

- רלוונטי

- ראוי לציון

- החליף

- לדווח

- דווח

- דוחות לדוגמא

- לבקש

- נדרש

- דורש

- משאב

- משאבים

- בהתאמה

- REST

- תוצאה

- תוצאות

- החזרות

- לעלות

- הפעלה

- ריצה

- בעל חכמים

- אותו

- להרחבה

- מדעים

- מַדְעָן

- לגרד

- Sdk

- חיפוש

- שניות

- סעיף

- סעיפים

- לִרְאוֹת

- נבחר

- לחצני מצוקה לפנסיונרים

- רגיש

- משפט

- נפרד

- שרות

- שירותים

- הגשה

- סט

- הצבה

- הגדרות

- היא

- צריך

- הראה

- הראה

- הופעות

- משמעות

- משמעותי

- פָּשׁוּט

- בפשטות

- קטן

- So

- פִּתָרוֹן

- פתרונות

- לפתור

- כמה

- משך

- מיוחד

- ספציפי

- במיוחד

- מפורט

- התחלה

- החל

- מדינה-of-the-art

- מצב

- שלב

- צעדים

- עוד

- אחסון

- חנות

- סיפורים

- אסטרטגיות

- אִסטרָטֶגִיָה

- סטודיו

- כזה

- סיכום

- בטוח

- שולחן

- לקחת

- לוקח

- המשימות

- משימות

- טכנולוגיה

- מֵאֲשֶׁר

- זֶה

- השמיים

- אותם

- אז

- שם.

- בכך

- לכן

- אלה

- זֶה

- אלה

- שְׁלוֹשָׁה

- דרך

- זמן

- ל

- גַם

- נושאים

- לעקוב

- רכבת

- הדרכה

- להעביר

- לשנות

- שנאי

- תרגום

- אמת

- לנסות

- שתיים

- סוג

- טיפוסי

- קו תחתון

- הבנה

- מאוחד

- יחידה

- אוניברסיטה

- נטען

- להשתמש

- מְשׁוּמָשׁ

- משתמש

- שימושים

- באמצעות

- אימות

- ערך

- ערכים

- שונים

- Vast

- גרסה

- באמצעות

- וידאו

- וירטואלי

- לחכות

- היה

- we

- אינטרנט

- שירותי אינטרנט

- אתר

- מתי

- אשר

- בזמן

- רוחב

- יצטרך

- עם

- בתוך

- לְלֹא

- Word

- מילים

- תיק עבודות

- זרימת עבודה

- היה

- כתיבה

- רנטגן

- שנים

- אתה

- זפירנט