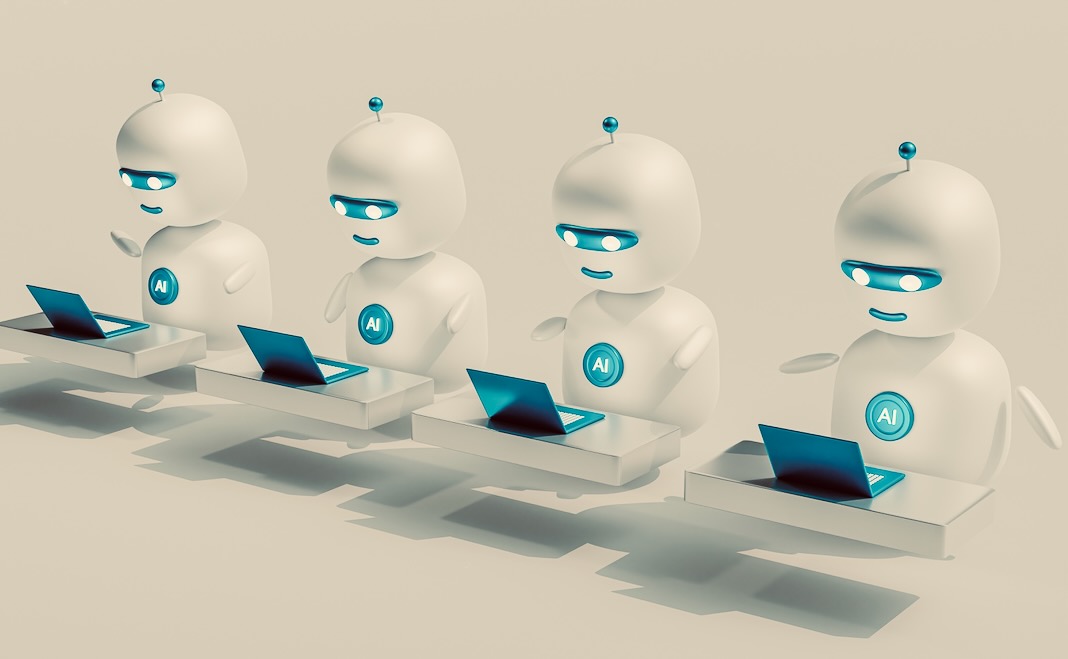

AI מתפתח במהירות. ChatGPT הפך להיות השירות המקוון הצומח ביותר בהיסטוריה. גוגל ומיקרוסופט משלבות AI גנרטיבי במוצרים שלהן. ומנהיגי העולם מאמצים בהתרגשות את AI ככלי לצמיחה כלכלית.

ככל שאנו עוברים מעבר ל-ChatGPT ול-Bard, אנו צפויים לראות צ'טבוטים של AI הופכים פחות גנריים ויותר מיוחדים. AI מוגבלים על ידי הנתונים שהם נחשפים אליהם כדי לשפר אותם במה שהם עושים - במקרה זה, חיקוי דיבור אנושי ומספקים למשתמשים תשובות שימושיות.

אימון לרוב מטיל את הרשת לרחבה, עם מערכות AI הקולטות אלפי ספרים ודפי אינטרנט. אבל קבוצה מובחרת וממוקדת יותר של נתוני הכשרה יכולה להפוך את צ'טבוטי הבינה המלאכותית לשימושי עוד יותר עבור אנשים העובדים בתעשיות מסוימות או המתגוררים באזורים מסוימים.

ערך הנתונים

גורם חשוב באבולוציה זו יהיה העלויות הגדלות של איסוף נתוני אימון עבור מודלים מתקדמים של שפות גדולות (LLMs), סוג הבינה המלאכותית שמניעה את ChatGPT. חברות יודעות שלנתונים יש ערך: Meta וגוגל מרוויחות מיליארדים ממכירת פרסומות הממוקדות בנתוני משתמשים. אבל הערך של הנתונים הוא עכשיו משתנה. Meta ו-Google מוכרות נתונים "תובנות"; הם משקיעים בניתוח כדי להפוך נקודות נתונים רבות לתחזיות לגבי משתמשים.

נתונים הם בעלי ערך ל-OpenAI - המפתחת של ChatGPT - בצורה שונה בתכלית. דמיינו לעצמכם ציוץ: "החתול ישב על המחצלת." ציוץ זה אינו בעל ערך עבור מפרסמים ממוקדים. זה אומר מעט על משתמש או על תחומי העניין שלו. אולי, בדחיפה, זה יכול לרמוז על עניין באוכל לחתולים ובד"ר סואס.

אבל עבור OpenAI, שבונה LLMs כדי לייצר שפה דמוית אדם, הציוץ הזה הוא בעל ערך כדוגמה לאופן שבו השפה האנושית פועלת. ציוץ בודד לא יכול ללמד AI לבנות משפטים, אבל מיליארדי ציוצים, פוסטים בבלוג, ערכים בוויקיפדיה וכן הלאה, בהחלט יכולים. לדוגמה, ה-LLM GPT-4 המתקדם כנראה נבנה באמצעות נתונים שנגרדו מ-X (לשעבר טוויטר), Reddit, ויקיפדיה ומעבר לכך.

מהפכת הבינה המלאכותית משנה את המודל העסקי עבור ארגונים עתירי נתונים. חברות כמו Meta וגוגל היו השקעה במחקר ופיתוח בינה מלאכותית במשך כמה שנים כשהם מנסים לנצל את משאבי הנתונים שלהם.

ארגונים כמו X ו reddit החלו לחייב צדדים שלישיים עבור גישה ל-API, המערכת המשמשת לגירוד נתונים מאתרים אלה. גירוד נתונים עולה לחברות כמו X כסף, כפי שהם חייב להוציא יותר על כוח מחשוב כדי למלא שאילתות נתונים.

בהמשך, כאשר ארגונים כמו OpenAI מחפשים לבנות גרסאות חזקות יותר של דגמי ה-GPT שלה, הם יתמודדו עם עלויות גבוהות יותר עבור רכישת נתונים. פתרון אחד לבעיה זו עשוי להיות נתונים סינתטיים.

הולך סינתטי

נתונים סינתטיים הם נוצר מאפס על ידי מערכות בינה מלאכותית להכשיר מערכות בינה מלאכותיות מתקדמות יותר - כך שהן ישתפרו. הם מתוכננים לבצע את אותה משימה כמו נתוני אימון אמיתיים אך נוצרים על ידי AI.

זה רעיון חדש, אבל הוא מתמודד עם הרבה בעיות. נתונים סינתטיים טובים צריכים להיות שונה מספיק מהנתונים המקוריים הוא מבוסס על כדי לספר לדגם משהו חדש, בעוד שהוא דומה מספיק כדי לספר לו משהו מדויק. זה יכול להיות קשה להשגה. איפה נתונים סינתטיים רק עותקים משכנעים של נתונים מהעולם האמיתי, מודלים של AI המתקבלים עשויים להיאבק ביצירתיות, ולבצר הטיות קיימות.

בעיה נוספת היא ה בעיית "הפסבורג AI".. זה מצביע על כך שאימון בינה מלאכותית על נתונים סינתטיים יגרום לירידה באפקטיביות של מערכות אלו - ומכאן האנלוגיה באמצעות ההתרבות הידועה לשמצה של משפחת המלוכה ההבסבורגית. כמה מחקרים מציע שזה כבר קורה עם מערכות כמו ChatGPT.

אחת הסיבות ש-ChatGPT כל כך טוב היא בגלל שהוא משתמש למידת חיזוק עם משוב אנושי (RLHF), שם אנשים מדרגים את התפוקות שלו במונחים של דיוק. אם לנתונים סינתטיים שנוצרו על ידי בינה מלאכותית יש אי דיוקים, מודלים של בינה מלאכותית שאומנו על נתונים אלו יהיו בעצמם לא מדויקים. אז הדרישה למשוב אנושי כדי לתקן את אי הדיוקים הללו צפויה לגדול.

עם זאת, בעוד שרוב האנשים יוכלו לומר אם משפט מדויק מבחינה דקדוקית, פחות יוכלו להגיב על הדיוק העובדתי שלו - במיוחד כאשר הפלט הוא טכני או מיוחד. פלטים לא מדויקים בנושאי מומחים נוטים פחות להיתפס על ידי RLHF. אם נתונים סינתטיים פירושם שיש יותר אי דיוקים לתפוס, האיכות של LLMs למטרות כלליות עשויה להיעצר או לרדת גם כשהמודלים האלה "לומדים" יותר.

מודלים קטנים של שפה

בעיות אלו עוזרות להסביר כמה מגמות מתפתחות ב-AI. מהנדסי גוגל חשפו שיש מעט מונע מצדדים שלישיים יצירה מחדש של לימודי LLM כמו GPT-3 או LaMDA AI של גוגל. ארגונים רבים יכולים לבנות מערכות AI פנימיות משלהם, תוך שימוש בנתונים מיוחדים משלהם, למטרותיהם. אלה כנראה יהיו בעלי ערך רב יותר עבור ארגונים אלה מאשר ChatGPT בטווח הארוך.

לאחרונה, ממשלת יפן ציינה כי פיתוח א גרסה ממוקדת ביפן של ChatGPT כדאי מאוד לאסטרטגיית הבינה המלאכותית שלהם, מכיוון ש-ChatGPT אינו מייצג מספיק את יפן. חברת התוכנה SAP השיקה לאחרונה את "מפת הדרכים" שלה בינה מלאכותית להציע יכולות פיתוח בינה מלאכותית לארגונים מקצועיים. זה יקל על חברות לבנות גרסאות מותאמות אישית של ChatGPT.

שירותי ייעוץ כגון מקינזי ו KPMG בוחנים את ההכשרה של מודלים של AI ל"מטרות ספציפיות". מדריכים כיצד לעשות זאת צור גרסאות פרטיות ואישיות של ChatGPT ניתן למצוא בקלות באינטרנט. מערכות קוד פתוח, כגון GPT4All, כבר קיים.

כאשר אתגרי הפיתוח - יחד עם מכשולים רגולטוריים פוטנציאליים - מתגברים עבור LLMs גנריים, יתכן שעתיד הבינה המלאכותית יהיה הרבה מודלים קטנים ספציפיים - ולא גדולים - שפות. מודלים קטנים של שפה עשויים להיאבק אם הם מאומנים על פחות נתונים מאשר מערכות כגון GPT-4.

אבל אולי יש להם גם יתרון במונחים של RLHF, שכן סביר להניח שמודלים קטנים של שפה יתפתחו למטרות ספציפיות. עובדים שיש להם ידע מקצועי על הארגון שלהם ועל מטרותיו עשויים לספק משוב בעל ערך רב יותר למערכות בינה מלאכותיות כאלה, בהשוואה למשוב גנרי למערכת בינה מלאכותית גנרית. זה עשוי להתגבר על החסרונות של פחות נתונים.

מאמר זה פורסם מחדש מתוך שיחה תחת רישיון Creative Commons. קרא את ה מאמר מקורי.

תמונת אשראי: מוחמד נוהאסי / Unsplash

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://singularityhub.com/2023/10/01/why-well-see-fewer-generic-ai-chatbots-like-chatgpt-in-the-future/

- :יש ל

- :הוא

- :לֹא

- :איפה

- a

- יכול

- אודות

- מֵעַל

- AC

- גישה

- דיוק

- מדויק

- להשיג

- רכישה

- מתקדם

- יתרון

- מפרסמים

- לאחר

- AI

- דגמי AI

- ai מחקר

- AI אסטרטגיה

- מערכות AI

- כְּבָר

- גם

- צְבִירָה

- an

- ניתוח

- ו

- תשובות

- כל

- API

- גישה לממשק API

- ARE

- אזורים

- מאמר

- AS

- At

- אקסיו

- מבוסס

- BE

- כי

- להיות

- היה

- התחיל

- להלן

- בהתאמה אישית

- מוטב

- מעבר

- הטיות

- מיליארדים

- ספרים

- לִבנוֹת

- בִּניָן

- נבנה

- עסקים

- מודל עסקי

- אבל

- לַחְצָן

- by

- CAN

- לא יכול

- יכולות

- מקרה

- חָתוּל

- היאבקות

- נתפס

- לגרום

- מסוים

- בהחלט

- משתנה

- תשלום

- chatbots

- ChatGPT

- קליק

- CNBC

- CO

- קוד

- לגבות

- COM

- הערה

- המון עם

- חברות

- חברה

- לעומת

- מחשוב

- לבנות

- שיחה

- לתקן

- עלויות

- יכול

- דלפק

- יְצִירָתִי

- יצירתיות

- אשראי

- נתונים

- נקודות מידע

- ירידה

- דרישה

- מעוצב

- מפותח

- מפתח

- מתפתח

- צעצועי התפתחות

- אחר

- קשה

- do

- עושה

- דון

- dr

- קל יותר

- כַּלְכָּלִי

- צמיחה כלכלית

- יְעִילוּת

- מחבק

- מתעורר

- עובדים

- סוף

- מהנדסים

- מספיק

- אֲפִילוּ

- אבולוציה

- דוגמה

- להתקיים

- קיימים

- מומחה

- להסביר

- לנצל

- היכרות

- חשוף

- פָּנִים

- פנים

- גורם

- משפחה

- מָשׁוֹב

- פחות

- מרוכז

- מזון

- בעד

- פורבס

- לשעבר

- קדימה

- מצא

- החל מ-

- FT

- הגשמה

- עתיד

- מטרה כללית

- נוצר

- גנרטטיבית

- AI Generative

- לקבל

- ענקים

- טוב

- גוגל

- ממשלה

- יותר

- גדל

- צמיחה

- מדריך

- מתרחש

- יש

- לעזור

- היסטוריה

- איך

- איך

- HTML

- HTTPS

- בן אנוש

- רעיון

- if

- תמונה

- חשוב

- לשפר

- in

- לֹא מְדוּיָק

- להגדיל

- תעשיות

- מְתוֹעָב

- מידע

- למשל

- שילוב

- אינטרס

- אינטרסים

- פנימי

- אל תוך

- להשקיע

- IT

- שֶׁלָה

- יפן

- יפני

- ממשלת יפן

- לדעת

- ידע

- שפה

- גָדוֹל

- הושק

- מנהיגים

- למידה

- פחות

- רישיון

- כמו

- סביר

- מוגבל

- קְצָת

- חי

- LLM

- ארוך

- נראה

- לעשות

- רב

- מאי..

- אולי

- מקינזי

- אומר

- meta

- מיקרוסופט

- יכול

- MIT

- מודל

- מודלים

- כסף

- יותר

- רוב

- המהלך

- הרבה

- צרכי

- נטו

- חדש

- ציין

- עַכשָׁיו

- יעדים

- of

- הַצָעָה

- לעתים קרובות

- on

- ONE

- באינטרנט

- לפתוח

- קוד פתוח

- OpenAI

- or

- להזמין

- ארגון

- ארגונים

- מְקוֹרִי

- תפוקה

- להתגבר על

- שֶׁלוֹ

- עמוד

- מסוים

- צדדים

- אֲנָשִׁים

- לְבַצֵעַ

- אישי

- מידע אישי

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- אנא

- נקודות

- אפשרי

- פוטנציאל

- פוטנציאל

- חזק

- כוחות

- התחזיות

- מניעה

- פְּרָטִי

- כנראה

- בעיה

- בעיות

- לייצר

- מוצרים

- מקצועי

- לספק

- מתן

- למטרות

- דחוף

- איכות

- שאילתות

- מהר

- ציון

- חומר עיוני

- לְלֹא קוֹשִׁי

- ממשי

- עולם אמיתי

- טעם

- לאחרונה

- רגולטורים

- להסיר

- נציג

- מחקר

- משאבים

- וכתוצאה מכך

- גילה

- מַהְפֵּכָה

- מלכותי

- משפחה מלכותית

- הפעלה

- s

- אותו

- מוהל

- לומר

- אומר

- לגרד

- לִרְאוֹת

- למכור

- מכירת

- משפט

- סט

- כמה

- דומה

- יחיד

- So

- תוכנה

- פִּתָרוֹן

- כמה

- משהו

- מָקוֹר

- מומחה

- מיוחד

- ספציפי

- נאום

- לבלות

- אִסטרָטֶגִיָה

- מַאֲבָק

- כזה

- להציע

- מציע

- סינטטי

- נתונים סינתטיים

- מערכת

- מערכות

- תָג

- ממוקד

- המשימות

- טכני

- לספר

- מונחים

- מֵאֲשֶׁר

- זֶה

- השמיים

- העתיד

- שֶׁלָהֶם

- אותם

- עצמם

- שם.

- אלה

- הֵם

- שְׁלִישִׁי

- צד שלישי

- זֶה

- אלפים

- ל

- כלי

- נושאים

- רכבת

- מְאוּמָן

- הדרכה

- לשנות

- מגמות

- לנסות

- ציוץ

- טוויטים

- סוג

- תחת

- מְשׁוּמָשׁ

- משתמש

- משתמשים

- שימושים

- באמצעות

- בעל ערך

- ערך

- גרסה

- גירסאות

- היה

- דֶרֶך..

- we

- אינטרנט

- אתרים

- מה

- מתי

- אם

- אשר

- בזמן

- מי

- רָחָב

- ויקיפדיה

- יצטרך

- עם

- עובד

- עובד

- עוֹלָם

- כדאי

- היה

- X

- שנים

- אתה

- זפירנט