מדיניות בקרה יעילה מאפשרת לחברות תעשייתיות להגדיל את הרווחיות שלהן על ידי מיקסום הפרודוקטיביות תוך צמצום זמני השבתה לא מתוכננים וצריכת אנרגיה. מציאת מדיניות בקרה אופטימלית היא משימה מורכבת מכיוון שמערכות פיזיקליות, כגון כורים כימיים וטורבינות רוח, קשות לרוב למודל ומכיוון שהסחף בדינמיקה של התהליך עלולה לגרום להידרדרות הביצועים לאורך זמן. למידת חיזוק לא מקוון היא אסטרטגיית בקרה המאפשרת לחברות תעשייתיות לבנות מדיניות בקרה כולה מנתונים היסטוריים ללא צורך במודל תהליך מפורש. גישה זו אינה מצריכה אינטראקציה עם התהליך ישירות בשלב חקר, מה שמסיר את אחד החסמים לאימוץ למידת חיזוק ביישומים קריטיים לבטיחות. בפוסט זה, נבנה פתרון מקצה לקצה כדי למצוא מדיניות בקרה אופטימלית תוך שימוש בנתונים היסטוריים בלבד אמזון SageMaker באמצעות Ray's RLlib סִפְרִיָה. למידע נוסף על למידת חיזוק, ראה השתמש ב-Reforcement Learning עם Amazon SageMaker.

מקרי שימוש

בקרה תעשייתית כוללת ניהול של מערכות מורכבות, כגון קווי ייצור, רשתות אנרגיה ומפעלים כימיים, כדי להבטיח פעולה יעילה ואמינה. אסטרטגיות בקרה מסורתיות רבות מבוססות על כללים ומודלים מוגדרים מראש, אשר לרוב דורשים אופטימיזציה ידנית. נהוג מקובל בתעשיות מסוימות לפקח על הביצועים ולהתאים את מדיניות הבקרה כאשר, למשל, ציוד מתחיל להתקלקל או תנאי הסביבה משתנים. כוונון מחדש יכול לקחת שבועות ועשוי לדרוש הזרקת עירורים חיצוניים למערכת כדי לתעד את תגובתה בגישת ניסוי וטעייה.

למידת חיזוק הופיעה כפרדיגמה חדשה בבקרת תהליכים ללימוד מדיניות בקרה מיטבית באמצעות אינטראקציה עם הסביבה. תהליך זה דורש פירוק נתונים לשלוש קטגוריות: 1) מדידות זמינות מהמערכת הפיזית, 2) מערך הפעולות שניתן לבצע על המערכת, ו-3) מדד מספרי (תגמול) של ביצועי הציוד. מדיניות מאומנת למצוא את הפעולה, בתצפית נתונה, שצפויה להניב את התגמולים העתידיים הגבוהים ביותר.

בלימוד חיזוק לא מקוון, אפשר לאמן מדיניות על נתונים היסטוריים לפני פריסתם לייצור. האלגוריתם שאומן בפוסט זה בבלוג נקרא "למידת Q שמרנית" (CQL). CQL מכיל מודל "שחקן" ומודל "מבקר" ונועד לחזות באופן שמרני את הביצועים שלו לאחר ביצוע פעולה מומלצת. בפוסט זה, התהליך מודגם עם בעיה ממחישה של בקרת מוט עגלה. המטרה היא להכשיר סוכן לאזן עמוד על עגלה ובו זמנית להזיז את העגלה לעבר מיקום יעד ייעודי. הליך ההדרכה משתמש בנתונים הלא מקוונים, ומאפשר לסוכן ללמוד ממידע קיים. תיאור מקרה זה עם מוט עגלה מדגים את תהליך ההדרכה ויעילותו ביישומים פוטנציאליים בעולם האמיתי.

סקירת פתרונות

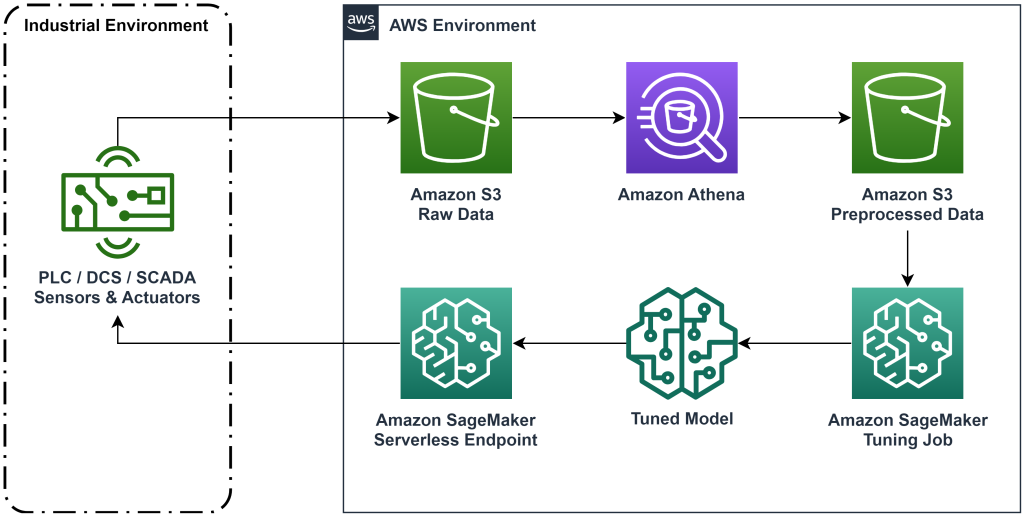

הפתרון המוצג בפוסט זה הופך את הפריסה של זרימת עבודה מקצה לקצה ללמידת חיזוק לא מקוון עם נתונים היסטוריים. התרשים הבא מתאר את הארכיטקטורה המשמשת בזרימת עבודה זו. נתוני המדידה מופקים בקצה על ידי ציוד תעשייתי (כאן מדומה על ידי א AWS למבדה פוּנקצִיָה). הנתונים מוכנסים לתוך אמזון קינסי Data Firehose, המאחסנת אותו שירות אחסון פשוט של אמזון (אמזון S3). Amazon S3 הוא פתרון אחסון עמיד, בעל ביצועים ובעלות נמוכה, המאפשר לך להגיש כמויות גדולות של נתונים לתהליך אימון למידת מכונה.

דבק AWS מקטלג את הנתונים והופך אותם לניתנים לשאילתות באמצעות אמזונה אתנה. אתנה הופכת את נתוני המדידה לצורה שאלגוריתם למידת חיזוק יכול לקלוט ואז פורקת אותם בחזרה לאמזון S3. Amazon SageMaker טוענת את הנתונים הללו לעבודת הדרכה ומייצרת מודל מאומן. SageMaker משרתת את הדגם הזה בנקודת קצה של SageMaker. הציוד התעשייתי יכול לאחר מכן לבצע שאילתות בנקודת הקצה הזו כדי לקבל המלצות לפעולה.

איור 1: תרשים ארכיטקטורה המציג את זרימת העבודה של למידה מקצה לקצה.

בפוסט זה, נפרק את זרימת העבודה בשלבים הבאים:

- נסח את הבעיה. החליטו אילו פעולות ניתן לבצע, על אילו מדידות להציע המלצות, וקבעו באופן מספרי עד כמה כל פעולה בוצעה.

- הכן את הנתונים. הפוך את טבלת המדידות לפורמט שאלגוריתם למידת מכונה יכול לצרוך.

- אמן את האלגוריתם על הנתונים האלה.

- בחר את ריצת האימון הטובה ביותר על סמך מדדי אימון.

- פרוס את המודל לנקודת קצה של SageMaker.

- הערכת ביצועי הדגם בייצור.

תנאים מוקדמים

כדי להשלים את ההדרכה הזו, אתה צריך שיהיה לך חשבון AWS וממשק שורת פקודה עם AWS SAM מותקן. בצע את השלבים הבאים כדי לפרוס את תבנית AWS SAM כדי להפעיל את זרימת העבודה הזו וליצור נתוני הדרכה:

- הורד את מאגר הקודים עם הפקודה

- שנה את הספרייה למאגר:

- בנה את המאגר:

- פרוס את המאגר

- השתמש בפקודות הבאות כדי לקרוא לסקריפט bash, שיוצר נתונים מדומים באמצעות פונקציית AWS Lambda.

sudo yum install jqcd utilssh generate_mock_data.sh

דרך פיתרון

נסח בעיה

המערכת שלנו בפוסט זה בבלוג היא עגלה עם מוט מאוזן למעלה. המערכת מתפקדת היטב כאשר המוט זקוף, ומיקום העגלה קרוב למיקום המטרה. בשלב הדרוש, הפקנו נתונים היסטוריים ממערכת זו.

הטבלה הבאה מציגה נתונים היסטוריים שנאספו מהמערכת.

| מיקום העגלה | מהירות העגלה | זווית מוט | מהירות זוויתית של קוטב | עמדת המטרה | כח חיצוני | לגמול | זְמַן |

| 0.53 | -0.79 | -0.08 | 0.16 | 0.50 | -0.04 | 11.5 | 5:37:54 |

| 0.51 | -0.82 | -0.07 | 0.17 | 0.50 | -0.04 | 11.9 | 5:37:55 |

| 0.50 | -0.84 | -0.07 | 0.18 | 0.50 | -0.03 | 12.2 | 5:37:56 |

| 0.48 | -0.85 | -0.07 | 0.18 | 0.50 | -0.03 | 10.5 | 5:37:57 |

| 0.46 | -0.87 | -0.06 | 0.19 | 0.50 | -0.03 | 10.3 | 5:37:58 |

אתה יכול לשאול מידע היסטורי על המערכת באמצעות Amazon Athena עם השאילתה הבאה:

המצב של מערכת זו מוגדר על ידי מיקום העגלה, מהירות העגלה, זווית המוט, מהירות זווית המוט ומיקום המטרה. הפעולה הננקטת בכל שלב בזמן היא הכוח החיצוני המופעל על העגלה. הסביבה המדומה מפיקה ערך תגמול גבוה יותר כאשר העגלה קרובה יותר לעמדת המטרה והמוט זקוף יותר.

הכן נתונים

כדי להציג את מידע המערכת למודל למידת החיזוק, הפוך אותו לאובייקטי JSON עם מפתחות שמסווגים ערכים לקטגוריות מצב (נקרא גם תצפית), פעולה ותגמול. אחסן את האובייקטים האלה באמזון S3. הנה דוגמה לאובייקטי JSON שהופקו משלבי זמן בטבלה הקודמת.

|

{“obs”:[[0.53,-0.79,-0.08,0.16,0.5]], “action”:[[-0.04]], “reward”:[11.5] ,”next_obs”:[[0.51,-0.82,-0.07,0.17,0.5]]} |

|

{“obs”:[[0.51,-0.82,-0.07,0.17,0.5]], “action”:[[-0.04]], “reward”:[11.9], “next_obs”:[[0.50,-0.84,-0.07,0.18,0.5]]} |

|

{“obs”:[[0.50,-0.84,-0.07,0.18,0.5]], “action”:[[-0.03]], “reward”:[12.2], “next_obs”:[[0.48,-0.85,-0.07,0.18,0.5]]} |

מחסנית AWS CloudFormation מכילה פלט שנקרא AthenaQueryToCreateJsonFormatedData. הפעל את השאילתה הזו באמזון אתנה כדי לבצע את השינוי ולאחסן את אובייקטי ה-JSON ב-Amazon S3. אלגוריתם למידת החיזוק משתמש במבנה של אובייקטי JSON אלה כדי להבין על אילו ערכים לבסס המלצות ואת התוצאה של נקיטת פעולות בנתונים ההיסטוריים.

סוכן רכבת

כעת נוכל להתחיל בעבודת הדרכה להפקת מודל המלצה לפעולה מאומן. Amazon SageMaker מאפשר לך להשיק במהירות מספר עבודות הדרכה כדי לראות כיצד תצורות שונות משפיעות על המודל המאומן המתקבל. קרא לפונקציית Lambda בשם TuningJobLauncherFunction להתחיל עבודת כוונון היפרפרמטרים שמתנסה בארבע קבוצות שונות של היפרפרמטרים בעת אימון האלגוריתם.

בחר את ריצת האימון הטובה ביותר

כדי למצוא איזו מעבודות ההכשרה יצרה את המודל הטוב ביותר, בחן עקומות הפסד שנוצרו במהלך האימון. מודל המבקרים של CQL מעריך את הביצועים של השחקן (הנקרא ערך Q) לאחר ביצוע פעולה מומלצת. חלק מפונקציית ההפסד של המבקר כולל את שגיאת ההפרש הזמני. מדד זה מודד את דיוק ערך ה-Q של המבקר. חפש ריצות אימון עם ערך Q ממוצע גבוה ושגיאת הפרש זמני נמוך. הדף הזה, זרימת עבודה ללימוד חיזוק רובוטי ללא מודלים מקוונים, פירוט כיצד לבחור את ריצת האימון הטובה ביותר. למאגר הקוד יש קובץ, /utils/investigate_training.py, שיוצרת דמות HTML עלילתית המתארת את עבודת ההדרכה האחרונה. הפעל את הקובץ הזה והשתמש בפלט כדי לבחור את ריצת האימון הטובה ביותר.

אנו יכולים להשתמש בערך Q הממוצע כדי לחזות את הביצועים של המודל המאומן. ערכי ה-Q מאומנים לחזות באופן שמרני את הסכום של ערכי תגמול עתידיים מוזלים. עבור תהליכים ארוכי טווח, אנו יכולים להמיר את המספר הזה לממוצע משוקלל אקספוננציאלי על ידי הכפלת ערך ה-Q ב-(1-"שיעור הנחה"). ריצת האימונים הטובה ביותר בקבוצה הזו השיגה ערך Q ממוצע של 539. שיעור ההנחה שלנו הוא 0.99, כך שהמודל חוזה לפחות 5.39 תגמול ממוצע לכל צעד זמן. אתה יכול להשוות ערך זה לביצועי מערכת היסטוריים כדי לקבל אינדיקציה אם המודל החדש ישיג ביצועים טובים יותר ממדיניות הבקרה ההיסטורית. בניסוי זה, התגמול הממוצע של הנתונים ההיסטוריים לצעד זמן היה 4.3, כך שמודל ה-CQL חוזה ביצועים טובים ב-25 אחוזים מהמערכת שהושגה היסטורית.

מודל פריסה

נקודות הקצה של Amazon SageMaker מאפשרות לך לשרת מודלים של למידת מכונה בכמה דרכים שונות כדי לעמוד במגוון מקרי שימוש. בפוסט זה, נשתמש בסוג נקודת הקצה ללא שרת כך שנקודת הקצה שלנו תתאים אוטומטית לפי הביקוש, ואנו משלמים עבור שימוש במחשב רק כאשר נקודת הקצה מייצרת הסקה. כדי לפרוס נקודת קצה ללא שרת, כלול א ProductionVariantServerlessConfig ב וריאנט ייצור של SageMaker תצורת נקודת הקצה. קטע הקוד הבא מציג כיצד נקודת הקצה ללא שרת בדוגמה זו נפרסת באמצעות ערכת פיתוח התוכנה Amazon SageMaker עבור Python. מצא את הקוד לדוגמה המשמש לפריסת המודל ב sagemaker-offline-inforcement-learning-ray-cql.

קבצי המודל המאומן ממוקמים בחפצי דגם S3 עבור כל ריצת אימון. כדי לפרוס את מודל למידת המכונה, אתר את קובצי המודל של ריצת האימון הטובה ביותר, וקרא לפונקציית Lambda בשם "ModelDeployerFunction" עם אירוע שמכיל את נתוני המודל הזה. פונקציית Lambda תשיק נקודת קצה ללא שרת של SageMaker שתשרת את הדגם המאומן. אירוע לדוגמה לשימוש בעת התקשרות ל"ModelDeployerFunction"

הערכת ביצועי מודל מאומן

זה הזמן לראות איך הדגם המאומן שלנו מתקדם בייצור! כדי לבדוק את הביצועים של הדגם החדש, קרא לפונקציית Lambda בשם "RunPhysicsSimulationFunction" עם שם נקודת הקצה של SageMaker באירוע. פעולה זו תפעיל את הסימולציה באמצעות הפעולות המומלצות על ידי נקודת הקצה. אירוע לדוגמה לשימוש בעת התקשרות ל RunPhysicsSimulatorFunction:

השתמש בשאילתת Athena הבאה כדי להשוות את הביצועים של המודל המאומן עם ביצועי המערכת ההיסטוריים.

| מקור פעולה | תגמול ממוצע לכל שלב בזמן |

trained_model |

10.8 |

historic_data |

4.3 |

האנימציות הבאות מציגות את ההבדל בין פרק לדוגמה מנתוני האימון לבין פרק שבו נעשה שימוש במודל המאומן כדי לבחור איזו פעולה לנקוט. בהנפשות, הקופסה הכחולה היא העגלה, הקו הכחול הוא המוט, והמלבן הירוק הוא מיקום המטרה. החץ האדום מציג את הכוח המופעל על העגלה בכל שלב בזמן. החץ האדום בנתוני האימון קופץ לא מעט קדימה ואחורה מכיוון שהנתונים נוצרו באמצעות 50 אחוז פעולות מומחים ו-50 אחוז פעולות אקראיות. הדגם המאומן למד מדיניות בקרה שמניעה את העגלה במהירות לעמדת המטרה, תוך שמירה על יציבות, כולה מתוך צפייה בהפגנות שאינן מומחים.

|

|

לנקות את

כדי למחוק משאבים המשמשים בזרימת עבודה זו, נווט אל קטע המשאבים של מחסנית Amazon CloudFormation ומחק את דלי S3 ואת תפקידי IAM. לאחר מכן מחק את ערימת CloudFormation עצמה.

סיכום

לימוד חיזוק לא מקוון יכול לעזור לחברות תעשייתיות להפוך את החיפוש אחר מדיניות אופטימלית מבלי לפגוע בבטיחות על ידי שימוש בנתונים היסטוריים. כדי ליישם גישה זו בפעולות שלך, התחל בזיהוי המדידות המרכיבות מערכת שנקבעה על ידי המדינה, הפעולות בהן תוכל לשלוט ומדדים המציינים את הביצועים הרצויים. לאחר מכן, גישה מאגר GitHub זה להטמעת פתרון אוטומטי מקצה לקצה באמצעות Ray ו-Amazon SageMaker.

הפוסט פשוט מגרד את פני השטח של מה שאתה יכול לעשות עם Amazon SageMaker RL. נסה את זה, ושלח לנו משוב, ב- פורום הדיון של אמזון SageMaker או דרך אנשי הקשר הרגילים שלך ב-AWS.

על הכותבים

וולט מייפילד הוא אדריכל פתרונות ב-AWS ומסייע לחברות אנרגיה לפעול בצורה בטוחה ויעילה יותר. לפני שהצטרף ל-AWS, וולט עבד כמהנדס תפעול בחברת Hilcorp Energy. הוא אוהב לגן ולעוף דגים בזמנו הפנוי.

וולט מייפילד הוא אדריכל פתרונות ב-AWS ומסייע לחברות אנרגיה לפעול בצורה בטוחה ויעילה יותר. לפני שהצטרף ל-AWS, וולט עבד כמהנדס תפעול בחברת Hilcorp Energy. הוא אוהב לגן ולעוף דגים בזמנו הפנוי.

פליפה לופז הוא אדריכל פתרונות בכיר ב-AWS עם ריכוז בפעילות הפקת נפט וגז. לפני שהצטרף ל-AWS, פליפה עבד עם GE Digital ושלומברגר, שם התמקד ביצירת מודלים ואופטימיזציה של מוצרי יישומים תעשייתיים.

פליפה לופז הוא אדריכל פתרונות בכיר ב-AWS עם ריכוז בפעילות הפקת נפט וגז. לפני שהצטרף ל-AWS, פליפה עבד עם GE Digital ושלומברגר, שם התמקד ביצירת מודלים ואופטימיזציה של מוצרי יישומים תעשייתיים.

ינגוויי יו הוא מדען יישומי בחממת AI Generative, AWS. יש לו ניסיון בעבודה עם מספר ארגונים בתעשיות על הוכחות שונות למושג למידת מכונה, כולל עיבוד שפה טבעית, ניתוח סדרות זמן ותחזוקה חזויה. בזמנו הפנוי הוא נהנה לשחות, לצייר, לטייל ולבלות עם המשפחה והחברים.

ינגוויי יו הוא מדען יישומי בחממת AI Generative, AWS. יש לו ניסיון בעבודה עם מספר ארגונים בתעשיות על הוכחות שונות למושג למידת מכונה, כולל עיבוד שפה טבעית, ניתוח סדרות זמן ותחזוקה חזויה. בזמנו הפנוי הוא נהנה לשחות, לצייר, לטייל ולבלות עם המשפחה והחברים.

האוז'ו וואנג הוא מדען מחקר ב- Amazon Bedrock המתמקד בבניית מודלים של בסיס טיטאן של אמזון. בעבר הוא עבד ב-Amazon ML Solutions Lab כמוביל משותף של Reinforcement Learning Vertical ועזר ללקוחות לבנות פתרונות ML מתקדמים עם המחקר העדכני ביותר על למידת חיזוק, עיבוד שפה טבעית ולמידת גרפים. האוז'ו קיבל את הדוקטורט שלו בהנדסת חשמל ומחשבים מאוניברסיטת מישיגן.

האוז'ו וואנג הוא מדען מחקר ב- Amazon Bedrock המתמקד בבניית מודלים של בסיס טיטאן של אמזון. בעבר הוא עבד ב-Amazon ML Solutions Lab כמוביל משותף של Reinforcement Learning Vertical ועזר ללקוחות לבנות פתרונות ML מתקדמים עם המחקר העדכני ביותר על למידת חיזוק, עיבוד שפה טבעית ולמידת גרפים. האוז'ו קיבל את הדוקטורט שלו בהנדסת חשמל ומחשבים מאוניברסיטת מישיגן.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. רכב / רכבים חשמליים, פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- ChartPrime. הרם את משחק המסחר שלך עם ChartPrime. גישה כאן.

- BlockOffsets. מודרניזציה של בעלות על קיזוז סביבתי. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/optimize-equipment-performance-with-historical-data-ray-and-amazon-sagemaker/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 07

- 08

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 16

- 17

- 25

- 32

- 39

- 50

- 51

- 54

- 7

- 8

- 84

- 9

- a

- אודות

- גישה

- דיוק

- הושג

- לרוחב

- פעולה

- פעולות

- בנוסף

- אימוץ

- מתקדם

- להשפיע על

- לאחר

- סוֹכֵן

- AI

- אַלגוֹרִיתְם

- מאפשר

- מאפשר

- גם

- אמזון בעברית

- אמזונה אתנה

- מעבדת פתרונות אמזון ML

- אמזון SageMaker

- אמזון שירותי אינטרנט

- an

- אנליזה

- ו

- זוויתי

- אנימציות

- יישומים

- יישומית

- גישה

- ארכיטקטורה

- ARE

- AS

- At

- אוטומטי

- אוטומטית

- מכני עם סלילה אוטומטית

- באופן אוטומטי

- זמין

- מְמוּצָע

- AWS

- AWS CloudFormation

- AWS למבדה

- בחזרה

- איזון

- מחסומים

- בסיס

- מבוסס

- לחבוט

- BE

- כי

- לפני

- הטוב ביותר

- מוטב

- בֵּין

- קצת

- בלוג

- כָּחוֹל

- אריזה מקורית

- לשבור

- שבירה

- לִבנוֹת

- בִּניָן

- by

- שיחה

- נקרא

- קוראים

- CAN

- מקרה

- מקרה מבחן

- מקרים

- קטלוגים

- קטגוריות

- לגרום

- שינוי

- לבדוק

- כימי

- סְגוֹר

- קרוב יותר

- קוד

- חברות

- חברה

- לְהַשְׁווֹת

- להשלים

- מורכב

- מתפשר

- לחשב

- המחשב

- הנדסת מחשבים

- ריכוז

- מושג

- תנאים

- שמרני

- לצרוך

- צְרִיכָה

- אנשי קשר

- מכיל

- לִשְׁלוֹט

- להמיר

- יוצר

- מבקר

- לקוחות

- נתונים

- להחליט

- מוגדר

- דרישה

- מופגן

- מדגים

- לפרוס

- פרס

- פריסה

- פריסה

- יעוד

- מעוצב

- רצוי

- פרטים

- לקבוע

- צעצועי התפתחות

- הבדל

- אחר

- דיגיטלי

- ישירות

- הנחה

- מוזל

- דיון

- do

- עושה

- עושה

- מטה

- זמן השבתה

- בְּמַהֲלָך

- דינמיקה

- כל אחד

- אדג '

- יְעִילוּת

- יעיל

- יעילות

- או

- יצא

- לאפשר

- מקצה לקצה

- נקודת קצה

- אנרגיה

- צריכת אנרגיה

- מהנדס

- הנדסה

- לְהַבטִיחַ

- לַחֲלוּטִין

- סביבה

- סביבתי

- אפיזודה

- ציוד

- שגיאה

- הערכות

- אירוע

- לִבחוֹן

- דוגמה

- ניסיון

- לְנַסוֹת

- ניסויים

- מומחה

- חקירה

- אקספוננציאלית

- חיצוני

- משפחה

- מָשׁוֹב

- תרשים

- שלח

- קבצים

- מציאת

- דג

- מרוכז

- התמקדות

- לעקוב

- הבא

- בעד

- להכריח

- טופס

- פוּרמָט

- הָלְאָה

- קרן

- ארבע

- חברים

- החל מ-

- פונקציה

- עתיד

- גן

- גז

- אסף

- ge

- ליצור

- נוצר

- מייצר

- יצירת

- גנרטטיבית

- AI Generative

- gif

- GitHub

- לתת

- נתן

- מטרה

- גרף

- ירוק

- קְבוּצָה

- קשה

- יש

- he

- לעזור

- עזר

- עוזר

- כאן

- גָבוֹהַ

- גבוה יותר

- הגבוה ביותר

- שֶׁלוֹ

- היסטורי

- הסטורי

- איך

- איך

- HTML

- HTTPS

- כוונון היפר-פרמטר

- זיהוי

- if

- ליישם

- הפעלה

- in

- לכלול

- כולל

- כולל

- להגדיל

- מַדגֵרָה

- להצביע

- סִימָן

- התעשייה

- תעשיות

- מידע

- להתקין

- אינטראקציה

- אינטראקציה

- מִמְשָׁק

- אל תוך

- IT

- שֶׁלָה

- עצמו

- עבודה

- מקומות תעסוקה

- הצטרפות

- jpg

- ג'סון

- קפיצות

- רק

- מפתחות

- מעבדה

- שפה

- גָדוֹל

- האחרון

- לשגר

- לִלמוֹד

- למד

- למידה

- הכי פחות

- לתת

- מאפשר לי

- סִפְרִיָה

- סביר

- אוהב

- להגביל

- קו

- קווים

- המון

- ממוקם

- מיקום

- נראה

- את

- נמוך

- בעלות נמוכה

- מכונה

- למידת מכונה

- שמירה

- תחזוקה

- לעשות

- עושה

- ניהול

- מדריך ל

- ייצור

- רב

- מקסום

- מאי..

- אומר

- מדידה

- מידות

- אמצעים

- לִפְגוֹשׁ

- מטרי

- מדדים

- מישיגן

- ML

- מודל

- דוגמנות

- מודלים

- צג

- יותר

- מהלכים

- נע

- מספר

- מכפילים

- שם

- שם

- טבעי

- עיבוד שפה טבעית

- נווט

- צורך

- חדש

- מספר

- אובייקטים

- of

- לא מחובר

- לעתים קרובות

- שמן

- on

- ONE

- רק

- להפעיל

- מבצע

- תפעול

- אופטימלי

- אופטימיזציה

- מטב

- or

- להזמין

- ארגונים

- שלנו

- תוֹצָאָה

- ביצועים טובים יותר

- תפוקה

- יותר

- שֶׁלוֹ

- ציור

- מאמר

- פרדיגמה

- חלק

- תשלום

- עבור

- אָחוּז

- לְבַצֵעַ

- ביצועים

- ביצעתי

- מבצע

- דוקטורט

- גופני

- לבחור

- לְחַבֵּר

- צמחים

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- אנא

- מדיניות

- מדיניות

- עמדה

- הודעה

- פוטנציאל

- תרגול

- לחזות

- ניבוי

- נבואה

- להציג

- מוצג

- קודם

- קוֹדֶם

- קודם

- בעיה

- הליך

- תהליך

- תהליכים

- תהליך

- לייצר

- מיוצר

- ייצור

- הפקה

- פִּריוֹן

- מוצרים

- כדאיויות

- הוכחות

- גם

- פיתון

- מהירות

- אקראי

- ציון

- RAY

- עולם אמיתי

- לקבל

- קיבלו

- המלצה

- המלצות

- מוּמלָץ

- שיא

- Red

- הפחתה

- אָמִין

- מאגר

- לדרוש

- דורש

- מחקר

- משאבים

- תגובה

- וכתוצאה מכך

- תוצאות

- לגמול

- תגמולים

- תפקידים

- כללי

- הפעלה

- פועל

- בבטחה

- בְּטִיחוּת

- בעל חכמים

- סם

- מאזניים

- מַדְעָן

- תסריט

- חיפוש

- סעיף

- לִרְאוֹת

- לשלוח

- לחצני מצוקה לפנסיונרים

- סדרה

- לשרת

- ללא שרת

- משמש

- שירותים

- סט

- סטים

- כמה

- לְהַצִיג

- הופעות

- פָּשׁוּט

- הדמיה

- בו זמנית

- קטע

- So

- תוכנה

- פיתוח תוכנה

- ערכת פיתוח תוכנה

- פִּתָרוֹן

- פתרונות

- כמה

- הוצאה

- יציבות

- לערום

- התמחות

- תֶקֶן

- התחלה

- התחלות

- מדינה

- שלב

- צעדים

- אחסון

- חנות

- חנויות

- אסטרטגיות

- אִסטרָטֶגִיָה

- מִבְנֶה

- לימוד

- כזה

- משטח

- מערכת

- מערכות

- שולחן

- לקחת

- משימות

- נטילת

- המשימות

- תבנית

- מֵאֲשֶׁר

- זֶה

- השמיים

- המדינה

- שֶׁלָהֶם

- אז

- אלה

- זֶה

- שְׁלוֹשָׁה

- דרך

- זמן

- סדרת זמן

- עֲנָק

- ל

- חלק עליון

- לקראת

- מסורתי

- רכבת

- מְאוּמָן

- הדרכה

- לשנות

- טרנספורמציה

- התמרות

- נָכוֹן

- לנסות

- סוג

- להבין

- אוניברסיטה

- על

- us

- נוֹהָג

- להשתמש

- מְשׁוּמָשׁ

- שימושים

- באמצעות

- ערך

- ערכים

- מגוון

- שונים

- מְהִירוּת

- אנכי

- כרכים

- בהדרכה

- היה

- דרכים

- we

- אינטרנט

- שירותי אינטרנט

- שבועות

- טוֹב

- מה

- מתי

- אשר

- בזמן

- יצטרך

- רוח

- עם

- לְלֹא

- עבד

- זרימת עבודה

- עובד

- אתה

- זפירנט