פוסט זה נכתב בשיתוף אנטולי חומנקו, מהנדס למידת מכונה, ו- Abdenour Bezzouh, קצין טכנולוגיה ראשי ב- Talent.com.

נוסדה בשנת 2011, Talent.com הוא אחד ממקורות התעסוקה הגדולים בעולם. החברה משלבת רישומי משרות בתשלום מלקוחותיה עם רשימות משרות ציבוריות לפלטפורמה אחת הניתנת לחיפוש. עם למעלה מ-30 מיליון משרות הרשומות ביותר מ-75 מדינות, Talent.com משרת משרות בשפות, תעשיות וערוצי הפצה רבים. התוצאה היא פלטפורמה שמתאימה בין מיליוני מחפשי עבודה למשרות זמינות.

המשימה של Talent.com היא לרכז את כל המשרות הזמינות באינטרנט כדי לעזור למחפשי עבודה למצוא את ההתאמה הטובה ביותר שלהם תוך כדי לספק להם את חווית החיפוש הטובה ביותר. ההתמקדות שלו היא ברלוונטיות, מכיוון שסדר המשרות המומלצות חשוב ביותר כדי להראות את המשרות הרלוונטיות ביותר לתחומי העניין של המשתמשים. הביצועים של אלגוריתם ההתאמה של Talent.com הם בעלי חשיבות עליונה להצלחת העסק ותורם מרכזי לחוויית המשתמשים שלהם. זה מאתגר לחזות אילו משרות רלוונטיות למחפש עבודה בהתבסס על כמות המידע המוגבלת המסופקת, הכלול בדרך כלל בכמה מילות מפתח ומיקום.

בהינתן משימה זו, Talent.com ו-AWS איחדו כוחות כדי ליצור מנוע המלצות לעבודה באמצעות עיבוד שפה טבעית (NLP) מתקדמת וטכניקות אימון מודל למידה עמוקה עם אמזון SageMaker לספק חוויה ללא תחרות למחפשי עבודה. פוסט זה מציג את הגישה המשותפת שלנו לתכנון מערכת המלצות לעבודה, כולל הנדסת תכונות, עיצוב ארכיטקטורת מודל למידה עמוקה, אופטימיזציה של היפרפרמטרים והערכת מודלים המבטיחים את האמינות והיעילות של הפתרון שלנו הן למחפשי עבודה והן למעסיקים. המערכת פותחה על ידי צוות של מדעני למידה יישומית (ML) ייעודיים, מהנדסי ML ומומחי נושא בשיתוף פעולה בין AWS ו-Talent.com.

מערכת ההמלצות הביאה לעלייה של 8.6% בשיעור הקליקים (CTR) בבדיקות A/B מקוונות מול פתרון קודם מבוסס XGBoost, ועזרה לחבר מיליוני משתמשים של Talent.com לעבודות טובות יותר.

סקירה כללית של הפיתרון

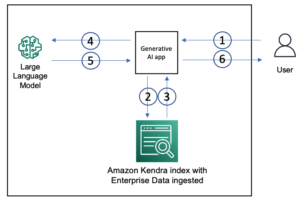

סקירה כללית של המערכת מוצגת באיור הבא. המערכת לוקחת את שאילתת החיפוש של המשתמש כקלט ומוציאה רשימה מדורגת של משרות לפי סדר רלוונטיות. רלוונטיות לעבודה נמדדת לפי הסתברות הקליקים (ההסתברות שמחפש עבודה ילחץ על משרה לקבלת מידע נוסף).

המערכת כוללת ארבעה מרכיבים עיקריים:

- אדריכלות מודל – הליבה של מנוע המלצות לעבודה זה הוא מודל Triple Tower Pointwise המבוסס על למידה עמוקה, הכולל מקודד שאילתות המקודד שאילתות חיפוש של משתמשים, מקודד מסמכים המקודד את תיאורי התפקיד ומקודד אינטראקציה שמעבד את עבודת המשתמש בעבר. תכונות אינטראקציה. התפוקות של שלושת המגדלים משורשרות ומועברות דרך ראש סיווג כדי לחזות את הסתברויות הלחיצה של העבודה. על ידי הכשרת מודל זה על שאילתות חיפוש, פרטי עבודה ונתוני אינטראקציה היסטוריים של משתמשים מ-Talent.com, מערכת זו מספקת המלצות עבודה מותאמות אישית ורלוונטיות ביותר למחפשי עבודה.

- הנדסת תכונות - אנו מבצעים שתי קבוצות של הנדסת תכונות כדי לחלץ מידע בעל ערך מנתוני קלט ולהזין אותו למגדלים המתאימים במודל. שני הסטים הם הנדסת תכונה סטנדרטית והטמעות מכווננות של Sentence-BERT (SBERT). אנו משתמשים בתכונות המהונדסות הסטנדרטיות כקלט לתוך מקודד האינטראקציה ומזינים את ההטמעה הנגזרת של SBERT לתוך מקודד השאילתות ומקודד המסמכים.

- אופטימיזציה וכוונון הדגם - אנו משתמשים במתודולוגיות הדרכה מתקדמות כדי לאמן, לבדוק ולפרוס את המערכת עם SageMaker. זה כולל אימון של SageMaker Distributed Data Parallel (DDP), SageMaker Automatic Model Tuning (AMT), תזמון קצב למידה ועצירה מוקדמת לשיפור ביצועי המודל ומהירות האימון. השימוש במסגרת האימון של DDP עזר להאיץ את אימון המודלים שלנו למהירות של בערך פי שמונה.

- הערכת מודל - אנו עורכים הערכה לא מקוונת וגם מקוונת. אנו מעריכים את ביצועי המודל עם שטח מתחת לעקומה (AUC) ודיוק ממוצע ב-K (mAP@K) בהערכה לא מקוונת. במהלך בדיקות A/B מקוונות, אנו מעריכים את שיפורי שיעור הקליקים.

בסעיפים הבאים נציג את הפרטים של ארבעת המרכיבים הללו.

עיצוב ארכיטקטורת מודל למידה עמוקה

אנו מתכננים מודל Triple Tower Deep Pointwise (TTDP) תוך שימוש בארכיטקטורת למידה עמוקה של מגדל משולש ובגישת דוגמנות זוג נקודתית. ארכיטקטורת המגדל המשולש מספקת שלוש רשתות עצביות עמוקות מקבילות, כאשר כל מגדל מעבד קבוצה של תכונות באופן עצמאי. דפוס עיצוב זה מאפשר למודל ללמוד ייצוגים שונים ממקורות מידע שונים. לאחר שהייצוגים מכל שלושת המגדלים מתקבלים, הם משורשרים ומועברים דרך ראש סיווג כדי לבצע את התחזית הסופית (0-1) על הסתברות הלחיצה (הגדרת דוגמנות נקודתית).

שמות שלושת המגדלים נקראים על סמך המידע שהם מעבדים: מקודד השאילתות מעבד את שאילתת החיפוש של המשתמש, מקודד המסמכים מעבד את התוכן התיעודי של העבודה המועמדת כולל שם התפקיד ושם החברה, ומקודד האינטראקציה משתמש בתכונות רלוונטיות שחולצו מאינטראקציות משתמש קודמות והיסטוריה (נדון בהרחבה בסעיף הבא).

כל אחד מהמגדלים הללו ממלא תפקיד מכריע בלמידה כיצד להמליץ על עבודות:

- מקודד שאילתות – מקודד השאילתות מקבל את הטמעות SBERT הנגזרות משאילתת חיפוש העבודה של המשתמש. אנו משפרים את ההטבעות באמצעות דגם SBERT שכיוונו עדין. מקודד זה מעבד ומבין את כוונת חיפוש העבודה של המשתמש, כולל פרטים וניואנסים שנלכדו על ידי ההטמעות הספציפיות לתחום שלנו.

- מקודד מסמכים – מקודד המסמכים מעבד את המידע של כל רישום משרות. באופן ספציפי, זה לוקח את הטבעות SBERT של הטקסט המשורשר מכותר המשרה והחברה. האינטואיציה היא שמשתמשים יתעניינו יותר במשרות מועמדות שרלוונטיות יותר לשאילתת החיפוש. על ידי מיפוי המשרות ושאילתות החיפוש לאותו מרחב וקטור (מוגדר על ידי SBERT), המודל יכול ללמוד לחזות את ההסתברות של המשרות הפוטנציאליות שמחפש עבודה ילחץ.

- מקודד אינטראקציה – מקודד האינטראקציה עוסק באינטראקציות העבר של המשתמש עם רשימות משרות. התכונות מיוצרות באמצעות שלב הנדסת תכונות סטנדרטי, הכולל חישוב מדדי פופולריות עבור תפקידי עבודה וחברות, קביעת ציוני דמיון בהקשר וחילוץ פרמטרים של אינטראקציה ממעורבות משתמשים קודמים. הוא גם מעבד את הישויות הנקובות המזוהות בתואר המשרה ושאילתות חיפוש עם מודל זיהוי ישויות בשם (NER) מאומן מראש.

כל מגדל מייצר פלט עצמאי במקביל, שכולם משורשרים יחדיו. וקטור תכונה משולב זה מועבר לאחר מכן כדי לחזות את הסתברות הקליקים של רישום עבודה עבור שאילתת משתמש. ארכיטקטורת המגדל המשולש מספקת גמישות בלכידת יחסים מורכבים בין תשומות או תכונות שונות, ומאפשרת למודל לנצל את היתרונות של כל מגדל תוך לימוד ייצוגים אקספרסיביים יותר עבור המשימה הנתונה.

סיכויי הקליקים החזויים של משרות מועמדים מדורגות מגבוה לנמוך, ומייצרות המלצות עבודה מותאמות אישית. באמצעות תהליך זה, אנו מבטיחים שכל פיסת מידע - בין אם זו כוונת החיפוש של המשתמש, פרטי רישום משרות או אינטראקציות קודמות - נלכדת במלואה על ידי מגדל ספציפי המוקדש לו. היחסים המורכבים ביניהם נלכדים גם באמצעות שילוב תפוקות המגדל.

הנדסת תכונות

אנו מבצעים שתי קבוצות של תהליכי הנדסת תכונות כדי לחלץ מידע בעל ערך מהנתונים הגולמיים ולהזין אותו למגדלים המתאימים במודל: הנדסת תכונות סטנדרטית והטמעות SBERT מכווננות.

הנדסת תכונה סטנדרטית

תהליך הכנת הנתונים שלנו מתחיל בהנדסת תכונות סטנדרטית. בסך הכל, אנו מגדירים ארבעה סוגים של תכונות:

- הכי פופולרי – אנו מחשבים את ציוני הפופולריות ברמת התפקיד האישי, רמת העיסוק ורמת החברה. זה מספק מדד למידת אטרקטיביות של עבודה או חברה מסוימת.

- דמיון טקסטואלי – כדי להבין את הקשר ההקשרי בין אלמנטים טקסטואליים שונים, אנו מחשבים ציוני דמיון, כולל דמיון מחרוזת בין שאילתת החיפוש לבין שם המשרה. זה עוזר לנו לאמוד את הרלוונטיות של משרה נפתחת להיסטוריית החיפוש או המועמדות של מחפש עבודה.

- פעולת גומלין - בנוסף, אנו מחלצים תכונות אינטראקציה ממעורבות קודמת של משתמשים עם רישומי משרות. דוגמה מצוינת לכך היא הדמיון המוטבע בין כותרות עבודה שנלחצו בעבר לבין כותרות עבודה של מועמדים. מדד זה עוזר לנו להבין את הדמיון בין עבודות קודמות שמשתמש גילה עניין בהן לעומת הזדמנויות עבודה קרובות. זה משפר את הדיוק של מנוע המלצות העבודה שלנו.

- פּרוֹפִיל - לבסוף, אנו מחלצים מידע על עניין עבודה המוגדר על ידי המשתמש מפרופיל המשתמש ומשווים אותו עם מועמדים חדשים לעבודה. זה עוזר לנו להבין אם מועמד לעבודה מתאים לעניין של משתמש.

שלב מכריע בהכנת הנתונים שלנו הוא היישום של מודל NER מאומן מראש. על ידי הטמעת מודל NER, אנו יכולים לזהות ולתייג ישויות בשם בתוך כותרות עבודה ושאילתות חיפוש. כתוצאה מכך, זה מאפשר לנו לחשב ציוני דמיון בין הישויות המזוהות הללו, ומספק מדד ממוקד יותר ומודע להקשר של קשר. מתודולוגיה זו מפחיתה את הרעש בנתונים שלנו ונותנת לנו שיטה יותר ניואנסית ורגישה להקשר להשוואת עבודות.

הטמעות SBERT מכוונות עדינות

כדי לשפר את הרלוונטיות והדיוק של מערכת המלצות העבודה שלנו, אנו משתמשים בכוחו של SBERT, מודל רב עוצמה מבוסס שנאים, הידוע במיומנות שלו בלכידת משמעויות והקשרים סמנטיים מטקסט. עם זאת, הטמעות גנריות כמו SBERT, למרות שהן יעילות, עשויות שלא ללכוד במלואן את הניואנסים והטרמינולוגיות הייחודיות הטבועות בתחום ספציפי כמו שלנו, שמתרכז סביב תעסוקה וחיפוש עבודה. כדי להתגבר על כך, אנו מכווננים את ההטמעות של SBERT באמצעות הנתונים הספציפיים לדומיין שלנו. תהליך כוונון עדין זה מייעל את המודל כדי להבין ולעבד טוב יותר את השפה, הז'רגון וההקשר הספציפיים לתעשייה, מה שהופך את ההטמעות למשקפות יותר את התחום הספציפי שלנו. כתוצאה מכך, ההטמעות המעודנות מציעות ביצועים משופרים בלכידת מידע סמנטי והקשרי כאחד בתוך התחום שלנו, מה שמוביל להמלצות עבודה מדויקות ומשמעותיות יותר עבור המשתמשים שלנו.

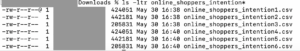

האיור הבא ממחיש את שלב הכוונון העדין של SBERT.

אנו מכווננים הטמעות SBERT באמצעות TripletLoss עם מדד מרחק קוסינוס הלומד הטבעת טקסט כאשר לטקסטים של עוגן וחיובי יש דמיון קוסינוס גבוה יותר מטקסטים של עוגן ושלילי. אנו משתמשים בשאילתות החיפוש של משתמשים כטקסטים של עוגן. אנו משלבים כותרות עבודה ושמות מעסיקים כתשומות לטקסטים החיוביים והשליליים. הטקסטים החיוביים נדגמים מפרסומי דרושים שהמשתמש המקביל לחץ עליהם, ואילו הטקסטים השליליים נדגמים מפרסומי דרושים שהמשתמש לא לחץ עליהם. להלן יישום לדוגמה של הליך הכוונון העדין:

אימון מודלים עם SageMaker Distributed Data Parallel

אנו משתמשים ב-SageMaker Distributed Data Parallel (SMDDP), תכונה של פלטפורמת SageMaker ML הבנויה על גבי PyTorch DDP. הוא מספק סביבה אופטימלית להפעלת עבודות אימון PyTorch DDP בפלטפורמת SageMaker. זה נועד להאיץ משמעותית את אימון מודל הלמידה העמוקה. הוא משיג זאת על ידי פיצול מערך נתונים גדול לנתחים קטנים יותר והפצתם על פני מספר GPUs. הדגם משוכפל בכל GPU. כל GPU מעבד את הנתונים שהוקצו לו באופן עצמאי, והתוצאות נאספות ומסונכרנות על פני כל ה-GPUs. DDP דואג לתקשורת שיפוע כדי לשמור על עותקים של מודל מסונכרן וחופף אותם עם חישובי שיפוע כדי להאיץ את האימון. SMDDP משתמש באלגוריתם AllReduce אופטימלי כדי למזער את התקשורת בין GPUs, להפחית את זמן הסנכרון ולשפר את מהירות האימון הכוללת. האלגוריתם מתאים לתנאי רשת שונים, מה שהופך אותו ליעיל ביותר הן בסביבות מקומיות והן בסביבות מבוססות ענן. בארכיטקטורת SMDDP (כפי שמוצג באיור הבא), האימון המבוזר מוגדל גם הוא באמצעות אשכול של צמתים רבים. המשמעות היא לא רק מספר GPUs במופע מחשוב, אלא מופעים רבים עם מספר GPUs, מה שמאיץ עוד יותר את האימון.

למידע נוסף על ארכיטקטורה זו, עיין ב מבוא לספריית הנתונים המקבילים של SageMaker.

עם SMDDP, הצלחנו להפחית באופן משמעותי את זמן האימון עבור מודל ה-TTDP שלנו, מה שהופך אותו למהיר פי שמונה. זמני אימון מהירים יותר פירושם שנוכל לחזור ולשפר את המודלים שלנו מהר יותר, מה שמוביל להמלצות עבודה טובות יותר עבור המשתמשים שלנו בפרק זמן קצר יותר. רווח התייעלות זה מסייע בשמירה על התחרותיות של מנוע המלצות העבודה שלנו בשוק העבודה המתפתח במהירות.

אתה יכול להתאים את סקריפט האימון שלך עם SMDDP עם שלוש שורות קוד בלבד, כפי שמוצג בבלוק הקוד הבא. באמצעות PyTorch כדוגמה, הדבר היחיד שאתה צריך לעשות הוא לייבא את הלקוח PyTorch של ספריית SMDDP (smdistributed.dataparallel.torch.torch_smddp). הלקוח נרשם smddp בתור קצה אחורי עבור PyTorch.

לאחר שיש לך סקריפט PyTorch עובד המותאם לשימוש בספריית הנתונים המקבילים המבוזרים, תוכל השקת עבודת הדרכה מבוזרת באמצעות SageMaker Python SDK.

הערכת ביצועי המודל

כאשר מעריכים את הביצועים של מערכת המלצות, חיוני לבחור מדדים המתאימים באופן הדוק ליעדים העסקיים ומספקים הבנה ברורה של יעילות המודל. במקרה שלנו, אנו משתמשים ב-AUC כדי להעריך את ביצועי חיזוי הקליקים של מודל ה-TTDP שלנו וב-mAP@K כדי להעריך את האיכות של רשימת המשרות הסופית המדורגת.

ה-AUC מתייחס לאזור מתחת לעקומת מאפיין הפעולה של המקלט (ROC). זה מייצג את ההסתברות שדוגמה חיובית שנבחרה באקראי תדורג גבוה יותר מדוגמה שלילית שנבחרה באקראי. הוא נע בין 0-1, כאשר 1 מציין מסווג אידיאלי ו-0.5 מייצג ניחוש אקראי. mAP@K הוא מדד נפוץ להערכת האיכות של מערכות אחזור מידע, כמו מנוע המלצת העבודה שלנו. הוא מודד את הדיוק הממוצע של אחזור ה-K הפריטים הרלוונטיים המובילים עבור שאילתה או משתמש נתון. הוא נע בין 0-1, כאשר 1 מציין דירוג אופטימלי ו-0 מציין את הדיוק הנמוך ביותר האפשרי בערך K הנתון. אנו מעריכים את ה-AUC, mAP@1 ו-mAP@3. ביחד, מדדים אלו מאפשרים לנו לאמוד את יכולתו של המודל להבחין בין מחלקות חיוביות לשליליות (AUC) ואת הצלחתו בדירוג הפריטים הרלוונטיים ביותר בראש (mAP@K).

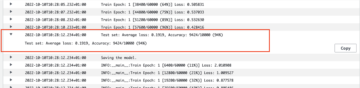

בהתבסס על ההערכה הלא מקוונת שלנו, מודל TTDP עלה על המודל הבסיסי - מודל הייצור הקיים מבוסס XGBoost - ב-16.65% עבור AUC, 20% עבור mAP@1 ו-11.82% עבור mAP@3.

יתר על כן, תכננו מבחן A/B מקוון כדי להעריך את המערכת המוצעת והרצנו את הבדיקה על אחוז מאוכלוסיית האימייל בארה"ב במשך 6 שבועות. בסך הכל נשלחו כ-22 מיליון מיילים באמצעות העבודה המומלצת על ידי המערכת החדשה. העלייה שהתקבלה בקליקים בהשוואה למודל הייצור הקודם הייתה 8.6%. Talent.com מגדילה בהדרגה את אחוז ההפצה של המערכת החדשה לכל האוכלוסיה והערוצים שלה.

סיכום

יצירת מערכת המלצות לעבודה היא מאמץ מורכב. לכל מחפש עבודה יש צרכים ייחודיים, העדפות וחוויות מקצועיות שלא ניתן להסיק משאילתת חיפוש קצרה. בפוסט זה, Talent.com שיתפה פעולה עם AWS כדי לפתח פתרון מקצה לקצה מבוסס למידה עמוקה לממליצים על עבודה המדרג רשימות של משרות להמליץ למשתמשים. צוות Talent.com באמת נהנה לשתף פעולה עם צוות AWS לאורך כל תהליך פתרון הבעיה. זה מסמן אבן דרך משמעותית במסע הטרנספורמטיבי של Talent.com, שכן הצוות מנצל את הכוח של למידה עמוקה כדי להעצים את העסק שלו.

פרויקט זה כוונן עדין באמצעות SBERT ליצירת הטמעות טקסט. בזמן הכתיבה, AWS הציגה Embeddings של אמזון טיטאן כחלק מהמודלים הבסיסיים שלהם (FMs) המוצעים דרך סלע אמזון, שהוא שירות מנוהל במלואו המספק מבחר של מודלים בסיסיים בעלי ביצועים גבוהים מחברות AI מובילות. אנו מעודדים את הקוראים לחקור את טכניקות למידת המכונה המוצגות בפוסט זה בבלוג ולמנף את היכולות המסופקות על ידי AWS, כגון SMDDP, תוך שימוש במודלים הבסיסיים של AWS Bedrock כדי ליצור פונקציונליות חיפוש משלהם.

הפניות

על המחברים

יי שיאנג היא מדענית יישומית II במעבדת פתרונות למידת מכונה של אמזון, שם היא עוזרת ללקוחות AWS בתעשיות שונות להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

יי שיאנג היא מדענית יישומית II במעבדת פתרונות למידת מכונה של אמזון, שם היא עוזרת ללקוחות AWS בתעשיות שונות להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

טונג וואנג הוא מדען יישומי בכיר במעבדת פתרונות למידת מכונה של אמזון, שם הוא עוזר ללקוחות AWS בתעשיות שונות להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

טונג וואנג הוא מדען יישומי בכיר במעבדת פתרונות למידת מכונה של אמזון, שם הוא עוזר ללקוחות AWS בתעשיות שונות להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

דמיטרי בספלוב הוא מדען יישומי בכיר במעבדת פתרונות למידת מכונה של אמזון, שם הוא עוזר ללקוחות AWS בתעשיות שונות להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

דמיטרי בספלוב הוא מדען יישומי בכיר במעבדת פתרונות למידת מכונה של אמזון, שם הוא עוזר ללקוחות AWS בתעשיות שונות להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

אנטולי חומנקו הוא מהנדס למידת מכונה בכיר ב-Talent.com עם תשוקה לעיבוד שפה טבעית בהתאמת אנשים טובים לעבודות טובות.

אנטולי חומנקו הוא מהנדס למידת מכונה בכיר ב-Talent.com עם תשוקה לעיבוד שפה טבעית בהתאמת אנשים טובים לעבודות טובות.

עבדנור בז'וה הוא מנהל עם יותר מ-25 שנות ניסיון בבנייה ואספקה של פתרונות טכנולוגיים המותאמים למיליוני לקוחות. עבדנור כיהן בתפקיד מנהל הטכנולוגיה הראשי (CTO) ב Talent.com כאשר צוות AWS תכנן והוציא לפועל את הפתרון הספציפי הזה עבור Talent.com.

עבדנור בז'וה הוא מנהל עם יותר מ-25 שנות ניסיון בבנייה ואספקה של פתרונות טכנולוגיים המותאמים למיליוני לקוחות. עבדנור כיהן בתפקיד מנהל הטכנולוגיה הראשי (CTO) ב Talent.com כאשר צוות AWS תכנן והוציא לפועל את הפתרון הספציפי הזה עבור Talent.com.

דייל ז'אק הוא אסטרטג בכיר בינה מלאכותית במרכז החדשנות של AI Generative, שם הוא עוזר ללקוחות AWS לתרגם בעיות עסקיות לפתרונות AI.

דייל ז'אק הוא אסטרטג בכיר בינה מלאכותית במרכז החדשנות של AI Generative, שם הוא עוזר ללקוחות AWS לתרגם בעיות עסקיות לפתרונות AI.

יאנג'ון צ'י הוא מנהל בכיר למדע יישומי במעבדת פתרונות למידת מכונה של אמזון. היא מחדשת ומיישמת למידת מכונה כדי לעזור ללקוחות AWS להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

יאנג'ון צ'י הוא מנהל בכיר למדע יישומי במעבדת פתרונות למידת מכונה של אמזון. היא מחדשת ומיישמת למידת מכונה כדי לעזור ללקוחות AWS להאיץ את אימוץ הבינה המלאכותית והענן שלהם.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/from-text-to-dream-job-building-an-nlp-based-job-recommender-at-talent-com-with-amazon-sagemaker/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 1

- 100

- 11

- 16

- 2011

- 22

- 25

- 30

- 31

- 32

- 7

- 75

- 8

- a

- יכולת

- יכול

- אודות

- להאיץ

- דיוק

- מדויק

- לרוחב

- להסתגל

- מסתגל

- תוספת

- אימוץ

- מתקדם

- יתרון

- לאחר

- נגד

- AI

- אַלגוֹרִיתְם

- ליישר

- תעשיות

- להתיר

- מאפשר

- מאפשר

- גם

- למרות

- אמזון בעברית

- למידת מכונת אמזון

- אמזון SageMaker

- אמזון שירותי אינטרנט

- כמות

- an

- עוגן

- ו

- בקשה

- יישומית

- חל

- גישה

- בערך

- ארכיטקטורה

- ARE

- AREA

- סביב

- AS

- לְהַעֲרִיך

- שהוקצה

- At

- מושך

- וואו

- מכני עם סלילה אוטומטית

- זמין

- מְמוּצָע

- AWS

- קצה אחורי

- מבוסס

- Baseline

- BE

- כי

- היה

- הטוב ביותר

- מוטב

- בֵּין

- לחסום

- בלוג

- שניהם

- בִּניָן

- נבנה

- עסקים

- אבל

- by

- לחשב

- חישוב

- CAN

- מועמד

- מועמדים

- יכולות

- ללכוד

- נתפס

- לכידה

- אשר

- מקרה

- מרכז

- מרכזים

- אתגר

- ערוצים

- מאפיין

- רֹאשׁ

- מנהל טכנולוגיה ראשי

- בחרו

- נבחר

- כיתות

- מיון

- ברור

- קליק

- לקוחות

- לקוחות

- מקרוב

- ענן

- אימוץ ענן

- אשכול

- קוד

- שיתף פעולה

- שיתוף פעולה

- שיתוף פעולה

- יַחַד

- COM

- שילוב

- לשלב

- משולב

- משלב

- בדרך כלל

- תקשורת

- חברות

- חברה

- לְהַשְׁווֹת

- לעומת

- השוואה

- התחרותיות

- להשלים

- מורכב

- רכיבים

- חישובים

- לחשב

- מחשוב

- תנאים

- לנהל

- לְחַבֵּר

- כתוצאה מכך

- לבנות

- הכלול

- תוכן

- הקשר

- הקשרים

- קשר

- תורם

- ליבה

- תוֹאֵם

- מדינות

- לִיצוֹר

- מכריע

- ראש אגף טכנולוגיה

- זונה

- לקוחות

- נתונים

- הכנת נתונים

- datetime

- DDP

- דילים

- מוקדש

- עמוק

- למידה עמוקה

- לְהַגדִיר

- מוגדר

- אספקה

- לפרוס

- נגזר

- עיצוב

- מעוצב

- תכנון

- פרטים

- לפתח

- מפותח

- DID

- אחר

- נָדוֹן

- מרחק

- מובהק

- לְהַבחִין

- מופץ

- הכשרה מבוזרת

- הפצה

- הפצה

- do

- מסמך

- תחום

- חלום

- מונע

- בְּמַהֲלָך

- כל אחד

- מוקדם

- אפקטיבי

- יְעִילוּת

- יְעִילוּת

- יעיל

- אלמנטים

- אמייל

- מיילים

- הטבעה

- מעסיקים

- תעסוקה

- להסמיך

- לעודד

- מקצה לקצה

- מאמץ

- התקשרויות

- מנוע

- מהנדס

- מהונדס

- הנדסה

- מהנדסים

- להגביר את

- משפר

- לְהַבטִיחַ

- מבטיח

- ישויות

- ישות

- סביבה

- סביבות

- מקימים

- להעריך

- הערכה

- הערכה

- כל

- דוגמה

- יצא לפועל

- מנהלים

- קיימים

- ניסיון

- חוויות

- מומחים

- לחקור

- אֶקְסְפּרֶסִיבִי

- תמצית

- מהר יותר

- מאפיין

- תכונות

- מעטים

- תרשים

- סופי

- גמישות

- להתמקד

- מרוכז

- הבא

- בעד

- כוחות

- ארבע

- מסגרת

- החל מ-

- לגמרי

- פונקציות

- נוסף

- לְהַשִׂיג

- מד

- ליצור

- מייצר

- יצירת

- גנרטטיבית

- AI Generative

- נתן

- נותן

- שערים

- טוב

- GPU

- GPUs

- בהדרגה

- יש

- he

- ראש

- הוחזק

- לעזור

- עזר

- עזרה

- עוזר

- גָבוֹהַ

- ביצועים גבוהים

- גבוה יותר

- מאוד

- היסטורי

- היסטוריה

- איך

- איך

- אולם

- HTML

- http

- HTTPS

- אופטימיזציה של היפר-פרמטרים

- אידאל

- מזוהה

- לזהות

- if

- ii

- מדגים

- הפעלה

- יישום

- לייבא

- חשוב

- לשפר

- משופר

- שיפורים

- שיפור

- in

- כולל

- כולל

- להגדיל

- גדל

- עצמאי

- באופן עצמאי

- מצביע על

- בנפרד

- תעשיות

- ספציפית לתעשייה

- מידע

- הטמון

- חדשנות

- קלט

- תשומות

- למשל

- אינסטרומנטלי

- כוונה

- אינטראקציה

- יחסי גומלין

- אינטרס

- מעוניין

- אינטרסים

- אל תוך

- הציג

- IT

- פריטים

- שֶׁלָה

- בז'רגון

- עבודה

- רישום עבודה

- כותרות עבודה

- מקומות תעסוקה

- הצטרף

- משותף

- מסע

- רק

- שמור

- מפתח

- מילות מפתח

- ידוע

- מעבדה

- תווית

- שפה

- שפות

- גָדוֹל

- הגדול ביותר

- לבסוף

- מוביל

- לִלמוֹד

- למידה

- רמה

- תנופה

- סִפְרִיָה

- כמו

- מוגבל

- קווים

- רשימה

- ברשימה

- רישום

- רישומים

- רשימות

- לִטעוֹן

- מיקום

- אבדות

- נמוך

- הנמוך ביותר

- מכונה

- למידת מכונה

- ראשי

- שמירה

- לעשות

- עשייה

- הצליח

- מנהל

- רב

- מיפוי

- שוק

- להתאים

- גפרורים

- תואם

- מתמטיקה

- דבר

- מאי..

- אומר

- משמעותי

- משמעויות

- אומר

- למדוד

- אמצעים

- שיטה

- מתודולוגיות

- מֵתוֹדוֹלוֹגִיָה

- מטרי

- מדדים

- יכול

- ציון דרך

- מִילִיוֹן

- מיליונים

- משימה

- ML

- מודל

- דוגמנות

- מודלים

- יותר

- רוב

- מספר

- שם

- שם

- שמות

- טבעי

- עיבוד שפה טבעית

- צורך

- צרכי

- שלילי

- תשלילים

- רשת

- רשתות

- עצבי

- רשתות עצביות

- חדש

- הבא

- NLP

- צמתים

- רעש

- ניואנסים

- מושג

- מקצוע

- of

- הַצָעָה

- מוצע

- קָצִין

- לא מחובר

- on

- ONE

- באינטרנט

- רק

- פתיחה

- פועל

- הזדמנויות

- אופטימלי

- אופטימיזציה

- אופטימיזציה

- מייעל

- or

- להזמין

- שלנו

- לשאת

- הַחוּצָה

- ביצועים טובים יותר

- תפוקה

- פלטים

- יותר

- מקיף

- להתגבר על

- סקירה

- שֶׁלוֹ

- נפרע

- זוג

- מקביל

- פרמטרים

- הגדול ביותר

- חלק

- מסוים

- עבר

- תשוקה

- עבר

- תבנית

- אֲנָשִׁים

- אחוזים

- לְבַצֵעַ

- ביצועים

- אישית

- לְחַבֵּר

- פלטפורמה

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- משחק

- פופולריות

- אוכלוסייה

- עמדה

- חיובי

- אפשרי

- הודעה

- פוטנציאל

- כּוֹחַ

- חזק

- דיוק

- לחזות

- חזה

- נבואה

- העדפות

- הכנה

- להציג

- מוצג

- קודם

- ראשוני

- בעיה

- בעיות

- הליך

- תהליך

- תהליכים

- תהליך

- מיוצר

- הפקה

- מקצועי

- פּרוֹפִיל

- פּרוֹיֶקט

- מוּצָע

- לספק

- ובלבד

- מספק

- מתן

- ציבורי

- פיתון

- פיטורך

- Qi

- איכות

- שאילתות

- מהירות

- אקראי

- מדורג

- דירוג

- דרגות

- ציון

- חי

- הקוראים

- הכרה

- להמליץ

- המלצה

- המלצות

- מוּמלָץ

- להפחית

- מפחית

- הפחתה

- להתייחס

- מתייחס

- מעודן

- רושמים

- קשר

- מערכות יחסים

- הרלוונטיות

- רלוונטי

- אמינות

- משוכפל

- מייצג

- תוצאה

- וכתוצאה מכך

- תוצאות

- תפקיד

- תפקידים

- גָלִיל

- ריצה

- בעל חכמים

- SageMaker כוונון דגם אוטומטי

- אותו

- סולם

- תזמון

- מדע

- מַדְעָן

- מדענים

- תסריט

- חיפוש

- חיפושים

- סעיף

- סעיפים

- מבחר

- לחצני מצוקה לפנסיונרים

- נשלח

- משמש

- שרות

- שירותים

- סט

- סטים

- התקנה

- היא

- קצר

- לְהַצִיג

- הראה

- הופעות

- משמעותי

- באופן משמעותי

- יחיד

- קטן יותר

- פִּתָרוֹן

- פתרונות

- פותר

- מקורות

- מֶרחָב

- ספציפי

- במיוחד

- פירוט

- מְהִירוּת

- מהירויות

- תֶקֶן

- מדינה-of-the-art

- שלב

- סְתִימָה

- מאוחסן

- תַכסִיסָן

- חוזק

- מחרוזת

- נושא

- באופן משמעותי

- הצלחה

- כזה

- סִנכְּרוּן

- מערכת

- מערכות

- לקחת

- לוקח

- כִּשָׁרוֹן

- המשימות

- נבחרת

- טכניקות

- טכנולוגיה

- מבחן

- בדיקות

- טֶקסט

- טקסטואלית

- מֵאֲשֶׁר

- זֶה

- השמיים

- האזור

- המידע

- שֶׁלָהֶם

- אותם

- אז

- אלה

- הֵם

- דבר

- זֶה

- שְׁלוֹשָׁה

- דרך

- בכל

- זמן

- פִּי

- עֲנָק

- כותרת

- כותרות

- ל

- יַחַד

- חלק עליון

- לפיד

- סה"כ

- מגדל

- רכבת

- הדרכה

- טרנספורמטיבית

- לתרגם

- לְשַׁלֵשׁ

- באמת

- שתיים

- סוגים

- תחת

- להבין

- הבנה

- מבין

- ייחודי

- ללא תחרות

- בקרוב ב

- הִתרוֹמְמוּת רוּחַ

- us

- להשתמש

- מְשׁוּמָשׁ

- משתמש

- משתמשים

- שימושים

- באמצעות

- בְּדֶרֶך כְּלַל

- לנצל

- מנצל

- בעל ערך

- ערך

- באמצעות

- vs

- היה

- we

- אינטרנט

- שירותי אינטרנט

- שבועות

- היו

- מתי

- ואילו

- אשר

- בזמן

- יצטרך

- עם

- בתוך

- עובד

- של העולם

- כתיבה

- שנים

- אתה

- זפירנט