היום, אנו מכריזים על זמינותן של מחברות לדוגמה המדגימות משימות מענה לשאלות תוך שימוש בגישה מבוססת Retrieval Augmented Generation (RAG) עם מודלים של שפה גדולה (LLMs) ב אמזון SageMaker JumpStart. הפקת טקסט באמצעות RAG עם LLMs מאפשרת לך ליצור פלטי טקסט ספציפיים לתחום על ידי אספקת נתונים חיצוניים ספציפיים כחלק מההקשר המוזן ל-LLMs.

JumpStart הוא רכזת למידת מכונה (ML) שיכולה לעזור לך להאיץ את מסע ה-ML שלך. JumpStart מספקת מודלים רבים של שפה מאומנים מראש הנקראים דגמי יסוד שיכול לעזור לך לבצע משימות כמו סיכום מאמרים, מענה על שאלות ויצירת שיחות ויצירת תמונות.

בפוסט זה, אנו מתארים את RAG ואת יתרונותיו, ומדגים כיצד להתחיל במהירות על ידי שימוש במחברת לדוגמה כדי לפתור משימת מענה לשאלות באמצעות הטמעת RAG עם LLMs ב-Jumpstart. אנו מציגים שתי גישות:

- כיצד לפתור את הבעיה עם קוד פתוח LangChain ספרייה ו אמזון SageMaker נקודות קצה בכמה שורות קוד

- כיצד להשתמש באלגוריתם SageMaker KNN לביצוע חיפוש סמנטי אחר נתונים בקנה מידה גדול באמצעות נקודות קצה של SageMaker

LLMS ואילוצים

LLMs מאומנים על כמויות גדולות של נתונים לא מובנים והם מצוינים ביצירת טקסט כללי. לימודי LLM יכולים לאחסן ידע עובדתי על ידי אימון הפרמטרים שלהם על קורפוס גדול של נתוני שפה טבעית.

ישנן מספר מגבלות של שימוש ב-LLMs שהוכשרו מראש על המדף:

- הם בדרך כלל מאומנים במצב לא מקוון, מה שהופך את המודל לאגנוסטי למידע העדכני ביותר (לדוגמה, לצ'אטבוט שאומן בין השנים 2011-2018 אין מידע על COVID-19).

- הם עורכים תחזיות רק על ידי חיפוש מידע המאוחסן בפרמטרים שלו, מה שמוביל לפרשנות נחותה.

- הם מאומנים בעיקר על קורפוסי תחום כללי, מה שהופך אותם לפחות יעילים במשימות ספציפיות לתחום. ישנם תרחישים שבהם אתה רוצה שמודלים ייצרו טקסט על סמך נתונים ספציפיים ולא נתונים גנריים. לדוגמה, חברת ביטוח בריאות עשויה לרצות שהבוט המשיב לשאלות יענה על שאלות באמצעות המידע העדכני ביותר המאוחסן במאגר המסמכים הארגוני או במסד הנתונים שלה, כך שהתשובות מדויקות וישקפו את הכללים העסקיים הייחודיים שלה.

נכון לעכשיו, ישנן שתי דרכים פופולריות להתייחס לנתונים ספציפיים ב-LLMs:

- הכנס נתונים כהקשר בהנחיית המודל כדרך לספק את המידע שהמודל יכול להשתמש בו בזמן יצירת התוצאה

- דק את המודל על ידי אספקת קובץ עם צמדי הבהרה והשלמה

האתגר של הגישה מבוססת ההקשר הוא שמודלים מגיעים עם גודל הקשר מוגבל, ולכלול את כל המסמכים כהקשר עשוי שלא להתאים לגודל ההקשר המותר של המודל. בהתאם לדגם המשמש, עשויה להיות גם עלות נוספת עבור הקשר גדול יותר.

עבור הגישה של כוונון עדין, יצירת המידע בפורמט הנכון גוזלת זמן וכרוכה בעלויות. בנוסף, אם נתונים חיצוניים המשמשים לכוונון עדין משתנים בתדירות גבוהה, זה מרמז על כוונון עדין תכוף ואימון מחדש כדי ליצור תוצאות מדויקות. אימון תכוף משפיע על מהירות היציאה לשוק ומוסיף לעלות הפתרון הכוללת.

כדי להדגים אילוצים אלה, השתמשנו בדגם LLM Flan T5 XXL ושאלנו את השאלה הבאה:

אנו מקבלים את התגובה הבאה:

כפי שאתה יכול לראות, התגובה אינה מדויקת. התשובה הנכונה צריכה להיות כל המופעים של SageMaker תומכים ב-Managed Spot Training.

ניסינו את אותה שאלה אבל עם הקשר נוסף שהועבר יחד עם השאלה:

קיבלנו הפעם את התגובה הבאה:

התגובה טובה יותר אבל עדיין לא מדויקת. עם זאת, במקרים אמיתיים של שימוש בייצור, משתמשים עשויים לשלוח שאילתות שונות, וכדי לספק תשובות מדויקות, ייתכן שתרצה לכלול את כל המידע הזמין או את רובו כחלק מההקשר הסטטי כדי ליצור תגובות מדויקות. לכן, עם גישה זו, אנו עשויים לפגוע במגבלה של מגבלת גודל ההקשר מכיוון שאפילו מידע לא רלוונטי לשאלה שנשאלה נשלח כחלק מההקשר. זה המקום שבו אתה יכול להשתמש בגישה מבוססת RAG כדי ליצור תגובות מדרגיות ומדויקות לשאילתות של משתמש.

אחזור דור מוגבר

כדי לפתור את האילוצים שדנו בהם, נוכל להשתמש ב-Retrieval Augmented Generation (RAG) עם LLMs. RAG שואב נתונים מחוץ למודל השפה (לא פרמטרי) ומגדיל את ההנחיות על ידי הוספת הנתונים הרלוונטיים שאוחזרו בהקשר. דגמי RAG הוצגו על ידי Lewis et al. בשנת 2020 כמודל שבו זיכרון פרמטרי הוא מודל seq2seq מאומן מראש והזיכרון הלא פרמטרי הוא אינדקס וקטור צפוף של ויקיפדיה, שאליו ניתן לגשת באמצעות רטריבר עצבי מאומן מראש.

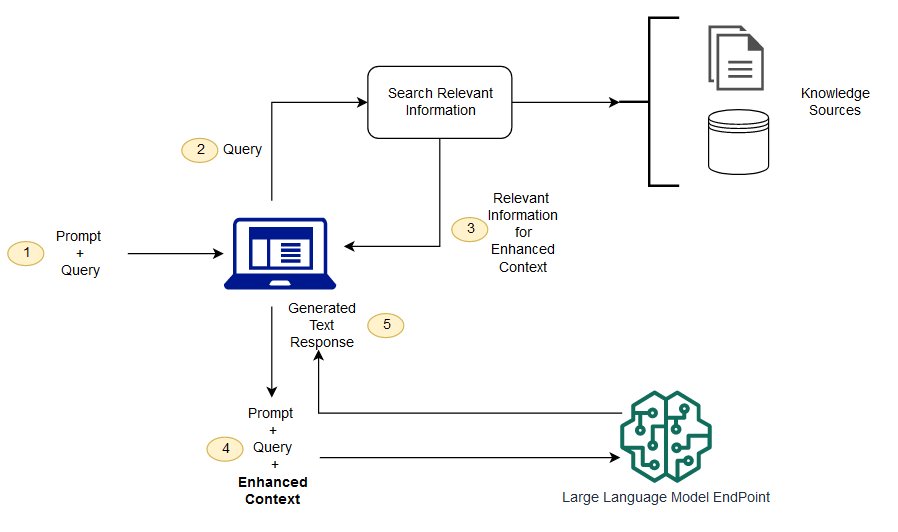

ב- RAG, הנתונים החיצוניים יכולים להגיע ממספר מקורות נתונים, כגון מאגר מסמכים, מסדי נתונים או ממשקי API. השלב הראשון הוא להמיר את המסמכים ואת שאילתת המשתמש בפורמט כדי שניתן יהיה להשוות ביניהם ולבצע חיפוש רלוונטיות. כדי להפוך את הפורמטים להשוות לביצוע חיפוש רלוונטיות, אוסף מסמכים (ספריית ידע) והשאילתה שנשלחה על ידי המשתמש מומרים לייצוג מספרי באמצעות מודלים של שפות הטבעה. ההטבעות הן בעצם ייצוגים מספריים של מושג בטקסט. לאחר מכן, בהתבסס על הטמעת שאילתת המשתמש, הטקסט הרלוונטי שלה מזוהה באוסף המסמכים על ידי חיפוש דמיון במרחב ההטמעה. לאחר מכן, ההנחיה שסופק על ידי המשתמש מצורף לטקסט רלוונטי שחיפשו והוא מתווסף להקשר. ההנחיה נשלחת כעת ל-LLM ומכיוון שלקונטקסט יש נתונים חיצוניים רלוונטיים יחד עם ההנחיה המקורית, פלט המודל רלוונטי ומדויק.

כדי לשמור על מידע עדכני עבור מסמכי העזר, ניתן לעדכן את המסמכים באופן אסינכרוני ולעדכן ייצוג הטבעה של המסמכים. בדרך זו, המסמכים המעודכנים ישמשו ליצירת תשובות לשאלות עתידיות כדי לספק תשובות מדויקות.

התרשים הבא מציג את הזרימה הרעיונית של שימוש ב- RAG עם LLMs.

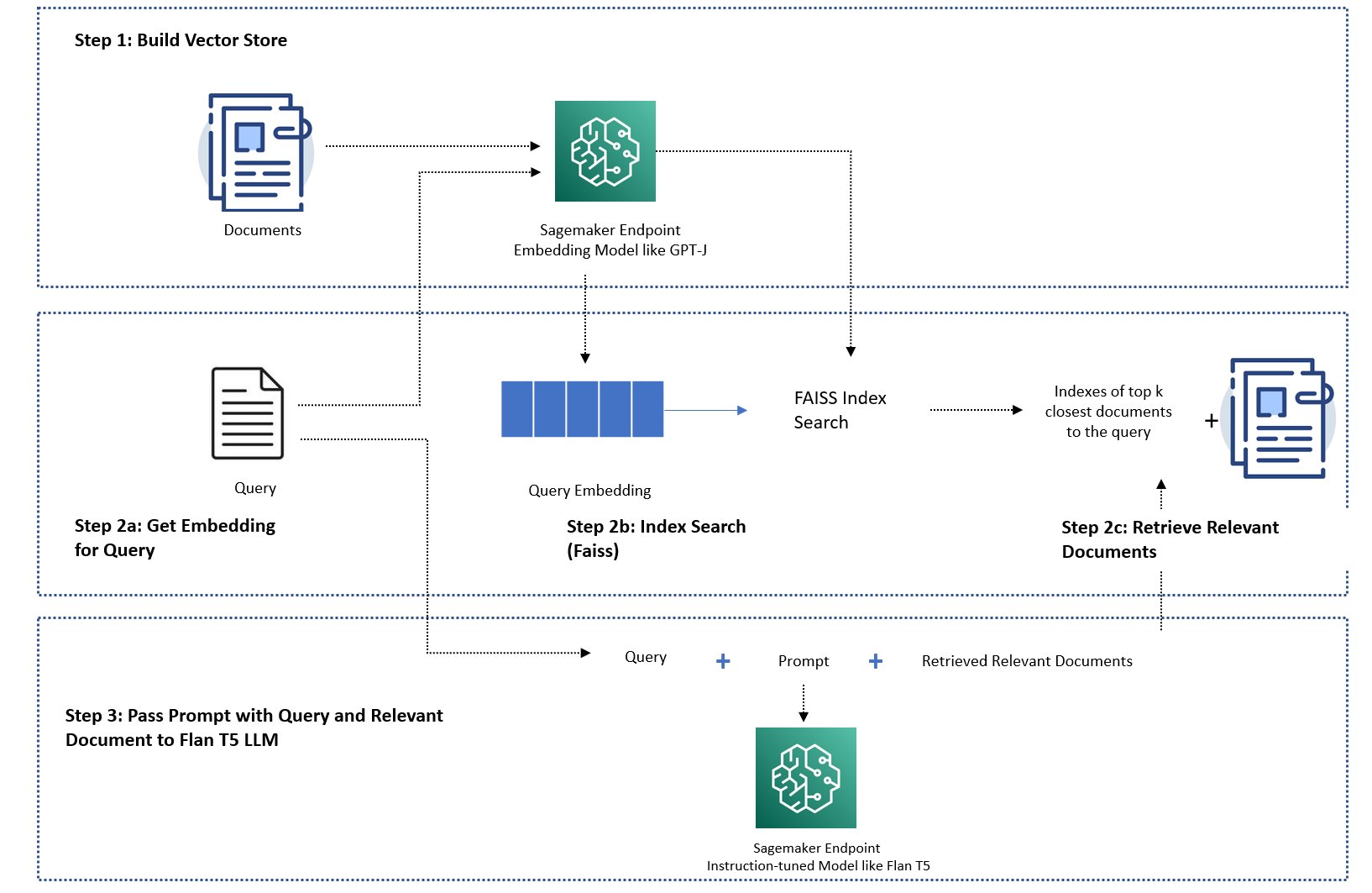

בפוסט זה, אנו מדגימים כיצד ליישם אפליקציית מענה לשאלות באמצעות השלבים הבאים:

- צור הטבעה עבור כל מסמך בספריית הידע עם מודל הטבעה של SageMaker GPT-J-6B.

- זהה את K המסמכים הרלוונטיים ביותר על סמך שאילתת המשתמש.

- עבור השאילתה שלך, צור את ההטמעה של השאילתה באמצעות אותו מודל הטמעה.

- חפש באינדקסים של K המסמכים הרלוונטיים ביותר במרחב ההטמעה באמצעות חיפוש FAISS בזיכרון.

- השתמש באינדקסים כדי לאחזר את המסמכים המתאימים.

- השתמש במסמכים הרלוונטיים שאוחזרו כהקשר עם ההנחיה והשאלה, ושלח אותם ל- SageMaker LLM כדי ליצור את התגובה.

אנו מדגימים את הגישות הבאות:

- כיצד לפתור משימת מענה לשאלות עם SageMaker LLMs והטמעת נקודות קצה וספריית הקוד הפתוח LangChain בכמה שורות קוד. בפרט, אנו משתמשים בשתי נקודות קצה של SageMaker עבור מודל ה-LLM (Flan T5 XXL) והטמעה (GPT-J 6B), ומסד הנתונים הווקטוריים בו נעשה שימוש הוא בזיכרון FAISS. לפרטים נוספים, ראה את GitHub ריפו.

- אם ה-FAISS בזיכרון אינו מתאים למערך הנתונים הגדול שלך, אנו מספקים לך א אלגוריתם SageMaker KNN כדי לבצע את החיפוש הסמנטי, המשתמש גם ב-FAISS בתור אלגוריתם החיפוש הבסיסי. לפרטים, ראה את GitHub ריפו.

התרשים הבא מתאר את ארכיטקטורת הפתרון.

מחברת יישום מבוססת RAG JumpStart עם LangChain

LangChain היא מסגרת קוד פתוח לפיתוח יישומים המופעלים על ידי מודלים של שפה. LangChain מספקת ממשק גנרי עבור LLMs רבים ושונים. זה גם מקל על מפתחים לשרשר LLMs שונים יחד ולבנות יישומים רבי עוצמה. LangChain מספקת ממשק סטנדרטי לזיכרון ואוסף של יישומי זיכרון כדי להתמיד במצב בין קריאות של סוכנים או רשתות.

ל-LangChain יש תכונות שירות רבות אחרות שיכולות להוסיף לפרודוקטיביות של מפתחים. תכונות אלו כוללות תבנית הנחיות המסייעת להתאים אישית הנחיות באמצעות משתנים בתבנית ההנחיות, סוכנים לבניית יישומים מקצה לקצה, אינדקסים לשלבי חיפוש ושליפה של השרשרת ועוד ועוד. כדי לחקור עוד יותר את יכולות LangChain, עיין ב- תיעוד LangChain.

צור מודל LLM

כצעד ראשון, פרוס את מודל JumpStart LLM לבחירתך. בהדגמה זו, אנו משתמשים בנקודת קצה של Jumpstart Flan T5 XXL. להוראות פריסה, עיין ב הנחיה אפסית לדגם הבסיס Flan-T5 באמזון SageMaker JumpStart. בהתבסס על מקרה השימוש שלך, אתה יכול גם לפרוס דגמים אחרים המותאמים להוראות כמו פלאן T5 UL2 or BloomZ 7B1. לפרטים, עיין ב מחברת דוגמה.

כדי להשתמש בנקודת הקצה SageMaker LLM עם LangChain, אנו משתמשים langchain.llms.sagemaker_endpoint.SagemakerEndpoint, אשר מפשט את נקודת הקצה SageMaker LLM. עלינו לבצע טרנספורמציה עבור מטען הבקשה והתגובה כפי שמוצג בקוד הבא עבור שילוב LangChain SageMaker. שים לב שייתכן שתצטרך להתאים את הקוד ContentHandler המבוסס על content_type ומקבל את הפורמט של מודל ה-LLM שבו תבחר להשתמש.

צור את מודל ההטמעה

לאחר מכן, עלינו להכין את הדגם המוטבע שלנו. אנו פורסים את GPT-J 6B דגם כדגם ההטמעה. אם אתה משתמש במודל הטמעה של JumpStart, עליך להתאים אישית את מחלקת הטבעת נקודות הקצה של LangChain SageMaker ולשנות את בקשת המודל והתגובה להשתלבות עם LangChain. ליישום מפורט, עיין ב GitHub ריפו.

טען מסמכים ספציפיים לתחום באמצעות טוען המסמכים LangChain וצור אינדקס

אנו משתמשים CSVLoader חבילה ב-LangChain לטעינת מסמכים בפורמט CSV לתוך טוען המסמכים:

לאחר מכן, אנו משתמשים ב-TextSplitter כדי לעבד נתונים מראש למטרות הטמעה ולהשתמש במודל ההטמעה של SageMaker GPT-J -6B כדי ליצור את ההטמעה. אנו מאחסנים הטמעה בחנות וקטורית של FAISS ליצירת אינדקס. אנו משתמשים באינדקס זה כדי למצוא מסמכים רלוונטיים הדומים מבחינה סמנטית לשאילתה של המשתמש.

הקוד הבא מראה כיצד כל השלבים הללו נעשים על ידי ה VectorstoreIndexCreator מחלקה בכמה שורות קוד בלבד ב-LangChain כדי ליצור יישום תמציתי של מענה לשאלות עם RAG:

השתמש באינדקס כדי לחפש הקשר רלוונטי ולהעביר אותו למודל LLM

לאחר מכן, השתמשו בשיטת השאילתה באינדקס שנוצר והעבירו את שאלת המשתמש ואת נקודת הקצה של SageMaker LLM. LangChain בוחר את ארבעת המסמכים הקרובים ביותר (K=4) ומעביר את ההקשר הרלוונטי שחולץ מהמסמכים כדי ליצור תגובה מדויקת. ראה את הקוד הבא:

אנו מקבלים את התגובה הבאה עבור השאילתה באמצעות הגישה מבוססת RAG עם Flan T5 XXL:

התגובה נראית מדויקת יותר בהשוואה לתגובה שקיבלנו עם גישות אחרות שהדגמנו קודם לכן שאין להן הקשר או הקשר סטטי שאולי לא תמיד רלוונטי.

גישה חלופית ליישום RAG עם יותר התאמה אישית באמצעות SageMaker ו-LangChain

בחלק זה, אנו מראים לך גישה נוספת ליישום RAG באמצעות SageMaker ו-LangChain. גישה זו מציעה את הגמישות להגדיר את הפרמטרים המובילים של K לחיפוש רלוונטיות במסמכים. זה גם מאפשר לך להשתמש בתכונה LangChain של תבניות בקשות, המאפשרים לך להגדיר בקלות את יצירת ההנחיה במקום לקוד קשיח של ההנחיות.

בקוד הבא, אנו משתמשים במפורש ב-FAISS כדי ליצור הטמעה עבור כל אחד מהמסמכים בספריית הידע עם מודל ההטמעה של SageMaker GPT-J-6B. לאחר מכן אנו מזהים את המסמכים העליונים (K=3) הרלוונטיים ביותר בהתבסס על שאילתת המשתמש.

לאחר מכן, אנו משתמשים בתבנית הנחיה ומשרשרים אותה עם SageMaker LLM:

אנו שולחים את שלושת המסמכים הרלוונטיים המובילים (K=3) שמצאנו כהקשר להנחיה באמצעות שרשרת LangChain:

עם גישה זו של הטמעת RAG, הצלחנו לנצל את הגמישות הנוספת של תבניות הנחיה של LangChain ולהתאים אישית את מספר המסמכים שחיפשו אחר התאמת רלוונטיות באמצעות ההיפרפרמטר העליון K.

מחברת הטמעה מבוססת JumpStart RAG עם SageMaker KNN

בחלק זה, אנו מיישמים את הגישה מבוססת RAG תוך שימוש באלגוריתם KNN למציאת מסמכים רלוונטיים ליצירת הקשר משופר. בגישה זו, אנחנו לא משתמשים ב-LangChain, אבל אנחנו משתמשים באותו מערך נתונים שאלות נפוצות של אמזון SageMaker כמסמכי ידע, הטמעת הדגמים GPT-J-6B ו-LLM Flan T5 XXL בדיוק כפי שעשינו בגישת LangChain הקודמת.

אם יש לך מערך נתונים גדול, ה- אלגוריתם SageMaker KNN עשוי לספק לך חיפוש סמנטי יעיל. אלגוריתם SageMaker KNN משתמש גם ב-FAISS בתור אלגוריתם החיפוש הבסיסי. את המחברת לפתרון זה ניתן למצוא ב GitHub.

ראשית, אנו פורסים את דגמי ההטמעה של LLM Flan T5 XXL ו-GPT-J 6B באותו אופן כמו בסעיף הקודם. עבור כל רשומה במסד הנתונים, אנו יוצרים וקטור הטמעה באמצעות מודל ההטמעה GPT-J.

לאחר מכן, אנו משתמשים ב-a SageMaker KNN עבודת הדרכה לאינדקס הטמעת נתוני הידע. האלגוריתם הבסיסי המשמש לאינדקס הנתונים הוא FAISS. אנחנו רוצים למצוא את חמשת המסמכים הרלוונטיים ביותר, אז קבענו את TOP_K משתנה ל-5. אנו יוצרים את האומדן עבור אלגוריתם KNN, מפעילים את עבודת ההדרכה ופורסים את מודל KNN כדי למצוא אינדקסים של חמשת המסמכים המובילים התואמים את השאילתה. ראה את הקוד הבא:

לאחר מכן, אנו יוצרים ייצוג הטבעה של השאילתה באמצעות מודל ההטמעה GPT-J-6B בו השתמשנו ליצירת הטבעה של מסמכי ספריית הידע:

לאחר מכן אנו משתמשים בנקודת הקצה של KNN ומעבירים את הטבעת השאילתה לנקודת הקצה של KNN כדי לקבל את האינדקסים של K המסמכים הרלוונטיים ביותר. אנו משתמשים באינדקסים כדי לאחזר את המסמכים הטקסטואליים התואמים. לאחר מכן, אנו משרשרים את המסמכים, ומבטיחים שלא יחרוג מהאורך המרבי המותר של ההקשר. ראה את הקוד הבא:

כעת אנו מגיעים לשלב האחרון שלנו בו אנו משלבים את השאילתה, ההנחיה וההקשר המכיל טקסט ממסמכים רלוונטיים ומעבירים אותו למודל יצירת הטקסט LLM Flan T5 XXL כדי ליצור את התשובה.

אנו מקבלים את התגובה הבאה עבור השאילתה באמצעות גישה מבוססת RAG עם Flan T5 XXL:

לנקות את

הקפד למחוק את נקודות הקצה שיצרנו במחברת זו כאשר אינך משתמש בהן כדי למנוע עלויות חוזרות.

סיכום

בפוסט זה, הדגמנו יישום של גישה מבוססת RAG עם LLMs למשימות מענה לשאלות תוך שימוש בשתי גישות: LangChain ואלגוריתם KNN המובנה. הגישה מבוססת RAG מייעלת את הדיוק של יצירת הטקסט באמצעות Flan T5 XXL על ידי מתן הקשר דינמי רלוונטי שנוצר על ידי חיפוש ברשימת מסמכים.

אתה יכול להשתמש במחברות אלה ב- SageMaker כפי שהן או שאתה יכול להתאים אותן לצרכים שלך. כדי להתאים אישית, אתה יכול להשתמש בסט משלך של מסמכים בספריית הידע, להשתמש ביישומי חיפוש רלוונטיות אחרים כמו OpenSearch, ולהשתמש במודלים אחרים של הטבעה ו-LLMs ליצירת טקסט הזמינים ב-JumpStart.

אנו מצפים לראות מה אתה בונה על JumpStart באמצעות גישה מבוססת RAG!

על המחברים

ד"ר שין הואנג הוא מדען יישומי בכיר עבור האלגוריתמים המובנים של Amazon SageMaker JumpStart ו-Amazon SageMaker. הוא מתמקד בפיתוח אלגוריתמים של למידת מכונה ניתנים להרחבה. תחומי העניין שלו במחקר הם בתחום של עיבוד שפה טבעית, למידה עמוקה הניתנת להסבר על נתונים טבלאיים וניתוח חזק של צבירת מרחב-זמן לא פרמטרית. הוא פרסם מאמרים רבים בכנסים של ACL, ICDM, KDD וב-Royal Statistic Society: Series A.

ד"ר שין הואנג הוא מדען יישומי בכיר עבור האלגוריתמים המובנים של Amazon SageMaker JumpStart ו-Amazon SageMaker. הוא מתמקד בפיתוח אלגוריתמים של למידת מכונה ניתנים להרחבה. תחומי העניין שלו במחקר הם בתחום של עיבוד שפה טבעית, למידה עמוקה הניתנת להסבר על נתונים טבלאיים וניתוח חזק של צבירת מרחב-זמן לא פרמטרית. הוא פרסם מאמרים רבים בכנסים של ACL, ICDM, KDD וב-Royal Statistic Society: Series A.

רחנה צ'דהא הוא ארכיטקט פתרונות ראשי AI/ML בחשבונות אסטרטגיים ב-AWS. רחנה היא אופטימית המאמינה ששימוש אתי ואחראי בבינה מלאכותית יכול לשפר את החברה בעתיד ולהביא לשגשוג כלכלי וחברתי. בזמנה הפנוי רחנה אוהבת לבלות עם משפחתה, לטייל ולהאזין למוזיקה.

רחנה צ'דהא הוא ארכיטקט פתרונות ראשי AI/ML בחשבונות אסטרטגיים ב-AWS. רחנה היא אופטימית המאמינה ששימוש אתי ואחראי בבינה מלאכותית יכול לשפר את החברה בעתיד ולהביא לשגשוג כלכלי וחברתי. בזמנה הפנוי רחנה אוהבת לבלות עם משפחתה, לטייל ולהאזין למוזיקה.

ד"ר קייל אולריך הוא מדען יישומי עם צוות האלגוריתמים המובנים של Amazon SageMaker. תחומי המחקר שלו כוללים אלגוריתמים של למידת מכונה ניתנים להרחבה, ראייה ממוחשבת, סדרות זמן, אי-פרמטריות בייסיאניות ותהליכי גאוס. הדוקטורט שלו הוא מאוניברסיטת דיוק והוא פרסם מאמרים ב-NeurIPS, Cell, and Neuron.

ד"ר קייל אולריך הוא מדען יישומי עם צוות האלגוריתמים המובנים של Amazon SageMaker. תחומי המחקר שלו כוללים אלגוריתמים של למידת מכונה ניתנים להרחבה, ראייה ממוחשבת, סדרות זמן, אי-פרמטריות בייסיאניות ותהליכי גאוס. הדוקטורט שלו הוא מאוניברסיטת דיוק והוא פרסם מאמרים ב-NeurIPS, Cell, and Neuron.

המנט סינג הוא מהנדס למידת מכונה עם ניסיון באלגוריתמים מובנים של Amazon SageMaker JumpStart ו-Amazon SageMaker. הוא קיבל את התואר השני שלו מ-Courant Institute of Mathematical Sciences ו-B.Tech מ- IIT Delhi. היה לו ניסיון בעבודה על מגוון רחב של בעיות למידת מכונה בתחום של עיבוד שפה טבעית, ראייה ממוחשבת וניתוח סדרות זמן.

המנט סינג הוא מהנדס למידת מכונה עם ניסיון באלגוריתמים מובנים של Amazon SageMaker JumpStart ו-Amazon SageMaker. הוא קיבל את התואר השני שלו מ-Courant Institute of Mathematical Sciences ו-B.Tech מ- IIT Delhi. היה לו ניסיון בעבודה על מגוון רחב של בעיות למידת מכונה בתחום של עיבוד שפה טבעית, ראייה ממוחשבת וניתוח סדרות זמן.

מנאס דאדרקר הוא מנהל פיתוח תוכנה בעל ההנדסה של שירות Amazon Forecast. הוא נלהב מהיישומים של למידת מכונה והפיכת טכנולוגיות ML לזמינות בקלות עבור כולם לאימוץ ולפריסה לייצור. מחוץ לעבודה, יש לו תחומי עניין מרובים, כולל טיולים, קריאה ובילוי עם חברים ובני משפחה.

מנאס דאדרקר הוא מנהל פיתוח תוכנה בעל ההנדסה של שירות Amazon Forecast. הוא נלהב מהיישומים של למידת מכונה והפיכת טכנולוגיות ML לזמינות בקלות עבור כולם לאימוץ ולפריסה לייצור. מחוץ לעבודה, יש לו תחומי עניין מרובים, כולל טיולים, קריאה ובילוי עם חברים ובני משפחה.

ד"ר אשיש חתן הוא מדען יישומי בכיר עם אלגוריתמים מובנים של Amazon SageMaker ועוזר בפיתוח אלגוריתמים של למידת מכונה. הוא קיבל את הדוקטורט שלו מאוניברסיטת אילינוי אורבנה-שמפיין. הוא חוקר פעיל בלמידת מכונה והסקה סטטיסטית, ופרסם מאמרים רבים בכנסים NeurIPS, ICML, ICLR, JMLR, ACL ו-EMNLP.

ד"ר אשיש חתן הוא מדען יישומי בכיר עם אלגוריתמים מובנים של Amazon SageMaker ועוזר בפיתוח אלגוריתמים של למידת מכונה. הוא קיבל את הדוקטורט שלו מאוניברסיטת אילינוי אורבנה-שמפיין. הוא חוקר פעיל בלמידת מכונה והסקה סטטיסטית, ופרסם מאמרים רבים בכנסים NeurIPS, ICML, ICLR, JMLR, ACL ו-EMNLP.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoAiStream. Web3 Data Intelligence. הידע מוגבר. גישה כאן.

- הטבעת העתיד עם אדריאן אשלי. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/question-answering-using-retrieval-augmented-generation-with-foundation-models-in-amazon-sagemaker-jumpstart/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 1

- 10

- 100

- 11

- 12

- 13

- 26%

- 500

- 7

- 8

- 9

- a

- יכול

- אודות

- תקצירים

- להאיץ

- מקבל

- נצפה

- חשבונות

- דיוק

- מדויק

- פעיל

- להוסיף

- הוסיף

- מוסיף

- תוספת

- נוסף

- מוסיף

- לְאַמֵץ

- יתרון

- יתרונות

- סוכנים

- AI

- AI / ML

- AL

- אַלגוֹרִיתְם

- אלגוריתמים

- תעשיות

- מאפשר

- לאורך

- גם

- תמיד

- אמזון בעברית

- תחזית אמזון

- אמזון SageMaker

- אמזון SageMaker JumpStart

- כמויות

- an

- אנליזה

- ו

- להכריז

- אחר

- לענות

- תשובות

- ממשקי API

- בקשה

- יישומים

- יישומית

- החל

- גישה

- גישות

- ארכיטקטורה

- ARE

- AREA

- מאמר

- AS

- At

- מוגבר

- זמינות

- זמין

- לְהִמָנַע

- AWS

- מבוסס

- בייסיאנית

- BE

- כי

- מאמין

- מוטב

- בֵּין

- בוט

- להביא

- לִבנוֹת

- מובנה

- עסקים

- אבל

- by

- נקרא

- שיחות

- CAN

- יכולות

- מקרה

- מקרים

- שרשרת

- שרשראות

- לאתגר

- שינויים

- chatbot

- בחירה

- בחרו

- בכיתה

- קיבוץ

- קוד

- סִמוּל

- אוסף

- לשלב

- איך

- חברה

- השוואה

- לעומת

- השלמה

- המחשב

- ראייה ממוחשבת

- מושג

- רעיוני

- כנסים

- אילוצים

- מכיל

- הקשר

- שיחה

- להמיר

- הומר

- לתקן

- תוֹאֵם

- עלות

- תקופת הקורונה

- לִיצוֹר

- נוצר

- יוצרים

- יצירה

- כיום

- התאמה אישית

- אישית

- נתונים

- מדע נתונים

- מסד נתונים

- מאגרי מידע

- עמוק

- למידה עמוקה

- דלהי

- להפגין

- מופגן

- תלוי

- לפרוס

- פרס

- פריסה

- לתאר

- מְפוֹרָט

- פרטים

- לפתח

- מפתח

- מפתחים

- מתפתח

- צעצועי התפתחות

- DID

- הבדל

- אחר

- נָדוֹן

- שונה

- מסמך

- מסמכים

- לא

- עושה

- תחום

- עשה

- דוכס

- אוניברסיטת דוכס

- באופן דינמי

- E&T

- כל אחד

- מוקדם יותר

- קל יותר

- בקלות

- אפקטיבי

- מוטבע

- הטבעה

- מאפשר

- מקצה לקצה

- נקודת קצה

- מהנדס

- הנדסה

- משופר

- הבטחתי

- מִפְעָל

- למעשה

- אֶתִי

- אֲפִילוּ

- כולם

- דוגמה

- חריג

- ניסיון

- לחקור

- חיצוני

- משפחה

- מאפיין

- תכונות

- הפד

- מעטים

- שלח

- סופי

- מציאת

- ראשון

- מתאים

- קבוע

- גמישות

- תזרים

- מתמקד

- הבא

- בעד

- תַחֲזִית

- פוּרמָט

- קדימה

- מצא

- קרן

- ארבע

- מסגרת

- תכוף

- בתדירות גבוהה

- חברים

- החל מ-

- נוסף

- עתיד

- כללי

- ליצור

- נוצר

- יצירת

- דור

- לקבל

- נתן

- גדול

- היה

- קשה

- יש

- he

- בְּרִיאוּת

- ביטוח בריאות

- לעזור

- עוזר

- לה

- גָבוֹהַ

- שֶׁלוֹ

- מכה

- איך

- איך

- אולם

- HTML

- HTTPS

- טבור

- i

- מזוהה

- לזהות

- if

- אילינוי

- תמונה

- השפעות

- ליישם

- הפעלה

- לייבא

- לשפר

- in

- לכלול

- כולל

- מדד

- אינדקסים

- מידע

- למשל

- במקום

- מכון

- הוראות

- ביטוח

- לשלב

- השתלבות

- אינטרסים

- מִמְשָׁק

- אל תוך

- הציג

- IT

- שֶׁלָה

- עבודה

- מסע

- jpg

- ג'סון

- רק

- ידע

- שפה

- גָדוֹל

- בקנה מידה גדול

- גדול יותר

- האחרון

- מוביל

- למידה

- אורך

- סִפְרִיָה

- כמו

- אוהב

- הגבלה

- מגבלות

- מוגבל

- גבולות

- קווים

- רשימה

- האזנה

- LLM

- לִטעוֹן

- מטעין

- מקומות

- נראה

- הסתכלות

- נראה

- נמוך

- מכונה

- למידת מכונה

- לתחזק

- לעשות

- עושה

- עשייה

- הצליח

- מנהל

- רב

- שוק

- להתאים

- תואם

- מתימטי

- מקסימום

- מאי..

- זכרון

- שיטה

- ML

- מודל

- מודלים

- יותר

- רוב

- הרבה

- מספר

- כלי נגינה

- טבעי

- עיבוד שפה טבעית

- צורך

- נחוץ

- צרכי

- הבא

- לא

- מחברה

- עַכשָׁיו

- מספר

- of

- המיוחדות שלנו

- לא מחובר

- on

- רק

- קוד פתוח

- מייעל

- or

- מְקוֹרִי

- אחר

- שלנו

- תפוקה

- בחוץ

- מקיף

- שֶׁלוֹ

- חבילה

- ניירות

- פרמטרים

- חלק

- מסוים

- לעבור

- עבר

- מעברי

- לוהט

- לְבַצֵעַ

- תוכניות

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- פופולרי

- הודעה

- מופעל

- חזק

- התחזיות

- חיזוי

- קודם

- מנהל

- בעיה

- בעיות

- תהליכים

- תהליך

- המוצר

- הפקה

- פִּריוֹן

- שגשוג

- לספק

- ובלבד

- מספק

- מתן

- לאור

- למטרות

- שאילתות

- שאלה

- שאלות

- מהירות

- רכס

- במקום

- קריאה

- מוכן

- ממשי

- שיא

- לשקף

- אזורים

- רלוונטי

- מאגר

- נציגות

- לבקש

- מחקר

- חוקר

- תגובה

- תגובות

- אחראי

- תוצאות

- לַחֲזוֹר

- חָסוֹן

- מלכותי

- כללי

- הפעלה

- בעל חכמים

- אותו

- חיסכון

- להרחבה

- תרחישים

- מדע

- מדעים

- מַדְעָן

- חיפוש

- חיפוש

- סעיף

- סעיפים

- לִרְאוֹת

- ראות

- נבחר

- עצמי

- לשלוח

- לחצני מצוקה לפנסיונרים

- רצף

- סדרה

- סדרה א '

- שרות

- שירותים

- סט

- צריך

- לְהַצִיג

- הראה

- הופעות

- דומה

- מידה

- So

- חֶברָתִי

- חֶברָה

- תוכנה

- פיתוח תוכנה

- פִּתָרוֹן

- לפתור

- מקורות

- מֶרחָב

- ספציפי

- מְהִירוּת

- הוצאה

- מסחרי

- תֶקֶן

- החל

- מדינה

- סטטיסטי

- שלב

- צעדים

- עוד

- חנות

- מאוחסן

- אסטרטגי

- מנוי

- כזה

- אספקה

- תמיכה

- נתמך

- לקחת

- המשימות

- משימות

- נבחרת

- טק

- טכנולוגיות

- תבנית

- תבניות

- מֵאֲשֶׁר

- זֶה

- השמיים

- האזור

- המידע

- המדינה

- שֶׁלָהֶם

- אותם

- אז

- שם.

- לכן

- אלה

- הֵם

- זֶה

- שְׁלוֹשָׁה

- זמן

- סדרת זמן

- ל

- יַחַד

- חלק עליון

- רכבת

- מְאוּמָן

- הדרכה

- לשנות

- טרנספורמציה

- ניסיתי

- שתיים

- בְּסִיסִי

- ייחודי

- אוניברסיטה

- עדכן

- עדכון

- מְעוּדכָּן

- נוֹהָג

- להשתמש

- במקרה להשתמש

- מְשׁוּמָשׁ

- משתמש

- משתמשים

- באמצעות

- בְּדֶרֶך כְּלַל

- תועלת

- שונים

- וירטואלי

- מכונה וירטואלית

- חזון

- רוצה

- היה

- דֶרֶך..

- דרכים

- we

- היו

- מה

- מתי

- אשר

- בזמן

- מי

- ויקיפדיה

- יצטרך

- עם

- בתוך

- תיק עבודות

- עובד

- היה

- אתה

- זפירנט