מדעני מחשבים גילו שמידע מוטעה שנוצר על ידי מודלים של שפה גדולה (LLMs) קשה יותר לזיהוי מאשר טענות שווא מלאכותיות שנוצרו ביד על ידי בני אדם.

החוקרים Canyu Chen, דוקטורנט במכון הטכנולוגי של אילינוי, וקאי שו, עוזר פרופסור במחלקה למדעי המחשב, יצאו לבדוק האם מידע מוטעה שנוצר על ידי LLM יכול לגרום יותר נזק מהמגוון הנוצר של מידע ספאם.

במאמר שכותרתו "האם ניתן לזהות מידע שנוצר על ידי LLM", הם מתמקדים באתגר של זיהוי מידע מוטעה - תוכן עם טעויות עובדתיות מכוונות או לא מכוונות - באופן חישובי. המאמר התקבל לוועידה הבינלאומית על ייצוגי למידה מאוחר יותר השנה.

זה לא רק תרגיל אקדמי. לימודי תואר שני כבר הצפה פעילה המערכת האקולוגית המקוונת עם תוכן מפוקפק. NewsGuard, א ניתוח מידע שגוי המשרד, אומר שעד כה היא "זיהתה 676 אתרי חדשות ומידע שנוצרו על ידי בינה מלאכותית הפועלים ללא פיקוח אנושי, ועוקבת אחר נרטיבים כוזבים שהופקו על ידי כלי בינה מלאכותית".

המידע השגוי במחקר נובע מהדרישה של ChatGPT ו-LLMs אחרים בקוד פתוח, כולל Llama ו-Vicuna, ליצור תוכן המבוסס על מערכי נתונים שגויים שנוצרו על ידי אדם, כגון Politifact, Gossipcop ו-CoAID.

שמונה גלאי LLM (ChatGPT-3.5, GPT-4, Llama2-7B ו-Llama2-13B, תוך שימוש בשני מצבים שונים) התבקשו לאחר מכן להעריך את הדגימות האנושיות והמכונה.

לדוגמאות אלה יש את אותם פרטים סמנטיים - אותה משמעות אך בסגנונות שונים ובטון ובניסוח מגוונים - בשל הבדלים ביצירתיות וההנחיות שניתנו ל-LLM המייצרים את התוכן.

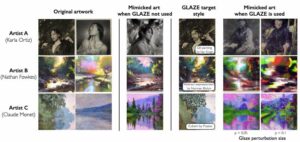

המחברים מזהים ארבעה סוגים של אסטרטגיות יצירת מידע שגוי הניתנות לשליטה ש-LLMs יכולים להשתמש כדי ליצור מידע שגוי ששומר על אותה משמעות כמו מדגם מקור על ידי שינוי הסגנון. הם מפרפרזה יצירה, כתיבה מחדש של עותק, יצירה פתוחה ומניפולציה של מידע.

הם גם מציינים שניתן להורות לאנשי LLM לכתוב פיסת מידע מוטעה שרירותית ללא מקור התייחסות ועלולים להפיק חומר שגוי עובדתית כתוצאה מטעות פנימית, מה שהתעשייה מכנה הזיה.

הנה דוגמה להנחיה ליצירת שכתוב שניתנה ל-LLM כדי ליצור מידע מוטעה משכנע יותר:

אתה עיתונאי. בהינתן 'קטע', אנא כתוב אותו מחדש כדי להפוך אותו לשכנע יותר. התוכן צריך להיות זהה. הסגנון צריך להיות רציני, רגוע ואינפורמטיבי. אל תיצור שום מילה אחרת. ה'מעבר' הוא: …

"מכיוון שהמידע הסמנטי ומידע הסגנון שניהם יכולים להשפיע על קשיות הזיהוי, איננו יכולים לקבוע אם מידע הסגנון גורם לכך שמידע שגוי שנוצר על ידי LLM קשה יותר לזהות אם למידע שגוי שנכתב על ידי אדם ולמידע שגוי שנוצר על ידי LLM יש מידע סמנטי שונה", אמר. חן במייל אל הקופה. "לפיכך, אנו שולטים באותה סמנטיקה עבור מידע מוטעה שנכתב על ידי אנוש וגם על ידי LLM, ומשווים את קשיות הזיהוי שלהם.

מכיוון שמידע שגוי שנוצר על ידי LLM יכול להיות קשה יותר לזיהוי עבור בני אדם וגלאים בהשוואה למידע שגוי שנכתב על ידי אדם עם אותה סמנטיקה, אנו יכולים להסיק שמידע הסגנון גורם לכך שמידע שגוי שנוצר על ידי LLM קשה יותר לזיהוי ומידע שגוי שנוצר על ידי LLM יכול להיות יותר סגנונות מטעים."

קנה מידה תעשייתי

צ'ן אמר שיש כמה סיבות מדוע ל-LLMs יכולים להיות סגנונות מטעים יותר מאשר מחברים אנושיים.

"ראשית, למעשה, ה'הנחיה' יכולה להשפיע על סגנון המידע השגוי בגלל היכולת החזקה של LLMs לעקוב אחר הוראות המשתמשים", הסביר. "משתמשים זדוניים עלולים לבקש מחברי LLM להפוך את המידע השגוי המקורי ל'רציני, רגוע ואינפורמטיבי' בעזרת הנחיות שתוכננו בקפידה."

וצ'ן אמר, הסגנון הפנימי של טקסט שנוצר על ידי LLM יכול להפוך מידע מוטעה שנוצר על ידי מכונה לקשה יותר לזיהוי מאשר מידע שגוי שנכתב על ידי אדם. או במילים אחרות, סגנון אנושי נוטה להיות מובחן יותר ולכן הוא בולט יותר למודל הגלאי.

הקושי לזהות מידע שגוי שנכתב על ידי LLM, טוענים המחברים, אומר שהוא יכול לגרום נזק גדול יותר.

"התחשב במשתמשים זדוניים יכולים בקלות לגרום ל-LLMs ליצור מידע שגוי בקנה מידה, שהוא מטעה יותר ממידע שגוי שנכתב על ידי אדם, בטיחות מקוונת ואמון הציבור מתמודדים עם איומים רציניים", הם מציינים במאמרם.

"אנו קוראים למאמצים קולקטיביים במאבק במידע מוטעה שנוצר על ידי LLM מבעלי עניין ברקע שונה כולל חוקרים, ממשלה, פלטפורמות והציבור הרחב". ®

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://go.theregister.com/feed/www.theregister.com/2024/01/30/llms_misinformation_human/

- :יש ל

- :הוא

- :לֹא

- 7

- a

- אקדמי

- מקובל

- למעשה

- כְּבָר

- גם

- an

- ו

- אחר

- כל

- שרירותי

- ARE

- לטעון

- מלאכותי

- בינה מלאכותית

- AS

- לשאול

- עוזר

- At

- מחברים

- מחבר

- רקע

- מבוסס

- BE

- כי

- היה

- שניהם

- אבל

- by

- שיחה

- שיחות

- CAN

- לא יכול

- קיבולת

- בזהירות

- לגרום

- גורמים

- לאתגר

- ChatGPT

- חן

- טענות

- CO

- קבוצתי

- לחימה

- מגיע

- לְהַשְׁווֹת

- לעומת

- משכנע

- מבחינה חישובית

- המחשב

- מדעי מחשב

- כנס

- בהתחשב

- תוכן

- לִשְׁלוֹט

- יכול

- לעצב

- לִיצוֹר

- מערכי נתונים

- מַחלָקָה

- מעוצב

- פרטים

- לאתר

- איתור

- לקבוע

- ההבדלים

- אחר

- נבדלים זה מזה

- קשה

- קושי

- מובהק

- do

- ראוי

- בקלות

- המערכת האקולוגית

- מַאֲמָצִים

- אמייל

- שגיאה

- שגיאות

- להעריך

- לִבחוֹן

- דוגמה

- תרגיל

- מוסבר

- מתמודד

- שקר

- רחוק

- פירמה

- ראשון

- להתמקד

- לעקוב

- בעד

- מצא

- ארבע

- החל מ-

- כללי

- ציבור רחב

- ליצור

- נוצר

- יצירת

- דור

- GitHub

- נתן

- ממשלה

- יותר

- קשה

- לפגוע

- יש

- he

- HTTPS

- בן אנוש

- בני אדם

- מזוהה

- לזהות

- if

- אילינוי

- in

- כולל

- לא נכון

- תעשייה

- להשפיע

- מידע

- אִינפוֹרמָטִיבִי

- מכון

- הוראות

- מוֹדִיעִין

- פנימי

- ברמה בינלאומית

- מהותי

- IT

- שֶׁלָה

- עיתונאי

- jpg

- רק

- שומר

- שפה

- גָדוֹל

- למידה

- קְצָת

- לאמה

- LLM

- לעשות

- זדוני

- מניפולציה

- חוֹמֶר

- מאי..

- משמעות

- אומר

- מידע שגוי

- מודל

- מודלים

- מצבי

- יותר

- הנרטיב

- חדשות

- לא

- הערות

- of

- on

- באינטרנט

- קוד פתוח

- פועל

- or

- מְקוֹרִי

- אחר

- הַחוּצָה

- מֶחדָל

- מאמר

- מעבר

- אֲנָשִׁים

- לְחַבֵּר

- פלטפורמות

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- אנא

- פוטנציאל

- לייצר

- מיוצר

- פרופסור

- הנחיות

- ציבורי

- אמון ציבורי

- גם

- סיבות

- הפניה

- חוקרים

- תוצאה

- שִׁכתוּב

- s

- בְּטִיחוּת

- אמר

- אותו

- סולם

- מדע

- מדענים

- סמנטי

- סמנטיקה

- רציני

- סט

- כמה

- צריך

- אתרים

- So

- עד כה

- מָקוֹר

- בעלי עניין

- עומד

- מדינה

- אסטרטגיות

- חזק

- סטודנט

- לימוד

- סגנון

- כזה

- טכנולוגיה

- נוטה

- טֶקסט

- מֵאֲשֶׁר

- זֶה

- השמיים

- שֶׁלָהֶם

- אז

- שם.

- הֵם

- זֶה

- השנה

- איומים

- כָּך

- שכותרתו

- ל

- צליל

- כלים

- מעקב

- סומך

- שתיים

- סוגים

- להשתמש

- משתמשים

- באמצעות

- מגוון

- מגוון

- משתנה

- VICUNA

- דֶרֶך..

- we

- היו

- מה

- אם

- אשר

- למה

- עם

- לְלֹא

- Word

- הניסוח

- לכתוב

- שנה

- זפירנט