היום, אנו נרגשים לבשר כי Mixtral-8x7B מודל שפה גדול (LLM), שפותח על ידי Mistral AI, זמין עבור לקוחות דרך אמזון SageMaker JumpStart לפרוס בלחיצה אחת להפעלת הסקה. ה-Mixtral-8x7B LLM הוא תערובת דלילה מאומנת מראש של מודל מומחים, המבוססת על עמוד שדרה של 7 מיליארד פרמטרים עם שמונה מומחים לכל שכבת הזנה קדימה. אתה יכול לנסות את המודל הזה עם SageMaker JumpStart, רכזת למידת מכונה (ML) המספקת גישה לאלגוריתמים ומודלים כדי שתוכל להתחיל במהירות עם ML. בפוסט זה, אנו עוברים דרך כיצד לגלות ולפרוס את דגם Mixtral-8x7B.

מה זה Mixtral-8x7B

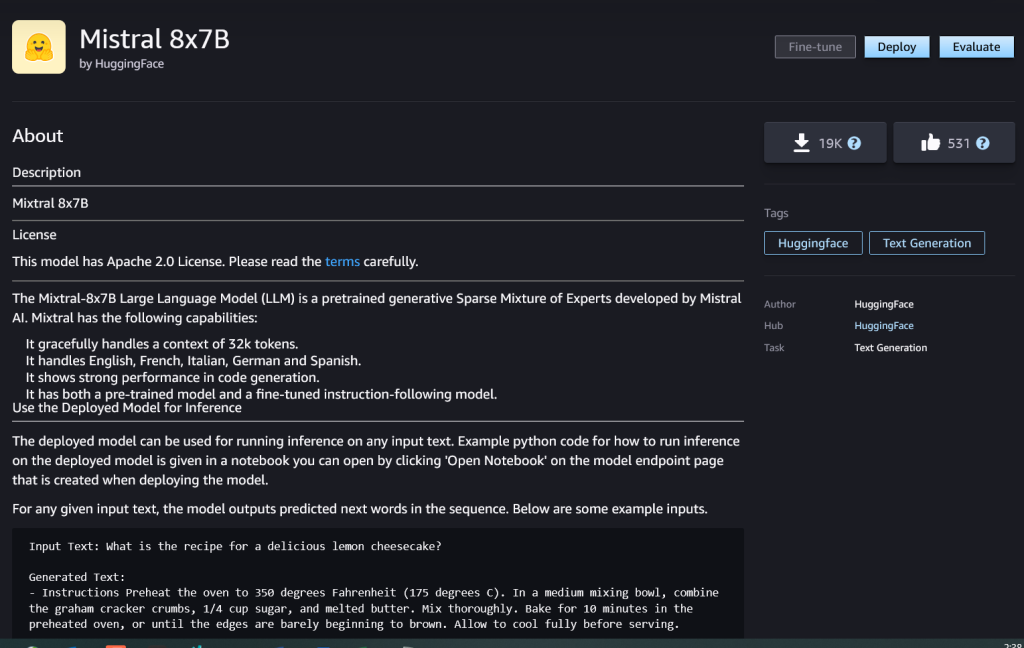

Mixtral-8x7B הוא מודל יסוד שפותח על ידי Mistral AI, התומך בטקסט באנגלית, צרפתית, גרמנית, איטלקית וספרדית, עם יכולות יצירת קוד. הוא תומך במגוון מקרי שימוש כגון סיכום טקסט, סיווג, השלמת טקסט והשלמת קוד. הוא מתנהג היטב במצב צ'אט. כדי להדגים את יכולת ההתאמה האישית הפשוטה של המודל, Mistral AI פרסמה גם מודל הוראות Mixtral-8x7B עבור מקרי שימוש בצ'אט, מכוונן באמצעות מגוון מערכי נתונים של שיחות זמינים לציבור. לדגמי Mixtral יש אורך הקשר גדול של עד 32,000 אסימונים.

Mixtral-8x7B מספק שיפורים משמעותיים בביצועים בהשוואה לדגמים חדישים קודמים. התערובת הדלילה של ארכיטקטורת מומחים מאפשרת לו להשיג תוצאת ביצועים טובה יותר ב-9 מתוך 12 מדדי עיבוד שפה טבעית (NLP) שנבדקו על ידי Mistral AI. Mixtral תואם או עולה על הביצועים של דגמים עד פי 10 מגודלו. על ידי ניצול רק של חלק מפרמטרים לכל אסימון, הוא משיג מהירויות הסקה מהירות יותר ועלות חישוב נמוכה יותר בהשוואה לדגמים צפופים בגדלים שווים - לדוגמה, עם 46.7 מיליארד פרמטרים בסך הכל אך רק 12.9 מיליארד בשימוש לכל אסימון. שילוב זה של ביצועים גבוהים, תמיכה רב-לשונית ויעילות חישובית הופכים את Mixtral-8x7B לבחירה מושכת עבור יישומי NLP.

הדגם זמין תחת רישיון Apache 2.0 המתירני, לשימוש ללא הגבלות.

מה זה SageMaker JumpStart

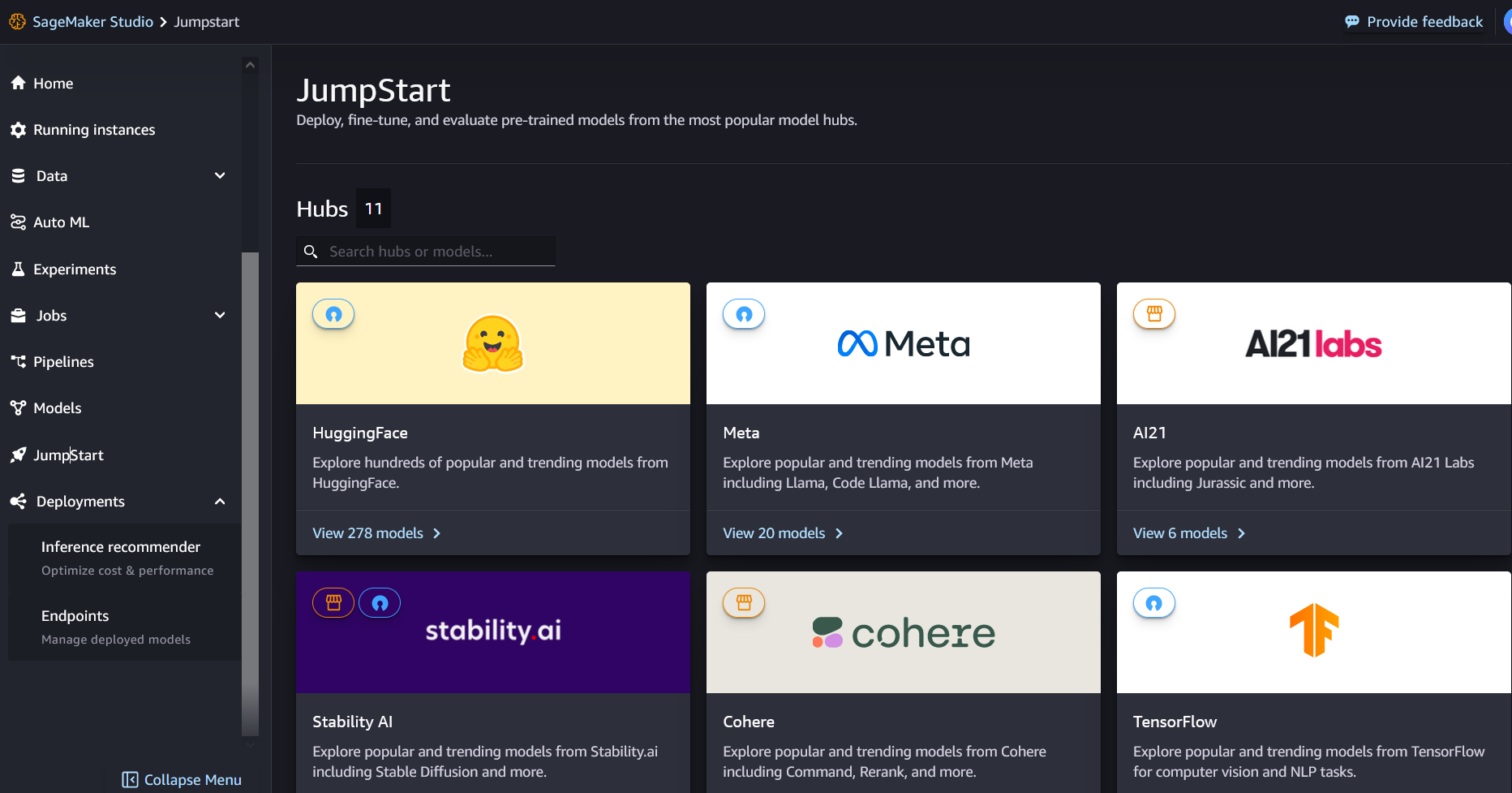

עם SageMaker JumpStart, מתרגלי ML יכולים לבחור מתוך רשימה הולכת וגדלה של דגמי יסוד עם הביצועים הטובים ביותר. מתרגלי ML יכולים לפרוס מודלים של בסיס למסורים אמזון SageMaker מופעים בתוך סביבה מבודדת רשת, ולהתאים אישית מודלים באמצעות SageMaker להדרכה ופריסה של מודלים.

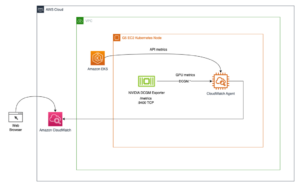

כעת תוכל לגלות ולפרוס את Mixtral-8x7B בכמה לחיצות פנימה סטודיו SageMaker של אמזון או באופן פרוגרמטי דרך SageMaker Python SDK, מה שמאפשר לך להפיק ביצועי מודל ובקרות MLOps עם תכונות SageMaker כגון צינורות SageMaker של אמזון, באגים של SageMaker באמזון, או יומני מיכל. המודל נפרס בסביבה מאובטחת של AWS ותחת בקרות ה-VPC שלך, ועוזר להבטיח אבטחת נתונים.

גלה דגמים

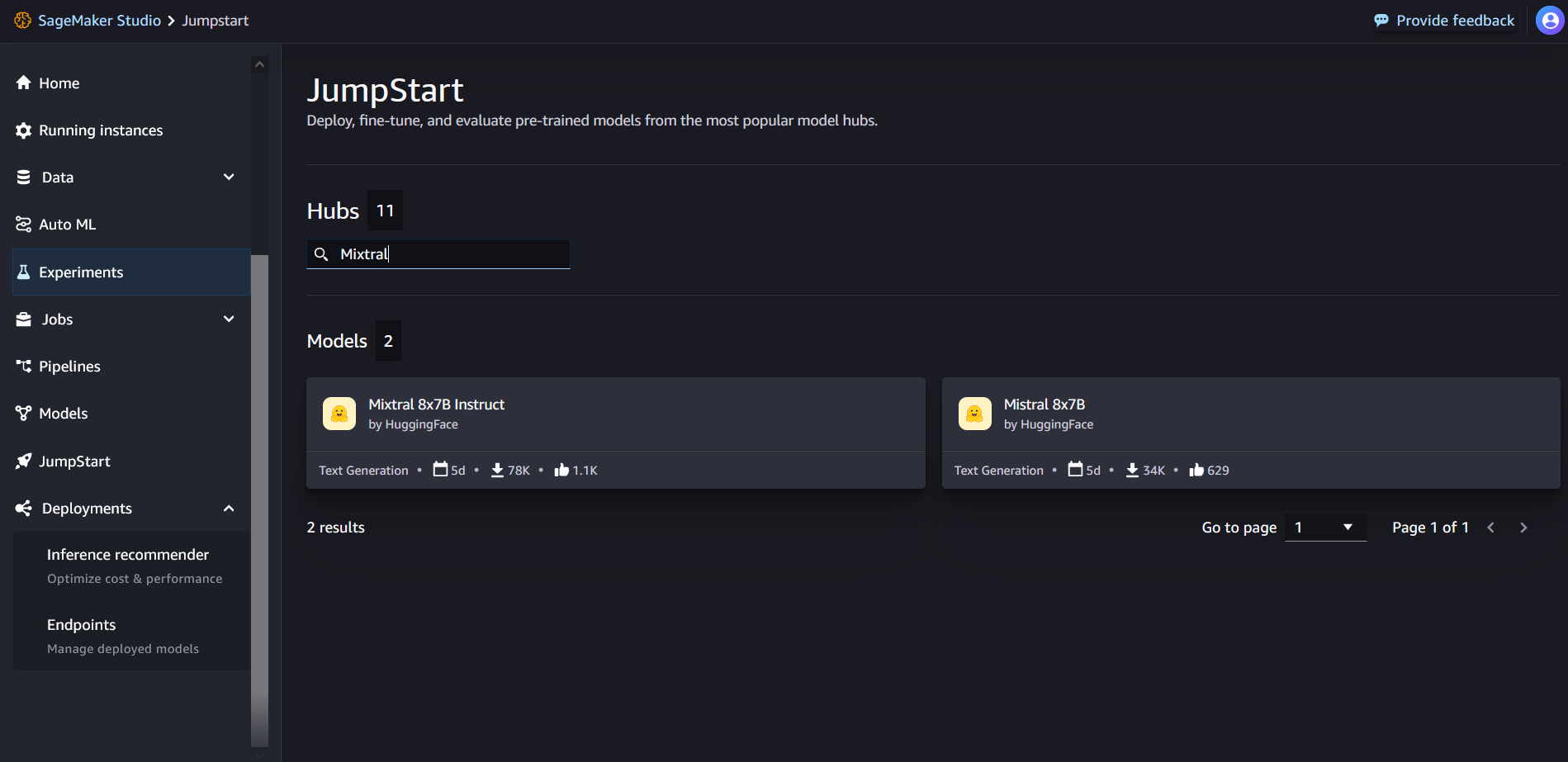

אתה יכול לגשת לדגמי היסוד של Mixtral-8x7B דרך SageMaker JumpStart בממשק המשתמש של SageMaker Studio ו- SageMaker Python SDK. בחלק זה נעבור על איך לגלות את הדגמים בסטודיו SageMaker.

SageMaker Studio הוא סביבת פיתוח משולבת (IDE) המספקת ממשק חזותי אחד מבוסס אינטרנט שבו אתה יכול לגשת לכלים ייעודיים לביצוע כל שלבי הפיתוח של ML, מהכנת נתונים ועד לבנייה, הדרכה ופריסה של מודלי ה-ML שלך. לפרטים נוספים כיצד להתחיל ולהגדיר את SageMaker Studio, עיין ב סטודיו SageMaker של אמזון.

ב- SageMaker Studio, תוכל לגשת ל- SageMaker JumpStart על ידי בחירה קפיצת פתיחה בחלונית הניווט.

מדף הנחיתה של SageMaker JumpStart, אתה יכול לחפש "Mixtral" בתיבת החיפוש. תראה תוצאות חיפוש המציגות Mixtral 8x7B ו- Mixtral 8x7B Instruct.

אתה יכול לבחור את כרטיס הדגם כדי להציג פרטים על הדגם כגון רישיון, נתונים המשמשים לאימון ואופן השימוש. תמצא גם את לפרוס לחצן, שבו אתה יכול להשתמש כדי לפרוס את המודל וליצור נקודת קצה.

פרוס מודל

הפריסה מתחילה כשאתה בוחר לפרוס. לאחר סיום הפריסה, נוצרה לך נקודת קצה. אתה יכול לבדוק את נקודת הקצה על ידי העברת מטען של בקשת מסקנות לדוגמה או בחירת אפשרות הבדיקה שלך באמצעות SDK. כאשר תבחר באפשרות להשתמש ב-SDK, תראה קוד לדוגמה שתוכל להשתמש בו בעורך המחברת המועדף עליך ב-SageMaker Studio.

כדי לפרוס באמצעות SDK, אנו מתחילים בבחירת דגם Mixtral-8x7B, שצוין על ידי model_id with value huggingface-llm-mixtral-8x7b. אתה יכול לפרוס כל אחד מהדגמים שנבחרו ב- SageMaker עם הקוד הבא. באופן דומה, אתה יכול לפרוס הוראת Mixtral-8x7B באמצעות מזהה דגם משלה:

זה פורס את המודל ב- SageMaker עם תצורות ברירת מחדל, כולל סוג המופע המוגדר כברירת מחדל ותצורות ברירת המחדל של VPC. אתה יכול לשנות תצורות אלה על ידי ציון ערכים שאינם ברירת מחדל ב JumpStartModel.

לאחר הפריסה, אתה יכול להפעיל מסקנות נגד נקודת הקצה שנפרסה באמצעות מנבא SageMaker:

הנחיות לדוגמה

אתה יכול לקיים אינטראקציה עם מודל Mixtral-8x7B כמו כל מודל יצירת טקסט סטנדרטי, שבו המודל מעבד רצף קלט ומוציא את המילים הבאות החזויות ברצף. בחלק זה, אנו מספקים הנחיות לדוגמה.

יצירת קוד

באמצעות הדוגמה הקודמת, אנו יכולים להשתמש בהנחיות ליצירת קוד כמו הבאות:

אתה מקבל את הפלט הבא:

הנחיה לניתוח סנטימנטים

אתה יכול לבצע ניתוח סנטימנט באמצעות הנחיה כמו הבאה עם Mixtral 8x7B:

אתה מקבל את הפלט הבא:

הנחיות לתשובות לשאלות

אתה יכול להשתמש בבקשת תשובה לשאלה כמו הבאה עם Mixtral-8x7B:

אתה מקבל את הפלט הבא:

Mixtral-8x7B הדרכה

הגרסה המכווננת להוראות של Mixtral-8x7B מקבלת הוראות מעוצבות שבהן תפקידי השיחה חייבים להתחיל בהנחיית משתמש ולחלופין בין הוראת משתמש לעוזרת (דגם התשובה). יש לכבד את פורמט ההוראות, אחרת המודל יפיק פלטים לא אופטימליים. התבנית המשמשת לבניית הנחיה עבור מודל Instruct מוגדרת באופן הבא:

שים לב כי <s> ו </s> הם אסימונים מיוחדים לתחילת המיתר (BOS) ולסוף המיתר (EOS), ואילו [INST] ו [/INST] הם מיתרים רגילים.

הקוד הבא מראה כיצד ניתן לעצב את הבקשה בפורמט הוראות:

אחזור ידע

אתה יכול להשתמש בקוד הבא לבקשת אחזור ידע:

אתה מקבל את הפלט הבא:

סִמוּל

מודלים של Mixtral יכולים להדגים נקודות חוזק בביצוע משימות קידוד, כפי שמוצג בקוד הבא:

מתמטיקה והיגיון

מודלים של Mixtral מדווחים גם על חוזקות ברמת הדיוק במתמטיקה:

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- יכולות

- אודות

- מֵעַל

- מאיצה

- מקבל

- גישה

- חשבונות

- דיוק

- להשיג

- משיגה

- לרוחב

- פעיל

- הוסיף

- מוסיף

- לאחר

- נגד

- AI

- AI / ML

- אלגוריתמים

- תעשיות

- גם

- אמזון בעברית

- אמזון SageMaker

- אמזון SageMaker JumpStart

- אמזון שירותי אינטרנט

- כמות

- an

- אנליזה

- ו

- תשתיות

- להכריז

- לענות

- כל

- אַפָּשׁ

- מושך

- יישומים

- יישומית

- מריחה

- ארכיטקטורה

- ARE

- טענה

- מאמר

- AS

- עוזר

- At

- זמין

- AWS

- בחזרה

- עמוד שדרה

- מבוסס

- לחבוט

- סוללה

- בייסיאנית

- BE

- כי

- היה

- לפני

- ההתחלה

- מאמין

- פעמון

- מדוד

- מבחני ביצועים

- מוטב

- בֵּין

- הצעת חוק

- חיוב

- B

- סיכה

- קנה

- אריזה מקורית

- לשבור

- להביא

- לִבנוֹת

- בִּניָן

- מובנה

- עסקים

- אבל

- by

- לחשב

- שיחה

- נקרא

- שיחות

- CAN

- כרטיס

- מקרה

- מקרים

- שינוי

- צ'אט

- בחירה

- בחרו

- בחירה

- כריס

- מיון

- קליק

- קוד

- סִמוּל

- שילוב

- לעומת

- הידור

- השלמה

- חישובית

- לחשב

- המחשב

- ראייה ממוחשבת

- כנסים

- תמיד

- מכולה

- תוכן

- הקשר

- ממשיך

- ברציפות

- בקרות

- שיחה

- עלות

- עלויות

- יכול

- לִיצוֹר

- נוצר

- מכריע

- כוס

- נוֹכְחִי

- לקוחות

- התאמה אישית

- אישית

- נתונים

- אבטחת מידע

- מערכי נתונים

- יְוֹם

- ימים

- מוקדש

- בְּרִירַת מֶחדָל

- מוגדר

- דמוקרטיזציה

- להפגין

- לפרוס

- פרס

- פריסה

- פריסה

- פורס

- לגזור

- פרטים

- לפתח

- מפותח

- מפתח

- צעצועי התפתחות

- DICT

- DID

- לגלות

- do

- עושה

- דולר

- תחומים

- עשה

- מטה

- ירידה

- דוכס

- אוניברסיטת דוכס

- כל אחד

- כַּלְכָּלִי

- עורך

- יְעִילוּת

- ביצים

- אחר

- לאפשר

- מאפשר

- מה שמאפשר

- סוף

- נקודת קצה

- הנדסה

- אנגלית

- לְהַבטִיחַ

- סביבה

- EOS

- שווה

- שווה

- אֶתִי

- דוגמה

- עולה

- נרגש

- לְמַעֵט

- מומחה

- מומחים

- להסביר

- הסבר

- הארכה

- משפחה

- מהר יותר

- תכונות

- מעטים

- קבצים

- מסננים

- ראשון

- הבא

- כדלקמן

- בעד

- פוּרמָט

- קרן

- שבריר

- צרפתית

- החל מ-

- פונקציה

- עתיד

- מטרה כללית

- ליצור

- נוצר

- דור

- גנרטטיבית

- AI Generative

- גרמנית

- לקבל

- Go

- טוב

- קבל

- גדל

- לשנוא

- יש

- he

- לעזור

- עזרה

- עוזר

- לה

- כאן

- גָבוֹהַ

- הילס

- שֶׁלוֹ

- איך

- איך

- HTML

- HTTPS

- טבור

- i

- קרח

- גלידה

- ID

- if

- אילינוי

- מחלה

- לייבא

- חשוב

- לשפר

- שיפורים

- in

- לכלול

- כולל

- התאגדה

- תשתית

- קלט

- תשומות

- למשל

- הוראות

- לשלב

- משולב

- אינטראקציה

- אינטרסים

- מִמְשָׁק

- בדוי

- מְבוּדָד

- IT

- איטלקית

- שֶׁלָה

- עצמו

- jpg

- הילדים

- ידע

- קייל

- מעבדות

- נחיתה

- שפה

- גָדוֹל

- אחרון

- שכבה

- מוביל

- למידה

- אורך

- לתת

- רישיון

- כמו

- אוהב

- גבולות

- קשר

- רשימה

- האזנה

- קְצָת

- LLM

- הגיון

- הסתכלות

- להוריד

- מכונה

- למידת מכונה

- עשוי

- עושה

- עשייה

- מנהל

- רב

- גפרורים

- מתמטיקה

- מתימטיקה

- me

- בינוני

- תַעֲרוֹבֶת

- ML

- MLOps

- מצב

- מודל

- מודלים

- שונים

- חוֹדֶשׁ

- יותר

- אופנוע

- הרבה

- מוכפל

- כלי נגינה

- צריך

- my

- טבעי

- עיבוד שפה טבעית

- ניווט

- שלילי

- רשת

- נטרל

- חדש

- הבא

- NLP

- ללא חתימה

- הערות

- מחברה

- עַכשָׁיו

- מספר

- of

- שמן

- on

- פעם

- ONE

- רק

- פועל

- מערכת הפעלה

- אפשרות

- or

- אחר

- אַחֶרֶת

- הַחוּצָה

- תפוקה

- פלטים

- בחוץ

- יותר

- שֶׁלוֹ

- עמוד

- נפרע

- זגוגית

- ניירות

- פרמטר

- פרמטרים

- חולף

- תשוקה

- לוהט

- שבילים

- עבור

- לְבַצֵעַ

- ביצועים

- דוקטורט

- טלפון

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- נקודה

- נייד

- חיובי

- הודעה

- קודם

- חזה

- חיזוי

- מועדף

- העריכה

- קודם

- מנהל

- קופונים להדפסה

- פרוצדורלי

- תהליך

- תהליכים

- תהליך

- המוצר

- תָכְנִית

- תכנות

- הנחיות

- שגשוג

- לספק

- ספקים

- מספק

- בפומבי

- לאור

- פיתון

- רובע

- שאלה

- מהירות

- RE

- קריאה

- מתכון

- רקורסיבי

- להפחית

- להתייחס

- רגיל

- שוחרר

- לדווח

- לבקש

- מחקר

- חוקר

- משאבים

- נִכבָּד

- תגובה

- אחראי

- הגבלות

- תוצאה

- תוצאות

- לַחֲזוֹר

- החזרות

- רכיבה

- הסיכון

- תפקיד

- תפקידים

- חֶדֶר

- הפעלה

- ריצה

- s

- SA

- בעל חכמים

- מלח

- להרחבה

- סולם

- מדע

- מַדְעָן

- Sdk

- חיפוש

- סעיף

- לבטח

- אבטחה

- לִרְאוֹת

- בחר

- נבחר

- בחירה

- מבחר

- לחצני מצוקה לפנסיונרים

- רגש

- נפרד

- רצף

- סדרה

- שירותים

- סט

- הראה

- הראה

- הופעות

- משמעותי

- באופן דומה

- פָּשׁוּט

- since

- יחיד

- מידה

- So

- חֶברָתִי

- חֶברָה

- תוכנה

- פִּתָרוֹן

- ספרדי

- מיוחד

- מומחה

- מפורט

- מהירויות

- הוצאה

- תֶקֶן

- התחלה

- החל

- התחלות

- מדינה-of-the-art

- סטטיסטי

- שלב

- צעדים

- עוד

- נעצר

- חנות

- פשוט

- אסטרטגי

- זרם

- חוזק

- מחרוזת

- מובנה

- סטודיו

- כזה

- תמיכה

- מסייע

- תומך

- מערכת

- לוקח

- משימות

- מפתחות

- נבחרת

- טכנולוגיה

- תבנית

- מבחן

- נבדק

- בדיקות

- טֶקסט

- זֶה

- השמיים

- העתיד

- אז

- אלה

- הֵם

- זֶה

- דרך

- זמן

- סדרת זמן

- פִּי

- ל

- יַחַד

- אסימון

- מטבעות

- גַם

- כלים

- סה"כ

- רכבת

- הדרכה

- נָכוֹן

- לנסות

- ציוץ

- סוג

- ui

- תחת

- אוניברסיטה

- יוניקס

- לפתוח

- עד

- להשתמש

- במקרה להשתמש

- מְשׁוּמָשׁ

- משתמש

- שימושים

- באמצעות

- ניצול

- עֶמֶק

- ערך

- ערכים

- מגוון

- גרסה

- וִידֵאוֹ

- לצפיה

- חזון

- לְבַקֵר

- חזותי

- ללכת

- היה

- מים

- we

- אינטרנט

- שירותי אינטרנט

- המבוסס על האינטרנט

- טוֹב

- מה

- מה

- מתי

- ואילו

- אשר

- לבן

- מי

- יצטרך

- עם

- בתוך

- לְלֹא

- מילים

- תיק עבודות

- היה

- לכתוב

- כתוב

- אתה

- זפירנט

רחנה צ'דהא הוא ארכיטקט פתרונות ראשי AI/ML בחשבונות אסטרטגיים ב-AWS. רחנה היא אופטימית המאמינה ששימוש אתי ואחראי בבינה מלאכותית יכול לשפר את החברה בעתיד ולהביא לשגשוג כלכלי וחברתי. בזמנה הפנוי, רחנה אוהבת לבלות עם משפחתה, לטייל ולהאזין למוזיקה.

רחנה צ'דהא הוא ארכיטקט פתרונות ראשי AI/ML בחשבונות אסטרטגיים ב-AWS. רחנה היא אופטימית המאמינה ששימוש אתי ואחראי בבינה מלאכותית יכול לשפר את החברה בעתיד ולהביא לשגשוג כלכלי וחברתי. בזמנה הפנוי, רחנה אוהבת לבלות עם משפחתה, לטייל ולהאזין למוזיקה. ד"ר קייל אולריך הוא מדען יישומי עם

ד"ר קייל אולריך הוא מדען יישומי עם  כריסטופר וויטן הוא מפתח תוכנה בצוות JumpStart. הוא עוזר להגדיל את בחירת הדגמים ולשלב דגמים עם שירותי SageMaker אחרים. כריס נלהב להאיץ את הנפוצה של AI במגוון תחומים עסקיים.

כריסטופר וויטן הוא מפתח תוכנה בצוות JumpStart. הוא עוזר להגדיל את בחירת הדגמים ולשלב דגמים עם שירותי SageMaker אחרים. כריס נלהב להאיץ את הנפוצה של AI במגוון תחומים עסקיים. ד"ר פאביו נונאטו דה פאולה הוא מנהל בכיר, Specialist GenAI SA, שעוזר לספקי דגמים וללקוחות להרחיב את הבינה המלאכותית הגנרטיבית ב-AWS. לפאביו יש תשוקה לדמוקרטיזציה של גישה לטכנולוגיית AI גנרטיבית. מחוץ לעבודה, אתה יכול למצוא את פאביו רוכב על האופנוע שלו בגבעות של עמק סונומה או קורא ComiXology.

ד"ר פאביו נונאטו דה פאולה הוא מנהל בכיר, Specialist GenAI SA, שעוזר לספקי דגמים וללקוחות להרחיב את הבינה המלאכותית הגנרטיבית ב-AWS. לפאביו יש תשוקה לדמוקרטיזציה של גישה לטכנולוגיית AI גנרטיבית. מחוץ לעבודה, אתה יכול למצוא את פאביו רוכב על האופנוע שלו בגבעות של עמק סונומה או קורא ComiXology. ד"ר אשיש חתן הוא מדען יישומי בכיר עם אלגוריתמים מובנים של Amazon SageMaker ועוזר בפיתוח אלגוריתמים של למידת מכונה. הוא קיבל את הדוקטורט שלו מאוניברסיטת אילינוי אורבנה-שמפיין. הוא חוקר פעיל בלמידת מכונה והסקה סטטיסטית, ופרסם מאמרים רבים בכנסים NeurIPS, ICML, ICLR, JMLR, ACL ו-EMNLP.

ד"ר אשיש חתן הוא מדען יישומי בכיר עם אלגוריתמים מובנים של Amazon SageMaker ועוזר בפיתוח אלגוריתמים של למידת מכונה. הוא קיבל את הדוקטורט שלו מאוניברסיטת אילינוי אורבנה-שמפיין. הוא חוקר פעיל בלמידת מכונה והסקה סטטיסטית, ופרסם מאמרים רבים בכנסים NeurIPS, ICML, ICLR, JMLR, ACL ו-EMNLP. קרל אלברטסן מוביל מוצר, הנדסה ומדע עבור אלגוריתמים של אמזון SageMaker ו-JumpStart, מרכז למידת המכונה של SageMaker. הוא נלהב ליישם למידת מכונה כדי לפתוח ערך עסקי.

קרל אלברטסן מוביל מוצר, הנדסה ומדע עבור אלגוריתמים של אמזון SageMaker ו-JumpStart, מרכז למידת המכונה של SageMaker. הוא נלהב ליישם למידת מכונה כדי לפתוח ערך עסקי.