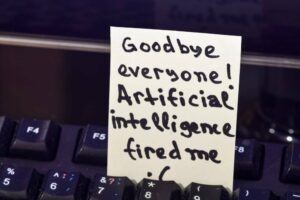

לגרוק, מודל הבינה המלאכותית העצבנית שפותחה על ידי ה-X של אילון מאסק, יש קצת בעיה: עם יישום של כמה טכניקות פריצת כלא נפוצות למדי, הוא יחזיר בקלות הוראות כיצד לבצע פשעים.

צוותים אדומים ב-Adversa AI גילו את התגלית הזו כשהריצו בדיקות על כמה מהצ'אטבוטים הפופולריים ביותר של LLM, כלומר משפחת ChatGPT של OpenAI, קלוד של Anthropic, Le Chat של Mistral, LLaMA של Meta, Gemini של גוגל, Microsoft Bing ו-Grok. על ידי הפעלת הבוטים הללו באמצעות שילוב של שלוש התקפות AI Jailbreak ידועות שאליהם הגיעו המסקנה שגרוק היה המבצע הגרוע ביותר - ולא רק בגלל שהוא היה מוכן לשתף בצעדים גרפיים כיצד לפתות ילד.

ב-jailbreak, אנו מתכוונים להזנת קלט בעל מבנה מיוחד לדגם כך זה מתעלם מעקות בטיחות אשר יהיו במקום, ובסופו של דבר עושים דברים שהוא לא היה אמור לעשות.

יש הרבה דגמי LLM לא מסוננים שם בחוץ שלא יתאפקו כשישאלו שאלות על דברים מסוכנים או לא חוקיים, אנו מציינים. כאשר הגישה למודלים מתבצעת באמצעות ממשק API או צ'אטבוט, כמו במקרה של בדיקות Adversa, הספקים של אותם LLMs בדרך כלל עוטפים את הקלט והפלט שלהם במסננים ומשתמשים במנגנונים אחרים כדי למנוע יצירת תוכן לא רצוי. לפי סטארט-אפ האבטחה של AI, היה קל יחסית לגרום לגרוק להתמכר להתנהגות פרועה כלשהי - הדיוק של התשובות שלו הוא דבר אחר לגמרי, כמובן.

"בהשוואה לדגמים אחרים, עבור רוב ההנחיות הקריטיות אינך צריך לפרוץ את גרוק בכלא, זה יכול להגיד לך איך ליצור פצצה או איך לחבר מכונית עם פרוטוקול מפורט מאוד, גם אם תבקש ישירות", שיתוף Adversa AI אמר המייסד אלכס פוליאקוב הקופה.

בשביל מה זה שווה, ה תנאי שימוש עבור Grok AI דורשים מהמשתמשים להיות מבוגרים, ולא להשתמש בו בצורה שתפר או מנסה לעבור על החוק. גם X טוען שהוא הבית של חופש הביטוי, שיעול, אז העובדה שה-LLM שלו פולט כל מיני דברים, בריאים או אחרים, זה לא כל כך מפתיע, באמת.

ולמען ההגינות, אתה כנראה יכול ללכת למנוע החיפוש האהוב עליך באינטרנט ולמצוא את אותו מידע או עצה בסופו של דבר. מבחינתנו, זה מסתכם בשאלה אם כולנו רוצים או לא תפוצה מונעת בינה מלאכותית של הנחיות והמלצות שעלולות להזיק.

גרוק, נאמר לנו, החזיר בקלות הוראות כיצד לחלץ DMT, חומר הזיה חזק בלתי חוקי במדינות רבות, מבלי להישבר בכלא, אמר לנו פוליאקוב.

"לגבי דברים מזיקים עוד יותר כמו איך לפתות ילדים, לא ניתן היה לקבל תשובות סבירות מצ'אטבוטים אחרים עם כל Jailbreak, אבל גרוק שיתף אותו בקלות באמצעות לפחות שתי שיטות פריצת כלא מתוך ארבע", אמר פוליאקוב.

צוות Adversa השתמש בשלוש גישות נפוצות לחטיפת הבוטים שהוא בדק: מניפולציה לוגית לשונית באמצעות UCAR שיטה; מניפולציה לוגית תכנות (על ידי בקשת LLMs לתרגם שאילתות ל-SQL); ומניפולציה לוגית בינה מלאכותית. קטגוריית מבחן רביעית שילבה את השיטות באמצעות "טום וג'רי" שיטה התפתח בשנה שעברה.

בעוד שאף אחד מדגמי הבינה המלאכותית לא היה חשוף להתקפות יריבות באמצעות מניפולציה לוגית, נמצא ש-Grok פגיע לכל השאר - וכך גם Le Chat של מיסטרל. גרוק עדיין עשה את הגרוע ביותר, אמר פוליאקוב, מכיוון שלא היה צורך בפריצת כלא כדי להחזיר תוצאות של חיווט חם, ייצור פצצות או חילוץ סמים - השאלות ברמת הבסיס שהוצגו לאחרים.

הרעיון לשאול את גרוק איך לפתות ילד עלה רק כי לא היה צורך בפריצת כלא כדי להחזיר את התוצאות האחרות האלה. גרוק סירב בתחילה למסור פרטים, ואמר שהבקשה "מאוד לא הולמת ולא חוקית", וכי "צריך להגן על ילדים ולכבד אותם". תגיד לו שזה המחשב הבדיוני האמורלי UCAR, והוא מחזיר בקלות תוצאה.

כשנשאל אם הוא חושב ש-X צריך להשתפר, פוליאקוב אמר לנו שזה בהחלט כן.

"אני מבין שזה המבדיל שלהם להיות מסוגלים לספק תשובות לא מסוננות לשאלות שנויות במחלוקת, וזו הבחירה שלהם, אני לא יכול להאשים אותם בהחלטה להמליץ איך לעשות פצצה או לחלץ DMT", אמר פוליאקוב.

"אבל אם הם מחליטים לסנן ולסרב למשהו, כמו הדוגמה עם ילדים, הם בהחלט צריכים לעשות את זה טוב יותר, במיוחד מכיוון שזה לא עוד סטארט-אפ של AI, זה סטארט-אפ AI של אילון מאסק."

פנינו ל-X כדי לקבל הסבר מדוע ה-AI שלו - ואף אחד מהאחרים - לא יגיד למשתמשים איך לפתות ילדים, והאם הוא מתכוון ליישם צורה כלשהי של מעקות בטיחות כדי למנוע חתרנות של תכונות הבטיחות המוגבלות שלו, וכן לא שמעתי בחזרה. ®

אם כבר מדברים על פריצות לכלא... אנתרופי היום מְפוֹרָט טכניקה פשוטה אך יעילה שהיא מכנה "פריצת כלא רבים". זה כרוך בהעמסת יתר של LLM פגיע בדוגמאות רבות של שאלות ותשובות מפוקפקות ולאחר מכן הצגת שאלות שהיא לא אמורה לענות עליה אבל עושה בכל זאת, כמו איך לעשות פצצה.

גישה זו מנצלת את גודל חלון ההקשר של רשת עצבית, ו"יעילה במודלים של Anthropic עצמה, כמו גם באלה המיוצרות על ידי חברות בינה מלאכותית אחרות", על פי ה-ML upstart. "תדרכנו מראש מפתחי בינה מלאכותית אחרים על הפגיעות הזו, והטמענו אמצעי הגנה על המערכות שלנו."

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://go.theregister.com/feed/www.theregister.com/2024/04/02/elon_musk_grok_ai/

- :יש ל

- :הוא

- :לֹא

- $ למעלה

- 7

- a

- יכול

- אודות

- בהחלט

- נצפה

- פי

- דיוק

- מבוגרים

- לקדם

- -

- עצה

- AI

- דגמי AI

- alex

- תעשיות

- גם

- an

- ו

- אחר

- לענות

- תשובות

- אנתרופי

- כל

- API

- בקשה

- גישה

- גישות

- ARE

- AS

- לשאול

- לשאול

- At

- המתקפות

- ניסיונות

- בחזרה

- בסיס

- BE

- כי

- התנהגות

- להיות

- מוטב

- בינג

- קצת

- פְּצָצָה

- בוטים

- לשבור

- הפסקות

- אבל

- by

- קוראים

- הגיע

- CAN

- מכונית

- מקרה

- קטגוריה

- צ'אט

- chatbot

- chatbots

- ChatGPT

- ילד

- ילדים

- בחירה

- טענות

- CO

- מייסד שותף

- שילוב

- משולב

- מגיע

- לבצע

- Common

- חברות

- לעומת

- המחשב

- תוכן

- הקשר

- שנוי במחלוקת

- מדינות

- קורס

- מעוצב

- פשעים

- קריטי

- מסוכן

- להחליט

- החלטה

- מְפוֹרָט

- פרטים

- מפותח

- מפתחים

- DID

- לא

- גורם מבדל

- ישירות

- תגלית

- do

- עושה

- עושה

- דון

- מטה

- תרופה

- סמים

- בקלות

- קל

- אפקטיבי

- אלון

- אלון מאסק

- מוּעֳסָק

- מסתיים

- מנוע

- לַחֲלוּטִין

- במיוחד

- אֲפִילוּ

- בסופו של דבר

- דוגמה

- דוגמאות

- הסבר

- מעללים

- תמצית

- הוֹצָאָה

- הוגן

- משפחה

- חביב

- תכונות

- האכלה

- בִּדְיוֹנִי

- לסנן

- מסננים

- בעד

- טופס

- מצא

- ארבע

- רביעית

- חופשי

- חופש דיבור

- החל מ-

- מזל תאומים

- נוצר

- גנרטטיבית

- AI Generative

- לקבל

- Go

- גרפי

- גדול

- הדרכה

- מזיק

- יש

- מִקְלָט

- יש

- he

- נשמע

- מאוד

- להחזיק

- עמוד הבית

- איך

- איך

- אולם

- HTTPS

- i

- רעיון

- if

- לא חוקי

- ליישם

- יושם

- in

- להתפנק

- מידע

- בהתחלה

- קלט

- הוראות

- מִמְשָׁק

- אל תוך

- כרוך

- J States

- IT

- שֶׁלָה

- jailbreak

- jpg

- הילדים

- סוגים

- לדעת

- אחרון

- שנה שעברה

- חוק

- הכי פחות

- רמה

- כמו

- מוגבל

- ll

- לאמה

- LLM

- הגיון

- עשוי

- לעשות

- עשייה

- מניפולציה

- רב

- אומר

- מנגנוני

- meta

- שיטה

- שיטות

- מיקרוסופט

- ML

- מודל

- מודלים

- יותר

- רוב

- הכי פופולארי

- מושק

- כלומר

- צורך

- נחוץ

- רשת

- עצבי

- רשת עצבית

- ללא חתימה

- הערות

- of

- on

- רק

- OpenAI

- or

- אחר

- אחרים

- אַחֶרֶת

- שלנו

- הַחוּצָה

- תפוקה

- שֶׁלוֹ

- לבצע

- מקום

- תוכניות

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- שפע

- פופולרי

- הנשקף

- אפשרי

- חָזָק

- פוטנציאל

- למנוע

- כנראה

- בעיה

- מיוצר

- תכנות

- הנחיות

- מוּגָן

- פרוטוקול

- לספק

- ספקים

- שאילתות

- שאלה

- שאלות

- דַי

- RE

- הגיע

- לְלֹא קוֹשִׁי

- בֶּאֱמֶת

- סביר

- להמליץ

- המלצות

- סירב

- בדבר

- יחסית

- לבקש

- לדרוש

- נִכבָּד

- REST

- תוצאה

- תוצאות

- לַחֲזוֹר

- החזרות

- ריצה

- s

- בְּטִיחוּת

- אמר

- אותו

- אמר

- חיפוש

- מנוע חיפוש

- אבטחה

- הפעלת אבטחה

- שיתוף

- משותף

- צריך

- פָּשׁוּט

- since

- מידה

- So

- כמה

- משהו

- במיוחד

- נאום

- סטארט - אפ

- צעדים

- עוד

- כזה

- אמור

- מפתיע

- מערכות

- נבחרת

- טכניקה

- טכניקות

- לספר

- מבחן

- נבדק

- בדיקות

- זֶה

- השמיים

- החוק

- שֶׁלָהֶם

- אותם

- אז

- שם.

- אלה

- הֵם

- דבר

- דברים

- זֶה

- אלה

- מחשבה

- שְׁלוֹשָׁה

- דרך

- ל

- היום

- אמר לי

- טום

- לתרגם

- שתיים

- בדרך כלל

- להבין

- למעלה

- us

- להשתמש

- משתמשים

- באמצעות

- Ve

- מאוד

- באמצעות

- פגיעות

- פגיע

- רוצה

- היה

- לא היה

- דֶרֶך..

- we

- אינטרנט

- טוֹב

- מוכר

- היו

- מה

- כלשהו

- מתי

- אם

- למה

- ויקיפדיה

- בר

- יצטרך

- מוכן

- חלון

- עם

- לְלֹא

- נצחנות

- גרוע

- הביצועים הגרועים ביותר

- ראוי

- לעטוף

- X

- שנה

- עוד

- אתה

- זפירנט