היום, אנו נרגשים להכריז כי מודלים של בסיס Code Lama, שפותחו על ידי Meta, זמינים עבור לקוחות באמצעות אמזון SageMaker JumpStart לפרוס בלחיצה אחת להפעלת הסקה. Code Llama הוא מודל שפה גדול (LLM) מתקדם המסוגל ליצור קוד ושפה טבעית לגבי קוד הן מהנחיות קוד והן בשפה טבעית. אתה יכול לנסות את המודל הזה עם SageMaker JumpStart, רכזת למידת מכונה (ML) המספקת גישה לאלגוריתמים, מודלים ופתרונות ML כדי שתוכל להתחיל במהירות עם ML. בפוסט זה, אנו עוברים דרך כיצד לגלות ולפרוס את מודל Code Llama באמצעות SageMaker JumpStart.

קוד לאמה

Code Lama הוא דגם ששוחרר על ידי meta שבנוי על גבי Llama 2. מודל חדיש זה נועד לשפר את הפרודוקטיביות של משימות תכנות עבור מפתחים על ידי סיוע להם ליצור קוד איכותי ומתועד היטב. המודלים מצטיינים ב-Python, C++, Java, PHP, C#, TypeScript ו-Bash, ויש להם פוטנציאל לחסוך זמן למפתחים ולהפוך את זרימות העבודה של התוכנה ליעילות יותר.

הוא מגיע בשלוש גרסאות, מתוכננות לכסות מגוון רחב של יישומים: המודל הבסיסי (Code Llama), מודל מיוחד של Python (Code Llama Python), ומודל העוקב אחר הוראות להבנת הוראות שפה טבעית (Code Llama Instruct). כל גרסאות Code Llama מגיעות בארבעה גדלים: 7B, 13B, 34B ו-70B פרמטרים. גרסאות הבסיס וההוראות 7B ו-13B תומכות במילוי המבוסס על תוכן שמסביב, מה שהופך אותן לאידיאליות עבור יישומי עוזר קוד. הדגמים תוכננו תוך שימוש ב-Llama 2 כבסיס ולאחר מכן אומנו על 500 מיליארד אסימונים של נתוני קוד, כאשר הגרסה המיוחדת של Python מאומנת על כמות מצטברת של 100 מיליארד אסימונים. דגמי Code Llama מספקים דורות יציבים עם עד 100,000 אסימוני הקשר. כל הדגמים מאומנים על רצפים של 16,000 אסימונים ומציגים שיפורים בכניסות עם עד 100,000 אסימונים.

הדגם זמין תחת אותו רישיון קהילה בתור לאמה 2.

דגמי יסוד ב- SageMaker

SageMaker JumpStart מספקת גישה למגוון דגמים ממרכזי דגמים פופולריים, כולל Hugging Face, PyTorch Hub ו- TensorFlow Hub, שבהם אתה יכול להשתמש במסגרת זרימת העבודה שלך לפיתוח ML ב- SageMaker. ההתקדמות האחרונה ב-ML הובילה לסוג חדש של דגמים המכונה דגמי יסוד, אשר בדרך כלל מאומנים על מיליארדי פרמטרים וניתנים להתאמה לקטגוריה רחבה של מקרי שימוש, כגון סיכום טקסט, יצירת אמנות דיגיטלית ותרגום שפה. מכיוון שדגמים אלו יקרים לאימון, לקוחות רוצים להשתמש במודלים קיימים של יסודות שהוכשרו מראש ולכוונן אותם לפי הצורך, במקום לאמן את הדגמים הללו בעצמם. SageMaker מספק רשימה אוצרת של דגמים שתוכלו לבחור מהם בקונסולת SageMaker.

אתה יכול למצוא דגמי יסוד מספקי דגמים שונים בתוך SageMaker JumpStart, מה שמאפשר לך להתחיל עם דגמי יסוד במהירות. אתה יכול למצוא מודלים של בסיס המבוססים על משימות או ספקי מודל שונים, ולסקור בקלות את מאפייני המודל ומונחי השימוש. אתה יכול גם לנסות את הדגמים האלה באמצעות ווידג'ט למבחן ממשק משתמש. כאשר אתה רוצה להשתמש במודל יסוד בקנה מידה, אתה יכול לעשות זאת מבלי לעזוב את SageMaker על ידי שימוש במחברות מובנות מראש מספקי דגמים. מכיוון שהמודלים מתארחים ונפרסים ב-AWS, אתה יכול להיות סמוך ובטוח שהנתונים שלך, בין אם הם משמשים להערכת המודל או לשימוש בקנה מידה גדול, לעולם אינם משותפים עם צדדים שלישיים.

גלה את דגם Code Llama ב- SageMaker JumpStart

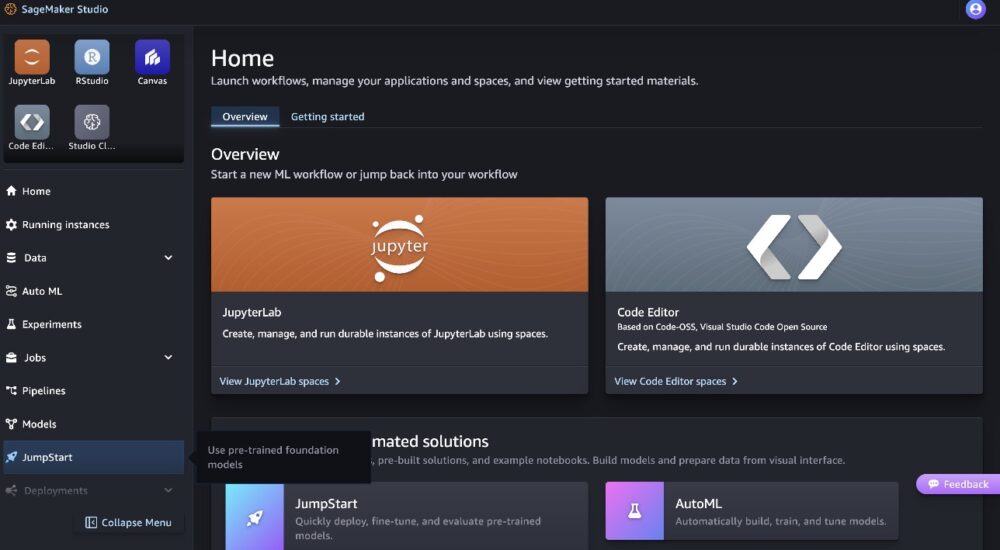

כדי לפרוס את מודל Code Llama 70B, השלם את השלבים הבאים ב סטודיו SageMaker של אמזון:

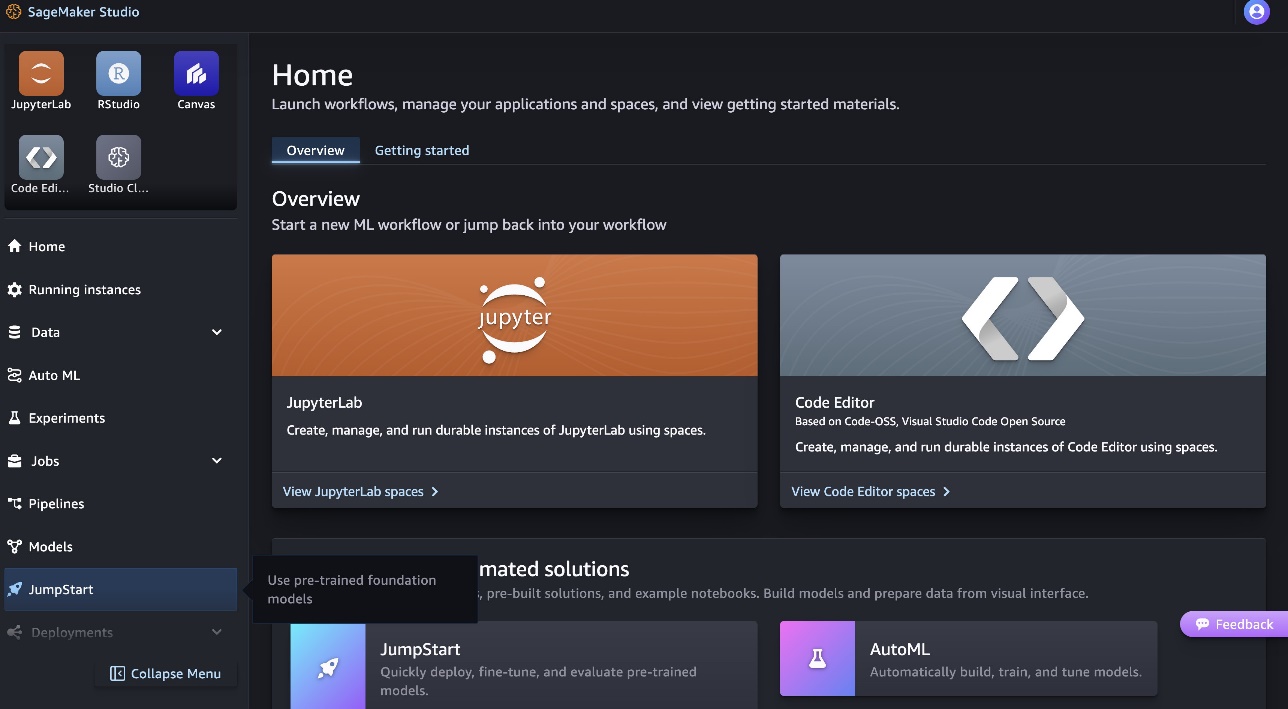

- בדף הבית של SageMaker Studio, בחר קפיצת פתיחה בחלונית הניווט.

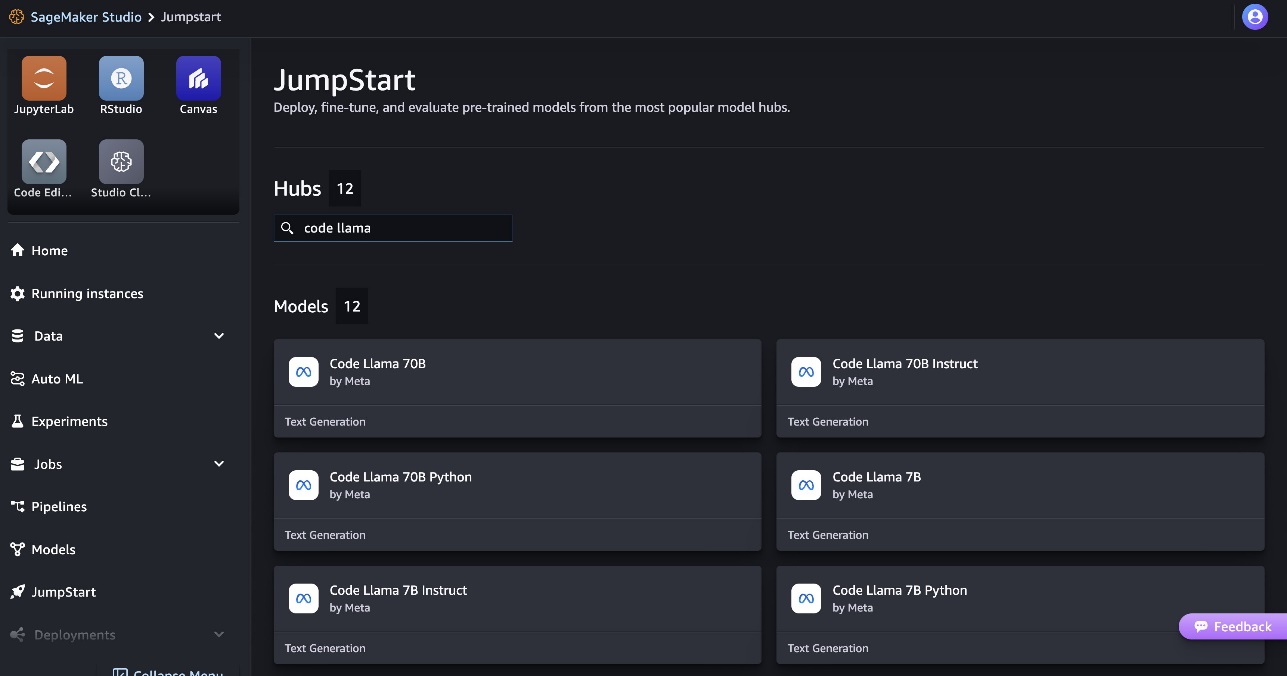

- חפש דגמי Code Llama ובחר את דגם Code Llama 70B מרשימת הדגמים המוצגים.

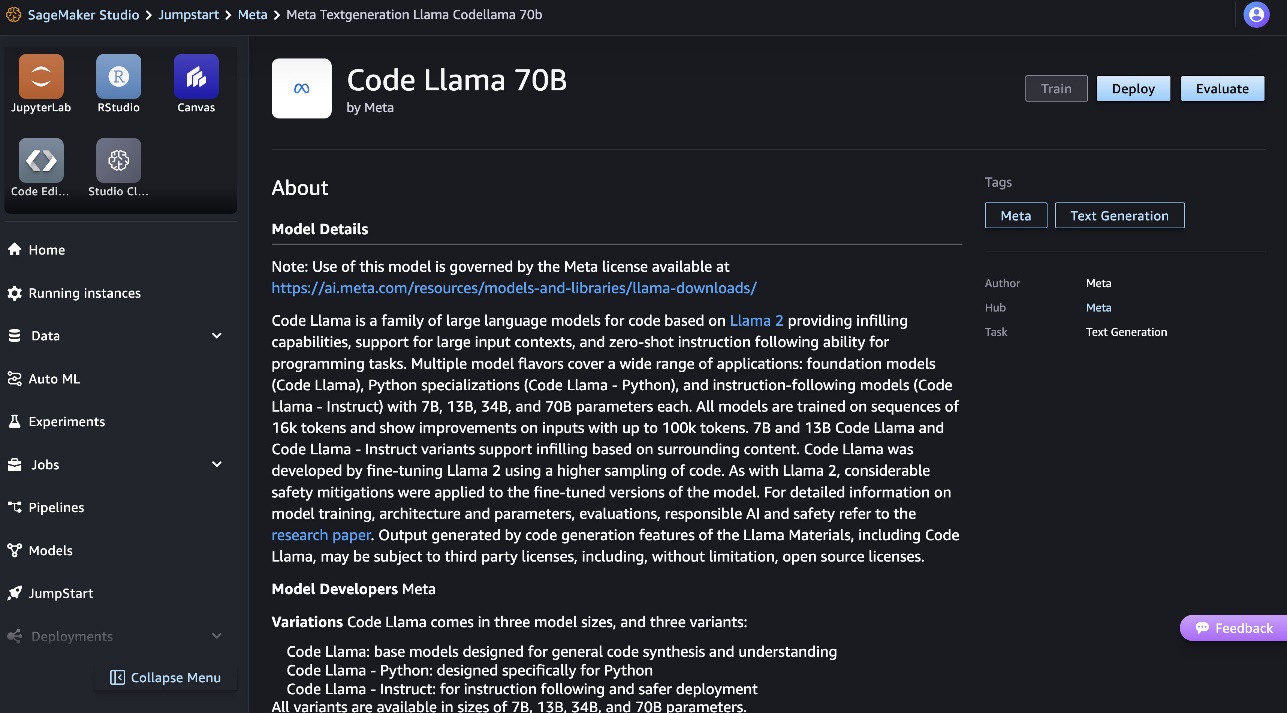

תוכל למצוא מידע נוסף על הדגם בכרטיס הדגם Code Llama 70B.

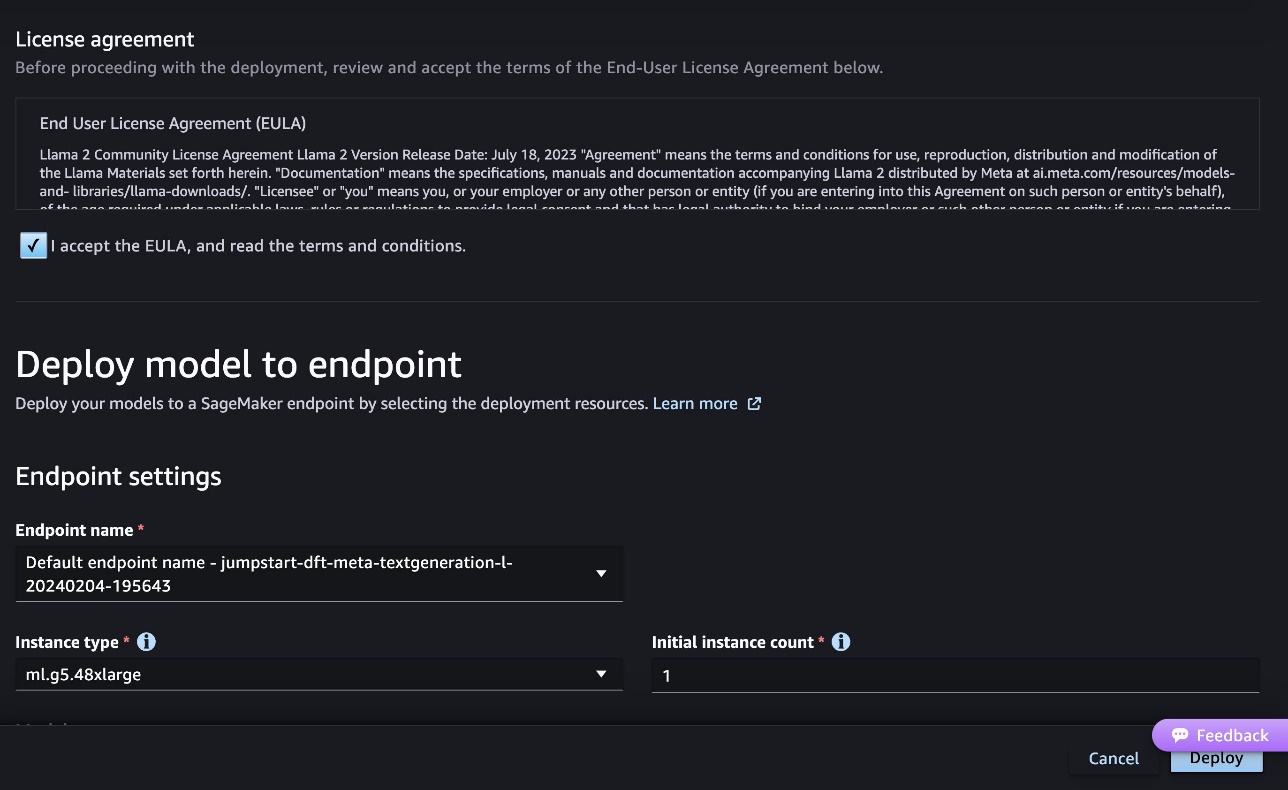

צילום המסך הבא מציג את הגדרות נקודת הקצה. אתה יכול לשנות את האפשרויות או להשתמש בברירת המחדל.

- קבל את הסכם הרישיון למשתמש הקצה (EULA) ובחר לפרוס.

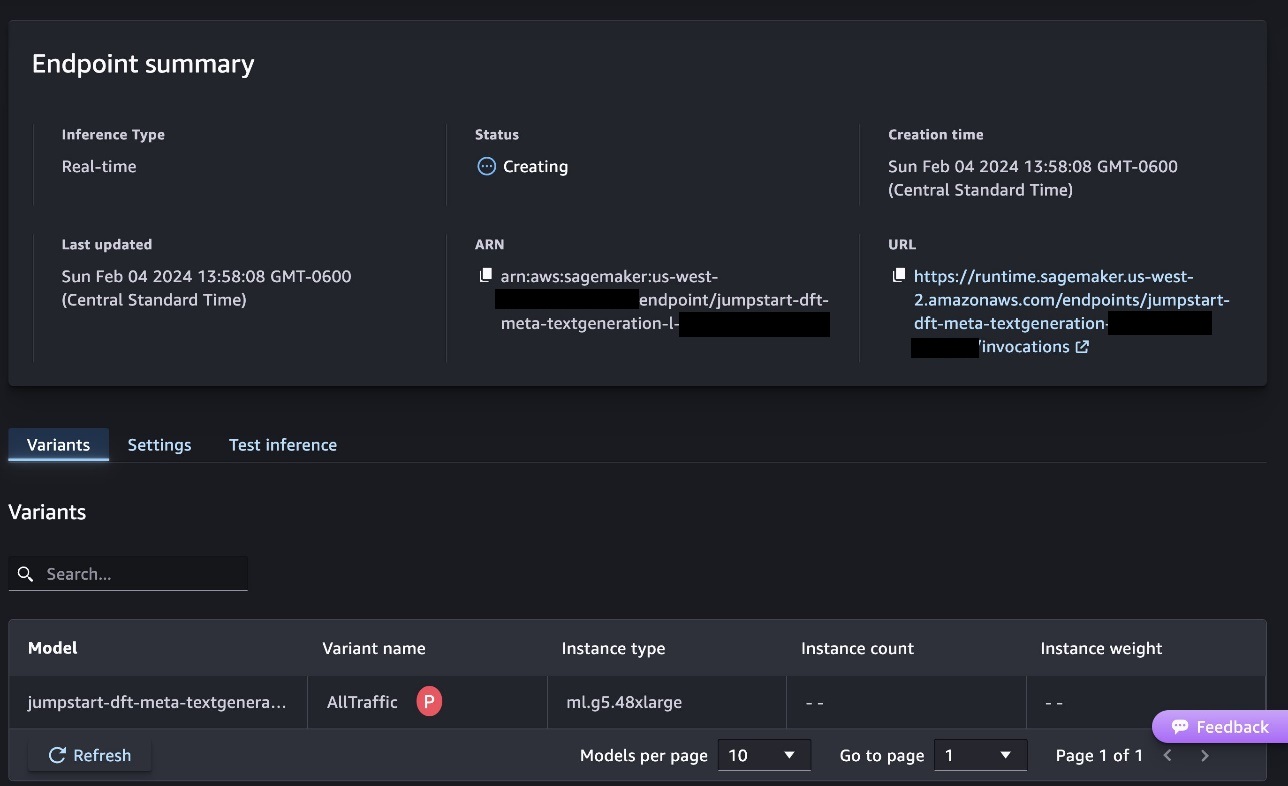

זה יתחיל את תהליך פריסת נקודות הקצה, כפי שמוצג בצילום המסך הבא.

פרוס את הדגם עם SageMaker Python SDK

לחלופין, תוכל לפרוס דרך המחברת לדוגמה על ידי בחירה פתח מחברת בתוך דף פרטי הדגם של Classic Studio. המחברת לדוגמה מספקת הדרכה מקצה לקצה כיצד לפרוס את המודל להסקת מסקנות וניקוי משאבים.

כדי לפרוס באמצעות מחברת, אנו מתחילים בבחירת דגם מתאים, שצוין על ידי model_id. אתה יכול לפרוס כל אחד מהדגמים שנבחרו ב- SageMaker עם הקוד הבא:

זה פורס את המודל ב- SageMaker עם תצורות ברירת מחדל, כולל סוג מופע ברירת מחדל ותצורות ברירת מחדל של VPC. אתה יכול לשנות תצורות אלה על ידי ציון ערכים שאינם ברירת מחדל ב JumpStartModel. שימו לב שכברירת מחדל, accept_eula מוגדר False. אתה צריך להגדיר accept_eula=True כדי לפרוס את נקודת הקצה בהצלחה. על ידי כך, אתה מקבל את הסכם רישיון המשתמש ומדיניות השימוש המקובל כפי שהוזכר קודם לכן. אתה יכול גם להורדה הסכם הרישיון.

הפעל נקודת קצה של SageMaker

לאחר פריסת נקודת הקצה, תוכל לבצע הסקה באמצעות Boto3 או SageMaker Python SDK. בקוד הבא, אנו משתמשים ב-SageMaker Python SDK כדי לקרוא למודל להסקה ולהדפיס את התגובה:

הפונקציה print_response לוקח מטען המורכב מהמטען ותגובת הדגם ומדפיס את הפלט. Code Llama תומך בפרמטרים רבים בעת ביצוע הסקה:

- אורך מקסימלי – המודל יוצר טקסט עד שאורך הפלט (הכולל את אורך ההקשר של הקלט) מגיע

max_length. אם צוין, זה חייב להיות מספר שלם חיובי. - max_new_tokens – המודל יוצר טקסט עד שאורך הפלט (לא כולל אורך ההקשר של הקלט) מגיע

max_new_tokens. אם צוין, זה חייב להיות מספר שלם חיובי. - num_beams - זה מציין את מספר הקורות המשמשות בחיפוש החמדני. אם צוין, הוא חייב להיות מספר שלם הגדול או שווה ל

num_return_sequences. - no_repeat_ngram_size – המודל מבטיח שרצף מילים של

no_repeat_ngram_sizeאינו חוזר על עצמו ברצף הפלט. אם צוין, זה חייב להיות מספר שלם חיובי הגדול מ-1. - טמפרטורה - זה שולט באקראיות בפלט. גבוה יותר

temperatureמביא לרצף פלט עם מילים בסבירות נמוכה, ומטהtemperatureמביא לרצף פלט עם מילים בסבירות גבוהה. אםtemperatureהוא 0, זה גורם לפענוח חמדני. אם צוין, זה חייב להיות ציפה חיובית. - עצירה מוקדמת - אם

True, יצירת טקסט מסתיימת כאשר כל השערות האלומה מגיעות לסוף המשפט. אם צוין, זה חייב להיות בוליאני. - do_sample - אם

True, המודל דוגם את המילה הבאה לפי הסבירות. אם צוין, זה חייב להיות בוליאני. - top_k – בכל שלב של יצירת טקסט, המודל דוגם רק מה-

top_kסביר להניח מילים. אם צוין, זה חייב להיות מספר שלם חיובי. - top_p - בכל שלב של יצירת טקסט, המודל דוגם מקבוצת המילים הקטנה ביותר האפשרית עם הסתברות מצטברת

top_p. אם צוין, זה חייב להיות צף בין 0 ל-1. - return_full_text - אם

True, טקסט הקלט יהיה חלק מהטקסט שנוצר בפלט. אם צוין, זה חייב להיות בוליאני. ערך ברירת המחדל עבורו הואFalse. - להפסיק – אם צוין, זה חייב להיות רשימה של מחרוזות. יצירת טקסט נעצרת אם אחת מהמחרוזות שצוינו נוצרת.

אתה יכול לציין כל תת-קבוצה של פרמטרים אלה בזמן הפעלת נקודת קצה. לאחר מכן, אנו מראים דוגמה כיצד להפעיל נקודת קצה באמצעות הטיעונים הללו.

השלמת קוד

הדוגמאות הבאות מדגימות כיצד לבצע השלמת קוד כאשר תגובת נקודת הקצה הצפויה היא ההמשך הטבעי של ההנחיה.

ראשית, אנו מריצים את הקוד הבא:

אנו מקבלים את הפלט הבא:

עבור הדוגמה הבאה שלנו, אנו מפעילים את הקוד הבא:

אנו מקבלים את הפלט הבא:

יצירת קוד

הדוגמאות הבאות מציגות יצירת קוד של Python באמצעות Code Llama.

ראשית, אנו מריצים את הקוד הבא:

אנו מקבלים את הפלט הבא:

עבור הדוגמה הבאה שלנו, אנו מפעילים את הקוד הבא:

אנו מקבלים את הפלט הבא:

אלו הן כמה מהדוגמאות למשימות הקשורות לקוד באמצעות Code Llama 70B. אתה יכול להשתמש במודל כדי ליצור קוד מסובך עוד יותר. אנו ממליצים לך לנסות את זה באמצעות מקרי שימוש ודוגמאות משלך הקשורים לקוד!

לנקות את

לאחר שבדקת את נקודות הקצה, ודא שאתה מוחק את נקודות הקצה של SageMaker ואת המודל כדי להימנע מחיובים. השתמש בקוד הבא:

סיכום

בפוסט זה, הצגנו את Code Llama 70B ב- SageMaker JumpStart. Code Llama 70B הוא מודל חדיש להפקת קוד מהנחיות בשפה טבעית וכן מקוד. אתה יכול לפרוס את המודל עם כמה שלבים פשוטים ב- SageMaker JumpStart ולאחר מכן להשתמש בו כדי לבצע משימות הקשורות לקוד כגון יצירת קוד ומילוי קוד. כשלב הבא, נסה להשתמש במודל עם מקרי שימוש ונתונים משלך הקשורים לקוד.

על המחברים

ד"ר קייל אולריך הוא מדען יישומי בצוות אמזון SageMaker JumpStart. תחומי המחקר שלו כוללים אלגוריתמים של למידת מכונה ניתנים להרחבה, ראייה ממוחשבת, סדרות זמן, אי-פרמטריות בייסיאניות ותהליכי גאוס. הדוקטורט שלו הוא מאוניברסיטת דיוק והוא פרסם מאמרים ב-NeurIPS, Cell, and Neuron.

ד"ר קייל אולריך הוא מדען יישומי בצוות אמזון SageMaker JumpStart. תחומי המחקר שלו כוללים אלגוריתמים של למידת מכונה ניתנים להרחבה, ראייה ממוחשבת, סדרות זמן, אי-פרמטריות בייסיאניות ותהליכי גאוס. הדוקטורט שלו הוא מאוניברסיטת דיוק והוא פרסם מאמרים ב-NeurIPS, Cell, and Neuron.

ד"ר פארוק סאביר הוא ארכיטקט פתרונות בכיר בבינה מלאכותית ולמידת מכונה ב-AWS. הוא בעל תואר דוקטור ותואר שני בהנדסת חשמל מאוניברסיטת טקסס באוסטין ותואר שני במדעי המחשב מהמכון הטכנולוגי של ג'ורג'יה. יש לו למעלה מ-15 שנות ניסיון בעבודה וגם אוהב ללמד ולהדריך סטודנטים. ב-AWS הוא עוזר ללקוחות לגבש ולפתור את הבעיות העסקיות שלהם במדעי הנתונים, למידת מכונה, ראייה ממוחשבת, בינה מלאכותית, אופטימיזציה מספרית ותחומים קשורים. ממוקם בדאלאס, טקסס, הוא ומשפחתו אוהבים לטייל ולצאת לנסיעות ארוכות.

ד"ר פארוק סאביר הוא ארכיטקט פתרונות בכיר בבינה מלאכותית ולמידת מכונה ב-AWS. הוא בעל תואר דוקטור ותואר שני בהנדסת חשמל מאוניברסיטת טקסס באוסטין ותואר שני במדעי המחשב מהמכון הטכנולוגי של ג'ורג'יה. יש לו למעלה מ-15 שנות ניסיון בעבודה וגם אוהב ללמד ולהדריך סטודנטים. ב-AWS הוא עוזר ללקוחות לגבש ולפתור את הבעיות העסקיות שלהם במדעי הנתונים, למידת מכונה, ראייה ממוחשבת, בינה מלאכותית, אופטימיזציה מספרית ותחומים קשורים. ממוקם בדאלאס, טקסס, הוא ומשפחתו אוהבים לטייל ולצאת לנסיעות ארוכות.

יוני זכה הוא מנהל מוצר עם SageMaker JumpStart. הוא מתמקד בהפיכת מודלים בסיסיים לניתנים לגילוי ושימוש בקלות כדי לעזור ללקוחות לבנות יישומי בינה מלאכותית. הניסיון שלו באמזון כולל גם אפליקציית קניות ניידת ומשלוח מייל אחרון.

יוני זכה הוא מנהל מוצר עם SageMaker JumpStart. הוא מתמקד בהפיכת מודלים בסיסיים לניתנים לגילוי ושימוש בקלות כדי לעזור ללקוחות לבנות יישומי בינה מלאכותית. הניסיון שלו באמזון כולל גם אפליקציית קניות ניידת ומשלוח מייל אחרון.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/code-llama-70b-is-now-available-in-amazon-sagemaker-jumpstart/

- :יש ל

- :הוא

- :לֹא

- :איפה

- $ למעלה

- 000

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- שנים 15

- 15%

- 16

- 22

- 25

- 500

- 7

- 80

- 9

- a

- אודות

- לְקַבֵּל

- קביל

- קבלה

- גישה

- התקדמות

- הסכם

- AI

- אלגוריתמים

- תעשיות

- גם

- אמזון בעברית

- אמזון SageMaker

- אמזון SageMaker JumpStart

- אמזון שירותי אינטרנט

- an

- ו

- להכריז

- כל

- בקשה

- יישומים

- יישומית

- מתאים

- ARE

- טיעונים

- אמנות

- מלאכותי

- בינה מלאכותית

- בינה מלאכותית ולמידה מכונה

- AS

- עוזר

- בטוח

- At

- אוסטין

- זמין

- לְהִמָנַע

- AWS

- בסיס

- מבוסס

- לחבוט

- בייסיאנית

- BE

- קרן

- כי

- בֵּין

- B

- מיליארד אסימונים

- מיליארדים

- שניהם

- בועה

- לִבנוֹת

- נבנה

- עסקים

- by

- C + +

- שיחה

- CAN

- מסוגל

- כרטיס

- לשאת

- מקרים

- קטגוריה

- תא

- שינוי

- מאפיינים

- חיובים

- בחרו

- בחירה

- בכיתה

- קלאסי

- לְנַקוֹת

- קליק

- קוד

- מִכלָלָה

- איך

- מגיע

- להשלים

- השלמה

- מסובך

- המחשב

- מדעי מחשב

- ראייה ממוחשבת

- מורכב

- קונסול

- תוכן

- הקשר

- המשך

- בקרות

- לכסות

- לִיצוֹר

- אוצר

- לקוחות

- דאלאס

- נתונים

- מדע נתונים

- פענוח

- בְּרִירַת מֶחדָל

- מסירה

- להפגין

- לפרוס

- פרס

- פריסה

- פורס

- מעוצב

- פרט

- מפותח

- מפתחים

- צעצועי התפתחות

- אחר

- דיגיטלי

- אמנות דיגיטלית

- לגלות

- do

- עושה

- תחומים

- דוכס

- אוניברסיטת דוכס

- כל אחד

- מוקדם יותר

- בקלות

- יעיל

- מה שמאפשר

- לעודד

- סוף

- מקצה לקצה

- נקודת קצה

- מהונדס

- הנדסה

- מבטיח

- שווה

- שגיאה

- הערכה

- אֲפִילוּ

- דוגמה

- דוגמאות

- Excel

- אלא

- נרגש

- לְמַעֵט

- קיימים

- צפוי

- יקר

- ניסיון

- מעריכי

- פָּנִים

- משפחה

- מעטים

- ראשון

- לָצוּף

- מתמקד

- הבא

- בעד

- קרן

- היסוד

- ארבע

- החל מ-

- פונקציה

- ליצור

- נוצר

- מייצר

- יצירת

- דור

- דורות

- גנרטטיבית

- AI Generative

- לקבל

- נתן

- Go

- יותר

- חמדן

- הדרכה

- יש

- he

- לעזור

- עזרה

- עוזר

- באיכות גבוהה

- גבוה יותר

- שֶׁלוֹ

- מחזיק

- עמוד הבית

- המארח

- אירח

- איך

- איך

- HTTPS

- טבור

- רכזות

- i

- אידאל

- if

- לייבא

- לשפר

- שיפורים

- in

- לכלול

- כולל

- כולל

- מצטבר

- מידע

- קלט

- תשומות

- למשל

- מכון

- הוראות

- מוֹדִיעִין

- אינטרסים

- הציג

- IT

- Java

- jpg

- ידוע

- קייל

- שפה

- גָדוֹל

- אחרון

- למידה

- עזיבה

- אורך

- רישיון

- סְבִירוּת

- סביר

- אוהב

- רשימה

- לאמה

- LLM

- ארוך

- אהבה

- להוריד

- מכונה

- למידת מכונה

- עשוי

- לעשות

- עשייה

- מנהל

- רב

- מוּזְכָּר

- המורה

- meta

- מיל

- ML

- סלולרי

- מודל

- מודלים

- יותר

- יותר יעיל

- רוב

- MS

- צריך

- טבעי

- ניווט

- צורך

- נחוץ

- לעולם לא

- חדש

- הבא

- הערות

- מחברה

- עַכשָׁיו

- מספר

- of

- on

- ONE

- יחידות

- רק

- אופטימיזציה

- אפשרויות

- or

- שלנו

- הַחוּצָה

- תפוקה

- יותר

- שֶׁלוֹ

- עמוד

- זגוגית

- ניירות

- פרמטרים

- חלק

- צדדים

- עבור

- לְבַצֵעַ

- ביצוע

- דוקטורט

- PHP

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- מדיניות

- פופולרי

- חיובי

- אפשרי

- הודעה

- פוטנציאל

- חיזוי

- קופונים להדפסה

- הדפסים

- בעיות

- תהליך

- תהליכים

- המוצר

- מנהל מוצר

- פִּריוֹן

- תכנות

- הנחיות

- לספק

- ספקים

- מספק

- לאור

- פיתון

- פיטורך

- מהירות

- אקראי

- רכס

- במקום

- לְהַגִיעַ

- מגיע

- לאחרונה

- קָשׁוּר

- שוחרר

- חזר

- מחקר

- משאבים

- תגובה

- REST

- תוצאות

- לַחֲזוֹר

- להפוך

- סקירה

- לעלות

- כביש

- הפעלה

- ריצה

- בעל חכמים

- SageMaker Inference

- אותו

- שמור

- להרחבה

- סולם

- מדע

- מַדְעָן

- Sdk

- חיפוש

- נבחר

- בחירה

- לחצני מצוקה לפנסיונרים

- משפט

- רצף

- סדרה

- שירותים

- סט

- הגדרות

- משותף

- קניות

- לְהַצִיג

- הראה

- הופעות

- פָּשׁוּט

- גדל

- So

- תוכנה

- פתרונות

- לפתור

- כמה

- מומחה

- מיוחד

- מפורט

- מפרט

- יציב

- התחלה

- החל

- מדינה-of-the-art

- שלב

- צעדים

- עוצר

- מחרוזת

- סטודנטים

- סטודיו

- בהצלחה

- כזה

- תמיכה

- תומך

- בטוח

- הסובב

- לוקח

- משימות

- נבחרת

- טכנולוגיה

- tensorflow

- מונחים

- מבחן

- נבדק

- טקסס

- טֶקסט

- מֵאֲשֶׁר

- זֶה

- השמיים

- שֶׁלָהֶם

- אותם

- עצמם

- אז

- אלה

- שְׁלִישִׁי

- צד שלישי

- זֶה

- שְׁלוֹשָׁה

- דרך

- זמן

- סדרת זמן

- ל

- אסימון

- מטבעות

- חלק עליון

- רכבת

- מְאוּמָן

- תרגום

- נסיעות

- לַחֲצוֹת

- נָכוֹן

- לנסות

- סוג

- כתב כתיבה

- בדרך כלל

- ui

- תחת

- הבנה

- אוניברסיטה

- עד

- שָׁמִישׁ

- נוֹהָג

- להשתמש

- מְשׁוּמָשׁ

- משתמש

- באמצעות

- ערך

- ערכים

- מגוון

- גרסה

- באמצעות

- חזון

- ללכת

- רוצה

- we

- אינטרנט

- שירותי אינטרנט

- טוֹב

- היו

- מתי

- אם

- אשר

- בזמן

- רָחָב

- יישומון

- יצטרך

- עם

- בתוך

- לְלֹא

- Word

- מילים

- תיק עבודות

- זרימת עבודה

- זרימות עבודה

- לכתוב

- שנים

- אתה

- זפירנט