לתעשיית משחקי הווידאו יש בסיס משתמשים מוערך של למעלה מ-3 מיליארד ברחבי העולם1. זה מורכב מכמויות אדירות של שחקנים המקיימים אינטראקציה כמעט זה עם זה מדי יום. למרבה הצער, כמו בעולם האמיתי, לא כל השחקנים מתקשרים בצורה הולמת ומכבדת. במאמץ ליצור ולתחזק סביבת משחק אחראית חברתית, שירותים מקצועיים של AWS התבקשו לבנות מנגנון שמזהה שפה לא הולמת (דיבור רעיל) בתוך אינטראקציות עם שחקנים מקוונים. התוצאה העסקית הכוללת הייתה שיפור הפעילות של הארגון על ידי אוטומציה של תהליך ידני קיים ושיפור חווית המשתמש על ידי הגברת המהירות והאיכות באיתור אינטראקציות לא מתאימות בין שחקנים, ובסופו של דבר קידום סביבת משחק נקייה ובריאה יותר.

בקשת הלקוח הייתה ליצור גלאי שפה אנגלית המסווגת קטעי קול וטקסט לקטגוריות שפה רעילות המוגדרות בהתאמה אישית. הם רצו קודם כל לקבוע אם קטע השפה הנתון הוא רעיל, ולאחר מכן לסווג את הקטע בקטגוריה ספציפית המוגדרת על ידי הלקוח של רעילות כגון ניבול פה או שפה פוגענית.

AWS ProServe פתרה את מקרה השימוש הזה באמצעות מאמץ משותף בין ה- Generative AI Innovation Center (GAIIC) וצוות ה-ProServe ML Delivery (MLDT). ה-AWS GAIIC היא קבוצה בתוך AWS ProServe שמשלבת לקוחות עם מומחים כדי לפתח פתרונות AI גנרטיביים עבור מגוון רחב של מקרי שימוש עסקיים תוך שימוש בבניית הוכחה לקונספציה (PoC). לאחר מכן, AWS ProServe MLDT מעביר את ה-PoC דרך הייצור על ידי קנה מידה, הקשחה ושילוב הפתרון עבור הלקוח.

מקרה שימוש זה של לקוחות יוצג בשני פוסטים נפרדים. פוסט זה (חלק 1) משמש כצלילה עמוקה לתוך המתודולוגיה המדעית. הוא יסביר את תהליך החשיבה והניסוי מאחורי הפתרון, כולל תהליך ההכשרה והפיתוח של המודל. חלק 2 יתעמק בפתרון המיוצר, ויסביר את החלטות התכנון, זרימת הנתונים והמחשה של ארכיטקטורת ההדרכה והפריסה של המודל.

פוסט זה מכסה את הנושאים הבאים:

- האתגרים ש-AWS ProServe היה צריך לפתור עבור מקרה השימוש הזה

- הקשר היסטורי לגבי מודלים של שפה גדולה (LLMs) ומדוע טכנולוגיה זו מתאימה באופן מושלם למקרה שימוש זה

- הפתרון של PoC ו-AWS ProServe MLDT של AWS GAIIC מנקודת מבט של מדעי נתונים ולמידת מכונה (ML)

אתגר נתונים

האתגר העיקרי שעמד בפני AWS ProServe בהכשרת מסווג שפה רעילה היה השגת מספיק נתונים מסומנים מהלקוח כדי לאמן מודל מדויק מאפס. AWS קיבלה מהלקוח כ-100 דגימות של נתונים מתויגים, וזה הרבה פחות מ-1,000 הדגימות המומלצות לכוונון עדין של לימודי LLM בקהילת מדעי הנתונים.

כאתגר מובנה נוסף, ידועים היסטוריים כי מסווגים לעיבוד שפה טבעית (NLP) יקרים מאוד לאימון ודורשים מערך גדול של אוצר מילים, המכונה גוף, כדי לייצר תחזיות מדויקות. פתרון NLP קפדני ויעיל, אם יסופק כמויות מספקות של נתונים מתויגים, יהיה הדרכה של מודל שפה מותאם אישית באמצעות הנתונים המסומנים של הלקוח. המודל יאומן אך ורק עם אוצר המילים של השחקנים, מה שהופך אותו מותאם לשפה הנצפית במשחקים. ללקוח היו גם מגבלות עלויות וגם מגבלות זמן שהפכו את הפתרון הזה לבלתי כדאי. AWS ProServe נאלץ למצוא פתרון לאימון מסווג רעילות שפה מדויק עם מערך נתונים קטן יחסית עם תווית. הפתרון טמון במה שמכונה העברת למידה.

הרעיון מאחורי למידת העברה הוא להשתמש בידע של מודל שהוכשר מראש וליישם אותו על בעיה שונה אך דומה יחסית. לדוגמה, אם מסווג תמונות הוכשר לחזות אם תמונה מכילה חתול, אתה יכול להשתמש בידע שהמודל צבר במהלך הכשרתו כדי לזהות חיות אחרות כמו נמרים. במקרה של שימוש בשפה זה, AWS ProServe היה צריך למצוא מסווג שפה שעבר הכשרה שעברה הכשרה לזהות שפה רעילה ולכוונן אותה באמצעות הנתונים המסומנים של הלקוח.

הפתרון היה למצוא ולכוונן LLM כדי לסווג שפה רעילה. LLMs הן רשתות עצביות שהוכשרו באמצעות מספר עצום של פרמטרים, בדרך כלל בסדר גודל של מיליארדים, תוך שימוש בנתונים לא מסומנים. לפני שנכנסים לפתרון AWS, הסעיף הבא מספק סקירה כללית של ההיסטוריה של LLMs ומקרי השימוש ההיסטוריים שלהם.

מנצלים את הכוח של LLMs

LLMs הפכו לאחרונה למוקד לעסקים המחפשים יישומים חדשים של ML, מאז ש-ChatGPT תפס את שיתוף הפעולה הציבורי בהיותו יישום הצרכנים הצומח ביותר בהיסטוריה2, להגיע ל-100 מיליון משתמשים פעילים עד ינואר 2023, חודשיים בלבד לאחר שחרורו. עם זאת, LLMs אינם טכנולוגיה חדשה בתחום ה-ML. נעשה בהם שימוש נרחב לביצוע משימות NLP כגון ניתוח סנטימנט, סיכום גופים, חילוץ מילות מפתח, תרגום דיבור וסיווג טקסט.

בשל האופי הרציף של טקסט, רשתות עצביות חוזרות (RNNs) היו המצב המתקדם ביותר עבור דוגמנות NLP. באופן ספציפי, ה מקודד-מפענח ארכיטקטורת הרשת גובשה מכיוון שהיא יצרה מבנה RNN המסוגל לקחת קלט באורך שרירותי ולייצר פלט באורך שרירותי. זה היה אידיאלי עבור משימות NLP כמו תרגום שבהן ניתן היה לחזות ביטוי פלט של שפה אחת מביטוי קלט של שפה אחרת, בדרך כלל עם מספר שונה של מילים בין הקלט והפלט. ארכיטקטורת הרובוטריק3 (Vaswani, 2017) היה שיפור פורץ דרך במקודד-מפענח; זה הציג את המושג של תשומת לב עצמית, מה שאפשר למודל למקד את תשומת הלב שלו במילים שונות על ביטויי הקלט והפלט. במקודד-מפענח טיפוסי, כל מילה מתפרשת על ידי הדגם בצורה זהה. כאשר המודל מעבד ברצף כל מילה בביטוי קלט, המידע הסמנטי בתחילת הביטוי עלול ללכת לאיבוד עד סוף הביטוי. מנגנון הקשב העצמי שינה זאת על ידי הוספת שכבת קשב הן לבלוק המקודד והן לבלוק המפענח, כך שהמודל יוכל לשים משקלים שונים על מילים מסוימות מביטוי הקלט בעת יצירת מילה מסוימת בביטוי הפלט. כך נולד הבסיס של מודל השנאים.

ארכיטקטורת השנאים הייתה הבסיס לשניים מה-LLMs הידועים והפופולריים ביותר בשימוש כיום, ייצוגי הקוד הדו-כיווני של רובוטריקים (BERT)4 (רדפורד, 2018) והשנאי המוכשר מראש (GPT)5 (Devlin 2018). גרסאות מאוחרות יותר של דגם ה-GPT, כלומר GPT3 ו-GPT4, הן המנוע שמניע את אפליקציית ChatGPT. החלק האחרון של המתכון שהופך את ה-LLM לעוצמתי כל כך הוא היכולת לזקק מידע מגופי טקסט עצומים ללא תיוג מקיף או עיבוד מקדים באמצעות תהליך הנקרא ULMFiT. לשיטה זו יש שלב אימון קדם שבו ניתן לאסוף טקסט כללי ולאמן את המודל במשימה של חיזוי המילה הבאה על סמך מילים קודמות; היתרון כאן הוא שכל טקסט קלט המשמש לאימון מסומן מטבעו על סמך סדר הטקסט. לימודי תואר שני מסוגלים באמת ללמוד מנתונים בקנה מידה אינטרנט. לדוגמה, המודל המקורי של BERT עבר הכשרה מוקדמת ב-BookCorpus ובכל מערכי הטקסט של ויקיפדיה האנגלית.

פרדיגמת הדוגמנות החדשה הזו הולידה שני מושגים חדשים: מודלים בסיסיים (FMs) ו- Generative AI. בניגוד לאימון מודל מאפס עם נתונים ספציפיים למשימה, שהוא המקרה הרגיל ללמידה מפוקחת קלאסית, LLMs מאומנים מראש כדי לחלץ ידע כללי ממערך טקסט רחב לפני שהם מותאמים למשימות ספציפיות או לתחומים עם הרבה יותר קטן מערך נתונים (בדרך כלל בסדר גודל של מאות דוגמאות). זרימת העבודה החדשה של ML מתחילה כעת עם מודל מאומן מראש המכונה מודל יסוד. חשוב לבנות על הבסיס הנכון, ויש יותר ויותר אפשרויות, כמו החדשה מכשירי אמזון טיטאן FM, שישוחרר על ידי AWS כחלק מ סלע אמזון. מודלים חדשים אלה נחשבים גם ליצירתיים מכיוון שהתפוקות שלהם ניתנות לפירוש אנושי ובאותו סוג נתונים כמו נתוני הקלט. בעוד שמודלים של ML בעבר היו תיאוריים, כמו סיווג תמונות של חתולים לעומת כלבים, LLMs הם יצירתיים מכיוון שהפלט שלהם הוא קבוצת המילים הבאה המבוססת על מילות קלט. זה מאפשר להם להפעיל יישומים אינטראקטיביים כמו ChatGPT שיכולים להיות אקספרסיביים בתוכן שהם מייצרים.

Hugging Face שיתף פעולה עם AWS לעשות דמוקרטיזציה של חברות FM ולהפוך אותן קלות לגישה ולבנייה איתם. חיבוק פנים יצר א רובוטריקים API שמאחד יותר מ-50 ארכיטקטורות שנאים שונות במסגרות ML שונות, כולל גישה למשקולות מודל מאומנות מראש רכזת דגם, שצמח ליותר מ-200,000 דגמים נכון לכתיבת הפוסט הזה. בסעיפים הבאים, אנו חוקרים את הוכחת הרעיון, הפתרון וה-FM שנבדקו ונבחרו כבסיס לפתרון מקרה השימוש בסיווג דיבור רעיל זה עבור הלקוח.

AWS GAIIC הוכחה לקונספט

AWS GAIIC בחרה להתנסות במודלים של בסיס LLM עם ארכיטקטורת BERT כדי לכוונן עדין סיווג שפה רעילה. בסך הכל נבדקו שלושה דגמים ממרכז הדגמים של Hugging Face:

כל שלוש ארכיטקטורות המודל מבוססות על BERTweet ארכיטקטורה. BERTweet מאומן על בסיס ה רוברטה הליך טרום אימון. הליך ההדרכה המקדים של RoBERTa הוא תוצאה של מחקר שכפול של אימון מקדים של BERT שהעריך את ההשפעות של כוונון היפרפרמטרים וגודל מערך האימון כדי לשפר את המתכון לאימון מודלים של BERT6 (ליו 2019). הניסוי ביקש למצוא שיטת אימון מוקדמת ששיפרה את תוצאות הביצועים של BERT מבלי לשנות את הארכיטקטורה הבסיסית. מסקנת המחקר מצאה שהשינויים הבאים לפני האימון שיפרו משמעותית את הביצועים של BERT:

- אימון המודל עם אצוות גדולות יותר על פני יותר נתונים

- הסרת מטרת חיזוי המשפט הבא

- אימון על רצפים ארוכים יותר

- שינוי דינמי של תבנית המיסוך המוחלת על נתוני האימון

המודל הבסיסי של bertweet משתמש בהליך ההכשרה הקודמת ממחקר RoBERTa כדי לאמן מראש את ארכיטקטורת BERT המקורית באמצעות 850 מיליון ציוצים באנגלית. זהו מודל השפה הציבורי הראשון בקנה מידה גדול שהוכשר מראש לציוצים באנגלית.

FM מיומנים מראש המשתמשים בציוצים נחשבו להתאים למקרה השימוש משתי סיבות תיאורטיות עיקריות:

- אורך הציוץ דומה מאוד לאורכו של ביטוי לא הולם או רעיל שנמצא בצ'אטים של משחקים מקוונים

- ציוצים מגיעים מאוכלוסיה עם מגוון גדול של משתמשים שונים, בדומה לזה של האוכלוסייה שנמצאת בפלטפורמות המשחקים

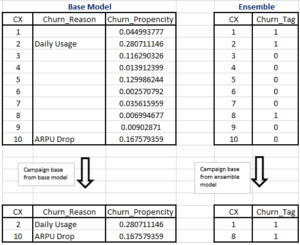

AWS החליטה תחילה לכוונן את BERTweet עם הנתונים המסומנים של הלקוח כדי לקבל קו בסיס. לאחר מכן בחרו לכוונן שני FMs אחרים ב-bertweet-base-offensive and bertweet-base-hate שהוכשרו מראש במיוחד על ציוצים רעילים רלוונטיים יותר כדי להשיג דיוק פוטנציאלי גבוה יותר. המודל של bertweet-base-offensive משתמש בבסיס BertTweet FM והוא מיומן מראש על 14,100 ציוצים מוערים שנחשבו כפוגעניים7 (Zampieri 2019). מודל ה-bertweet-base-hate משתמש גם ב-BertTweet FM הבסיסי, אך מיומן מראש על 19,600 ציוצים שנחשבו כדברי שטנה8 (בזיל 2019).

כדי לשפר עוד יותר את הביצועים של מודל PoC, AWS GAIIC קיבלה שתי החלטות עיצוביות:

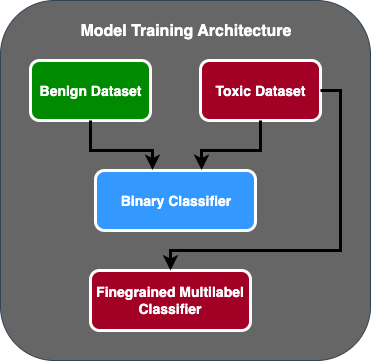

- יצר זרימת חיזוי דו-שלבית שבה המודל הראשון פועל כמסווג בינארי שמסווג אם קטע טקסט רעיל או לא רעיל. הדגם השני הוא דגם עדין המסווג טקסט לפי סוגי הרעילים המוגדרים של הלקוח. רק אם המודל הראשון מנבא את הטקסט כרעיל, הוא מועבר לדגם השני.

- הגדילו את נתוני האימון והוסיפו תת-קבוצה של מערך נתונים של טקסט רעיל מסומן על ידי צד שלישי מתחרות Kaggle ציבורית (רעילות פאזל) ל-100 הדגימות המקוריות שהתקבלו מהלקוח. הם מיפו את תוויות הפאזל לתוויות הרעילות המוגדרות על ידי הלקוח, ועשו פיצול של 80% כנתוני אימון ו-20% כנתוני בדיקה כדי לאמת את המודל.

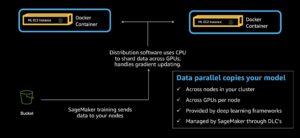

נעשה שימוש ב-AWS GAIIC אמזון SageMaker מחברות כדי להריץ את ניסויי הכוונון העדין שלהם וגילו שהמודל של bertweet-base-offensive השיג את הציונים הטובים ביותר בערכת האימות. הטבלה הבאה מסכמת את הציונים המטריים שנצפו.

| מספר סימוכין | דיוק | להיזכר | F1 | AUC |

| בינרי | . 92 | . 90 | . 91 | . 92 |

| עדין | . 81 | . 80 | . 81 | . 89 |

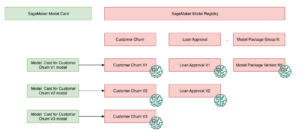

מנקודה זו, GAIIC מסרה את ה-PoC לצוות המסירה של AWS ProServe ML כדי לייצר את ה-PoC.

פתרון AWS ProServe ML Delivery Team

כדי לייצר את ארכיטקטורת המודל, AWS ProServe ML Delivery Team (MLDT) התבקש על ידי הלקוח ליצור פתרון שניתן להרחבה וקל לתחזוקה. היו כמה אתגרי תחזוקה של גישת מודל דו-שלבי:

- המודלים ידרשו כמות כפולה של ניטור מודל, מה שהופך את תזמון ההכשרה מחדש ללא עקבי. ייתכנו מקרים שדגם אחד יצטרך לעבור הכשרה מחדש לעתים קרובות יותר מהשני.

- עלויות מוגברות של הפעלת שני דגמים בניגוד לאחד.

- מהירות ההסקה מואטת מכיוון שהמסק עובר דרך שני מודלים.

כדי להתמודד עם האתגרים הללו, AWS ProServe MLDT היה צריך להבין כיצד להפוך את ארכיטקטורת המודל הדו-שלבי לארכיטקטורת מודל יחיד, תוך כדי יכולת לשמור על הדיוק של הארכיטקטורה הדו-שלבית.

הפתרון היה קודם כל לבקש מהלקוח עוד נתוני הכשרה, ואז לכוונן את המודל הפוגעני של bertweet על כל התוויות, כולל דגימות לא רעילות, לדגם אחד. הרעיון היה שכוונון עדין של מודל אחד עם יותר נתונים יביא לתוצאות דומות כמו כוונון עדין של ארכיטקטורת מודל דו-שלבי על פחות נתונים. כדי לכוונן עדין את ארכיטקטורת המודל הדו-שלבי, AWS ProServe MLDT עדכנה את ראש הסיווג הרב-תווית של המודל שהוכשר מראש כך שיכלול צומת אחד נוסף כדי לייצג את המחלקה הלא רעילה.

להלן דגימת קוד של האופן שבו תוכל לכוונן דגם מאומן מראש ממרכז המודלים של Hugging Face באמצעות פלטפורמת השנאים שלהם ולשנות את ראש הסיווג הרב-תוויות של הדגם כדי לחזות את מספר המחלקות הרצוי. AWS ProServe MLDT השתמש בתוכנית זו כבסיס לכוונון עדין. זה מניח שנתוני הרכבת ונתוני האימות שלך מוכנים ובפורמט הקלט הנכון.

ראשית, מודולי Python מיובאים כמו גם הדגם המיומן מראש ממרכז המודלים של Hugging Face:

לאחר מכן, הדגם שהוכשר מראש נטען ומוכן לכוונון עדין. זהו השלב שבו מגדירים את מספר הקטגוריות הרעילות וכל פרמטרי המודל:

כוונון עדין של המודל מתחיל בהזנת נתיבים למערכי הנתונים של ההדרכה והאימות:

AWS ProServe MLDT קיבלה עוד כ-5,000 דגימות נתונים מתויגות, 3,000 אינן רעילות ו-2,000 רעילות, וכיוונה עדינה את כל שלושת הדגמים המבוססים על bertweet, תוך שילוב כל התוויות לדגם אחד. הם השתמשו בנתונים אלה בנוסף ל-5,000 הדגימות מה-PoC כדי לכוונן מודלים חד-שלביים חדשים באמצעות אותה שיטת 80% רכבת, 20% ערכת בדיקה. הטבלה הבאה מראה שציוני הביצועים היו דומים לזה של המודל הדו-שלבי.

| מספר סימוכין | דיוק | להיזכר | F1 | AUC |

| bertweet-base (1-Stage) | . 76 | . 72 | . 74 | . 83 |

| bertweet-base-hate (1-Stage) | . 85 | . 82 | . 84 | . 87 |

| bertweet-base-offensive (1-Stage) | . 88 | . 83 | . 86 | . 89 |

| bertweet-base-offensive (2-Stage) | . 91 | . 90 | . 90 | . 92 |

גישת המודל החד-שלבי סיפקה את שיפורי העלות והתחזוקה תוך הפחתת הדיוק ב-3%. לאחר שקלול הפשרות, הלקוח בחר ב-AWS ProServe MLDT כדי לייצר את הדגם החד-שלבי.

על ידי כוונון עדין של דגם אחד עם נתונים מתויגים יותר, AWS ProServe MLDT הצליח לספק פתרון שעמד בסף של הלקוח לדיוק הדגם, כמו גם לספק את בקשתו לקלות תחזוקה, תוך הפחתת עלויות והגדלת החוסן.

סיכום

לקוח משחק גדול חיפש דרך לזהות שפה רעילה בתוך ערוצי התקשורת שלו כדי לקדם סביבת משחקים אחראית חברתית. AWS GAIIC יצרה PoC של גלאי שפה רעילה על ידי כוונון עדין של LLM לזיהוי שפה רעילה. AWS ProServe MLDT עדכנה אז את זרימת ההדרכה של המודל מגישה דו-שלבית לגישה חד-שלבית ויצרה את ה-LLM עבור הלקוח לשימוש בקנה מידה.

בפוסט זה, AWS מדגים את האפקטיביות והמעשיות של כוונון עדין של LLM כדי לפתור מקרה שימוש זה של לקוחות, חולק הקשר על ההיסטוריה של מודלים בסיסיים ו-LLMs, ומציג את זרימת העבודה בין AWS Generative AI Innovation Center ו-AWS ProServe ML צוות משלוחים. בפוסט הבא בסדרה זו, נצלול לעומק כיצד AWS ProServe MLDT ייצר את הדגם החד-שלבי שנוצר באמצעות SageMaker.

אם אתה מעוניין לעבוד עם AWS כדי לבנות פתרון AI Generative, אנא פנה אל GAIIC. הם יעריכו את מקרה השימוש שלך, יבנו הוכחה מבוססת AI מבוססת, ויהיה להם אפשרויות להרחיב את שיתוף הפעולה עם AWS כדי ליישם את ה-PoC שנוצר לייצור.

הפניות

- דמוגרפיה של גיימרים: עובדות וסטטיסטיקות על התחביב הפופולרי ביותר בעולם

- ChatGPT קובע שיא עבור בסיס המשתמשים הצומח ביותר - הערת אנליסט

- Vaswani וחב', "תשומת לב היא כל מה שאתה צריך"

- רדפורד וחב', "שיפור הבנת השפה על ידי אימון מקדים גנרטיבי"

- Devlin וחב', "BERT: אימון מקדים של רובוטריקים דו-כיווניים עמוקים להבנת שפה"

- Yinhan Liu וחב', "RoBERTa: A Robustly Optimized Pretraining BERT Approach"

- Marcos Zampieri וחב', "SemEval-2019 משימה 6: זיהוי וסיווג שפה פוגענית במדיה חברתית (OffensEval)"

- Valerio Basile וחב', "SemEval-2019 משימה 5: זיהוי רב לשוני של דברי שנאה נגד מהגרים ונשים בטוויטר"

על המחברים

ג'יימס פוקיז הוא מדען נתונים עם שירותים מקצועיים של AWS שבסיסו במחוז אורנג', קליפורניה. יש לו תואר ראשון במדעי המחשב מאוניברסיטת קליפורניה, אירווין ויש לו כמה שנות ניסיון בעבודה בתחום הנתונים לאחר שמילא תפקידים רבים ושונים. כיום הוא עובד על הטמעה ופריסה של פתרונות ML הניתנים להרחבה כדי להשיג תוצאות עסקיות עבור לקוחות AWS.

ג'יימס פוקיז הוא מדען נתונים עם שירותים מקצועיים של AWS שבסיסו במחוז אורנג', קליפורניה. יש לו תואר ראשון במדעי המחשב מאוניברסיטת קליפורניה, אירווין ויש לו כמה שנות ניסיון בעבודה בתחום הנתונים לאחר שמילא תפקידים רבים ושונים. כיום הוא עובד על הטמעה ופריסה של פתרונות ML הניתנים להרחבה כדי להשיג תוצאות עסקיות עבור לקוחות AWS.

האן מן הוא מנהל בכיר למדעי נתונים ולמידת מכונה עם שירותים מקצועיים של AWS שבסיסו בסן דייגו, קליפורניה. יש לו דוקטורט בהנדסה מאוניברסיטת נורת'ווסטרן ויש לו ניסיון של מספר שנים כיועץ ניהולי בייעוץ ללקוחות בייצור, שירותים פיננסיים ואנרגיה. כיום, הוא עובד בלהט עם לקוחות מפתח ממגוון רחב של ענפים כדי לפתח ולהטמיע פתרונות ML ו-GenAI ב-AWS.

האן מן הוא מנהל בכיר למדעי נתונים ולמידת מכונה עם שירותים מקצועיים של AWS שבסיסו בסן דייגו, קליפורניה. יש לו דוקטורט בהנדסה מאוניברסיטת נורת'ווסטרן ויש לו ניסיון של מספר שנים כיועץ ניהולי בייעוץ ללקוחות בייצור, שירותים פיננסיים ואנרגיה. כיום, הוא עובד בלהט עם לקוחות מפתח ממגוון רחב של ענפים כדי לפתח ולהטמיע פתרונות ML ו-GenAI ב-AWS.

סאפא טינזטפה הוא מדען נתונים מלא עם שירותים מקצועיים של AWS. יש לו תואר ראשון במדעי המחשב מאוניברסיטת אמורי ויש לו תחומי עניין ב-MLOps, מערכות מבוזרות ו-web3.

סאפא טינזטפה הוא מדען נתונים מלא עם שירותים מקצועיים של AWS. יש לו תואר ראשון במדעי המחשב מאוניברסיטת אמורי ויש לו תחומי עניין ב-MLOps, מערכות מבוזרות ו-web3.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. רכב / רכבים חשמליים, פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- BlockOffsets. מודרניזציה של בעלות על קיזוז סביבתי. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :יש ל

- :הוא

- :לֹא

- :איפה

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- יכולת

- יכול

- אודות

- גישה

- דיוק

- מדויק

- להשיג

- הושג

- פעיל

- מעשים

- הוסיף

- מוסיף

- תוספת

- כתובת

- ייעוץ

- לאחר

- נגד

- AI

- AL

- תעשיות

- מותר

- מאפשר

- גם

- אמזון בעברית

- אמזון שירותי אינטרנט

- כמות

- כמויות

- an

- מנתח

- ניתוח

- ו

- בעלי חיים

- אחר

- כל

- בקשה

- יישומים

- יישומית

- החל

- גישה

- כראוי

- בערך

- ארכיטקטורה

- ARE

- טיעונים

- אמנות

- AS

- לְהַעֲרִיך

- המשויך

- מניח

- At

- תשומת לב

- אוטומציה

- AWS

- שירותים מקצועיים של AWS

- בסיס

- מבוסס

- Baseline

- בסיס

- BE

- כי

- להיות

- היה

- לפני

- ההתחלה

- מאחור

- להיות

- להלן

- תועלת

- הטוב ביותר

- בֵּין

- גדול

- B

- מיליארדים

- לחסום

- נולד

- שניהם

- פריצת דרך

- רחב

- לִבנוֹת

- בונה

- עסקים

- עסקים

- אבל

- by

- CA

- קליפורניה

- נקרא

- CAN

- מסוגל

- נתפס

- מקרה

- מקרים

- חָתוּל

- קטגוריות

- סיווג

- קטגוריה

- חתולים

- מרכז

- מסוים

- לאתגר

- האתגרים

- השתנה

- משתנה

- ערוצים

- ChatGPT

- בחר

- נבחר

- בכיתה

- כיתות

- מיון

- לסווג

- לקוחות

- קוד

- שיתוף פעולה

- שילוב

- איך

- מגיע

- להעביר

- תקשורת

- קהילה

- חברה

- השוואה

- תחרות

- המחשב

- מדעי מחשב

- מושג

- מושגים

- מסקנה

- נחשב

- מורכב

- אילוצים

- יועץ

- צרכן

- מכיל

- תוכן

- הקשר

- לתקן

- עלות

- יקר

- עלויות

- יכול

- מחוז

- מכסה

- לִיצוֹר

- נוצר

- מנהג

- לקוח

- לקוחות

- נתונים

- מדע נתונים

- מדען נתונים

- מערכי נתונים

- יְוֹם

- החליט

- החלטות

- נחשב

- עמוק

- צלילה לעומק

- עמוק יותר

- לְהַגדִיר

- מוגדר

- למסור

- נתן

- מסירה

- להתעמק

- דמוקרטיזציה

- דמוגרפיה

- מדגים

- פריסה

- פריסה

- עיצוב

- רצוי

- לאתר

- איתור

- לקבוע

- לפתח

- צעצועי התפתחות

- DID

- דייגו

- אחר

- נבדלים זה מזה

- מופץ

- מערכות מבוזרות

- עושה

- תחום

- תחומים

- לְהַכפִּיל

- דיבוב

- בְּמַהֲלָך

- E&T

- כל אחד

- להקל

- קל

- אפקטיבי

- יְעִילוּת

- תופעות

- מאמץ

- סוף

- אנרגיה

- מנוע

- הנדסה

- אנגלית

- להגביר את

- מספיק

- זן

- שלם

- סביבה

- תקופה

- מוערך

- העריך

- אי פעם

- כל

- דוגמה

- קיימים

- ניסיון

- לְנַסוֹת

- ניסויים

- מומחים

- להסביר

- המסביר

- לחקור

- אֶקְסְפּרֶסִיבִי

- להאריך

- נרחב

- בהרחבה

- נוסף

- תמצית

- פָּנִים

- מתמודד

- עובדות

- אופנה

- המהיר ביותר

- הצמיחה המהירה ביותר

- מעטים

- תרשים

- סופי

- כספי

- שירותים פיננסיים

- ראשון

- מתאים

- תזרים

- להתמקד

- הבא

- בעד

- פוּרמָט

- מצא

- קרן

- מסגרות

- החל מ-

- נוסף

- צבר

- מִשְׂחָק

- משחקים

- המשחקים

- תעשיית המשחקים

- אסף

- כללי

- ליצור

- יצירת

- גנרטטיבית

- AI Generative

- לקבל

- נתן

- Goes

- הולך

- קְבוּצָה

- גדל

- מְגוּדָל

- היה

- יש

- יש

- he

- ראש

- בריא

- כאן

- גבוה יותר

- היסטורי

- הסטורי

- היסטוריה

- איך

- איך

- אולם

- HTTPS

- טבור

- בן אנוש

- מאות

- כוונון היפר-פרמטר

- רעיון

- אידאל

- זהה

- זיהוי

- if

- תמונה

- תמונות

- מהגרים

- ליישם

- יישום

- לייבא

- חשוב

- יבוא

- לשפר

- משופר

- השבחה

- שיפורים

- in

- לכלול

- כולל

- גדל

- תעשייה

- מידע

- הטמון

- מטבע הדברים

- חדשנות

- קלט

- שילוב

- אינטראקציה

- יחסי גומלין

- אינטראקטיבי

- מעוניין

- אינטרסים

- אל תוך

- הציג

- מציג

- IT

- שֶׁלָה

- יָנוּאָר

- פאזל

- משותף

- רק

- מפתח

- מילות מפתח

- ידע

- ידוע

- תיוג

- תוויות

- שפה

- גָדוֹל

- בקנה מידה גדול

- מאוחר יותר

- שכב

- שכבה

- למידה

- אורך

- פחות

- כמו

- LLM

- לִטעוֹן

- עוד

- הסתכלות

- אבוד

- מגרש

- מוריד

- מכונה

- למידת מכונה

- עשוי

- ראשי

- לתחזק

- תחזוקה

- לעשות

- עושה

- עשייה

- איש

- ניהול

- מנהל

- מדריך ל

- ייצור

- רב

- מסיבי

- מאי..

- מנגנון

- מדיה

- נפגש

- שיטה

- מֵתוֹדוֹלוֹגִיָה

- מטרי

- מִילִיוֹן

- ML

- MLOps

- מודל

- דוגמנות

- מודלים

- שינויים

- מודולים

- ניטור

- חודשים

- יותר

- רוב

- הכי פופולארי

- הרבה

- כלומר

- טבעי

- עיבוד שפה טבעית

- טבע

- נחוץ

- רשת

- רשתות

- רשתות עצביות

- חדש

- הבא

- NLP

- צומת

- עַכשָׁיו

- מספר

- מספרים

- להשיג

- of

- כבוי

- מתקפה

- לעתים קרובות

- on

- ONE

- באינטרנט

- משחקים מקוונים

- רק

- תפעול

- מִתנַגֵד

- אופטימיזציה

- אפשרויות

- or

- כָּתוֹם

- להזמין

- מְקוֹרִי

- אחר

- הַחוּצָה

- תוֹצָאָה

- תוצאות

- תפוקה

- יותר

- מקיף

- סקירה

- שֶׁלוֹ

- זוגות

- פרדיגמה

- פרמטר

- פרמטרים

- חלק

- שותף

- עבר

- עבר

- תבנית

- לְבַצֵעַ

- ביצועים

- מבצע

- שלב

- דוקטורט

- ביטויים

- לְחַבֵּר

- פלטפורמה

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- שיחק

- שחקן

- שחקנים

- אנא

- PoC

- נקודה

- פופולרי

- אוכלוסייה

- הודעה

- הודעות

- פוטנציאל

- כּוֹחַ

- חזק

- כוחות

- דיוק

- לחזות

- חזה

- ניבוי

- נבואה

- התחזיות

- תחזית

- קודם

- קוֹדֶם

- בעיה

- הליך

- תהליך

- תהליכים

- תהליך

- לייצר

- הפקה

- ניבולי פה

- מקצועי

- לקדם

- קידום

- הוכחה

- הוכחה של רעיון או תאוריה

- ובלבד

- מספק

- ציבורי

- גם

- פיתון

- איכות

- רכס

- לְהַגִיעַ

- הגעה

- מוכן

- ממשי

- עולם אמיתי

- סיבות

- קיבלו

- לאחרונה

- מתכון

- להכיר

- מוּמלָץ

- שיא

- יחסית

- לשחרר

- שוחרר

- רלוונטי

- שכפול

- לייצג

- לדרוש

- אחראי

- אחראי משחקים

- תוצאה

- וכתוצאה מכך

- תוצאות

- רויטרס

- תקין

- קַפְּדָנִי

- לעלות

- איתנות

- תפקידים

- הפעלה

- ריצה

- בעל חכמים

- אותו

- סן

- סן דייגו

- להרחבה

- סולם

- דרוג

- מדע

- מדעי

- מַדְעָן

- לגרד

- שְׁנִיָה

- סעיף

- סעיפים

- לחצני מצוקה לפנסיונרים

- משפט

- רגש

- נפרד

- רצף

- סדרה

- משמש

- שירותים

- סט

- סטים

- כמה

- שיתופים

- הוצג

- הופעות

- דומה

- since

- יחיד

- מידה

- מאט

- קטן

- קטן יותר

- So

- חֶברָתִי

- מדיה חברתית

- מבחינה חברתית

- אך ורק

- פִּתָרוֹן

- פתרונות

- לפתור

- פותר

- כמה

- ביקש

- מֶרחָב

- ספציפי

- במיוחד

- נאום

- מְהִירוּת

- לפצל

- התחלות

- מדינה

- סטטיסטיקות

- שלב

- עוד

- מִבְנֶה

- לימוד

- באופן משמעותי

- כזה

- מספיק

- מערכות

- שולחן

- מותאם

- לוקח

- נטילת

- המשימות

- משימות

- נבחרת

- טכנולוגיה

- מבחן

- נבדק

- מֵאֲשֶׁר

- זֶה

- השמיים

- המדינה

- שֶׁלָהֶם

- אותם

- אז

- תיאורטי

- שם.

- אלה

- הֵם

- זֶה

- מחשבה

- שְׁלוֹשָׁה

- סף

- דרך

- כָּך

- זמן

- פִּי

- תזמון

- עֲנָק

- ל

- היום

- נושאים

- סה"כ

- רכבת

- מְאוּמָן

- הדרכה

- להעביר

- שנאי

- רוֹבּוֹטרִיקִים

- תרגום

- באמת

- תור

- ציוץ

- טוויטים

- שתיים

- סוג

- סוגים

- טיפוסי

- בדרך כלל

- בסופו של דבר

- בְּסִיסִי

- הבנה

- לצערי

- אוניברסיטה

- אוניברסיטת קליפורניה

- מְעוּדכָּן

- להשתמש

- במקרה להשתמש

- מְשׁוּמָשׁ

- משתמש

- חוויית משתמש

- משתמשים

- שימושים

- באמצעות

- לְאַמֵת

- אימות

- מגוון

- Vast

- גירסאות

- אנכיות

- מאוד

- באמצעות

- וִידֵאוֹ

- משחקי וידאו

- כמעט

- קול

- vs

- רוצה

- רציתי

- היה

- דֶרֶך..

- we

- אינטרנט

- שירותי אינטרנט

- Web3

- משקל

- טוֹב

- מוכר

- היו

- מתי

- אם

- אשר

- בזמן

- למה

- רָחָב

- טווח רחב

- ויקיפדיה

- יצטרך

- עם

- בתוך

- לְלֹא

- נשים

- Word

- מילים

- זרימת עבודה

- עובד

- עובד

- עוֹלָם

- היה

- כתיבה

- שנים

- אתה

- זפירנט