הגידול בפעילויות חברתיות מקוונות כגון רשתות חברתיות או משחקים מקוונים רצוף לרוב בהתנהגות עוינת או תוקפנית שעלולה להוביל לביטויים בלתי רצויים של דברי שטנה, בריונות ברשת או הטרדה. לדוגמה, קהילות משחק מקוונות רבות מציעות פונקציונליות של צ'אט קולי כדי להקל על התקשורת בין המשתמשים שלהן. למרות שצ'אט קולי תומך לעתים קרובות בהתלוצצות ידידותית ובדיבור זבל, הוא יכול גם להוביל לבעיות כמו דברי שטנה, בריונות ברשת, הטרדה והונאות. סימון שפה מזיקה עוזר לארגונים לשמור על שיחות אזרחיות ולשמור על סביבה מקוונת בטוחה ומכילה למשתמשים ליצור, לשתף ולהשתתף בחופשיות. כיום, חברות רבות מסתמכות אך ורק על מנחים אנושיים לבדיקת תוכן רעיל. עם זאת, קנה מידה של מנהלים אנושיים כדי לענות על צרכים אלה באיכות ובמהירות מספקת הוא יקר. כתוצאה מכך, ארגונים רבים מסתכנים בפני שיעורי שחיקה גבוהים של משתמשים, פגיעה במוניטין וקנסות רגולטוריים. בנוסף, מנחים לרוב מושפעים פסיכולוגית מבדיקת התוכן הרעיל.

אמזון תעתיק הוא שירות זיהוי דיבור אוטומטי (ASR) המקל על מפתחים להוסיף יכולת דיבור לטקסט ליישומים שלהם. היום אנחנו נרגשים להכריז זיהוי רעילות לתמלול אמזון, יכולת למידת מכונה (ML) שמשתמשת ברמזים מבוססי אודיו וטקסט כדי לזהות ולסווג תוכן רעיל מבוסס קול בשבע קטגוריות, כולל הטרדה מינית, דברי שטנה, איומים, התעללות, ניבול פה, עלבונות ושפה גרפית . בנוסף לטקסט, זיהוי רעילות משתמש ברמזים של דיבור כגון צלילים וגובה קול כדי לחדד את הכוונה הרעילה בדיבור.

זהו שיפור ממערכות ניהול תוכן סטנדרטיות שנועדו להתמקד רק במונחים ספציפיים, ללא התחשבות בכוונה. לרוב הארגונים יש SLA של 7-15 ימים כדי לסקור תוכן שדווח על ידי משתמשים מכיוון שמנחים חייבים להאזין לקבצי אודיו ארוכים כדי להעריך אם ומתי השיחה הפכה רעילה. עם Amazon Transcribe Toxcity Detection, מנהלים בודקים רק את החלק הספציפי של קובץ האודיו המסומן כתוכן רעיל (לעומת קובץ האודיו כולו). התוכן שמנהלים אנושיים חייבים לבדוק מופחת ב-95%, מה שמאפשר ללקוחות להפחית את ה-SLA שלהם למספר שעות בלבד, כמו גם לאפשר להם לנהל באופן יזום יותר תוכן מעבר למה שסומן על ידי המשתמשים. זה יאפשר לארגונים לזהות ולתת תוכן באופן אוטומטי בקנה מידה גדול, לספק סביבה מקוונת בטוחה ומכילה ולנקוט פעולה לפני שהוא יכול לגרום לנטישה של משתמשים או נזק למוניטין. המודלים המשמשים לזיהוי תוכן רעיל מתוחזקים על ידי Amazon Transcribe ומתעדכנים מעת לעת כדי לשמור על דיוק ורלוונטיות.

בפוסט זה תלמדו כיצד:

- זהה תוכן מזיק בדיבור באמצעות Amazon Transcribe Toxicity Detection

- השתמש במסוף התמלול של Amazon לזיהוי רעילות

- צור עבודת תמלול עם זיהוי רעילות באמצעות ה ממשק שורת הפקודה של AWS (AWS CLI) ו- Python SDK

- השתמש בתגובת ה-API לזיהוי רעילות של Amazon Transcribe

זהה רעילות בצ'אט אודיו עם Amazon Transcribe Toxicity Detection

Amazon Transcribe מספקת כעת פתרון פשוט מבוסס ML לסימון שפה מזיקה בשיחות מדוברות. תכונה זו שימושית במיוחד עבור מדיה חברתית, משחקים וצרכים כלליים, ומבטלת את הצורך של לקוחות לספק נתונים משלהם כדי להכשיר את מודל ה-ML. זיהוי רעילות מסווג תוכן שמע רעיל לשבע הקטגוריות הבאות ומספק ציון ביטחון (0-1) לכל קטגוריה:

- ניבולי פה - דיבור המכיל מילים, ביטויים או ראשי תיבות שאינם מנומסים, וולגריים או פוגעניים.

- דברי שנאה - דיבור המבקר, מעליב, מוקיע או עושה דה-הומניזציה של אדם או קבוצה על בסיס זהות (כגון גזע, מוצא אתני, מגדר, דת, נטייה מינית, יכולת ומוצא לאומי).

- מיני - דיבור המעיד על עניין מיני, פעילות או עוררות תוך שימוש בהתייחסויות ישירות או עקיפות לאברי גוף, תכונות גופניות או מין.

- עלבונות – דיבור הכולל שפה משפילה, משפילה, לעג, מעליב או מזלזל. סוג זה של שפה מתויג גם כבריונות.

- אלימות או איום - דיבור הכולל איומים המבקשים לגרום לכאב, פציעה או עוינות כלפי אדם או קבוצה.

- גרפי - דיבור המשתמש בדימויים תיאוריים ויזואליים וחיים בצורה לא נעימה. סוג זה של שפה הוא לעתים קרובות מילולי בכוונה כדי להגביר את אי הנוחות של הנמען.

- הטרדה או התעללות - דיבור שנועד להשפיע על רווחתו הפסיכולוגית של הנמען, כולל מונחים משפילים ומחפצים.

אתה יכול לגשת לזיהוי רעילות או דרך מסוף התמלול של Amazon או על ידי קריאה ישירה לממשקי ה-API באמצעות AWS CLI או AWS SDKs. בקונסולת התמלול של Amazon, אתה יכול להעלות את קבצי האודיו שברצונך לבדוק לגבי רעילות ולקבל תוצאות בכמה קליקים בלבד. Amazon Transcribe תזהה ותסווג תוכן רעיל, כגון הטרדה, דברי שטנה, תוכן מיני, אלימות, עלבונות וניבול פה. Amazon Transcribe מספקת גם ציון ביטחון עבור כל קטגוריה, ומספקת תובנות חשובות לגבי רמת הרעילות של התוכן. זיהוי רעילות זמין כעת ב-Amazon Transcribe API הסטנדרטי לעיבוד אצווה ותומך בשפה האנגלית בארה"ב.

הדרכה על קונסולת התמלול של Amazon

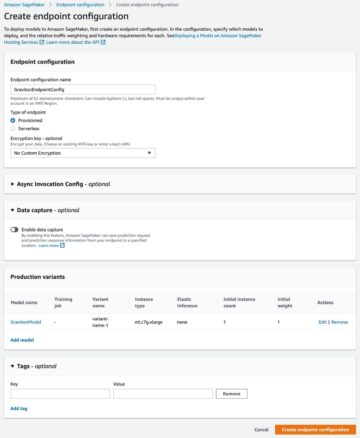

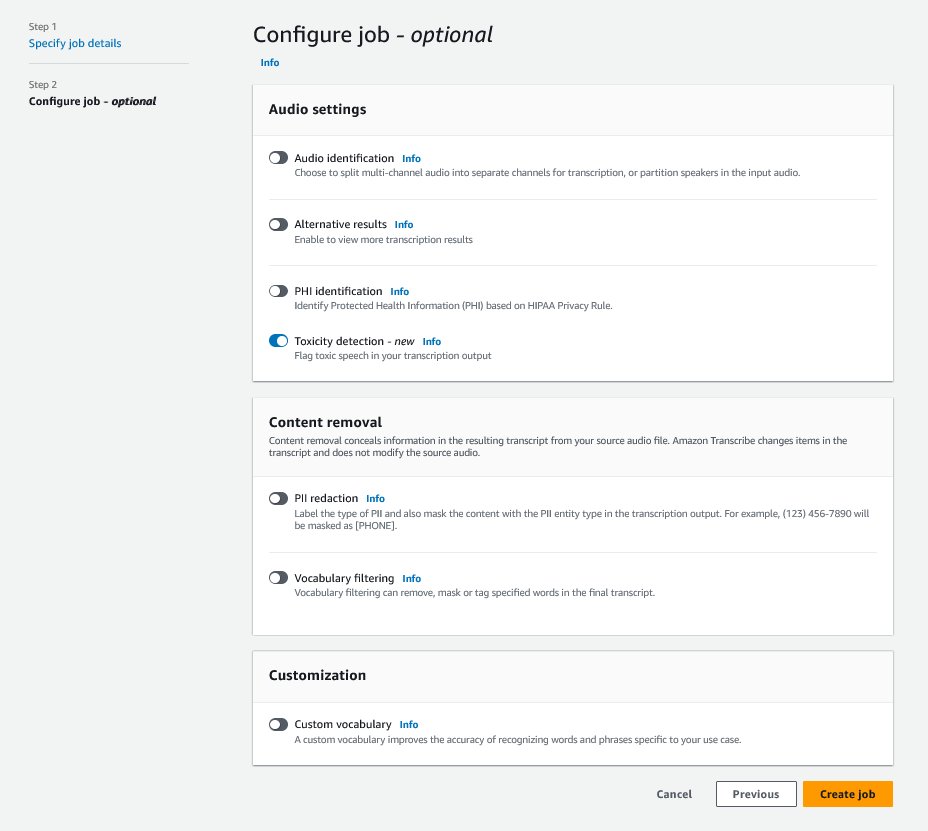

כדי להתחיל, היכנס ל- קונסולת הניהול של AWS ועבור אל Amazon Transcribe. כדי ליצור עבודת תמלול חדשה, עליך להעלות את הקבצים המוקלטים שלך לקובץ שירות אחסון פשוט של אמזון (Amazon S3) דלי לפני שניתן יהיה לעבד אותם. בדף הגדרות השמע, כפי שמוצג בצילום המסך הבא, הפעל זיהוי רעילות והמשך ליצירת העבודה החדשה. Amazon Transcribe תעבד את עבודת התמלול ברקע. ככל שהעבודה מתקדמת, אתה יכול לצפות שהסטטוס ישתנה ל הושלם כאשר התהליך יסתיים.

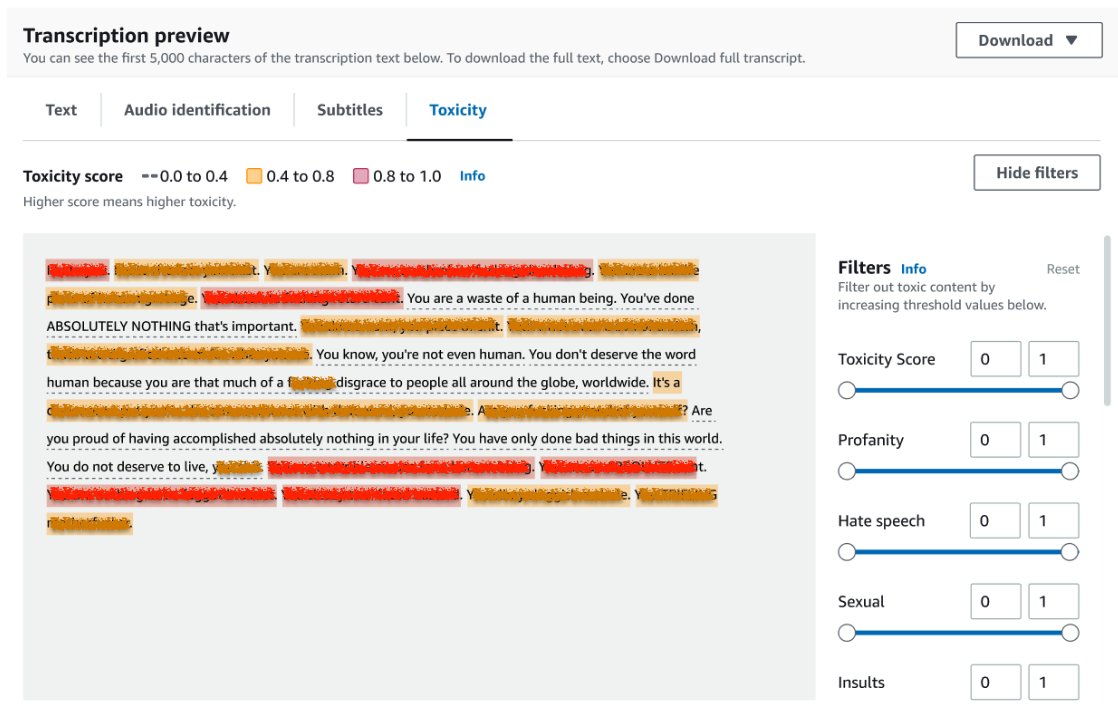

כדי לעיין בתוצאות של עבודת תמלול, בחר את המשרה מרשימת התפקידים כדי לפתוח אותה. גלול מטה אל תצוגה מקדימה של תמלול סעיף לבדיקת תוצאות על רעילות לשונית. ממשק המשתמש מציג מקטעי תמלול מקודדי צבע כדי לציין את רמת הרעילות, שנקבעת על פי ציון הביטחון. כדי להתאים אישית את התצוגה, אתה יכול להשתמש בפס ההחלפה ב- מסנן שִׁמשָׁה. פסים אלו מאפשרים לך להתאים את הספים ולסנן את קטגוריות הרעילות בהתאם.

צילום המסך הבא כיסה חלקים מטקסט התעתיק עקב נוכחות מידע רגיש או רעיל.

תמלול API עם בקשת זיהוי רעילות

בחלק זה, אנו מנחים אותך ביצירת עבודת תמלול עם זיהוי רעילות באמצעות ממשקי תכנות. אם קובץ השמע עדיין לא נמצא בדלי S3, העלה אותו כדי להבטיח גישה באמצעות Amazon Transcribe. בדומה ליצירת עבודת תמלול במסוף, בעת הפעלת העבודה, עליך לספק את הפרמטרים הבאים:

- TranscriptionJobName – ציין שם עבודה ייחודי.

- MediaFileUri - הזן את מיקום ה-URI של קובץ השמע ב-Amazon S3. Amazon Transcribe תומך בפורמטי האודיו הבאים: MP3, MP4, WAV, FLAC, AMR, OGG או WebM

- קוד שפה - מכוון ל

en-US. נכון לכתיבת שורות אלה, זיהוי רעילות תומך רק בשפה האנגלית בארה"ב. - קטגוריות רעילות - תעביר את ה

ALLערך שיכלול את כל קטגוריות זיהוי הרעילות הנתמכות.

להלן דוגמאות לתחילת עבודת תמלול עם זיהוי רעילות מופעל באמצעות Python3:

אתה יכול להפעיל את אותה עבודת תמלול עם זיהוי רעילות באמצעות הפקודה הבאה של AWS CLI:

API לתעתוק עם תגובה לגילוי רעילות

פלט JSON לזיהוי רעילות של Amazon Transcribe יכלול את תוצאות התמלול בשדה התוצאות. הפעלת זיהוי רעילות מוסיפה שדה נוסף בשם toxicityDetection מתחת לשדה התוצאות. toxicityDetection כולל רשימה של פריטים מתומללים עם הפרמטרים הבאים:

- טֶקסט – הטקסט המתומלל הגולמי

- רַעֲלָנוּת - ציון ביטחון של זיהוי (ערך בין 0-1)

- קטגוריות - ציון ביטחון עבור כל קטגוריה של דיבור רעיל

- שעת התחלה - מיקום ההתחלה של הזיהוי בקובץ השמע (שניות)

- שעת סיום - מיקום הקצה של הזיהוי בקובץ השמע (שניות)

להלן תגובת זיהוי רעילות מקוצרת לדוגמה שתוכל להוריד מהמסוף:

<br> סיכום

בפוסט זה, סיפקנו סקירה כללית על התכונה החדשה של זיהוי רעילות תמלול של אמזון. תיארנו גם כיצד ניתן לנתח את פלט זיהוי הרעילות של JSON. למידע נוסף, בדוק את קונסולת התמלול של Amazon ונסה את ה-API של תמלול עם זיהוי רעילות.

זיהוי רעילות תמלול של אמזון זמין כעת באזורי ה-AWS הבאים: מזרח ארה"ב (אוהיו), מזרח ארה"ב (נ' וירג'יניה), מערב ארה"ב (אורגון), אסיה פסיפיק (סידני), אירופה (אירלנד) ואירופה (לונדון). למידע נוסף, בקר אמזון תעתיק.

למידע נוסף בנושא ניהול תוכן ב-AWS ו שלנו ניהול תוכן ML מקרי שימוש. תעשה את הצעד הראשון לקראת ייעול פעולות ניהול התוכן שלך עם AWS.

על הסופר

לאנה ג'אנג הוא ארכיטקט פתרונות בכיר בצוות שירותי AI של AWS WWSO, המתמחה בבינה מלאכותית ו-ML לניהול תוכן, ראייה ממוחשבת ועיבוד שפה טבעית. עם המומחיות שלה, היא מחויבת לקידום פתרונות AI/ML של AWS ולסייע ללקוחות לשנות את הפתרונות העסקיים שלהם בתעשיות מגוונות, כולל מדיה חברתית, משחקים, מסחר אלקטרוני ופרסום ושיווק.

לאנה ג'אנג הוא ארכיטקט פתרונות בכיר בצוות שירותי AI של AWS WWSO, המתמחה בבינה מלאכותית ו-ML לניהול תוכן, ראייה ממוחשבת ועיבוד שפה טבעית. עם המומחיות שלה, היא מחויבת לקידום פתרונות AI/ML של AWS ולסייע ללקוחות לשנות את הפתרונות העסקיים שלהם בתעשיות מגוונות, כולל מדיה חברתית, משחקים, מסחר אלקטרוני ופרסום ושיווק.

סומית קומאר הוא מנהל מוצר Sr, טכני בצוות שירותי השפה של AWS AI. יש לו ניסיון של 10 שנים בניהול מוצר במגוון תחומים והוא נלהב מבינה מלאכותית/ML. מחוץ לעבודה, סומיט אוהבת לטייל ונהנית לשחק קריקט וטניס דשא.

סומית קומאר הוא מנהל מוצר Sr, טכני בצוות שירותי השפה של AWS AI. יש לו ניסיון של 10 שנים בניהול מוצר במגוון תחומים והוא נלהב מבינה מלאכותית/ML. מחוץ לעבודה, סומיט אוהבת לטייל ונהנית לשחק קריקט וטניס דשא.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. רכב / רכבים חשמליים, פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- BlockOffsets. מודרניזציה של בעלות על קיזוז סביבתי. גישה כאן.

- מקור: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- :יש ל

- :הוא

- :לֹא

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- יכולת

- אודות

- התעללות

- גישה

- לפיכך

- חשבונאות

- דיוק

- לרוחב

- פעולה

- פעילויות

- פעילות

- להוסיף

- תוספת

- מוסיף

- פרסום

- תוֹקפָּנִי

- AI

- שירותי AI

- AI / ML

- תעשיות

- להתיר

- כְּבָר

- גם

- למרות

- אמזון בעברית

- אמזון תעתיק

- אמזון שירותי אינטרנט

- בין

- an

- ו

- להכריז

- API

- ממשקי API

- יישומים

- ARE

- AS

- אסיה

- אסיה פסיפיק

- סיוע

- At

- התשה

- אודיו

- מכני עם סלילה אוטומטית

- באופן אוטומטי

- זמין

- AWS

- רקע

- סורגים

- בסיס

- BE

- הפך

- כי

- לפני

- התנהגות

- בֵּין

- מעבר

- גוּף

- שניהם

- לשבור

- הצקה

- עסקים

- by

- נקרא

- קוראים

- CAN

- יכולת

- קטגוריות

- קטגוריה

- לגרום

- שינוי

- לבדוק

- בחרו

- לסווג

- תקשורת

- הקהילות

- חברות

- להשלים

- השלמת

- המחשב

- ראייה ממוחשבת

- אמון

- קונסול

- מכיל

- תוכן

- שיחה

- שיחות

- מכוסה

- לִיצוֹר

- יוצרים

- קריקט

- מבקר

- כיום

- לקוחות

- אישית

- נתונים

- ימים

- מוקדש

- מְתוּאָר

- מעוצב

- לאתר

- איתור

- נחוש

- מפתחים

- ישיר

- ישירות

- לְהַצִיג

- שונה

- תחומים

- מטה

- להורדה

- ראוי

- מסחר אלקטרוני

- כל אחד

- מזרח

- קל

- או

- חיסול

- לאפשר

- מופעל

- מה שמאפשר

- סוף

- אנגלית

- לְהַבטִיחַ

- זן

- חברות

- שלם

- סביבה

- במיוחד

- מוצא אתני

- אירופה

- להעריך

- דוגמה

- דוגמאות

- נרגש

- לצפות

- יקר

- ניסיון

- מומחיות

- נוסף

- לְהַקֵל

- מול

- נכשל

- מאפיין

- מעטים

- שדה

- שלח

- קבצים

- לסנן

- קנסות

- ראשון

- מסומן

- להתמקד

- הבא

- בעד

- ידידותי

- החל מ-

- פונקציונלי

- המשחקים

- מין

- כללי

- לקבל

- Go

- Goes

- גרפי

- קְבוּצָה

- מדריך

- מזיק

- יש

- he

- עוזר

- לה

- כאן

- גָבוֹהַ

- שעות

- איך

- איך

- אולם

- HTML

- http

- HTTPS

- בן אנוש

- לזהות

- זהות

- if

- מושפעים

- לייבא

- השבחה

- in

- לכלול

- כולל

- כולל

- כולל

- להגדיל

- להצביע

- מצביע על

- תעשיות

- מידע

- תובנות

- לְהַעֲלִיב

- התכוון

- כוונה

- מטרה

- בכוונה

- אינטרס

- ממשקים

- אל תוך

- אירלנד

- IT

- פריטים

- עבודה

- jpg

- ג'סון

- רק

- שמור

- שפה

- עוֹפֶרֶת

- לִלמוֹד

- למידה

- רמה

- קו

- רשימה

- מיקום

- לונדון

- אוהב

- מכונה

- למידת מכונה

- לתחזק

- עושה

- ניהול

- מנהל

- רב

- שיווק

- מדיה

- לִפְגוֹשׁ

- ML

- מודל

- מודלים

- מתינות

- יותר

- רוב

- צריך

- שם

- לאומי

- טבעי

- עיבוד שפה טבעית

- צורך

- צרכי

- רשתות

- חדש

- עַכשָׁיו

- of

- הַצָעָה

- לעתים קרובות

- אוהיו

- on

- באינטרנט

- משחקים מקוונים

- רק

- לפתוח

- תפעול

- or

- אורגון

- ארגונים

- מקור

- שלנו

- הַחוּצָה

- תפוקה

- בחוץ

- סקירה

- שֶׁלוֹ

- פסיפיק

- עמוד

- כְּאֵב

- פרמטרים

- להשתתף

- חלקים

- לעבור

- לוהט

- אדם

- ביטויים

- גופני

- גובה הצליל

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- משחק

- חלק

- עמדה

- הודעה

- נוכחות

- בעיות

- תהליך

- מעובד

- תהליך

- המוצר

- ניהול מוצר

- מנהל מוצר

- ניבולי פה

- תכנות

- קידום

- לספק

- ובלבד

- מספק

- מתן

- פיתון

- איכות

- גזע

- תעריפים

- חי

- מוכן

- הכרה

- מוקלט

- להפחית

- מופחת

- אזכור

- אזורים

- רגולטורים

- הרלוונטיות

- דת

- לסמוך

- דווח

- תגובה

- תוצאה

- תוצאות

- סקירה

- ביקורת

- הסיכון

- בטוח

- אותו

- סולם

- דרוג

- הונאות

- ציון

- לגלול

- sdks

- שניות

- סעיף

- מחפשים

- קטע

- מגזרים

- לחצני מצוקה לפנסיונרים

- רגיש

- שרות

- שירותים

- סט

- הגדרות

- שבע

- מִין

- מיני

- שיתוף

- היא

- הראה

- הופעות

- סִימָן

- דומה

- פָּשׁוּט

- חֶברָתִי

- מדיה חברתית

- רשתות חברתיות

- אך ורק

- פִּתָרוֹן

- פתרונות

- מתמחה

- ספציפי

- נאום

- זיהוי דיבור

- דיבור-לטקסט

- מְהִירוּת

- דיבר

- תֶקֶן

- התחלה

- החל

- החל

- מצב

- שלב

- אחסון

- כזה

- מספיק

- נתמך

- תומך

- סידני

- מערכות

- לקחת

- מדבר

- נבחרת

- טכני

- מונחים

- מבחן

- זֶה

- השמיים

- שֶׁלָהֶם

- אותם

- אלה

- הֵם

- זֶה

- איומים

- דרך

- זמן

- ל

- היום

- לקראת

- לקראת

- רכבת

- הפיכה

- נסיעות

- נָכוֹן

- לנסות

- סוג

- ui

- תחת

- ייחודי

- ללא הזמנה

- מְעוּדכָּן

- us

- להשתמש

- מְשׁוּמָשׁ

- משתמש

- משתמשים

- שימושים

- באמצעות

- בעל ערך

- ערך

- מגוון

- באמצעות

- אלימות

- וירג'יניה

- חזון

- לְבַקֵר

- קול

- vs

- וולגרי

- לחכות

- רוצה

- we

- אינטרנט

- שירותי אינטרנט

- טוֹב

- מערב

- מתי

- בזמן

- יצטרך

- עם

- לְלֹא

- מילים

- תיק עבודות

- כתיבה

- שנים

- עוד

- אתה

- זפירנט