בום הבינה המלאכותית הגנרטיבי קשור למחשוב. יש לו את המאפיין הייחודי שהוספת יותר מחשוב מביאה ישירות למוצר טוב יותר. בדרך כלל, ההשקעה במחקר ופיתוח קשורה באופן ישיר יותר למידת הערך של המוצר, והקשר הזה הוא תת-ליניארי באופן ניכר. אבל זה לא כך כרגע עם בינה מלאכותית, וכתוצאה מכך, גורם עיקרי שמניע את התעשייה כיום הוא פשוט עלות ההכשרה וההסקה.

אמנם אנחנו לא יודעים את המספרים האמיתיים, אבל שמענו ממקורות מוכרים שהיצע המחשוב כל כך מוגבל, שהביקוש עולה עליו בפקטור של 10(!) אז אנחנו חושבים שזה הוגן לומר שכרגע, גישה למשאבי מחשוב - בעלות הכוללת הנמוכה ביותר - הפכה לגורם מכריע להצלחתן של חברות בינה מלאכותית.

למעשה, ראינו חברות רבות מוציאות יותר מ-80% מסך ההון שגויס על משאבי מחשוב!

בפוסט זה, אנו מנסים לפרק את גורמי העלות של חברת בינה מלאכותית. המספרים האבסולוטיים כמובן ישתנו עם הזמן, אבל אנחנו לא רואים הקלה מיידית של חברות בינה מלאכותית להיות כבולים בגישה שלהן למשאבי מחשוב. אז, אני מקווה, זו מסגרת מועילה לחשיבה דרך הנוף.

מדוע דגמי AI כל כך יקרים מבחינה חישובית?

קיים מגוון רחב של דגמי AI גנרטיביים, ועלויות ההסקה וההדרכה תלויות בגודל ובסוג הדגם. למרבה המזל, הדגמים הפופולריים ביותר כיום הם בעיקר ארכיטקטורות מבוססות שנאים, הכוללות מודלים פופולריים של שפה גדולה (LLM) כגון GPT-3, GPT-J או BERT. בעוד שהמספר המדויק של פעולות להסקת מסקנות ולמידה של שנאים הוא ספציפי לדגם (ראה מאמר זה), ישנו כלל אצבע מדויק למדי שתלוי רק במספר הפרמטרים (כלומר, משקלי הרשתות העצביות) של המודל ובמספר אסימוני הקלט והפלט.

אסימונים הם בעצם רצפים קצרים של כמה תווים. הם תואמים למילים או לחלקי מילים. הדרך הטובה ביותר לקבל אינטואיציה לגבי אסימונים היא לנסות טוקניזציה עם טוקנים מקוונים זמינים לציבור (למשל, OpenAI). עבור GPT-3, האורך הממוצע של אסימון הוא 4 תווים.

כלל האצבע עבור שנאים הוא שמעבר קדימה (כלומר, מסקנות) עבור דגם עם p פרמטרים עבור קלט ורצף פלט של אורך n אסימונים כל אחד, לוקח בערך 2*נ*עמ' פעולות נקודה צפה (FLOPS)¹. אימון עבור אותו דגם לוקח בערך 6*עמ' FLOPS לכל אסימון (כלומר, מעבר אחורה נוסף דורש ארבע פעולות נוספות²). אתה יכול להעריך את עלות האימון הכוללת על ידי הכפלה בכמות האסימונים בנתוני האימון.

דרישות הזיכרון לשנאים תלויות גם בגודל הדגם. כדי להסיק, אנחנו צריכים את p פרמטרי מודל שיתאימו לזיכרון. לצורך למידה (כלומר, התפשטות לאחור), עלינו לאחסן ערכי ביניים נוספים לכל פרמטר בין המעבר קדימה לאחור. בהנחה שאנו משתמשים במספרי נקודה צפה של 32 סיביות, מדובר בתוספת של 8 בתים לכל פרמטר. כדי להכשיר מודל של 175 מיליארד פרמטרים, נצטרך לשמור על טרה-בייט של נתונים בזיכרון - זה עולה על כל GPU שקיים היום ומחייב אותנו לפצל את המודל בין כרטיסים. ניתן לייעל את דרישות הזיכרון להסקת מסקנות ואימון על ידי שימוש בערכי נקודה צפה באורכים קצרים יותר, כאשר 16 סיביות יהפכו נפוצות ו-8 סיביות צפויות בעתיד הקרוב.

בטבלה למעלה יש גדלים ועלויות חישוב עבור מספר דגמים פופולריים. ל-GPT-3 יש כ-175 מיליארד פרמטרים, אשר עבור קלט ופלט של 1,024 אסימונים, מביאים לעלות חישובית של כ-350 טריליון פעולות נקודה צפה (כלומר, Teraflops או TFLOPS). אימון דגם כמו GPT-3 לוקח בערך 3.14*10^23 פעולות נקודה צפה. לדגמים אחרים כמו LLaMA של Meta יש אפילו גבוה יותר דרישות מחשוב. אימון מודל כזה היא אחת המשימות האינטנסיביות יותר מבחינה חישובית שהאנושות לקחה על עצמה עד כה.

לסיכום: תשתית AI היא יקרה מכיוון שהבעיות האלגוריתמיות הבסיסיות הן קשות ביותר מבחינה חישובית. המורכבות האלגוריתמית של מיון טבלת מסד נתונים עם מיליון ערכים אינה משמעותית בהשוואה למורכבות של יצירת מילה אחת עם GPT-3. זה אומר שאתה רוצה לבחור את הדגם הקטן ביותר שפותר את מקרה השימוש שלך.

החדשות הטובות הן שעבור שנאים, אנו יכולים להעריך בקלות כמה מחשוב וזיכרון מודל בגודל מסוים יצרוך. וכך, בחירת החומרה הנכונה הופכת לשיקול הבא.

טיעון הזמן והעלות עבור GPUs

כיצד מורכבות חישוב מתורגמת לזמן? ליבת מעבד יכולה בדרך כלל לבצע 1-2 הוראות בכל מחזור, וקצבי השעון של המעבד היו יציבים סביב 3 GHz במשך 15 השנים האחרונות עקב סוף דנארד קנה מידה. ביצוע פעולת הסקת מסקנות בודדת של GPT-3 ללא ניצול ארכיטקטורה מקבילה כלשהי ייקח בסדר גודל של 350 TFLOPS/(3 GHz*1 FLOP) או 116,000 שניות, או 32 שעות. זה מאוד לא מעשי; במקום זאת אנחנו צריכים שבבים מיוחדים שמאיצים את המשימה הזו.

בפועל, כל דגמי הבינה המלאכותית פועלים כיום על כרטיסים המשתמשים במספר רב מאוד של ליבות מיוחדות. לדוגמה, ל-NVIDIA A100 GPU יש 512 "ליבות טנזור" שיכולות לבצע כפל מטריצה 4×4 (שווה ערך ל-64 הכפלות והוספות, או 128 FLOPS) במחזור בודד. כרטיסי מאיץ בינה מלאכותית מכונים לעתים קרובות כ-GPUs (יחידות עיבוד גרפיות), מכיוון שהארכיטקטורה פותחה במקור עבור משחקים שולחניים. בעתיד אנו מצפים שבינה מלאכותית תהפוך יותר ויותר למשפחת מוצרים מובחנת.

ל-A100 יש ביצועים נומינליים של 312 TFLOPS מה שבתיאוריה יפחית את ההסקה עבור GPT-3 לכ-1 שנייה. אולם זהו חישוב מופשט מדי מכמה סיבות. ראשית, ברוב מקרי השימוש, צוואר הבקבוק אינו כוח המחשוב של ה-GPU אלא היכולת להעביר נתונים מהזיכרון הגרפי המיוחד לליבות הטנזור. שנית, 175 מיליארד המשקלים יתפסו 700GB ולא יכנסו לזיכרון הגרפי של אף GPU. יש להשתמש בטכניקות כגון חלוקה לחלוקה והזרמת משקל. ושלישית, ישנן מספר אופטימיזציות (למשל, שימוש בייצוגי נקודה צפה קצרה יותר, כגון FP16, FP8 או מטריצות דלילות) המשמשות כדי להאיץ את החישוב. אבל, בסך הכל, המתמטיקה שלעיל נותנת לנו אינטואיציה לגבי עלות החישוב הכוללת של ה-LLM של היום.

אימון דגם שנאי לוקח בערך פי שלושה זמן לכל אסימון מאשר ביצוע מסקנות. עם זאת, בהתחשב בעובדה שמערך נתוני האימון גדול פי 300 מיליון מהנחיית מסקנות, האימון נמשך זמן רב יותר בפקטור של מיליארד. ב-GPU יחיד, האימון יימשך עשרות שנים; בפועל זה נעשה על אשכולות מחשוב גדולים במרכזי נתונים ייעודיים או, סביר יותר, בענן. קשה יותר להקביל לאימון גם מאשר להסיק, מכיוון שיש להחליף משקלים מעודכנים בין צמתים. זיכרון ורוחב פס בין GPUs הופכים לעתים קרובות לגורם חשוב בהרבה, כאשר חיבורים מהירים ובדים ייעודיים הם נפוצים. לאימון דגמים גדולים מאוד, יצירת מערך רשת מתאים יכול להיות האתגר העיקרי. במבט אל העתיד, למאיצי AI יהיו יכולות רשת בכרטיס או אפילו בשבב.

כיצד מתורגמת המורכבות החישובית הזו לעלות? להסקת GPT-3, אשר, כפי שראינו למעלה, לוקח בערך שנייה אחת ב-A1 תהיה בעלת עלות חישוב גולמית בין $100 ל-$0.0002 עבור 0.0014 אסימונים (זה בהשוואה לתמחור של OpenAI של $1,000/0.002 אסימונים). משתמש שיוצר 1000 בקשות להסקת הסקה ביום יעלה בסדר גודל של דולרים לשנה. זוהי נקודת מחיר נמוכה מאוד והופכת את רוב מקרי השימוש של AI מבוסס טקסט על ידי בני אדם לכדאיות כלכלית.

הדרכה GPT-3, לעומת זאת, הרבה יותר יקר. שוב חישוב רק את עלות החישוב עבור 3.14*10^23 FLOPS בתעריפים שלעיל נותן לנו הערכה של $560,000 בכרטיסי A100 עבור ריצת אימון בודדת. בפועל, לאימון לא נקבל כמעט 100% יעילות ב-GPU; עם זאת, אנו יכולים גם להשתמש באופטימיזציות כדי להפחית את זמן האימון. הערכות אחרות של עלות אימון GPT-3 נעות בין $500,000 ל $ 4.6, בהתאם להנחות החומרה. שימו לב שזו העלות של ריצה בודדת ולא עלות כוללת. ככל הנראה יידרשו ריצות מרובות וספקי ענן ירצו התחייבויות ארוכות טווח (עוד על כך בהמשך). הכשרת דגמים מהשורה הראשונה נשארת יקרה, אך בהישג יד של סטארט-אפ ממומן היטב.

לסיכום, בינה מלאכותית גנרטיבית דורשת השקעות מסיביות בתשתית בינה מלאכותית כיום. אין סיבה להאמין שזה ישתנה בזמן הקרוב. אימון דגם כמו GPT-3 הוא אחת המשימות האינטנסיביות ביותר מבחינה חישובית שלקחה על האנושות אי פעם. ולמרות שמעבדי ה-GPU נעשים מהירים יותר, ואנו מוצאים דרכים לייעל את האימון, ההתרחבות המהירה של AI שוללת את שתי ההשפעות הללו.

שיקולים לתשתית AI

עד לנקודה זו, ניסינו לתת לכם קצת אינטואיציה לגבי קנה המידה הנדרש כדי לבצע אימון והסקת מודלים של AI, ומה הפרמטרים הבסיסיים שמניעים אותם. בהקשר זה, אנו רוצים כעת לספק הדרכה מעשית כיצד להחליט באיזו תשתית AI להשתמש.

תשתית חיצונית לעומת פנימית

בואו נודה בזה: GPUs מגניבים. למהנדסים רבים ומייסדים בעלי חשיבה הנדסית יש הטיה לאספקת חומרת בינה מלאכותית משלהם, לא רק בגלל שהיא נותנת שליטה עדינה על הכשרת מודלים, אלא בגלל שיש פשוט משהו מהנה בריתום כמויות גדולות של כוח מחשוב (מייצג א).

המציאות, לעומת זאת, היא כזו סטארטאפים רבים - במיוחד חברות אפליקציות - לא צריכים לבנות תשתית AI משלהם ביום 1. במקום זאת, שירותי מודל מתארחים כמו OpenAI או Hugging Face (לשפה) ושכפול (ליצירת תמונות) מאפשרים למייסדים לחפש במהירות התאמה לשוק המוצר ללא צורך בניהול התשתית או המודלים הבסיסיים.

השירותים האלה נעשו כל כך טובים שחברות רבות לעולם לא מסיימות את לימודיהם. מפתחים יכולים להשיג שליטה משמעותית על ביצועי המודל באמצעות הנדסה מהירה והפשטות של כוונון עדין מסדר גבוה (כלומר, כוונון עדין באמצעות קריאות API). התמחור עבור שירותים אלה מבוסס על צריכה, כך שהוא גם זול יותר מהפעלת תשתית נפרדת. ראינו חברות אפליקציות שמייצרות יותר מ-50 מיליון דולר של ARR, ומוערכות יותר ממיליארד דולר, שמריצות שירותי דגמים מתארחים מתחת למכסה המנוע.

בצד ההפוך, כמה סטארט-אפים - במיוחד אלה המאמנים מודלים חדשים של בסיס או בונים יישומי AI משולבים אנכית - לא יכולים להימנע מהפעלת מודלים משלהם ישירות על GPUs. או בגלל שהמודל הוא למעשה המוצר והצוות מחפש "התאמה לשוק של מודל", או בגלל שנדרשת שליטה עדינה על הכשרה ו/או מסקנות כדי להשיג יכולות מסוימות או להפחית את העלות השולית בקנה מידה גדול. כך או כך, ניהול התשתית יכול להפוך למקור ליתרון תחרותי.

בניית הענן לעומת מרכז הנתונים

ברוב המקרים, הענן הוא המקום הנכון עבור תשתית ה-AI שלך. פחות עלות מקדימה, היכולת להגדיל ולהקטין, זמינות אזורית ופחות הסחת דעת מבניית מרכז הנתונים שלך משכנעים את רוב הסטארט-אפים והחברות הגדולות יותר.

אבל יש כמה חריגים לכלל זה:

- אם אתה פועל בקנה מידה גדול מאוד, זה עשוי להיות חסכוני יותר לנהל את מרכז הנתונים שלך. נקודת המחיר המדויקת משתנה בהתאם למיקום הגיאוגרפי וההגדרה, אך היא דורשת בדרך כלל הוצאות תשתית של יותר מ-50 מיליון דולר בשנה.

- אתה צריך חומרה מאוד ספציפית שאתה לא יכול להשיג מספק ענן. לדוגמה, סוגי GPU שאינם זמינים באופן נרחב, כמו גם דרישות חריגות של זיכרון, אחסון או רשת.

- אתה לא יכול למצוא ענן שמקובל משיקולים גיאופוליטיים.

אם אתה רוצה לבנות מרכז נתונים משלך, בוצע ניתוח מחיר/ביצועים מקיף של GPUs עבור ההגדרה שלך (למשל, הניתוח של טים דטמר). בנוסף לעלות ולביצועים של הכרטיס עצמו, בחירת החומרה תלויה גם בכוח, מקום וקירור. לדוגמה, לשני כרטיסי RTX 3080 Ti יחד יש קיבולת חישוב גולמית דומה ל-A100, אך צריכת החשמל המתאימה היא 700W לעומת 300W. הפרש ההספק של 3,500 קילוואט-שעה בתעריפי שוק של $0.10/קוט"ש לאורך מחזור חיים של שלוש שנים מגדיל את העלות של ה-RTX3080 Ti בכמעט פי 2 (כ-1,000 דולר).

כל זה נאמר, אנו מצפים שהרוב המכריע של סטארט-אפים ישתמשו במחשוב ענן.

השוואה בין ספקי שירותי הענן

שירותי האינטרנט של אמזון (AWS), Microsoft Azure ו-Google Cloud Platform (GCP) מציעות כולן מופעי GPU, אך נראה שגם ספקים חדשים מתמקדים בעומסי עבודה בינה מלאכותית במיוחד. הנה מסגרת שראינו שמייסדים רבים משתמשים בהם כדי לבחור ספק ענן:

מחיר: הטבלה שלהלן מציגה תמחור עבור מספר עננים מיוחדים עיקריים וקטנים יותר נכון ל-7 באפריל 2023. נתונים אלה הם רק אינדיקטיביים, מכיוון שהמקרים משתנים במידה ניכרת מבחינת רוחב הפס של הרשת, עלויות יציאת הנתונים, עלות נוספת ממעבד ורשת, זמינות הנחות וגורמים נוספים.

קיבולת מחשוב על חומרה ספציפית היא מצרך. באופן נאיבי, היינו מצפים למחירים אחידים למדי, אבל זה לא המקרה. ולמרות שקיימים הבדלי תכונות מהותיים בין העננים, הם אינם מספיקים כדי להסביר שהתמחור עבור NVIDIA A100 לפי דרישה משתנה בפקטור של כמעט פי 4 בין הספקים.

בקצה העליון של סולם המחירים, העננים הציבוריים הגדולים גובים פרמיה על סמך מוניטין המותג, אמינות מוכחת והצורך לנהל מגוון רחב של עומסי עבודה. ספקי בינה מלאכותית קטנים יותר מציעים מחירים נמוכים יותר, בין אם על ידי הפעלת מרכזי נתונים ייעודיים (למשל, Coreweave) או עריכת עננים אחרים (למשל, Lambda Labs).

באופן מעשי, רוב הקונים הגדולים מנהלים משא ומתן על מחירים ישירות עם ספקי הענן, ולעתים קרובות מתחייבים לדרישת הוצאות מינימלית כלשהי וכן התחייבויות למינימום זמן (ראינו 1-3 שנים). הבדלי המחירים בין העננים מתכווצים במקצת לאחר משא ומתן, אבל ראינו שהדירוג בטבלה למעלה נשאר יציב יחסית. חשוב גם לציין שחברות קטנות יותר יכולות לקבל תמחור אגרסיבי מעננים מיוחדים ללא התחייבויות הוצאות גדולות.

זמינות: ה-GPUs החזקים ביותר (למשל, Nvidia A100s) היו במחסור עקבי במשך 12 החודשים האחרונים פלוס.

זה יהיה הגיוני לחשוב שלשלושת ספקי הענן המובילים יש את הזמינות הטובה ביותר, לאור כוח הקנייה הגדול שלהם ומאגר המשאבים שלהם. אבל, באופן קצת מפתיע, סטארטאפים רבים לא מצאו שזה נכון. לעננים הגדולים יש הרבה חומרה אבל יש להם גם צרכי לקוחות גדולים שיש לספק אותם - למשל, Azure היא המארח העיקרי של ChatGPT - והם כל הזמן מוסיפים/חוכרים קיבולת כדי לענות על הביקוש. בינתיים, Nvidia התחייבה להפוך את החומרה לזמינה בכל רחבי התעשייה, כולל הקצאות לספקים מיוחדים חדשים. (הם עושים זאת גם כדי להיות הוגנים וגם כדי להפחית את התלות שלהם בכמה לקוחות גדולים שגם מתחרים בהם.)

כתוצאה מכך, סטארט-אפים רבים מוצאים שבבים זמינים יותר, כולל ה-Nvidia H100s החדישים, אצל ספקי ענן קטנים יותר. אם אתה מוכן לעבוד עם חברת תשתית חדשה יותר, ייתכן שתוכל להפחית את זמני ההמתנה לחומרה ואולי לחסוך כסף בתהליך.

מודל מסירה מחשוב: העננים הגדולים כיום מציעים רק מקרים עם GPUs ייעודיים, הסיבה לכך היא שווירטואליזציה של GPU היא עדיין בעיה בלתי פתורה. ענני בינה מלאכותית מתמחים מציעים מודלים אחרים, כגון מכולות או עבודות אצווה, שיכולים להתמודד עם משימות בודדות מבלי לשאת בעלות ההפעלה והפירוק של מופע. אם אתה מרגיש בנוח עם הדגם הזה, זה יכול להפחית משמעותית את העלות.

חיבורי רשת: להדרכה, במיוחד, רוחב הפס של הרשת הוא גורם מרכזי בבחירת הספק. יש צורך באשכולות עם בדים ייעודיים בין צמתים, כגון NVLink, כדי להכשיר דגמים גדולים מסוימים. עבור יצירת תמונות, עמלות תעבורה יציאה יכולות גם להיות מניע עלות עיקרי.

שירות לקוחות: ספקי ענן גדולים משרתים מאגר עצום של לקוחות על פני אלפי SKUs של מוצרים. זה יכול להיות קשה למשוך את תשומת הלב של תמיכת הלקוחות, או לתקן בעיה, אלא אם כן אתה לקוח גדול. לעומת זאת, ענני AI מתמחים רבים מציעים תמיכה מהירה ומגיבה גם ללקוחות קטנים. זה נובע בחלקו בגלל שהם פועלים בקנה מידה קטן יותר, אבל גם בגלל שעומסי העבודה שלהם הומוגניים יותר - כך שהם מתמריצים יותר להתמקד בתכונות ובבאגים ספציפיים ל-AI.

השוואה בין GPUs

כשכל השאר שווים, ה-GPUs העליון יתפקדו בצורה הטובה ביותר כמעט בכל עומסי העבודה. עם זאת, כפי שניתן לראות בטבלה למטה, החומרה הטובה ביותר היא גם יקרה משמעותית. בחירת הסוג המתאים של GPU עבור היישום הספציפי שלך יכולה להפחית משמעותית את העלות ועשויה לעשות את ההבדל בין מודל עסקי בר-קיימא למודל עסקי שאינו בר-קיימא.

ההחלטה באיזה מרחק ברשימה ללכת - כלומר, קביעת אפשרויות ה-GPU החסכוניות ביותר עבור היישום שלך - היא במידה רבה החלטה טכנית שהיא מעבר להיקף של מאמר זה. אבל נשתף להלן כמה מקריטריוני הבחירה שראינו שהם החשובים ביותר:

אימון מול מסקנות: כפי שראינו בסעיף הראשון למעלה, אימון דגם שנאי מחייב אותנו לאחסן 8 בתים של נתונים לאימון בנוסף למשקולות הדגם. המשמעות היא ש-GPU טיפוסי לצרכן מתקדם עם זיכרון של 12GB בקושי יכול לשמש לאימון דגם של 4 מיליארד פרמטרים. בפועל, אימון דגמים גדולים מתבצע על אשכולות של מכונות עם עדיף GPUs רבים לשרת, הרבה VRAM וחיבורי רוחב פס גבוה בין השרתים (כלומר, אשכולות שנבנו באמצעות GPUs של מרכזי נתונים מובילים).

באופן ספציפי, דגמים רבים יהיו חסכוניים ביותר ב-NVIDIA H100, אך נכון להיום קשה למצוא אותם ולרוב דורשים התחייבות ארוכת טווח של יותר משנה. ה-NVIDIA A100 מפעיל את רוב דגמי ההדרכה כיום; קל יותר למצוא אותו, אבל עבור אשכולות גדולים, עשוי לדרוש גם מחויבות ארוכת טווח.

דרישות זיכרון: ל-LLMs גדולות יש ספירת פרמטרים גבוהה מכדי להתאים לכל כרטיס. הם צריכים להיות מפוצלים על פני מספר כרטיסים ודורשים הגדרה דומה לאימון. במילים אחרות, אתה כנראה צריך H100s או A100s אפילו להסקת LLM. אבל דגמים קטנים יותר (למשל, דיפוזיה יציבה) דורשים הרבה פחות VRAM. בעוד ה-A100 עדיין פופולרי, ראינו סטארטאפים משתמשים בכרטיסי A10, A40, A4000, A5000 ו-A6000, או אפילו RTX.

תמיכה בחומרה: בעוד שהרוב המכריע של עומסי העבודה בחברות שדיברנו איתן להריץ ב-NVIDIA, כמה מהם התחילו להתנסות עם ספקים אחרים. הנפוץ ביותר הוא ה-TPU של Google, אבל נראה שגם גאודי 2 של אינטל מקבל משיכה מסוימת. האתגר מול ספקים אלה הוא שהביצועים של המודל שלך תלויים לעתים קרובות מאוד בזמינות של אופטימיזציות תוכנה עבור שבבים אלה. סביר להניח שתצטרך לעשות PoC כדי להבין את הביצועים.

דרישות אחזור: באופן כללי, עומסי עבודה פחות רגישים לאחזור (למשל, עיבוד נתונים אצווה או יישומים שאינם דורשים תגובות ממשק משתמש אינטראקטיביות) יכולים להשתמש במעבדי GPU פחות חזקים. זה יכול להפחית את עלות המחשוב פי 3-4 (למשל, השוואת A100s ל-A10s ב-AWS). אפליקציות הפונות למשתמש, לעומת זאת, זקוקות לרוב לכרטיסים מובילים כדי לספק חווית משתמש מרתקת בזמן אמת. לרוב יש צורך באופטימיזציה של מודלים כדי להביא עלויות לטווח שניתן לניהול.

קוצים: חברות בינה מלאכותית גנריות רואות לעתים קרובות עליות דרמטיות בביקוש מאחר שהטכנולוגיה כל כך חדשה ומרגשת. זה לא יוצא דופן לראות את נפחי הבקשות גדלים פי 10 ביום, בהתבסס על מהדורת מוצר חדש, או גדלים ב-50% בשבוע באופן עקבי. הטיפול בשפיצים הללו הוא לרוב קל יותר ב-GPUs בקצה נמוך יותר, מכיוון שככל הנראה יותר צמתי מחשוב זמינים לפי דרישה. לעתים קרובות גם הגיוני לשרת סוג זה של תעבורה עם משאבים בעלות נמוכה יותר - על חשבון הביצועים - אם היא מגיעה ממשתמשים פחות מעורבים או פחות מחזיקים מעמד.

אופטימיזציה ותזמון מודלים

אופטימיזציות של תוכנה יכולות להשפיע מאוד על זמן הריצה של דגמים - ורווחים פי 10 אינם נדירים. עם זאת, תצטרך לקבוע אילו שיטות יהיו היעילות ביותר עם הדגם והמערכת הספציפיים שלך.

טכניקות מסוימות עובדות עם מגוון רחב למדי של דגמים. שימוש בייצוגי נקודה צפה קצרים יותר (כלומר, FP16 או FP8 לעומת ה-FP32 המקורי) או קוונטיזציה (INT8, INT4, INT2) משיגים מהירות שלרוב היא ליניארית עם הפחתת ביטים. זה מצריך לפעמים לשנות את המודל, אך ישנן, יותר ויותר, טכנולוגיות זמינות המאפשרות עבודה אוטומטית עם דיוק מעורב או קצר יותר. גיזום רשתות עצביות מפחית את מספר המשקולות על ידי התעלמות ממשקולות עם ערכים נמוכים. יחד עם כפל מטריקס דליל יעיל, זה יכול להשיג מהירות משמעותית במעבדי GPU מודרניים. קבוצה נוספת של טכניקות אופטימיזציה מטפלת בצוואר הבקבוק של רוחב הפס של הזיכרון (למשל, על ידי הזרמת משקלי מודל).

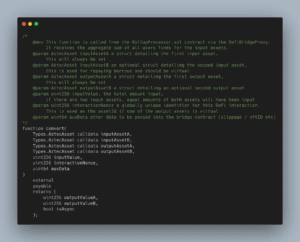

אופטימיזציות אחרות הן מאוד ספציפיות לדגם. לדוגמה, Stable Diffusion עשתה התקדמות משמעותית בכמות ה-VRAM הנדרשת להסקת מסקנות. סוג נוסף של אופטימיזציות הוא ספציפי לחומרה. TensorML של NVIDIA כולל מספר אופטימיזציות, אך יעבוד רק על חומרת NVIDIA. אחרון חביב, תזמון משימות AI יכול ליצור צווארי בקבוק או שיפורים עצומים בביצועים. הקצאת דגמים למעבדי GPU באופן למזער את החלפת משקלים, בחירת ה-GPU הטוב ביותר עבור משימה אם זמינים מרובים, ומזעור זמן השבתה על ידי אצווה של עומסי עבודה מראש הן טכניקות נפוצות.

בסופו של דבר, אופטימיזציה של מודלים היא עדיין אמנות שחורה, ורוב הסטארט-אפים שאנו מדברים איתם עובדים עם צדדים שלישיים כדי לעזור עם חלק מהיבטי התוכנה הללו. לרוב, לא מדובר בספקי MLops מסורתיים, אלא בחברות המתמחות באופטימיזציות עבור מודלים גנרטיביים ספציפיים (למשל, OctoML או SegMind).

כיצד תתפתח עלויות תשתית בינה מלאכותית?

במהלך השנים האחרונות, ראינו צמיחה אקספוננציאלית של שניהם פרמטרים של דגם ו כוח מחשוב של GPU. לא ברור אם מגמה זו תימשך.

כיום, מקובל על כך שיש קשר בין מספר פרמטרים אופטימלי לגודל מערך נתוני האימון (ראה Deepmind's צ'ינצ'ילה לעבוד על זה יותר). ה-LLMs הטובים ביותר כיום מאומנים על סריקה נפוצה (אוסף של 4.5 מיליארד דפי אינטרנט, או כ-10% מכלל דפי האינטרנט הקיימים). קורפוס ההדרכה כולל גם את ויקיפדיה ואוסף ספרים, אם כי שניהם קטנים בהרבה (המספר הכולל של הספרים הקיימים מוערך רק בסביבות 100 מיליון). רעיונות אחרים, כמו תמלול תוכן וידאו או אודיו, הוצעו, אך אף אחד מהם לא מתקרב בגודלו. לא ברור אם נוכל להשיג מערך אימון לא סינתטי שגדול פי 10 ממה שכבר נעשה בו שימוש.

ביצועי ה-GPU ימשיכו לעלות, אך גם בקצב איטי יותר. חוק מור עדיין שלם ומאפשר יותר טרנזיסטורים ויותר ליבות, אבל הספק ו-I/O הופכים לגורמים מגבילים. בנוסף, רבים מהפירות התלויים הנמוכים לצורך אופטימיזציה נקטפו.

עם זאת, כל זה לא אומר שאנחנו לא מצפים לעלייה בביקוש ליכולת מחשוב. גם אם צמיחת המודלים והאימונים תאט, הצמיחה של תעשיית הבינה המלאכותית והגידול במספר מפתחי הבינה המלאכותית יתדלקו ביקוש למעבדי GPU נוספים ומהירים יותר. חלק גדול מקיבולת ה-GPU משמש לבדיקה על ידי מפתחים במהלך שלב הפיתוח של מודל, והביקוש הזה מתרחב באופן ליניארי עם מספר העובדים. אין שום סימן שהמחסור ב-GPU שיש לנו היום יפחת בעתיד הקרוב.

האם המשך העלות הגבוהה הזו של תשתית בינה מלאכותית תיצור חפיר שלא מאפשר למצטרפים חדשים להדביק את הפער עם בעלי תפקידים ממומנים היטב? אנחנו עדיין לא יודעים את התשובה לשאלה הזו. עלות ההכשרה של LLM עשויה להיראות כמו חפיר היום, אבל מודלים של קוד פתוח כמו Alpaca או Stable Diffusion הראו שהשווקים האלה עדיין מוקדמים ועשויים להשתנות במהירות. לאורך זמן, מבנה העלויות של ערימת תוכנת הבינה המלאכותית המתהווה (ראה את הפוסט הקודם שלנו) עשוי להתחיל להיראות יותר כמו תעשיית התוכנה המסורתית.

בסופו של דבר, זה יהיה דבר טוב: ההיסטוריה הוכיחה שזה מוביל למערכות אקולוגיות תוססות עם חדשנות מהירה והמון הזדמנויות למייסדים יזמים.

תודה ל-Moin Nadeem ו-Shangda Xu על ההשקעה וההכוונה שלהם במהלך תהליך הכתיבה.

¹ האינטואיציה כאן היא שלכל פרמטר (כלומר משקל) ברשת עצבית, פעולת הסקה (כלומר מעבר קדימה) צריכה לבצע שתי פעולות נקודה צפה לכל פרמטר. ראשית, הוא מכפיל את הערך של צומת הקלט של הרשת העצבית עם הפרמטר. שנית, הוא מוסיף את תוצאת הסיכום לצומת הפלט של הרשת העצבית. הפרמטרים במקודד משמשים פעם אחת לכל אסימון קלט והפרמטרים במפענח משמשים פעם אחת לכל אסימון פלט. אם נניח שיש לדגם p לפרמטרים ולקלט ופלט שניהם יש אורך n אסימונים, סך כל פעולות הנקודה הצפה הן n * p. יש הרבה פעולות אחרות (למשל נורמליזציה, קידוד/פענוח ההטמעה) שקורות במודל, אבל הזמן שלוקח לביצוען קטן בהשוואה.

² הלמידה מצריכה תחילה מעבר קדימה דרך השנאי כמתואר לעיל, ולאחר מכן מעבר אחורה הכרוך בארבע פעולות נוספות לכל פרמטר כדי לחשב את השיפוע ולהתאים את המשקל. שים לב שחישוב השיפוע דורש שימור ערכי הצומת המחושבים מהמעבר קדימה. עבור GPT-3, מודלים לשפה הם לומדים מעטים דן בעלות ההכשרה.

* * *

הדעות המובעות כאן הן אלה של אנשי AH Capital Management, LLC ("a16z") המצוטטות ואינן הדעות של a16z או החברות הקשורות לה. מידע מסוים הכלול כאן התקבל ממקורות צד שלישי, כולל מחברות פורטפוליו של קרנות המנוהלות על ידי a16z. למרות שנלקחה ממקורות האמינים כאמינים, a16z לא אימתה מידע כזה באופן עצמאי ואינה מציגה מצגים לגבי הדיוק המתמשך של המידע או התאמתו למצב נתון. בנוסף, תוכן זה עשוי לכלול פרסומות של צד שלישי; a16z לא סקרה פרסומות כאלה ואינה תומכת בתוכן פרסומי כלשהו הכלול בהן.

תוכן זה מסופק למטרות מידע בלבד, ואין להסתמך עליו כייעוץ משפטי, עסקי, השקעות או מס. עליך להתייעץ עם היועצים שלך באשר לעניינים אלה. הפניות לניירות ערך או לנכסים דיגיטליים כלשהם נועדו למטרות המחשה בלבד, ואינן מהוות המלצת השקעה או הצעה לספק שירותי ייעוץ השקעות. יתר על כן, תוכן זה אינו מכוון ואינו מיועד לשימוש על ידי משקיעים או משקיעים פוטנציאליים כלשהם, ואין להסתמך עליו בשום פנים ואופן בעת קבלת החלטה להשקיע בקרן כלשהי המנוהלת על ידי a16z. (הצעה להשקעה בקרן a16z תתבצע רק על ידי מזכר ההנפקה הפרטית, הסכם המנוי ותיעוד רלוונטי אחר של כל קרן כזו ויש לקרוא אותה במלואה). המתוארים אינם מייצגים את כל ההשקעות בכלי רכב המנוהלים על ידי a16z, ואין כל ודאות שההשקעות יהיו רווחיות או שלהשקעות אחרות שיבוצעו בעתיד יהיו מאפיינים או תוצאות דומות. רשימה של השקעות שבוצעו על ידי קרנות המנוהלות על ידי אנדריסן הורוביץ (למעט השקעות שעבורן המנפיק לא נתן אישור ל-a16z לחשוף בפומבי וכן השקעות בלתי מוקדמות בנכסים דיגיטליים הנסחרים בבורסה) זמינה בכתובת https://a16z.com/investments /.

תרשימים וגרפים המסופקים בתוכן הם למטרות מידע בלבד ואין להסתמך עליהם בעת קבלת החלטת השקעה כלשהי. ביצועי העבר אינם מעידים על תוצאות עתידיות. התוכן מדבר רק לתאריך המצוין. כל תחזיות, אומדנים, תחזיות, יעדים, סיכויים ו/או דעות המובעות בחומרים אלו כפופים לשינויים ללא הודעה מוקדמת ועשויים להיות שונים או מנוגדים לדעות שהובעו על ידי אחרים. אנא ראה https://a16z.com/disclosures למידע חשוב נוסף.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoAiStream. Web3 Data Intelligence. הידע מוגבר. גישה כאן.

- הטבעת העתיד עם אדריאן אשלי. גישה כאן.

- מקור: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- :יש ל

- :הוא

- :לֹא

- 1 $ מיליארד

- $ למעלה

- 000

- 1

- 100

- 116

- שנים 15

- 2023

- 500

- 7

- 8

- a

- a16z

- יכולת

- יכול

- אודות

- מֵעַל

- מוּחלָט

- להאיץ

- מאיץ

- מאיצים

- קביל

- מקובל

- גישה

- דיוק

- מדויק

- להשיג

- לרוחב

- מוסיף

- תוספת

- נוסף

- בנוסף

- נוסף

- כתובות

- מוסיף

- לקדם

- התקדמות

- יתרון

- פרסום

- עצה

- ייעוץ

- שירותי ייעוץ

- להשפיע על

- סניפים

- לאחר

- שוב

- תוֹקפָּנִי

- הסכם

- AI

- אלגוריתמי

- תעשיות

- הקצאות

- מאפשר

- כְּבָר

- גם

- למרות

- בין

- כמות

- כמויות

- an

- אנליזה

- ו

- אנדריסן

- אנדריסן הורוביץ

- אחר

- לענות

- צפוי

- כל

- API

- האפליקציה

- מופיע

- מופיע

- בקשה

- יישומים

- בערך

- אפליקציות

- אַפּרִיל

- ארכיטקטורה

- ARE

- טענה

- סביב

- אמנות

- מאמר

- מלאכותי

- בינה מלאכותית

- AS

- היבטים

- נכסים

- הבטחה

- At

- תשומת לב

- אודיו

- אוטומטי

- זמינות

- זמין

- מְמוּצָע

- לְהִמָנַע

- AWS

- תכלת

- רוחב פס

- מבוסס

- BE

- כי

- להיות

- הופך להיות

- התהוות

- היה

- להיות

- תאמינו

- האמין

- להלן

- הטוב ביותר

- מוטב

- בֵּין

- מעבר

- הטיה

- גָדוֹל

- B

- קצת

- שחור

- ספרים

- בום

- שניהם

- כָּרוּך

- מותג

- לשבור

- להביא

- רחב

- בְּהַרְחָבָה

- באגים

- לִבנוֹת

- בִּניָן

- נבנה

- עסקים

- מודל עסקי

- אבל

- קונים

- by

- לחשב

- מחושב

- חישוב

- שיחות

- CAN

- יכול לקבל

- לא יכול

- יכולות

- קיבולת

- הון

- כרטיס

- כרטיסים

- מקרה

- מקרים

- היאבקות

- מרכז

- מרכזים

- מסוים

- לאתגר

- שינוי

- מאפיינים

- תווים

- תשלום

- ChatGPT

- זול יותר

- שבב

- שבבי

- בחירות

- בחרו

- בנסיבות

- בכיתה

- ברור

- שעון

- סְגוֹר

- ענן

- ענן מחשוב

- פלטפורמת ענן

- אוסף

- איך

- מגיע

- נוח

- מחויבות

- מְחוּיָב

- מתחייב

- מצרך

- Common

- חברות

- חברה

- לעומת

- השוואה

- השוואה

- משכנע

- להתחרות

- תחרותי

- מורכבות

- מַקִיף

- חישוב

- לחשב

- מחשוב

- - כוח מחשוב

- חיבורי

- התחשבות

- שיקולים

- תמיד

- להוות

- לצרוך

- צרכן

- צְרִיכָה

- מכולות

- תוכן

- הקשר

- להמשיך

- נמשך

- להפך

- לִשְׁלוֹט

- קריר

- ליבה

- עלות

- עלות תועלת

- עלויות

- יכול

- קורס

- לִיצוֹר

- יוצרים

- הקריטריונים

- כיום

- לקוח

- שירות לקוחות

- לקוחות

- שיא הטכנולוגיה

- מחזור

- נתונים

- מרכז נתונים

- מרכז נתונים

- עיבוד נתונים

- מערך נתונים

- מסד נתונים

- תַאֲרִיך

- יְוֹם

- עשרות שנים

- להחליט

- החלטה

- מוקדש

- Deepmind

- למסור

- מסירה

- דרישה

- תלות

- תלוי

- תלוי

- תלוי

- מְתוּאָר

- שולחן העבודה

- לקבוע

- קביעה

- מפותח

- מפתחים

- צעצועי התפתחות

- נבדלים

- הבדל

- ההבדלים

- שידור

- דיגיטלי

- נכסים דיגיטליים

- ישירות

- לחשוף

- הנחות

- מובהק

- do

- תיעוד

- עושה

- עושה

- דולר

- עשה

- לא

- מטה

- זמן השבתה

- באופן דרמטי

- נהיגה

- נהג

- נהיגה

- ראוי

- בְּמַהֲלָך

- e

- מוקדם

- קל יותר

- בקלות

- מערכות אקולוגיות

- אפקטיבי

- יעילות

- תופעות

- יְעִילוּת

- יעיל

- או

- הטבעה

- מתעורר

- סוף

- תומך

- מתמשכת

- מאורס

- מרתק

- הנדסה

- מהנדסים

- שְׁלֵמוּת

- נכנס

- יזמית

- שווה

- במיוחד

- למעשה

- לְהַעֲרִיך

- מוערך

- הערכות

- אֲפִילוּ

- אי פעם

- להתפתח

- דוגמה

- עולה

- מרגש

- לְמַעֵט

- לבצע

- מבצע

- להתקיים

- הרחבה

- לצפות

- יקר

- ניסיון

- להסביר

- מעריכי

- צמיחה אקספוננציאלית

- ביטא

- מאוד

- בדים

- פָּנִים

- גורמים

- הוגן

- למדי

- משפחה

- מהר

- מהר יותר

- מאפיין

- תכונות

- אגרות

- מעטים

- כלכלית

- סוף

- ראשון

- מתאים

- קבוע

- Flip

- צף

- להתמקד

- בעקבות

- בעד

- תחזיות

- למרבה המזל

- קדימה

- מצא

- קרן

- המייסדים

- ארבע

- שבריר

- מסגרת

- החל מ-

- לתדלק

- כֵּיף

- קרן

- כספים

- יתר על כן

- עתיד

- רווחים

- המשחקים

- כללי

- יצירת

- דור

- גנרטטיבית

- AI Generative

- גֵאוֹגרָפִי

- הגיאופוליטי

- לקבל

- מקבל

- לתת

- נתן

- נותן

- Go

- טוב

- Google Cloud

- פלטפורמת Google Cloud

- GPU

- GPUs

- בוגר

- גרפיקה

- גרפים

- לגדול

- צמיחה

- הדרכה

- יד

- לטפל

- טיפול

- לקרות

- קשה

- חומרה

- רתימה

- יש

- ספירת ראשים

- נשמע

- לעזור

- מועיל

- כאן

- גָבוֹהַ

- היי-אנד

- מאוד

- היסטוריה

- ברדס

- אני מקווה

- הורוביץ

- המארח

- אירח

- שעות

- איך

- איך

- אולם

- HTML

- HTTPS

- עצום

- הַרבֵּה מְאוֹד

- בני אדם

- i

- רעיונות

- if

- תמונה

- מיידי

- חשוב

- בלתי אפשרי

- שיפורים

- in

- באחר

- תמריץ

- לכלול

- כולל

- כולל

- להגדיל

- עליות

- יותר ויותר

- באופן עצמאי

- הצביע

- בנפרד

- תעשייה

- מידע

- מידע

- תשתית

- חדשנות

- קלט

- למשל

- במקום

- הוראות

- משולב

- מוֹדִיעִין

- אינטראקטיבי

- אל תוך

- להשקיע

- השקעה

- ייעוץ השקעות

- השקעות

- משקיעים

- מנפיק

- IT

- שֶׁלָה

- עצמו

- מקומות תעסוקה

- רק

- שמור

- סוג

- לדעת

- מעבדות

- נוף

- שפה

- גָדוֹל

- במידה רבה

- גדול יותר

- אחרון

- חֶבִיוֹן

- חוק

- מוביל

- למידה

- משפטי

- אורך

- החיים

- כמו

- סביר

- רשימה

- לאמה

- LLM

- מיקום

- הגיוני

- ארוך

- לטווח ארוך

- עוד

- נראה

- נראה כמו

- הסתכלות

- מגרש

- נמוך

- להוריד

- הנמוך ביותר

- מכונה

- עשוי

- גדול

- הרוב

- לעשות

- עושה

- עשייה

- לנהל

- הצליח

- ניהול

- ניהול

- האנושות

- רב

- שוק

- שוקי

- מסיבי

- חומרים

- מתמטיקה

- מַטרִיצָה

- עניינים

- max-width

- מאי..

- משמעותי

- אומר

- בינתיים

- לִפְגוֹשׁ

- תזכיר

- זכרון

- מוּזְכָּר

- שיטות

- מיקרוסופט

- Microsoft Azure

- מִילִיוֹן

- מזעור

- מינימום

- מעורב

- MLOps

- מודל

- מודלים

- מודרני

- כסף

- חודשים

- יותר

- רוב

- הכי פופולארי

- הרבה

- מספר

- מכפילים

- מנווט

- ליד

- כמעט

- הכרחי

- צורך

- נחוץ

- צרכי

- רשת

- רשתות

- רשתות

- רשת עצבית

- רשתות עצביות

- חדש

- מוצר חדש

- חדשות

- הבא

- לא

- צומת

- צמתים

- הודעה..

- עַכשָׁיו

- מספר

- מספרים

- Nvidia

- להשיג

- מושג

- of

- הַצָעָה

- הצעה

- לעתים קרובות

- on

- On-Demand

- פעם

- ONE

- באינטרנט

- רק

- לפתוח

- קוד פתוח

- OpenAI

- פועל

- מבצע

- תפעול

- דעות

- הזדמנויות

- אופטימלי

- אופטימיזציה

- מטב

- אופטימיזציה

- מיטוב

- or

- להזמין

- מְקוֹרִי

- בְּמָקוֹר

- אחר

- אחרים

- שלנו

- הַחוּצָה

- תפוקה

- מתעלה

- יותר

- מקיף

- שֶׁלוֹ

- מקביל

- פרמטר

- פרמטרים

- מסוים

- צדדים

- חלקים

- לעבור

- עבר

- לְבַצֵעַ

- ביצועים

- רשות

- כוח אדם

- שלב

- לבחור

- הרים

- מקום

- פלטפורמה

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- אנא

- PoC

- נקודה

- בריכה

- פופולרי

- תיק עבודות

- יִתָכֵן

- הודעה

- כּוֹחַ

- חזק

- מעשי

- תרגול

- דיוק

- פּרֶמיָה

- קודם

- מחיר

- מחירים

- תמחור

- יְסוֹדִי

- פְּרָטִי

- כנראה

- בעיה

- בעיות

- תהליך

- תהליך

- מעבד

- המוצר

- משתלם

- התחזיות

- רכוש

- לְעַתִיד

- לקוחות פוטנציאליים

- מוכח

- לספק

- ובלבד

- ספק

- ספקים

- ציבורי

- בפומבי

- רכישה

- למטרות

- שאלה

- מהירות

- R & D

- מורם

- רכס

- דירוג

- מהיר

- מהר

- ציון

- תעריפים

- חי

- לְהַגִיעַ

- חומר עיוני

- זמן אמת

- מציאות

- טעם

- סיבות

- המלצה

- להפחית

- מפחית

- אזכור

- מכונה

- אזורי

- קשר

- יחסית

- לשחרר

- רלוונטי

- אמינות

- אָמִין

- הקלה

- להשאר

- שְׂרִידִים

- נציג

- מכובד

- מוניטין

- לבקש

- בקשות

- לדרוש

- נדרש

- דרישה

- דרישות

- דורש

- משאבים

- אלה

- תגובה

- תוצאה

- תוצאות

- סקר

- rtx

- RTX 3080

- RTX 3080 טי

- כלל

- הפעלה

- ריצה

- אמר

- אותו

- שמור

- סולם

- מאזניים

- תזמון

- היקף

- חיפוש

- חיפוש

- שְׁנִיָה

- שניות

- סעיף

- ניירות ערך

- לִרְאוֹת

- לראות

- מבחר

- תחושה

- רגיש

- נפרד

- רצף

- לשרת

- שרתים

- שרות

- שירותים

- סט

- התקנה

- כמה

- שיתוף

- קצר

- מחסור

- צריך

- הראה

- הופעות

- צד

- סִימָן

- דומה

- בפשטות

- since

- יחיד

- מצב

- מידה

- גדל

- מאט

- קטן

- קטן יותר

- So

- עד כה

- תוכנה

- פותר

- כמה

- משהו

- במידה מסוימת

- מָקוֹר

- מקורות

- מֶרחָב

- מדבר

- מדבר

- מתמחים

- מיוחד

- התמחות

- ספציפי

- במיוחד

- לבלות

- הוצאה

- קוצים

- לפצל

- יציב

- לערום

- התחלה

- Start-up

- החל

- חברות סטארט

- עוד

- אחסון

- חנות

- נהירה

- מִבְנֶה

- נושא

- מִנוּיים

- ניכר

- הצלחה

- כזה

- מַתְאִים

- לסכם

- לספק

- תמיכה

- מערכת

- שולחן

- לקחת

- לוקח

- לדבר

- מטרות

- המשימות

- משימות

- מס

- נבחרת

- טכני

- טכניקות

- טכנולוגיות

- טכנולוגיה

- מונחים

- בדיקות

- מֵאֲשֶׁר

- זֶה

- השמיים

- העתיד

- המידע

- הנוף

- שֶׁלָהֶם

- אותם

- שם.

- בו

- אלה

- הֵם

- דבר

- לחשוב

- חושב

- שְׁלִישִׁי

- צד שלישי

- צד שלישי

- זֶה

- אלה

- אלפים

- שְׁלוֹשָׁה

- דרך

- קָשׁוּר

- זמן

- פִּי

- ל

- היום

- של היום

- יַחַד

- אסימון

- טוקניזציה

- מטבעות

- גַם

- חלק עליון

- סה"כ

- לקראת

- כוח משיכה

- נסחר

- מסורתי

- תְנוּעָה

- רכבת

- מְאוּמָן

- הדרכה

- רוֹבּוֹטרִיקִים

- לתרגם

- מְגַמָה

- ניסיתי

- טרִילִיוֹן

- נָכוֹן

- שתיים

- סוג

- סוגים

- טיפוסי

- בדרך כלל

- ui

- נדיר

- תחת

- בְּסִיסִי

- להבין

- ייחודי

- יחידות

- מְעוּדכָּן

- על

- us

- להשתמש

- במקרה להשתמש

- מְשׁוּמָשׁ

- משתמש

- חוויית משתמש

- משתמשים

- באמצעות

- בְּדֶרֶך כְּלַל

- בעל ערך

- ערך

- מוערך

- ערכים

- מגוון

- Vast

- כלי רכב

- ספקים

- מְאוּמָת

- בֵּמְאוּנָך

- מאוד

- בַּר חַיִים

- מלא חיים

- וִידֵאוֹ

- נופים

- כרכים

- vs

- לחכות

- רוצה

- היה

- דֶרֶך..

- דרכים

- we

- אינטרנט

- שירותי אינטרנט

- שבוע

- מִשׁקָל

- טוֹב

- מה

- מתי

- אשר

- בזמן

- מי

- רָחָב

- טווח רחב

- באופן נרחב

- ויקיפדיה

- יצטרך

- מוכן

- עם

- בתוך

- לְלֹא

- Word

- מילים

- תיק עבודות

- עובד

- היה

- כתיבה

- שנה

- שנים

- עוד

- אתה

- זפירנט