מבוא

לימוד אנגלית אינו משימה קלה, כפי שאינספור תלמידים יודעים היטב. אבל כשהתלמיד הוא מחשב, גישה אחת עובדת בצורה מפתיעה: פשוט הזינו הרים של טקסט מהאינטרנט למודל מתמטי ענק שנקרא רשת עצבית. זה עקרון הפעולה מאחורי מודלים של שפה גנרטיבית כמו ChatGPT של OpenAI, שהיכולת שלו לשוחח באופן קוהרנטי (אם לא תמיד בכנות) על מגוון רחב של נושאים הפתיעה את החוקרים ואת הציבור בשנה האחרונה.

אבל לגישה יש חסרונות. ראשית, הליך ה"הדרכה" הנדרש כדי להפוך ארכיוני טקסט עצומים למודלים של שפות חדישים הוא יקר ועתיר זמן. מצד שני, אפילו האנשים המאמנים מודלים של שפה גדולים מתקשים להבין את פעולתם הפנימית; זה, בתורו, מקשה לחזות את הדרכים הרבות שבהן הם יכולים להיכשל.

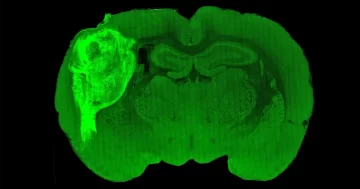

מול קשיים אלה, חלק מהחוקרים בחרו להתאמן דגמים קטנים יותר על מערכי נתונים קטנים יותר ואז למד את ההתנהגות שלהם. "זה כמו לעשות רצף של תסיסנית הגנום לעומת רצף הגנום האנושי", אמר אלי פאבליק, חוקר מודל שפה באוניברסיטת בראון.

עכשיו, בתוך מאמר זוג חוקרים של מיקרוסופט, שפורסם לאחרונה בשרת ה-preprint המדעי arxiv.org, הציגו שיטה חדשה לאימון מודלים של שפות זעירות: גדל אותם על דיאטה קפדנית של סיפורי ילדים.

חוקרי למידת מכונה אימצו את השיעור הזה. ל-GPT-3.5, מודל השפה הגדול שמפעיל את ממשק ChatGPT, יש כמעט 200 מיליארד פרמטרים, והוא הוכשר על מערך נתונים הכולל מאות מיליארדי מילים. (OpenAI לא פרסמה את הנתונים המקבילים עבור היורש שלה, GPT-4.) אימון דגמים גדולים כאלה דורש בדרך כלל לפחות 1,000 מעבדים מיוחדים הנקראים GPUs הפועלים במקביל במשך שבועות בכל פעם. רק חברות בודדות יכולות לגייס את המשאבים הדרושים, שלא לדבר על להכשיר ולהשוות בין דגמים שונים.

שני החוקרים הראו כי מודלים של שפה הקטנים פי אלפי מונים מהמערכות המתקדמות של היום למדו במהירות לספר סיפורים עקביים ודקדוקיים כשהם מאומנים בצורה זו. התוצאות שלהם מרמזות על כיווני מחקר חדשים שעשויים להיות מועילים לאימון מודלים גדולים יותר והבנת ההתנהגות שלהם.

"מצאתי את המאמר הזה מאוד אינפורמטיבי," אמר צ'נדרה בהגאוואטולה, חוקר מודל שפה במכון אלן לבינה מלאכותית בסיאטל. "הקונספט עצמו סופר מעניין."

היה היה

הרשתות העצביות בלב מודלים של שפה הן מבנים מתמטיים בהשראת המוח האנושי. כל אחד מהם מכיל נוירונים מלאכותיים רבים המסודרים בשכבות, עם קשרים בין נוירונים בשכבות סמוכות. התנהגות הרשת העצבית נשלטת על ידי עוצמתם של קשרים אלה, הנקראים פרמטרים. במודל שפה, הפרמטרים קובעים אילו מילים המודל עשוי לירוק לאחר מכן, בהינתן הנחיה ראשונית והמילים שהוא כבר יצר.

מודל מתעורר לחיים רק במהלך האימון, כאשר הוא משווה שוב ושוב את הפלט שלו לטקסט במערך נתוני האימון שלו ומתאים את הפרמטרים שלו כדי להגדיל את הדמיון. רשת לא מאומנת עם פרמטרים אקראיים קלה להרכיב מכמה שורות קוד, אבל היא רק תיצור ג'יבריש. לאחר האימון, לעתים קרובות זה יכול להמשיך טקסט לא מוכר. דגמים גדולים יותר עוברים לעתים קרובות כוונון עדין נוסף המלמד אותם לענות על שאלות ולעקוב אחר הוראות, אך עיקר האימון הוא שליטה בחיזוי מילים.

הצלחה בחיזוי מילים דורשת מודל שפה כדי לשלוט במיומנויות רבות ושונות. לדוגמה, כללי הדקדוק האנגלי מציעים שהמילה הבאה אחרי המילה "הולך" צפויה להיות "אל", ללא קשר לנושא הטקסט. בנוסף, מערכת זקוקה לידע עובדתי כדי להשלים "בירת צרפת היא", והשלמת קטע המכיל המילה "לא" דורש תפיסה בסיסית של היגיון.

"שפה גולמית היא מאוד מסובכת", אמר טימותי נגוין, חוקר למידת מכונה ב-DeepMind. "כדי שייווצרו יכולות לשוניות מעניינות, אנשים פנו ל'יותר נתונים זה טוב יותר'".

מבוא

רונן אלדן, מתמטיקאי שהצטרף ל-Microsoft Research בשנת 2022 כדי ללמוד מודלים של שפה גנרטיבית, רצה לפתח דרך זולה ומהירה יותר לחקור את היכולות שלהם. הדרך הטבעית לעשות זאת הייתה באמצעות מערך נתונים קטן, וזה בתורו אומר שהוא יצטרך להכשיר דגמים להתמחות במשימה ספציפית, כדי שהם לא יתפשטו מדי. בתחילה, הוא רצה להכשיר דוגמניות כדי לפתור סוג מסוים של בעיות במתמטיקה, אבל אחר הצהריים אחד, לאחר שבילה עם בתו בת ה-5, הוא הבין שסיפורי ילדים מתאימים באופן מושלם.

"זה ממש בא לי אחרי שקראתי לה סיפור", אמר.

כדי ליצור סיפורי ילדים קוהרנטיים, מודל שפה יצטרך ללמוד עובדות על העולם, לעקוב אחר דמויות ואירועים ולשמור על כללי הדקדוק - גרסאות פשוטות יותר של האתגרים העומדים בפני מודלים גדולים. אבל מודלים גדולים המאומנים על מערכי נתונים מסיביים לומדים אינספור פרטים לא רלוונטיים יחד עם הכללים החשובים באמת. אלדן קיווה שהקיצור ואוצר המילים המצומצם של סיפורי ילדים עשויים להפוך את הלמידה לניתנת לניהול עבור דוגמניות קטנות - מה שיהפוך אותן גם לקל יותר לאימון וגם לקל יותר להבנה.

עם זאת, בעולם של מודלים לשפות, "קטן" הוא יחסי: מערך נתונים קטן פי אלף מזה המשמש לאימון GPT-3.5 עדיין יצטרך להכיל מיליוני סיפורים. "אני לא יודע כמה כסף אתה רוצה להוציא, אבל אני מנחש שאתה לא הולך לשכור אנשי מקצוע כדי לכתוב [כמה מיליון] סיפורים קצרים", אמר נגוין.

יידרש סופר פורה בצורה יוצאת דופן כדי לספק קוראים רעבים כאלה, אבל אלדן חשב על כמה מועמדים. מי יותר טוב לכתוב לקהל של דגמי שפה קטנים מאשר לגדולים?

צעצוע סיפורים

אלדן יצא מיד ליצור ספרייה של סיפורי ילדים סינתטיים שנוצרו על ידי מודלים לשוניים גדולים. אבל עד מהרה גילה שאפילו דוגמניות חדישות מטבע הדברים אינן יצירתיות במיוחד. אם רק תגיד ל-GPT-4 לכתוב סיפורים המתאימים לילדים בני 4, אמר אלדן, "כחמישית מהסיפורים יהיו על ילדים שהולכים לפארק מפחדים מהמגלשות". זה כנראה הסיפור המובהק לגיל הרך, מבחינת האינטרנט.

הפתרון היה להוסיף קצת אקראיות להנחיה. ראשית, אלדן השתמש ב-GPT-4 כדי ליצור רשימה של 1,500 שמות עצם, פעלים ושמות תואר שילד בן 4 עשוי לדעת - קצר מספיק כדי שיוכל לבדוק זאת בקלות בעצמו. אחר כך הוא כתב תוכנת מחשב פשוטה שתנחה שוב ושוב את GPT-3.5 או GPT-4 ליצור סיפור המותאם לגיל הכולל שלוש מילים אקראיות מהרשימה, יחד עם פרט נוסף שנבחר באקראי כמו סוף טוב או טוויסט בעלילה. הסיפורים שהתקבלו, רחמנא ליצלן, פחות התמקדו בשקופיות מפחידות.

לאלדן היה כעת נוהל להוצאת נתוני אימון לפי דרישה, אבל לא היה לו מושג כמה סיפורים הוא צריך כדי להכשיר מודל פונקציונלי, או כמה גדול המודל הזה צריך להיות. אז הוא התחבר אליו יואנשי לי, חוקר למידת מכונה במיקרוסופט ובאוניברסיטת קרנגי מלון, לנסות אפשרויות שונות, תוך ניצול העובדה שניתן לאמן דגמים קטנים במהירות רבה. שלב 1 היה ההחלטה כיצד להעריך את המודלים שלהם.

מבוא

בחקר מודלים של שפה - כמו בכל כיתה - ציון הוא נושא עמוס. יש אין רובריקה מושלמת שמכיל בתוכו את כל מה שחוקרים רוצים לדעת, ומודלים המצטיינים במשימות מסוימות נכשלים לעתים קרובות בצורה מרהיבה באחרות. עם הזמן, חוקרים פיתחו אמות מידה סטנדרטיות שונות המבוססות על שאלות עם תשובות חד משמעיות, וזו גישה טובה אם אתה מנסה להעריך מיומנויות ספציפיות. אבל אלדן ולי התעניינו במשהו מעורפל יותר: כמה גדולים באמת צריכים להיות מודלים של שפה אם מפשטים את השפה ככל האפשר?

"כדי לבדוק ישירות אם המודל דובר אנגלית, אני חושב שהדבר היחיד שאתה יכול לעשות הוא לתת למודל ליצור אנגלית בצורה פתוחה", אמר אלדן.

יש רק שתי דרכים למדוד ביצועים של מודל בשאלות איכותיות כאלה: הסתמכו על תלמידי כיתה אנושיים, או פנו שוב ל-GPT-4. שני החוקרים בחרו במסלול האחרון, ולמעשה נתנו לדוגמניות הגדולות גם לכתוב את ספרי הלימוד וגם לדרג את החיבורים.

Bhagavatula אמר שהוא היה רוצה לראות כיצד ההערכות של GPT-4 בהשוואה לאלו של סוקרים אנושיים - GPT-4 עשויה להיות מוטה כלפי מודלים שהוא עזר לאמן, והאטימות של מודלים של שפה מקשה לכמת הטיות כאלה. אבל הוא לא חושב שדקויות כאלה ישפיעו על השוואות בין מודלים שונים שהוכשרו על סטים דומים של סיפורים סינתטיים - המוקד העיקרי של עבודתם של אלדן ולי.

אלדן ולי השתמשו בהליך דו-שלבי להערכת כל אחד מהמודלים הקטנים שלהם לאחר האימון. ראשית, הם הניעו את המודל הקטן עם המחצית הראשונה של סיפור נבדל מאלה שבסט נתוני האימון, כך שהוא יצר סוף חדש, וחוזר על התהליך הזה עם 50 סיפורי מבחן שונים. שנית, הם הורו ל-GPT-4 לדרג כל אחד מהסופים של הדגם הקטן בהתבסס על שלוש קטגוריות - יצירתיות, דקדוק ועקביות עם תחילת הסיפור. לאחר מכן הם הביאו ממוצע של הציונים בכל קטגוריה, והגיעו לשלושה ציונים סופיים לכל דגם.

עם ההליך הזה ביד, אלדן ולי היו מוכנים סוף סוף להשוות בין דגמים שונים ולגלות מי הם התלמידים הכוכבים.

תוצאות מבחן

לאחר חקירה ראשונית, שני החוקרים התייצבו על מערך נתוני אימון המכיל בערך 2 מיליון סיפורים. לאחר מכן הם השתמשו במערך הנתונים הזה, שזכה לכינוי TinyStories, כדי להכשיר דגמים בגודל של בין מיליון ל-1 מיליון פרמטרים, עם מספר משתנה של שכבות. זו הייתה עבודה מהירה: תוך שימוש בארבעה מעבדי GPU בלבד, לאימון הגדול מבין הדגמים הללו לקח לא יותר מיממה.

הדוגמניות הקטנות ביותר נאבקו. לדוגמה, סיפור מבחן אחד מתחיל עם גבר מרושע למראה אומר לבחורה שהוא ייקח את החתול שלה. דוגמנית של מיליון פרמטרים נתקעה בלופ כשהילדה מספרת שוב ושוב לגבר שהיא רוצה להיות חברים. אבל הגדולים יותר - עדיין קטנים מאלפי מונים מ-GPT-3.5 - פעלו בצורה מפתיעה. הגרסה של 28 מיליון פרמטרים סיפרה סיפור קוהרנטי, אם כי הסוף היה קודר: "קייטי התחילה לבכות, אבל לאיש לא היה אכפת. הוא לקח את החתול וקייטי לא ראתה את החתול שלה שוב. הסוף."

בנוסף לבדיקת המודלים שלהם, אלדן ולי הציגו את אותו אתגר ל-GPT-2 של OpenAI, דגם של 1.5 מיליארד פרמטרים ששוחרר ב-2019. זה היה הרבה יותר גרוע - לפני סיום הסיפור הפתאומי, האיש מאיים לקחת את הילדה לבית המשפט, לכלא, לבית החולים, לחדר המתים ולבסוף למשרפה.

מבוא

Nguyen אמר שזה מרגש שדגמים זעירים כאלה היו כל כך שוטפים, אבל אולי לא מפתיע ש-GPT-2 נאבק במשימה: זה דגם גדול יותר אבל רחוק ממצב האמנות, והוא הוכשר על מערך נתונים שונה מאוד. "פעוט שמתאמן רק על משימות פעוטות, כמו משחק עם כמה צעצועים, עשוי להצליח יותר ממך או ממני", ציין. "לא התמקצענו בדבר הפשוט הזה."

השוואות בין דגמי TinyStories שונים לא סובלות מאותם גורמים מבלבלים. אלדן ולי הבחינו ברמזים לכך שרשתות עם פחות שכבות אך יותר נוירונים לשכבה היו טובות יותר במתן מענה לשאלות הדורשות ידע עובדתי; לעומת זאת, רשתות עם יותר שכבות ופחות נוירונים לשכבה היו טובות יותר במעקב אחר דמויות ונקודות עלילה מקודם בסיפור. Bhagavatula מצאה את התוצאה הזו מסקרנת במיוחד. אם ניתן יהיה לשכפל את זה בדגמים גדולים יותר, הוא אמר, "זו תהיה תוצאה ממש מגניבה שיכולה לנבוע מהעבודה הזו".

אלדן ולי גם למדו כיצד יכולות הדוגמניות הקטנות שלהם תלויות במשך תקופת ההכשרה. בכל מקרה, מודלים שלטו תחילה בדקדוק ובעקביות מאוחר יותר. בעיני אלדן, דפוס זה ממחיש כיצד הבדלים במבני תגמול מובילים להבדלים בדפוסי רכישת שפה בין רשתות עצביות וילדים. עבור מודלים של שפה, הלומדים על ידי חיזוי מילים, "התמריץ על המילים 'אני רוצה לקבל' הוא גדול כמו שהוא על המילים 'גלידה'", אמר. לילדים, לעומת זאת, "לא אכפת להם אם הם אומרים 'אני רוצה קצת גלידה' או רק 'גלידה, גלידה, גלידה'".

איכות מול כמות

אלדן ולי מקווים שהמחקר יניע חוקרים אחרים להכשיר מודלים שונים מערך הנתונים של TinyStories ולהשוות את היכולות שלהם. אבל לעתים קרובות קשה לחזות אילו מאפיינים של דגמים קטנים יופיעו גם בגדולים יותר.

"אולי מודלים של ראייה של עכברים הם באמת מקור טוב לראייה אנושית, אבל האם מודלים של עכברים של דיכאון הם מודלים טובים של דיכאון אנושי?" אמר פאבליק. "לכל מקרה זה קצת שונה."

ההצלחה של דגמי ה-TinyStories מציעה גם לקח רחב יותר. הגישה הסטנדרטית להרכבת מערכי אימון כוללת שאיבת טקסט מרחבי האינטרנט ואז סינון האשפה. טקסט סינתטי שנוצר על ידי מודלים גדולים יכול להציע דרך חלופית להרכיב מערכי נתונים באיכות גבוהה שלא יצטרכו להיות כל כך גדולים.

"יש לנו יותר ויותר עדויות לכך שזה מאוד יעיל, לא רק בדגמים בגודל של TinyStories אלא גם בדגמים גדולים יותר", אמר אלדן. העדויות הללו מגיעות מצמד מאמרי המשך על מודלים של מיליארד פרמטרים של אלדן, לי וחוקרים אחרים של מיקרוסופט. בתוך ה נייר ראשון, הם אימנו מודל ללמוד את שפת התכנות Python באמצעות קטעי קוד שנוצרו על ידי GPT-3.5 יחד עם קוד שנקבע בקפידה מהאינטרנט. בתוך ה שני, הם הגדילו את מערך נתוני ההדרכה עם "ספרי לימוד" סינתטיים, המכסים מגוון רחב של נושאים, כדי להכשיר מודל שפה למטרות כלליות. בבדיקות שלהם, שני המודלים השוו לטובה למודלים גדולים יותר שהוכשרו על מערכי נתונים גדולים יותר. אבל הערכת מודלים של שפה היא תמיד מסובכת, וגישת נתוני האימון הסינתטיים עדיין בחיתוליה - יש צורך במבחנים עצמאיים יותר.

ככל שדגמי השפה החדישים הולכים וגדלים, ממצאים מפתיעים מבני הדודים הקטנטנים שלהם מזכירים שעדיין יש הרבה שאנחנו לא מבינים אפילו על הדגמים הפשוטים ביותר. Nguyen מצפה לראות מאמרים רבים נוספים הבוחנים את הגישה שחלו על ידי TinyStories.

"השאלה היא: איפה ולמה הגודל חשוב?" הוא אמר. "צריך להיות מדע על זה, ואני מקווה שהמאמר הזה הוא התחלה של סיפור עשיר."

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://www.quantamagazine.org/tiny-language-models-thrive-with-gpt-4-as-a-teacher-20231005/

- :יש ל

- :הוא

- :לֹא

- :איפה

- ][עמ'

- $ למעלה

- 000

- 1

- 200

- 200 מיליארדים

- 2019

- 2022

- 30

- 50

- 500

- a

- יכולות

- יכולת

- אודות

- רכישה

- לרוחב

- להוסיף

- תוספת

- נוסף

- סמוך

- יתרון

- להשפיע על

- לאחר

- שוב

- אלן

- לבד

- לאורך

- כְּבָר

- גם

- חלופה

- תמיד

- an

- ו

- אנדרו

- אחר

- לענות

- תשובות

- לְהוֹפִיעַ

- גישה

- מתאים

- ארכיון

- ARE

- לְהִתְעוֹרֵר

- מְסוּדָר

- אמנות

- מלאכותי

- בינה מלאכותית

- AS

- At

- קהל מאזינים

- מוגבר

- מחבר

- רָחוֹק

- מבוסס

- BE

- לפני

- ההתחלה

- התנהגות

- מאחור

- להיות

- מבחני ביצועים

- מוטב

- בֵּין

- מְשׁוּחָד

- הטיות

- גָדוֹל

- B

- מיליארדים

- קצת

- שניהם

- מוֹחַ

- רחב

- חום

- אבל

- by

- נקרא

- הגיע

- CAN

- מועמדים

- יכולות

- הון

- אשר

- בזהירות

- קרנגי מלון

- מקרה

- חָתוּל

- קטגוריות

- קטגוריה

- מסוים

- לאתגר

- האתגרים

- מאפיינים

- תווים

- ChatGPT

- זול יותר

- לבדוק

- ילדים

- בחר

- נבחר

- בכיתה

- קוד

- קוהרנטי

- מגיע

- חברות

- לְהַשְׁווֹת

- לעומת

- השוואות

- להשלים

- מַשׁלִים

- מסובך

- מכיל

- המחשב

- מושג

- מודאג

- חיבורי

- עִקבִי

- להכיל

- מכיל

- להמשיך

- לִשְׁלוֹט

- להיפך

- קריר

- תוֹאֵם

- יקר

- יכול

- זוג

- בית דין

- כיסוי

- לִיצוֹר

- יְצִירָתִי

- יצירתיות

- אוצר

- נתונים

- מערך נתונים

- ערכות נתונים

- יְוֹם

- מחליטים

- Deepmind

- דרישה

- דכאון

- פרט

- פרטים

- לפתח

- מפותח

- דִיאֵטָה

- ההבדלים

- אחר

- קשיים

- ישירות

- גילה

- מובהק

- do

- עושה

- לא

- לא

- חסרונות

- דיבוב

- משך

- בְּמַהֲלָך

- כל אחד

- מוקדם יותר

- קל יותר

- בקלות

- קל

- אפקטיבי

- יעילות

- חבוק

- עוטף

- סוף

- סיום

- אנגלית

- מספיק

- במיוחד

- להעריך

- הערכה

- הערכות

- אֲפִילוּ

- אירועים

- אי פעם

- כל

- הכל

- עדות

- דוגמה

- Excel

- מרגש

- מצפה

- חקירה

- לחקור

- היכרות

- באופן יוצא דופן

- מול

- עובדה

- גורמים

- עובדות

- FAIL

- רחוק

- מהר יותר

- מעטים

- פחות

- דמויות

- סינון

- סופי

- בסופו של דבר

- ממצאים

- ראשון

- מתאים

- להתמקד

- מרוכז

- לעקוב

- בעד

- מצא

- ארבע

- צרפת

- חברים

- החל מ-

- פונקציונלי

- נוסף

- מטרה כללית

- ליצור

- נוצר

- גנרטטיבית

- ענק

- ילדה

- נתן

- הולך

- טוב

- קבל

- נשלט

- GPUs

- ציון

- דקדוק

- לתפוס

- קודר

- לגדול

- היה

- חצי

- יד

- שמח

- קשה

- יש

- he

- לֵב

- עזר

- מועיל

- לה

- באיכות גבוהה

- רמזים

- לִשְׂכּוֹר

- שֶׁלוֹ

- לקוות

- אני מקווה

- בית חולים

- איך

- איך

- HTTPS

- בן אנוש

- מאות

- i

- קרח

- גלידה

- רעיון

- if

- מדגים

- מיד

- in

- תמריץ

- כלול

- להגדיל

- עצמאי

- אִינפוֹרמָטִיבִי

- בתחילה

- בהתחלה

- השראה

- מכון

- הוראות

- מוֹדִיעִין

- מעוניין

- מעניין

- מִמְשָׁק

- אינטרנט

- אל תוך

- מסקרן

- הציג

- IT

- שֶׁלָה

- עצמו

- כלא

- הצטרף

- רק

- שמור

- שמירה

- לדעת

- ידע

- שפה

- גָדוֹל

- גדול יותר

- הגדול ביותר

- מאוחר יותר

- שכבה

- שכבות

- עוֹפֶרֶת

- לִלמוֹד

- למד

- למידה

- הכי פחות

- פחות

- לקח

- לתת

- לתת

- Li

- סִפְרִיָה

- החיים

- כמו

- סביר

- מוגבל

- קווים

- רשימה

- קְצָת

- הגיון

- מכונה

- למידת מכונה

- מגזין

- ראשי

- לעשות

- עושה

- עשייה

- איש

- ניתן לניהול

- רב

- מסיבי

- אב

- מאסטרינג

- מתמטיקה

- מתימטי

- דבר

- מאי..

- me

- התכוון

- למדוד

- מלון

- שיטה

- מיקרוסופט

- יכול

- מִילִיוֹן

- מיליונים

- אכפת לי

- מודל

- מודלים

- כסף

- יותר

- הרבה

- טבעי

- כמעט

- הכרחי

- צורך

- צרכי

- רשת

- רשתות

- עצבי

- רשת עצבית

- רשתות עצביות

- נוירונים

- לעולם לא

- חדש

- הבא

- נגויין

- לא

- ציין

- שמות עצם

- עַכשָׁיו

- מספרים

- להתבונן

- of

- הַצָעָה

- לעתים קרובות

- on

- פעם

- ONE

- יחידות

- רק

- עֲמִימוּת

- OpenAI

- פועל

- or

- להזמין

- אחר

- אחרים

- הַחוּצָה

- תפוקה

- יותר

- שֶׁלוֹ

- זוג

- מאמר

- ניירות

- מקביל

- פרמטרים

- פארק

- מעבר

- עבר

- תבנית

- דפוסי

- אֲנָשִׁים

- עבור

- ביצועים

- ביצעתי

- אוּלַי

- תקופה

- חלוצית

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- משחק

- נקודות

- אפשרויות

- אפשרי

- פורסם

- כוחות

- לחזות

- ניבוי

- נבואה

- מקדים

- מוצג

- עקרון

- בעיות

- הליך

- תהליך

- מעבדים

- לייצר

- אנשי מקצוע

- תָכְנִית

- תכנות

- ציבורי

- פיתון

- אֵיכוּתִי

- קוונטמגזין

- שאלה

- שאלות

- מָהִיר

- מהירות

- תַמצִיתִי

- להעלות

- אקראי

- אקראי

- רכס

- טִוּוּחַ

- מהר

- חומר עיוני

- הקוראים

- מוכן

- הבין

- בֶּאֱמֶת

- לאחרונה

- ללא קשר

- קרוב משפחה

- שוחרר

- לסמוך

- שוב ושוב

- משוכפל

- נדרש

- דורש

- נָחוּץ

- מחקר

- חוקר

- חוקרים

- משאבים

- תוצאה

- וכתוצאה מכך

- תוצאות

- לגמול

- עשיר

- בערך

- מסלול

- כללי

- ריצה

- אמר

- אותו

- ראה

- לומר

- מפחד

- מדע

- מדעי

- סיאטל

- שְׁנִיָה

- לִרְאוֹת

- רצף

- שרת

- סט

- סטים

- מיושב

- היא

- קצר

- צריך

- הראה

- דומה

- פָּשׁוּט

- פשוט יותר

- לפשט

- בפשטות

- מידה

- מיומנויות

- שקופיות

- קטן

- קטן יותר

- So

- פִּתָרוֹן

- לפתור

- כמה

- משהו

- בקרוב

- מדבר

- מתמחים

- מיוחד

- ספציפי

- לבלות

- הוצאה

- התפשטות

- תֶקֶן

- כוכב

- החל

- מדינה

- מדינה-of-the-art

- גֶזַע

- שלב

- עוד

- סיפורים

- סיפור

- כוח

- קפדן

- מבנים

- סטודנט

- סטודנטים

- מְחוֹשָׁב

- לימוד

- נושא

- הצלחה

- כזה

- להציע

- מציע

- סוּפֶּר

- הופתע

- מפתיע

- סינטטי

- מערכת

- מערכות

- לקחת

- נטילת

- המשימות

- משימות

- התחברה

- לספר

- אומר לי

- מבחן

- בדיקות

- בדיקות

- טֶקסט

- מֵאֲשֶׁר

- זֶה

- השמיים

- המדינה

- העולם

- שֶׁלָהֶם

- אותם

- עצמם

- אז

- אלה

- הֵם

- דבר

- לחשוב

- זֶה

- אלה

- אם כי?

- אלף

- אלפים

- מאיים

- שְׁלוֹשָׁה

- לשגשג

- זמן

- פִּי

- ל

- של היום

- אמר לי

- גַם

- לקח

- נושא

- נושאים

- לקראת

- לעקוב

- רכבת

- מְאוּמָן

- הדרכה

- ממיר

- באמת

- לנסות

- מנסה

- תור

- לפתול

- שתיים

- בדרך כלל

- לַעֲבוֹר

- להבין

- הבנה

- זָר

- אוניברסיטה

- על

- מְשׁוּמָשׁ

- באמצעות

- שונים

- משתנה

- Vast

- גרסה

- גירסאות

- נגד

- מאוד

- חזון

- רוצה

- רציתי

- היה

- דֶרֶך..

- דרכים

- we

- webp

- שבועות

- טוֹב

- היו

- מתי

- אם

- אשר

- מי

- של מי

- למה

- רָחָב

- טווח רחב

- יצטרך

- עם

- Word

- מילים

- תיק עבודות

- עובד

- עובד

- עוֹלָם

- גרוע יותר

- היה

- לכתוב

- כתב

- שנה

- אתה

- זפירנט