より多くの組織が生成型 AI テクノロジーを採用し、ピッチを作成し、助成金申請を完了し、文書を作成する 定型コード — セキュリティ チームは、AI ツールをどのように保護するかという新たな問題に対処する必要性を認識しています。

Gartner の最近の調査では、回答者の XNUMX 分の XNUMX が次のいずれかを報告しました。 AI ベースのアプリケーション セキュリティ ツールの使用または実装 組織内での生成 AI の使用によってもたらされるリスクに対処するため。

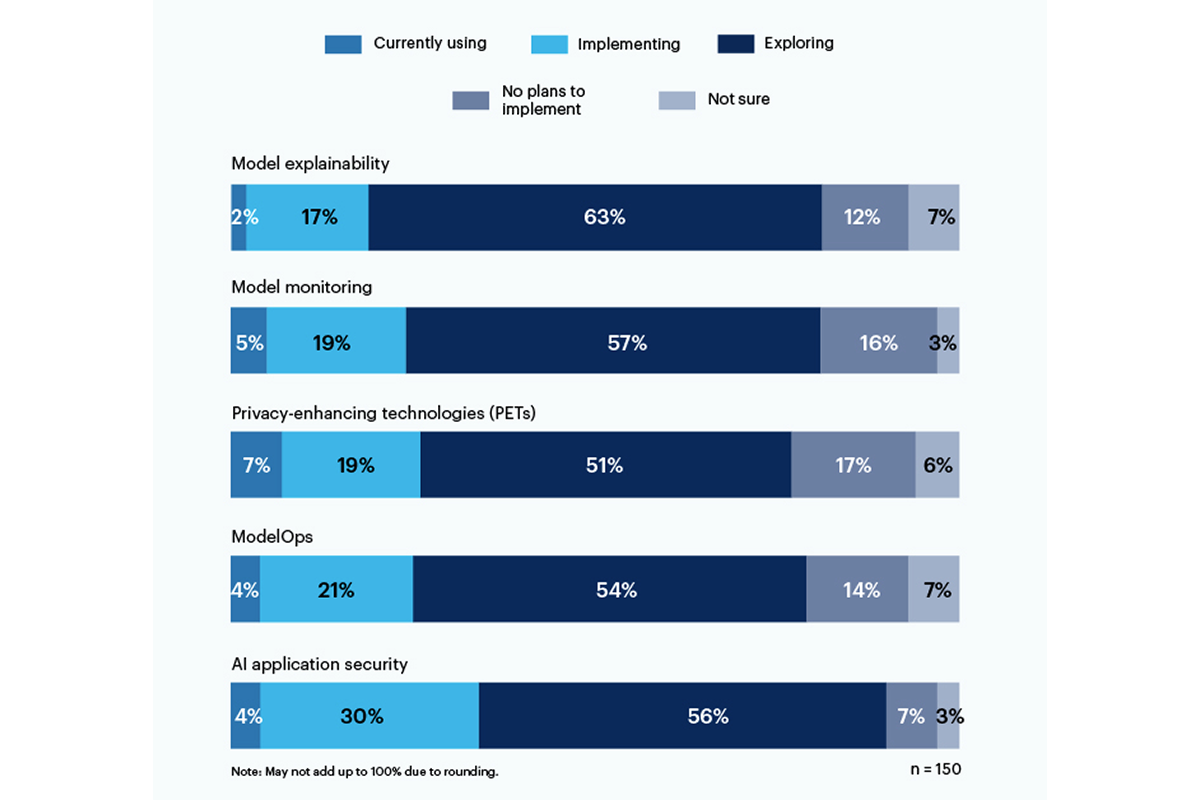

現在、プライバシー強化テクノロジー (PET) が最も多く使用されており、回答者の 7% が使用しており、19% の企業が導入しています。このカテゴリには、次のような個人データを保護する方法が含まれます。 同型暗号, AIが生成した合成データ, 安全なマルチパーティ計算, 連携学習, 差別的なプライバシー。しかし、17% は自分たちの環境に PET を導入する計画を持っていません。

モデルの説明可能性のためのツールを使用または実装しているのは 19% のみですが、回答者の間では、生成的な AI リスクに対処するためにこれらのツールを探索および理解することに大きな関心 (56%) があります。 Gartner によると、説明可能性、モデル監視、AI アプリケーション セキュリティ ツールはすべて、オープンソース モデルまたは独自モデルで使用でき、企業ユーザーが必要とする信頼性と信頼性を実現できます。

回答者が最も懸念しているリスクには、不正確または偏った出力 (58%)、および AI 生成コードの脆弱性または秘密の漏洩 (57%) が含まれます。注目すべきは、43% が、組織に対する最大のリスクとして、AI によって生成されたコンテンツから生じる潜在的な著作権またはライセンス問題を挙げていることです。

「トレーニングに使用されているデータモデルについては依然として透明性がありません。そのため、バイアスやプライバシーに関連するリスクを理解し、推定することは非常に困難です」と、ある経営幹部はガートナーの調査に答えて書いている。

XNUMX月に米国国立標準技術研究所は、 (NIST) が公開ワーキンググループを発足 1 月の AI リスク管理フレームワークに基づいて、その疑問に対処するのに役立ちます。 Gartner のデータが示すように、 企業は待っていない NIST 指令用。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :は

- :not

- 7

- a

- 私たちについて

- 従った

- 達成する

- 住所

- 採用

- AI

- すべて

- 間で

- および

- 申し込み

- アプリケーションセキュリティ

- です

- AS

- 関連する

- At

- ベース

- BE

- バイアス

- 偏った

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- Cスイート

- 缶

- カテゴリー

- 引用された

- コード

- 企業

- コンプリート

- 心配

- コンテンツ

- 著作権

- クラフト

- 電流プローブ

- データ

- 難しい

- ディレクティブ

- do

- どちら

- Enterprise

- 環境

- 推定

- エグゼクティブ

- 探る

- フレームワーク

- から

- ガートナー

- 生々しい

- 生成AI

- 助成金

- 最大

- 持ってる

- 助けます

- 認定条件

- しかしながら

- HTTPS

- 実装

- in

- include

- 含ま

- 機関

- 関心

- 問題

- IT

- ITS

- 1月

- 六月

- 打ち上げ

- ライセンシング

- 管理

- メソッド

- モデル

- モニタリング

- 他には?

- 最も

- の試合に

- 国民

- 必要

- 新作

- ニスト

- いいえ

- of

- on

- 開いた

- オープンソース

- or

- 組織

- 組織

- 個人的な

- 個人データ

- ペット

- ピッチ

- プラン

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 提起

- 潜在的な

- プライバシー

- 所有権

- 守る

- 公共

- 質問

- 実現

- 最近

- 信頼性

- 頼る

- 報告

- 回答者

- 応答

- リスク

- リスク管理

- リスク

- 秘密

- 安全に

- セキュリティ

- 示されました

- 作品

- 重要

- 著しく

- So

- 固体

- ソース

- 規格

- まだ

- そのような

- Survey

- 合成

- チーム

- テクノロジー

- テクノロジー

- それ

- アプリ環境に合わせて

- そこ。

- ボーマン

- この

- 〜へ

- 豊富なツール群

- top

- トレーニング

- 透明性

- 信頼性

- わかる

- 理解する

- つかいます

- 中古

- users

- 非常に

- 脆弱性

- 方法

- ワーキング

- 書きます

- 書いた

- You

- ゼファーネット