AI システムの偏りは、テクノロジーを社会に広く統合するための主要な障害であることが証明されています。 偏見を発見した研究者に報酬を与える新しいイニシアチブ AIシステム 問題の解決に役立つ可能性があります。

この取り組みは、ソフトウェア企業がサイバーセキュリティの専門家に支払うバグ報奨金をモデルにしています。製品に潜在的なセキュリティ上の欠陥がある場合。 このアイデアは新しいものではありません。 「バイアス報奨金」は 最初に提案された Aによって私は 2018 年に研究者で起業家の JB Rubinovitz を務めましたが、さまざまな組織がすでにこのような課題に取り組んでいます。

しかし、この新しい取り組みは、特定の組織から独立した、バイアス報奨金競争のための進行中のフォーラムを作成しようとしています。 ツイッターを含むさまざまな企業のボランティアで構成された、いわゆる「バイアス・バッカニアーズ」は、定期的なコンテスト、つまり「反乱」を開催する計画を立てており、今月初めにそのようなチャレンジを開始しました。

「バグ報奨金は、サイバーセキュリティの標準的な慣行であり、アルゴリズムのバイアス コミュニティに足場をまだ見つけていません。」ナイザー 彼らのウェブサイトで言う. 「最初の XNUMX 回限りのイベントでは報奨金に対する熱意が示されましたが、Bias Buccaneers は、進行中の Mutinies を作成し、テクノロジー企業と協力し、AI システムの透明で再現可能な評価への道を開くことを目的とした最初の非営利団体です。」

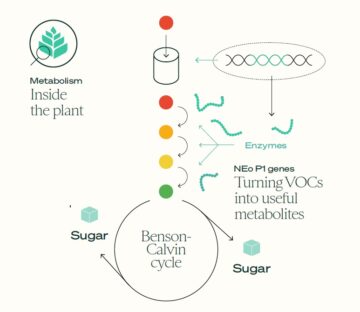

この最初のコンテストは、画像検出アルゴリズムのバイアスに取り組むことを目的としていますが、特定の AI システムをターゲットにするのではなく、 競争 するでしょう偏ったデータセットを検出できるツールを構築するよう研究者に依頼します。 アイデアは、データセット内の各画像に肌の色、認識されている性別、年齢層を正確にラベル付けできる機械学習モデルを作成することです。 コンテストは30月XNUMX日に終了します 一等賞は $6,000、二等賞は $4,000、三等賞は $2,000 です。

この課題は、アルゴリズムの偏りの原因はアルゴリズムそのものではなく、トレーニング対象のデータの性質にあることが多いという事実を前提としています。 コレクションのバランスをすばやく評価できる自動ツール of 画像は、差別の原因となることが多い属性に関連しており、AI 研究者が明らかに偏ったデータソースを回避するのに役立ちます。

しかし、主催者は、これはデータセット、アルゴリズム、およびアプリケーションのバイアスを評価するためのツールキットを構築し、最終的にどのように対処するかの基準を作成する取り組みの最初のステップに過ぎないと述べています。l アルゴリズムのバイアス、公平性、説明可能性。

信じられないほどシンプル そのような努力だけではありません. 新生のリーダーの一人 イニシアチブ Twitter の Rumman Chowdhury は、昨年、最初の AI バイアス報奨金コンペティションの組織化を支援しました。 ユーザーが苦情を言った 黒人や女性よりも肌の白い男性の顔が好まれました。

競争は、ハッカーに会社のモデルへのアクセスを与え、その欠陥を見つけるように挑戦しました。 応募者 幅広い問題を発見、含む典型的な美しい顔を好み、 への嫌悪感 白髪の人(年齢のマーカー)、および ミームの好み アラビア文字ではなく英語で。

スタンフォード大学は最近、商業的に展開された、またはオープンソースの AI システムを差別のために監査するのに役立つように設計されたツールを考え出すようにチームに挑戦するコンテストも終了しました。 また、現在および今後の EU 法により、企業はデータとアルゴリズムを定期的に監査することが義務付けられる可能性があります。

しかし、取る AI バグ報奨金とアルゴリズム監査 主流化し、それらを効果的にすることは、言うは易く行うは難しです。 必然的に、アルゴリズムに基づいてビジネスを構築している企業は、彼らの信用を傷つけようとするあらゆる努力に抵抗するでしょう。

監査システムからの教訓に基づく構築 金融、環境、健康規制など、他の分野の研究者 最近概説した 効果的な説明責任のための重要な要素のいくつか。 最も重要なもののXNUMXつ 基準 彼らは、独立した第三者の有意義な関与であると特定しました。

研究者は、現在の自発的な AI 監査には、対象組織が監査の費用を負担したり、監査の範囲を設定するのを手伝ったり、結果が公表される前に調査結果を確認する機会が与えられたりするなど、利益相反が伴うことが多いと指摘しています。 この懸念は、最近の報告書にも反映されています。 アルゴリズム正義リーグ、chは特大サイズに注意しましたd 現在のサイバーセキュリティ バグ報奨金プログラムにおける対象組織の役割。

真に独立した AI 監査人やバグ ハンターに資金を提供し、支援する方法を見つけることは、特に、世界で最もリソースの豊富な企業と戦うことになるため、大きな課題となるでしょう。 幸いなことに、この問題に取り組むことがユーザーのサービスに対する信頼を維持するために重要であるという認識が業界内で高まっているようです。

画像のクレジット: ジェイコブ・ローゼン / Unsplash