補助付き微調整

昨年 11 月の DevDay で、私たちは 発表の OpenAI 研究者の専任グループと協力して、特定のドメイン向けにモデルをトレーニングおよび最適化するように設計されたカスタム モデル プログラム。それ以来、私たちは数十の顧客と会い、カスタム モデルのニーズを評価し、パフォーマンスをさらに最大化するためにプログラムを進化させてきました。

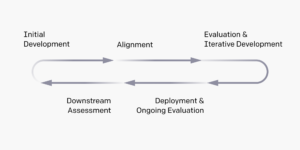

本日、カスタム モデル プログラムの一環として、微調整支援サービスを正式に発表します。補助微調整は、追加のハイパーパラメータや大規模なさまざまなパラメータ効率的微調整 (PEFT) メソッドなど、微調整 API を超えた技術を活用するための当社の技術チームとの共同作業です。これは、ユースケースやタスクのモデルのパフォーマンスを最大化するために、効率的なトレーニング データ パイプライン、評価システム、特注のパラメーターとメソッドのセットアップのサポートを必要とする組織にとって特に役立ちます。

たとえば、 SKテレコム韓国で 30 万人以上の加入者にサービスを提供する電気通信事業者である は、最初は顧客サービスに重点を置き、電気通信分野のエキスパートとなるようにモデルをカスタマイズしたいと考えていました。彼らは OpenAI と協力して GPT-4 を微調整し、韓国語での通信関連の会話におけるパフォーマンスを向上させました。数週間にわたって、SKT と OpenAI は通信カスタマー サービス タスクのパフォーマンスを大幅に向上させました。会話の要約の品質が 35% 向上し、意図認識の精度が 33% 向上し、満足度スコアが 3.6 から 4.5 に向上しました。 5) 微調整モデルを GPT-4 と比較する場合。

カスタムトレーニングされたモデル

場合によっては、組織は、自社のビジネス、業界、ドメインを理解する専用のモデルを一からトレーニングする必要があります。完全にカスタム トレーニングされたモデルは、新しいトレーニング中およびトレーニング後の手法を使用してモデル トレーニング プロセスの主要なステップを変更することにより、特定のドメインから新しい知識を注入します。完全にカスタム トレーニングされたモデルで成功を収めている組織は、多くの場合、大量の独自のデータ (数百万のサンプルまたは数十億のトークン) を保有しており、これらのデータを使用して、モデルに新しい知識や、非常に特殊なユース ケース向けの複雑でユニークな動作を教えたいと考えています。

たとえば、 ハーヴェイ弁護士向けの AI ネイティブ法務ツールであり、OpenAI と提携して、 判例法用にカスタムトレーニングされた大規模な言語モデルを作成する。財団モデルは推論には優れていましたが、訴訟履歴や法律業務に必要なその他の知識に関する広範な知識が不足していました。プロンプト エンジニアリング、RAG、微調整をテストした後、Harvey はチームと協力してモデルに必要なコンテキストの深さを追加しました。これは 10 億トークン相当のデータに相当します。私たちのチームは、ドメイン固有のトレーニング中からトレーニング後のプロセスのカスタマイズ、弁護士の専門家のフィードバックの組み込みに至るまで、モデル トレーニング プロセスのすべてのステップを修正しました。結果として得られたモデルでは、事実に基づく回答が 83% 増加し、弁護士は GPT-97 よりもカスタマイズされたモデルの出力を 4% の確率で好んでいました。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://openai.com/blog/introducing-improvements-to-the-fine-tuning-api-and-expanding-our-custom-models-program

- :は

- $UP

- 10

- 30

- 視聴者の38%が

- a

- 精度

- 達成

- 加えます

- NEW

- 後

- an

- および

- 発表

- API

- です

- AS

- 評価する

- 支援

- At

- 弁護士

- BE

- 行動

- 別注

- 越えて

- 10億

- XNUMX億トークン

- 億

- ビジネス

- by

- 場合

- 例

- 共同

- 比較

- 複雑な

- コンテキスト

- 会話

- 会話

- コース

- カスタム

- 顧客

- 顧客サービス

- Customers

- カスタマイズ

- カスタマイズ

- データ

- 専用の

- 深さ

- 設計

- ドメイン

- 数十

- 効率的な

- 努力

- エンジニアリング

- 同等の

- 評価

- あらゆる

- 進化

- 例

- 例

- 拡大

- エキスパート

- 広範囲

- フィードバック

- フォーカス

- 正式に

- Foundation

- から

- 完全に

- さらに

- グループ

- 持ってる

- 役立つ

- 非常に

- history

- HTML

- HTTPS

- 改善します

- 改善

- 改善

- in

- 組み込む

- 増える

- 産業を変えます

- 初期

- 意図

- 導入

- ITS

- キー

- 知識

- 韓国

- 韓国語

- 言語

- 大

- より大きい

- 姓

- リーガルポリシー

- 活用します

- 最大化します

- 意味のある

- 会った

- メソッド

- 百万

- モデル

- 修正されました

- の試合に

- 必要

- 必要とされる

- ニーズ

- 新作

- 小説

- 11月

- of

- 提供すること

- 頻繁に

- on

- OpenAI

- オペレータ

- 最適化

- or

- 組織

- その他

- 私たちの

- でる

- outputs

- が

- パラメーター

- パラメータ

- 部

- 特に

- 提携

- パートナーシップ

- パフォーマンス

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 優先

- プロセス

- ラボレーション

- 演奏曲目

- 所有権

- 品質

- ぼろ

- 認識

- の提出が必要です

- 研究者

- 回答

- 結果として

- 満足

- 規模

- スコア

- スクラッチ

- サービス

- サービング

- 設定

- から

- SKT

- 一部

- サウス

- 韓国

- 特定の

- 手順

- ステップ

- 強い

- 加入者

- 成功

- そのような

- サポート

- システム

- 仕事

- チーム

- チーム

- 技術的

- テクニック

- 電気通信

- 電気通信

- テスト

- それ

- アプリ環境に合わせて

- その後

- 彼ら

- 時間

- 〜へ

- トークン

- ツール

- トレーニング

- トレーニング

- 理解する

- ユニーク

- つかいます

- 使用事例

- さまざまな

- Ve

- 欲しいです

- wanted

- we

- ウィークス

- した

- いつ

- while

- 仕事

- 働いていました

- 価値

- ゼファーネット