ChatGPT に同じ単語を何度も繰り返させると、個人を特定できる情報や Web から収集したその他のデータを含む大量のトレーニング データが逆流する可能性がありますか?

Google DeepMind、コーネル大学、および他の XNUMX つの大学の研究者チームによると、非常に人気のある生成 AI チャットボットが、特定の方法でプロンプトを出した場合にデータが漏洩しやすいかどうかをテストしたところ、答えは断固としてイエスです。

トリガーワードとしての「詩」

今週のレポートで研究者らは、「詩」、「会社」、「送る」、「作る」、「別れる」などの単語を永遠に繰り返すよう促すだけで、ChatGPT がトレーニング データの記憶された部分を吐き出す方法を説明しました。

たとえば、研究者が ChatGPT に「詩」という単語を永遠に繰り返すよう指示すると、チャットボットは最初、指示どおりにその単語を繰り返すことで応答しました。 しかし、数百回を繰り返すと、ChatGPT は「しばしば無意味な」出力を生成し始めました。その出力には、個人の電子メール署名や個人の連絡先情報などの記憶されたトレーニング データがごく一部含まれていました。

研究者らは、一部の単語が他の単語よりも生成 AI モデルに記憶されたデータを流出させるのに優れていることを発見しました。 たとえば、チャットボットに「会社」という単語を繰り返すように促すと、チャットボットは「知っています」などの他の単語より 164 倍の頻度でトレーニング データを出力しました。

研究者らがこの方法で ChatGPT から抽出できたデータには、数十人の個人に関する個人情報が含まれていました。 露骨なコンテンツ (研究者が NSFW の単語をプロンプトとして使用した場合)。 本や詩の逐語的な段落(プロンプトに「本」または「詩」という単語が含まれている場合)。 URL、一意のユーザー識別子、ビットコイン アドレス、プログラミング コードなどです。

潜在的に大きなプライバシー問題?

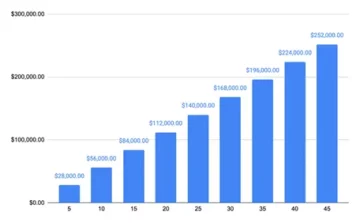

「ChatGPT (gpt-200-turbo) へのわずか 3.5 米ドル相当のクエリを使用して、10,000 を超える固有の逐語的に記憶されたトレーニング サンプルを抽出することができます」と研究者らは「(本番) 言語からのトレーニング データのスケーラブルな抽出」と題した論文で述べています。モデルたち。」

「私たちがより大きな予算を推定したところ、熱心な敵対者がはるかに多くのデータを抽出できる可能性があることが示唆されています」と彼らは書いている。 研究者らは、攻撃者はより多くのクエリを使用して 10 倍のデータを抽出できると推定しています。

Dark Reading が研究でいくつかのプロンプトを使用しようとしたが、研究者がレポートで言及したような出力は生成されませんでした。 ChatGPTの作成者であるOpenAIが、研究者らがXNUMX月下旬に調査結果を同社に開示した後、根本的な問題に対処したためかどうかは不明だ。 OpenAIはDark Readingのコメント要請にすぐには応じなかった。

この新しい研究は、開発者が AI モデルをトレーニングするために、さまざまな (そして多くの場合完全には公開されていない) ソースから収集した大規模なデータセットを使用する開発者のプライバシーへの影響を理解するための最新の試みです。

これまでの研究 ChatGPT などの大規模言語モデル (LLM) は、トレーニング データセット内のパターンやフレーズを誤って逐語的に記憶する可能性があることが示されています。 このような暗記の傾向は、トレーニング データのサイズが大きくなるほど増加します。

研究者らは、そのような記憶されたデータがどのように頻繁に保存されるかを示しました。 発見可能 モデルの出力内。 他の研究者は、敵がいわゆるダイバージェンス攻撃をどのように使用して、 トレーニングデータを抽出する LLMから。 発散攻撃とは、攻撃者が意図的に作成したプロンプトまたは入力を使用して、LLM に通常生成される出力とは大きく異なる出力を生成させる攻撃です。

これらの研究の多くでは、研究者らはトレーニング データセットとアルゴリズムが既知のオープンソース モデルを使用して、データの記憶と漏洩に対する LLM の脆弱性をテストしてきました。 研究には通常、ChatGPT などの AI チャットボットのような方法で動作するように調整されていない基本 AI モデルも含まれています。

ChatGPT に対する発散攻撃

最新の研究は、訓練データやアルゴリズムがほとんど知られていない、洗練された閉鎖型の生成型 AI チャットボットに対してダイバージェンス攻撃がどのように作用するかを示す試みです。 この研究には、研究者らがChatGPTを「アラインメントトレーニングから『脱出』」させ、「基本言語モデルのように動作させ、典型的なインターネットテキストスタイルでテキストを出力」させる方法を開発することが含まれていた。 彼らが発見したプロンプト戦略 (ChatGPT に同じ単語を絶え間なく繰り返させる) はまさにそのような結果を引き起こし、モデルが記憶されたデータを吐き出すという結果になりました。

モデルが生成しているデータが実際にトレーニング データであることを検証するために、研究者らはまず、LLM の最大の 9 つの事前トレーニング データセット (The Pile、RefinedWeb、RedPajama、Dolma) からの約 XNUMX テラバイトのデータを含む補助データセットを構築しました。 次に、ChatGPT からの出力データを補助データセットと比較し、多数の一致を見つけました。

研究者らは、プロンプトの出力を 9 テラバイトの補助データセットとのみ比較していたため、ChatGPT でのデータ記憶の範囲を過小評価している可能性が高いと考えました。 そこで彼らは、プロンプトから ChatGPT の出力の約 494 個を取得し、Google で逐語的に一致するものを手動で検索しました。 この演習では 150 件の完全一致が得られましたが、補助データセットではわずか 70 件でした。

研究者らは、「手動検索分析では、(比較的小規模な)補助データセットで検出されたモデル出力のほぼ XNUMX 倍のモデル出力が記憶されていることが検出されました」と述べています。 「私たちの論文は、過去数年間で最高の言語モデルから簡単な手法でトレーニング データを簡単に抽出できることを示唆しています。」

研究者らが報告書で説明した攻撃はChatGPTに特有のものであり、他のLLMに対しては機能しない。 しかし、この文書は「プライバシーに敏感なアプリケーションに対して、極度の安全策を講じずに LLM をトレーニングおよび導入すべきではないことを実務家に警告する」のに役立つはずだと彼らは指摘している。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.darkreading.com/cyber-risk/researchers-simple-technique-extract-chatgpt-training-data

- :持っている

- :は

- :not

- :どこ

- 000

- 10

- 150

- 7

- 70

- 9

- a

- できる

- 従った

- 対処する

- アドレス

- 後

- 再び

- に対して

- AI

- AIチャットボット

- AIモデル

- アルゴリズム

- 整列した

- アラインメント

- また

- 金額

- an

- 分析

- および

- 回答

- どれか

- です

- AS

- At

- 攻撃

- 攻撃

- 試み

- 試み

- 8月

- ベース

- BE

- なぜなら

- き

- 始まった

- BEST

- より良いです

- ビッグ

- Bitcoin

- 本

- 本

- 予算

- 内蔵

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 缶

- 原因となる

- 生じました

- チャットボット

- AI言語モデルを活用してコードのデバッグからデータの異常検出まで、

- 閉まっている

- コード

- コメント

- 会社

- 比較的

- 比べ

- 比較

- 接触

- 含まれている

- コンテンツ

- コーネル

- 可能性

- 細工された

- クリエイター

- 暗いです

- 暗い読書

- データ

- データセット

- 専用の

- ディープマインド

- 展開します

- 記載された

- 検出

- 検出された

- 開発者

- 開発

- DID

- 異なります

- 発見

- ディヴァージュ

- 発散

- ありません

- 数十

- 簡単に

- 脱出

- 推定

- 例

- 例

- 運動

- エクステント

- エキス

- 抽出

- 極端な

- 遠く

- 少数の

- 考え出した

- 調査結果

- 名

- に前進

- 発見

- 4

- 分数

- から

- 完全に

- 生成する

- 生成

- 生々しい

- 生成AI

- 取得する

- 受け

- でログイン

- だ

- ハッキング

- 持ってる

- 助けます

- 認定条件

- HTTPS

- すごく

- 百

- 識別子

- if

- 直ちに

- 意義

- in

- うっかり

- 絶え間なく

- 含まれました

- 含めて

- 増加

- 確かに

- 個人

- 個人

- 情報

- 当初

- 入力

- 故意に

- 関係する

- 問題

- 問題

- IT

- ITS

- JPG

- ただ

- 知っている

- 既知の

- 言語

- 大

- より大きい

- 最大の

- 遅く

- 最新の

- リーク

- ような

- 可能性が高い

- LLM

- make

- 方法

- マニュアル

- 手動で

- 多くの

- 大規模な

- マッチ

- 言及した

- 単に

- モデル

- 他には?

- 主に

- ほぼ

- 新作

- 注意

- NSFW

- 多数の

- of

- 頻繁に

- on

- ONE

- の

- 開いた

- オープンソース

- OpenAI

- 操作する

- or

- その他

- その他

- 私たちの

- でる

- 結果

- 出力

- outputs

- が

- 紙素材

- 部

- 過去

- パターン

- 個人的な

- 個人的に

- フレーズ

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 人気

- :

- 正確に

- プライバシー

- 作り出す

- 生産

- プログラミング

- プロンプト

- クエリ

- リーディング

- 残る

- 繰り返す

- レポート

- 要求

- 研究

- 研究者

- 反応します

- 結果として

- s

- 保障措置

- 同じ

- ド電源のデ

- を検索

- 送信

- すべき

- 表示する

- 示す

- 署名

- 著しく

- 簡単な拡張で

- サイズ

- 小さい

- So

- 一部

- 洗練された

- ソース

- ソース

- 特定の

- 戦略

- 研究

- 勉強

- そのような

- 提案する

- 感受性

- チーム

- 技術

- テクニック

- test

- テスト

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- より

- それ

- アプリ環境に合わせて

- その後

- ボーマン

- 彼ら

- この

- 介して

- <font style="vertical-align: inherit;">回数</font>

- タイトル

- 〜へ

- 取った

- トレーニング

- トレーニング

- トリガー

- Twice

- 典型的な

- 一般的に

- 根本的な

- わかる

- ユニーク

- 大学

- 大学

- 未知の

- USD

- つかいます

- 中古

- ユーザー

- 使用されます

- 確認する

- ました

- 仕方..

- we

- ウェブ

- した

- この試験は

- いつ

- which

- 誰

- その

- 無し

- Word

- 言葉

- 仕事

- 価値

- でしょう

- 書いた

- 年

- はい

- 得られた

- ゼファーネット