ChatGPTやGeminiなどの生成AIモデルを駆動する先進的な半導体の製造競争が激化する中、GoogleとIntelは火曜日、Nvidiaに対抗する独自のAIチップを発売した。

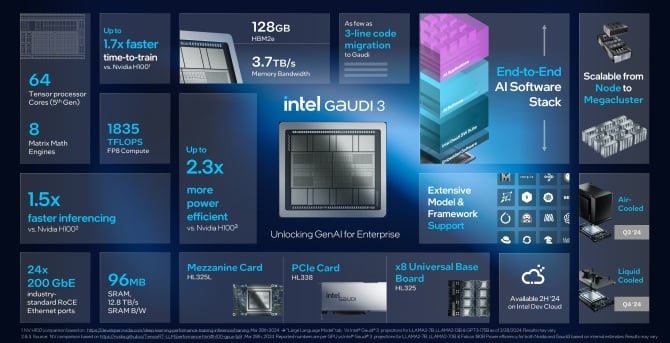

でログイン Cloud TPU v5p をリリースし、Intel は Gaudi 3 AI プロセッサを発表しました。このチップは、AI システムのトレーニングと「完成したソフトウェアの実行」のパフォーマンスを向上させるように設計されています。

また、お読みください。 台湾地震で主要AIチップハブが混乱、世界供給が脅かされる

LLM のトレーニングをより迅速に行う

Googleは5月にGeminiとともに新しいTPU(テンソル処理ユニット)を初めて発表した。現在開発者が利用できるTPU vXNUMXpは、これまでで最も「強力でスケーラブルな」AIプロセッサであると同社は述べた。

同社は、アップデートされたチップが、AI チャットボットの背後にあるテクノロジーである大規模言語モデル (LLM) をトレーニングできると主張しています。 双子座 および AI言語モデルを活用してコードのデバッグからデータの異常検出まで、、以前の Google TPU v4 よりも 12 倍高速です。 AIチップは旧バージョンに比べてXNUMX倍のスループットを実現したという。

Google CEOのサンダー・ピチャイ氏はラスベガスで開催された社内イベントで、「(GoogleのTPUの)こうした進歩は第5世代となり、顧客が最先端の言語モデルをトレーニングし提供するのに役立っている」と述べた。 従った 業界メディアへ。

[埋め込まれたコンテンツ]

目的は、グラフィックス・プロセッシング・ユニット(GPU)として知られるAIチップの最大90%を供給する米国企業Nvidiaに挑戦することだが、Googleは依然としてNvidiaに依存していることを示した。

同じで ブログ投稿 最新のTPUを発表したGoogleは、A3スーパーコンピュータをアップグレードしていると発表した。 NVIDIA H100 グラフィックス処理ユニット。同社はまた、Nvidia の最新 GPU を使用していることも明らかにしました。 ブラックウェル、AI ハイパーコンピューター内。

Googleはまた、英国企業Armの技術を使用して構築されたデータセンター向けの新しいカスタム中央処理装置(CPU)であるAxionをリリースした。 Microsoft、Amazon、MetaのCPUに匹敵するAxionは、Google検索やAI操作などさまざまなタスクを処理できると同社は述べている。

Google によると、Axion は「今日クラウドで利用できる最速の汎用 Arm ベースのインスタンスよりも 30% 優れたパフォーマンス」を実現し、他の汎用 Arm よりも「最大 50% 優れたパフォーマンスと最大 60% 優れたエネルギー効率」を提供します。チップス。

インテル: どこでも AI

火曜日、Intel はまた、人工知能プロセッサの新バージョンである Gaudi 3 の発売を発表しました。同社によると、Gaudi 3 チップは Nvidia の H100 GPU の XNUMX 倍以上の電力効率があり、AI モデルを完全に実行できるとのことです。半分の速度になります。

「イノベーションは前例のないペースで進歩しており、すべてはシリコンによって実現されており、あらゆる企業が急速に AI 企業になりつつあります」と Intel CEO のパット・ゲルシンガー氏は記事で述べています。 ステートメント。 「インテルは、PC からデータセンター、エッジに至るまで、企業全体のあらゆる場所に AI を導入しています。

🔎

_🔥🔥🔥_

****🤖****— ムンディア ブライアン (@Mundia_Brian_) 2024 年 4 月 9 日

ゲルシンガー氏はGaudi 3の価格については明言しなかった、ブルームバーグ レポートしかし、同氏の会社のいわゆるアクセラレータチップは、Nvidiaの現在および将来のチップのコストを「大幅に下回る」だろうと述べた。これらは「非常に優れた」総所有コストをもたらすだろうと同氏は付け加えた。

Intel は、自社の最新チップが生成 AI に取り組む企業の AI トレーニングと推論において「大きな飛躍」をもたらすと主張しています。 AI システムをトレーニングする企業は、AI システムが実際の質問に応じて予測を行えるようにする必要があります。これは推論として知られています。

Intel によると、Gaudi 3 は、H100 や、Meta の Llama やアブダビの多言語 Falcon などの GPU を使用してトレーニングされたすべての大規模言語モデルよりも高速で電力効率が高いとのことです。このチップは、OpenAIのStable DiffusionやWhisperなどの音声認識モデルのトレーニングに役立つという。

同社によれば、この種のトレーニングでは、Gaudi 3 はソフトウェアの実行速度が 1.7 倍速く、ソフトウェアの実行能力が 1.5 倍優れているという。 Intelによれば、このAIチップの性能はNvidiaの新しいB200に匹敵し、ある分野では優れているが、他の分野では劣っているという。

Intelは、新しいGaudi 3チップは第XNUMX四半期に顧客に提供される予定で、Supermicro、Dell、HPなどの企業がAIアクセラレータを搭載したシステムを構築すると述べた。

Nvidiaへの挑戦

生成 AI システムを構築している企業は、高価な Nvidia の GPU への依存をやめてコストを削減しようとしています。

ソフトウェアエンジニアのジェームス・ハミルトン氏によると、アマゾンは2023年に65回のトレーニング実行に約1万ドルを費やしたという。同氏は、その額が間もなくXNUMX億ドルを超えると予想している。

1 週間前、OpenAI とマイクロソフト 明らかになった は、「スターゲート」と呼ばれる AI トレーニング用の 100 億ドルのデータセンターを建設する計画です。そして9月、Metaの最高経営責任者(CEO)Mark Zuckerberg氏は、同社がNvidia GPUだけでXNUMX億ドルを費やす計画だと述べた。

すべての大手ハイテク企業は Nvidia からチップを購入していますが、自社でチップを製造したり、昨年 MI300X と呼ばれる新しいデータセンター GPU を導入した AMD から購入したりすることも始めています。 AMDは今年、さらに多くの人工知能チップをサーバー向けに拡大し、販売する予定だ。

Googleの競合企業であるMicrosoft、Meta(ともにAMDの顧客)、Amazonも独自のAIチップを開発している。しかし、それは簡単ではありません。今年初め、Nvidia は H100 の後継となる B200 GPU と B100 GPU をリリースし、パフォーマンスの向上を約束しました。チップの出荷は2024年後半に開始される予定だ。

AI ブームと H100 のおかげで倍増 Nvidiaの収益 そして市場評価額を2兆ドル以上に引き上げ、ウォール街で最も成功した企業のXNUMXつとなった。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://metanews.com/google-and-intel-launch-own-ai-chips-as-nvidia-rivalry-heats-up/

- :は

- :not

- 2022年の174億4000万ドル

- 65万ドル

- $ 9億

- $UP

- 1

- 12

- 2023

- 2024

- 7

- 800

- 9

- a

- できる

- 加速器

- 従った

- 越えて

- 追加されました

- 高度な

- 進歩

- 前進

- 前

- AI

- AIモデル

- AIシステム

- AIトレーニング

- 目指す

- すべて

- 一人で

- 並んで

- また

- Amazon

- AMD

- an

- および

- 発表の

- 発表

- です

- エリア

- ARM

- 周りに

- 人工の

- 人工知能

- AS

- At

- 利用できます

- BE

- になる

- 背後に

- 舞台裏で

- より良いです

- 10億

- ブルームバーグ

- ブーム

- ブースト

- 両言語で

- ブライアン

- 持って来る

- 持参

- ビルド

- 建物

- 内蔵

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- 購入

- by

- 呼ばれます

- 缶

- センター

- センター

- 中央の

- 最高経営責任者(CEO)

- 挑戦する

- チャットボット

- AI言語モデルを活用してコードのデバッグからデータの異常検出まで、

- チップ

- チップ

- クレーム

- クラウド

- 企業

- 会社

- 会社の

- 匹敵します

- 競合他社

- コンテンツ

- 費用

- コスト

- 電流プローブ

- カスタム

- Customers

- 切断

- データ

- データセンター

- データセンター

- データセンター

- 12月

- 配信する

- 提供します

- デル

- 依存

- 設計

- 発展した

- 開発者

- DID

- 混乱させる

- ダウン

- ダビングされた

- 前

- 簡単に

- エッジ(Edge)

- 埋め込まれた

- 使用可能

- エンジニア

- Enterprise

- エンティティ

- イベント

- あらゆる

- 詳細

- 予想される

- 期待する

- 高価な

- 速いです

- 最速

- フィギュア

- 会社

- 企業

- 名

- から

- 未来

- 利益

- 双子座

- 一般的用途

- 世代

- 生々しい

- 生成AI

- グローバル

- 行く

- でログイン

- Googleクラウド

- Googleの

- GPU

- GPU

- グラフィック

- ハミルトン

- ハンドル

- 持ってる

- he

- 助けます

- 助けました

- ハイ

- 彼の

- 認定条件

- しかしながら

- HTTPS

- ハブ

- in

- 含めて

- 産業を変えます

- インテル

- インテリジェンス

- 強化する

- 導入

- IT

- ITS

- ジェームズ

- 1月

- JPG

- ただ

- 既知の

- 言語

- 大

- LAS

- ラスベガス

- 姓

- 昨年

- 後で

- 最新の

- 起動する

- 打ち上げ

- ような

- ラマ

- 探して

- たくさん

- 主要な

- make

- 作成

- マーク

- マーク・ザッカーバーグ

- 市場

- 最大幅

- メディア

- Meta

- Microsoft

- 百万

- モデル

- 他には?

- 最も

- ずっと

- 必要

- 新作

- 今

- Nvidia

- of

- 提供

- 古い

- on

- ONE

- OpenAI

- 業務執行統括

- or

- その他

- その他

- が

- 自分の

- 所有権

- 平和

- PC

- パフォーマンス

- プラン

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 電力

- パワード

- 前任者

- 予測

- 処理

- プロセッサ

- 有望

- は、大阪で

- 目的

- 地震

- 四半期

- 質問

- すぐに

- レース

- リーチ

- 読む

- リアル

- 認識

- リリース

- 信頼

- 応答

- 明らかに

- 競争

- ライバル

- ラン

- ランニング

- 前記

- 同じ

- 言う

- シーン

- 検索

- 売る

- 半導体関連装置

- 役立つ

- サーバー

- 発送

- 示されました

- 重要

- シリコン

- ソフトウェア

- ソフトウェアエンジニア

- 一部

- すぐに

- スピーチ

- 音声認識

- 過ごす

- 費やした

- 安定した

- start

- 開始

- 都道府県

- まだ

- ストリート

- 成功した

- そのような

- サンダーピチャイ

- スーパーコンピュータ

- 用品

- システム

- タスク

- テク

- テクノロジー

- より

- それ

- アプリ環境に合わせて

- それら

- 自分自身

- ボーマン

- 彼ら

- 三番

- この

- 今年

- 三

- スループット

- <font style="vertical-align: inherit;">回数</font>

- 〜へ

- トータル

- トレーニング

- 訓練された

- トレーニング

- トレーニング

- 1兆

- true

- 火曜日

- Twice

- type

- Uk

- 単位

- ユニット

- 前例のない

- 発表

- 更新しました

- us

- 評価

- さまざまな

- VEGAS

- バージョン

- 壁

- ウォール街

- 週間

- WELL

- which

- ウィスパー

- 意志

- ワーキング

- でしょう

- 年

- まだ

- ユーチューブ

- ゼファーネット

- ザッカーバーグ