不正行為は、e コマース、ソーシャル メディア、金融サービスなど、多くの業界に深刻な影響を与えています。 詐欺は、企業や消費者に重大な損失をもたらす可能性があります。 アメリカの消費者は、5.8 年に詐欺で 2021 億ドル以上を失ったと報告しており、70 年に比べて 2020% 以上増加しています。. ルールベースのフィルター、異常検出、機械学習 (ML) モデルなど、詐欺師を検出するために多くの手法が使用されてきました。

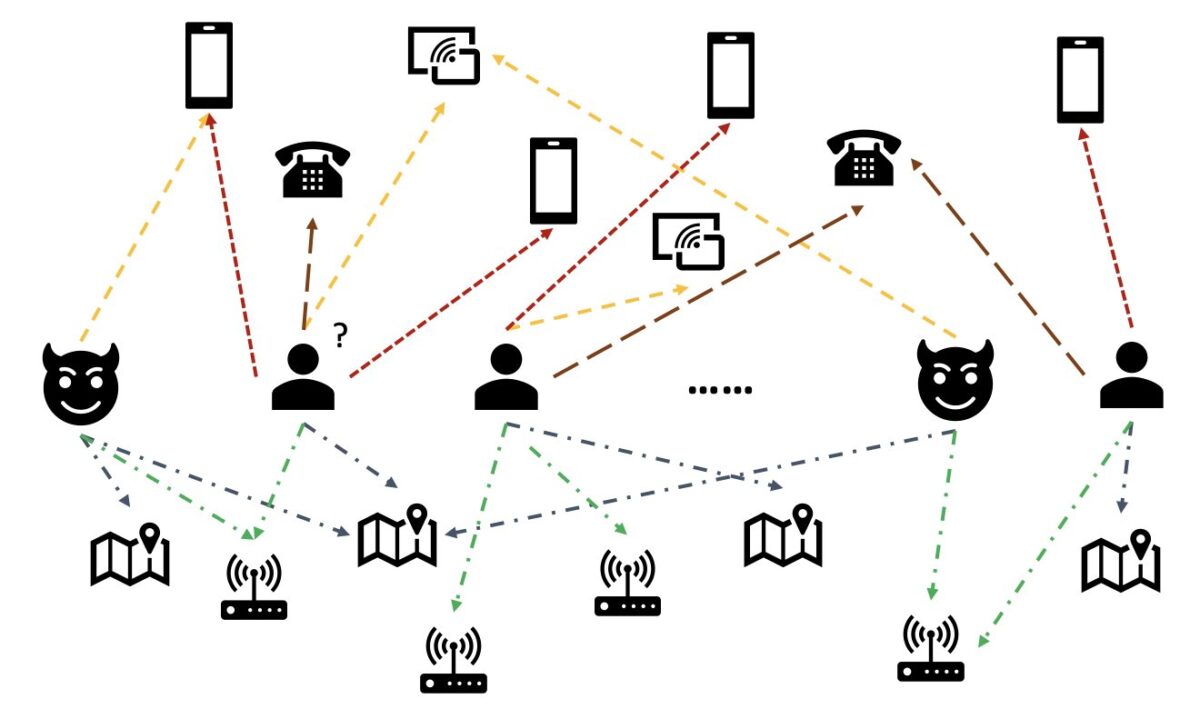

実世界のデータでは、エンティティは多くの場合、他のエンティティとの豊富な関係を伴います。 このようなグラフ構造は、異常検出のための貴重な情報を提供できます。 たとえば、次の図では、ユーザーは Wi-Fi ID、物理的な場所、電話番号などの共有エンティティを介して接続されています。 電話番号など、これらのエンティティには多数の一意の値があるため、従来の機能ベースのモデルでそれらを使用することは困難です。たとえば、すべての電話番号をワンホット エンコードすることは現実的ではありません。 しかし、そのような関係は、ユーザーが詐欺師であるかどうかを予測するのに役立ちます。 ユーザーが既知の詐欺師と複数のエンティティを共有している場合、そのユーザーは詐欺師である可能性が高くなります。

最近では、グラフ ニューラル ネットワーク (GNN) が不正検出の一般的な方法になっています。 GNN モデルは、グラフ構造とノードまたはエッジ (ユーザーやトランザクションなど) の属性の両方を組み合わせて、意味のある表現を学習し、悪意のあるユーザーやイベントを正当なものから区別することができます。 この機能は、詐欺師が共謀して異常な特徴を隠し、関係の痕跡を残す詐欺を検出するために重要です。

現在の GNN ソリューションは、主にオフラインのバッチ トレーニングと推論モードに依存しており、悪意のあるイベントが発生して損失が発生した後に詐欺師を検出します。 ただし、不正なユーザーや不正行為をリアルタイムで把握することは、損失を防ぐために非常に重要です。 これは特に、不正行為を防止する機会が XNUMX 回しかないビジネス ケースに当てはまります。 たとえば、一部の電子商取引プラットフォームでは、アカウント登録が広く開かれています。 詐欺師は、XNUMX つのアカウントで一度だけ悪意を持って行動することができ、同じアカウントを二度と使用することはありません。

リアルタイムで詐欺師を予測することは重要です。 ただし、このようなソリューションを構築するのは困難です。 GNN は業界ではまだ新しいため、GNN モデルをバッチ サービングからリアルタイム サービングに変換するためのオンライン リソースは限られています。 さらに、着信イベントを GNN リアルタイム サービング API にフィードできるストリーミング データ パイプラインを構築するのは困難です。 著者の知る限り、この記事の執筆時点では、GNN ベースのリアルタイム推論ソリューションに使用できる参照アーキテクチャと例はありません。

開発者が GNN をリアルタイムの不正検出に適用できるようにするために、この投稿では使用方法を示します。 アマゾン海王星, アマゾンセージメーカー、 そしてその ディープグラフライブラリ(DGL)、他の AWS サービスの中でも、GNN モデルを使用したリアルタイムの不正検出のためのエンドツーエンドのソリューションを構築します。

次の XNUMX つのタスクに重点を置いています。

- 表形式のトランザクション データセットを異種グラフ データセットに処理する

- SageMaker を使用して GNN モデルをトレーニングする

- トレーニング済み GNN モデルを SageMaker エンドポイントとしてデプロイする

- 着信トランザクションのリアルタイム推論のデモンストレーション

この投稿は、以前の作業を拡張します Amazon SageMakerとDeep Graph Libraryを使用して異種ネットワークの不正を検出する、最初の XNUMX つのタスクに焦点を当てています。 異種グラフ、GNN、および GNN の半教師付きトレーニングの詳細については、その投稿を参照してください。

不正検出のための完全マネージド型の AWS AI サービスを探している企業も使用できます アマゾン詐欺検出器。これにより、偽のアカウントの作成やオンライン決済詐欺など、詐欺の可能性があるオンライン活動を簡単に特定できます。

ソリューションの概要

このソリューションには、XNUMX つの主要部分が含まれています。

最初の部分は、データを処理し、GNN モデルをトレーニングし、トレーニング済みのモデルをデプロイするパイプラインです。 それは使用しています AWSグルー トランザクションデータを処理し、処理されたデータを両方に保存します アマゾン海王星 および Amazon シンプル ストレージ サービス (アマゾン S3)。 次に、SageMaker トレーニングジョブがトリガーされ、Amazon S3 に保存されたデータで GNN モデルをトレーニングして、トランザクションが不正かどうかを予測します。 トレーニングされたモデルは、トレーニング ジョブの完了時に、他のアセットとともに Amazon S3 に保存されます。 最後に、保存されたモデルが SageMaker エンドポイントとしてデプロイされます。 パイプラインは AWSステップ関数、次の図に示すように。

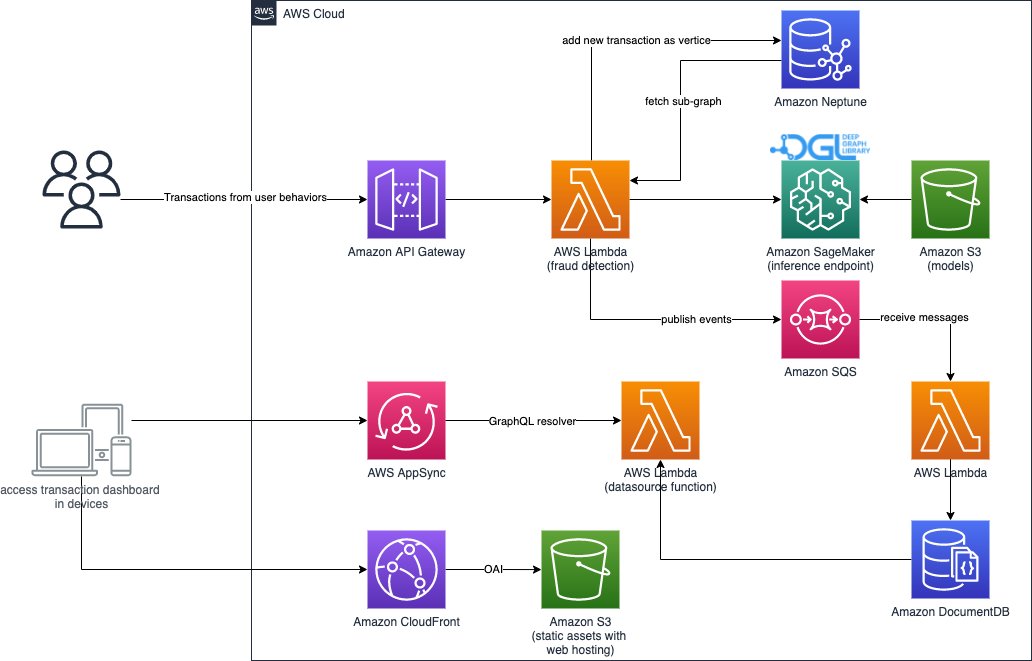

ソリューションの XNUMX 番目の部分は、リアルタイムの不正取引検出を実装します。 これは、Neptune のグラフ データベースにクエリを実行して受信トランザクションに関連するサブグラフを抽出する RESTful API から始まります。 また、ビジネス アクティビティをシミュレートできる Web ポータルもあり、不正なトランザクションと正当なトランザクションの両方でオンライン トランザクションを生成します。 Web ポータルは、不正検出のライブ視覚化を提供します。 この部分は使用します アマゾンCloudFrontの, AWS 増幅, AWS アプリ同期, アマゾンAPIゲートウェイ、ステップ関数、および アマゾンドキュメントDB Web アプリケーションを迅速に構築します。 次の図は、リアルタイムの推論プロセスと Web ポータルを示しています。

このソリューションの実装は、 AWS CloudFormation AWS アカウントでアーキテクチャを起動できるテンプレートは、次の方法で公開されています。 GitHubレポ.

データ処理

このセクションでは、サンプル データセットを処理し、それを生のテーブルから、異なる列間で特定された関係を持つグラフに変換する方法について簡単に説明します。

このソリューションでは、同じデータセットを使用します。 IEEE-CIS不正データセット、前回の投稿の通り Amazon SageMakerとDeep Graph Libraryを使用して異種ネットワークの不正を検出する. したがって、データ処理の基本原理は同じです。 簡単に言うと、不正データセットにはトランザクション テーブルと ID テーブルが含まれており、約 500,000 件の匿名化されたトランザクション レコードとコンテキスト情報 (トランザクションで使用されたデバイスなど) が含まれています。 一部のトランザクションには、トランザクションが不正かどうかを示すバイナリ ラベルが付いています。 私たちのタスクは、ラベルのないトランザクションのうち、どれが不正でどれが正当なものかを予測することです。

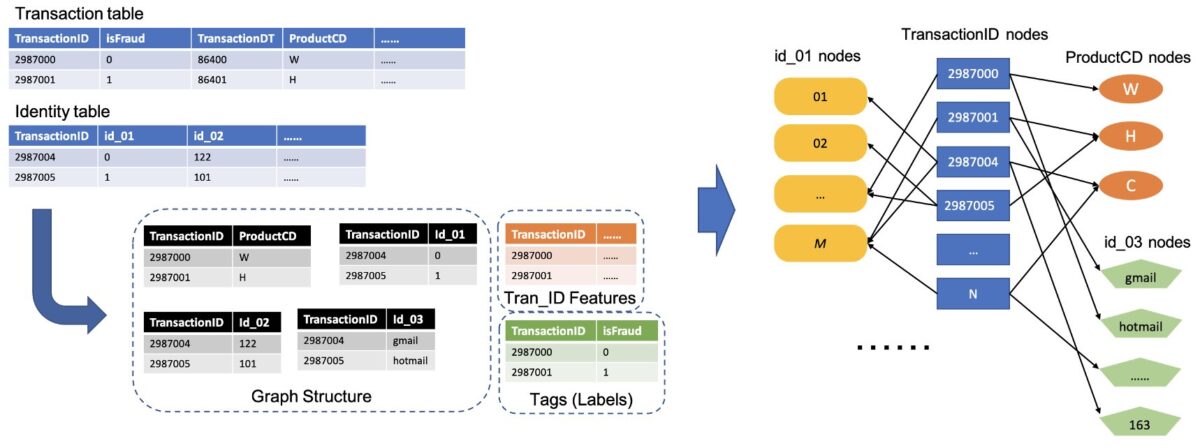

次の図は、IEEE テーブルを異種グラフに変換する一般的なプロセスを示しています。 まず、各テーブルから 03 つの列を抽出します。 XNUMX つの列は常にトランザクション ID 列であり、一意の各 TransactionID を XNUMX つのノードとして設定します。 ProductCD 列や id_XNUMX 列などのカテゴリ列から別の列が選択され、各一意のカテゴリがノードとして設定されます。 TransactionID と一意のカテゴリが同じ行に表示される場合、それらを XNUMX つのエッジで接続します。 このようにして、テーブル内の XNUMX つの列を XNUMX つの XNUMX 列に変換します。 次に、それらの二部構成を TransactionID ノードと組み合わせます。ここで、同じ TransactionID ノードが XNUMX つの一意のノードにマージされます。 このステップの後、二部構成から構築された異種グラフが得られます。

グラフの作成に使用されない残りの列については、TransactionID ノードの機能として結合します。 isFraud 値を持つ TransactionID 値は、モデル トレーニングのラベルとして使用されます。 この異種グラフに基づいて、タスクは TransactionID ノードのノード分類タスクになります。 GNN をトレーニングするためのグラフ データの準備の詳細については、 特徴抽出 および グラフの作成 以前のブログ投稿のセクション。

このソリューションで使用されるコードは、 src/scripts/glue-etl.py. Jupyter ノートブックを使用してデータ処理を試すこともできます src/sagemaker/01.FD_SL_Process_IEEE-CIS_Dataset.ipynb.

前回の記事で行ったようにデータを手動で処理する代わりに、このソリューションでは、Apache Spark を介して膨大なデータセットを並行して処理することをサポートする Step Functions と AWS Glue によって調整された完全に自動化されたパイプラインを使用します。 Step Functions ワークフローは、 AWSクラウド開発キット (AWS CDK)。 以下は コードスニペット このワークフローを作成するには:

このワークフローは、GNN モデルトレーニング用のグラフデータを構築するだけでなく、グラフデータを Neptune にバッチロードして、後でリアルタイムの推論を実行します。 このバッチ データ ロード プロセス 次のコード スニペットに示されています。

GNNモデルのトレーニング

モデル トレーニング用のグラフ データが Amazon S3 に保存された後、 SageMakerトレーニングジョブは、トレーニング ジョブの実行中にのみ課金され、Bring Your Own Container (BYOC) モードで GNN モデル トレーニング プロセスを開始するためにトリガーされます。 モデルのトレーニング スクリプトと依存関係を Docker イメージにパックし、それを使用して SageMaker トレーニング インスタンスを作成できます。 BYOC 方式を使用すると、トレーニング環境をセットアップする際の労力を大幅に節約できます。 の src/sagemaker/02.FD_SL_Build_Training_Container_Test_Local.ipynbでは、GNN モデル トレーニングの詳細を確認できます。

Dockerイメージ

Jupyter ノートブック ファイルの最初の部分は、トレーニング用の Docker イメージの生成です (次のコード スニペットを参照)。

モデルのトレーニングには PyTorch ベースのイメージを使用しました。 Docker イメージのビルド時に、Deep Graph Library (DGL) とその他の依存関係がインストールされます。 の GNN モデル コード src/sagemaker/FD_SL_DGL/gnn_fraud_detection_dgl フォルダもイメージにコピーされます。

トランザクション データを異種グラフに処理するため、このソリューションでは、 リレーショナルグラフ畳み込みネットワーク (RGCN) モデル。異種グラフ用に特別に設計されています。 私たちの RGCN モデルは、異種グラフのノードの学習可能な埋め込みをトレーニングできます。 次に、学習された埋め込みは、ノード ラベルを予測するための全結合層の入力として使用されます。

ハイパーパラメータ

GNN をトレーニングするには、トレーニング プロセスの前に、構築されたグラフのファイル名、GNN モデルのレイヤー数、トレーニング エポック、オプティマイザー、最適化パラメーターなど、いくつかのハイパーパラメーターを定義する必要があります。 構成のサブセットについては、次のコードを参照してください。

すべてのハイパーパラメータとそのデフォルト値の詳細については、次を参照してください。 estimator_fns.py セクションに src/sagemaker/FD_SL_DGL/gnn_fraud_detection_dgl フォルダにコピーします。

SageMaker を使用したモデルのトレーニング

カスタマイズされたコンテナー Docker イメージがビルドされたら、前処理されたデータを使用して、定義したハイパーパラメーターで GNN モデルをトレーニングします。 トレーニング ジョブは、バックエンドのディープ ラーニング フレームワークとして PyTorch とともに DGL を使用して、GNN を構築およびトレーニングします。 SageMaker では、カスタマイズされた Docker イメージ (SageMaker estimator の入力引数) を使用して GNN モデルを簡単にトレーニングできます。 SageMaker で DGL を使用して GNN をトレーニングする方法の詳細については、次を参照してください。 ディープグラフネットワークのトレーニング.

SageMaker Python SDK は使用します 推定量 SageMaker 互換のカスタム Docker コンテナを実行する SageMaker でのトレーニングをカプセル化し、SageMaker Python SDK を使用して独自の ML アルゴリズムを実行できるようにします。 次のコード スニペットは、(ローカル環境またはクラウド インスタンスのいずれかで) SageMaker を使用してモデルをトレーニングする方法を示しています。

トレーニング後、テスト セットでの GNN モデルのパフォーマンスが次の出力のように表示されます。 RGCN モデルは通常、約 0.87 AUC と 95% 以上の精度を達成できます。 RGCN モデルと他の ML モデルの比較については、 結果 詳細については、以前のブログ投稿のセクションを参照してください。

モデルのトレーニングが完了すると、SageMaker はトレーニング済みのモデルを、トレーニング済みのノードの埋め込みを含む他のアセットと一緒に ZIP ファイルにパックし、指定された S3 の場所にアップロードします。 次に、リアルタイムの不正検出のためのトレーニング済みモデルの展開について説明します。

GNN モデルの展開

SageMaker を使用すると、トレーニング済み ML モデルのデプロイが簡単になります。 この段階では、SageMaker PyTorchModel クラスを使用してトレーニング済みモデルをデプロイします。これは、DGL モデルがバックエンド フレームワークとして PyTorch に依存しているためです。 展開コードは src/sagemaker/03.FD_SL_Endpoint_Deployment.ipynb ファイルにソフトウェアを指定する必要があります。

トレーニング済みのモデル ファイルとアセットに加えて、SageMaker には、カスタマイズされたモデルをデプロイするためのエントリ ポイント ファイルが必要です。 エントリ ポイント ファイルは、推論リクエストに応答するために実行され、推論エンドポイント インスタンスのメモリに格納されます。 この場合、エントリ ポイント ファイルは fd_sl_deployment_entry_point.py 内のファイル src/sagemaker/FD_SL_DGL/code 次の XNUMX つの主要な機能を実行します。

- リクエストを受信し、リクエストの内容を解析して、予測されるノードとそれに関連するデータを取得します

- データを RGCN モデルの入力として DGL 異種グラフに変換します

- トレーニング済みの RGCN モデルを介してリアルタイムの推論を実行する

- 予測結果をリクエスタに返す

SageMaker の規則に従い、最初の XNUMX つの関数は input_fn 方法。 次のコードを参照してください (簡単にするために、一部のコメント コードを削除しています)。

構築された DGL グラフと機能は、 predict_fn 第三の機能を満たす方法。 predict_fn XNUMX つの入力引数を取ります: の出力 input_fn そして訓練されたモデル。 次のコードを参照してください。

で使用されたモデル perdict_fn によって作成されます model_fn エンドポイントが初めて呼び出されたときのメソッド。 関数 model_fn 保存されたモデル ファイルと関連するアセットを model_dir 引数と SageMaker モデルフォルダー。 次のコードを参照してください。

の出力 predict_fn method は、クラス 0 とクラス 1 のロジットを示す 0 つの数値のリストです。1 は正当であることを意味し、XNUMX は不正であることを意味します。 SageMaker はこのリストを受け取り、それを内部メソッドと呼ばれるメソッドに渡します output_fn 最終的な機能を完了します。

GNN モデルをデプロイするには、まずエントリ ポイント ファイルとその他のパラメータ (保存された ZIP ファイルのパス、PyTorch フレームワーク バージョン、Python バージョンなど) を使用して GNN モデルを SageMaker PyTorchModel クラスにラップします。 次に、インスタンス設定で deploy メソッドを呼び出します。 次のコードを参照してください。

上記の手順とコード スニペットは、Jupyter ノートブックから GNN モデルをオンライン推論エンドポイントとしてデプロイする方法を示しています。 ただし、本番環境では、データの処理、モデルのトレーニング、推論エンドポイントのデプロイなど、ワークフロー全体で Step Functions によってオーケストレーションされた前述の MLOps パイプラインを使用することをお勧めします。 パイプライン全体は AWS CDK によって実装されます 、さまざまな地域やアカウントで簡単に複製できます。

リアルタイム推論

新しいトランザクションが到着したら、リアルタイム予測を実行するには、次の XNUMX つの手順を完了する必要があります。

- ノードとエッジの挿入 – TransactionID や ProductCD などのトランザクションの情報をノードとエッジとして抽出し、Neptune データベースに保存されている既存のグラフ データに新しいノードを挿入します。

- サブグラフ抽出 – 予測対象のトランザクション ノードを中心ノードとして設定し、GNN モデルの入力要件に従って n ホップ サブグラフを抽出します。

- 特徴抽出 – サブグラフのノードとエッジについて、関連する特徴を抽出します。

- 推論エンドポイントを呼び出す – サブグラフと機能をリクエストのコンテンツにパックしてから、リクエストを推論エンドポイントに送信します。

このソリューションでは、RESTful API を実装して、前の手順で説明したリアルタイムの不正な予測を実現します。 リアルタイム予測については、次の疑似コードを参照してください。 完全な実装は 完全なソース コード ファイル.

リアルタイムで予測するには、最初の XNUMX つのステップでレイテンシを低くする必要があります。 したがって、グラフ データベースは、これらのタスク、特にグラフ データベース クエリで効率的に達成できる部分グラフ抽出に最適な選択肢です。 疑似コードをサポートする下線付き関数は、Neptune の gremlin クエリに基づいています。

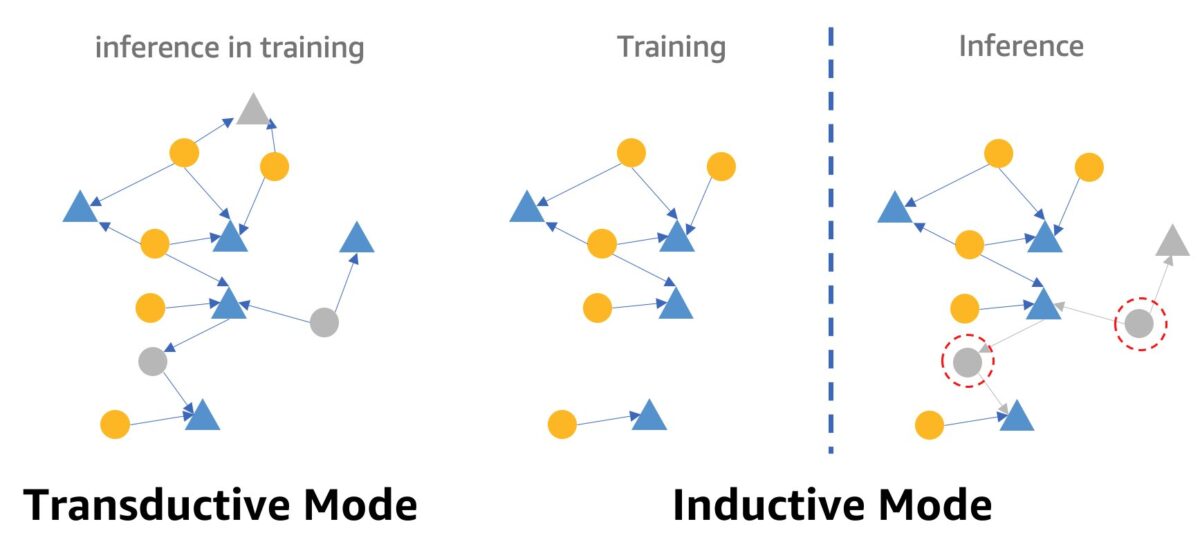

GNN を使用したリアルタイムの不正検出に関する注意点の XNUMX つは、GNN 推論モードです。 リアルタイムの推論を実現するには、GNN モデルの推論を伝達モードから帰納モードに変換する必要があります。 伝達的推論モードの GNN モデルは、新しく出現したノードとエッジを予測できませんが、帰納的モードでは、GNN モデルは新しいノードとエッジを処理できます。 次の図は、変換モードと誘導モードの違いを示しています。

変換モードでは、予測されたノードとエッジは、トレーニング中にラベル付きのノードとエッジと共存します。 モデルは推論の前にそれらを識別し、トレーニングで推論できます。 帰納モードのモデルはトレーニング グラフでトレーニングされますが、見えないノード (右側の赤い点線の円内のノード) を、右側の灰色の三角形のノードのように、新しいノードである可能性がある関連する隣接ノードと共に予測する必要があります。

当社の RGCN モデルは、伝達モードでトレーニングおよびテストされています。 トレーニング中のすべてのノードにアクセスでき、IP アドレスやカードの種類など、機能のない各ノードの埋め込みもトレーニングされます。 テスト段階では、RGCN モデルはこれらの埋め込みをノード機能として使用して、テスト セット内のノードを予測します。 ただし、リアルタイムの推論を行うと、新しく追加された機能のないノードの一部には、トレーニング グラフにないため、そのような埋め込みがありません。 この問題に取り組む XNUMX つの方法は、同じノード タイプのすべての埋め込みの平均を新しいノードに割り当てることです。 このソリューションでは、この方法を採用しています。

さらに、このソリューションは Web ポータル (次のスクリーンショットを参照) を提供し、事業者の視点からリアルタイムの不正予測を示します。 シミュレートされたオンライン トランザクションを生成し、検出された不正なトランザクション情報をリアルタイムで視覚化できます。

クリーンアップ

ソリューションの探索が終了したら、次のことができます。 リソースをきれいにする 料金が発生しないようにします。

まとめ

この投稿では、SageMaker、Neptune、および DGL を使用して、GNN ベースのリアルタイム不正検出ソリューションを構築する方法を示しました。 このソリューションには、次の XNUMX つの主な利点があります。

- 予測精度と AUC 指標の点で優れたパフォーマンスを発揮します

- ストリーミング MLOps パイプラインと SageMaker エンドポイントを介してリアルタイムの推論を実行できます

- 提供された CloudFormation テンプレートを使用して展開プロセス全体を自動化し、関心のある開発者が自分のアカウントのカスタム データを使用してこのソリューションを簡単にテストできるようにします。

ソリューションの詳細については、 GitHubレポ.

このソリューションをデプロイした後、GNN モデルを変更せずに、独自のデータ形式に合わせてデータ処理コードをカスタマイズし、リアルタイムの推論メカニズムを変更することをお勧めします。 レイテンシをさらに最適化せずに、リアルタイム推論を XNUMX つのステップに分割したことに注意してください。 これらの XNUMX つのステップでは、デモ データセットで予測を取得するのに数秒かかります。 サブグラフと特徴抽出のための Neptune グラフ データ スキーマ設計とクエリを最適化することで、推論のレイテンシーを大幅に削減できると考えています。

著者について

ジャン・チャン 機械学習技術を使用して、詐欺の検出、装飾画像の生成など、顧客がさまざまな問題を解決するのを支援してきた応用科学者です。 グラフベースの機械学習、特にグラフ ニューラル ネットワーク、中国、米国、シンガポールの顧客向けソリューションの開発に成功しました。 AWS のグラフ機能の啓蒙者として、Zhang は GNN、Deep Graph Library (DGL)、Amazon Neptune、およびその他の AWS サービスに関する多くの公開プレゼンテーションを行ってきました。

ジャン・チャン 機械学習技術を使用して、詐欺の検出、装飾画像の生成など、顧客がさまざまな問題を解決するのを支援してきた応用科学者です。 グラフベースの機械学習、特にグラフ ニューラル ネットワーク、中国、米国、シンガポールの顧客向けソリューションの開発に成功しました。 AWS のグラフ機能の啓蒙者として、Zhang は GNN、Deep Graph Library (DGL)、Amazon Neptune、およびその他の AWS サービスに関する多くの公開プレゼンテーションを行ってきました。

朱蒙心 AWS のソリューション アーキテクトのマネージャーであり、再利用可能な AWS ソリューションの設計と開発に重点を置いています。 彼は長年ソフトウェア開発に携わっており、さまざまな規模のいくつかのスタートアップ チームを担当してきました。 彼はまた、オープンソース ソフトウェアの支持者でもあり、Eclipse コミッターでもありました。

朱蒙心 AWS のソリューション アーキテクトのマネージャーであり、再利用可能な AWS ソリューションの設計と開発に重点を置いています。 彼は長年ソフトウェア開発に携わっており、さまざまな規模のいくつかのスタートアップ チームを担当してきました。 彼はまた、オープンソース ソフトウェアの支持者でもあり、Eclipse コミッターでもありました。

王浩珠 は、Amazon ML Solutions Lab の研究科学者であり、強化学習バーティカルを共同でリードしています。 彼は、グラフ学習、自然言語処理、強化学習、および AutoML に関する最新の研究を使用して、顧客が高度な機械学習ソリューションを構築するのを支援しています。 Haozhu は、ミシガン大学で電気およびコンピューター エンジニアリングの博士号を取得しています。

王浩珠 は、Amazon ML Solutions Lab の研究科学者であり、強化学習バーティカルを共同でリードしています。 彼は、グラフ学習、自然言語処理、強化学習、および AutoML に関する最新の研究を使用して、顧客が高度な機械学習ソリューションを構築するのを支援しています。 Haozhu は、ミシガン大学で電気およびコンピューター エンジニアリングの博士号を取得しています。