Whisper は、さまざまな言語とタスクを網羅する、Web からの 680,000 時間の教師付きデータを使用してトレーニングされた自動音声認識 (ASR) モデルです。 制限の 100 つは、マラーティー語やドラヴィダ語などの低リソース言語でのパフォーマンスの低下です。これは微調整で修正できます。 ただし、Whisper モデルを微調整することは、計算リソースとストレージ要件の両方の点でかなりの課題になっています。 Whisper モデルの完全な微調整を 100 ~ 40 回実行するには、約 4 時間の A7 GPU (XNUMX GB SXMXNUMX) (モデルのサイズとモデル パラメーターによって異なります) が必要で、各微調整チェックポイントには約 XNUMX GB のストレージ スペースが必要です。 この高い計算需要とストレージ需要の組み合わせは、特にリソースが限られた環境では大きな障害となる可能性があり、多くの場合、有意義な結果を達成することが非常に困難になります。

低ランク適応、別名 ロラ、モデルの微調整に独自のアプローチを採用しています。 事前トレーニングされたモデルの重みを静的な状態に維持し、トレーニング可能なランク分解行列を Transformer 構造の各層に導入します。 この方法では、ダウンストリーム タスクに必要なトレーニング可能なパラメーターの数を 10,000 分の 3 に減らし、GPU メモリ要件を XNUMX 分の XNUMX に減らすことができます。 モデルの品質に関しては、LoRA は、トレーニング可能なパラメーターが少ないにもかかわらず、従来の微調整手法のパフォーマンスに匹敵するか、それを上回ることが示されています (オリジナルの結果を参照) LoRA 論文)。 また、トレーニングのスループットが向上するという利点もあります。 とは異なり、 アダプタ LoRA では、推論中に追加の遅延が発生しないため、展開フェーズ中のモデルの効率が維持されます。 LoRA を使用した Whisper の微調整は有望な結果を示しています。 たとえば、Whisper-Large-v2 を考えてみましょう。 3 GB メモリの GPU で 12 時間の共通音声データセットを使用して 8 エポックを実行するには 6 ~ 8 時間かかりますこれは、同等のパフォーマンスを持つ完全な微調整よりも 5 倍高速です。

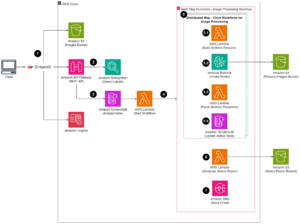

アマゾンセージメーカー LoRA による Whisper の微調整を実装するための理想的なプラットフォームです。 Amazon SageMaker を使用すると、フルマネージド型のインフラストラクチャ、ツール、ワークフローを使用して、あらゆるユースケース向けの機械学習モデルを構築、トレーニング、デプロイできます。 モデル トレーニングの追加の利点としては、マネージド スポット トレーニングによるトレーニング コストの削減、モデルとトレーニング データセットを AWS GPU インスタンス間で分割するための分散トレーニング ライブラリ、および 他には?。 トレーニングされた SageMaker モデルは、推論のために SageMaker 上に直接簡単にデプロイできます。 この投稿では、SageMaker で LoRA 微調整を実装するためのステップバイステップのガイドを紹介します。 この実装に関連するソース コードは、次の場所にあります。 GitHubの.

微調整用のデータセットを準備する

微調整タスクには低リソース言語のマラーティー語を使用します。 の使用 ハグ顔データセット ライブラリを使用すると、Common Voice データセットをダウンロードして、トレーニング データセットとテスト データセットに分割できます。 次のコードを参照してください。

ささやき音声認識モデルでは、オーディオ入力が次のとおりである必要があります。 16kHz モノラル 16 ビット符号付き整数 WAV ファイル。 Common Voice データセットは 48K サンプリング レートであるため、最初にオーディオ ファイルをダウンサンプリングする必要があります。 次に、Whisper の特徴抽出機能をオーディオに適用してログメル スペクトログラムの特徴を抽出し、Whisper のトークナイザーをフレーム化された特徴に適用してトランスクリプト内の各文をトークン ID に変換する必要があります。 次のコードを参照してください。

すべてのトレーニング サンプルを処理した後、処理されたデータを Amazon S3 にアップロードします。これにより、微調整段階で処理されたトレーニング データを使用するときに、 高速ファイル S3 ファイルをローカル ディスクにコピーする代わりに直接マウントするには:

モデルを訓練する

デモンストレーションのために、事前トレーニング済みモデルとして Whisper-large-v2 を使用します (Whisper v3 が利用可能になりました)。これは、Hugging Face トランスフォーマー ライブラリを通じてインポートできます。 使用できます 8ビット量子化 トレーニング効率をさらに向上させます。 8 ビット量子化は、浮動小数点から 8 ビット整数に丸めることによってメモリを最適化します。 これは、推論中の精度をあまり犠牲にすることなくメモリを節約するために一般的に使用されるモデル圧縮手法です。

事前トレーニングされたモデルを 8 ビット量子化形式でロードするには、次のコードに示すように、モデルをインスタンス化するときに、単にload_in_8bit=True 引数を追加します。 これにより、8 ビットに量子化されたモデルの重みがロードされ、メモリ フットプリントが削減されます。

Hugging Face の LoRA 実装を使用します。 ペフト パッケージ。 LoRA を使用してモデルを微調整するには、次の XNUMX つの手順があります。

- (最後のステップで行ったように) 基本モデルをインスタンス化します。

- 構成を作成します (

LoraConfig) ここで、LoRA 固有のパラメーターが定義されます。 - ベースモデルをラップします

get_peft_model()トレーニング可能なものを取得するPeftModel. - トレーニング

PeftModelベースモデルとして。

次のコードを参照してください。

を実行するには SageMakerトレーニング 私たちは独自の Docker コンテナを導入しています。 Docker イメージは次からダウンロードできます。 GitHubのここで、ffmpeg4 と git-lfs は、他の Python 要件とともにパッケージ化されています。 独自の Docker コンテナを SageMaker で動作するように調整する方法の詳細については、以下を参照してください。 独自のトレーニング コンテナを調整する。 その後、Hugging Face Estimator を使用して、SageMaker トレーニング ジョブを開始できます。

LoRA の実装により、単一の GPU インスタンス (ml.g5.2xlarge など) で Whisper の大規模微調整タスクを実行できるようになりました。 比較すると、Whisper のラージ完全微調整タスクには複数の GPU (ml.p4d.24xlarge など) とはるかに長いトレーニング時間が必要です。 具体的には、私たちの実験では、完全な微調整タスクには LoRA アプローチと比較して 24 倍の GPU 時間が必要であることが実証されました。

モデルのパフォーマンスを評価する

微調整された Whisper モデルのパフォーマンスを評価するために、保持されたテスト セットで単語誤り率 (WER) を計算します。 WER は、予測されたトランスクリプトとグランド トゥルース トランスクリプト間の差異を測定します。 WER が低いほど、パフォーマンスが優れていることを示します。 事前トレーニングされたモデルと微調整されたモデルに対して次のスクリプトを実行し、それらの WER の違いを比較できます。

まとめ

この投稿では、最先端の音声認識モデルである Whisper の微調整をデモンストレーションしました。 特に、Hugging Face の PEFT LoRA を使用し、効率的なトレーニングのために 8 ビット量子化を有効にしました。 また、SageMaker でトレーニング ジョブを実行する方法も示しました。

これは重要な最初のステップですが、この作業を基にしてウィスパー モデルをさらに改善する方法がいくつかあります。 今後は、SageMaker 分散トレーニングを使用して、より大規模なデータセットでトレーニングを拡張することを検討してください。 これにより、より多様で包括的なデータに基づいてモデルをトレーニングできるようになり、精度が向上します。 また、Whisper モデルを提供するときに遅延を最適化して、リアルタイムの音声認識を有効にすることもできます。 さらに、より長い音声文字起こしを処理するために作業を拡張することもできますが、これにはモデル アーキテクチャとトレーニング スキームの変更が必要になります。

了承

著者らは、この投稿に対する洞察力に富んだフィードバックとレビューを提供してくれた Paras Mehra、John Sol、Evandro Franco に感謝の意を表します。

著者について

ジュンシ アマゾン ウェブ サービス (AWS) のシニア ソリューション アーキテクトです。 彼の現在の重点分野は、AI/ML インフラストラクチャとアプリケーションです。 彼はソフトウェア エンジニアとして FinTech 業界で XNUMX 年以上の経験があります。

ジュンシ アマゾン ウェブ サービス (AWS) のシニア ソリューション アーキテクトです。 彼の現在の重点分野は、AI/ML インフラストラクチャとアプリケーションです。 彼はソフトウェア エンジニアとして FinTech 業界で XNUMX 年以上の経験があります。

博士 長沙馬 AWS の AI/ML スペシャリストです。 彼女はコンピューター サイエンスの博士号、教育心理学の修士号を取得した技術者であり、データ サイエンスと AI/ML の独立系コンサルティングで長年の経験があります。 彼女は、機械と人間の知能のための方法論的アプローチの研究に情熱を注いでいます。 仕事以外では、ハイキング、料理、食べ物探し、友人や家族と時間を過ごすことが大好きです。

博士 長沙馬 AWS の AI/ML スペシャリストです。 彼女はコンピューター サイエンスの博士号、教育心理学の修士号を取得した技術者であり、データ サイエンスと AI/ML の独立系コンサルティングで長年の経験があります。 彼女は、機械と人間の知能のための方法論的アプローチの研究に情熱を注いでいます。 仕事以外では、ハイキング、料理、食べ物探し、友人や家族と時間を過ごすことが大好きです。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/fine-tune-whisper-models-on-amazon-sagemaker-with-lora/

- :持っている

- :は

- :どこ

- 000

- 1

- 10

- 100

- 13

- 視聴者の38%が

- 17

- 24

- 25

- 視聴者の38%が

- 40

- 7

- 8

- 97

- a

- 私たちについて

- 精度

- 達成する

- 越えて

- 適応する

- 適応

- 加えます

- NEW

- さらに

- に対して

- AI / ML

- すべて

- 許す

- また

- Amazon

- アマゾンセージメーカー

- Amazon Webサービス

- Amazon Webサービス(AWS)

- amp

- an

- および

- どれか

- 申し込む

- アプローチ

- アプローチ

- 約

- 建築

- です

- エリア

- 引数

- 配列

- AS

- 関連する

- At

- オーディオ

- 著者

- オート

- オートマチック

- 利用できます

- AWS

- ベース

- ベース

- BE

- なぜなら

- になる

- き

- 恩恵

- 利点

- より良いです

- の間に

- 両言語で

- 持って来る

- ビルド

- by

- 計算する

- 缶

- 場合

- 挑戦する

- 変更

- コード

- 組み合わせ

- コマンドと

- 一般に

- 匹敵します

- 比較します

- 比べ

- 比較

- 包括的な

- 計算的

- 計算

- コンピュータ

- コンピュータサイエンス

- 検討

- かなりの

- コンサルティング

- コンテナ

- 変換

- 複写

- コスト

- 可能性

- 電流プローブ

- データ

- データの準備

- データサイエンス

- データセット

- 十年

- 減少

- 定義済みの

- 度

- インクルード

- 需要

- 実証

- 展開します

- 展開

- 展開

- にもかかわらず

- DID

- 違い

- 難しい

- 直接に

- 配布

- 分散トレーニング

- デッカー

- そうではありません

- ダウンロード

- 間に

- 各

- 簡単に

- 教育

- 効率

- 効率的な

- enable

- 使用可能

- 可能

- 包含する

- エンジニア

- 環境

- 時代

- エラー

- 特に

- 評価する

- さらに

- 例

- 超えます

- 例外的に

- 詳細

- 体験

- 実験

- 伸ばす

- エキス

- 顔

- 家族

- 速いです

- 特徴

- 特徴

- フィードバック

- より少ない

- File

- フィンテック

- 名

- 五

- floating

- フォーカス

- フォロー中

- フード

- フットプリント

- 形式でアーカイブしたプロジェクトを保存します.

- フォワード

- 発見

- 4

- 友達

- から

- フル

- 完全に

- function

- さらに

- 取得する

- 行く

- GPU

- GPU

- 感謝の気持ち

- 陸上

- ガイド

- ハンドル

- 持ってる

- he

- ハイ

- 彼の

- HOURS

- 認定条件

- How To

- しかしながら

- HTML

- HTTPS

- 人間

- 人間の知性

- 狩猟

- ハードル

- ID

- 理想

- イド

- 画像

- 実装する

- 実装

- import

- 重要

- 改善します

- 改善

- in

- include

- 増加した

- 独立しました

- を示し

- 産業を変えます

- インフラ関連事業

- 入力

- 洞察力のある

- を取得する必要がある者

- インテリジェンス

- に

- 紹介する

- 紹介します

- IT

- ITS

- ジョブ

- John Redfern

- JPG

- 既知の

- ラベル

- ラベル

- 言語

- ESL, ビジネスESL <br> 中国語/フランス語、その他

- 大

- より大きい

- 姓

- レイテンシ

- 層

- LEARN

- 学習

- ライブラリ

- 図書館

- 制限

- 限定的

- 負荷

- ローカル

- より長いです

- で

- 下側

- 機械

- 機械学習

- 保守

- 維持

- 作成

- マネージド

- 地図

- マスターの

- 一致

- 意味のある

- 措置

- メモリ

- 方法

- メソッド

- メトリック

- ML

- モデル

- 他には?

- MOUNT

- mr

- ずっと

- の試合に

- 必要

- 必要

- 必要とされる

- なし

- 今

- 数

- Nvidia

- of

- オファー

- 頻繁に

- on

- ONE

- オペレーティング

- 最適化

- 最適化

- オプション

- or

- オリジナル

- その他

- 私たちの

- 外側

- が

- 自分の

- パッケージ

- パッケージ化された

- パラメータ

- 特定の

- 情熱的な

- パフォーマンス

- 相

- 博士号

- プラットフォーム

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- ポイント

- ポーズ

- ポスト

- 精度

- 予測

- 準備

- 現在

- 処理済み

- 有望

- Psychology

- Python

- 品質

- 範囲

- ランク

- レート

- への

- 認識

- 減らします

- 電話代などの費用を削減

- 縮小

- 参照する

- 要件

- 要件

- 必要

- リソース

- 結果

- return

- レビュー

- 丸め

- ラン

- runs

- s

- 犠牲にする

- セージメーカー

- 貯蓄

- 規模

- スキーム

- 科学

- スクリプト

- シニア

- 文

- サービス

- サービング

- セッションに

- いくつかの

- 彼女

- 示す

- 署名されました

- 重要

- 単に

- サイズ

- So

- ソフトウェア

- ソフトウェアエンジニア

- SOL

- ソリューション

- ソース

- ソースコード

- スペース

- 専門家

- 特に

- スピーチ

- 音声認識

- 支出

- split

- Spot

- ステージ

- start

- 都道府県

- 最先端の

- 静的な

- 手順

- ステップ

- ストレージ利用料

- 構造

- そのような

- 取る

- 取り

- ターゲット

- 仕事

- タスク

- 技術

- 技術者

- 10

- 条件

- test

- テスト

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- より

- それ

- ソース

- アプリ環境に合わせて

- その後

- そこ。

- それによって

- この

- 介して

- スループット

- 時間

- <font style="vertical-align: inherit;">回数</font>

- 〜へ

- 一緒に

- トークン

- あまりに

- 豊富なツール群

- トーチ

- 伝統的な

- トレーニング

- 訓練された

- トレーニング

- 成績証明書(トランスクリプト)

- トランス

- トランスフォーマー

- 真実

- ユニーク

- 異なり、

- us

- つかいます

- 使用事例

- 中古

- 変化した

- ボイス

- 方法

- we

- ウェブ

- Webサービス

- いつ

- which

- ウィスパー

- 意志

- 無し

- Word

- 仕事

- ワークフロー

- 年

- You

- あなたの

- ゼファーネット