データはあらゆる分野とあらゆるビジネスを変革しています。 しかし、ほとんどの企業が追跡できる以上の速さでデータが増加しているため、データを収集してそのデータから価値を引き出すことは困難です。 あ 最新のデータ戦略 は、データを使用してより良いビジネス成果を生み出すのに役立ちます。 AWS は、最も完全なサービス セットを提供します。 エンドツーエンドのデータジャーニー で、あなたの データから価値を引き出す そしてそれを洞察に変える。

データ サイエンティストは、機械学習 (ML) プロジェクト用のデータの準備に最大 80% の時間を費やすことができます。 この準備プロセスは、大部分が差別化されていない退屈な作業であり、複数のプログラミング API とカスタム ライブラリが必要になる場合があります。 AmazonSageMakerデータラングラー は、データ サイエンティストとデータ エンジニアが、視覚的なインターフェイスを介して、表形式および時系列データの準備と機能エンジニアリングを簡素化および高速化するのに役立ちます。 次のような複数のデータ ソースからデータをインポートできます。 Amazon シンプル ストレージ サービス (Amazon S3)、 アマゾンアテナ, Amazonレッドシフト、または次のようなサードパーティのソリューション スノーフレーク or データブリック、および 300 を超える組み込みのデータ変換とコード スニペットのライブラリを使用してデータを処理するため、コードを記述することなく、機能をすばやく正規化、変換、結合できます。 PySpark、SQL、または Pandas でカスタム変換を行うこともできます。

この投稿では、データ準備ジョブを自動的に実行するようにスケジュールする方法を示します。 また、パラメーター化されたデータセットの新しい Data Wrangler 機能についても調べます。これにより、パラメーター化された URI を使用してデータ フローに含めるファイルを指定できます。

ソリューションの概要

Data Wrangler は、パラメーター化された URI を使用したデータのインポートをサポートするようになりました。 これにより、URI で指定されたパラメーター (String、Number、Datetime、および Pattern) に一致するすべてのデータセットをインポートできるようになったため、柔軟性がさらに高まります。 さらに、スケジュールに従って Data Wrangler 変換ジョブをトリガーできるようになりました。

この投稿では、Titanic データセットを使用してサンプル フローを作成し、これら XNUMX つの新しい Data Wrangler の機能の実験を開始する方法を示します。 データセットをダウンロードするには、次を参照してください。 タイタニック–災害からの機械学習.

前提条件

この投稿で説明されているすべての機能を利用するには、最新のカーネル バージョンの Data Wrangler を実行する必要があります。 詳細については、次を参照してください。 データ ラングラーの更新. さらに、実行する必要があります Amazon SageMakerスタジオ JupyterLab 3. 現在のバージョンを表示して更新するには、次を参照してください。 JupyterLabのバージョン管理.

ファイル構造

このデモンストレーションでは、この投稿で概説した手順を再現するために複製する必要がある単純なファイル構造に従います。

- スタジオでは、 新しいノートブックを作成する.

- 次のコード スニペットを実行して、使用するフォルダー構造を作成します (ファイル ツリーの目的のフォルダーにいることを確認してください)。

- コピー

train.csv&test.csv元の Titanic データセットからフォルダーへのファイルtitanic_dataset/train&titanic_dataset/testそれぞれ。 - 次のコード スニペットを実行して、フォルダーに必要なファイルを設定します。

私たちは分割します train.csv タイタニック データセットのファイルを XNUMX つの異なるファイルに分割し、 part_x、ここで x はパーツの番号です。 パート 0 には最初の 100 レコード、パート 1 には次の 100 レコード、というようにパート 8 まで続きます。ファイル ツリーのすべてのノード フォルダーには、トレーニング データの XNUMX つの部分のコピーが含まれています。 train & test 含むフォルダ train.csv & test.csv.

パラメータ化されたデータセット

Data Wrangler ユーザーは、Amazon S3 からインポートされたデータセットのパラメーターを指定できるようになりました。 データセット パラメーターはリソースの URI で指定され、その値は動的に変更できるため、インポートするファイルをより柔軟に選択できます。 パラメータには、次の XNUMX つのデータ型があります。

- 数 – 任意の整数の値を取ることができます

- 文字列 – 任意のテキスト文字列の値を取ることができます

- パターン – 任意の正規表現の値を取ることができます

- 日付時刻 – サポートされている日付/時刻形式のいずれかの値を取ることができます

このセクションでは、この新機能のウォークスルーを提供します。 これは、データセットを現在のフローにインポートした後にのみ使用でき、Amazon S3 からインポートされたデータセットに対してのみ使用できます。

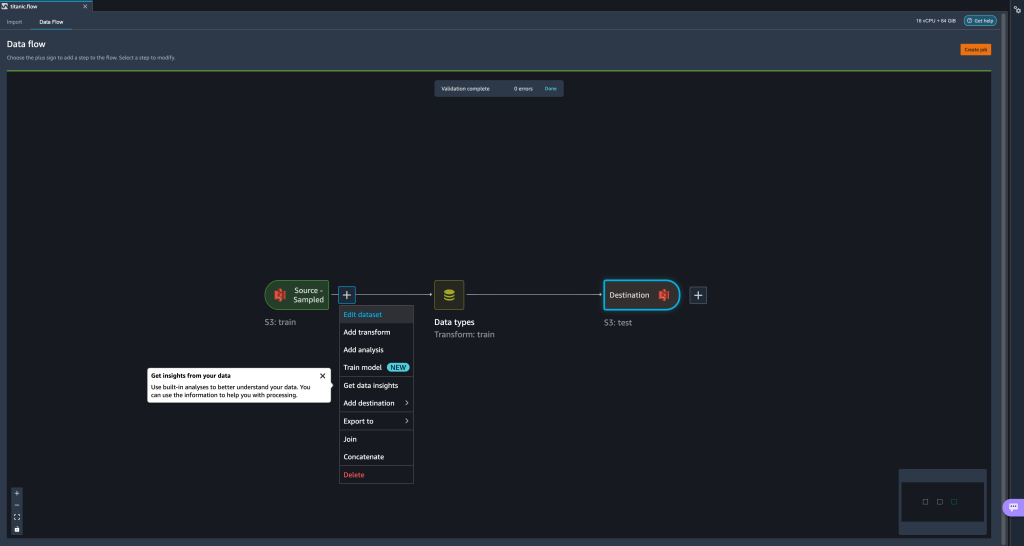

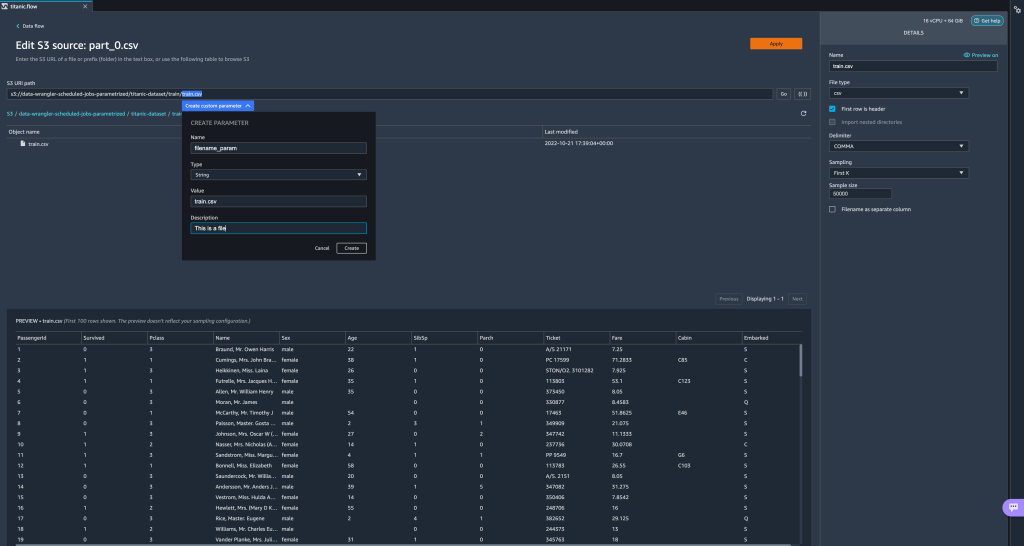

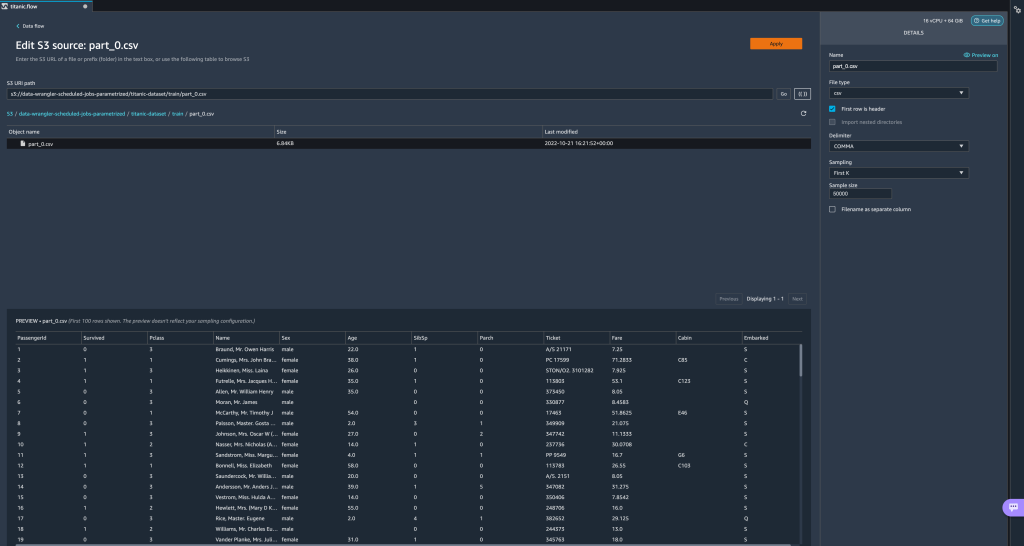

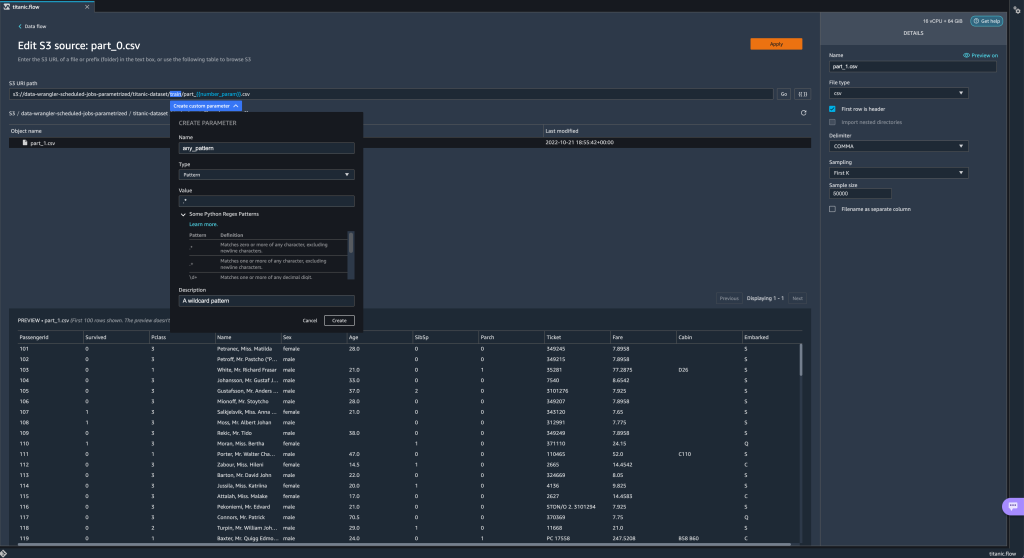

- データ フローから、インポート ステップの横にあるプラス (+) 記号を選択し、 データセットを編集.

- 新しいパラメーターを作成するための推奨される (そして最も簡単な) 方法は、URI のセクションを強調表示して選択することです。 カスタムパラメータを作成する ドロップダウンメニューで。 作成するパラメーターごとに XNUMX つのことを指定する必要があります。

- 名前

- タイプ

- デフォルト値

- 説明

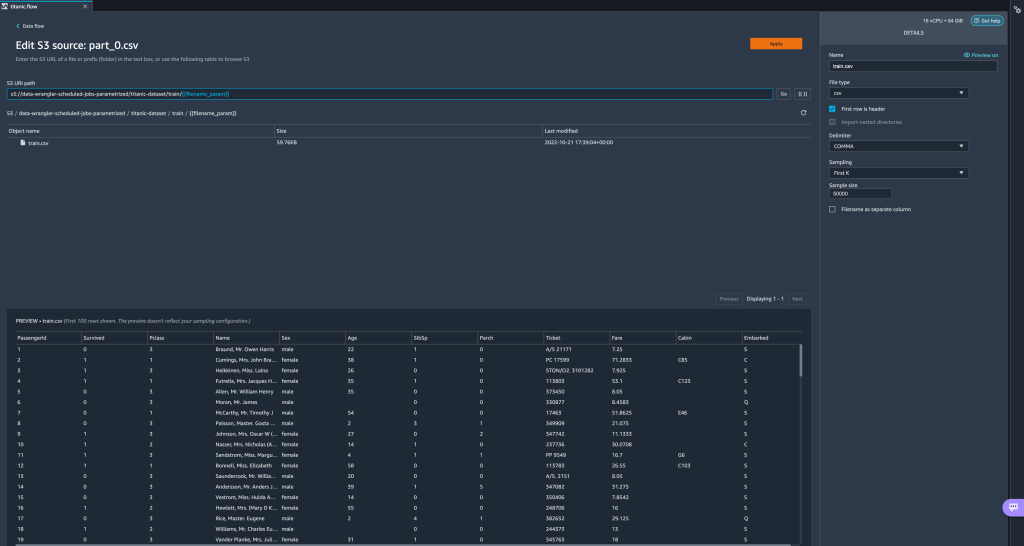

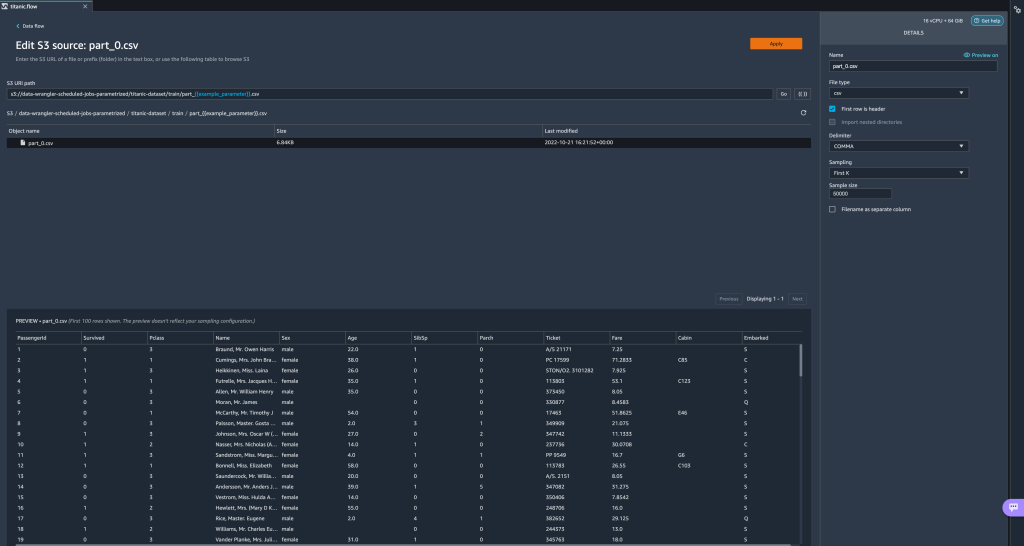

ここでは、String 型のパラメーターを作成しました。filename_paramデフォルト値はtrain.csv. 二重括弧で囲まれたパラメーター名が表示され、以前に強調表示した URI の部分が置き換えられます。 このパラメータの定義値はtrain.csv、ファイルが表示されますtrain.csv輸入表に記載されています。

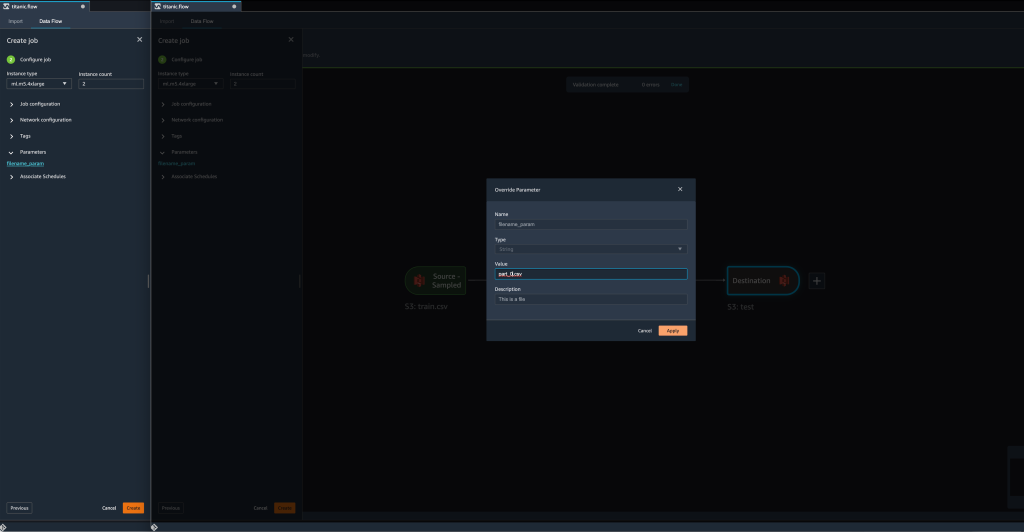

- 変換ジョブを作成しようとすると、 ジョブの構成 ステップ、私たちは今、 計測パラメータ セクションでは、定義したすべてのパラメーターのリストを確認できます。

- パラメータを選択すると、パラメータの値を変更するオプションが表示されます。この場合は、定義されたフローに従って変換される入力データセットを変更します。

の値を変更すると仮定します。filename_paramからtrain.csv〜へpart_0.csv、変換ジョブがかかるようになりましたpart_0.csv(ただし、次の名前のファイルpart_0.csv新しい入力データと同じフォルダーの下に存在します)。

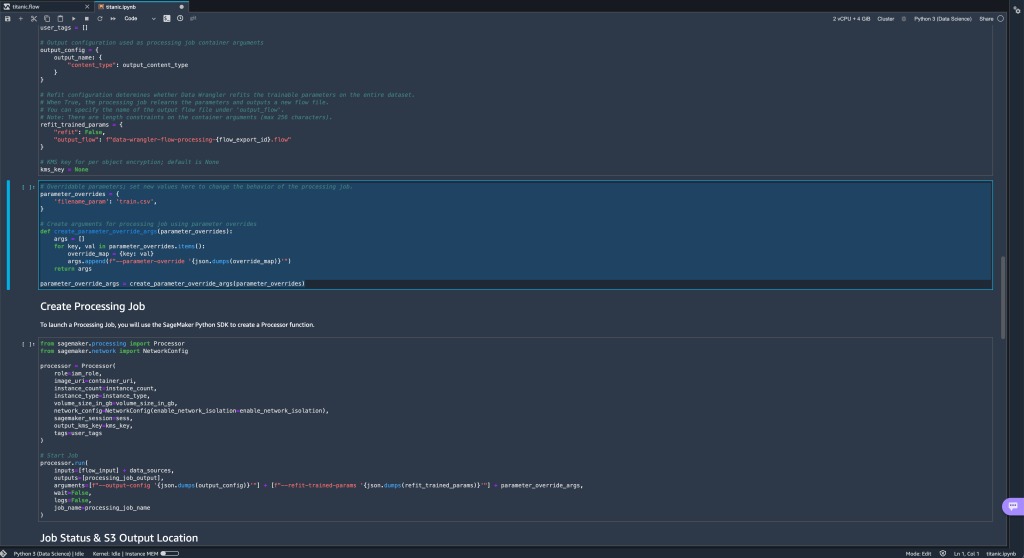

- さらに、フローを (Jupyter ノートブック経由で) Amazon S3 の宛先にエクスポートしようとすると、定義したパラメータを含む新しいセルが表示されるようになりました。

パラメータはデフォルト値を取りますが、その値をparameter_overridesディクショナリ (ディクショナリのキーは変更せずに)。

さらに、から新しいパラメータを作成できます。 計測パラメータ UI。 - パラメーター アイコン ({{}}) の隣にあります。 Go オプション; どちらも URI パス値の隣にあります。

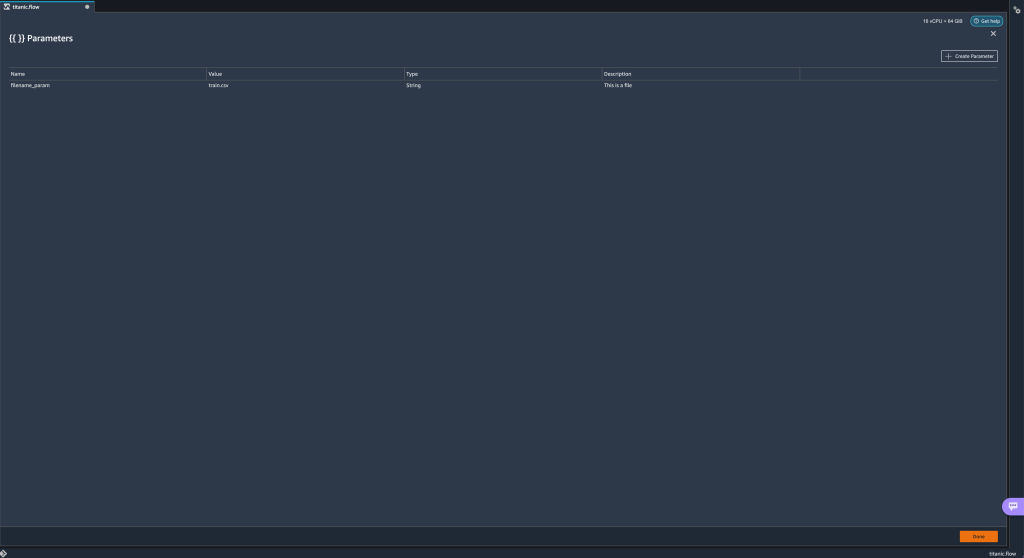

テーブルが開き、フロー ファイルに現在存在するすべてのパラメーターが表示されます (

テーブルが開き、フロー ファイルに現在存在するすべてのパラメーターが表示されます (filename_paramこの時点で)。 - を選択して、フローの新しいパラメーターを作成できます。 パラメータの作成.

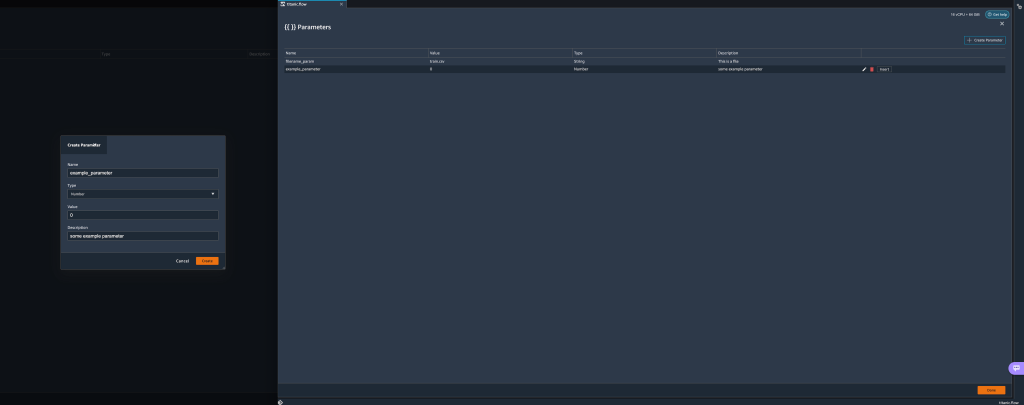

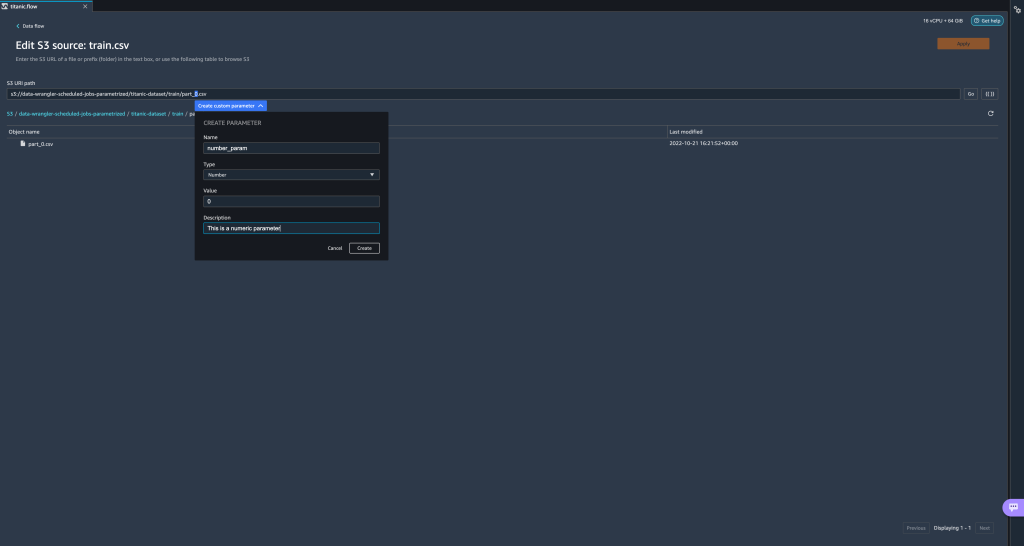

ポップアップ ウィンドウが開き、新しいカスタム パラメータを作成できます。 - ここでは、新しい

example_parameterデフォルト値が 0 の Number 型として。この新しく作成されたパラメータは、 計測パラメータ テーブル。 パラメータの上にカーソルを置くと、オプションが表示されます 編集, 削除, インセット.

- 内から 計測パラメータ UI で、目的のパラメーターを選択して選択することで、パラメーターの XNUMX つを URI に挿入できます。 インセット.

これにより、パラメーターが URI の末尾に追加されます。 URI 内の目的のセクションに移動する必要があります。

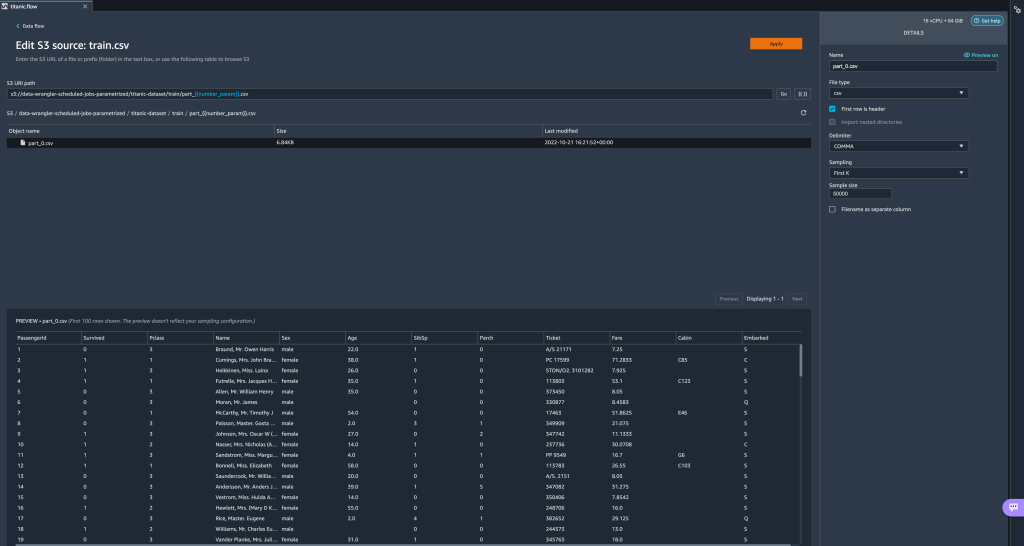

- パラメータのデフォルト値を変更し、(モーダルから) 変更を適用し、 Goをクリックし、更新アイコンを選択して、新しく定義されたパラメーターの値に基づいて、選択したデータセットを使用してプレビュー リストを更新します。

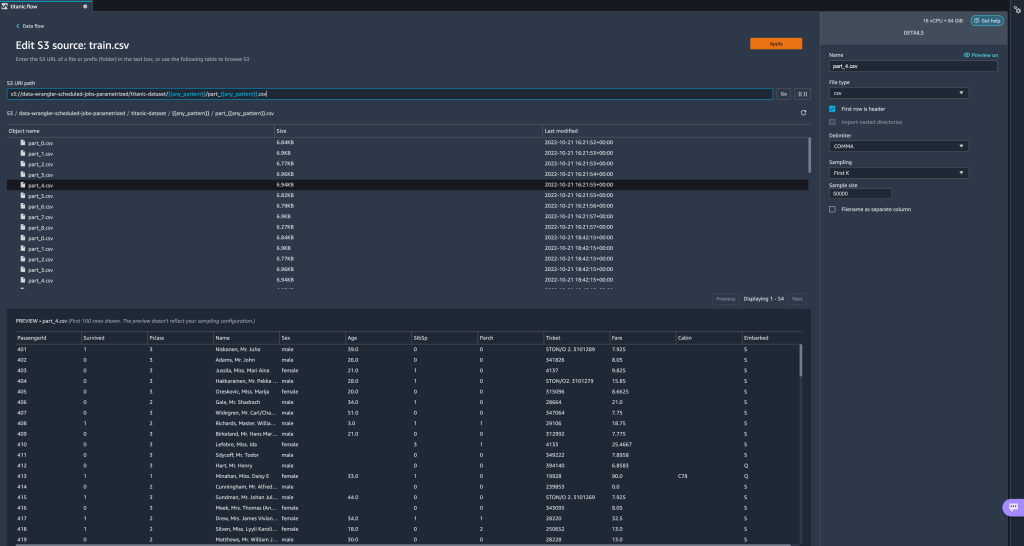

他のパラメーターの種類を調べてみましょう。 データセットが複数の部分に分割され、各ファイルに部分番号があるとします。

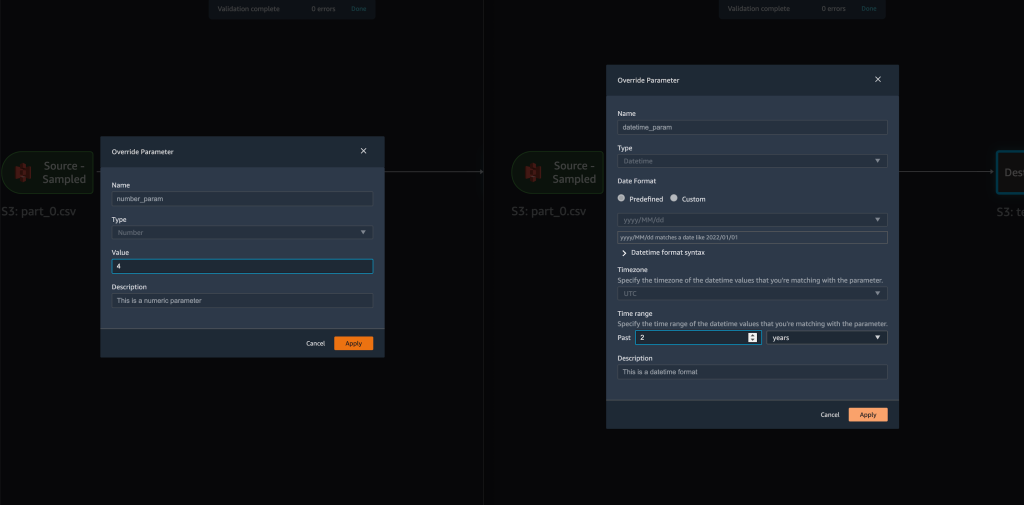

他のパラメーターの種類を調べてみましょう。 データセットが複数の部分に分割され、各ファイルに部分番号があるとします。 - ファイル番号を動的に変更する場合は、次のスクリーンショットに示すように Number パラメーターを定義できます。

選択されたファイルは、パラメータで指定された番号と一致するものであることに注意してください。

選択されたファイルは、パラメータで指定された番号と一致するものであることに注意してください。 ここで、Pattern パラメーターの使用方法を示しましょう。 すべてをインポートしたいとします。

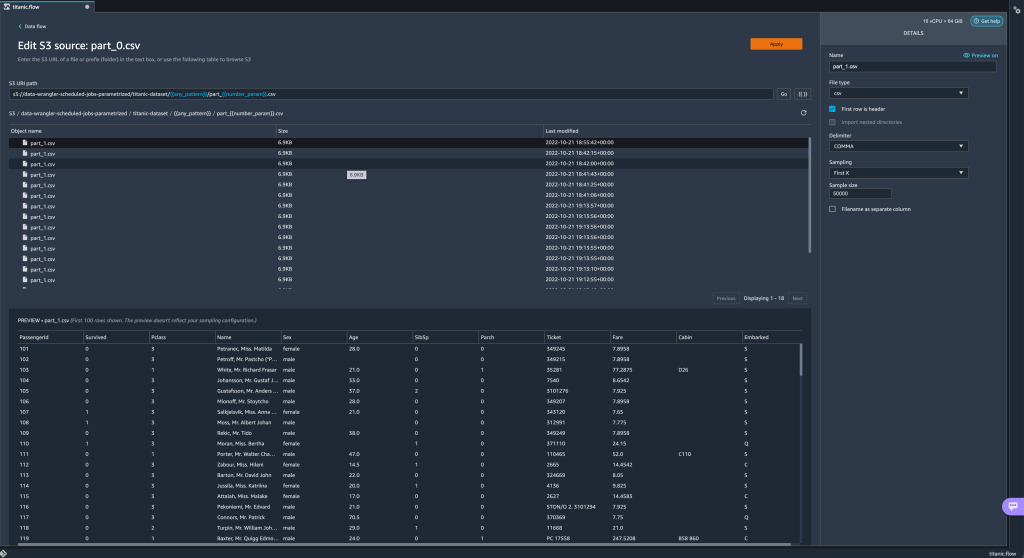

ここで、Pattern パラメーターの使用方法を示しましょう。 すべてをインポートしたいとします。 part_1.csv以下のすべてのフォルダー内のファイルtitanic-dataset/フォルダ。 パターン パラメータには、有効な正規表現を使用できます。 例としていくつかの正規表現パターンが示されています。 - というパターン パラメータを作成します。

any_patternの下にある任意のフォルダーまたはファイルに一致します。titanic-dataset/デフォルト値のフォルダ.*ワイルドカードは単一の * (アスタリスク) ではなく、ドットも含まれていることに注意してください。 - ハイライト

titanic-dataset/パスの一部を編集し、カスタム パラメータを作成します。 今回は、 パターン タイプ。 このパターンは、呼び出されたすべてのファイルを選択します

このパターンは、呼び出されたすべてのファイルを選択します part-1.csv以下のいずれかのフォルダからtitanic-dataset/. パラメータは、パス内で複数回使用できます。 次の例では、新しく作成したパラメーターを使用します

パラメータは、パス内で複数回使用できます。 次の例では、新しく作成したパラメーターを使用します any_pattern以下のいずれかのフォルダー内のいずれかのパーツ ファイルと一致するように、URI で XNUMX 回titanic-dataset/. 最後に、Datetime パラメータを作成しましょう。 日時パラメーターは、によって生成されたパスのように、日付と時刻で分割されたパスを扱う場合に役立ちます。 Amazon Kinesis データ ファイアホース (参照してください Kinesis Data Firehose での動的パーティショニング)。 このデモでは、datetime-data フォルダーの下のデータを使用します。

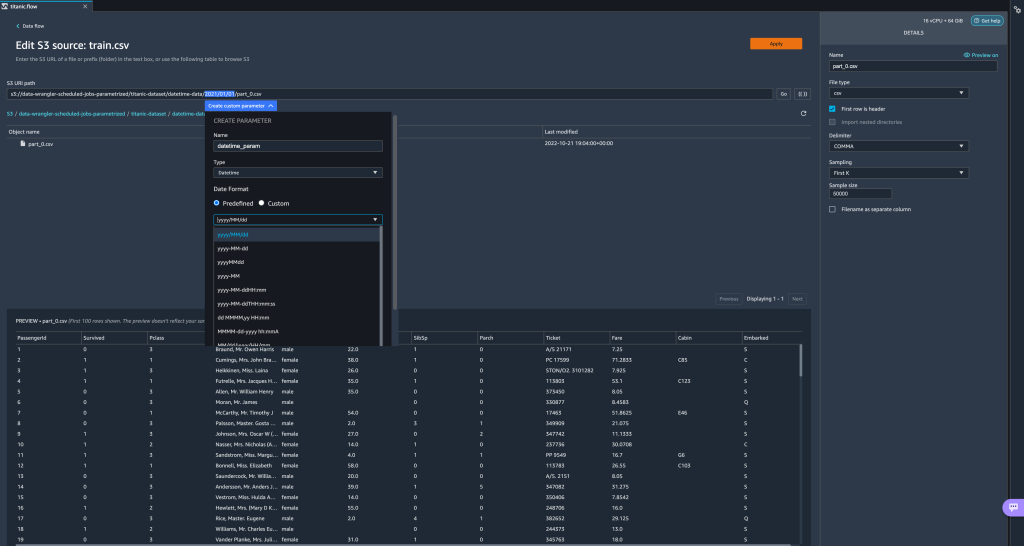

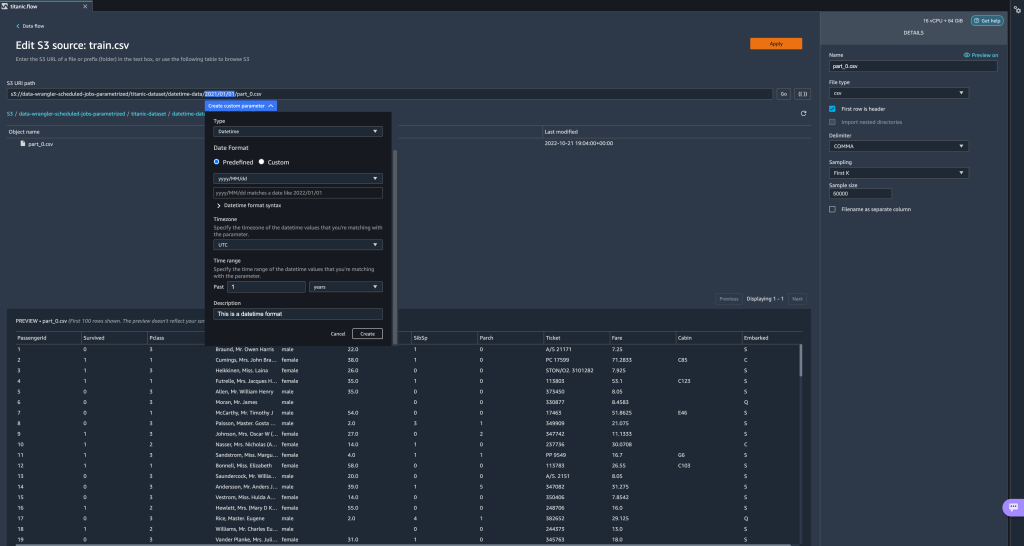

最後に、Datetime パラメータを作成しましょう。 日時パラメーターは、によって生成されたパスのように、日付と時刻で分割されたパスを扱う場合に役立ちます。 Amazon Kinesis データ ファイアホース (参照してください Kinesis Data Firehose での動的パーティショニング)。 このデモでは、datetime-data フォルダーの下のデータを使用します。 - 日付/時刻であるパスの部分を選択し、カスタム パラメータを作成します。 を選択 日付時刻 パラメータタイプ。

Datetime データ型を選択する場合は、詳細を入力する必要があります。 - まず、日付形式を指定する必要があります。 定義済みの日付/時刻形式のいずれかを選択するか、カスタム形式を作成できます。

定義済みの日付/時刻形式の場合、選択した形式に一致する日付の例が凡例に表示されます。 このデモンストレーションでは、フォーマットを選択します yyyy / MM / dd.

- 次に、日付/時刻値のタイム ゾーンを指定します。

たとえば、現在の日付は、あるタイム ゾーンでは 1 年 2022 月 2 日であるが、別のタイム ゾーンでは 2022 年 XNUMX 月 XNUMX 日である場合があります。 - 最後に、時間範囲を選択できます。これにより、データ フローに含めるファイルの範囲を選択できます。

時間範囲は、時間、日、週、月、または年で指定できます。 この例では、昨年のすべてのファイルを取得します。 - パラメータの説明を入力し、 創造する.

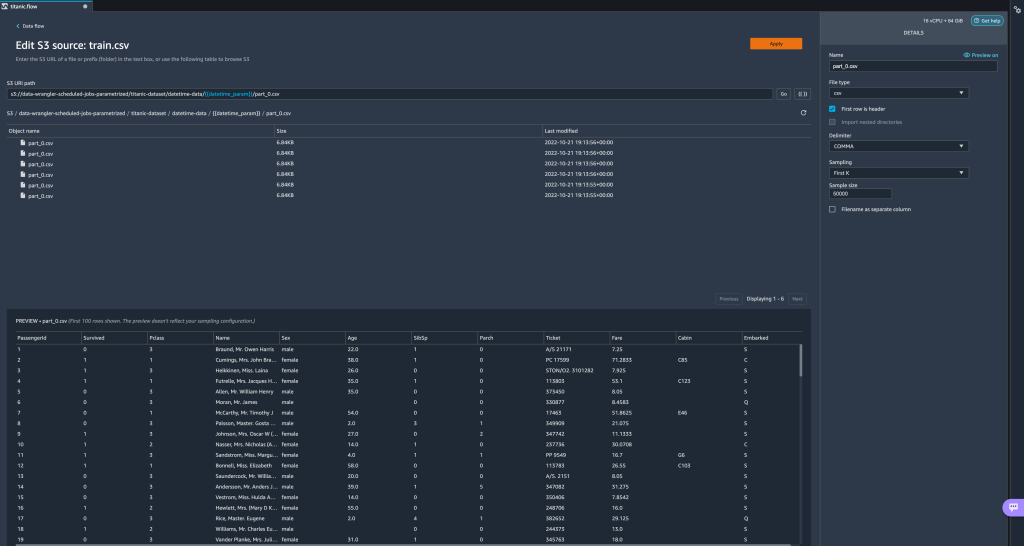

タイム ゾーンが異なる複数のデータセットを使用している場合、時間は自動的に変換されません。 各ファイルまたはソースを前処理して、XNUMX つのタイム ゾーンに変換する必要があります。 選択したファイルは、昨年度のデータに対応するフォルダ配下のすべてのファイルです。

選択したファイルは、昨年度のデータに対応するフォルダ配下のすべてのファイルです。

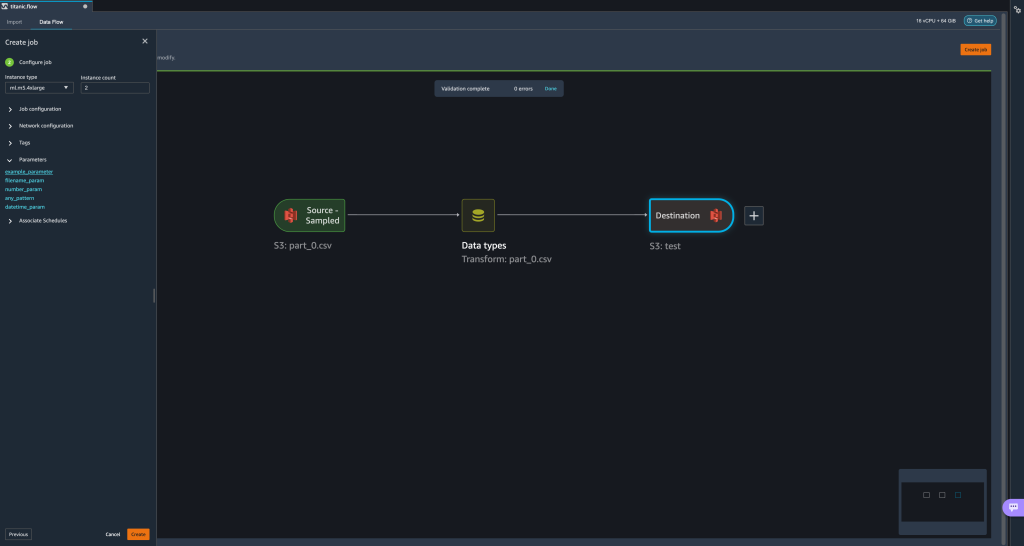

- ここで、データ変換ジョブを作成すると、定義されたすべてのパラメーターのリストが表示され、変換ジョブが指定されたファイルを選択するように、それらの既定値をオーバーライドできます。

スケジュール処理ジョブ

処理ジョブをスケジュールして、データ変換ジョブの実行を自動化し、変換したデータを Amazon S3 または Amazon SageMaker フィーチャーストア. ニーズに合った時間と周期でジョブをスケジュールできます。

スケジュールされた処理ジョブの使用 アマゾンイベントブリッジ ルール ジョブの実行をスケジュールします。 したがって、前提条件として、次のことを確認する必要があります。 AWS IDおよびアクセス管理 (IAM) Data Wrangler によって使用されるロール、つまり アマゾンセージメーカー 実行の役割 Studio インスタンスの、EventBridge ルールを作成する権限を持っています。

IAM を構成する

Data Wrangler フローが実行されている Studio インスタンスに対応する IAM SageMaker 実行ロールで、次の更新に進みます。

- アタッチする AmazonEventBridgeフルアクセス 管理されたポリシー。

- ポリシーをアタッチして、処理ジョブを作成する権限を付与します。

- 次の信頼ポリシーを追加して、ロールを引き受けるアクセス許可を EventBridge に付与します。

または、別のロールを使用して処理ジョブを実行している場合は、手順 2 と 3 で説明したポリシーをそのロールに適用します。 IAM 構成の詳細については、を参照してください。 新しいデータを自動的に処理するスケジュールを作成する.

スケジュールを作成する

スケジュールを作成するには、Data Wrangler フロー エディターでフローを開きます。

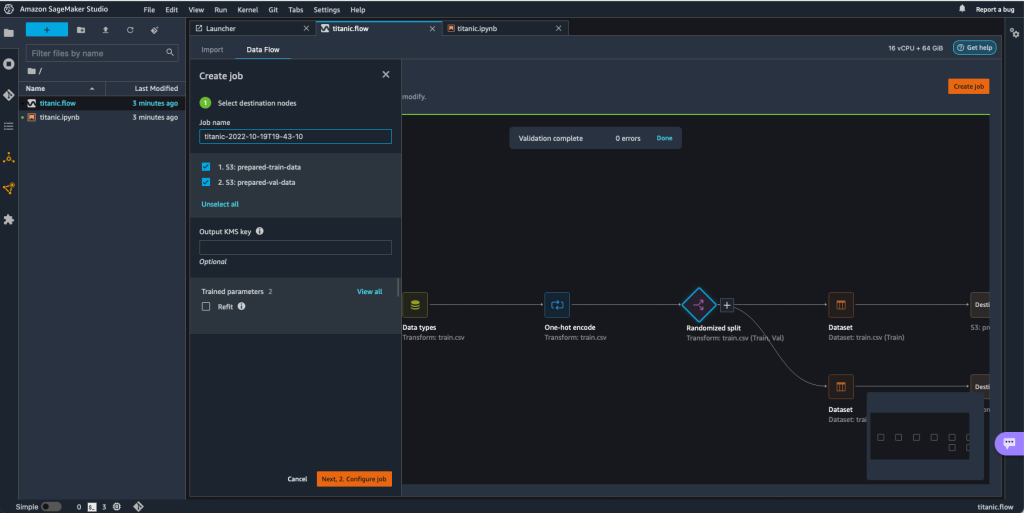

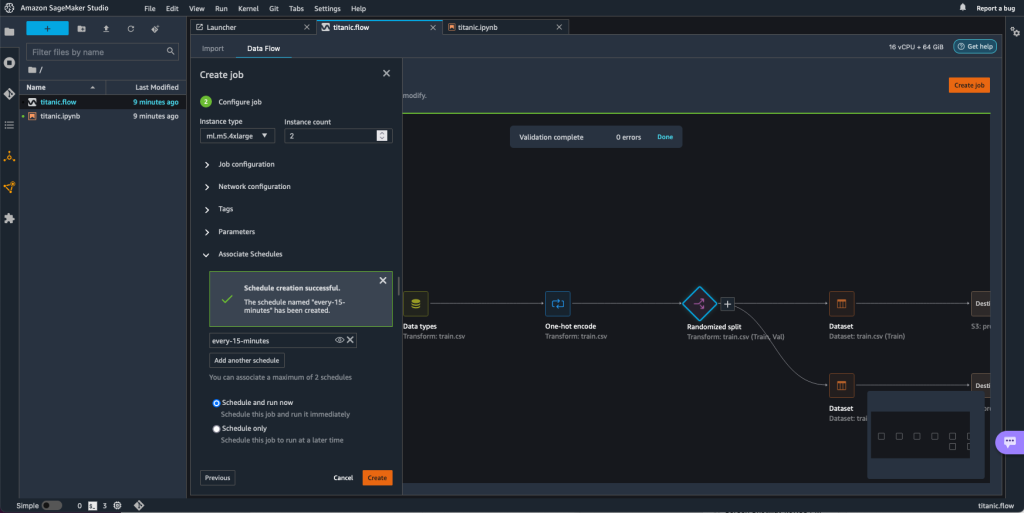

- ソフトウェア設定ページで、下図のように データフロー タブを選択 ジョブを作成.

- 必須フィールドを構成し、選択した 次に、2.ジョブの設定.

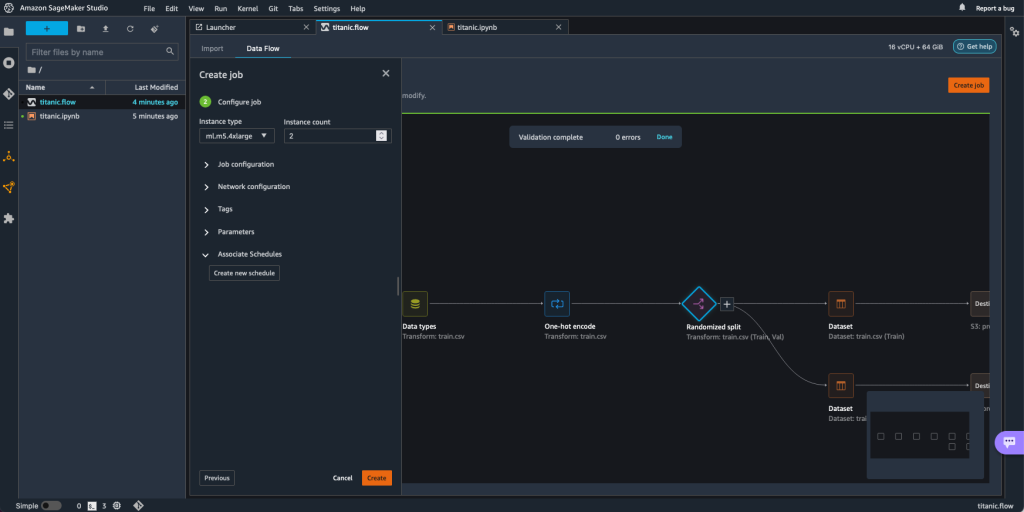

- 詳細 アソシエイト スケジュール.

- 選択する 新しいスケジュールを作成.

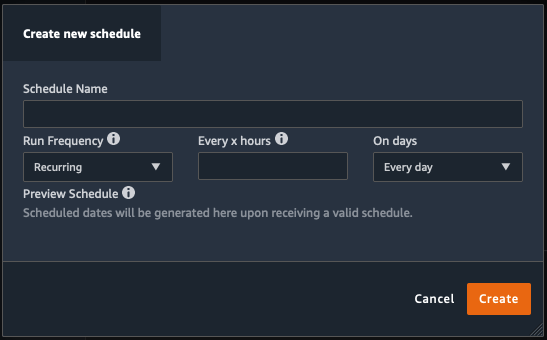

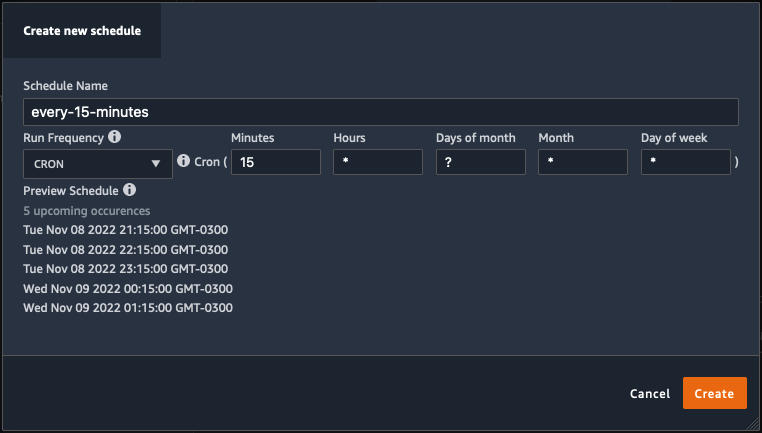

新しいスケジュールを作成 ダイアログが開き、処理ジョブのスケジュールの詳細を定義します。

このダイアログは、スケジュールを定義するのに役立つ優れた柔軟性を提供します。 たとえば、特定の曜日の特定の時刻または X 時間ごとに処理ジョブを実行することができます。

周期性は、分レベルまで細かく設定できます。

- スケジュール名と周期を定義し、 創造する スケジュールを保存します。

- 将来の実行を処理するスケジューリングと共に処理ジョブをすぐに開始するか、ジョブを残してスケジュールに従ってのみ実行するかを選択できます。

- 同じ処理ジョブに対して追加のスケジュールを定義することもできます。

- 処理ジョブのスケジュールを終了するには、 創造する.

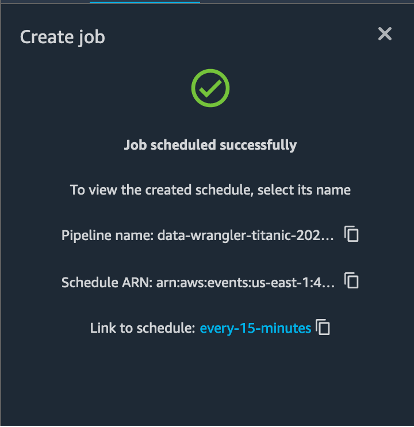

「ジョブが正常にスケジュールされました」というメッセージが表示されます。 さらに、ジョブをスケジュールに従ってのみ実行することを選択した場合は、作成した EventBridge ルールへのリンクが表示されます。

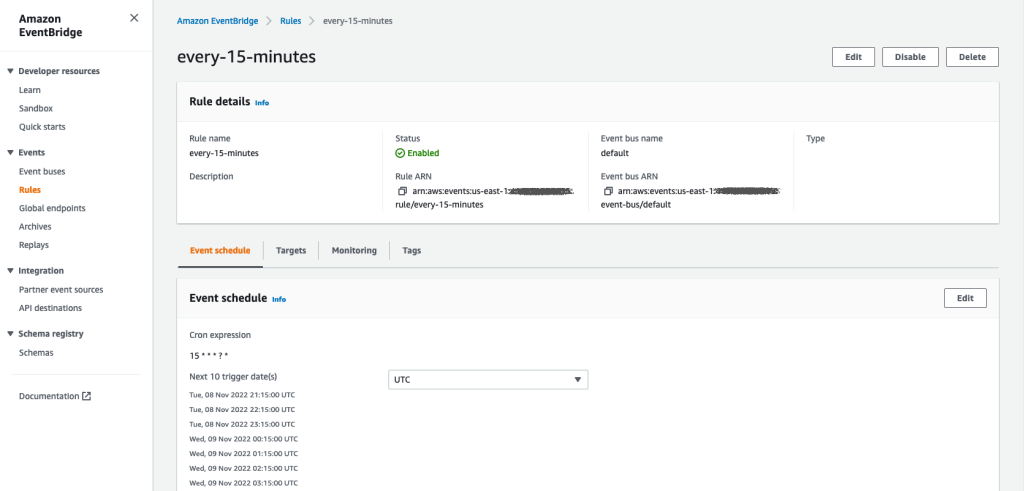

スケジュール リンクを選択すると、ブラウザの新しいタブが開き、EventBridge ルールが表示されます。 このページでは、ルールをさらに変更し、その呼び出し履歴を追跡できます。 スケジュールされた処理ジョブの実行を停止するには、スケジュール名を含むイベント ルールを削除します。

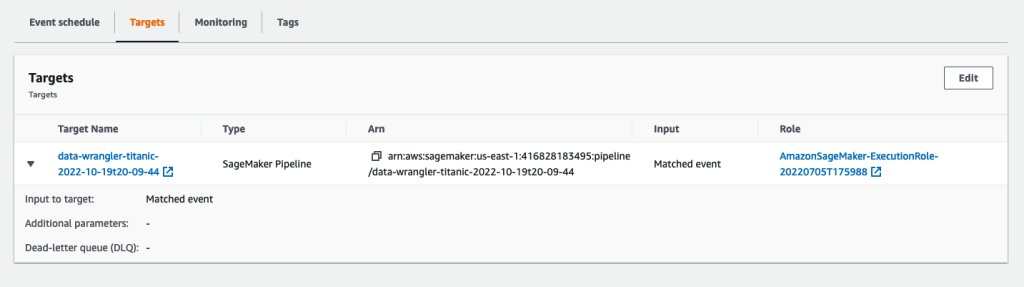

EventBridge ルールは、定義されたスケジュールに従ってトリガーされる SageMaker パイプラインをターゲットとして示し、パイプラインの一部として呼び出される処理ジョブを示します。

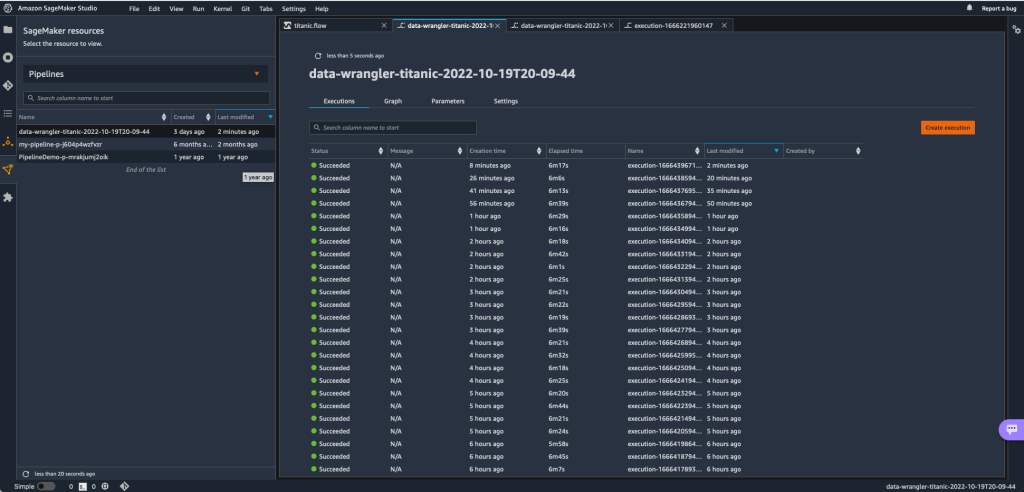

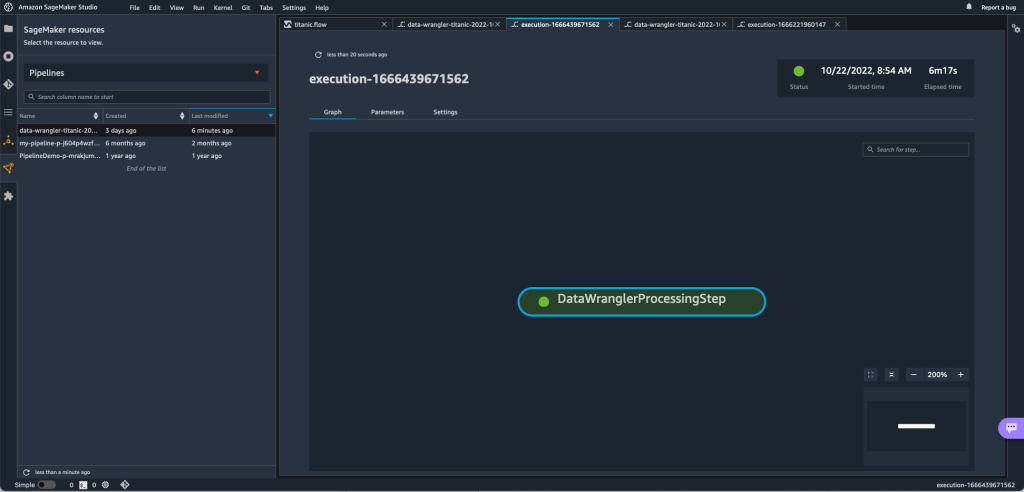

SageMaker パイプラインの実行を追跡するには、Studio に戻り、 SageMakerリソース アイコンを選択 パイプラインをクリックして、追跡するパイプライン名を選択します。 現在および過去のすべての実行とそのパイプラインのステータスを含むテーブルを表示できるようになりました。

特定のエントリをダブルクリックすると、詳細を表示できます。

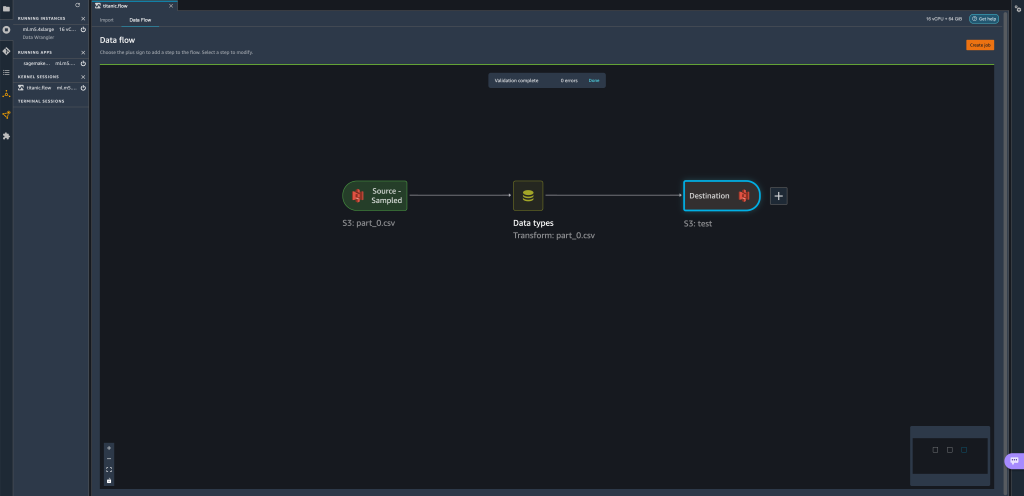

クリーンアップ

Data Wrangler を使用していない場合は、追加料金が発生しないように、Data Wrangler が実行されているインスタンスをシャットダウンすることをお勧めします。

作業が失われないように、Data Wrangler をシャットダウンする前にデータ フローを保存してください。

- データ フローを Studio に保存するには、次を選択します。 File、を選択します データラングラーの流れを保存. Data Wrangler は、60 秒ごとにデータ フローを自動的に保存します。

- Data Wrangler インスタンスをシャットダウンするには、Studio で、 インスタンスとカーネルの実行.

- アプリの実行の横にあるシャットダウン アイコンを選択します。

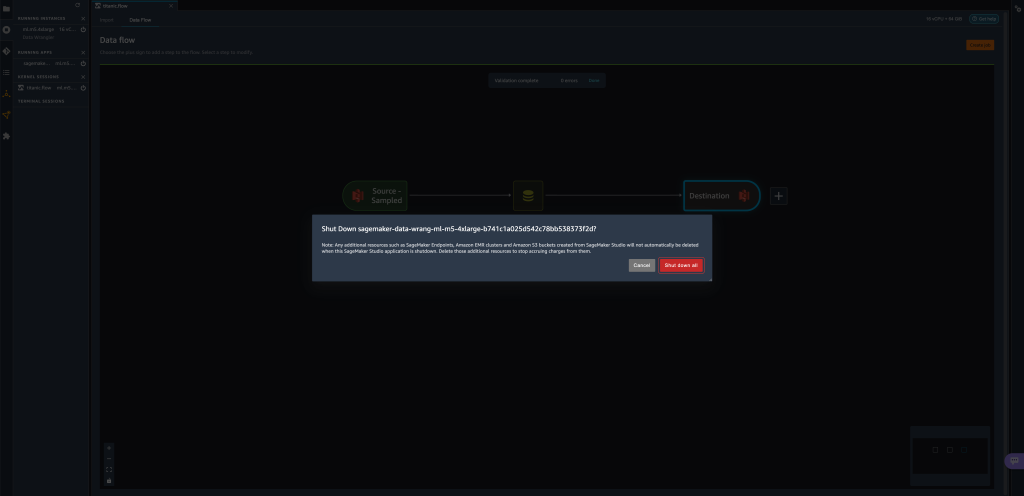

sagemaker-data-wrangler-1.0アプリ。

- 選択する すべてシャットダウン 確認します。

Data Wrangler は ml.m5.4xlarge インスタンスで実行されます。 このインスタンスは インスタンスの実行 Data Wrangler アプリをシャットダウンしたとき。

Data Wrangler アプリをシャットダウンした後、次に Data Wrangler フロー ファイルを開くときに再起動する必要があります。 これには数分かかる場合があります。

まとめ

この投稿では、パラメーターを使用して、Data Wrangler フローを使用してデータセットをインポートし、データ変換ジョブを作成する方法を示しました。 パラメーター化されたデータセットを使用すると、使用するデータセットの柔軟性が高まり、フローを再利用できます。 また、Data Wrangler のユーザー インターフェイス内から直接、ニーズに合った時間と周期で、データ変換と Amazon S3 または Feature Store へのエクスポートを自動化するスケジュール ジョブを設定する方法も示しました。

データラングラーでのデータフローの使用の詳細については、以下を参照してください。 データラングラーフローの作成と使用 & Amazon SageMakerの価格。 データラングラーの使用を開始するには、を参照してください。 Amazon SageMaker Data Wrangler で ML データを準備する.

著者について

デビッドラレド は、Amazon Web Services のプロトタイピングおよびクラウド エンジニアリング チームのプロトタイピング アーキテクトであり、AWS のお客様向けに複数の機械学習プロトタイプの開発を支援してきました。 彼は過去 6 年間機械学習に取り組んでおり、ML モデルのトレーニングと微調整、およびそれらのモデルを製品化するためのエンドツーエンドのパイプラインの実装に取り組んできました。 彼の関心のある分野は、NLP、ML アプリケーション、およびエンドツーエンドの ML です。

デビッドラレド は、Amazon Web Services のプロトタイピングおよびクラウド エンジニアリング チームのプロトタイピング アーキテクトであり、AWS のお客様向けに複数の機械学習プロトタイプの開発を支援してきました。 彼は過去 6 年間機械学習に取り組んでおり、ML モデルのトレーニングと微調整、およびそれらのモデルを製品化するためのエンドツーエンドのパイプラインの実装に取り組んできました。 彼の関心のある分野は、NLP、ML アプリケーション、およびエンドツーエンドの ML です。

ジバニルド・アウヴェス は、Amazon Web Services のプロトタイピングおよびクラウド エンジニアリング チームのプロトタイピング アーキテクトであり、人工知能に関するいくつかのプロトタイプをすでに実装しており、AWS で可能な技術を示すことでクライアントの革新と加速を支援しています。 彼はソフトウェア エンジニアリングで長いキャリアを持ち、以前は Amazon.com.br でソフトウェア開発エンジニアとして働いていました。

ジバニルド・アウヴェス は、Amazon Web Services のプロトタイピングおよびクラウド エンジニアリング チームのプロトタイピング アーキテクトであり、人工知能に関するいくつかのプロトタイプをすでに実装しており、AWS で可能な技術を示すことでクライアントの革新と加速を支援しています。 彼はソフトウェア エンジニアリングで長いキャリアを持ち、以前は Amazon.com.br でソフトウェア開発エンジニアとして働いていました。

エイドリアン・フェンテス は、Amazon Web Services のプロトタイピングおよびクラウド エンジニアリング チームのプログラム マネージャーであり、機械学習、IoT、およびブロックチェーンで顧客のために革新を行っています。 プロジェクトの管理と実装に 15 年以上の経験があり、AWS で 1 年間勤務しています。

エイドリアン・フェンテス は、Amazon Web Services のプロトタイピングおよびクラウド エンジニアリング チームのプログラム マネージャーであり、機械学習、IoT、およびブロックチェーンで顧客のために革新を行っています。 プロジェクトの管理と実装に 15 年以上の経験があり、AWS で 1 年間勤務しています。