これは、Getir の Nafi Ahmet Turgut、Hasan Burak Yel、Damla Şentürk が共同執筆したゲスト投稿です。

2015に設立され、 もたらしました は、超高速食料品配達の分野における先駆者としての地位を確立しました。 この革新的なテクノロジー企業は、「数分で食料品を」という魅力的なサービスで、ラスト マイルの配達セグメントに革命をもたらしました。 トルコ、英国、オランダ、ドイツ、米国に拠点を置くゲティルは、数え切れないほどの多国籍勢力となっています。 現在、Getir ブランドは XNUMX つの異なる業種を網羅する多角的な複合企業体を表しており、すべてが単一の傘下で相乗的に機能しています。

この投稿では、以下を使用して商業チームを支援するエンドツーエンドの製品カテゴリ予測パイプラインをどのように構築したかについて説明します。 アマゾンセージメーカー および AWSバッチ、モデルのトレーニング時間を 90% 短縮します。

当社の既存の製品品揃えを詳細に理解することは、今日のペースが速く競争の激しい市場において、多くの企業と同様に当社が直面する重要な課題です。 この問題に対する効果的な解決策は、製品カテゴリの予測です。 包括的なカテゴリ ツリーを生成するモデルにより、当社の営業チームは既存の製品ポートフォリオを競合他社の製品ポートフォリオと比較してベンチマークすることができ、戦略的優位性が得られます。 したがって、私たちの中心的な課題は、正確な製品カテゴリ予測モデルの作成と実装です。

私たちは AWS が提供する強力なツールを活用してこの課題に取り組み、機械学習 (ML) と予測分析の複雑な分野を効果的にナビゲートしました。 私たちの取り組みの結果、SageMaker と AWS Batch の長所を組み合わせた、エンドツーエンドの製品カテゴリ予測パイプラインの作成に成功しました。

この予測分析の機能、特に製品カテゴリの正確な予測は、非常に貴重であることが証明されています。 これにより、在庫管理を最適化し、顧客とのやり取りを強化し、市場での存在感を強化する重要なデータ主導の洞察が当社のチームに提供されました。

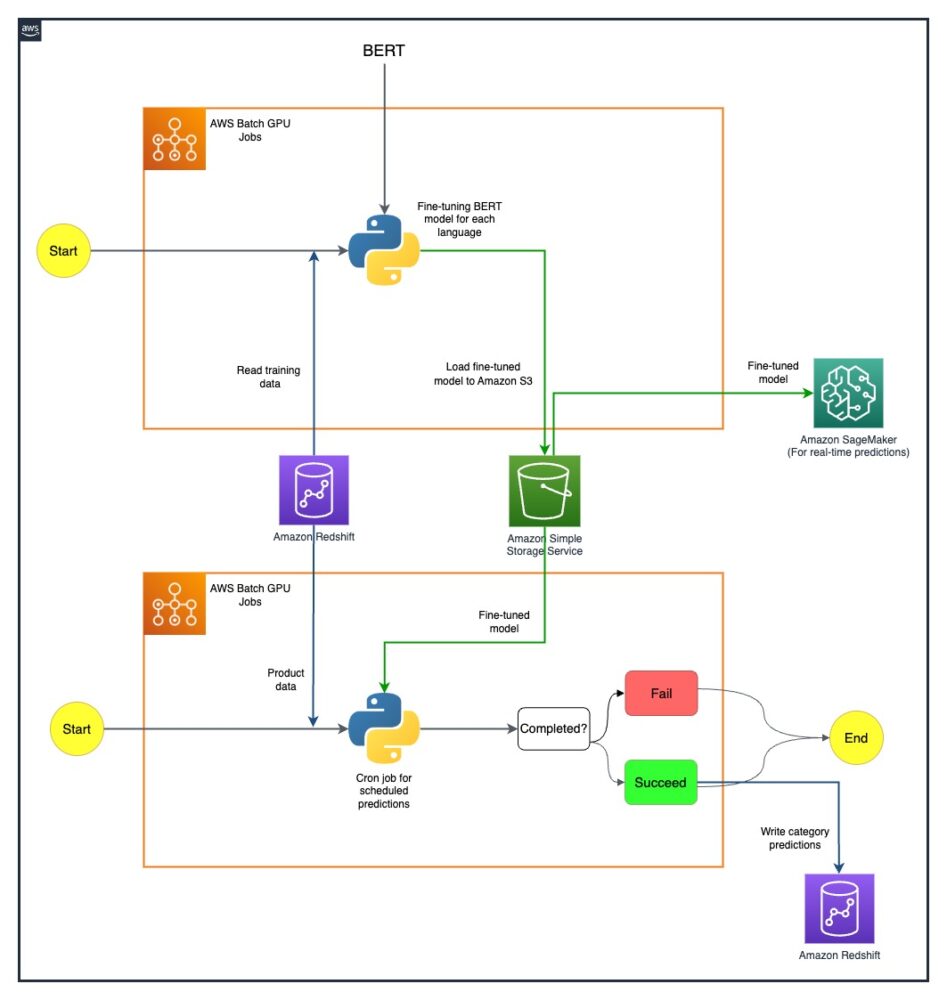

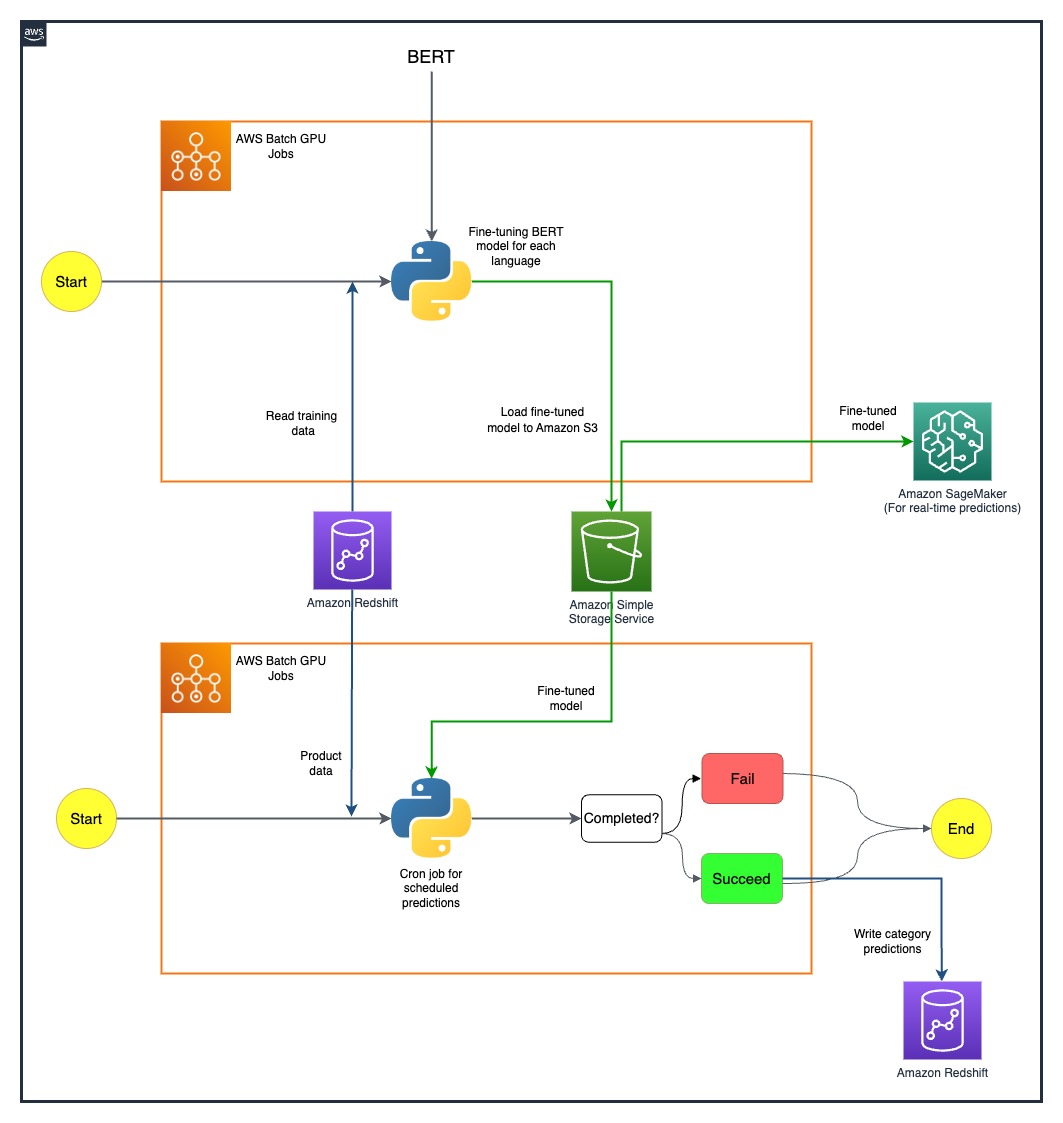

この投稿で説明する方法論は、特徴セット収集の初期段階から予測パイプラインの最終実装まで多岐にわたります。 私たちの戦略の重要な側面は、SageMaker と AWS Batch を使用して、事前トレーニングされた BERT モデルを XNUMX つの異なる言語に合わせて改良することです。 さらに、AWS のオブジェクト ストレージ サービスとのシームレスな統合 Amazon シンプル ストレージ サービス (Amazon S3) は、これらの洗練されたモデルを効率的に保存し、アクセスするための鍵となってきました。

SageMaker はフルマネージド ML サービスです。 SageMaker を使用すると、データ サイエンティストと開発者は、ML モデルを迅速かつ簡単に構築およびトレーニングし、本番環境に対応したホスト環境に直接デプロイできます。

フルマネージドサービスである AWS Batch は、あらゆる規模のバッチコンピューティングワークロードの実行に役立ちます。 AWS Batch は、コンピューティング リソースを自動的にプロビジョニングし、ワークロードの量と規模に基づいてワークロードの分散を最適化します。 AWS Batch を使用すると、バッチ コンピューティング ソフトウェアのインストールや管理が必要ないため、結果の分析と問題の解決に時間を集中できます。 インスタンスの GPU を使用するジョブの実行に役立つ GPU ジョブを使用しました。

ソリューションの概要

Getir のデータ サイエンス チームとインフラストラクチャ チームの XNUMX 人がこのプロジェクトに協力しました。 プロジェクトは XNUMX か月で完了し、XNUMX 週間のテスト後に実稼働環境にデプロイされました。

次の図は、ソリューションのアーキテクチャを示しています。

モデル パイプラインは国ごとに個別に実行されます。 このアーキテクチャには、定義されたスケジュールで実行される、国ごとに XNUMX つの AWS Batch GPU cron ジョブが含まれています。

私たちは、SageMaker と AWS Batch GPU リソースを戦略的にデプロイすることで、いくつかの課題を克服しました。 それぞれの困難に対処するために使用されるプロセスについては、次のセクションで詳しく説明します。

AWS Batch GPU ジョブを使用して多言語 BERT モデルを微調整する

私たちは、多様なユーザー ベースに合わせて複数の言語をサポートするソリューションを模索しました。 BERT モデルは、複雑な自然言語タスクを効果的に処理する能力が確立されているため、当然の選択でした。 これらのモデルをニーズに合わせて調整するために、シングルノード GPU インスタンス ジョブを使用して AWS の力を活用しました。 これにより、サポートが必要な XNUMX つの言語ごとに、事前トレーニングされた BERT モデルを微調整することができました。 この方法により、潜在的な言語の壁を克服し、製品カテゴリーを高精度で予測できるようになりました。

Amazon S3 を使用した効率的なモデルのストレージ

次のステップは、モデルの保存と管理に取り組むことでした。 このために、スケーラビリティとセキュリティで知られる Amazon S3 を選択しました。 微調整された BERT モデルを Amazon S3 に保存することで、組織内のさまざまなチームに簡単にアクセスできるようになり、導入プロセスが大幅に合理化されました。 これは、業務の俊敏性と ML の取り組みのシームレスな統合を実現する上で重要な側面でした。

エンドツーエンドの予測パイプラインの作成

事前トレーニングされたモデルを最大限に活用するには、効率的なパイプラインが必要でした。 私たちは最初にこれらのモデルを SageMaker にデプロイしました。これにより、低遅延でのリアルタイム予測が可能になり、それによってユーザー エクスペリエンスが向上しました。 当社の運用にとって同様に重要な大規模なバッチ予測には、AWS Batch GPU ジョブを利用しました。 これにより、リソースが最適に使用され、パフォーマンスと効率の完璧なバランスが実現されました。

SageMaker MME で将来の可能性を探る

ML パイプラインの進化と効率化を追求し続ける中で、私たちが熱心に検討している手段の XNUMX つは、微調整されたモデルをデプロイするために SageMaker マルチモデル エンドポイント (MME) を使用することです。 MME を使用すると、さまざまな微調整されたモデルのデプロイメントを潜在的に合理化し、効率的なモデル管理を確保しながら、シャドウ バリアント、自動スケーリング、 アマゾンクラウドウォッチ 統合。 この探求は、予測分析機能を強化し、お客様に優れたエクスペリエンスを提供するという当社の継続的な追求と一致しています。

まとめ

SageMaker と AWS Batch の統合に成功したことで、当社特有の課題に対処しただけでなく、運用効率も大幅に向上しました。 洗練された製品カテゴリ予測パイプラインの実装を通じて、当社はデータに基づいた洞察を商業チームに提供することができ、それによってより効果的な意思決定を促進します。

私たちの結果は、私たちのアプローチの有効性を雄弁に物語っています。 当社は、カテゴリー粒度の 80 つのレベルすべてにわたって XNUMX% の予測精度を達成しました。これは、当社がサービスを提供する各国の製品の品揃えを形成する上で重要な役割を果たしています。 このレベルの精度により、言語の壁を超えて当社の対応範囲が広がり、多様なユーザー ベースに最大限の精度で対応できるようになります。

さらに、スケジュールされた AWS Batch GPU ジョブを戦略的に使用することで、モデルのトレーニング時間を 90% 短縮することができました。 この効率化により、プロセスがさらに合理化され、運用の機敏性が強化されました。 Amazon S3 を使用した効率的なモデルストレージは、リアルタイム予測とバッチ予測の両方のバランスをとり、この達成において重要な役割を果たしました。

SageMaker を使用して独自の ML パイプラインの構築を開始する方法の詳細については、以下を参照してください。 AmazonSageMakerリソース。 AWS Batch は、低い運用オーバーヘッドでバッチジョブを実行するための、低コストでスケーラブルなソリューションをお探しの場合に最適なオプションです。 開始するには、を参照してください。 AWS Batch の使用開始.

著者について

ナフィ・アフメット・トゥルグト 電気電子工学の修士号を取得し、大学院研究員として働いていました。 彼の焦点は、神経ネットワークの異常をシミュレートする機械学習アルゴリズムの構築でした。 彼は 2019 年に Getir に入社し、現在はシニア データ サイエンス & アナリティクス マネージャーとして働いています。 彼のチームは、Getir のエンドツーエンドの機械学習アルゴリズムとデータ駆動型ソリューションの設計、実装、保守を担当しています。

ナフィ・アフメット・トゥルグト 電気電子工学の修士号を取得し、大学院研究員として働いていました。 彼の焦点は、神経ネットワークの異常をシミュレートする機械学習アルゴリズムの構築でした。 彼は 2019 年に Getir に入社し、現在はシニア データ サイエンス & アナリティクス マネージャーとして働いています。 彼のチームは、Getir のエンドツーエンドの機械学習アルゴリズムとデータ駆動型ソリューションの設計、実装、保守を担当しています。

ハサン・ブラク・イェル ボアジチ大学で電気電子工学の学士号を取得しました。 彼は Turkcell で勤務し、主に時系列予測、データ視覚化、ネットワーク自動化に重点を置いていました。 彼は 2021 年に Getir に入社し、現在、検索、レコメンデーション、成長ドメインを担当するデータ サイエンス & 分析マネージャーとして働いています。

ハサン・ブラク・イェル ボアジチ大学で電気電子工学の学士号を取得しました。 彼は Turkcell で勤務し、主に時系列予測、データ視覚化、ネットワーク自動化に重点を置いていました。 彼は 2021 年に Getir に入社し、現在、検索、レコメンデーション、成長ドメインを担当するデータ サイエンス & 分析マネージャーとして働いています。

ダムラ・シェンテュルク ガラタサライ大学でコンピューター工学の学士号を取得しました。 彼女はボアジチ大学でコンピュータ エンジニアリングの修士号を取得し続けています。 彼女は 2022 年に Getir に入社し、データ サイエンティストとして働いています。 彼女は商業、サプライ チェーン、ディスカバリー関連のプロジェクトに取り組んできました。

ダムラ・シェンテュルク ガラタサライ大学でコンピューター工学の学士号を取得しました。 彼女はボアジチ大学でコンピュータ エンジニアリングの修士号を取得し続けています。 彼女は 2022 年に Getir に入社し、データ サイエンティストとして働いています。 彼女は商業、サプライ チェーン、ディスカバリー関連のプロジェクトに取り組んできました。

エスラ・カヤバリ AWS のシニア ソリューション アーキテクトであり、データ ウェアハウジング、データ レイク、ビッグ データ分析、バッチおよびリアルタイムのデータ ストリーミング、データ統合などの分析ドメインを専門としています。 彼女はソフトウェア開発とアーキテクチャに 12 年の経験があります。 彼女はクラウド テクノロジーの学習と教育に情熱を注いでいます。

エスラ・カヤバリ AWS のシニア ソリューション アーキテクトであり、データ ウェアハウジング、データ レイク、ビッグ データ分析、バッチおよびリアルタイムのデータ ストリーミング、データ統合などの分析ドメインを専門としています。 彼女はソフトウェア開発とアーキテクチャに 12 年の経験があります。 彼女はクラウド テクノロジーの学習と教育に情熱を注いでいます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :持っている

- :は

- :not

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- 能力

- できる

- 私たちについて

- アクセス

- アクセス

- 精度

- 正確な

- 達成

- 達成

- 達成する

- 越えて

- Action

- さらに

- 住所

- 対処する

- 利点

- 後

- に対して

- アルゴリズム

- 整列

- すべて

- 許可されて

- ことができます

- 沿って

- また

- Amazon

- アマゾンセージメーカー

- Amazon Webサービス

- an

- 分析論

- 分析する

- および

- とインフラ

- 異常

- どれか

- 建築

- です

- AS

- 側面

- 品揃え

- At

- オート

- 自動的に

- オートメーション

- 大通り

- AWS

- バランシング

- 障壁

- ベース

- ベース

- BE

- になる

- き

- ベンチマーク

- 恩恵を受ける

- BEST

- 越えて

- ビッグ

- ビッグデータ

- ブーストされた

- 両言語で

- ブランド

- ビルド

- 建物

- 内蔵

- ビジネス

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 缶

- 機能

- 機能

- 大文字で

- カテゴリ

- カテゴリー

- 応じます

- 中央の

- チェーン

- 挑戦する

- 課題

- 選択

- クラウド

- 組み合わせ

- コマーシャル

- 会社

- 説得力のある

- 競争力のある

- 競合他社

- 記入済みの

- 複雑な

- 包括的な

- 計算

- コンピュータ

- コンピューター工学

- コンピューティング

- コングロマリット

- 続ける

- 続ける

- 連続的な

- 国

- 創造

- 重大な

- 重大な

- 現在

- 顧客

- Customers

- データ

- データ分析

- データサイエンス

- データサイエンティスト

- データの可視化

- データ駆動型の

- 意思決定

- 定義済みの

- 度

- 配達

- 展開します

- 展開

- 展開する

- 展開

- 設計

- 詳細な

- 開発者

- 開発

- 異なります

- 難しさ

- 直接に

- ディストリビューション

- 異なる

- 多様化した

- ドメイン

- ドメイン

- 原因

- デュレーション

- 各

- 簡単に

- 効果的な

- 効果的に

- 有効

- 効率

- 効率

- 効率的な

- 効率良く

- 楽

- 努力

- 電子

- エンパワー

- 使用可能

- 包含する

- 端から端まで

- エンジニアリング

- 強化された

- 強化

- 確実

- 確実に

- 確保する

- 環境

- 平等に

- 設立

- 進化

- 優れた

- 既存の

- 体験

- エクスペリエンス

- 説明する

- 探査

- 探る

- 拡張する

- 顔

- 容易化する

- テンポの速い

- 特徴

- フィールド

- ファイナル

- 名

- フォーカス

- 焦点を当て

- フォロー中

- 強

- 予想

- 4

- から

- 完全に

- さらに

- 未来

- 集まり

- 生成

- ドイツ

- 取得する

- GPU

- GPU

- 卒業生

- 成長性

- ゲスト

- ゲストのポスト

- ハンドル

- 持ってる

- he

- 助けます

- ことができます

- 彼女の

- ハイ

- 彼の

- 主催

- 認定条件

- How To

- HTML

- HTTP

- HTTPS

- if

- 実装

- 実装

- 重要

- 重要な側面

- in

- 含ま

- 含めて

- 情報

- インフラ関連事業

- 初期

- 革新的な

- 洞察

- install

- 統合

- 相互作用

- に

- 貴重な

- インベントリー

- 在庫管理

- IT

- ITS

- 自体

- Jobs > Create New Job

- 参加した

- JPG

- キーン

- キー

- 既知の

- 湖

- 言語

- ESL, ビジネスESL <br> 中国語/フランス語、その他

- レイテンシ

- 学習

- ツェッペリン

- レベル

- レベル

- ような

- 探して

- ロー

- 低コストの

- 機械

- 機械学習

- 主に

- 保守

- make

- 管理します

- マネージド

- 管理

- マネージャー

- 方法

- 多くの

- 市場

- マスターの

- 方法

- 方法論

- 分

- ML

- モデル

- 月

- 他には?

- 多国籍

- の試合に

- ネイティブ

- ナチュラル

- ナビゲート

- 必要

- ニーズ

- オランダ

- ネットワーク

- 次の

- 9

- いいえ

- オブジェクト

- 明白

- of

- 提供すること

- on

- ONE

- の

- オペレーショナル

- 業務執行統括

- 最適な

- 最適化

- 最適化

- オプション

- or

- 注文

- 組織

- 私たちの

- 克服する

- 自分の

- 特に

- 情熱的な

- のワークプ

- 完璧

- パフォーマンス

- 相

- パイプライン

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 演奏

- 演劇

- ポートフォリオ

- 配置された

- の可能性

- ポスト

- 潜在的な

- :

- 電力

- 強力な

- 精度

- 予測

- 予測

- 予測

- 予測分析

- プレゼンス

- 問題

- 問題

- プロセス

- ラボレーション

- プロダクト

- 生産

- プロジェクト

- プロジェクト(実績作品)

- 実績のある

- 提供します

- 提供

- 提供

- 追求

- 量

- すぐに

- 範囲

- リーチ

- への

- リアルタイムデータ

- 受け

- おすすめ

- 減らします

- 電話代などの費用を削減

- 縮小

- リファイン

- 洗練された

- 表し

- の提出が必要です

- 研究

- リソース

- 責任

- 責任

- 結果

- 革命を起こした

- 職種

- ラン

- ランニング

- セージメーカー

- スケーラビリティ

- ド電源のデ

- 規模

- スケーリング

- 予定の

- 科学

- 科学者

- 科学者たち

- シームレス

- を検索

- セクション

- セキュリティ

- Seek

- セグメント

- 選択

- シニア

- シリーズ

- 役立つ

- サービス

- サービス

- セッションに

- セブン

- Shadow

- シェーピング

- 彼女

- 作品

- 著しく

- 簡単な拡張で

- 単数

- So

- ソフトウェア

- ソフトウェア開発

- 溶液

- ソリューション

- 解決

- 一部

- 洗練された

- 求め

- 話す

- 専門の

- 特定の

- 開始

- 米国

- 手順

- ストレージ利用料

- 保存

- 戦略的

- 戦略的に

- 戦略

- ストリーミング

- 流線

- 合理化された

- 合理化

- 強化された

- 強み

- 成功した

- 優れた

- 供給

- サプライチェーン

- サポート

- タックル

- テーラー

- タスク

- ティーチング

- チーム

- チーム

- テク

- テックカンパニー

- テクノロジー

- テスト

- それ

- オランダ

- 英国

- アプリ環境に合わせて

- それら

- その後

- それによって

- したがって、

- ボーマン

- この

- 介して

- 時間

- 時系列

- 〜へ

- 今日

- 今日の

- 一緒に

- 豊富なツール群

- 先駆者

- トレーニング

- トレーニング

- ツリー

- Turkey

- 2

- Uk

- 傘

- 下

- ユナイテッド

- 米国

- 大学

- us

- つかいます

- 中古

- ユーザー

- 操作方法

- 利用された

- 最大限

- さまざまな

- 垂直

- 可視化

- 極めて重要な

- ボリューム

- ました

- we

- ウェブ

- Webサービス

- 週間

- した

- which

- while

- 以内

- 働いていました

- ワーキング

- 作品

- 年

- You

- あなたの

- ゼファーネット