AI言語モデルを活用してコードのデバッグからデータの異常検出まで、, DALL-E, 安定拡散、その他の生成型 AI は世界を席巻しました。 彼らは素晴らしい詩やイメージを生み出します。 彼らは、マーケティングから法的準備書面の作成、創薬に至るまで、私たちの世界の隅々にまで浸透しています。 彼らは、人間と機械の心が融合した成功物語の象徴のように見えます。

しかし、内部では事態はそれほど甘くないように見えます。 これらのシステムは大量のエネルギーを消費し、数千トンの二酸化炭素を排出するデータセンターを必要とし、すでに不安定な気候をさらに強調し、数十億ドルを吸い上げます。 ニューラル ネットワークがより洗練され、より広く使用されるようになるにつれて、エネルギー消費はさらに急増する可能性があります。

生成型 AI に大量のインクがこぼれた カーボンフットプリント。 エネルギー需要がその衰退の原因となり、さらに成長するにつれて発展を妨げる可能性があります。 現在のハードウェアを使用すると、生成 AI は「標準のコンピューティング ハードウェアに依存し続けるとすぐに失速すると予想されます」。 と インテル研究所のHechen Wang博士。

持続可能な AI を構築する時期が来ています。

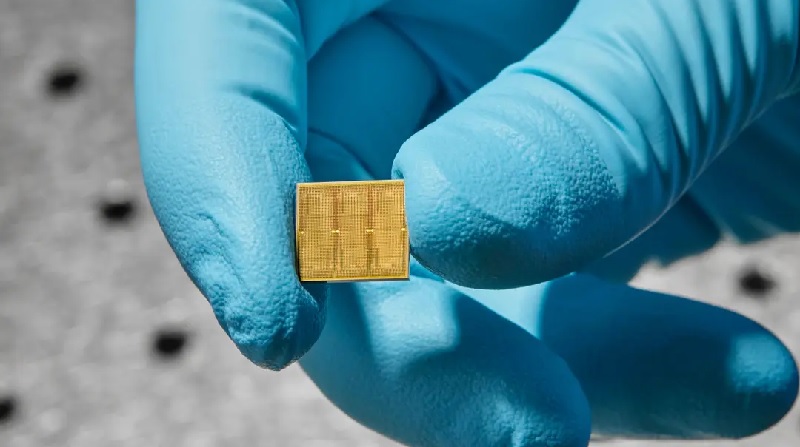

今週、 調査 IBM からは、その方向に向けて実際的な一歩を踏み出しました。 彼らは、14 万個のメモリ ユニットを搭載した 35 ナノメートルのアナログ チップを作成しました。 現在のチップとは異なり、計算はこれらのユニット内で直接行われるため、データを往復する必要がなくなり、エネルギーが節約されます。

データの往復により、エネルギー消費が実際の計算に必要なエネルギー消費量の 3 倍から 10,000 倍に増加する可能性があると Wang 氏は述べています。

このチップは、XNUMX つの音声認識タスクに挑戦したときに非常に効率的でした。 XNUMX つの Google Speech Commands は小さいですが実用的です。 ここではスピードが鍵となります。 もう XNUMX つの Librispeech は、音声をテキストに書き写すのに役立つ巨大なシステムで、大量のデータを処理するチップの能力に負担をかけます。

従来のコンピューターと比較した場合、このチップは同等の精度で動作しましたが、一部のタスクに通常必要とされるエネルギーの XNUMX 分の XNUMX 以下で、はるかに少ないエネルギーでより速くジョブを完了しました。

「我々の知る限り、これらは商業的に適切な精度レベルを商業的に適切なモデルで、効率性と大規模な並列性を備えてアナログチップで実証したのは初めてだ」と研究チームは述べた。

ブレイニーバイト

これは決して最初のアナログチップではありません。 しかし、これはニューロモーフィック コンピューティングのアイデアを実用の領域に押し上げます。いつか、脳に近い効率で携帯電話、スマート ホーム、その他のデバイスに電力を供給できるチップです。

えっと、何? バックアップしましょう。

現在のコンピューターは、 フォンノイマンアーキテクチャ。 複数の部屋がある家と考えてください。 XNUMX つは中央処理装置 (CPU) で、データを分析します。 もう XNUMX つはメモリを保存します。

計算ごとに、コンピューターはこれら XNUMX つの部屋の間でデータを往復する必要があり、時間とエネルギーがかかり、効率が低下します。

対照的に、脳は計算と記憶の両方をワンルームアパートに組み合わせています。 シナプスと呼ばれるキノコのような接合部は、両方ともニューラル ネットワークを形成し、同じ場所に記憶を保存します。 シナプスは非常に柔軟性があり、保存された記憶と新しい学習、つまり「重み」と呼ばれる特性に基づいて、他のニューロンとの結合の強さを調整します。 私たちの脳は、これらのシナプスの重みを調整することで、絶えず変化する環境に素早く適応します。

IBMは設計の最前線に立ってきました アナログチップ それを真似する 脳の計算。 画期的な進歩 2016年に来ました、書き換え可能なCDに通常見られる魅力的な素材に基づいたチップを導入したとき。 この材料は、電気を当てると物理的状態が変化し、ネバネバしたスープから結晶のような構造に形状が変化します。デジタルの 0 と 1 に似ています。

ここが重要です。チップはハイブリッド状態でも存在できるということです。 言い換えれば、生物学的シナプスと同様に、人工シナプスはバイナリだけでなく無数の異なる重みをエンコードできるため、データを XNUMX ビットも移動することなく複数の計算を蓄積することができます。

ジキルとハイド

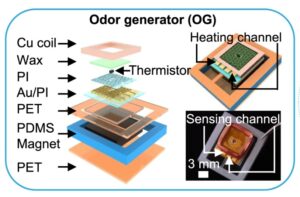

新しい研究は、相変化材料も使用することにより、以前の研究に基づいて構築されました。 基本コンポーネントは「メモリータイル」です。 それぞれに何千もの相変化材料が格子状に詰め込まれています。 タイルは互いに容易に通信します。

各タイルはプログラム可能なローカル コントローラーによって制御されるため、チームはニューロンに似たコンポーネントを正確に微調整できます。 さらに、チップは何百ものコマンドを順番に保存し、そのパフォーマンスを掘り下げて分析できる一種のブラック ボックスを作成します。

全体として、チップには 35 万個の相変化メモリ構造が含まれていました。 接続数は 45 万のシナプスに達し、人間の脳とは程遠いものの、14 ナノメートルのチップ上では非常に印象的です。

これらの気が遠くなるような数字は、AI チップの初期化に問題を引き起こします。つまり、探索するにはパラメータが多すぎるのです。 研究チームは、計算を開始する前にシナプスの重みを事前にプログラミングするという、AI 幼稚園に相当する問題に取り組みました。 (これは、新しい鋳鉄鍋で調理する前に味付けするのと少し似ています。)

彼らは「ハードウェアの利点と限界を念頭に置いてネットワーク トレーニング技術を調整し」、最適な結果が得られるように重みを設定したと、研究には関与していない Wang 氏は説明しました。

それはうまくいきました。 ある最初のテストでは、チップは電力 12.4 ワットあたり XNUMX 秒あたり XNUMX 兆回の動作を容易に実行しました。 エネルギー消費量は「最も強力な CPU や GPU よりも数十倍、さらには数百倍も高い」と Wang 氏は述べています。

このチップは、メモリ タイル内のわずか数個の古典的なハードウェア コンポーネントを使用して、ディープ ニューラル ネットワークの基礎となるコア計算プロセスを確立しました。 対照的に、従来のコンピューターには数百または数千のトランジスタ (計算を実行する基本単位) が必要です。

町の話

次にチームは、このチップに XNUMX つの音声認識タスクを課しました。 それぞれがチップの異なる側面を強調しました。

最初のテストは、比較的小さなデータベースを使用した場合の速度でした。 の使用 Google音声コマンド このタスクでは、数千人が 12 語の短い単語を話している約 65,000 個のクリップのセットから 30 のキーワードを AI チップが見つけ出す必要がありました (「小さい」は深層学習の世界では相対的なものです)。 認められたベンチマークを使用する場合—MLPerf— チップのパフォーマンスが XNUMX 倍高速になりました 前作よりも.

このチップは大規模なデータベースに挑戦したときにも輝きました。 リブスピーチ。 このコーパスには、AI による音声解析や自動音声テキスト変換のトレーニングに一般的に使用される 1,000 時間以上の読み上げられた英語音声が含まれています。

全体として、チームは 45 つのチップを使用して、140 億 14 万個の相変化デバイスからのデータを使用して最終的に 550 万を超える重みをエンコードしました。 従来のハードウェアと比較した場合、このチップはエネルギー効率が約 9 倍高く、エネルギー消費 XNUMX ワットあたり毎秒 XNUMX 近くのサンプルを処理し、エラー率は XNUMX% をわずかに上回りました。

素晴らしいものではありますが、アナログ チップはまだ初期段階にあります。 これらは「AIに関連する持続可能性の問題と闘う上で非常に有望である」とワン氏は述べた。しかし、前進するにはさらにいくつかのハードルをクリアする必要がある。

要因の XNUMX つは、メモリ テクノロジ自体とその周囲のコンポーネントの設計、つまりチップのレイアウトを工夫することです。 IBMの新しいチップには、必要な要素がすべてまだ含まれていない。 次の重要なステップは、その有効性を維持しながら、すべてを XNUMX つのチップに統合することです。

ソフトウェア側では、特にアナログチップに合わせたアルゴリズムや、コードを機械が理解できる言語に容易に変換するソフトウェアも必要になります。 これらのチップが商業的に実現可能になるにつれて、専用アプリケーションを開発することで、アナログ チップの将来の夢を生き続けることができます。

「CPU と GPU が非常にうまく動作する計算エコシステムを形成するのに数十年かかりました」と Wang 氏は言います。 「そして、アナログ AI にも同様の環境を確立するには、おそらく何年もかかるでしょう。」

画像のクレジット: IBMのライアン・ラビン

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 自動車/EV、 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- チャートプライム。 ChartPrime でトレーディング ゲームをレベルアップしましょう。 こちらからアクセスしてください。

- ブロックオフセット。 環境オフセット所有権の近代化。 こちらからアクセスしてください。

- 情報源: https://singularityhub.com/2023/08/25/ibms-brain-inspired-analog-chip-aims-to-make-ai-more-sustainable/

- :持っている

- :は

- :not

- $UP

- 000

- 1

- 10

- 12

- 14

- 30

- 9

- a

- 能力

- 上記の.

- 一般に認められた

- 累積する

- 精度

- 正確にデジタル化

- 実際の

- 適応する

- に対して

- AI

- 目指して

- アルゴリズム

- すべて

- 許可

- ことができます

- 既に

- また

- 金額

- an

- 分析します

- 分析

- および

- 別の

- どこにでも

- 検索&予約

- です

- 人工の

- AS

- 関連する

- At

- オートマチック

- バック

- ベース

- 基本

- BE

- になる

- き

- 始まる

- 利点

- の間に

- 億

- ビット

- ブラック

- 両言語で

- ボックス

- 脳

- 画期的な

- ビルド

- 内蔵

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 計算

- 呼ばれます

- 缶

- カーボン

- CDS

- センター

- 中央の

- 挑戦した

- 変更

- 子

- チップ

- チップ

- 決済

- クリップ

- コード

- 組み合わせ

- 商業的に

- 一般に

- 伝える

- コンポーネント

- 計算

- 計算

- コンピュータ

- コンピューター

- コンピューティング

- お問合せ

- Connections

- 消費

- 含む

- 含まれている

- 含まれています

- 続ける

- コントラスト

- 制御

- コントローラ

- 従来の

- 基本

- 可能性

- 作ります

- 作成した

- 作成

- クレジット

- 重大な

- 電流プローブ

- データ

- データセンター

- データベース

- データセット

- 中

- 数十年

- 減少

- 専用の

- 深いです

- 深い学習

- 需要

- 設計

- 設計

- 開発

- 開発

- Devices

- 異なります

- DIG

- デジタル

- 方向

- 直接に

- 発見

- ありません

- ドル

- 没落

- dr

- 夢

- 薬

- 各

- 生態系

- 効能

- 効率

- 効率的な

- 要素は

- エネルギー

- エネルギー消費

- 英語

- 環境

- 平等に

- エラー

- 確立する

- さらに

- 最終的に

- 刻々と変化する

- あらゆる

- すべてのもの

- 存在する

- 説明

- 要因

- 遠く

- ファークライ

- 魅惑的な

- 速いです

- 少数の

- 名

- フレキシブル

- 最前線

- フォーム

- 前進

- フォワード

- 発見

- から

- さらに

- 未来

- 生々しい

- 生成AI

- でログイン

- GPU

- グリッド

- 育ちます

- ハンド

- 起こります

- Hardware

- 持ってる

- 持って

- ことができます

- こちら

- ハイ

- より高い

- 非常に

- ホーム

- フード

- HOURS

- お家の掃除

- 認定条件

- しかしながら

- HTML

- HTTPS

- 人間

- 何百

- ハードル

- ハイブリッド

- IBM

- アイデア

- if

- 画像

- 画像

- 印象的

- in

- その他の

- 増える

- ますます

- 初期

- 統合

- インテル

- に

- 導入

- 関係する

- IT

- ITS

- 自体

- ジョブ

- JPG

- ただ

- キープ

- キー

- キーワード

- 知識

- ラボ

- 言語

- 大

- 学習

- リーガルポリシー

- less

- レベル

- ような

- 可能性が高い

- 制限

- ローカル

- 場所

- 探して

- マシン

- 保守

- make

- 多くの

- マーケティング

- 大規模な

- 材料

- 材料

- 最大幅

- 思い出

- メモリ

- 百万

- マインド

- 他には?

- 最も

- の試合に

- 無数の

- 自然

- 近く

- ほぼ

- 必要

- 必要とされる

- ニーズ

- ネットワーク

- ニューラルネットワーク

- ニューロモルフィックコンピューティング

- ニューロン

- 新作

- 新しいチップ

- 次の

- 通常は

- 番号

- of

- on

- ONE

- 〜に

- 操作する

- 業務執行統括

- 最適な

- or

- その他

- 私たちの

- でる

- が

- パック

- パラメータ

- path

- のワークプ

- 以下のために

- パーセント

- パフォーマンス

- 実行

- 実行する

- 電話

- 物理的な

- あばたのあります

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 詩

- 電力

- 強力な

- 実用的

- 精度

- 現在

- 前

- 多分

- 問題

- 問題

- プロセス

- 処理

- 約束

- 財産

- プッシュ

- すぐに

- レート

- 読む

- realm

- 認識

- 相対

- 相対的に

- 関連した

- 頼る

- の提出が必要です

- 必要

- 安静

- 結果

- 客室

- 大体

- 前記

- 同じ

- 節約

- 二番

- Seek

- 思われる

- シーケンス

- セッションに

- セブン

- 形状

- ショート

- 表示する

- 側

- 同様の

- 単に

- 急騰します

- 小さい

- スマート

- スマートホーム

- So

- ソフトウェア

- 一部

- すぐに

- 洗練された

- 話す

- 特に

- スピーチ

- 音声認識

- 音声テキスト

- スピード

- Spot

- 標準

- 都道府県

- 手順

- まだ

- 店舗

- 保存され

- 店舗

- ストーム

- ストーリー

- 強く

- 構造

- 構造

- 研究

- 勉強

- 成功

- サクセスストーリー

- 首尾よく

- 周囲の

- 3つの柱

- 持続可能な

- Synapse

- シナプス

- システム

- 取る

- 撮影

- 取り

- 仕事

- タスク

- チーム

- テクニック

- テクノロジー

- test

- より

- それ

- 世界

- アプリ環境に合わせて

- それら

- その後

- そこ。

- ボーマン

- 彼ら

- 物事

- 考える

- それらの

- 数千

- 介して

- 時間

- <font style="vertical-align: inherit;">回数</font>

- 〜へ

- トーン

- あまりに

- 取った

- 伝統的な

- トレーニング

- 1兆

- 順番

- 2

- 下

- 根本的な

- わかる

- 単位

- ユニット

- 宇宙

- 異なり、

- 中古

- 通常

- 非常に

- 実行可能な

- ました

- we

- 週間

- この試験は

- いつ

- which

- while

- 誰

- 広く

- 意志

- 以内

- 無し

- 言葉

- 仕事

- 働いていました

- 世界

- 書き込み

- 年

- まだ

- あなたの

- ゼファーネット