本日、Meta が開発した Llama 2 基盤モデルが、以下を通じてお客様に提供されることを発表できることを嬉しく思います。 Amazon SageMaker ジャンプスタート。 Llama 2 ファミリーの大規模言語モデル (LLM) は、7 億から 70 億のパラメーターの規模にわたる、事前トレーニングされ、微調整された生成テキスト モデルのコレクションです。 Llama-2-chat と呼ばれる微調整された LLM は、対話のユースケース向けに最適化されています。 これらのモデルは簡単に試したり、SageMaker JumpStart で使用したりできます。SageMaker JumpStart は、アルゴリズム、モデル、ML ソリューションへのアクセスを提供する機械学習 (ML) ハブであり、ML をすぐに始めることができます。

この投稿では、SageMaker JumpStart 経由で Llama 2 モデルを使用する方法を説明します。

ラマ2とは

Llama 2 は、最適化されたトランスフォーマー アーキテクチャを使用する自動回帰言語モデルです。 Llama 2 は、英語での商用および研究での使用を目的としています。 これには、7 億、13 億、70 億といったさまざまなパラメーター サイズがあり、事前トレーニングおよび微調整されたバリエーションも用意されています。 Meta 氏によると、調整されたバージョンでは、教師あり微調整 (SFT) とヒューマン フィードバックを伴う強化学習 (RLHF) が使用され、有用性と安全性に対する人間の好みに合わせられます。 Llama 2 は、公的に入手可能なソースからの 2 兆トークンのデータで事前トレーニングされました。 調整されたモデルはアシスタントのようなチャットを目的としていますが、事前トレーニングされたモデルはさまざまな自然言語生成タスクに適応できます。 開発者が使用するモデルのバージョンに関係なく、 メタからの責任ある使用ガイド 適切な安全性を緩和してモデルをカスタマイズおよび最適化するために必要となる可能性のある追加の微調整をガイドするのに役立ちます。

SageMaker JumpStart とは

SageMaker JumpStart を使用すると、ML 実践者はオープンソースの基盤モデルの幅広い選択肢から選択できます。 ML 実践者は基礎モデルを専用のモデルにデプロイできます。 アマゾンセージメーカー ネットワーク分離環境からインスタンスを抽出し、モデルのトレーニングとデプロイメントに SageMaker を使用してモデルをカスタマイズします。

数回クリックするだけで Llama 2 を検出して展開できるようになりました。 Amazon SageMakerスタジオ または、SageMaker Python SDK を介してプログラム的に、次のような SageMaker 機能を使用してモデルのパフォーマンスと MLOps コントロールを導き出すことができます。 AmazonSageMakerパイプライン, Amazon SageMakerデバッガ、またはコンテナーのログ。 モデルは AWS の安全な環境にデプロイされ、VPC の制御下に置かれるため、データのセキュリティが確保されます。 Llama 2 モデルは現在、Amazon SageMaker Studio で利用可能です。 us-east 1 および us-west 2 地域。

モデルを発見する

基礎モデルには、SageMaker Studio UI の SageMaker JumpStart および SageMaker Python SDK を通じてアクセスできます。 このセクションでは、SageMaker Studio でモデルを検出する方法について説明します。

SageMaker Studio は、単一の Web ベースのビジュアル インターフェイスを提供する統合開発環境 (IDE) であり、専用ツールにアクセスして、データの準備から ML モデルの構築、トレーニング、デプロイまで、すべての ML 開発ステップを実行できます。 SageMaker Studio の開始方法とセットアップ方法の詳細については、以下を参照してください。 Amazon SageMakerスタジオ.

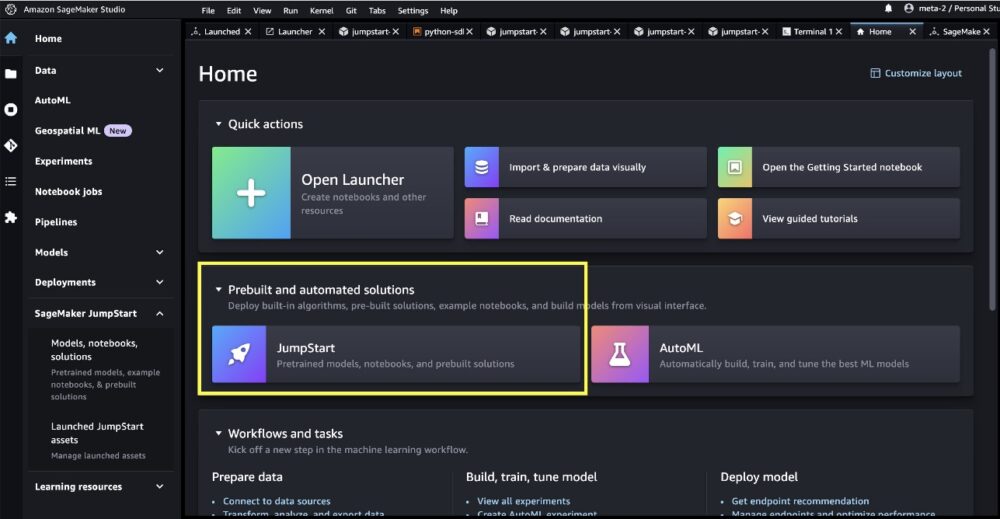

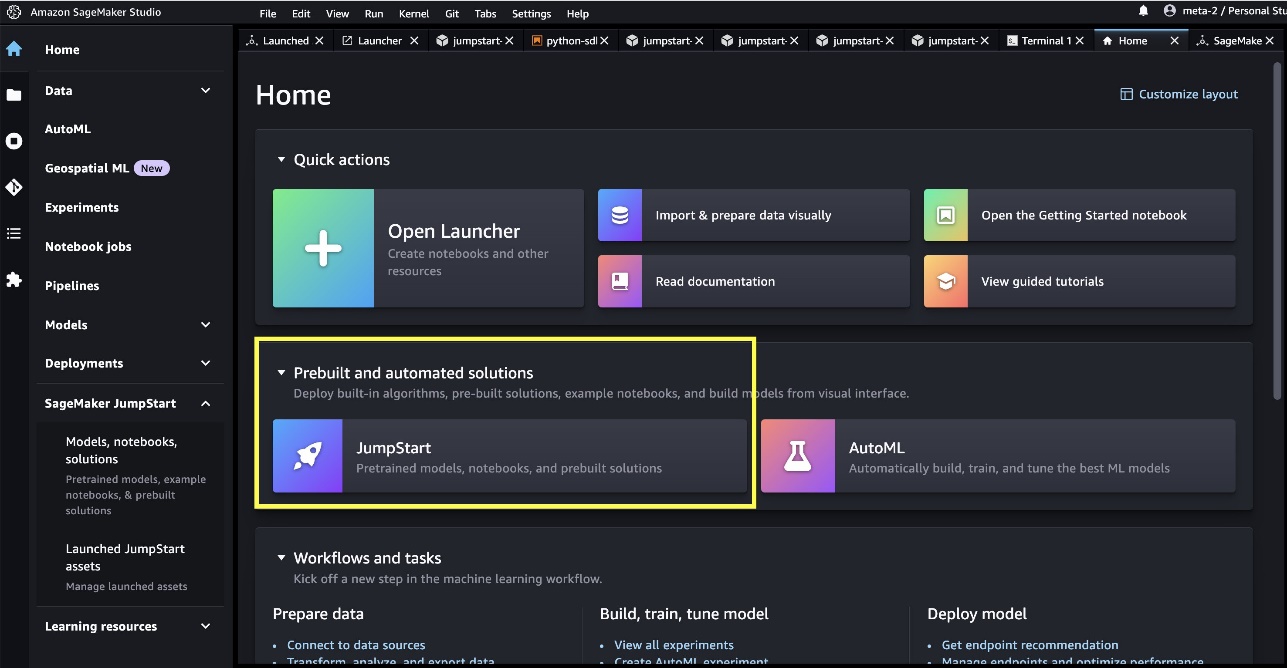

SageMaker Studio にアクセスすると、事前トレーニングされたモデル、ノートブック、事前構築されたソリューションが含まれる SageMaker JumpStart にアクセスできます。 事前に構築された自動化されたソリューション.

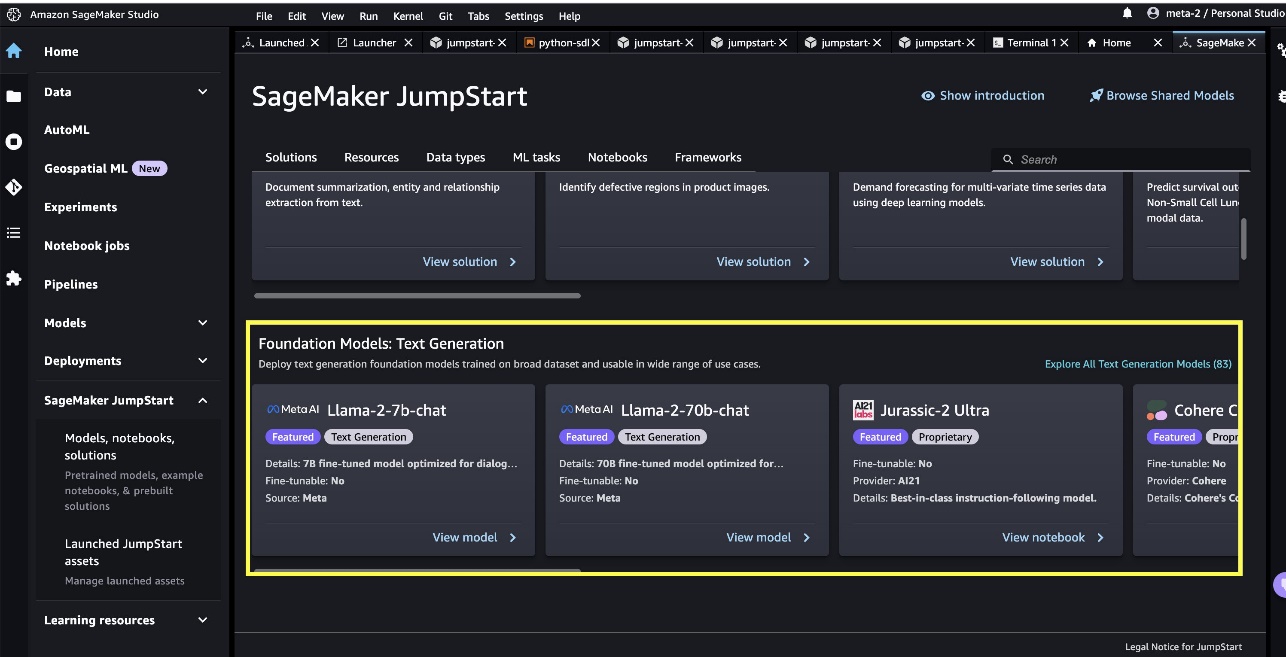

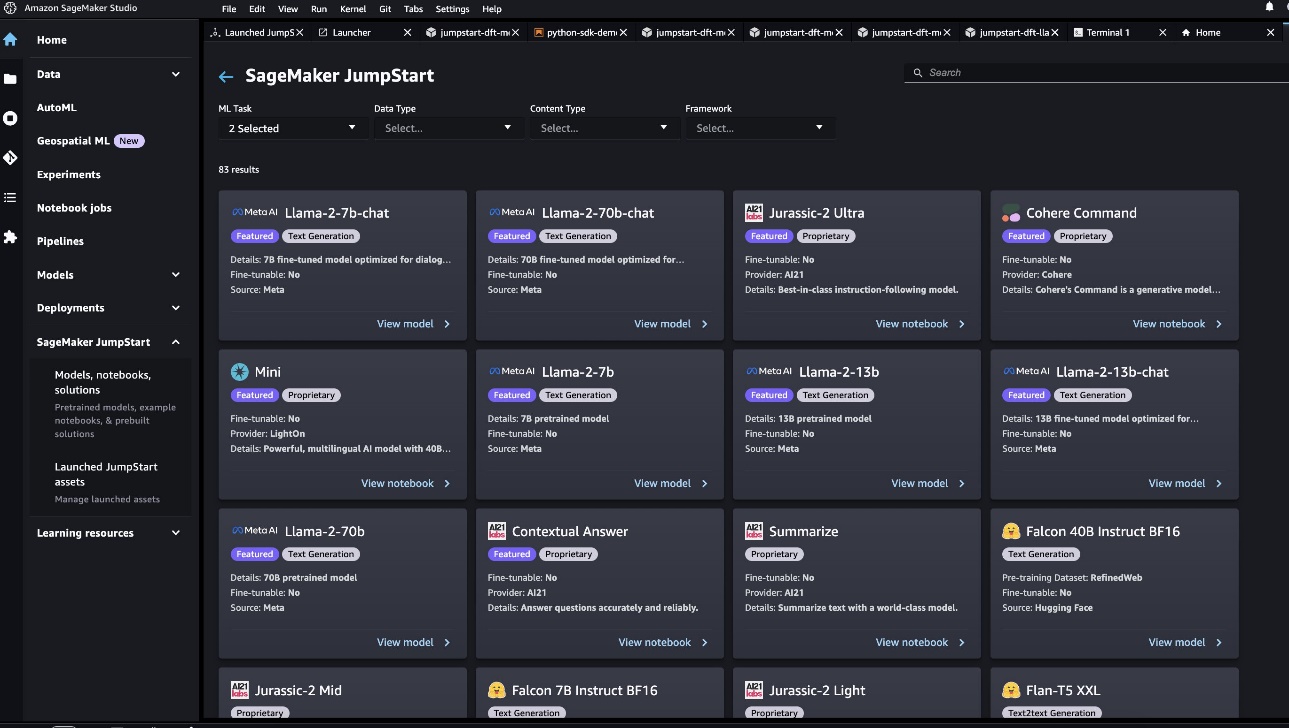

SageMaker JumpStart ランディング ページから、ソリューション、モデル、ノートブック、その他のリソースを参照できます。 2 つの主力 Llama XNUMX モデルが、 基礎モデル: テキスト生成 カルーセル。 Llama 2 モデルが表示されない場合は、シャットダウンして再起動して、SageMaker Studio のバージョンを更新してください。 バージョンアップデートの詳細については、以下を参照してください。 Studio アプリをシャットダウンして更新する.

を選択すると、他の XNUMX つのモデル バリエーションを見つけることもできます。 すべてのテキスト生成モデルを調べる または検索 llama 検索ボックスに

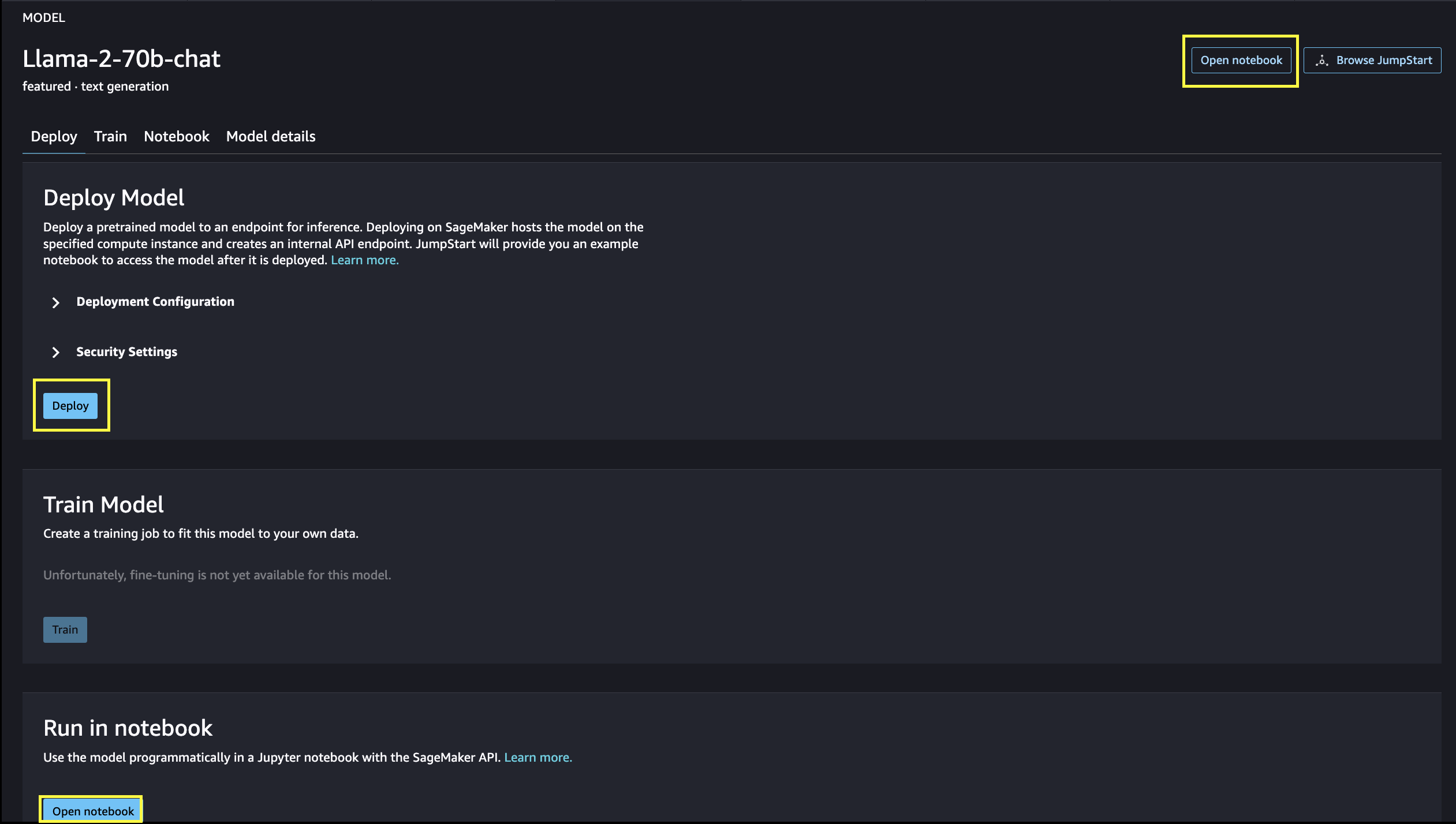

モデル カードを選択すると、ライセンス、トレーニングに使用されるデータ、使用方法などのモデルに関する詳細が表示されます。 ボタンも XNUMX つあります。 配備します および ノートブックを開く、モデルの使用に役立ちます。

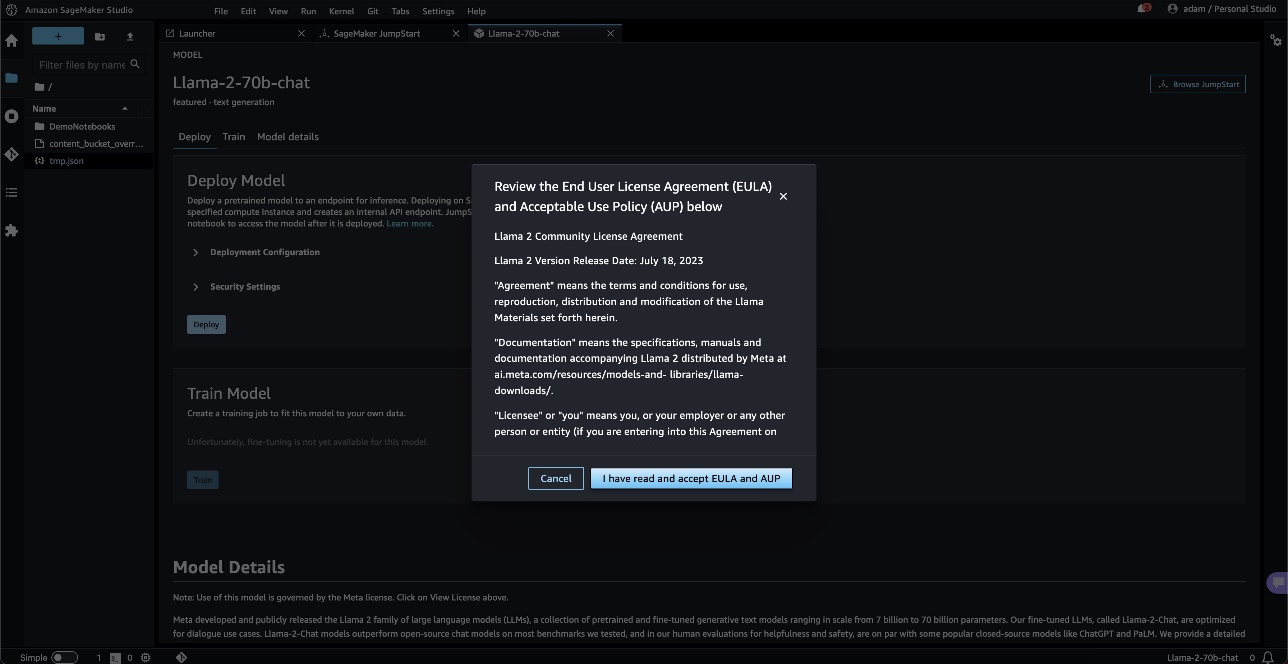

いずれかのボタンを選択すると、ポップアップにエンドユーザー使用許諾契約書と使用許諾ポリシーが表示され、同意する必要があります。

承認すると、モデルを使用する次のステップに進みます。

モデルをデプロイする

選ぶとき 配備します 条件に同意すると、モデルのデプロイが開始されます。 あるいは、選択して表示されるサンプル ノートブックを通じてデプロイすることもできます。 ノートブックを開く。 サンプル ノートブックは、推論用のモデルをデプロイし、リソースをクリーンアップする方法に関するエンドツーエンドのガイダンスを提供します。

ノートブックを使用してデプロイするには、まず、 model_id。 次のコードを使用して、選択したモデルのいずれかを SageMaker にデプロイできます。

これにより、デフォルトのインスタンス タイプやデフォルトの VPC 構成などのデフォルト構成でモデルが SageMaker にデプロイされます。 これらの構成は、デフォルト以外の値を指定することで変更できます。 ジャンプスタートモデル。 デプロイ後、SageMaker プレディクターを介して、デプロイされたエンドポイントに対して推論を実行できます。

微調整されたチャット モデル (Llama-2-7b-chat、Llama-2-13b-chat、Llama-2-70b-chat) は、ユーザーとチャット アシスタント間のチャット履歴を受け入れ、後続のチャットを生成します。 事前トレーニングされたモデル (Llama-2-7b、Llama-2-13b、Llama-2-70b) には文字列プロンプトが必要で、提供されたプロンプトでテキスト補完を実行します。 次のコードを参照してください。

デフォルトでは、 accept_eula false に設定されます。 設定する必要があります accept_eula=true エンドポイントを正常に呼び出すことができます。 これにより、前述のユーザー使用許諾契約および利用規定に同意したことになります。 あなたもすることができます ダウンロード ライセンス契約。

Custom_attributes EULA を渡すために使用されるのはキーと値のペアです。 キーと値は次のように区切られます。 = そしてペアは次のように区切られます ;。 ユーザーが同じキーを複数回渡す場合、最後の値が保持され、スクリプト ハンドラーに渡されます (つまり、この場合は条件付きロジックに使用されます)。 たとえば、次の場合 accept_eula=false; accept_eula=true サーバーに渡されると、 accept_eula=true 保持され、スクリプト ハンドラーに渡されます。

推論パラメータは、エンドポイントでのテキスト生成プロセスを制御します。 新しいトークンの最大数の制御は、モデルによって生成される出力のサイズを指します。 モデルの語彙は英語の語彙と同じではなく、各トークンは英語の単語ではない可能性があるため、これは単語の数と同じではないことに注意してください。 温度は出力のランダム性を制御します。 温度が高いほど、より創造的で幻覚的な出力が得られます。 すべての推論パラメータはオプションです。

次の表は、SageMaker JumpStart で利用可能なすべての Llama モデルと、 model_ids、デフォルトのインスタンス タイプ、およびこれらの各モデルでサポートされる合計トークンの最大数 (入力トークンの数と生成されたトークンの数の合計)。

| モデル名 | モデルID | 最大合計トークン数 | デフォルトのインスタンスタイプ |

| ラマ-2-7b | メタテキスト生成-ラマ-2-7b | 4096 | ml.g5.2xラージ |

| ラマ-2-7b-チャット | メタテキスト生成-ラマ-2-7b-f | 4096 | ml.g5.2xラージ |

| ラマ-2-13b | メタテキスト生成-ラマ-2-13b | 4096 | ml.g5.12xラージ |

| ラマ-2-13b-チャット | メタテキスト生成-ラマ-2-13b-f | 4096 | ml.g5.12xラージ |

| ラマ-2-70b | メタテキスト生成-ラマ-2-70b | 4096 | ml.g5.48xラージ |

| ラマ-2-70b-チャット | メタテキスト生成-ラマ-2-70b-f | 4096 | ml.g5.48xラージ |

SageMaker エンドポイントには 60 秒のタイムアウト制限があることに注意してください。 したがって、モデルが 4096 個のトークンを生成できる場合でも、テキストの生成に 60 秒以上かかる場合、リクエストは失敗します。 7B、13B、70B モデルの場合は、 max_new_tokens トークンの合計数は 1500K 未満に保ちながら、それぞれ 1000、500、および 4 を超えないようにしてください。

Llama-2-70b の推論とプロンプト例

Llama モデルを使用して、あらゆるテキストのテキスト補完を行うことができます。 テキスト生成を通じて、質問への回答、言語翻訳、感情分析など、さまざまなタスクを実行できます。 エンドポイントへの入力ペイロードは次のコードのようになります。

以下は、プロンプトのサンプル例とモデルによって生成されたテキストです。 すべての出力は推論パラメーターを使用して生成されます {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

次の例では、少数ショットのインコンテキスト学習で Llama モデルを使用する方法を示し、モデルで利用できるトレーニング サンプルを提供します。 デプロイされたモデルに対してのみ推論が行われ、このプロセス中、モデルの重みは変更されないことに注意してください。

Llama-2-70b-chat の推論とプロンプト例

対話のユースケース向けに最適化された Llama-2-Chat モデルでは、チャット モデルのエンドポイントへの入力は、チャット アシスタントとユーザーの間の以前の履歴です。 これまでの会話に関連した質問をすることができます。 チャット アシスタントの動作を定義するペルソナなどのシステム構成を提供することもできます。 エンドポイントへの入力ペイロードは次のコードのようになります。

以下は、プロンプトのサンプル例とモデルによって生成されたテキストです。 すべての出力は推論パラメータを使用して生成されます {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

次の例では、ユーザーはアシスタントとパリの観光地について会話しています。 次に、ユーザーはチャット アシスタントが推奨する最初のオプションについて問い合わせています。

次の例では、システムの構成を設定します。

クリーンアップ

ノートブックの実行が完了したら、プロセス中に作成したすべてのリソースが削除され、請求が停止されるように、必ずすべてのリソースを削除してください。

まとめ

この投稿では、SageMaker Studio で Llama 2 モデルの使用を開始する方法を説明しました。 これにより、数十億のパラメータを含む 2 つの Llama XNUMX 基礎モデルにアクセスできるようになります。 基礎モデルは事前にトレーニングされているため、トレーニングとインフラストラクチャのコストを削減し、ユースケースに合わせたカスタマイズを可能にすることもできます。 SageMaker JumpStart の使用を開始するには、次のリソースにアクセスしてください。

著者について

ジューン・ウォン SageMaker JumpStart のプロダクト マネージャーです。 彼は、顧客が生成 AI アプリケーションを構築できるように、基礎モデルを簡単に見つけて使用できるようにすることに重点を置いています。 Amazon での経験には、モバイル ショッピング アプリケーションやラスト マイル配送も含まれます。

ジューン・ウォン SageMaker JumpStart のプロダクト マネージャーです。 彼は、顧客が生成 AI アプリケーションを構築できるように、基礎モデルを簡単に見つけて使用できるようにすることに重点を置いています。 Amazon での経験には、モバイル ショッピング アプリケーションやラスト マイル配送も含まれます。

ヴィヴェック・マダン博士 Amazon SageMaker JumpStart チームの応用科学者です。 イリノイ大学アーバナ シャンペーン校で博士号を取得し、ジョージア工科大学で博士研究員を務めました。 彼は機械学習とアルゴリズム設計の活発な研究者であり、EMNLP、ICLR、COLT、FOCS、および SODA カンファレンスで論文を発表しています。

ヴィヴェック・マダン博士 Amazon SageMaker JumpStart チームの応用科学者です。 イリノイ大学アーバナ シャンペーン校で博士号を取得し、ジョージア工科大学で博士研究員を務めました。 彼は機械学習とアルゴリズム設計の活発な研究者であり、EMNLP、ICLR、COLT、FOCS、および SODA カンファレンスで論文を発表しています。  カイル・ウルリッヒ博士 Amazon SageMaker JumpStart チームの応用科学者です。 彼の研究対象には、スケーラブルな機械学習アルゴリズム、コンピューター ビジョン、時系列、ベイジアン ノンパラメトリック、ガウス プロセスなどがあります。 彼はデューク大学で博士号を取得しており、NeurIPS、Cell、および Neuron で論文を発表しています。

カイル・ウルリッヒ博士 Amazon SageMaker JumpStart チームの応用科学者です。 彼の研究対象には、スケーラブルな機械学習アルゴリズム、コンピューター ビジョン、時系列、ベイジアン ノンパラメトリック、ガウス プロセスなどがあります。 彼はデューク大学で博士号を取得しており、NeurIPS、Cell、および Neuron で論文を発表しています。  アシッシュ・ケタン博士 Amazon SageMaker JumpStart の上級応用科学者であり、機械学習アルゴリズムの開発を支援しています。 イリノイ大学アーバナ・シャンペーン校で博士号を取得しました。 彼は機械学習と統計的推論の積極的な研究者であり、NeurIPS、ICML、ICLR、JMLR、ACL、および EMNLP カンファレンスで多くの論文を発表しています。

アシッシュ・ケタン博士 Amazon SageMaker JumpStart の上級応用科学者であり、機械学習アルゴリズムの開発を支援しています。 イリノイ大学アーバナ・シャンペーン校で博士号を取得しました。 彼は機械学習と統計的推論の積極的な研究者であり、NeurIPS、ICML、ICLR、JMLR、ACL、および EMNLP カンファレンスで多くの論文を発表しています。  サンダー・ランガナサン AWS の GenAI/Frameworks GTM スペシャリストのグローバル ヘッドです。 彼は、大規模言語モデル、GenAI、および Amazon EC2、EKS、EFA、AWS Batch、Amazon SageMaker などの AWS サービスにわたる大規模 ML ワークロードの GTM 戦略の開発に重点を置いています。 彼の経験には、NetApp、Micron Technology、Qualcomm、Mentor Graphics での製品管理および製品開発におけるリーダーとしての役割が含まれます。

サンダー・ランガナサン AWS の GenAI/Frameworks GTM スペシャリストのグローバル ヘッドです。 彼は、大規模言語モデル、GenAI、および Amazon EC2、EKS、EFA、AWS Batch、Amazon SageMaker などの AWS サービスにわたる大規模 ML ワークロードの GTM 戦略の開発に重点を置いています。 彼の経験には、NetApp、Micron Technology、Qualcomm、Mentor Graphics での製品管理および製品開発におけるリーダーとしての役割が含まれます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 自動車/EV、 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- ブロックオフセット。 環境オフセット所有権の近代化。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :持っている

- :は

- :not

- :どこ

- $UP

- 1

- 10

- 100

- 11

- 13

- 視聴者の38%が

- 17

- 19

- 20

- 30

- 31

- 33

- 360度

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- できる

- 私たちについて

- 同意

- ことができます。

- アクセス

- 接近性

- アクセス可能な

- 従った

- 認める

- 越えて

- アクティブ

- 加えます

- 追加

- NEW

- 住所

- 後

- 再び

- に対して

- 契約

- AI

- アルゴリズム

- アルゴリズム

- 整列する

- すべて

- 許す

- 沿って

- また

- 常に

- am

- Amazon

- Amazon EC2

- アマゾンセージメーカー

- Amazon SageMaker ジャンプスタート

- Amazon SageMakerスタジオ

- Amazon Webサービス

- アメリカ

- an

- 分析

- および

- とインフラ

- アナウンス

- 別の

- 回答

- どれか

- 誰も

- 申し込み

- 適用された

- 認める

- 適切な

- アーク

- 建築

- です

- 宝品

- AS

- アシスト

- アシスタント

- At

- 雰囲気

- 観光スポット

- 自動化

- 利用できます

- AWS

- バナナ

- 基本

- 戦い

- ベイジアン

- BE

- 美しい

- 美容

- になりました

- なぜなら

- になる

- き

- ビール

- 行動

- Beijing

- 信じる

- 信じて

- BEST

- の間に

- 請求

- 10億

- 億

- ブラック

- ボックス

- ブレーク

- 息をのむような

- 広い

- ビルド

- 建物

- 内蔵

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- (Comma Separated Values) ボタンをクリックして、各々のジョブ実行の詳細(開始/停止時間、変数値など)のCSVファイルをダウンロードします。

- by

- 呼ばれます

- 缶

- 資本

- 自動車

- カード

- カルーセル

- 場合

- 例

- CAT

- 変化する

- チョコレート

- 選択する

- 選択する

- 市町村

- クラシック

- コード

- コレクション

- 組み合わせた

- 組み合わせ

- comes

- 到来

- コマーシャル

- 会社

- 完成

- コンピュータ

- Computer Vision

- 会議

- 確信して

- 見なさ

- 定数

- 建設

- 含む

- コンテナ

- 含まれています

- コンテンツ

- 文脈上の

- 続ける

- 連続的に

- コントロール

- controls

- 便利

- 会話

- コスト

- 国

- 勇気

- カバー

- 作ります

- 作成した

- クリエイティブ

- 文化的な

- 文化

- カップ

- Customers

- カスタム化

- カスタマイズ

- データ

- データセキュリティ

- 専用の

- 献身

- デフォルト

- 定義します

- 配達

- 展開します

- 展開

- 展開する

- 展開

- 配備する

- 設計

- 設計

- 希望

- デスティネーション

- 目的地

- 細部

- 開発する

- 発展した

- Developer

- 開発

- 開発

- 対話

- 違い

- 異なります

- 難しい

- 発見する

- 独特の

- do

- ドキュメンタリー

- すること

- 行われ

- ドント

- 倍増

- ダウン

- デューク

- デューク大学

- 間に

- e

- 各

- 前

- 簡単に

- 簡単に

- エドワード

- アインシュタイン

- どちら

- enable

- 有効にする

- end

- 端から端まで

- エンドポイント

- エンジニアリング

- 英語

- 楽しみます

- 十分な

- 確保

- 環境

- 装置

- エーテル

- さらに

- イベント

- 誰も

- 例

- 例

- 興奮した

- 体験

- 実験

- 実験

- 表現します

- フェイル

- Failed:

- フェア

- false

- 家族

- 有名な

- 遠く

- 妙技

- 特集

- 特徴

- フィードバック

- 足

- 少数の

- ファイナル

- 最後に

- もう完成させ、ワークスペースに掲示しましたか?

- 名

- 旗艦

- フロート

- 流れ

- 焦点を当てて

- フォロー中

- フォワード

- 発見

- Foundation

- 4

- フランス

- フランス語

- から

- 完全に

- さらに

- 未来

- 生成する

- 生成された

- 世代

- 生々しい

- 生成AI

- 取得する

- 与える

- ガラス

- グローバル

- Go

- 行く

- グラフィック

- 素晴らしい

- 大きい

- 画期的な

- 成長する

- ガイダンス

- ガイド

- 持っていました

- ハンドル

- が起こった

- ハッピー

- ハード

- 重労働

- 持ってる

- 持って

- he

- 助けます

- 助け

- ことができます

- こちら

- hi

- ハイ

- より高い

- 彼の

- 歴史的

- history

- 住宅

- 認定条件

- How To

- HTML

- HTTPS

- ハブ

- 人間

- i

- 象徴的な

- アイデア

- if

- ii

- イリノイ州

- 影響

- import

- 重要

- 印象的

- in

- include

- 含ま

- 含めて

- Incorporated

- 情報

- インフラ関連事業

- 当初

- インスピレーションある

- インスピレーション

- 瞬時に

- 説明書

- 統合された

- 意図された

- 利益

- インタフェース

- に

- 分離された

- IT

- ITS

- 旅

- JPG

- ただ

- 保管

- 保管

- キー

- 種類

- 知っている

- 既知の

- 着陸

- ランドマーク

- 言語

- 大

- 大規模

- 最大の

- 姓

- 遅く

- 起動する

- 法制

- リーダーシップ

- LEARN

- 学び、成長する

- 学習

- 最低

- less

- レベル

- ライセンス

- 生活

- 光

- ような

- LIMIT

- リスト

- レポート

- ll

- ラマ

- ロジック

- 長い

- 長い時間

- 探して

- LOOKS

- 愛

- 愛され

- 下側

- 機械

- 機械学習

- 製

- make

- 作る

- 作成

- 管理

- マネージャー

- 多くの

- 驚異

- 問題

- 五月..

- 意味

- だけど

- メディア

- ミディアム

- 言及した

- メッセージ

- Meta

- ミクロン

- 分

- 分

- 混合

- ML

- MLOps

- モバイル

- モデル

- 瞬間

- ヶ月

- 他には?

- 最も

- 一番人気

- モーション

- 映画

- ずっと

- 博物館

- 博物館

- 音楽を聴く際のスピーカーとして

- 名

- ナチュラル

- 必要

- 必要

- 必要とされる

- ネットワーク

- 新作

- ニューヨーク

- 次の

- いいえ

- ノート

- 今

- 数

- 多数の

- NY

- of

- 提供

- 提供すること

- オファー

- 油

- on

- かつて

- ONE

- の

- 開いた

- オープンソース

- 最適化

- 最適化

- オプション

- or

- その他

- その他

- さもないと

- 私たちの

- でる

- 出力

- が

- 全体

- ページ

- 足

- 紙素材

- 論文

- パラメーター

- パラメータ

- パリ

- 部

- パス

- 渡された

- パス

- 過去

- 平和

- 実行する

- パフォーマンス

- 恒久的な

- 電話

- 写真

- 物理学

- ピース

- ピザ

- プラスチック

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 演奏

- 方針

- ポップアップ

- 人気

- ポスト

- 郵便

- Predictor

- プ

- 準備中

- 現在

- 前

- プロセス

- ラボレーション

- プロダクト

- 製品開発

- 製品管理

- プロダクトマネージャー

- 提案

- 誇りに思う

- 提供します

- 提供

- は、大阪で

- 提供

- 公共

- 公共交通機関

- 公然と

- 公表

- 目的

- 置きます

- Python

- クアルコム

- 質問

- クイック

- すぐに

- ランプ

- ランダム

- 範囲

- 測距

- 準備

- 理由は

- 受け取ります

- レシピ

- 推奨する

- 推奨される

- 指し

- 関係なく

- 地域

- 相対

- 相対性理論

- 繰り返される

- 表す

- 要求

- 必要

- 研究

- 研究者

- リソース

- それぞれ

- 反応します

- REST

- 結果

- 結果

- 川

- 職種

- 役割

- ラン

- ランニング

- s

- 安全性

- セージメーカー

- 塩

- 同じ

- ド電源のデ

- 規模

- 科学者

- 科学者たち

- SDDK

- SEA

- を検索

- 検索

- セクション

- 安全に

- セキュリティ

- 見ること

- 見えた

- 選択

- 選択

- 選択

- 送信

- シニア

- 感情

- シリーズ

- サービス

- サービング

- セッションに

- 設定

- 形状

- 鮫

- ショッピング

- すべき

- 表示する

- 示されました

- 作品

- シャットダウン

- 意義

- 重要

- 簡単な拡張で

- 単に

- ウェブサイト

- サイト

- SIX

- サイズ

- ゆっくり

- 小さい

- So

- これまでのところ

- 社会

- ソーシャルメディア

- ソリューション

- 一部

- ソース

- ソース

- 特別

- 専門家

- 指定の

- スピード

- スタンド

- start

- 開始

- 都道府県

- 米国

- 統計的

- 手順

- ステップ

- 停止

- 戦略

- 文字列

- 構造

- 研究

- 見事な

- テーマ

- それに続きます

- 成功

- 首尾よく

- そのような

- サポート

- 確か

- シンボル

- テーブル

- 取る

- 取り

- タスク

- キー

- チーム

- テク

- テクノロジー

- 一時的

- 条件

- より

- 感謝

- それ

- 首都

- 未来

- ソース

- 世界

- アプリ環境に合わせて

- それら

- 理論

- そこ。

- ボーマン

- 彼ら

- 物事

- 考える

- この

- しかし?

- 介して

- タイガー

- 時間

- 時系列

- <font style="vertical-align: inherit;">回数</font>

- 役職

- 〜へ

- 今日

- 一緒に

- トークン

- トークン

- 豊富なツール群

- top

- トータル

- タワー

- トレーニング

- トレーニング

- トランス

- 翻訳する

- インタビュー

- 輸送サービス

- 1兆

- 試します

- 2

- type

- ui

- 下

- 忘れられない

- ユニーク

- 大学

- まで

- アップデイト

- 更新版

- 使用可能な

- つかいます

- 使用事例

- 中古

- ユーザー

- users

- 使用されます

- 値

- 価値観

- 多様

- バージョン

- バージョン

- 非常に

- 、

- 詳しく見る

- ビュー

- ビジョン

- 訪問

- 訪問者

- ボリューム

- wanted

- 戦争

- ました

- we

- ウェブ

- Webサービス

- ウェブベースの

- ウェブサイト

- WELL

- クジラ

- この試験は

- 何ですか

- いつ

- 一方

- which

- while

- なぜ

- 意志

- ウィンドウズ

- Word

- 言葉

- 仕事

- 作品

- 世界

- 世界的に有名

- ラップ

- 年

- ヨーク

- You

- あなたの

- あなた自身

- ゼファーネット

- 〒