연구에 따르면 검색 엔진에 대한 액세스는 쿼리에 대한 정확한 최신 답변을 생성하는 AI 챗봇의 능력을 향상시키는 경향이 없으며, 이는 개발자가 상호 작용을 보다 유용하게 만들기 위해 새로운 기술을 찾아야 한다는 것을 의미합니다.

ChatGPT의 기반인 GPT-3.5와 같은 대규모 언어 모델(LLM)은 2021년 XNUMX월까지 인터넷에서 스크랩한 텍스트에 대해 교육을 받습니다. Google 및 Microsoft와 같은 회사는 LLM을 검색 엔진으로 보강하여 현재 웹 지식에 액세스할 수 있도록 합니다. 페이지.

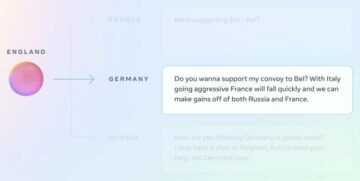

그들의 각각에 의해 입증된 바와 같이 음유 시인 및 빙 챗봇, Google 및 Microsoft는 여전히 검색 쿼리에 대한 정확한 응답을 생성하는 데 어려움을 겪고 있습니다. 정답은 인터넷 어딘가에 있을 수 있습니다.

"검색 엔진과 ChatGPT를 연결하는 것이 완벽한 솔루션이라고 생각할 수도 있지만 검색 결과의 정확도가 제한되어 있기 때문에 현실은 더 어렵습니다. 등록.

Luo는 검색 엔진이 키워드 기반 검색 시스템이며 대부분의 질문에 항상 직접적인 답변을 제공하지는 않는다고 설명합니다. 또한 서로 다른 웹 페이지에는 관련이 없거나 모순되거나 잘못된 정보가 포함될 수 있습니다. Bing이 잘못 주장함 아돌프 히틀러는 밴드 라디오헤드의 멤버였다. 예를 들어 하나의 검색 결과에서.

네티즌 추측 된 오류가 a로 인해 발생할 수 있는지 여부 페이지 Radiohead와 Adolf Hitler를 언급한 Wikidata에서.

Bard와 Bing이 유용하려면 개발자는 LLM이 시끄럽고 혼란스럽고 일관성이 없는 텍스트 바다에서 가장 유용한 정보를 추출하도록 만드는 방법을 알아내야 합니다. MIT와 홍콩 중문 대학의 Luo와 그의 동료들은 웹 검색에 대한 응답을 생성하는 방법에 대한 지침을 더 잘 따를 수 있도록 모델을 더 미세 조정해야 한다고 생각합니다.

팀이 메타를 수정했습니다. 야마, 52,000억 개의 매개변수 LLM, 4쌍의 텍스트 기반 명령과 GPT-XNUMX에서 생성된 해당 응답이 포함된 데이터베이스에서 이를 미세 조정합니다. 연구원들은 또한 각 지침과 관련된 상위 XNUMX개 웹 페이지를 포함하는 별도의 데이터 세트를 구성하고 소스가 올바른 응답과 얼마나 관련되고 밀접하게 정렬되어 있는지 순위를 매겨 올바른 응답을 생성하도록 모델을 훈련했습니다.

Luo는 미세 조정 모델이라고 말했습니다 – 별명 돛-7B는 search-augmented instruction learning을 의미하며 주의를 산만하게 하거나 신뢰할 수 없는 검색 결과를 무시하는 데 더 좋고 더 높은 품질의 답변을 생성합니다. 자세한 내용은 출판 [PDF] arXiv에 발표된 논문과 모델의 암호 GitHub에 있습니다. 당신은 또한 데모 Hugging Face에서 호스팅되는 시스템의

“우리 모델은 시끄러운 검색 결과에서 유용한 정보를 찾고 가능한 한 정확한 응답을 생성하는 방법을 배웁니다. 결과적으로 우리 모델은 귀중한 정보를 더 잘 요약하고 검색 엔진이 잘 처리하지 못하는 경우에도 다양한 검색 쿼리에 대해 더 나은 답변을 생성할 수 있습니다.”라고 Luo는 말했습니다.

“우리 교육에는 각 검색 결과가 유용한지 여부를 명확히 하는 단계가 명시적으로 포함되어 있으며 언어 모델은 선택된 유용한 정보를 따릅니다. 이 프로세스는 대부분의 신뢰할 수 없고 관련 없는 검색 결과를 필터링하고 평균 명령 수행 성능을 향상시킵니다.”

초기 실험은 SAIL-7B가 GPT-3.5 및 작업 범위에서 더 많은 매개변수를 포함하는 다른 모델보다 성능이 우수함을 보여주었습니다. 실험은 상식과 개방형 질문에 답하는 능력, 사실 확인, 증오심 표현 감지 능력을 평가했습니다. 모델은 후보 응답 목록에서 정답을 선택하는 데 도움이 되도록 Wikipedia의 웹 페이지와 DuckDuckGo의 검색 결과를 제공받았습니다. 그러나 GPT-4는 여전히 SAIL-7B보다 낫습니다.

“문제는 더 큰 모델이 훨씬 더 강한 지식, 암기 및 추론 능력을 가지고 있기 때문에 우리 모델이 아직 GPT-4만큼 좋지 않다는 것입니다. 그러나 SAIL-7B는 '소형' 모델의 개념 증명이며 다음 단계는 우리가 제안한 전략으로 더 큰 모델을 교육하는 것입니다.”라고 Luo가 말했습니다.

그러나 현재의 검색 증강 교육 학습 기술로 미세 조정된 모델은 완벽하지 않습니다. 연구원들은 설명할 수 없다고 지적했습니다. why 검색 결과를 신뢰할 수 있는지 여부. 그들은 미래에 정확성과 신뢰성을 높이기 위한 또 다른 전략을 제시하기를 희망합니다. ®

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- EVM 금융. 탈중앙화 금융을 위한 통합 인터페이스. 여기에서 액세스하십시오.

- 퀀텀미디어그룹. IR/PR 증폭. 여기에서 액세스하십시오.

- PlatoAiStream. Web3 데이터 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 출처: https://go.theregister.com/feed/www.theregister.com/2023/06/07/search_engines_make_chatbots_inaccurate/

- :이다

- :아니

- $UP

- 000

- 2021

- 7

- a

- 능력

- 능력

- ACCESS

- 에 따르면

- 정확한

- AI

- 인공 지능 봇봇

- 정렬 된

- 또한

- 항상

- an

- 및

- 다른

- 답변

- 답변

- 있군요

- 인조의

- 인공 지능

- AS

- 평가

- 준

- 관련

- At

- 평균

- 밴드

- 기초

- BE

- 때문에

- 된

- 믿으세요

- 더 나은

- 빙

- 비자 면제 프로그램에 해당하는 국가의 시민권을 가지고 있지만

- by

- CAN

- 후보자

- 발생

- 도전

- 도전

- 채팅 봇

- 잡담

- ChatGPT

- 확인

- 중국말

- 주장

- 면밀히

- CO

- 동료

- 왔다

- 공통의

- 기업

- 컴퓨터

- 컴퓨터 과학

- 개념

- 혼란

- 연결

- 포함하는

- 수정

- 동

- 수

- Current

- 데이터베이스

- 시연

- 세부설명

- 개발자

- 다른

- 곧장

- do

- 들린

- 돈

- 마다

- 엔진

- 엔진

- 오류

- 조차

- 예

- 실험

- 설명

- 설명

- 추출물

- 페이스메이크업

- 사실

- 그릇된

- 연방 준비 은행

- 그림

- 필터

- Find

- 따라

- 다음

- 럭셔리

- 에

- 추가

- 미래

- 생성

- 생성

- 생성

- GitHub의

- 기부

- 좋은

- 구글

- 핸들

- 있다

- 도움

- 도움이

- 더 높은

- 그의

- 홍콩

- 香港

- 기대

- 호스팅

- 방법

- How To

- 그러나

- HTTPS

- if

- 개선

- in

- 포함

- 잘못

- 증가

- 정보

- 명령

- 인텔리전스

- 상호 작용

- 인터넷

- IT

- JPG

- 지식

- 홍콩

- 실험실

- 언어

- 큰

- 배우기

- 처럼

- 제한된

- 명부

- LLM

- 확인

- XNUMX월..

- 방법

- 회원

- 말하는

- 메타

- Microsoft

- 수도

- MIT

- 모델

- 모델

- 배우기

- 가장

- 많은

- 필요

- 신제품

- 다음 것

- 유명한

- of

- on

- ONE

- or

- 기타

- 우리의

- 아웃

- 쌍

- 서

- 매개 변수

- 완전한

- 성능

- PHP

- 선택

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 연극

- 가능한

- 방법

- 생산

- 증명

- 개념 증명

- 제안 된

- 제공

- 품질

- 쿼리

- 문의

- 범위

- 순위

- 현실

- 출시

- 관련된

- 신뢰성

- 연구

- 연구원

- 그

- 응답

- 응답

- 결과

- 결과

- 연락해주세요

- s

- 말했다

- 과학

- 바다

- 검색

- 검색 엔진

- 검색 엔진

- 선택된

- 감각

- 별도의

- XNUMX월

- 보여

- 작은

- So

- 해결책

- 어딘가에

- 지우면 좋을거같음 . SM

- 연설

- 서

- 단계

- 아직도

- 전략

- 강한

- 노력

- 요약

- 체계

- 시스템은

- 작업

- 팀

- 기법

- 보다

- 그

- XNUMXD덴탈의

- 미래

- 그들의

- 그들

- 그들

- 생각

- 이

- 그래도?

- 에

- 상단

- 훈련 된

- 트레이닝

- 신뢰할 수있는

- 시도

- 대학

- 까지

- 최신의

- us

- 가치 있는

- 여러

- 대단히

- 였다

- we

- 웹

- 잘

- 했다

- 언제

- 여부

- 어느

- 위키 백과

- 의지

- 과

- 아직

- 자신의

- 제퍼 넷