Qualcomm AI의 AK Roy님의 게스트 포스트입니다.

Amazon Elastic Compute Cloud(Amazon EC2) Qualcomm AI 2 Standard 가속기로 구동되는 DL100q 인스턴스를 사용하면 클라우드에서 딥 러닝(DL) 워크로드를 비용 효율적으로 배포할 수 있습니다. 또한 Qualcomm 장치에 배포될 DL 워크로드의 성능과 정확성을 개발하고 검증하는 데에도 사용할 수 있습니다. DL2q 인스턴스는 Qualcomm의 인공 지능(AI) 기술을 클라우드에 도입한 최초의 인스턴스입니다.

100개의 Qualcomm AI 128 Standard 가속기와 2GiB의 총 가속기 메모리를 갖춘 고객은 DL100q 인스턴스를 사용하여 콘텐츠 생성, 텍스트 요약, 가상 비서 등 인기 있는 생성 AI 애플리케이션은 물론 자연어 처리를 위한 클래식 AI 애플리케이션도 실행할 수 있습니다. 그리고 컴퓨터 비전. 또한 Qualcomm AI 2 가속기는 스마트폰, 자율 주행, 개인용 컴퓨터 및 확장 현실 헤드셋 전반에 사용되는 것과 동일한 AI 기술을 갖추고 있으므로 배포 전에 DLXNUMXq 인스턴스를 사용하여 이러한 AI 워크로드를 개발하고 검증할 수 있습니다.

새로운 DL2q 인스턴스 하이라이트

각 DL2q 인스턴스에는 100개의 Qualcomm Cloud AI2.8 가속기가 통합되어 있으며, 총 성능은 Int8 추론 성능의 1.4 PetaOps 이상, FP16 추론 성능의 112 PetaFlops 이상입니다. 인스턴스에는 총 128개의 AI 코어, 1.1GB의 가속기 메모리 용량, 초당 XNUMXTB의 메모리 대역폭이 있습니다.

각 DL2q 인스턴스에는 96개의 vCPU, 768GB의 시스템 메모리 용량이 있으며 100Gbps의 네트워킹 대역폭과 Amazon 탄력적 블록 스토어(Amazon EBS) 19Gbps의 저장 공간.

| 인스턴스 이름 | vCPU | Cloud AI100 가속기 | 가속기 메모리 | 가속기 메모리 BW(집계) | 인스턴스 메모리 | 인스턴스 네트워킹 | 스토리지(Amazon EBS) 대역폭 |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB / 초 | 768 GB | 100Gbps | 19Gbps |

Qualcomm Cloud AI100 가속기 혁신

Cloud AI100 가속기 SoC(시스템 온 칩)는 특수 목적으로 구축된 확장 가능한 멀티 코어 아키텍처로, 데이터센터에서 에지까지 광범위한 딥 러닝 사용 사례를 지원합니다. SoC는 업계 최고의 126MB 온다이 SRAM 용량을 갖춘 스칼라, 벡터 및 텐서 컴퓨팅 코어를 사용합니다. 코어는 고대역폭, 저지연 NoC(Network-On-Chip) 메시로 상호 연결됩니다.

AI100 가속기는 광범위하고 포괄적인 범위의 모델과 사용 사례를 지원합니다. 아래 표에는 모델 지원 범위가 강조되어 있습니다.

| 모델 카테고리 | 모델 번호 | 예시 |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z 코드 MOE |

| 생성적 AI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| 생성적 AI – 이미지 | 3 | 안정적인 확산 v1.5 및 v2.1, OpenAI CLIP |

| CV – 이미지 분류 | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – 객체 감지 | 23 | YOLO v2, v3, v4, v5 및 v7, SSD-ResNet, RetinaNet |

| 이력서 – 기타 | 15 | LPRNet, 초고해상도/SRGAN, ByteTrack |

| 자동차 네트워크* | 53 | 인식 및 LIDAR, 보행자, 차선 및 신호등 감지 |

| 총 | > 300 â € < | â € < |

* 대부분의 자동차 네트워크는 개별 네트워크의 융합으로 구성된 복합 네트워크입니다.

DL2q 가속기의 대형 온다이 SRAM을 사용하면 가중치 저장을 위한 MX6 마이크로 지수 정밀도와 가속기 간 통신을 위한 MX9 마이크로 지수 정밀도와 같은 고급 성능 기술을 효율적으로 구현할 수 있습니다. 마이크로 지수 기술은 다음 OCP(Open Compute Project) 업계 발표에 설명되어 있습니다. AMD, Arm, Intel, Meta, Microsoft, NVIDIA 및 Qualcomm, AI를 위한 차세대 협정밀 데이터 형식 표준화 » 개방형 컴퓨팅 프로젝트.

인스턴스 사용자는 다음 전략을 사용하여 비용당 성능을 극대화할 수 있습니다.

- 온가속기 DDR 메모리에 MX6 마이크로 지수 정밀도를 사용하여 가중치를 저장합니다. MX6 정밀도를 사용하면 사용 가능한 메모리 용량과 메모리 대역폭의 활용도가 극대화되어 동급 최고의 처리량과 대기 시간을 제공합니다.

- FP16에서 컴퓨팅하여 필요한 사용 사례 정확도를 제공하는 동시에 우수한 온칩 SRAM과 카드의 예비 TOP를 사용하여 지연 시간이 짧은 고성능 MX6~FP16 커널을 구현합니다.

- 가중치 재사용을 최대화하는 동시에 온칩 활성화를 최대한 유지하기 위해 사용 가능한 대형 온칩 SRAM을 사용하여 최적화된 일괄 처리 전략과 더 높은 배치 크기를 사용합니다.

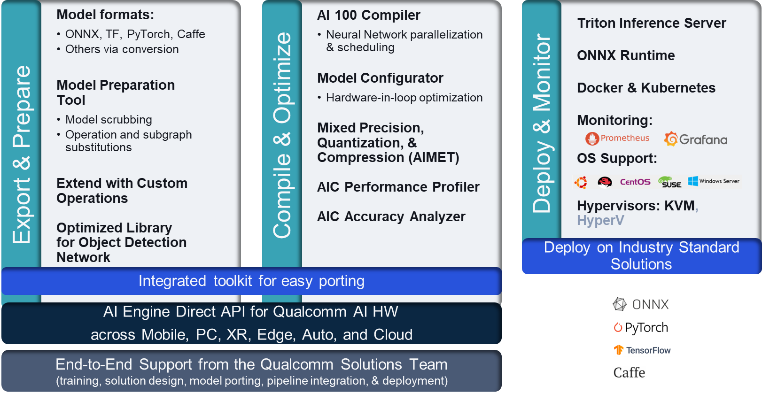

DL2q AI 스택 및 툴체인

DL2q 인스턴스에는 클라우드 및 기타 Qualcomm 제품의 Qualcomm AI 전반에 걸쳐 일관된 개발자 경험을 제공하는 Qualcomm AI 스택이 함께 제공됩니다. 동일한 Qualcomm AI 스택 및 기본 AI 기술이 DL2q 인스턴스 및 Qualcomm 엣지 장치에서 실행되어 클라우드, 자동차, 개인용 컴퓨터, 확장 현실 및 스마트폰 개발 환경 전반에 걸쳐 통합 API를 통해 고객에게 일관된 개발자 경험을 제공합니다.

툴체인을 사용하면 인스턴스 사용자는 이전에 훈련된 모델을 신속하게 온보딩하고, 인스턴스 기능에 맞게 모델을 컴파일 및 최적화한 다음, 다음 그림에 표시된 세 단계를 통해 프로덕션 추론 사용 사례를 위해 컴파일된 모델을 배포할 수 있습니다.

모델 성능 조정에 대한 자세한 내용은 다음을 참조하세요. Cloud AI 100 주요 성능 매개변수 선적 서류 비치.

DL2q 인스턴스 시작하기

이 예에서는 사전 학습된 BERT 모델 에 포옹하는 얼굴 사전 구축된 사용 가능한 DL2q AMI를 사용하여 EC2 DL2q 인스턴스에서 XNUMX단계로 진행합니다.

사전 구축된 제품 중 하나를 사용할 수 있습니다. 퀄컴 DLAMI 인스턴스에서 시작하거나 Amazon Linux2 AMI로 시작하고 여기에서 사용 가능한 Cloud AI 2 플랫폼 및 앱 SDK를 사용하여 자체 DL100q AMI를 구축하세요. Amazon Simple Storage Service(Amazon S3) 버킷: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

다음 단계에서는 사전 구축된 DL2q AMI를 사용합니다. 퀄컴 베이스 AL2 DLAMI.

SSH를 사용하여 Qualcomm Base AL2 DLAMI AMI가 포함된 DL2q 인스턴스에 액세스하고 1~4단계를 수행하세요.

1단계. 환경 설정 및 필수 패키지 설치

- 파이썬 3.8를 설치합니다.

- Python 3.8 가상 환경을 설정합니다.

- Python 3.8 가상 환경을 활성화합니다.

- 다음에 표시된 필수 패키지를 설치합니다. 요구사항.txt 문서 Qualcomm 공개 Github 사이트에서 사용할 수 있습니다.

- 필요한 라이브러리를 가져옵니다.

2단계. 모델 가져오기

- 모델을 가져오고 토큰화합니다.

- 샘플 입력을 정의하고 추출합니다.

inputIds및attentionMask. - 모델을 ONNX로 변환한 다음 컴파일러에 전달할 수 있습니다.

- FP16 정밀도로 모델을 실행합니다. 따라서 모델에 FP16 범위를 벗어나는 상수가 포함되어 있는지 확인해야 합니다. 모델을

fix_onnx_fp16필요한 수정 사항이 포함된 새 ONNX 파일을 생성하는 함수입니다.

3단계. 모델 컴파일

XNUMXD덴탈의 qaic-exec 명령줄 인터페이스(CLI) 컴파일러 도구는 모델을 컴파일하는 데 사용됩니다. 이 컴파일러에 대한 입력은 2단계에서 생성된 ONNX 파일입니다. 컴파일러는 이진 파일( QPC에 대한 Qualcomm 프로그램 컨테이너)에 의해 정의된 경로에서 -aic-binary-dir 논의.

아래 컴파일 명령에서는 XNUMX개의 AI 컴퓨팅 코어와 XNUMX개의 배치 크기를 사용하여 모델을 컴파일합니다.

QPC는 다음에서 생성됩니다. bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc 폴더에 있습니다.

4단계. 모델 실행

DL100q 인스턴스의 Cloud AI2 Qualcomm 가속기에서 추론을 실행하도록 세션을 설정합니다.

Qualcomm qaic Python 라이브러리는 Cloud AI100 가속기에서 추론 실행을 지원하는 API 세트입니다.

- 세션 API 호출을 사용하여 세션 인스턴스를 생성합니다. 세션 API 호출은 qaic Python 라이브러리를 사용하기 위한 진입점입니다.

- 다음을 사용하여 출력 버퍼의 데이터를 재구성합니다.

output_shape및output_type. - 생성된 출력을 디코딩합니다.

다음은 입력 문장 "The dog [MASK] on the mat"에 대한 출력입니다.

그게 다야. 몇 단계만 거치면 Amazon EC2 DL2q 인스턴스에서 PyTorch 모델을 컴파일하고 실행할 수 있습니다. DL2q 인스턴스의 모델 온보딩 및 컴파일에 대한 자세한 내용은 다음을 참조하세요. Cloud AI100 튜토리얼 문서.

AWS DL2q 인스턴스에 적합한 DL 모델 아키텍처와 현재 모델 지원 매트릭스에 대해 자세히 알아보려면 다음을 참조하세요. Qualcomm Cloud AI100 문서.

지금 사용 가능

오늘부터 미국 서부(오레곤) 및 유럽(프랑크푸르트) AWS 리전에서 DL2q 인스턴스를 시작할 수 있습니다. 온 디맨드, 예약및 스팟 인스턴스또는 저축 계획. 평소와 마찬가지로 Amazon EC2에서는 사용한 만큼만 비용을 지불합니다. 자세한 내용은 다음을 참조하세요. Amazon EC2 요금.

DL2q 인스턴스는 다음을 사용하여 배포할 수 있습니다. AWS Deep Learning AMI(DLAMI), 컨테이너 이미지는 다음과 같은 관리형 서비스를 통해 제공됩니다. 아마존 세이지 메이커, Amazon Elastic Kubernetes 서비스(Amazon EKS), Amazon Elastic Container Service(Amazon ECS)및 AWS 병렬 클러스터.

자세한 내용은 Amazon EC2 DL2q 인스턴스 페이지로 피드백을 보내주세요. AWS re:EC2용 게시 또는 일반적인 AWS Support 연락처를 통해

저자 소개

AK 로이 Qualcomm의 클라우드 및 데이터 센터 AI 제품 및 솔루션 제품 관리 이사입니다. 그는 제품 전략 및 개발 분야에서 20년 이상의 경험을 보유하고 있으며, 현재는 광범위한 사용 사례에 대해 클라우드 내 AI 추론을 위한 동급 최고의 성능 및 성능/$ 엔드투엔드 솔루션에 중점을 두고 있습니다. GenAI, LLM, 자동차 및 하이브리드 AI를 포함합니다.

AK 로이 Qualcomm의 클라우드 및 데이터 센터 AI 제품 및 솔루션 제품 관리 이사입니다. 그는 제품 전략 및 개발 분야에서 20년 이상의 경험을 보유하고 있으며, 현재는 광범위한 사용 사례에 대해 클라우드 내 AI 추론을 위한 동급 최고의 성능 및 성능/$ 엔드투엔드 솔루션에 중점을 두고 있습니다. GenAI, LLM, 자동차 및 하이브리드 AI를 포함합니다.

랑 지안잉 AWS Worldwide Specialist Organization(WWSO)의 수석 솔루션 아키텍트입니다. 그녀는 HPC 및 AI 분야에서 15년 이상의 업무 경험을 보유하고 있습니다. AWS에서 그녀는 고객이 가속화된 컴퓨팅 인스턴스에서 AI/ML 워크로드를 배포, 최적화 및 확장하도록 돕는 데 중점을 두고 있습니다. 그녀는 HPC와 AI 분야의 기술을 결합하는 데 열정을 갖고 있습니다. Jianying은 콜로라도 대학교 볼더 캠퍼스에서 전산 물리학 박사 학위를 취득했습니다.

랑 지안잉 AWS Worldwide Specialist Organization(WWSO)의 수석 솔루션 아키텍트입니다. 그녀는 HPC 및 AI 분야에서 15년 이상의 업무 경험을 보유하고 있습니다. AWS에서 그녀는 고객이 가속화된 컴퓨팅 인스턴스에서 AI/ML 워크로드를 배포, 최적화 및 확장하도록 돕는 데 중점을 두고 있습니다. 그녀는 HPC와 AI 분야의 기술을 결합하는 데 열정을 갖고 있습니다. Jianying은 콜로라도 대학교 볼더 캠퍼스에서 전산 물리학 박사 학위를 취득했습니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :있다

- :이다

- $UP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15년

- 15%

- 17

- 19

- 20

- 20년

- 22

- 23

- 7

- 75

- 8

- 84

- a

- 소개

- 위의

- 가속 된

- 가속 자

- 가속기

- ACCESS

- 동행 한

- 가로질러

- 활성화

- 또한

- 많은

- 골재

- AI

- AI / ML

- All

- 또한

- 아마존

- Amazon EC2

- Amazon Web Services

- an

- 및

- 강의자료

- 어떤

- API를

- API

- 어플리케이션

- 앱

- 아키텍처

- 있군요

- 논의

- ARM

- 인조의

- AS

- 비서

- At

- 자동

- 자동차

- 자발적인

- 가능

- AWS

- 축

- 대역폭

- 기지

- BE

- 전에

- 이하

- 그 너머

- BIN

- 블록

- 꽃

- 가져

- 넓은

- 버퍼

- 빌드

- by

- 전화

- 라는

- CAN

- 기능

- 생산 능력

- 카드

- 케이스

- 검사

- 고전적인

- 클라우드

- 콜로라도

- 결합

- 의사 소통

- 포괄적 인

- 계산

- 계산

- 컴퓨터

- 컴퓨터 비전

- 컴퓨터

- 컴퓨팅

- 일관된

- 구성

- 콘택트 렌즈

- 컨테이너

- 이 포함되어 있습니다

- 함유량

- 컨텐츠 생성

- 만들

- Current

- 고객

- 데이터

- 데이터 센터

- 깊은

- 깊은 학습

- 한정된

- 도

- 배달하다

- 제공

- 배포

- 배포

- 전개

- 기술 된

- 개발

- 개발자

- 개발

- 장치

- 디바이스

- 방송

- 책임자

- 선적 서류 비치

- 개

- 운전

- 동적

- Edge

- 효율적인

- 중

- 고용하다

- 수

- 끝으로 종료

- 항목

- 환경

- 환경

- 유럽

- 예

- 경험

- 확장 된 현실

- 추출물

- 그릇된

- 특색

- 피드백

- 를

- 들

- Fields

- 그림

- 입양 부모로서의 귀하의 적합성을 결정하기 위해 미국 이민국에

- 먼저,

- 맞게

- 초점

- 집중

- 따라

- 수행원

- 럭셔리

- 발견

- 사

- 프랑크푸르트

- 에

- 기능

- 퓨전

- 일반적으로

- 생성

- 생성

- 세대

- 생성적인

- 제너레이티브 AI

- GitHub의

- 주어진

- 좋은

- 손님

- 고객 포스트

- he

- 헤드셋

- 도움이

- 여기에서 지금 확인해 보세요.

- 고성능

- 더 높은

- 하이라이트

- 보유

- HPC

- HTML

- HTTPS

- 잡종

- i

- IDX

- if

- 영상

- 형상

- 구현

- 이행

- import

- in

- 포함

- 통합

- 개인

- 산업

- 업계 최고의

- 정보

- 입력

- 설치

- 예

- 인텔

- 지능형

- 상호 연결된

- 인터페이스

- IT

- JPG

- 다만

- 키

- 레인

- 언어

- 넓은

- 숨어 있음

- 시작

- 배우다

- 배우기

- 도서관

- 도서관

- 빛

- 라인

- 잔뜩

- 관리

- 구축

- 마스크

- 매트릭스

- 최대

- 극대화하다

- 최대화하다

- 최고

- 메모리

- 조화

- 메타

- Microsoft

- 분

- 모델

- 모델

- 수정

- 배우기

- 가장

- name

- 폭이 좁은

- 자연의

- 자연 언어 처리

- 필요한

- 필요

- 네트워크

- 네트워킹

- 네트워크

- 신제품

- 다음 세대

- 지금

- numpy

- 엔비디아

- 대상

- of

- on

- 온보드

- 온 보딩

- ONE

- 만

- 열 수

- OpenAI

- 최적화

- 최적화

- or

- 오레곤

- 조직

- OS

- 기타

- 아웃

- 출력

- 출력

- 위에

- 자신의

- 패키지

- 페이지

- 부품

- 패스

- 합격

- 열렬한

- 통로

- 지불

- 용

- 성능

- 확인

- 박사 학위

- 물리학

- 플랫폼

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 포인트 적립

- 인기 문서

- 가능한

- 게시하다

- powered

- Precision

- 이전에

- 교장

- 처리

- 생산

- 생산하다

- 프로덕트

- 제품 관리

- 생산

- 제품

- 프로그램

- 프로젝트

- 제공

- 제공

- 공개

- Python

- 파이 토치

- 자격

- 빨리

- 범위

- RE

- 읽기

- 현실

- 지역

- 필수

- 요구조건 니즈

- 유지

- return

- 재사용

- 로이

- 달리기

- 달리는

- 실행

- 같은

- 찜하기

- 절약

- 확장성

- 규모

- SDK

- 둘째

- 참조

- 보내다

- 문장

- 순서

- 서비스

- 서비스

- 세션

- 세트

- 그녀

- 표시

- 단순, 간단, 편리

- 단순화

- 대지

- 크기

- 스마트 폰

- 스마트폰

- So

- 솔루션

- 스패닝

- 전문가

- 스택

- 표준

- 스타트

- 시작

- 단계

- 단계

- 저장

- 저장

- 저장

- 전략

- 그후

- 이러한

- 우수한

- SUPPORT

- 지원

- 지원

- SYS

- 체계

- 테이블

- 기법

- Technology

- 본문

- 그

- XNUMXD덴탈의

- 그들의

- 그때

- Bowman의

- 그들

- 이

- 세

- 을 통하여

- 처리량

- 죽

- 에

- 오늘

- 토큰 화하다

- 수단

- 상의

- 토치

- 금액

- 교통

- 훈련 된

- 변압기

- 참된

- 동조

- 지도 시간

- 통일

- 대학

- us

- 사용

- 유스 케이스

- 사용 사례

- 익숙한

- 사용자

- 사용

- 보통의

- v1

- 유효 기간

- 가치

- 온라인

- 시력

- 방문

- we

- 웹

- 웹 서비스

- 잘

- West

- 뭐

- 어느

- 동안

- 넓은

- 넓은 범위

- 의지

- 과

- 워드

- 일하는

- 전세계적인

- 년

- 자신의

- 너의

- 제퍼 넷