오늘 우리는 Meta를 사용하여 Llama 2 모델을 미세 조정하는 기능을 발표하게 되어 기쁘게 생각합니다. Amazon SageMaker 점프스타트. Llama 2 LLM(대형 언어 모델) 제품군은 7억~70억 개의 매개변수 범위에 걸쳐 사전 훈련되고 미세 조정된 생성 텍스트 모델 컬렉션입니다. Llama-2-chat이라고 하는 미세 조정된 LLM은 대화 사용 사례에 최적화되어 있습니다. 이러한 모델을 쉽게 시험해보고 ML을 빠르게 시작할 수 있도록 알고리즘, 모델 및 ML 솔루션에 대한 액세스를 제공하는 기계 학습(ML) 허브인 SageMaker JumpStart와 함께 사용할 수 있습니다. 이제 SageMaker JumpStart를 사용하여 7억, 13억 및 70억 매개변수 Llama 2 텍스트 생성 모델을 미세 조정할 수도 있습니다. 아마존 세이지 메이커 스튜디오 몇 번의 클릭만으로 UI를 만들거나 SageMaker Python SDK를 사용할 수 있습니다.

생성적 AI 기반 모델은 현재 XNUMX년 넘게 대부분의 ML 및 인공 지능 연구와 사용 사례의 초점이 되어 왔습니다. 이러한 기초 모델은 크기가 크고 여러 개의 대규모 데이터 세트와 수백 개의 작업에 대해 훈련되었기 때문에 텍스트 생성, 요약, 질문 답변, 이미지 및 비디오 생성 등과 같은 생성 작업에서 매우 잘 수행됩니다. 이러한 모델의 뛰어난 일반화 기능에도 불구하고 매우 구체적인 도메인 데이터(예: 의료 또는 금융 서비스)가 있는 사용 사례가 종종 있으므로 이러한 모델은 이러한 사용 사례에 좋은 결과를 제공하지 못할 수 있습니다. 이로 인해 사용 사례별 및 도메인별 데이터에 대해 이러한 생성 AI 모델을 더욱 세부적으로 조정할 필요가 있습니다.

이 게시물에서는 SageMaker JumpStart를 통해 사전 훈련된 Llama 2 텍스트 생성 모델을 미세 조정하는 방법을 안내합니다.

라마 2 란?

Llama 2는 최적화된 변환기 아키텍처를 사용하는 자동 회귀 언어 모델입니다. Llama 2는 영어로 된 상업용 및 연구용입니다. 7억, 13억, 70억 등의 다양한 매개변수 크기와 사전 훈련 및 미세 조정된 변형으로 제공됩니다. Meta에 따르면 조정된 버전은 지도 미세 조정(SFT) 및 인간 피드백을 통한 강화 학습(RLHF)을 사용하여 유용성과 안전성에 대한 인간의 선호도에 맞춥니다. Llama 2는 공개적으로 사용 가능한 소스에서 2조 개의 데이터 토큰으로 사전 훈련되었습니다. 조정된 모델은 비서와 같은 채팅을 위한 반면 사전 훈련된 모델은 다양한 자연어 생성 작업에 맞게 조정할 수 있습니다. 개발자가 사용하는 모델의 버전에 관계없이 Meta의 책임감 있는 사용 가이드 적절한 안전 완화로 모델을 사용자 정의하고 최적화하는 데 필요할 수 있는 추가 미세 조정을 안내하는 데 도움을 줄 수 있습니다.

현재 Llama 2는 다음 지역에서 사용할 수 있습니다.

- 사용 가능한 사전 학습된 모델 배포:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - 미세 조정된 모델을 미세 조정하고 배포합니다.

“us-east-1”,“us-west-2”,“eu-west-1”

SageMaker JumpStart란?

SageMaker JumpStart를 사용하면 ML 실무자는 공개적으로 사용 가능한 다양한 기초 모델 중에서 선택할 수 있습니다. ML 실무자는 기초 모델을 전용 모델에 배포할 수 있습니다. 아마존 세이지 메이커 네트워크 격리 환경의 인스턴스를 생성하고 모델 훈련 및 배포를 위해 SageMaker를 사용하여 모델을 사용자 정의합니다. 이제 SageMaker Studio에서 몇 번의 클릭만으로 또는 SageMaker Python SDK를 통해 프로그래밍 방식으로 Llama 2를 검색하고 배포할 수 있습니다. 이를 통해 다음과 같은 SageMaker 기능을 통해 모델 성능 및 MLOps 제어를 도출할 수 있습니다. Amazon SageMaker 파이프 라인, Amazon SageMaker 디버거또는 컨테이너 로그. 이 모델은 AWS 보안 환경과 VPC 제어에 배포되어 데이터 보안을 보장합니다. 또한 SageMaker JumpStart를 통해 Llama2 7B, 13B 및 70B 사전 훈련된 텍스트 생성 모델을 미세 조정할 수 있습니다.

Llama2 모델 미세 조정

SageMaker Studio UI 또는 SageMaker Python SDK를 사용하여 모델을 미세 조정할 수 있습니다. 이 섹션에서는 두 가지 방법을 모두 논의합니다.

SageMaker Studio UI를 통한 코드 없이 미세 조정

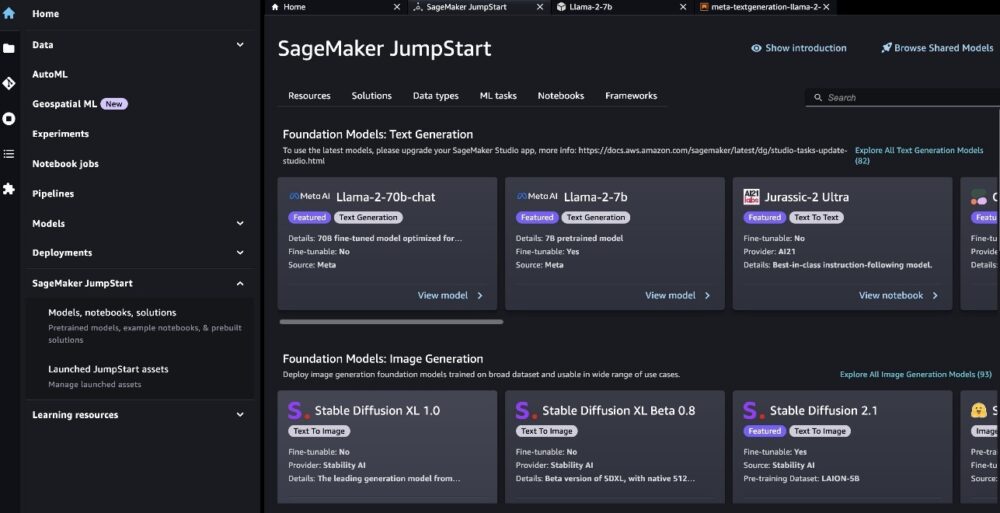

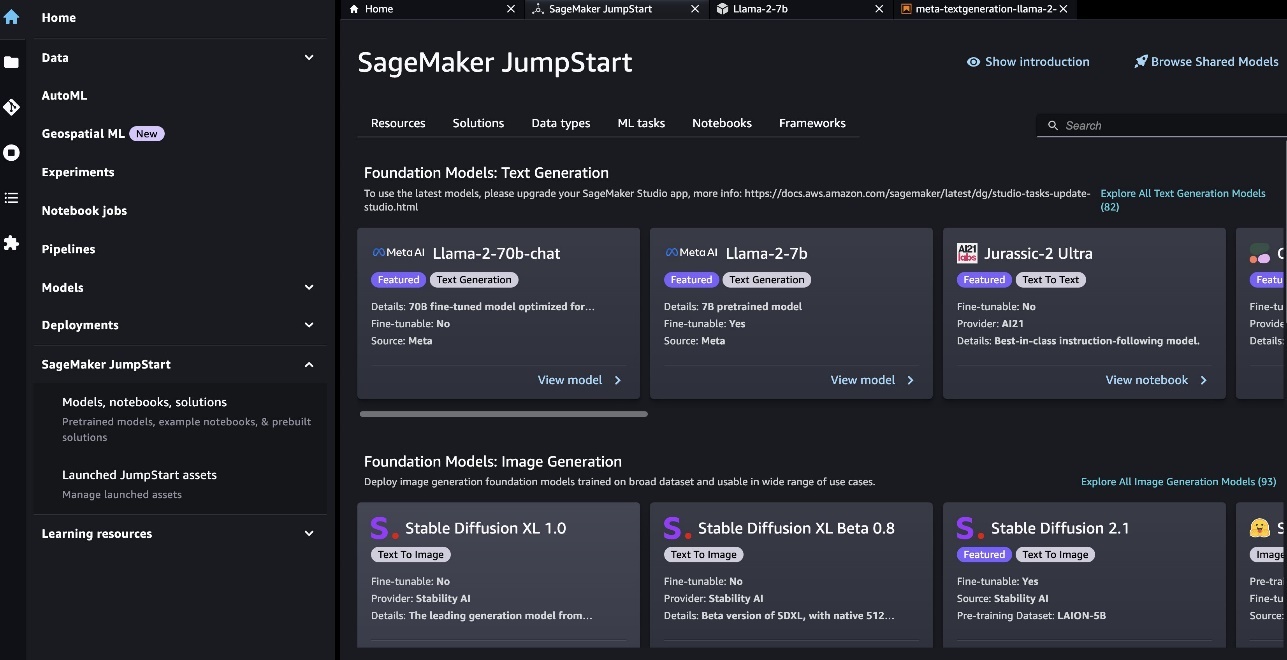

SageMaker Studio에서는 SageMaker JumpStart를 통해 Llama 2 모델에 액세스할 수 있습니다. 모델, 노트북 및 솔루션다음 스크린 샷에 표시된대로

Llama 2 모델이 표시되지 않으면 종료했다가 다시 시작해 SageMaker Studio 버전을 업데이트하십시오. 버전 업데이트에 대한 자세한 내용은 다음을 참조하세요. Studio 앱 종료 및 업데이트.

선택하여 다른 네 가지 모델 변형을 찾을 수도 있습니다. 모든 텍스트 생성 모델 살펴보기 아니면 검색창에 라마를 검색해 보세요.

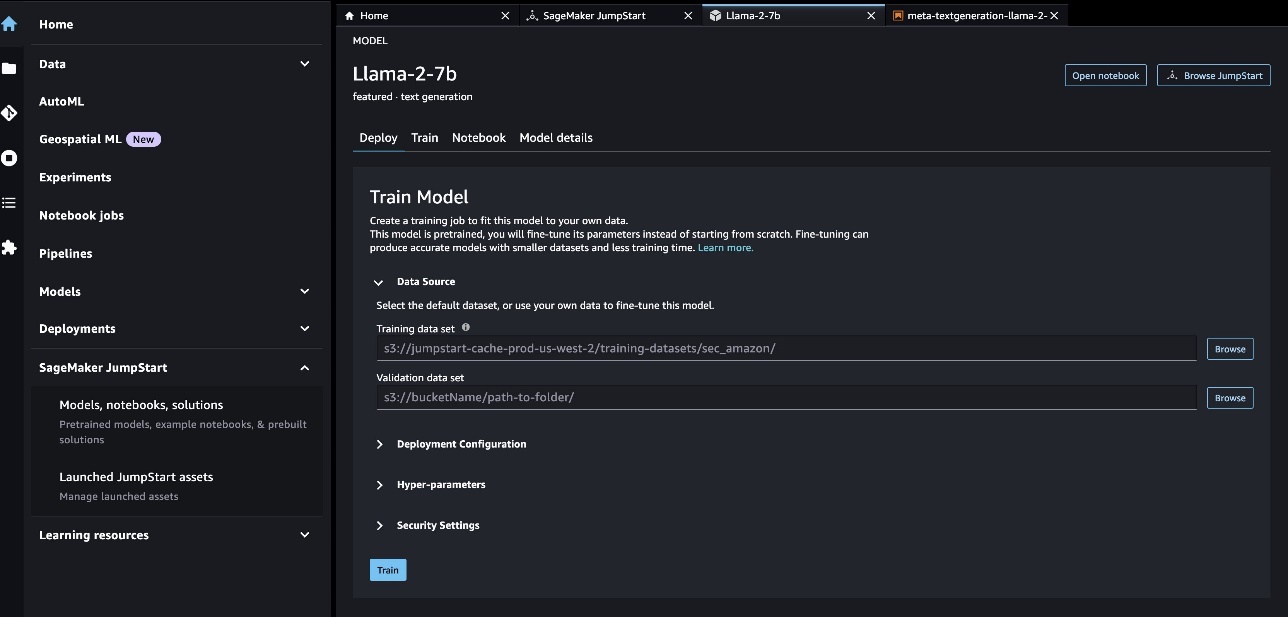

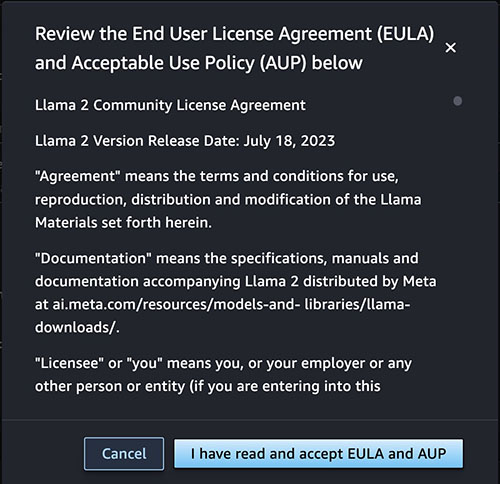

이 페이지에서 다음을 가리킬 수 있습니다. 아마존 단순 스토리지 서비스 (Amazon S3) 미세 조정을 위한 훈련 및 검증 데이터 세트가 포함된 버킷입니다. 또한 미세 조정을 위한 배포 구성, 하이퍼 매개변수 및 보안 설정을 구성할 수 있습니다. 그런 다음 선택할 수 있습니다 Train SageMaker ML 인스턴스에서 훈련 작업을 시작합니다. 앞의 스크린샷은 Llama-2 7B 모델의 미세 조정 페이지를 보여줍니다. 그러나 해당 모델 페이지를 유사하게 사용하여 13B 및 70B Llama 2 텍스트 생성 모델을 미세 조정할 수 있습니다. Llama 2 모델을 사용하려면 EULA(최종 사용자 사용권 계약)에 동의해야 합니다. 선택하면 표시됩니다. Train , 다음 스크린샷과 같이. 선택하다 EULA 및 AUP를 읽고 이에 동의합니다. 미세 조정 작업을 시작합니다.

모델 배포

모델을 미세 조정한 후 SageMaker JumpStart의 모델 페이지를 사용하여 배포할 수 있습니다. 다음 스크린샷과 같이 미세 조정이 완료되면 미세 조정된 모델을 배포하는 옵션이 나타납니다.

SageMaker Python SDK를 통해 미세 조정

SageMaker Python SDK를 사용하여 Llama 2 모델을 미세 조정할 수도 있습니다. 다음은 데이터 세트에서 Llama 2 7B를 미세 조정하는 샘플 코드입니다.

추정기에서 직접 미세 조정된 모델을 배포할 수 있습니다.

다음에서도 코드를 찾을 수 있습니다. SageMaker JumpStart에서 LLaMA 2 모델 미세 조정. 여기에는 데이터세트 준비, 사용자 정의 데이터세트에 대한 교육, 미세 조정된 모델 배포가 포함됩니다. 요약 작업의 예를 통해 Dolly 데이터 세트의 하위 집합에 대한 미세 조정을 보여줍니다. 다음은 정답 응답과 함께 미세 조정된 응답과 미세 조정되지 않은 응답이 포함된 입력 예입니다.

모델에 입력:

Ground Truth 응답:

미세 조정되지 않은 모델의 응답:

미세 조정된 모델의 응답:

Dolly 및 Dialogsum 데이터세트의 다양한 모델에 대한 성능 벤치마킹은 다음을 참조하세요. 성능 벤치마킹 이 게시물 끝에 있는 부록의 섹션을 참조하세요.

미세 조정 기술

Llama와 같은 언어 모델의 크기는 10GB 이상, 심지어 100GB 이상입니다. 이러한 대규모 모델을 미세 조정하려면 상당히 높은 CUDA 메모리를 갖춘 인스턴스가 필요합니다. 게다가, 이러한 모델을 훈련하는 것은 모델의 크기로 인해 매우 느릴 수 있습니다. 따라서 효율적인 미세 조정을 위해 다음과 같은 최적화를 사용합니다.

- 낮은 순위 적응(LoRA) – 대형 모델의 효율적인 미세 조정을 위한 PEFT(Parameter Efficient Fine-Tuning)의 일종입니다. 여기에서는 전체 모델을 동결하고 조정 가능한 작은 매개변수 또는 레이어 세트만 모델에 추가합니다. 예를 들어 Llama 7 2B에 대해 7억 개의 매개변수를 모두 훈련하는 대신 매개변수의 1% 미만을 미세 조정할 수 있습니다. 이는 매개변수의 1%에 대해서만 기울기, 최적화 상태 및 기타 훈련 관련 정보만 저장하면 되므로 메모리 요구 사항을 크게 줄이는 데 도움이 됩니다. 또한 이는 교육 시간과 비용을 줄이는 데 도움이 됩니다. 이 방법에 대한 자세한 내용은 다음을 참조하세요. LoRA: 대규모 언어 모델의 낮은 순위 적응.

- Int8 양자화 – LoRA와 같은 최적화를 적용하더라도 Llama 70B와 같은 모델은 여전히 학습하기에는 너무 큽니다. 훈련 중에 메모리 공간을 줄이기 위해 훈련 중에 Int8 양자화를 사용할 수 있습니다. 양자화는 일반적으로 부동 소수점 데이터 유형의 정밀도를 감소시킵니다. 이렇게 하면 모델 가중치를 저장하는 데 필요한 메모리가 줄어들지만 정보 손실로 인해 성능이 저하됩니다. Int8 양자화는 8/XNUMX 정밀도만 사용하지만 단순히 비트를 삭제하는 것이 아니기 때문에 성능 저하가 발생하지 않습니다. 데이터를 한 유형에서 다른 유형으로 반올림합니다. IntXNUMX 양자화에 대해 알아보려면 다음을 참조하세요. LLM.int8(): 대규모 변환기를 위한 8비트 행렬 곱셈.

- 완전 샤딩 데이터 병렬(FSDP) – 이는 모델의 매개변수를 데이터 병렬 작업자 간에 분할하고 선택적으로 훈련 계산의 일부를 CPU로 오프로드할 수 있는 일종의 데이터 병렬 훈련 알고리즘입니다. 매개변수는 서로 다른 GPU에 걸쳐 분할되지만 각 마이크로배치의 계산은 GPU 작업자에 따라 로컬로 수행됩니다. 매개변수를 보다 균일하게 분할하고 훈련 중 통신 및 계산 중첩을 통해 최적화된 성능을 달성합니다.

다음 표에서는 세 가지 Llama 2 모델의 다양한 방법을 비교합니다.

| , | 기본 인스턴스 유형 | 기본 구성으로 지원되는 인스턴스 유형 | 기본 설정 | 로라 + FSDP | LORA + FSDP 없음 | Int8 양자화 + LORA + FSDP 없음 |

| 라마 2 7B | ml.g5.12xlarge | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | 로라 + FSDP | 가능 | 가능 | 가능 |

| 라마 2 13B | ml.g5.12xlarge | ml.g5.24xlarge, ml.g5.48xlarge | 로라 + FSDP | 가능 | 가능 | 가능 |

| 라마 2 70B | ml.g5.48xlarge | ml.g5.48xlarge | INT8 + LORA + FSDP 없음 | 아니 | 아니 | 가능 |

Llama 모델의 미세 조정은 다음에서 제공하는 스크립트를 기반으로 합니다. GitHub 레포.

훈련 데이터 세트 형식

SageMaker JumpStart는 현재 도메인 적응 형식과 명령 조정 형식 모두의 데이터 세트를 지원합니다. 이 섹션에서는 두 형식 모두의 예시 데이터 세트를 지정합니다. 자세한 내용은 다음을 참조하세요. 데이터세트 형식화 부록의 섹션.

도메인 적응 형식

텍스트 생성 Llama 2 모델은 모든 도메인별 데이터 세트에서 미세 조정할 수 있습니다. 도메인별 데이터 세트를 미세 조정한 후 모델은 도메인별 텍스트를 생성하고 몇 번의 프롬프트를 통해 해당 특정 도메인에서 다양한 NLP 작업을 해결할 것으로 예상됩니다. 이 데이터 세트를 사용하면 입력이 CSV, JSON 또는 TXT 파일로 구성됩니다. 예를 들어 입력 데이터는 Amazon의 SEC 제출 텍스트 파일일 수 있습니다.

명령어 튜닝 형식

명령어 미세 조정에서 모델은 명령어를 사용하여 설명된 일련의 자연어 처리(NLP) 작업에 맞게 미세 조정됩니다. 이는 제로샷 프롬프트를 통해 보이지 않는 작업에 대한 모델 성능을 향상시키는 데 도움이 됩니다. 명령어 튜닝 데이터 세트 형식에서 다음을 지정합니다. template.json 입력 및 출력 형식을 설명하는 파일입니다. 예를 들어 파일의 각 줄은 train.jsonl 다음과 같이 보입니다.

추가 파일 template.json 다음과 같이 보입니다.

훈련에 지원되는 하이퍼파라미터

Llama 2 미세 조정은 다양한 하이퍼파라미터를 지원하며 각 하이퍼파라미터는 미세 조정된 모델의 메모리 요구 사항, 훈련 속도 및 성능에 영향을 미칠 수 있습니다.

- 시대 – 미세 조정 알고리즘이 교육 데이터 세트를 통과하는 패스 수입니다. 1보다 큰 정수여야 합니다. 기본값은 5입니다.

- 학습_속도 – 각 훈련 예제 배치를 처리한 후 모델 가중치가 업데이트되는 속도입니다. 0보다 큰 양수 부동 소수점이어야 합니다. 기본값은 1e-4입니다.

- Instruction_tuned – 모델을 교육할 것인지 여부. 반드시 '

True'또는'False'. 기본값은 'False'. - per_device_train_batch_size – 훈련을 위한 GPU 코어/CPU당 배치 크기입니다. 양의 정수여야 합니다. 기본값은 4입니다.

- per_device_eval_batch_size – 평가를 위한 GPU 코어/CPU당 배치 크기입니다. 양의 정수여야 합니다. 기본값은 1입니다.

- max_train_samples – 디버깅 목적 또는 빠른 교육을 위해 교육 예제 수를 이 값으로 자릅니다. 값 -1은 모든 훈련 샘플을 사용함을 의미합니다. 양의 정수 또는 -1이어야 합니다. 기본값은 -1입니다.

- max_val_samples – 디버깅 목적이나 빠른 교육을 위해 검증 예제 수를 이 값으로 자릅니다. 값 -1은 모든 검증 샘플을 사용함을 의미합니다. 양의 정수 또는 -1이어야 합니다. 기본값은 -1입니다.

- 최대 입력_길이 – 토큰화 후 최대 총 입력 시퀀스 길이. 이보다 긴 시퀀스는 잘립니다. -1이면,

max_input_length최소값 1024와 토크나이저에서 정의한 최대 모델 길이로 설정됩니다. 양수 값으로 설정하면max_input_length제공된 값의 최소값으로 설정되며model_max_length토크나이저에 의해 정의됩니다. 양의 정수 또는 -1이어야 합니다. 기본값은 -1입니다. - 검증_분할_비율 – 검증 채널이 다음과 같은 경우

none, 열차 데이터의 열차 검증 분할 비율은 0-1 사이여야 합니다. 기본값은 0.2입니다. - train_data_split_seed – 검증 데이터가 없는 경우 입력 훈련 데이터를 알고리즘에서 사용하는 훈련 및 검증 데이터로 무작위로 분할하는 문제가 수정됩니다. 정수여야 합니다. 기본값은 0입니다.

- preprocessing_num_workers – 전처리에 사용할 프로세스 수입니다. 만약에

None, 주요 프로세스는 전처리에 사용됩니다. 기본값은None. - lora_r – Lora R. 양의 정수여야 합니다. 기본값은 8입니다.

- lora_alpha – 로라 알파. 양의 정수여야 합니다. 기본값은 32입니다.

- lora_dropout – 로라 드롭아웃. 0과 1 사이의 양수 부동 소수점이어야 합니다. 기본값은 0.05입니다.

- int8_양자화 - 만약

True, 모델은 훈련을 위해 8비트 정밀도로 로드됩니다. 7B 및 13B의 기본값은 다음과 같습니다.False. 70B의 기본값은True. - 활성화_fsdp - 만약

True, 교육에서는 FSDP를 사용합니다. 7B 및 13B의 기본값은 다음과 같습니다.True. 70B의 기본값은False. 그 주int8_quantizationFSDP에서는 지원되지 않습니다.

인스턴스 유형 및 호환되는 하이퍼파라미터

미세 조정 중 메모리 요구 사항은 여러 요인에 따라 달라질 수 있습니다.

- 모델 유형 – 7B 모델은 GPU 메모리 요구 사항이 가장 적고 70B는 메모리 요구 사항이 가장 큽니다.

- 최대 입력 길이 – 입력 길이 값이 높을수록 한 번에 더 많은 토큰을 처리하게 되므로 더 많은 CUDA 메모리가 필요합니다.

- 배치 크기 – 배치 크기가 클수록 더 큰 CUDA 메모리가 필요하므로 더 큰 인스턴스 유형이 필요합니다.

- Int8 양자화 – Int8 양자화를 사용하는 경우 모델은 낮은 정밀도로 로드되므로 CUDA 메모리가 덜 필요합니다.

시작하는 데 도움이 되도록 성공적으로 미세 조정할 수 있는 다양한 인스턴스 유형, 하이퍼파라미터 및 모델 유형의 조합 세트를 제공합니다. 요구 사항 및 인스턴스 유형의 가용성에 따라 구성을 선택할 수 있습니다. 요약 예제가 포함된 Dolly 데이터세트의 하위 집합에 대해 세 가지 시대를 사용하여 다양한 설정에서 세 가지 모델을 모두 미세 조정합니다.

7B 모델

다음 표에는 7B 모델의 미세 조정 옵션이 요약되어 있습니다.

| 인스턴스 유형 | 최대 입력 렌 | 장치당 배치 크기 | Int8 양자화 | FSDP 활성화 | 소요 시간(분) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | 그릇된 | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | 그릇된 | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | 그릇된 | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | 그릇된 | TRUE | 143 |

| ml.g5.2xlarge | 1024 | 4 | TRUE | 그릇된 | 61 |

| ml.g5.2xlarge | 2048 | 2 | TRUE | 그릇된 | 68 |

| ml.g5.2xlarge | 1024 | 4 | 그릇된 | TRUE | 43 |

| ml.g5.2xlarge | 2048 | 2 | 그릇된 | TRUE | 49 |

| ml.g5.4xlarge | 1024 | 4 | 그릇된 | TRUE | 39 |

| ml.g5.4xlarge | 2048 | 2 | 그릇된 | TRUE | 50 |

| ml.g5.12xlarge | 1024 | 16 | TRUE | 그릇된 | 57 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | 그릇된 | 64 |

| ml.g5.12xlarge | 1024 | 4 | 그릇된 | TRUE | 26 |

| ml.g5.12xlarge | 2048 | 4 | 그릇된 | TRUE | 23 |

| ml.g5.48xlarge | 1024 | 16 | TRUE | 그릇된 | 59 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | 그릇된 | 67 |

| ml.g5.48xlarge | 1024 | 8 | 그릇된 | TRUE | 22 |

| ml.g5.48xlarge | 2048 | 4 | 그릇된 | TRUE | 21 |

13B

다음 표에는 13B 모델의 미세 조정 옵션이 요약되어 있습니다.

| 인스턴스 유형 | 최대 입력 렌 | 장치당 배치 크기 | Int8 양자화 | FSDP 활성화 | 소요 시간(분) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | 그릇된 | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | 그릇된 | 328 |

| ml.g5.12xlarge | 1024 | 8 | TRUE | 그릇된 | 92 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | 그릇된 | 104 |

| ml.g5.48xlarge | 1024 | 8 | TRUE | 그릇된 | 95 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | 그릇된 | 107 |

| ml.g5.48xlarge | 1024 | 8 | 그릇된 | TRUE | 35 |

| ml.g5.48xlarge | 2048 | 2 | 그릇된 | TRUE | 41 |

70B

다음 표에는 70B 모델의 미세 조정 옵션이 요약되어 있습니다.

| 인스턴스 유형 | 최대 입력 렌 | 장치당 배치 크기 | Int8 양자화 | FSDP 활성화 | 소요 시간(분) |

| ml.g5.48xlarge | 1024 | 4 | TRUE | 그릇된 | 396 |

| ml.g5.48xlarge | 2048 | 1 | TRUE | 그릇된 | 454 |

인스턴스 유형 및 하이퍼파라미터에 대한 권장 사항

모델의 정확도를 미세 조정할 때 다음 사항에 유의하세요.

- 70B와 같은 대형 모델은 7B보다 더 나은 성능을 제공합니다.

- Int8 양자화가 없는 성능은 INT8 양자화가 있는 성능보다 우수합니다.

다음 교육 시간 및 CUDA 메모리 요구 사항에 유의하세요.

- 환경

int8_quantization=True메모리 요구 사항이 줄어들고 더 빠른 훈련이 가능해집니다. - 감소

per_device_train_batch_size및max_input_length메모리 요구 사항이 줄어들므로 더 작은 인스턴스에서 실행할 수 있습니다. 그러나 매우 낮은 값을 설정하면 훈련 시간이 늘어날 수 있습니다. - Int8 양자화를 사용하지 않는 경우(

int8_quantization=False), FSDP(enable_fsdp=True) 더 빠르고 효율적인 훈련을 위해.

인스턴스 유형을 선택할 때 다음을 고려하십시오.

- G5 인스턴스는 지원되는 인스턴스 유형 중에서 가장 효율적인 교육을 제공합니다. 따라서 사용 가능한 G5 인스턴스가 있으면 이를 사용해야 합니다.

- 훈련 시간은 GPU 수와 사용 가능한 CUDA 메모리 양에 따라 크게 달라집니다. 따라서 동일한 수의 GPU(예: ml.g5.2xlarge 및 ml.g5.4xlarge)를 사용하는 인스턴스에 대한 교육은 거의 동일합니다. 따라서 훈련에는 더 저렴한 인스턴스(ml.g5.2xlarge)를 사용할 수 있습니다.

- p3 인스턴스를 사용하는 경우 bfloat32이 해당 인스턴스에서 지원되지 않으므로 교육은 16비트 정밀도로 수행됩니다. 따라서 훈련 작업은 g3 인스턴스에 비해 p5 인스턴스에서 훈련할 때 CUDA 메모리 양을 두 배로 소비합니다.

인스턴스당 훈련 비용에 대해 알아보려면 다음을 참조하세요. Amazon EC2 G5 인스턴스.

데이터세트가 명령 조정 형식이고 입력+완료 시퀀스가 작은 경우(예: 50~100단어) 높은 값은 max_input_length 매우 낮은 성능으로 이어집니다. 이 매개변수의 기본값은 -1입니다. max_input_length Llama 모델의 경우 2048년. 따라서 데이터 세트에 작은 샘플이 포함된 경우 작은 값을 사용하는 것이 좋습니다. max_input_length (예: 200-400).

마지막으로, G5 인스턴스에 대한 높은 수요로 인해 해당 지역에서 이러한 인스턴스를 사용하지 못할 수 있으며 오류가 발생할 수 있습니다. “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” 이 오류가 발생하면 훈련 작업을 다시 시도하거나 다른 리전을 시도하십시오.

매우 큰 모델을 미세 조정할 때 발생하는 문제

이 섹션에서는 매우 큰 모델을 미세 조정할 때 발생하는 두 가지 문제에 대해 논의합니다.

출력 압축 비활성화

기본적으로 훈련 작업의 출력은 Amazon S3에 업로드되기 전에 .tar.gz 형식으로 압축된 훈련된 모델입니다. 그러나 모델의 크기가 크기 때문에 이 단계는 시간이 오래 걸릴 수 있습니다. 예를 들어 70B 모델을 압축하고 업로드하는 데는 4시간 이상이 걸릴 수 있습니다. 이 문제를 방지하려면 SageMaker 교육 플랫폼에서 지원하는 출력 압축 비활성화 기능을 사용할 수 있습니다. 이 경우 모델은 압축 없이 업로드되며 배포에 추가로 사용됩니다.

SageMaker Studio 커널 시간 초과 문제

Llama 70B 모델의 크기로 인해 훈련 작업에 몇 시간이 걸릴 수 있으며 훈련 단계 중에 SageMaker Studio 커널이 종료될 수 있습니다. 그러나 이 기간 동안 SageMaker에서는 훈련이 계속 실행됩니다. 이런 경우에도 다음 코드와 함께 훈련 작업 이름을 사용하여 엔드포인트를 배포할 수 있습니다.

훈련 작업 이름을 찾으려면 SageMaker 콘솔로 이동한 후 트레이닝 탐색 창에서 훈련 직업. 훈련 작업 이름을 식별하고 이를 이전 코드로 대체합니다.

결론

이 게시물에서는 SageMaker JumpStart를 사용하여 Meta의 Llama 2 모델을 미세 조정하는 방법에 대해 논의했습니다. SageMaker Studio 또는 SageMaker Python SDK의 SageMaker JumpStart 콘솔을 사용하여 이러한 모델을 미세 조정하고 배포할 수 있음을 보여주었습니다. 또한 미세 조정 기술, 인스턴스 유형 및 지원되는 하이퍼파라미터에 대해서도 논의했습니다. 또한, 우리가 실시한 다양한 테스트를 바탕으로 최적화된 교육에 대한 권장 사항을 간략하게 설명했습니다. 두 개의 데이터 세트에 대해 세 가지 모델을 미세 조정한 결과는 이 게시물 끝에 있는 부록에 나와 있습니다. 이러한 결과에서 볼 수 있듯이 미세 조정은 미세 조정되지 않은 모델에 비해 요약을 향상시킵니다. 다음 단계에서는 GitHub 리포지토리에 제공된 코드를 사용하여 자신의 데이터 세트에서 이러한 모델을 미세 조정하여 사용 사례에 대한 결과를 테스트하고 벤치마킹할 수 있습니다.

저자들은 Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne 및 June의 기술적 기여에 감사를 표하고 싶습니다. 이겼다.

저자에 관하여

비벡 마단 박사 Amazon SageMaker JumpStart 팀의 응용 과학자입니다. 그는 일리노이 대학교 어바나 샴페인에서 박사 학위를 받았고 조지아 공대에서 박사후 연구원이었습니다. 그는 기계 학습 및 알고리즘 설계 분야에서 활발한 연구원이며 EMNLP, ICLR, COLT, FOCS 및 SODA 컨퍼런스에 논문을 발표했습니다.

비벡 마단 박사 Amazon SageMaker JumpStart 팀의 응용 과학자입니다. 그는 일리노이 대학교 어바나 샴페인에서 박사 학위를 받았고 조지아 공대에서 박사후 연구원이었습니다. 그는 기계 학습 및 알고리즘 설계 분야에서 활발한 연구원이며 EMNLP, ICLR, COLT, FOCS 및 SODA 컨퍼런스에 논문을 발표했습니다.

파루크 사비르 박사 AWS의 수석 인공 지능 및 기계 학습 전문가 솔루션 설계자입니다. 그는 오스틴에 있는 텍사스 대학교에서 전기 공학 박사 및 석사 학위를, 조지아 공과 대학에서 컴퓨터 공학 석사 학위를 받았습니다. 그는 15년 이상의 경력을 가지고 있으며 대학생들을 가르치고 멘토링하는 것을 좋아합니다. AWS에서 그는 고객이 데이터 과학, 기계 학습, 컴퓨터 비전, 인공 지능, 수치 최적화 및 관련 도메인에서 비즈니스 문제를 공식화하고 해결하도록 돕습니다. 텍사스주 댈러스에 거주하는 그와 그의 가족은 여행과 장거리 자동차 여행을 좋아합니다.

파루크 사비르 박사 AWS의 수석 인공 지능 및 기계 학습 전문가 솔루션 설계자입니다. 그는 오스틴에 있는 텍사스 대학교에서 전기 공학 박사 및 석사 학위를, 조지아 공과 대학에서 컴퓨터 공학 석사 학위를 받았습니다. 그는 15년 이상의 경력을 가지고 있으며 대학생들을 가르치고 멘토링하는 것을 좋아합니다. AWS에서 그는 고객이 데이터 과학, 기계 학습, 컴퓨터 비전, 인공 지능, 수치 최적화 및 관련 도메인에서 비즈니스 문제를 공식화하고 해결하도록 돕습니다. 텍사스주 댈러스에 거주하는 그와 그의 가족은 여행과 장거리 자동차 여행을 좋아합니다.

Ashish Khetan 박사 Amazon SageMaker JumpStart의 수석 응용 과학자이며 기계 학습 알고리즘 개발을 돕습니다. 그는 University of Illinois Urbana-Champaign에서 박사 학위를 받았습니다. 그는 기계 학습 및 통계적 추론 분야에서 활동적인 연구원이며 NeurIPS, ICML, ICLR, JMLR, ACL 및 EMNLP 컨퍼런스에서 많은 논문을 발표했습니다.

Ashish Khetan 박사 Amazon SageMaker JumpStart의 수석 응용 과학자이며 기계 학습 알고리즘 개발을 돕습니다. 그는 University of Illinois Urbana-Champaign에서 박사 학위를 받았습니다. 그는 기계 학습 및 통계적 추론 분야에서 활동적인 연구원이며 NeurIPS, ICML, ICLR, JMLR, ACL 및 EMNLP 컨퍼런스에서 많은 논문을 발표했습니다.

충수

이 부록에서는 성능 벤치마킹 및 데이터세트 형식화에 대한 추가 정보를 제공합니다.

성능 벤치마킹

이 섹션에서는 두 개의 서로 다른 데이터 세트에서 세 개의 Llama 2 모델(7B, 13B 및 70B)을 미세 조정한 결과를 제공합니다. 인형 및 대화상자. Dolly 데이터세트의 경우 우리의 임무는 텍스트 단락을 요약하는 것이고, Dialogsum의 경우 두 사람 간의 토론을 요약하기 위해 모델을 미세 조정하는 것입니다. 다음 표에서는 모델에 대한 입력(프롬프트 및 지침), 실제 정보(요약), 사전 훈련된 Llama 2 모델의 응답, 세 개의 Llama 각각에 대한 미세 조정된 Llama 2 모델의 응답을 보여줍니다. 2가지 모델. XNUMX개의 데이터 포인트에 대한 추론 결과를 보여줍니다. 다음 표에서 모델을 미세 조정하면 두 데이터 세트 모두에 대한 요약이 향상된다는 것을 알 수 있습니다.

- Dolly 데이터 세트에서 Llama 2 7B 텍스트 생성 모델을 미세 조정한 결과:

| 입력 | 지상 진실 | 미세 조정되지 않은 모델의 응답 | 미세 조정된 모델의 응답 |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:nAllauchnn은 어디에### 입력:nAllauch(프랑스어 발음: ; Occitan: Alaug)는 Bouches-du-Rhône 부서의 마르세유 동쪽에 위치한 프랑스 코뮌입니다. 프랑스 프로방스-알프-코트다쥐르(Provence-Alpes-Côte d'Azur) 지역.nn이 공동체의 주민들은 프랑스어로 Allaudiens 또는 Allaudiennes로 알려져 있습니다.nnnn### 응답:n | Allauch는 프랑스 Provence-Alpes-Côte d'Azur 지역의 Bouches-du-Rhône 부서에 있는 마르세유 동쪽에 위치한 프랑스 코뮌입니다.nn이 코뮌의 주민들은 프랑스어로 Allaudiens 또는 Allaudiennes로 알려져 있습니다. | 알라우(Allauch)는 프랑스 프로방스알프코트다쥐르(Provence-Alpes-Côte d'Azur) 지역 부슈뒤론(Bouches-du-Rhône)현에 있는 마르세유에서 동쪽으로 28km 떨어진 마을이다. 프랑스에서 가장 아름다운 마을 중 하나로 꼽힌다. 이 마을은 언덕과 포도원으로 둘러싸여 있으며 인구는 약 6,000명입니다. 1006년에 처음 언급되었으며 풍부한 내용을 담고 있습니다. | 이 공동체는 마르세유 동쪽에 위치한 Massif du Gélas라는 바위 고원에 위치하고 있습니다. 마르세유와 해안선의 아름다운 전망을 감상하실 수 있습니다. Allauch는 이제 자체 시청과 다양한 상점, 바, 레스토랑을 갖춘 잘 발달된 공동체입니다. 마르세유와 알필 사이에 위치하기 때문에 "W"라고도 알려진 글랑드 대산괴를 포함하여 이 지역의 많은 자연적 특징을 유지하고 있습니다. |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:n알을 낳는 포유류란 무엇입니까?nn### 입력:n때로 오리너구리라고도 불리는 오리너구리(Ornithorhynchus anatinus)는 반수생 알입니다. -태즈메이니아를 포함한 호주 동부 고유의 산란 포유류. 오리너구리는 오리너구리과(Ornithorhynchidae)와 속(Ornithorhynchus)의 유일한 살아있는 대표자 또는 단일형 분류군이지만, 화석 기록에는 다수의 관련 종이 나타납니다.nnnn### 응답:n | 오리너구리는 호주 동부에서 발견되는 알을 낳는 포유동물입니다. Ornithorhynchus 속의 유일한 살아있는 대표자입니다. | n 귀하의 질문에 대해 꽤 많은 조사를 했습니다. 두 번째 문단에 제공하신 정보를 모두 읽었습니다. 또한 [이 페이지](https://phys.org/news/2019-04-australia-platypus-predator-species.html)를 포함하여 오리너구리에 관한 약간의 내용도 읽었습니다. 귀하의 질문에 대한 답변을 찾은 것 같습니다. 오리너구리가 알을 낳는 포유류인지 아니면 | 오리너구리처럼 알을 낳는 포유류 |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:nFelix Luna는 언제 죽었습니까?nn### 입력:nFélix César Luna(30년 1925월 5일 – 2009년 XNUMX월 XNUMX일)는 아르헨티나 작가, 작사가 및 역사가였습니다.nnnn# ## 응답:n | 펠릭스 루나는 5년 2009월 XNUMX일 사망했습니다. | Félix César Luna(30년 1925월 5일 – 2009년 1102월 XNUMX일)는 아르헨티나 사람이었습니다nn Luna는 언제 죽었나요?nnn### 설명:n 입력된 생년월일과 사망 날짜로 질문에 답합니다.nnn### 해결 방법: XNUMXn | Félix Luna는 5년 2009월 XNUMX일에 사망했습니다.nn |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:n주어진 구절에서 착시에 관한 몇 가지 중요한 사항을 적어 두세요.nn### 입력:n시각적 인식에서 착시(시각 착시라고도 함)는 다음과 같습니다. 시각 시스템에 의해 발생하는 환상으로, 현실과 다르게 보이는 시각적 인식을 특징으로 합니다. 환상은 매우 다양합니다. 근본적인 원인이 명확하지 않은 경우가 많기 때문에 분류가 어렵지만 Richard Gregory가 제안한 분류는 방향으로 유용합니다. 이에 따르면 신체적, 생리적, 인지적 환상의 세 가지 주요 유형이 있으며, 각 유형에는 모호함, 왜곡, 역설, 허구의 네 가지 유형이 있습니다. 물리적 왜곡에 대한 고전적인 예는 물에 반쯤 담근 막대기의 명백한 구부러짐입니다. 생리학적 역설의 한 예는 운동 후유증(움직임에도 불구하고 위치는 변하지 않음)입니다. 무생리학적 소설의 한 예는 잔상이다. 세 가지 전형적인 인지 왜곡은 폰조(Ponzo), 포겐도르프(Poggendorff), 뮐러-라이어(Müller-Lyer) 환상입니다. 물리적 환상은 물리적 환경(예: 물의 광학적 특성)으로 인해 발생합니다. 생리적 환상은 눈이나 시각 경로에서 발생합니다(예: 특정 수용체 유형에 대한 과도한 자극의 영향). 인지적 시각적 환상은 무의식적인 추론의 결과이며 아마도 가장 널리 알려진 것일 것입니다.nnnn### 응답:n | 1. 시각적 환상은 시각 시스템에 의해 발생하며 현실과 다르게 보이는 시각적 인식이 특징입니다.n2. 리처드 그레고리(Richard Gregory)가 제안한 분류는 신체적, 생리적, 인지적 환상의 세 가지 주요 분류가 있고 각 분류에는 모호함, 왜곡, 역설, 허구의 네 가지 유형이 있다는 방향으로 유용합니다. 물리적 왜곡의 예는 물에 반쯤 잠긴 막대기의 명백한 구부러짐입니다. 생리학적 역설의 한 예는 운동 후유증(움직임에도 불구하고 위치는 변하지 않음)입니다. n3. 생리학적 허구의 예는 잔상입니다4. 세 가지 인지 왜곡은 Ponzo, Poggendorff, Müller-Lyer 환상입니다.n5. 물리적 환상은 물리적 환경(예: 물의 광학적 특성)으로 인해 발생합니다. 생리적 환상은 눈이나 시각 경로에서 발생합니다.n6. 가장 널리 알려진 환상은 무의식적인 추론의 결과인 시각적 환상입니다. | 지문에 언급된 착시현상은 부분적으로 물에 잠긴 막대의 환상적 움직임입니다.nn## 50.n### 지침:n주장을 뒷받침하거나 반박하는 주장을 작성하세요.n저희 연구실의 모든 학생들은 동일한 평균 IQ.nn### 입력:n실험에 참여한 많은 학생들의 평균 IQ가 동일하며, 가장 높은 상위 10%라고 생각합니다. | n착시 환상은 우리 주변 세계의 자극과 내부적으로 생성된 시각적 자극 모두를 해석하고 이에 반응하는 방식과 관련된 생리적, 심리적 한계를 활용합니다. 이는 두 시스템(신체적, 심리적/지각적)에 공통 자극을 제공하여 두 시스템을 비교하고 각각의 작동 방식을 이해할 수 있게 해줍니다. 착시에는 심리적, 착시 등 다양한 형태가 있습니다. |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지침:n혁신가의 딜레마를 몇 문장으로 요약합니다nn### 입력:n대규모 기존 기업이 고객의 의견을 듣고 가장 높은 것으로 보이는 제품을 제공함으로써 시장 점유율을 잃는 방법을 설명합니다. - 가치가 높은 제품이지만, 제대로 개발되지 않은 기술로 가치가 낮은 고객에게 서비스를 제공하는 새로운 회사는 해당 기술이 충분히 좋아질 때까지 점진적으로 개선할 수 있습니다nnnn### 응답:n | 혁신가의 딜레마: 신기술로 인해 위대한 기업이 실패할 때(The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail)는 1997년에 처음 출판된 책으로, 하버드 교수이자 사업가인 Clayton Christensen의 가장 유명한 작품입니다. 이는 그가 1995년 기사 "파괴적 기술: 물결을 잡기(Disruptive Technologies: Catching the Wave)"에서 만든 용어인 파괴적 기술의 개념을 확장합니다. 이는 기존 대기업이 고객의 의견에 귀를 기울이고 가장 가치가 높은 제품을 제공함으로써 시장 점유율을 잃는 방법을 설명하지만, 제대로 개발되지 않은 기술로 가치가 낮은 고객에게 서비스를 제공하는 새로운 회사는 해당 기술이 충분히 좋아질 때까지 점진적으로 향상시킬 수 있습니다. 기존 사업에서 빠르게 시장 점유율을 빼앗아갑니다. Christensen은 대기업이 스타트업 경쟁업체의 기만과 추월을 피하기 위해 이러한 현상을 내부적으로 복제하려고 시도하는 작고 민첩한 부서를 유지할 것을 권장합니다. | 안녕하세요.n 답변이 늦어서 죄송합니다!! 저는 지난주에 휴가를 다녀왔습니다. :)nnClayton Christensen이 쓴 혁신가의 딜레마는 다음과 같이 설명합니다. “혁신가의 딜레마는 기업이 기존 고객에게 더 많은 가치를 제공하기 위해 제품을 출시하거나 개선하여 지속적인 이익을 추구하면 동일한 고객이 제품을 포기하게 된다는 것입니다. 적어도 어느 정도 가치를 제공하는 혁신을 구매하는 회사 | 혁신가의 딜레마(Innovator's Dilemma)는 기존 대기업이 고객의 의견에 귀를 기울이고 가장 가치가 높은 것처럼 보이는 제품을 제공함으로써 시장 점유율을 잃는 방법을 설명하는 책입니다. 충분히 좋아질 때까지 nn |

- Dolly 데이터 세트에서 Llama 2 13B 텍스트 생성 모델을 미세 조정한 결과:

| 입력 | 지상 진실 | 미세 조정되지 않은 모델의 응답 | 미세 조정된 모델의 응답 |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:nFc 바이에른 뮌헨에서 율리안 나겔스만 감독을 대신할 다음 코치는 누구입니까?nn### 입력:n나겔스만 시대(2021-2023)n새로운 율리안 나겔스만 감독 아래, 바이에른은 Der Klassiker를 10-3로 꺾고 분데스리가 1연패라는 위업을 달성했습니다. 그러나 팀은 챔피언스리그 24강전에서 예상치 못하게 비야레알에게 패해 2023년 연속 그 무대에 오르게 됐다. 30년 2025월 XNUMX일 나겔스만은 바이에른에서 방출되었고 토마스 투헬로 대체되었으며 투헬은 XNUMX년 XNUMX월 XNUMX일까지 계약을 맺었습니다.nnnn### 응답:n | 토마스 투헬(Thomas Tuchel)은 2023년 XNUMX월 율리안 나겔스만(Julian Nagelsmann)을 대신하여 현재 FC 바이에른 뮌헨의 새 코치이며 이전에는 첼시의 코치였습니다. | nn“`pythonn{n “instruction”: “Julian Nagelsmann의 뒤를 이을 Fc Bayern München의 다음 코치는 누구입니까?”, n “action”: “FC Bayern의 다음 코치”, n “context”:{n “ 나겔스만 시대(2021~2023)”: n” 새 감독 율리안 나겔스만 지휘 하에 바이에른은 분데스리가 10연패라는 위업을 완수했다. | Fc 바이에른 뮌헨의 다음 감독은 토마스 투헬(Thomas Tuchel)이 될 것이다. Tuchel은 24년 2023월 XNUMX일 Nagelsmann이 팀을 떠나면서 Julian Nagelsmann의 뒤를 잇게 됩니다.nn |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:nAdolphe Cohnnn의 삶에 대해 말해 주세요### 입력:nAdolphe Cohn(29년 1851월 1930일~1868년)은 파리에서 태어난 프랑스계 미국인 교육자였습니다. 그는 1873년 파리 대학에서 "문학 학사"를 졸업하고 파리의 여러 고등 교육 기관에서 법학, 역사 비평, 문헌학을 공부하고 LL.B 학위를 받았습니다. 1874년. École des Chartes의 학생이었던 그의 논문은 Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires라고 불렸으며 그는 "archiviste paléographe" 학위를 받았습니다. 1870년 프랑스-프로이센 전쟁이 시작되자 그는 프랑스군에 입대하여 투쟁 내내 복무했습니다. République française는 당시 프랑스에서 알고 지내던 Léon Gambetta가 편집했으며 그의 정치적 견해를 받아들였습니다. 13년 1875월 콘은 컬럼비아 대학의 프랑스어 교사로 임명되었고 곧 강사가 되었습니다. 뉴욕에 거주하는 프랑스 주민들의 대중투표에 의해 그는 1876년 Tammany Hall에서 Gambetta에 대한 장례식 연설을 하도록 선택되었으며, 1884년에는 Victor Hugo가 사망하자 유사한 목적으로 매사추세츠 주 케임브리지에서 부름을 받았습니다.nnnn ### 응답:n | 아돌프 콘(Adolphe Cohn, 29년 1851월 1930일 – 1868년)은 파리에서 태어난 프랑스계 미국인 교육자였습니다. 그는 1873년 파리 대학에서 "문학 학사"를 졸업하고 파리의 여러 고등 교육 기관에서 법학, 역사 비평, 문헌학을 공부하고 LL.B 학위를 받았습니다. 1874년에 École des Chartes의 학생이었던 그의 논문은 Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires라고 불렸으며 그는 "archiviste paléographe" 학위를 받았습니다. 1870년 프랑스-프로이센 전쟁이 시작되자 그는 프랑스군에 입대하여 투쟁 내내 복무했습니다. République française는 당시 프랑스에서 알고 지내던 Léon Gambetta가 편집했으며 그의 정치적 견해를 받아들였습니다. 13년 1875월 콘은 컬럼비아 대학의 프랑스어 교사로 임명되었고 곧 강사가 되었습니다. 뉴욕에 거주하는 프랑스인의 대중투표에 의해 그는 1876년 Tammany Hall에서 Gambetta에 대한 장례식 연설을 하도록 선택되었으며, 1884년에는 Victor Hugo가 사망하자 비슷한 목적으로 매사추세츠 주 케임브리지에서 부름을 받았습니다. | 아돌프 콘(29년 1851월 1930일 ~ 1868년)은 파리에서 태어난 프랑스계 미국인 교육자였습니다. 그는 1873년 파리 대학에서 "문학 학사"를 졸업하고 파리의 여러 고등 교육 기관에서 법학, 역사 비평, 문헌학을 공부하고 LL.B 학위를 받았습니다. XNUMX년. É의 학생 | 아돌프 콘(Adolphe Cohn)은 29년 1851월 1873일 파리에서 태어난 프랑스계 미국인 교육자입니다. 그는 파리 대학교에 다녔고 1874년에 법학 학위를 받았습니다. 그는 또한 École des Chartes에서 일했으며 XNUMX. 프랑스-프로이센 전쟁이 시작되자 그는 프랑스군에 입대하여 전 기간 동안 복무했습니다. |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지침:n맥도날드의 타겟 고객은 시간이 지남에 따라 어떻게 변했습니까?nn### 입력:n패스트 푸드 레스토랑은 종종 광고의 일부를 청소년층을 직접 겨냥합니다. 새로 개봉된 가족 영화에 종종 장난감이 포함되어 있는 맥도날드의 해피밀(McDonald's Happy Meals)이 중요한 예입니다. 1963년에 소개되어 어린 아이들의 관심을 끌기 위해 디자인된 광대 광고 마스코트인 Ronald McDonald도 또 다른 예입니다. 또한, 1987년에 McDonald's는 어린이들에게 더 많은 광고를 하기 위해 레스토랑에 Play Place를 통합하여 레스토랑을 어린이들에게 더욱 매력적인 환경으로 만들었습니다. 또한 1996년부터 2006년까지 Disney는 McDonald's의 제품을 서로 연결하는 독점 파트너였습니다. 그들은 2006년 1985월에 이 거래의 종료를 발표했으며, 일부 보도에 따르면 디즈니는 아동 비만을 걱정하고 있었습니다. Disney 외에도 McDonald's도 Nintendo Entertainment System이 처음 출시된 1987년부터 Nintendo와 파트너십을 맺었습니다. 2007년에 McDonald's는 또한 아이들이 음식을 기다리는 동안 Nintendo 콘솔에서 놀 수 있는 Nintendo 플레이 랜드를 레스토랑에 만들었습니다. XNUMX년에 McDonald's는 Nintendo 콘솔에서 Wi-Fi를 제공하기 시작했습니다. 아이들이 어디에 있든 놀 수 있는 능력을 제공합니다. 또한 이러한 새 영화를 개봉하고 장난감을 결합한 어린이를 대상으로 하는 이 프로그램은 막대한 투자로 인해 어린이가 부모의 주머니에 손을 뻗는 데 사용합니다.nnnn### 응답:n | McDonald's는 지속적으로 청소년 인구를 대상으로 광고를 직접 목표로 삼았습니다.nn1963년부터 그들은 어린 아이들의 관심을 끌기 위해 고안된 광대 광고 마스코트인 Ronald McDonald를 선보였습니다. 수년에 걸쳐 McDonald's는 Nintendo 및 Disney와 같이 어린이를 대상으로 하는 제품을 보유한 여러 회사와 파트너십을 맺었습니다. | 패스트푸드점은 항상 젊은층을 타겟으로 삼아왔습니다. 해피밀은 청소년 광고에 있어서도 큰 요소입니다.n 많은 영화가 개봉됨에 따라 해피밀에는 지역 맥도날드에서 해당 영화를 홍보할 수 있는 장난감도 함께 제공됩니다.—n## 400-999nn### 댓글:nAs 세계에 대한 상대적으로 좁은 비전을 가진 젊은 회사인 맥도날드는 | 출시 이후 McDonald's는 어린이 중심의 패스트푸드점과 식품은 물론 주로 청소년을 대상으로 한 광고를 통해 어린이와 청소년을 타겟으로 삼았습니다. 아이들이 부모에 의해 맥도날드로 데려가는 동안, 그 레스토랑은 본질적으로 아이들을 위한 부모의 광고입니다. 맥도날드는 밝은 색상의 레스토랑과 음식에 들어 있는 장난감으로 아이들의 관심을 끌고 있습니다. |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:n아난다푸람 만달이란 무엇입니까nn### 입력:n아난다푸람 만달은 인도 안드라프라데시 주의 비사카파트남 지역에 있는 46개 만달 중 하나입니다. Visakhapatnam 수익 부서의 관리하에 있으며 본사는 Anandapuram에 있습니다. 아난다푸람 만달은 동쪽으로 Bheemunipatnam 만달, 남쪽으로 Chinagadila, 북쪽으로 Padmanabham, 서쪽으로 Kothavalasa와 경계를 이루고 있습니다.nnnn### 응답:n | 아난다푸람 만달(Anandapuram mandal)은 인도 안드라프라데시주 비사카파트남 지역에 있는 46개 만달 중 하나입니다. Visakhapatnam 수익 부서의 관리하에 있으며 본사는 Anandapuram에 있습니다. | NNNN | 아난다푸람 만달(Anandapuram mandal)은 인도 안드라프라데시주 비사카파트남 지역에 있는 46개 만달 중 하나입니다. Visakhapatnam 수익 부서의 관리하에 있으며 본사는 Anandapuram에 있습니다. Anandapuram 만달은 동쪽의 Bheemunipatnam mandal, 남쪽의 Chinagadila, 북쪽의 Padmanabham 및 Koth와 경계를 이루고 있습니다. |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:nWoodstocknn에서 일어난 일### 입력:n일반적으로 Woodstock이라고 불리는 Woodstock Music and Art Fair는 15년 18월 1969~40일에 개최된 음악 축제입니다. 미국 뉴욕주 베델에 있는 Max Yasgur의 낙농장은 우드스톡에서 남서쪽으로 65km 떨어져 있습니다. "물병자리 박람회: 3일간의 평화와 음악" 또는 우드스톡 록 페스티벌이라고도 불리는 이 행사에는 400,000명 이상의 관객이 모였습니다. 간헐적으로 내리는 비에도 불구하고 1970개의 공연이 야외에서 공연되었습니다. 이는 역사상 가장 큰 음악 페스티벌 중 하나였습니다.nn이 페스티벌은 대중 음악 역사상 중추적인 순간이자 반문화 세대를 위한 결정적인 행사로 널리 인식되었습니다. 이 행사의 중요성은 2004년 다큐멘터리 영화, 사운드트랙 앨범, 그리고 Crosby, Stills, Nash & Young 및 Matthews Southern Comfort의 대히트가 된 Joni Mitchell이 작곡한 노래로 더욱 강화되었습니다. 19주년, 50주년, 2017주년, XNUMX주년, XNUMX주년, XNUMX주년을 포함한 기념일에 우드스톡이라는 이름을 붙인 음악 행사가 계획되었습니다. XNUMX년 롤링 스톤(Rolling Stone) 매거진은 이 곡을 로큰롤의 역사를 바꾼 XNUMX가지 순간 중 XNUMX위로 선정했습니다. XNUMX년에 축제 장소는 국가 사적지에 등재되었습니다.nnnn### 응답:n | 일반적으로 우드스톡(Woodstock)이라고 불리는 우드스톡 음악 및 미술 박람회(Woodstock Music and Art Fair)는 15년 18월 1969일부터 40일까지 미국 뉴욕주 베델에 있는 Max Yasgur의 낙농장에서 남서쪽으로 65km 떨어진 곳에서 열린 음악 축제였습니다. 우드스톡의. "물병자리 박람회: 3일간의 평화와 음악" 또는 우드스톡 록 페스티벌이라고도 불리는 이 행사에는 400,000명 이상의 관객이 모였습니다. 간헐적으로 내리는 비에도 불구하고 1970개의 공연이 야외에서 공연되었습니다. 이는 역사상 가장 큰 음악 페스티벌 중 하나였습니다.nn이 페스티벌은 대중 음악 역사상 중추적인 순간이자 반문화 세대를 위한 결정적인 행사로 널리 인식되었습니다. 이 행사의 중요성은 2004년 다큐멘터리 영화, 사운드트랙 앨범, 그리고 Crosby, Stills, Nash & Young 및 Matthews Southern Comfort의 대히트가 된 Joni Mitchell이 작곡한 노래로 더욱 강화되었습니다. 19주년, 50주년, 2017주년, XNUMX주년, XNUMX주년, XNUMX주년을 포함한 기념일에 우드스톡이라는 이름을 붙인 음악 행사가 계획되었습니다. XNUMX년 롤링 스톤(Rolling Stone) 매거진은 이 곡을 로큰롤의 역사를 바꾼 XNUMX가지 순간 중 XNUMX위로 선정했습니다. XNUMX년에는 축제 장소가 국가 사적지로 등재되었습니다. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## 해결책:nn N 솔루션을 보려면 nn“`jsnn// 솔루션 필요 | 15월 18~400,000일 후반에 개최된 우드스톡 뮤직 앤 아트 페어(Woodstock Music and Art Fair)는 뉴욕주 베델에서 열린 반문화 세대의 역사적인 행사였습니다. 축제에 참석한 군중은 32명이 넘었습니다. 간헐적으로 내리는 비에도 불구하고 약 XNUMX개 공연이 야외에서 공연됐다. 역사상 가장 큰 음악 축제 중 하나로 여겨졌습니다.nn |

- Dolly 데이터 세트에서 Llama 2 70B 텍스트 생성 모델을 미세 조정한 결과:

| 입력 | 지상 진실 | 미세 조정되지 않은 모델의 응답 | 미세 조정된 모델의 응답 |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:n회사는 누구입니까? ABBnn### 입력:nABB Ltd.는 스위스 취리히에 본사를 둔 스웨덴-스위스 다국적 기업입니다. 이 회사는 1988년 스웨덴의 Allmänna Svenska Elektriska Aktiebolaget(ASEA)와 스위스의 Brown, Boveri & Cie가 합병하여 ASEA Brown Boveri를 설립하면서 설립되었으며 나중에 이니셜 ABB로 단순화되었습니다. 두 회사 모두 1800년대 후반에 설립되었으며 ABB가 오늘날까지 활발히 활동하고 있는 주요 전기 장비 제조업체였습니다. 이후 회사는 로봇 공학 및 자동화 기술로 사업을 확장했습니다.nnnn### 응답:n | ABB Ltd.는 스위스 취리히에 본사를 둔 스웨덴-스위스 다국적 기업입니다. 이 회사는 1988년 스웨덴의 Allmanna Svenska Elektriska Aktiebolaget(ASEA)와 스위스의 Brown, Boveri & Cie가 합병하여 ASEA Brown Boveri를 설립하면서 설립되었으며 나중에 이니셜 ABB로 단순화되었습니다. 두 회사 모두 1800년대 후반에 설립되었으며 주요 전기 장비 제조업체였으며 ABB는 오늘날에도 이 사업을 계속하고 있습니다. 이후 회사는 로봇 공학 및 자동화 기술 분야로도 사업을 확장했습니다. | * ABB는 스웨덴-스위스 다국적 기업입니다nn### LognEND I/O DATA —n | ABB는 스위스 취리히에 본사를 둔 스웨덴-스위스 다국적 기업입니다. 이 회사는 1988년 스웨덴의 Allmänna Svenska Elektriska Aktiebolaget(ASEA)와 스위스의 Brown, Boveri & Cie가 합병하여 ASEA Brown Boveri를 설립하면서 설립되었으며 나중에 이니셜 ABB로 단순화되었습니다. 두 회사 모두 1800년대 후반에 설립되었으며 |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:n프랑스인 정복자 윌리엄이 영국의 왕이 된 이유는 무엇입니까?nn### 입력:n1050년대와 1060년대 초에 윌리엄은 잉글랜드의 왕이 되었습니다. 영국의 왕좌는 한때 그의 사촌이었던 아이가 없는 참회왕 에드워드(Edward the Confessor)가 차지했습니다. 강력한 영국 백작 해롤드 고드윈슨(Harold Godwinson)을 포함한 다른 잠재적 주장자들도 있었는데, 에드워드는 1066년 1066월 임종 당시 그를 왕으로 임명했습니다. 에드워드는 이전에 그에게 왕좌를 약속했고 해롤드는 그의 주장을 지지하겠다고 맹세했다고 주장하면서 윌리엄은 큰 규모의 건물을 세웠습니다. 그는 14년 1066월 영국을 침공했습니다. 그는 1066년 1067월 1075일 헤이스팅스 전투에서 해럴드를 결정적으로 패배시키고 죽였습니다. 추가적인 군사적 노력 끝에 윌리엄은 XNUMX년 크리스마스에 런던에서 왕위에 올랐습니다. 그는 노르망디로 돌아오기 전 XNUMX년 초에 영국의 통치를 위한 준비를 했습니다. 여러 차례 반란이 실패했지만 윌리엄의 지배권은 XNUMX년까지 영국에서 대부분 확보되어 통치 기간의 대부분을 유럽 대륙에서 보낼 수 있었습니다.nnnn### 응답:n | 정복자 윌리엄은 프랑스 북서부에 위치한 노르망디 출신이었습니다. 1050년대 후반과 1060년대 초반 영국의 왕은 참회왕 에드워드(Edward the Confessor)였습니다. 에드워드는 윌리엄의 사촌이었습니다. 에드워드에게는 자녀가 없었기 때문에 자신이 정당한 상속자이며 왕이 되어야 한다고 주장하는 사람이 많았습니다. 이러한 상충되는 주장은 무력 충돌을 일으켰습니다. 윌리엄은 영국을 침공하여 헤이스팅스 전투에서 해럴드 고드윈슨 백작을 물리치고 승리했습니다. 여러 번의 전투가 이어졌지만 윌리엄은 1066년 후반에 영국의 왕이 되었습니다. 그는 다음 XNUMX년 동안 여러 차례의 반란을 겪었지만 권력을 유지했습니다. 결국 그는 노르망디로 돌아가 그곳에서 영국을 통치할 수 있었습니다. | 정복자 윌리엄은 1050년대와 1060년대 초반에 영국의 왕이 되었습니다. 그는 자녀가 없는 참회왕 에드워드(그의 첫 번째 사촌이 한때 제거됨)가 보유한 영국 왕좌의 경쟁자가 되었습니다.nnn응답은 비어 있을 수 있지만 길이가 256자 이내여야 합니다. N | 14년 1066월 1066일 헤이스팅스 전투에서 해롤드 왕이 사망한 후, XNUMX년 크리스마스에 정복자 윌리엄이 영국 왕으로 즉위하여 노르만인의 잉글랜드 정복이 시작되었습니다. |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:nRMS Adriatic에 대해 알려주세요nn### 입력:nRMS Adriatic은 White Star Line의 영국 해양 정기선이었습니다. 그녀는 The Big Four라고 불리는 20,000 GRT 이상의 1911중주 선박 중 1917번째 선박이었습니다. 그 배는 네 척의 배 중 유일하게 세계에서 가장 큰 배는 아니었습니다. 그러나 그녀는 실내 수영장과 터키식 목욕탕을 갖춘 최초의 해양 여객선으로서 빅 1930 중 가장 크고 가장 빠르며 가장 호화로운 여객선이었습니다.nn그녀는 이전에 사우샘프턴에서 뉴욕까지의 새로운 항로에서 경력을 시작했습니다. 1934년부터 그녀의 자매선이 리버풀에서 출발하는 보조 항로에 합류했습니다. 사실 그들은 적당한 가격으로 서비스를 제공하기 위한 저속 여객선이었습니다. 제1935차 세계 대전이 발발했을 때 아드리아해(Adriatic)호는 많은 식량을 싣고 민간 대서양 횡단 임무를 계속한 선박 중 하나였습니다. XNUMX년에 징발되어 병력 수송선으로 복무했습니다.nn전쟁 후 여러 차례 개조되었으며 점차 크루즈용으로 사용되었으며, 이는 XNUMX년대에 주요 서비스가 되었습니다. XNUMX년 Cunard Line과 White Star Line이 합병되었을 때, 그녀는 빠르게 불필요하다고 간주되어 연말에 매각되었습니다. 그녀는 XNUMX년 오사카에서 폐기되었습니다.nnnn### 응답:n | RMS Adriatic은 White Star Line의 영국 해양 정기선이었습니다. 그녀는 The Big Four라고 불리는 20,000 GRT 이상의 XNUMX중주 선박 중 XNUMX번째 선박이었습니다. 그 배는 네 척의 배 중 유일하게 세계에서 가장 큰 배는 아니었습니다. 그러나 이 선박은 Big Four 중 가장 크고 가장 빠르며 가장 고급스러운 선박으로 실내 수영장과 터키식 목욕탕을 갖춘 최초의 해양 정기선이었습니다. | RMS Adriatic은 White Star Line의 영국 해양 정기선이었습니다. 그녀는 The Big Four라고 불리는 20,000 GRT 이상의 XNUMX중주 선박 중 XNUMX번째 선박이었습니다. 그 배는 네 척의 배 중 유일하게 세계에서 가장 큰 배는 아니었습니다. nn### Contextn이 유형의 질문은 일반적으로 검색 엔진에 쿼리하는 데 사용됩니다. 입력은 쿼리의 입력이고 응답은 공개됩니다. | RMS 아드리아틱(RMS Adriatic)은 화이트 스타 라인(White Star Line)의 영국 해양 정기선이었습니다. 이 배는 1906년에 진수되었지만 첫 상업 항해는 1907년에 이루어졌습니다. 이 배는 20,000톤이 넘는 1901중 선박 중 네 번째였으며 Big Four라고 불렸습니다. 나머지 세 대는 1903년의 RMS Celtic, XNUMX년의 RMS Baltic, 그리고 R이었습니다. |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:n광자를 감지하는 CGRO는 무엇입니까?nn### 입력:nCompton Gamma Ray Observatory(CGRO)는 20keV에서 30keV 사이의 에너지를 갖는 광자를 감지하는 우주 관측소입니다. 1991년부터 2000년까지 지구 궤도에 있는 GeV. 이 천문대는 다양한 전문 하위 장비 및 탐지기를 포함하여 엑스선과 감마선을 감시하는 하나의 우주선에 14개의 주요 망원경을 갖추고 있습니다. 37년간의 노력 끝에 이 관측소는 5년 1991월 4일 STS-2000 동안 우주왕복선 아틀란티스에서 발사되어 450년 280월 17,000일 궤도에 진입할 때까지 운영되었습니다. Van Allen 방사선 벨트를 피하십시오. 그것은 37,000kg(XNUMXlb)으로 당시 비행한 천체물리학적 탑재체 중 가장 무거웠습니다.nnnn### 응답:n | CGRO는 CGRO(Compton Gamma Ray Observatory)로, 20년부터 30년까지 지구에서 1991keV~2000GeV의 에너지를 갖는 광자를 탐지하는 우주 관측소였습니다. | **기록자:** EGRET 장비가 광자를 감지합니다.nn | CGRO(Compton Gamma Ray Observatory)는 20keV~30GeV의 에너지로 광자를 측정합니다.nn |

| 다음은 추가 컨텍스트를 제공하는 입력과 쌍을 이루는 작업을 설명하는 지침입니다. 요청을 적절하게 완료하는 응답을 작성하세요.nn### 지시:n손열음은 얼마나 훌륭한 피아니스트인가요nn### 입력:n손열음(2년 1986월 2004일, 대한민국 원주에서 태어남)은 한국의 클래식 음악가입니다. 피아니스트. 그녀는 18년 1월 2008세의 나이로 서울, 대전, 도쿄 아시아 투어에서 로린 마젤(Lorin Maazel) 지휘 하에 뉴욕 필하모닉과 리스트 피아노 협주곡 2번을 연주하면서 솔리스트로 등장하면서 처음으로 국제적인 주목을 받았다. 손연재는 2009년 2011월 예술의 전당으로 돌아와 마젤과 뉴욕 필하모닉과 다시 협연했으며, 이번에는 베토벤 피아노 협주곡 2005번의 솔리스트로 활동했다. ) 및 XNUMX년 차이콥스키 국제 콩쿠르에서 최우수 실내악 협주곡 연주상과 최우수 의뢰 작품상을 수상했습니다. 그녀는 또한 Arthur Rubinstein 국제 피아노 마스터 콩쿠르(XNUMX)에서 동메달을 수상했습니다. nnnn### 응답:n | 손열음(2년 1986월 2004일, 대한민국 원주 출생)은 대한민국의 클래식 피아니스트이다. 그녀는 18년 1월 2008세의 나이로 서울, 대전, 도쿄 아시아 투어에서 로린 마젤(Lorin Maazel) 지휘 하에 뉴욕 필하모닉과 리스트 피아노 협주곡 2번을 연주하면서 솔리스트로 등장하면서 처음으로 국제적인 주목을 받았다. 손연재는 2009년 2011월 예술의 전당으로 돌아와 마젤과 뉴욕 필하모닉과 다시 협연했으며, 이번에는 베토벤 피아노 협주곡 2005번의 솔리스트로 활동했다. ) 및 XNUMX년 차이콥스키 국제 콩쿠르에서 최우수 실내악 협주곡 연주상과 최우수 의뢰 작품상을 수상했습니다. 그녀는 또한 Arthur Rubinstein 국제 피아노 마스터 콩쿠르(XNUMX)에서 동메달을 수상했습니다. | 손열음은 세계 최고의 오케스트라와 협연한 뛰어난 피아니스트이다. 2009년 제2005회 Van Cliburn 국제 피아노 콩쿠르에서 은상을 수상했고, XNUMX년에는 Arthur Rubinstein 국제 피아노 마스터 콩쿠르에서 동메달을 획득했습니다. 그녀는 전 세계적으로 계속해서 큰 성공을 거두고 있습니다. | 손열음님은 정말 훌륭한 피아니스트이십니다. 그녀는 18세에 세계 최고의 음악가들과 합류하면서 국제적인 경력을 시작했습니다. 그리고 25세가 되었을 때 이미 두 개의 국제 콩쿠르에서 은메달리스트였습니다. |

- Dialogsum 데이터 세트에서 Llama 2 7B 텍스트 생성 모델을 미세 조정한 결과:

| 입력 | 지상 진실 | 미세 조정되지 않은 모델의 응답 | 미세 조정된 모델의 응답 |

| 이 대화를 요약하세요:n#Person1#: 정말 맛있는 식사네요!n#Person2#: 감사합니다. 모든 일이 잘 돼서 기쁘다.n#Person1#: 누가 이렇게 잘 요리하는 법을 가르쳐줬어?n#Person2#: 요리학원에서 요리 수업을 들었어.n#Person1#: 와, 이게 뭐야? 닭고기 요리?n#Person2#: 정말 좋지 않나요? 그게 코코넛 생강 치킨 밥이에요.n#Person1#: 국물이 새우국인가요?n#Person2#: 네, 새우도 있고 바다 야채와 레몬그라스도 들어있어요.n#Person1#: 운이 좋은 것 같아요 n#Person2#: 와인을 가져와주셔서 감사합니다. 치킨이랑 잘 어울려요.n—n요약:nnn### 답변:n | #Person1#은 #Person2#이 준비한 식사가 훌륭하다고 생각합니다. #Person2#가 요리 재료를 소개합니다. | 대화가 완료된 후, 그 사람은 수집된 정보에 대해 적절한 응답을 제공할 것입니다. 예를 들어, 사람 1은 nn#Person1#: 이거 정말 훌륭하다고 말할 수 있습니다. 감사합니다.nn#Person2#: 천만에요. 나는 당신이 식사를 좋아할 것이라고 생각했습니다. 즐거우셨다니 기쁘네요.nn—n— — — — –nnn### 요약:nnn### 응답:n대화 후 | #Person1#과 #Person2#는 #Person2#의 집에서 식사를 합니다. 치킨과 어울리는 음식과 와인에 대해 이야기해요.nn |

| 이 대화를 요약하세요:n#Person1#: 죄송합니다. 저는 고대 그리스에 대한 에세이를 쓰고 있습니다. 이 주제에 관해 추천할 만한 책이 있나요?n#Person2#: Geese? 고대 거위에 대해 쓰고 싶나요? 나는 그런 말을 들어본 적이 없습니다. 어쨌든 J행에 있는 몇몇 동물에 관한 책이 될 것입니다. 아니면 Gn#Person1#: 동물에 있는 과학을 시험해 보고 싶으십니까? 하지만 그리스는 동물이 아닌 나라다.n#Person2#: 아, 그리스. 글쎄요, 오늘은 당신에게 행운의 날이겠네요. 우리는 바로 그 주제에 관한 새로운 책 모음을 방금 받았습니다. 여기 Cn#Person1# 열에 작가들이 있습니다: 그렇군요. 책이 너무 많은데 어떤 것을 제안하시겠습니까?n#Person2#: 글쎄요, Robin Smith의 책은 훌륭하지만 너무 깁니다. 표지에 조각상이 있는 것이에요. Milton Pike의 작품도 있습니다. 앞면에는 군인의 그림이 있습니다. 보시다시피 그다지 두껍지 않아서 읽는 데 시간이 많이 걸리지는 않을 것 같습니다. 하지만 아마도 가장 좋은 책은 고대 올림픽 경기장의 그림이 담긴 책일 것입니다. 여러 역사 작품 상을 받았습니다.n#Person1#: 글쎄요, 결정하기는 어렵지만, 많이 읽을 시간이 부족할 것 같습니다. 나는 Milton Pike의 책을 살 것 같아요.n#Person2#: 좋습니다. 도서관 카드를 주시겠습니까?n#Person1#: 물론입니다. 여기 있습니다.n—n요약:nnn### 응답:n | #Person1#은 #Person2#에게 고대 그리스에 관한 책을 추천해 달라고 요청합니다. #Person2#는 매우 긴 Robin Smith 작품, 그다지 두껍지 않은 Milton Pike 작품, 그리고 여러 역사 작품에서 우승한 작품을 추천합니다. #Person1#은 시간이 충분하지 않기 때문에 #Person1#은 Milton Pike의 책을 구하겠습니다. | n—nn요약:n | #Person1#님이 고대 그리스에 대한 에세이를 쓰고 있습니다. #Person2#는 새로 받은 #Person1#에게 고대 그리스에 관한 책을 추천하고 Milton Pike.nn의 책을 구하라고 제안합니다. |

| 이 대화를 요약하세요:n#Person1#: 글쎄요, 조지, 책을 갖고 계시군요. 그런데 읽고 있나요? 색칠만 하시는 것 같네요.n#Person2#: 책의 중요한 부분을 표시하고 있어요. 색상은 용도에 따라 다릅니다.n#Person1#: 어떤가요?n#Person2#: 주요 아이디어는 노란색입니다. 기억해야 할 중요한 세부 사항은 분홍색이고 연한 녹색은 어려운 아이디어를 위한 것입니다.n#Person1#: 활동이 많은 것 같습니다. 시간 낭비하고 있지 않나요?n#Person2#: 그런 것 같지 않아요, 엄마. 오늘 밤에 다 읽어보겠습니다. 내일 들을게요. 그러다가 공부할 시간이 되면 이미 대부분의 정보를 알고 있을 것입니다.n#Person1#: 저는 하루에 책만 읽고 정보를 기억하려고 노력했습니다.n#Person2#: 선생님이 우리에게 정보의 중요성을 말씀해 주셨습니다. 적극적인 독서. 그리고 그것은 당신이 선택하는 속도에 관계없이 학습할 수 있는 가장 좋은 방법입니다.n#Person1#: 그렇군요. 그러면 이 노트는 무엇을 위한 것인가요?n#Person2#: 메모를 하기 위한 것입니다. 어떤 내용을 적나요?n#Person1#: 가끔 요약해서 씁니다. 이 페이지에는 질문을 적습니다. 그리고 물론 새로운 단어를 적는 또 다른 페이지도 있습니다.n—n요약:nnn### 응답:n | 조지는 책의 중요한 부분을 다른 색깔로 표시하는 것이 자신의 학습 방식이라고 어머니에게 말합니다. 그는 또한 노트에 메모를 하고 때로는 요약을 쓰기도 합니다. | #Person1#: 오오오! 능동적 읽기, 읽기 질문, 어휘 메모, 요약 및 강조 표시. 이제 정보 학습과 관련하여 어떤 차이가 있는지 알 수 있습니다. 감동받았습니다.n#Person2#: 감사합니다. 독서는 새로운 정보를 배우고 기억하는 가장 좋은 방법입니다. 지금 액티브 리딩을 하고 계시나요?n#Person1#: 흠….. 그건 생각해봐야겠네요.nnn#Person | 조지는 책을 빨리 읽기 위해 자신이 하고 있는 활동에 대해 설명합니다. George는 엄마에게 공책을 보여주고 메모하는 방법을 설명합니다.nn |

| 이 대화를 요약하세요:n#Person1#: 안녕하세요. 여권을 보여주시겠어요?n#Person2#: 네, 물론이죠. 여기 있습니다.n#Person1#: 감사합니다. 이거 다 네 거야?n#Person2#: 아니요, 일부는 내 친구 거예요. 그 사람 여권도 드릴까요?n#Person1#: 네, 주세요. 기내 반입 물품이 있나요?n#Person2#: 벨트에도 올려드릴까요?n#Person1#: 예, 부탁드립니다. 이 큰 가방 좀 열어주시겠어요?n#Person2#: 좋아요. 잠시만. 그냥 옷이랑 세면도구 정도예요.n#Person1#: 좋아요. 신고할 게 있나요?n#Person2#: 아무것도 없는 것 같아요.n#Person1#: 신선한 음식, 살아있는 식물, 동물이 있나요?n#Person2#: 아, 아니요. 전혀 그렇지 않습니다.n#Person1#: 감사합니다. 여행가방을 잠글 수도 있습니다. 여기 여권이 있습니다.n#Person2#: 정말 감사합니다.n—n요약:nnn### 응답:n | #Person1#은 #Person2#과 #Person2#의 친구 여권을 보고 그들의 짐을 확인합니다. #Person2#은 #Person1#에게 선언할 것이 없다고 말합니다. #Person1#은 그들을 놓아줍니다. | > 없는 것 같아요.nnn—n**카테고리:**nn- [대화(32)](../conversation/32.md)n – [TSA(4)](../conversation/32/ 4.md)nn### 키:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* 모든 저작권 | 출입국 관리소 직원은 #Person2#에게 여권을 보여주고 큰 가방을 열어달라고 요청합니다. #Person2#은 신고할 것이 없으며 여행 가방을 잠글 수도 있습니다.nn |

| 이 대화를 요약해 보세요:n#Person1#: 중국 차는 전 세계적으로 유명합니다. 여러박스 사고 싶어요.n#Person2#: 중국에는 다양한 종류의 차가 있어요. 맛과 효과에 따라 다릅니다.n#Person1#: 글쎄, 저는 중국차를 전혀 모릅니다.n#Person2#: 녹차입니다. 여름에 마셔도 됩니다. 여름 더위를 해소하고 폐 건강에도 좋습니다.n#Person1#: 재미있을 것 같네요. 이건 어때요?n#Person2#: 홍차인데 맛이 진하고 소화를 촉진합니다.n#Person1#: 이게 뭐죠? 향긋한 향이 나요.n#Person2#: 고급 자스민차입니다. 향긋하고 맛이 좋아요.n#Person1#: 자스민차로 하겠습니다. 포장지와 리본으로 포장해 주실 수 있나요? 친구를 위한 선물입니다.n#Person2#: 문제없습니다. 잠시만 기다려주세요.n—n요약:nnn### 응답:n | #Person2#는 중국차를 사고 싶은 #Person1#에게 녹차, 검은색 티셔츠, 자스민 티를 추천하고 #Person1#은 자스민차를 선택합니다. | #[English]#: 중국 차는 전 세계적으로 유명합니다. 여러 상자를 사고 싶습니다.n#[프랑스어]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[스페인어]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[독일어]#: Ich mö | #Person1#은 다양한 종류의 차와 함께 중국차 여러 상자를 사고 싶어합니다. #Person2#는 #Person1#이 선택하는 데 도움을 주고 포장해 드립니다.nn |

- Dialogsum 데이터 세트에서 Llama-2 13B 모델을 미세 조정한 결과:

| 입력 | 지상 진실 | 미세 조정되지 않은 모델의 응답 | 미세 조정된 모델의 응답 |

| 이 대화를 요약하십시오:n#Person1#: 한때 이신론자였던 Mrs. Thompson, Jason.n#Person2#: 왜? 우리는 곤경에 처하면 안 되나요? 사실 우리는 오늘 아침 전체 수업 토론 동안 매우 활발했습니다.n#Person1#: 그게 전부입니다. 나는 그것이 전혀 나쁜 것이라고 생각하지 않습니다. 내 생각엔 그녀가 우리에게 수업 모니터에 출마하라고 요청할 것 같아요.n#Person2#: 우와! 정말? 막중한 책임이군요.n#Person1#: 글쎄, 당신은 그 일을 아주 잘할 것 같아요. 게다가 해달라고 부탁을 받아서 정말 영광이에요. 이는 톰슨 부인이 우리를 리더로 본다는 뜻입니다.n#Person2#: 하지만 제가 혼자서 할 수 있을지 잘 모르겠습니다. 같이 할 수 있을까요?n#Person1#: 톰슨 부인에게 물어봅시다. 지금 복도에서 그녀가 들어오는 소리가 들립니다.n—n요약:nnn### 응답:n | #Person1#은 한때 이신론자였던 Jason Mrs. Thompson에게 말하고 #Person1#은 그들이 클래스 모니터에 출마하기를 원한다고 추측합니다. 그들은 톰슨 부인에게 이 일을 함께 할 수 있는지 물어볼 것입니다. | n* 선생님이 Jason과 그의 반 친구에게 학급 모니터로 출마하고 싶은지 물었을 때 그와 그의 반 친구는 함께 동의했습니다. 두 소년 모두 기독교인이지만 수업 시간에 친구는 아닙니다.n* 예수님에 대한 그들의 믿음은 공개적으로 공유되지 않을 수 있지만, 다른 사람들을 돕고 사랑을 보여주기 위해 함께 따르는 기도와 모범을 통해 분명합니다.nn—n## 1654nn **[상황:** 학생들이 최근에 있었던 일에 대해 이야기하고 있습니다. | Thompson 선생님은 Jason과 James가 리더라고 생각하기 때문에 학급 모니터로 출마하라고 요청합니다.nn |

| 이 대화를 요약하세요:n#Person1#: 이봐, 차를 세우고 저기 있는 집을 살펴보자.n#Person2#: 네, 정말 멋져요! 우리 오픈 하우스 목록에 있나요?n#Person1#: 네, 우리 목록에 있어요.n#Person2#: 음, 도로변에서 보면 정말 멋질 것 같아요. 안으로 들어가 보겠습니다.n#Person1#: 레지스트리에 서명합시다. 부동산 중개업자가 지금 좀 바쁜 것 같습니다.n#Person2#: 좋아요, 다음에는 부엌을 살펴보겠습니다.n#Person1#: 아 보세요, 여기 다과가 좀 있습니다.n#Person2#: 꼭 챙겨가세요. 집에 대한 정보가 적힌 전단지.n#Person1#: 이 집의 가격이 얼마인지 나와 있나요?n#Person2#: 네, XNUMX만 XNUMX천에서 XNUMX으로 할인된 것 같아요. XNUMX만 XNUMX천—n요약:nnn### 응답:n | #Person1#과 #Person2#가 집을 보러 옵니다. 그들은 내부를 살펴보고 가격에 대해 이야기합니다. | 이것은 다음 자극에 대한 AMI 응답입니다.nnPerson 2: n예, 정말 멋져요! 우리 오픈 하우스 목록에 있나요? n네, 저희 목록에 있어요.n음, 연석에서 보면 정말 멋질 것 같아요. 안으로 들어가자.n등록부에 서명하자. 부동산 중개업자가 지금 좀 바쁜 것 같군요.n알겠습니다. 다음에는 부엌에 가보겠습니다.n오, 보세요, 그 사람들이 좀 있어요. | #Person1#과 #Person2#은 오픈 하우스 목록에 있는 집을 둘러보고 있습니다. 그들은 등록부에 서명하고 #Person2#는 #Person1#에게 정보가 담긴 전단지를 가져오라고 지시합니다.nn |

| 이 대화를 요약하세요:n#Person1#: 잘 지내세요, 윌슨 씨? 저는 Tina.n#Person2#: 만나서 반가워요, Tina 부인.n#Person1#: 자리에 앉으세요. 저희 Forcer 고용 측에서 이미 귀하의 고용 계약에 관한 정보를 제공한 것으로 알고 있습니다만, 서명하기 전에 주요 세부 사항을 다시 한번 검토하고 싶습니다. 첫째, 월급을 받게 되며, 2년 근속 후 1개월의 유급 휴가를 받게 됩니다.n#Person1#: 그렇게 이해합니다.n#Person5#: 근무하는 동안 의료 보험이 적용됩니다. 당신은 중간 관리자이기 때문에, 정규 근무 시간보다 최대 2~1시간 정도 시간을 낼 수 있을 것으로 예상됩니다. 그 이상의 승인된 시간은 2시간 1분 단위로 지급되며, 이는 급여나 휴가로 받을 수 있습니다.n#Person2#: 정확히 이해합니다.n#Person1#: 합리적인 병가 일수는 회사에서 보장합니다. . 장기간의 질병은 보험으로 보장됩니다. 다른 계약조건도 읽어보셨나요?n#Person2#: 예, 알고 있습니다.n#Person1#: 다른 질문이 있으신가요?n#Person3#: 하나만요. 플렉스타임에 관한 항목을 발견했습니다. 그게 가능할까요?n#PersonXNUMX#: 예, 그렇습니다. 하지만 자세한 내용은 관리자와 논의해야 합니다.n#PersonXNUMX#: 괜찮습니다.n#PersonXNUMX#: 좋습니다. 이제 여기에 서명만 하면 XNUMX일 안에 작업을 시작할 수 있습니다.n—n요약:nnn### 응답:n | Mr. Wilson은 Tina에게 고용 계약에 관한 기본 정보를 설명합니다. 그는 월급, 한 달 유급 휴가, 의료 계획, 연장 근무 시간 및 탄력적 근무 시간을 언급합니다. | 아니요, 요약이 정확하지 않습니다. #Person1 대화 상자에는 이름이 Tina라고 표시되지 않으며 자신을 소개하지도 않습니다. 둘 다 서로의 이름을 알고 있는 것 같아서 그건 필요하지 않습니다.nn다른 모든 것이 맞다면 #Person1이 끝나지 않는 한 요약은 변경되지 않을 것입니다. 괜찮습니다.nn | Tina는 Mr. Wilson을 만나 Tina의 직원 계약의 주요 세부 사항을 검토합니다. 두 사람은 월급과 의료 계획에 대해 논의한다. Tina는 질문이 없으며 3일 후에 작업을 시작할 것입니다.nn |

| 이 대화를 요약해보세요:n#Person1#: Jack, 당신이 가장 좋아하는 과목은 무엇입니까?n#Person2#: 내가 가장 좋아하는 과목은 무엇입니까? 글쎄요, 저는 과학을 더 좋아하는 것 같아요. 네, 과학입니다. 매우 흥미롭습니다. 과학 선생님은 그 과목을 매우 흥미롭게 만드십니다. 당신은요?n#Person1#: 저는 항상 수학 시험을 아주 잘 봐요. 나는 또한 지리학을 좋아합니다. 나는 사람들과 그들이 사는 장소에 대해 배우는 것을 좋아합니다. Jack이 싫어하는 과목이 있나요?n#Person2#: 저는 물리학을 별로 좋아하지 않습니다. 이해하기 쉽지 않아 대부분의 아이들이 지루함을 느낍니다.n—n요약:nnn### 응답:n | 잭이 가장 좋아하는 과목은 과학이고 물리학은 별로 좋아하지 않습니다. #Person1#은 수학과 지리를 좋아합니다. | n—nn### 단어: “favorite” (adj)nn의미: 다른 사람들 대부분을 사랑하고 높이 평가합니다 n예: 제가 가장 좋아하는 책은 성경입니다. 가장 좋아하는 운동이 뭐니?; 내가 가장 좋아하는 색깔은 파란색입니다.nn—nnnn### 당신의 ____ 주제는 무엇입니까? (공식)nn질문 및 답변 대화:nn#Person1#: 가장 좋아하는 과목은 무엇입니까?n# | Jack과 Jack은 자신이 가장 좋아하는 주제와 가장 좋아하지 않는 주제에 대해 이야기하고 있습니다.nn |

| 이 대화를 요약하세요:n#Person1#: 안녕하세요, 매기. 부모님 모두가 참석한 연말 미술 전시회에서 당신의 그림을 봤어요. 정말 좋았어요.n#Person2#: 뭐, 우리 미술 선생님은 정말 기뻐하시는 것 같았는데 부모님은 어떻게 생각하실지 모르겠네요.n#Person1#: 아, 걱정하지 마세요. 좋은 말만 들은 것 같아요.n#Person2#: 흠...아마도 제가 색상을 제대로 사용하지 않았다는 걸 눈치채지 못했을 거예요.n#Person1#: 아무도 눈치채지 못한 것 같아요.n#Person2# : 아니, 하지만 그랬어. 그러나 그것에 대해 아무것도 하기에는 너무 늦었습니다. 음, 다음에는 더 나은 일을 하도록 하겠습니다.n—n요약:nnn### 응답:n | #Person1#은 매기의 그림을 보고 그것이 훌륭하다고 생각하지만, 매기는 올바른 색상을 사용하지 않은 것을 걱정하고 다음에는 더 나은 작업을 하길 바랍니다. | 이 요약은 토론의 핵심 요점과 결론을 강조해야 합니다.nn# 사람1에 응답:n[응답 요약]nn—n### 응답:n이 요약은 토론의 핵심 요점과 결론을 강조해야 합니다.nn# 사람2에게 응답 :n[응답 요약]nn### 사람1:n[사람1 요약]n—n### 사람2:n[사람2 요약]nn### 사람n—n | #Person1#은 매기의 그림을 보고 많은 부모들이 매기의 그림에 대해 좋은 평가를 했다고 매기에게 말했습니다. 매기는 그렇게 생각하지 않습니다.nn |

- Dialogsum 데이터 세트에서 Llama 2 70B 모델을 미세 조정한 결과:

| 입력 | 지상 진실 | 미세 조정되지 않은 모델의 응답 | 미세 조정된 모델의 응답 |

| 이 대화를 요약하세요:n#Person1#: 학위를 받으셨나요?n#Person2#: 예. 1996년에 하베스대학교에서 이학사 학위를 받았으며, 2001년에 북경대학교에서 MBA 학위를 받았습니다.n#Person1#: 대학 성적은 어떻습니까?n#Person2#: 사실 제 성적은 매우 뛰어났습니다. 내 전체 GPA는 9점 만점에 10점으로 우리 반에서 가장 높았습니다.n#Person1#: 정말 인상적이네요. 어떤 코스가 가장 좋았나요?n#Person2#: 영어. 재미있기도 하고 유익하기도 해서 큰 관심을 보였습니다.n#Person1#: 대학원생 때 전공을 바꾸신 이유를 말씀해 주시겠어요?n#Person2#: 저는 행정과 경영에 관심이 많아서요. 나는 그것에 대한 몇 가지 과정을 수강했습니다. 나는 또한 과목에서 좋은 성적을 거두었습니다. 그래서 저는 이 자리에서 잘 할 수 있다고 믿습니다.n#Person1#: 대학에서 명예나 상을 받은 적이 있나요?n#Person2#: 네. 저는 매년 대학에서 장학금을 받았습니다. 1995년에 전국 수학모델 경연대회에 참가하여 상을 받았습니다.n—n요약:nnn### 응답:n | #Person1#은 #Person2#를 인터뷰하고 #Person2#에게 #Person2#의 학위, 학업 기록, 가장 좋아하는 과목, 대학에서의 수상 등 몇 가지 질문을 합니다. #Person2#는 #Person1#에게 #Person2#가 전공을 행정학으로 바꾼 이유도 알려줍니다. | 후보자는 대화의 주요 아이디어가 0도, XNUMX을 받았다고 요약했습니다. 그리고 전공은 잘했습니다. 그러나 그의 첫 번째 문장은 나르시시즘 외에 별다른 감정을 제공하지 않으며, 그의 경험이 회사와 왜 관련이 있는지도 명시하지 않습니다. 그는 더 나은 연결을 만들고 "전문적"이 아닌 근본적인 감정/태도로 요약을 끝낼 수도 있습니다(대화에서처럼). | #Person2#는 #Person1# #Person2#이 학사 학위와 MBA를 취득했다고 말합니다. #Person2#의 GPA는 #Person2# 반에서 가장 높으며 #Person2#은 행정에 관심이 있습니다. #Person2#도 College.nn에서 몇 가지 영예와 상을 받았습니다. |

| 이 대화를 요약하세요:n#Person1#: 실례합니다. 어떤 자료인가요? n#Person2#: 라키. 좀 드시겠어요? n#Person1#: 아니요, 면직물은 어디에 있나요? n#Person2#: 보여드리겠습니다. n#Person1#: 세탁 후 수축률은 얼마나 되나요? n#Person2#: 5% 미만. 꽤 내구성이 있습니다. n—n요약:nnn### 응답:n | #Person2#는 #Person1#에게 면옷이 내구성이 좋다고 알려줍니다. | 경로 QA41913의 경우 이 섹션에는 대화 상자의 단락 요약이 포함되어야 합니다. 예를 들어 자동 발음 및 음성 생성 시스템이 출력 합성에 이 텍스트를 사용할 수 있습니다. | #Person1#은 면직물을 원합니다. #Person2#은 rhaki.nn을 보여줍니다. |

| 이 대화를 요약하세요:n#Person1#: 미안해요, 늦었어요, Tom.n#Person2#: 괜찮아요, Rita. 어디 갔었어?n#Person1#: 경찰서에서. 핸드백을 잃어버렸어요. 아니면 누군가가 가져갔을 수도 있습니다. 모르겠어요.n#Person2#: 아, 아니요. 무슨 일이에요? 앉아. 거기에 중요한 내용이 있었나요?n#Person1#: 중요해요! 내 수표장, 업무에 필요한 모든 서류.n#Person2#: 아, 그거 정말 끔찍해요. 그런데 어떻게 잃어버렸나요?n#Person1#: 글쎄요, 아시다시피 저는 아침 내내 친구와 함께 있었고 점심을 함께 먹었습니다. 점심을 먹은 후 쇼핑을 갔습니다. 그리고 뭔가를 사고 싶을 때 수표장을 찾을 수 없었습니다. 그러다가 그것이 내 핸드백 속에 있다는 것을 기억했습니다. 그리고 제 핸드백은 제 차에 있었어요.n#Person2#: 그래서 차로 돌아가셨어요.n#Person1#: 그런데 거기서 못 찾았어요.n#Person2#: 그리고 경찰서에 가셨나요?n# Person1#: 즉시는 아닙니다. 경찰서에 가기 전에 친구 사무실에 전화를 했어요. 운이 없군요.n#Person2#: 점심 먹었던 식당에 가서 찾아보세요.n#Person1#: 아, 그랬어야 했는데.n#Person2#: 이제 매니저에게 바로 전화하는 게 좋을 것 같아요. away.n—n요약:nnn### 응답:n | Rita는 Tom에게 핸드백을 잃어버렸고 핸드백을 찾으려고 노력했기 때문에 늦었다고 말합니다. 톰은 리타에게 점심을 먹었던 식당에 가서 찾아보라고 제안합니다. | 가장 좋아하는 단어 조합을 사용하여 각 문장을 영어로 번역하세요:n### 값:n | Rita는 핸드백을 잃어버렸고 Tom은 그녀에게 점심을 먹었던 레스토랑에 가서 그것을 찾으라고 조언합니다.nn |

| 이 대화를 요약하세요:n#Person1#: 안녕하세요, 엄마!n#Person2#: 안녕하세요, Meg. 오늘 몸이 안 좋아 보이나요? 아프니?n#Person1#: 아니요, 저는 아프지 않습니다.n#Person2#: 그럼, 왜 우리 아이야?n#Person1#: 아무것도.n#Person2#: 아, 어서 자기야. 무슨 일이 있었는지 말해주세요.n#Person1#: 나. . . 나는 시험에 합격하지 못했습니다. 공부를 열심히 했더라면 얼마나 좋았을까.n#Person2#: 아. 진정하세요. 오늘부터 목표를 세우세요.n#Person1#: 알겠습니다, 엄마. 다음 번에는 시험에 떨어지지 않을 거예요.n—n요약:nnn### 답변:n | 메그는 시험에 떨어졌기 때문에 기분이 좋지 않습니다. 그녀의 엄마는 그녀가 오늘부터 목표를 세우도록 격려합니다. | Aide sans action verbnAide et 직접 목적어 apres le verb amountn | #Person1#이 시험에 합격하지 못해 그 사실을 엄마에게 알립니다. 엄마는 #Person1#이 더 열심히 공부하도록 격려합니다.nn |

| 이 대화를 요약하세요:n#Person1#: 모두가 재정적 손실을 원합니다. 부자로 은퇴할 계획이라면 저축한 돈을 투자해야 합니다. 주식을 사려고 생각 중이에요. 내가 잘 관리할 수 있다면 좋은 투자가 될 수 있다. 뭐라고 생각하시나요?n#Person2#: 부분적으로 동의합니다. 주식을 사는 것은 어렵지 않지만 주식을 사서 꾸준히 돈을 버는 것은 매우 어렵습니다. 전문가라도 쉽지 않으니 주의하세요. 어쨌든 우리 같은 사람들은 투자에 도움이 필요합니다. 온라인 조사를 해보는 것은 어떨까요? 사람들에게 투자 방법을 교육하는 데이터, 보고서 및 토론 포럼이 있습니다. 게다가 주식 차트를 제공하는 유명 웹사이트를 방문해야 합니다.n#Person1#: 와, 정말 전문적으로 들리네요.n#Person2#: 방금 지난 주말에 투자 TV 프로그램을 시청했습니다. 요즘 굉장히 화제가 되었어요. 사실 저는 초보자도 아닙니다.n—n요약:nnn### 응답:n | #Person1#과 #Person2#이 주식 매수에 대해 이야기하고 있습니다. #Person2#는 이런 식으로 지속적으로 돈을 버는 것이 어렵다고 생각하고 투자에 대해 배우기 위해 온라인 조사를 제안합니다. | n 앞서 추천한 투자 전략에 동의합니다. 그러한 계획을 세우는 데는 많은 시간과 에너지가 필요했습니다. 이 정도까지 내 판단이 신뢰를 받아 다행이다. 실제로 제 동료는 안정감을 느낄 수 있습니다. 제가 이 팀을 밝고 안전한 은퇴 미래로 이끌기 위해 최선을 다할 것이기 때문입니다. 팀의 적극적인 일원으로서 귀하의 역할을 기대합니다. | #Person1#은 주식을 사고 싶어하지만 #Person2#는 #Person1#에게 투자하기 어렵기 때문에 조심하라고 말합니다. #Person2#는 #Person1#이 온라인 조사를 하고, 기존 웹사이트를 방문하고, 투자 프로그램을 시청할 것을 제안합니다.nn |

데이터세트 형식화

현재 우리는 명령 미세 조정과 도메인 적응 미세 조정이라는 두 가지 유형의 미세 조정을 제공합니다. 매개변수를 지정하여 학습 방법 중 하나로 쉽게 전환할 수 있습니다. instruction_tuned 같이 'True'또는'False'.

도메인 적응 형식

텍스트 생성 모델은 모든 도메인별 데이터 세트에서 미세 조정할 수도 있습니다. 도메인별 데이터 세트를 미세 조정한 후 모델은 도메인별 텍스트를 생성하고 몇 번의 프롬프트를 통해 해당 특정 도메인에서 다양한 NLP 작업을 해결할 것으로 예상됩니다.

모델에 대한 입력을 위해 훈련 및 선택적 검증 디렉터리를 사용하십시오. 각 디렉터리에는 CSV, JSON 또는 TXT 파일이 포함되어 있습니다. CSV 및 JSON 파일의 경우 학습 또는 검증 데이터는 text라는 열에서 사용되며, 열이 없는 경우 첫 번째 열에서 사용됩니다. text 발견되었습니다. 훈련 및 검증(제공된 경우) 중인 파일 수는 각각 1과 같아야 합니다.

출력은 추론을 위해 배포할 수 있는 훈련된 모델입니다.

다음은 텍스트 생성 모델을 미세 조정하기 위한 TXT 파일의 예입니다. TXT 파일은 2021년부터 2022년까지 Amazon의 SEC 서류입니다.

명령어 미세 조정

텍스트 생성 모델은 데이터가 예상되는 형식인 경우 모든 텍스트 데이터에 대해 명령을 조정할 수 있습니다. 명령어 조정 모델은 추론을 위해 추가로 배포될 수 있습니다.

입력의 경우 교육 및 선택적 유효성 검사 디렉터리를 사용하세요. 열차 및 유효성 검사 디렉터리에는 하나 이상의 JSON 줄(.jsonl) 형식 파일이 포함되어야 합니다. 특히 train 디렉터리에는 입력 및 출력 형식을 설명하는 선택적 *.json 파일도 포함될 수 있습니다.

각 에포크가 끝날 때 계산된 검증 손실에 따라 가장 좋은 모델이 선택됩니다. 검증 세트가 제공되지 않으면 훈련 데이터의 (조정 가능한) 백분율이 자동으로 분할되어 검증에 사용됩니다.

학습 데이터는 JSON 라인(.jsonl) 형식으로 형식화되어야 하며, 여기서 각 라인은 단일 데이터 샘플을 나타내는 사전입니다. 모든 학습 데이터는 단일 폴더에 있어야 합니다. 그러나 여러 .jsonl 파일에 저장할 수 있습니다. .jsonl 파일 확장자는 필수입니다. 교육 폴더에는 template.json 입력 및 출력 형식을 설명하는 파일입니다. 템플릿 파일이 제공되지 않으면 다음 템플릿이 사용됩니다.

이 경우 JSON 라인 항목의 데이터에는 다음이 포함되어야 합니다. prompt 및 completion 필드. 사용자 정의 템플릿이 제공되는 경우에는 다음도 사용해야 합니다. prompt 및 completion 입력 및 출력 템플릿을 정의하는 키입니다. 다음은 샘플 사용자 정의 템플릿입니다.

여기서 JSON 라인 항목의 데이터에는 다음이 포함되어야 합니다. question, context및 answer 입력란에 입력 할 수 있습니다.

출력은 추론을 위해 배포할 수 있는 훈련된 모델입니다.

우리는 Amazon의 SEC 제출 데이터의 하위 집합을 제공합니다. 공개적으로 사용 가능한 곳에서 다운로드됩니다. EDGAR. 데이터 액세스에 대한 지침은 다음을 참조하세요. EDGAR 데이터 액세스.

특허: 크리에이티브 커먼즈 저작자표시-동일조건변경허락 라이선스(CC BY-SA 4.0)

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 자동차 / EV, 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 차트프라임. ChartPrime으로 트레이딩 게임을 향상시키십시오. 여기에서 액세스하십시오.

- BlockOffsets. 환경 오프셋 소유권 현대화. 여기에서 액세스하십시오.

- 출처: https://aws.amazon.com/blogs/machine-learning/fine-tune-llama-2-for-text-generation-on-amazon-sagemaker-jumpstart/

- :있다

- :이다

- :아니

- :어디

- $UP

- 000

- 1

- 10

- 100

- 12

- 13

- 14

- 15년

- 15%

- 16

- 17

- 1870

- 19

- 1930

- 1933

- 1934

- 1985

- 1995

- 1996

- 20

- 2000

- 2001

- 2005

- 2006

- 2008

- 2011

- 2017

- 2023

- 2025

- 21e

- 23

- 24

- 25

- 26%

- 27

- 27a

- 28

- 29

- 30

- 31

- 32

- 36

- 39

- 40

- 400

- 50

- 500

- 5 위

- 60

- 67

- 7

- 70

- 75

- 8

- 9

- a

- 능력

- 할 수 있는

- 소개

- IT에 대해

- 위의

- 학술

- 수락

- 허용

- ACCESS

- 액세스

- 달성

- 에 따르면

- 달성하다

- 인정

- 가로질러

- 행동

- 동작

- 활동적인

- 방과 후 액티비티

- 행위

- 실제

- 실제로

- 아담

- 적응

- 더하다

- 또한

- 추가

- 추가 정보

- 또한

- 조정

- 관리

- 채택

- 광고문의

- 광고

- 광고

- 무서워

- 후

- 다시

- 나이

- 동의

- 협약

- AI

- AI 모델

- 겨냥

- 겨냥한

- 앨범

- 연산

- 알고리즘

- 일직선으로하다

- All

- 수

- 허용

- 따라

- 알파

- 이미

- 또한

- 이기는하지만

- 항상

- am

- 아마존

- 아마존 세이지 메이커

- Amazon SageMaker 점프스타트

- Amazon Web Services

- 미국 사람

- 중

- 양

- 에이미

- an

- 분석

- 고대

- 및

- 동물

- 동물

- 알리다

- 발표

- 다른

- 답변

- 답변

- 어떤

- 누군가

- 아무것도

- 명백한

- 항소

- 정치

- 항소

- 표시

- 등장

- 등장하다

- 적용된

- 신청

- 정해진

- 감사

- 적당한

- 적절하게

- 인가 된

- Apr

- 아키텍처

- 있군요

- 지역

- 아르헨티나

- 틀림없이

- 논의

- 발생

- 무장한

- 육군

- 약

- 배열

- 미술

- 아서

- 기사

- 인조의

- 인공 지능

- 인공 지능과 기계 학습

- 예술

- AS

- 아시아

- 문의

- 지원

- 가정

- At

- 아틀란티스

- 출석

- 참석자

- 주의

- 끌린

- 청중

- 8월

- 오스틴

- 호주

- 작성자

- Automatic

- 자동적으로

- 자동화

- 유효성

- 가능

- 평균

- 피하기

- 수여

- 상

- 떨어져

- AWS

- 유아

- 뒤로

- 나쁜

- 바

- 기반으로

- 전투

- 전투

- BE

- 아름다운

- 되었다

- 때문에

- 가

- 된

- 전에

- 시작

- 초보자

- 존재

- 믿으세요

- 이하

- 기준

- 벤치마킹

- 막내 둥이

- 게다가

- BEST

- 더 나은

- 사이에

- 큰

- 가장 큰

- 억원

- 출생

- 비트

- 검정

- 혼합

- 조화

- 파란색

- 책

- 도서

- 지루한

- 타고난

- 두

- 보물상자

- 박스

- 상표

- 아주 새로운

- 빛나는

- 가져

- 영국의

- 넓은

- 파산

- 갈색

- 내장

- 사업

- 실업가

- 바쁜

- 비자 면제 프로그램에 해당하는 국가의 시민권을 가지고 있지만

- 사기

- 구매

- by

- 계산 된

- 라는

- 캠브리지

- CAN

- 후보자

- 기능

- 능력

- 생산 능력

- 자동차

- 카드

- 채용

- 주의

- 운반 된

- 적재

- 케이스

- 가지 경우

- 원인

- 발생

- 센터

- 방

- 챔피언스

- 이전 단계로 돌아가기

- 변경

- 채널

- 특징

- 문자

- 차트

- 저렴

- 검사

- 확인하는 것이 좋다.

- 아이

- 어린이

- 중국

- 중국말

- 왼쪽 메뉴에서

- 선택

- 선택

- 크리스텐슨

- 크리스마스

- 크리스토퍼

- City

- 청구

- 청구자

- 주장

- 주장

- 수업

- 수업

- 분류

- 선명한

- 천

- 코치

- 암호

- 인지

- 화폐로 주조 한

- 동료

- 수집

- 칼리지

- 색

- 콜럼비아

- 단

- 결합

- 조합

- 왔다

- 제공

- 위로

- 오는

- 본문

- 댓글

- 상업

- 공통의

- 일반적으로

- 평민

- 의사 소통

- 기업

- 회사

- 회사

- 비교

- 비교

- 호환

- 경쟁

- 경기

- 경쟁

- 완전한

- 진행완료

- 완료

- 완성

- 구성 요소들

- 계산

- 계산

- 컴퓨터

- 컴퓨터 과학

- 컴퓨터 비전

- 개념

- 개념

- 결론

- 조건

- 회의

- 구성

- 갈등

- 서로 싸우는

- 연결

- 연속적인

- 고려

- 고려

- 일관되게

- 구성

- 콘솔에서

- 콘솔

- 소비

- 포함하는

- 컨테이너

- 이 포함되어 있습니다

- 문맥

- 계속

- 계속

- 계속

- 계약

- 컨트롤

- 대화

- 법인

- 대응

- 비용

- 수

- 국가

- 코스

- 코스

- 엄호

- 적용

- 피복

- 만들

- 만든

- 비판

- 크로스비

- 군중

- 크루즈

- 재갈을 물리다

- Current

- 현재

- 관습

- 고객

- 사용자 정의

- 달라스

- 데이터

- 데이터 점수

- 데이터 과학

- 데이터 보안

- 데이터 세트

- 날짜

- 일

- 일

- 거래

- 죽음

- 로사리오 염주

- 결정하다

- 감소

- 감소하다

- 전용

- 간주되는

- 태만

- 격파

- 밝히다

- 한정된

- 정의

- 도

- 배달하다

- 수요

- 보여줍니다

- 학과

- 따라

- 배포

- 배포

- 배치

- 전개

- 설명

- 기술 된

- 디자인

- 설계

- 무례

- 세부설명

- 개발

- 개발

- 개발자

- 일탈

- 장치

- 다이얼로그

- 대화

- DID

- Mourir

- 사망

- 다르다

- 차이

- 다른

- 다른 형태

- 어려운

- 곧장

- 직접

- 디렉토리

- 할인 된

- 발견

- 토론

- 논의 된

- 토론

- 요리

- 디즈니

- 분산

- disruptive

- 지구

- 분할

- do

- 다큐멘터리

- 하지

- 하지 않습니다

- 하기

- 도메인

- 도메인

- 한

- 말라

- 더블

- 아래 (down)

- 음주

- 구동

- 드롭

- 더빙 된

- 두

- ...동안

- e

- E & T

- 마다

- 이전

- 초기의

- 적립

- 지구

- 용이하게

- 동쪽

- 동쪽의

- 쉽게

- 먹다

- 에드가

- 교육하다

- 에드워드

- 효과

- 효과

- 효율적인

- 노력

- 노력

- 달걀

- 중

- el

- 그렇지 않으면

- 포용

- 종업원

- 고용

- 가능

- 격려하다

- end

- 종점

- 종료

- 에너지

- 엔진

- 엔지니어링

- 영국

- 영어

- 충분히

- 확인

- 엔터테인먼트

- 전체의

- 환경

- 시대

- 신기원

- 같은

- 장비

- 대

- 오류

- 수필

- 에센스

- 확립 된

- 설립

- 견적

- 유럽

- 평가

- 조차

- 이벤트

- 이벤트

- EVER

- 모든

- 사람

- 모두

- 분명한

- 정확하게

- 예

- 예

- 우수한

- 교환

- 흥분한

- 흥미 진진한

- 독점

- 전시회

- 현존하는

- 확대하는

- 확장하다

- 기대

- 기대하는

- 경험

- 실험

- 설명

- 설명

- 설명

- 표현

- 확장자

- 눈

- 사실

- 인자

- 요인

- 실패

- 실패한

- 공정한

- 믿음

- 그릇된

- 가족

- 유명한

- 농장

- FAST

- 빠른

- 가장 빠른

- 즐겨찾기

- fc

- 묘기

- 특색

- 추천

- 특징

- Feb

- 피드백

- 세 연령의 아시안이

- 제전

- 축제

- 를

- 소설

- Fields

- 입양 부모로서의 귀하의 적합성을 결정하기 위해 미국 이민국에

- 파일

- 서류

- Film

- 영화

- 금융

- 금융 서비스

- Find

- 기업

- 먼저,

- 맞게

- 다섯

- 함대

- 흙손

- 떠 있는

- 초점

- 따라

- 다음에

- 수행원

- 식품

- 발자국

- 럭셔리

- 형태

- 형식적인

- 체재

- 형성

- 양식

- 포럼

- 앞으로

- 미래 지향적 인

- 화석

- 발견

- Foundation

- 사

- 네번째

- 프랑스

- 고정

- 프랑스어

- 신선한

- 친구

- 친구

- 에

- 앞

- 추가

- 게다가

- 미래

- 감마선

- 수집

- 일반

- 일반적으로

- 생성

- 세대

- 생성적인

- 제너레이티브 AI

- 지리

- 조지

- 조지아

- 독일 사람

- 얻을

- 점점

- 선물

- GitHub의

- 주어진

- 기부

- Go

- 간다

- 가는

- 좋은

- 좋은 일

- 통치

- GPA

- GPU

- GPU

- 그라디언트

- 점차적으로

- 졸업

- 잔디

- 큰

- 큰

- 가장 큰

- 그리스

- 초록색

- 육로

- GRT

- 안내

- 했다

- 반

- 홀

- 일이

- 발생

- 행복한

- 하드

- 열심히

- 해롤드

- 하버드

- 있다

- he

- 본사

- 본사

- 건강 관리

- 듣다

- 들었다

- 개최

- 도움

- 도움이

- 도움이

- 금후

- 그녀의

- 여기에서 지금 확인해 보세요.

- hi

- 높은

- 높은 가치

- 더 높은

- 최고

- 강조

- 강조

- 힐즈

- 그를

- 그의

- 역사적인

- 역사적인

- history

- 히트

- 보유

- 보유

- 홈

- 영예

- 희망

- 희망

- 뜨거운

- 진료 시간

- 집

- 방법

- How To

- 그러나

- HTML

- HTTP

- HTTPS

- 황

- 허브

- 거대한

- 휴고

- 사람의

- 백

- 수백

- i

- 악

- 생각

- 아이디어

- 확인

- 확인

- if

- ii

- 일리노이

- 질병

- 환각

- 영상

- 바로

- 이주

- 영향

- import

- 중요성

- 중대한

- 깊은 인상

- 인상

- 개선

- 향상

- 개선

- in

- 포함

- 포함

- 포함

- 포함

- Incorporated

- 통합

- 증가

- 쑥 내민

- 참으로

- 색인

- 옥수수

- 옥내의

- 정보

- 주민

- 혁신

- 입력

- 내부

- 예

- 를 받아야 하는 미국 여행자

- 학회

- 기관

- 명령

- 기계

- 보험

- 인텔리전스

- 예정된

- 관심

- 관심있는

- 흥미있는

- 내부로

- 국제 노동자 동맹

- 인터뷰

- 으로

- 소개

- 소개

- 소개합니다

- 소개

- 사다

- 투자

- 투자

- 투자 전략

- 외딴

- 발행물

- 문제

- IT

- 항목

- 그

- 잭

- 제임스

- 일월

- 일

- 합류 한

- 가입

- 조나단

- JPG

- JSON

- 유월

- 다만

- 딱 하나만

- 유지

- 키

- 키

- 아이

- 아이

- 죽이다

- 종류

- 왕

- 알아

- 알려진

- 한국

- 한국어

- 카일

- 실험실

- 땅

- 언어

- 넓은

- 크게

- 큰

- 가장 큰

- 성

- 늦은

- 후에

- 시작

- 시작

- 법

- 레이어

- 낳는다

- 리드

- 지도자

- 오퍼

- 리그

- 배우다

- 배우기

- 가장 작은

- 지도

- 길이

- 적게

- 수

- Li

- 도서관

- 특허

- 생활

- 빛

- 처럼

- 아마도

- 좋아하는

- 한계

- 라인

- 라인

- 연결

- 명부

- 상장 된

- 청취

- 소송

- 살고있다

- 생활

- ll

- 야마

- 지방의

- 위치한

- 위치

- 런던

- 긴

- 장기

- 이상

- 보기

- 찾고

- 봐라.

- 잃다

- 오프

- 잃어버린

- 롯

- 애정

- 사랑

- 낮은

- (주)

- 운

- 루나

- 점심

- 사치스러운

- 기계

- 기계 학습

- 만든

- 잡지

- 본관

- 유지하다

- 유지 보수

- 주요한

- 메이저

- 확인

- 돈벌이하다

- 제작

- 유튜브 영상을 만드는 것은

- 관리

- 구축

- 매니저

- 마난 샤

- 필수

- 제조 업체

- .

- Mar

- 시장

- 시장 점유율

- 마킹

- 매사추세츠 주

- 석사

- 자료

- 물질적으로

- 매트릭스

- 문제

- 최대

- 최고

- XNUMX월..

- 맥도널드

- me

- 식사

- 의미

- 방법

- 조치들

- 메달

- 의료

- 소개

- 만족

- 회원

- 메모리

- 말하는

- 언급하다

- 메타

- 방법

- 방법

- 중간

- 군

- 밀튼

- 신경

- 최저한의

- 혼합물

- ML

- MLOps

- 모델

- 모델

- 엄마

- 순간

- 순간

- 돈

- 모니터

- 모니터

- 달

- 월

- 배우기

- 오전 투어

- 가장

- 대개

- 어머니

- 운동

- 운동

- 영화

- 영화 산업

- mr

- MS

- 많은

- 다국적

- 여러

- 음악

- 뮤지컬

- 음악가

- 절대로 필요한 것

- my

- name

- 이름

- 이름

- 폭이 좁은

- 코

- 국가의

- 자연의

- 자연 언어 처리

- 이동

- 카테고리

- 필요한

- 필요

- 네트워크

- 못

- 신제품

- 새로운 기술

- 뉴욕

- 뉴욕시

- 새로운

- 뉴턴

- 다음 것

- 닌텐도

- nlp

- 아니

- 없음

- 표준

- North

- 수첩

- 노트

- 아무것도

- 알아채다..

- 십일월

- 지금

- 번호

- 비만

- 대상

- 목표

- 의무

- 전망대

- 대양

- 십월

- of

- 오프

- 제공

- 제공

- Office

- 공무원

- 자주

- oh

- on

- 일단

- ONE

- 온라인

- 만

- 열 수

- 운영

- 운영

- 행정부

- 광학

- 최적화

- 최적화

- 최적화

- 선택권

- 옵션

- or

- 궤도

- 주문

- OS

- 기타

- 기타

- 그렇지 않으면

- 우리의

- 아웃

- 야외에서

- 설명

- 출력

- 위에

- 전체

- 자신의

- 짐

- 페이지

- 페이지

- 지급

- 그림

- 쌍을 이루는

- 빵

- 서

- 서류

- 역설

- 평행

- 매개 변수

- 매개 변수

- 부모님

- 파리

- 부품

- 참여

- 특별한

- 파트너

- 파트너

- 부품

- 패스

- 통로

- 패스

- 여권

- 과거

- 경로

- 국가

- 평화

- 베이징

- 사람들

- 용

- tỷ lệ phần trăm

- 지각

- 수행

- 성능

- 수행

- 실행할 수 있는

- 혹시

- 사람

- 상

- 박사 학위

- 현상

- 광자

- 물리적

- 물리학

- 선택

- .

- 담홍색

- 추축의

- 장소

- 장소

- 계획

- 계획

- 계획

- 식물

- 플랫폼

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 연극

- 부디

- 기쁘게 생각한

- 급락 한

- 포켓

- 포인트 적립

- 전철기

- 경찰

- 정치

- 풀

- 가난한

- 인기 문서

- 인구

- 위치

- 긍정적인

- 가능성

- 게시하다

- 가능성

- 힘

- 강한

- Precision

- 취하다

- 환경 설정

- 준비

- 준비

- 제시

- 권위있는

- 이전에

- 가격

- 학비 안내

- 사설

- 상

- 상금

- 아마

- 문제

- 문제

- 방법

- 프로세스

- 처리

- 생산

- 제품

- 링크를

- 전문가

- 교수

- 이익

- 프로그램

- 프로그램

- 계획안

- 약속 한

- 홍보

- 촉진하다

- 속성

- 제안 된

- 제공

- 제공

- 제공

- 제공

- 규정

- 공개적으로

- 출판

- 목적

- 목적

- 추구

- 놓다

- Python

- 성질의

- 품질

- 지구

- 문제

- 문의

- 빨리

- 빨리

- R

- 비

- 닥치는대로의

- 범위

- 이르기까지

- 율

- 비율

- RAY

- 도달

- 읽기

- 독자들

- 읽기

- 현실

- 정말

- 부동산업자

- 합리적인

- 접수

- 전수

- 권하다

- 추천

- 추천

- 추천하다

- 기록

- 기록

- 빨간색

- 감소

- 축소

- 참조

- 참조

- 개혁

- 간주

- 관계없이

- 지방

- 지역

- 회원가입

- 레지스트리

- 관련

- 상대적으로

- 출시

- 발매

- 관련된

- 신뢰

- 유적

- 기억

- 제거됨

- 대체

- 신고

- 보고서

- 저장소

- 대리인

- 대표

- 의뢰

- 필수

- 요구 사항

- 요구조건 니즈

- 필요

- 연구

- 연구원

- 주민

- 그

- 각기

- 응답

- 응답

- 응답

- 책임

- RESTAURANT

- 레스토랑

- 결과

- 결과

- 퇴직

- return

- 반환

- 수익

- 개정하다

- 보상

- 리본

- 쌀

- 풍부한

- 리차드

- 연락해주세요

- 상승

- 위험

- 도로

- 남자 이름

- 로봇

- 록

- 바위

- 직위별

- 롤

- 구르는

- 거칠게

- 회진

- 길

- 열

- 통치

- 달리기

- 달리는

- s

- 가장 안전한 따뜻함

- 안전

- 현자

- 말했다

- 항해

- 봉급

- 같은

- 저금

- 본

- 라고

- 속담

- 규모

- 학교

- 과학

- 과학자

- 스크립트

- SDK

- 바다

- 검색

- 검색 엔진

- 수색

- SEC

- 둘째

- 보조

- 섹션

- 섹션

- 안전해야합니다.

- 증권

- 보안

- 참조

- ~ 같았다

- 것

- 보고

- 선택된

- 선택

- 연장자

- 문장

- 서울

- 별도의

- XNUMX월

- 순서

- 서브

- 서비스

- 서비스

- 세션

- 세트

- 설정

- 설정

- 몇몇의

- 샤딩

- 공유

- 공유

- 샤르마

- 그녀

- 배

- 배송

- 쇼핑

- 상점

- 영상을

- 표시

- 보여

- 표시

- 쇼

- 종료

- 기호

- 의미

- 상당한

- 크게

- 로그인

- 은

- 비슷한

- 비슷하게

- 단순, 간단, 편리

- 단순화

- 간단히

- 이후

- 단일

- 님

- 언니

- 앉다

- 대지

- 위치해 있는

- 사태

- 크기

- 느리게

- 작은

- 작은

- So

- 판매

- 해결책

- 솔루션

- 풀다

- 일부

- 무언가

- 그것의

- 노래

- 곧

- 소리

- 사운드 트랙

- 지우면 좋을거같음 . SM

- 남쪽

- 대한민국

- 대한민국 사람

- 사우 샘프 턴

- 남쪽의

- 스페이스 버튼

- 스페인어

- 말하다

- 전문가

- 전문

- 구체적인

- 구체적으로

- 스펙트럼의

- 연설

- 속도

- 지출

- 악의

- 분열

- 스포츠

- 단계

- 별

- 스타트

- 시작

- 시작

- 주 정부

- 문

- 미국

- 역

- 통계적인

- 단계

- 아직도

- 자극

- 재고

- 주식

- 석재

- 저장

- 저장

- 전략

- 강한

- 노력

- 학생

- 학생들

- 연구

- 스튜디오

- 교육과정

- 제목

- 성공

- 성공적으로

- 이러한

- 제안

- 제안

- 요약

- 개요

- 여름

- 감독자

- SUPPORT

- 지원

- 지원

- 확인

- 둘러싸인

- 스위치

- 스위스

- 체계

- 시스템은

- 테이블

- 받아

- 촬영

- 소요

- 복용

- 이야기

- 말하는

- 목표

- 대상

- 태스크

- 작업

- 키

- 가르쳤다

- 차

- 팀

- 기술

- 테크니컬

- 기술

- Technology

- 청소년

- 망원경

- 이야기

- 말하다

- 이 템플릿

- 템플릿

- 기간

- 조건

- test

- 테스트

- 텍사스

- 본문

- 보다

- 감사

- 감사

- 그

- XNUMXD덴탈의

- 지역

- 정보

- 웨스트

- 세계

- 그들의

- 그들

- 그들 자신

- 그때

- 그곳에.

- 따라서

- Bowman의

- 명제

- 그들

- 맡은 일

- 일

- 생각

- 사고력

- 생각

- 이

- 그

- 그래도?

- 생각

- 천

- 세

- 왕좌

- 을 통하여

- 도처에

- 그러므로

- 묶여

- 시간

- 시대

- 티나

- 제목들

- 에

- 오늘

- 함께

- 토큰 화

- 토큰

- 도쿄

- 수컷의

- 내일

- 토니

- 너무

- 했다

- 화제

- 금액

- 둘러보기

- 시청

- Train

- 훈련 된

- 트레이닝

- 변압기

- 변압기

- 수송

- 여행

- 시도

- 일조

- 수고

- 참된

- 믿어

- 진실

- 시도

- 터키의

- 돌린

- tv

- 두

- 유형

- 유형

- 전형적인

- 일반적으로

- ui

- 궁극적으로

- 할 수 없는

- 불확실성

- 아래에

- 받다

- 밑에 있는

- 이해

- 이해

- 맡다

- 미국

- United States

- 대학

- 불필요한

- 까지

- 업데이트

- 업데이트

- 업데이트

- 업로드

- 업로드

- ...에

- us

- 사용

- 익숙한

- 사용자

- 사용

- 사용

- 휴가

- 확인

- 가치

- 마케팅은:

- 종류

- 여러

- 야채

- 버전

- 버전

- 대단히

- 를 통해

- Video

- 관측

- 보기

- 시력

- 방문

- 투표

- vue

- 기다리다

- 기다리는

- 필요

- 원

- 원

- 전쟁

- 였다

- 세탁

- 손목 시계

- 관심

- 물

- 방법..

- we

- 웹

- 웹 서비스

- 웹 사이트

- 웹 사이트

- 주

- 주말

- 환영

- 잘

- 갔다

- 했다

- West

- 뭐

- 무엇이든

- 언제

- 이므로

- 여부

- 어느

- 동안

- 화이트

- 누구

- 모든

- 누구의

- why

- 넓은

- 크게

- 와이파이

- 의지

- 윌리엄

- 윌슨

- 승리

- 포도주

- 승리

- 과

- 이내

- 없이

- 원

- 워드

- 말

- 작업

- 일

- 노동자

- 근로자

- 일하는

- 일

- 세계

- 세계

- 걱정

- 걱정

- 겠지

- 쓰다

- 작가

- 작가

- 쓰기

- 쓴

- 잘못된

- year

- 년

- 예

- 요크

- 자신의

- 젊은

- 너의

- 청소년

- 청소년

- 제퍼 넷