산업 장비 유지 관리, 무역 모니터링, 차량 관리 및 경로 최적화를 위한 많은 애플리케이션은 오픈 소스 Cassandra API 및 드라이버를 사용하여 구축되어 데이터를 고속 및 짧은 대기 시간으로 처리합니다. Cassandra 테이블을 직접 관리하는 것은 시간과 비용이 많이 소요될 수 있습니다. Amazon Keyspaces(Apache Cassandra용) 추가 인프라를 관리하지 않고도 AWS 클라우드에서 Cassandra 테이블을 설정, 보호 및 확장할 수 있습니다.

이 게시물에서는 높은 수준에서 Amazon Keyspaces를 사용하여 기계 학습(ML) 모델 교육과 관련된 AWS 서비스를 안내하고 Amazon Keyspaces에서 데이터를 다음으로 수집하기 위한 단계별 지침을 제공합니다. 아마존 세이지 메이커 및 특정 고객 세분화 사용 사례에 사용할 수 있는 모델을 교육합니다.

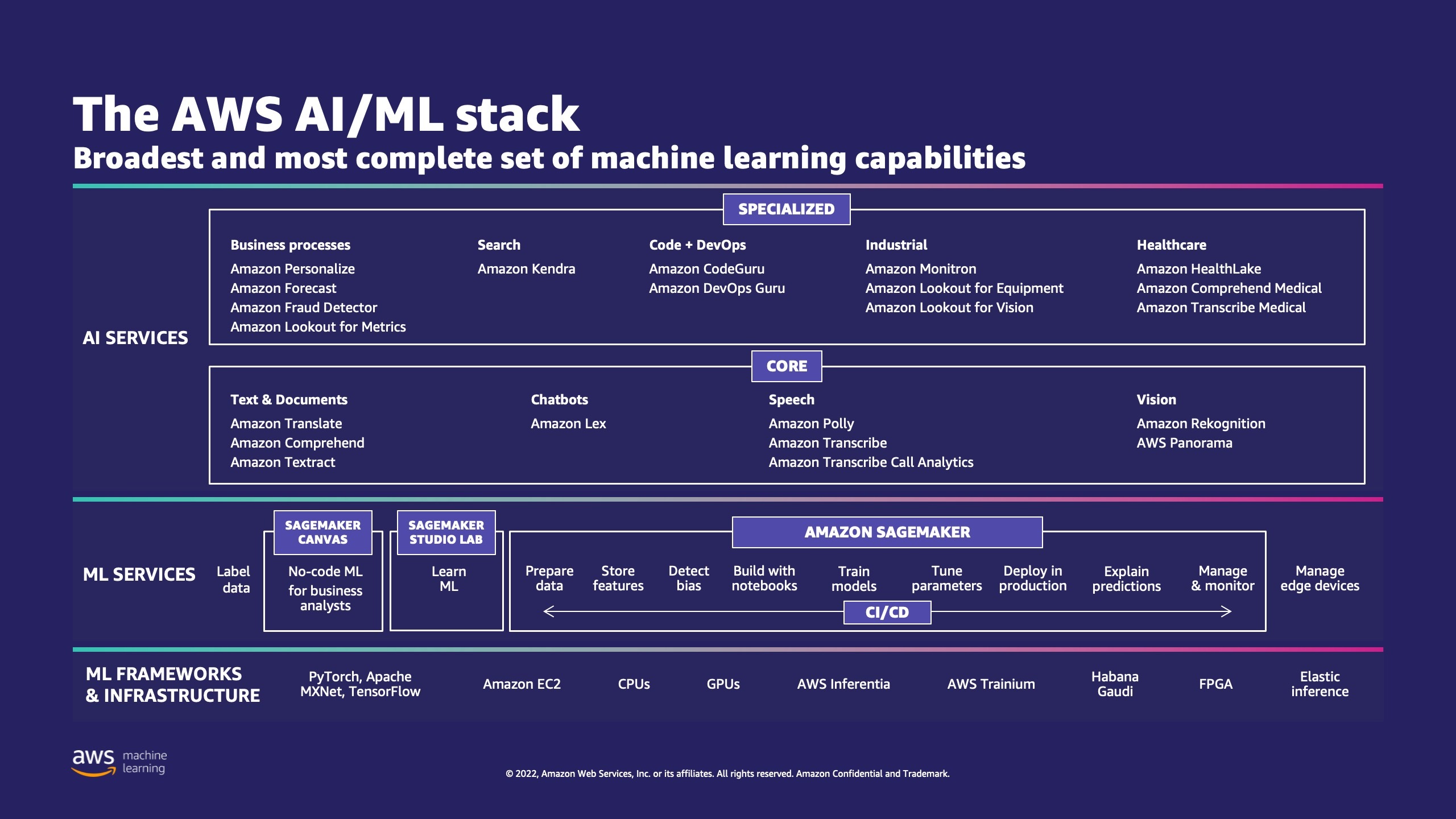

AWS에는 기업이 클라우드에서 ML 프로세스를 구현하는 데 도움이 되는 여러 서비스가 있습니다.

AWS ML 스택에는 XNUMX개의 계층이 있습니다. 중간층에는 세이지 메이커, 개발자, 데이터 과학자 및 ML 엔지니어에게 ML 모델을 대규모로 구축, 교육 및 배포할 수 있는 기능을 제공합니다. ML 사용 사례를 보다 쉽게 배포할 수 있도록 ML 워크플로의 각 단계에서 복잡성을 제거합니다. 여기에는 예측 유지 관리에서 고객 행동을 예측하기 위한 컴퓨터 비전에 이르기까지 모든 것이 포함됩니다. 고객은 SageMaker를 사용하여 데이터 과학자의 생산성을 최대 10배 향상시킵니다.

Apache Cassandra는 비정형 또는 반정형 데이터의 읽기 중심 사용 사례에 널리 사용됩니다. 예를 들어 인기 있는 음식 배달 비즈니스는 배달 시간을 예상하고 소매 고객은 Apache Cassandra 데이터베이스의 제품 카탈로그 정보를 자주 사용할 수 있습니다. 아마존 키스페이스 확장 가능하고 가용성이 높으며 관리되는 서버리스 Apache Cassandra 호환 데이터베이스 서비스입니다. 서버를 프로비저닝, 패치 또는 관리할 필요가 없으며 소프트웨어를 설치, 유지 관리 또는 운영할 필요가 없습니다. 테이블은 자동으로 확장 및 축소할 수 있으며 사용한 리소스에 대해서만 비용을 지불하면 됩니다. Amazon Keyspaces를 사용하면 현재 사용하는 것과 동일한 Cassandra 애플리케이션 코드 및 개발자 도구를 사용하여 AWS에서 Cassandra 워크로드를 실행할 수 있습니다.

SageMaker는 다음 제품군을 제공합니다. 내장 알고리즘 데이터 과학자와 ML 실무자가 ML 모델 교육 및 배포를 빠르게 시작할 수 있도록 지원합니다. 이 게시물에서는 소매 고객이 Keyspaces 데이터베이스의 고객 구매 내역을 사용하고 마케팅 캠페인을 위해 다양한 고객 세그먼트를 타겟팅하는 방법을 보여줍니다.

K- 평균 비지도 학습 알고리즘입니다. 데이터 내에서 그룹의 구성원이 서로 가능한 한 유사하고 다른 그룹의 구성원과 가능한 한 다른 개별 그룹을 찾으려고 시도합니다. 알고리즘이 유사성을 결정하는 데 사용할 속성을 정의합니다. SageMaker는 수정된 버전을 사용합니다. 웹 규모 k-평균 클러스터링 알고리즘. 알고리즘의 원래 버전과 비교할 때 SageMaker에서 사용하는 버전이 더 정확합니다. 그러나 원래 알고리즘과 마찬가지로 대규모 데이터 세트로 확장되고 훈련 시간이 향상됩니다.

솔루션 개요

지침에서는 SageMaker Studio를 사용하여 코드를 실행한다고 가정합니다. 연결된 코드가 다음에서 공유되었습니다. AWS 샘플 GitHub. 실습 지침에 따라 다음을 수행할 수 있습니다.

- 필요한 종속성을 설치합니다.

- Amazon Keyspaces에 연결하고 테이블을 생성하고 샘플 데이터를 수집합니다.

- Amazon Keyspaces의 데이터를 사용하여 분류 ML 모델을 구축합니다.

- 모델 결과를 탐색합니다.

- 새로 생성된 리소스를 정리합니다.

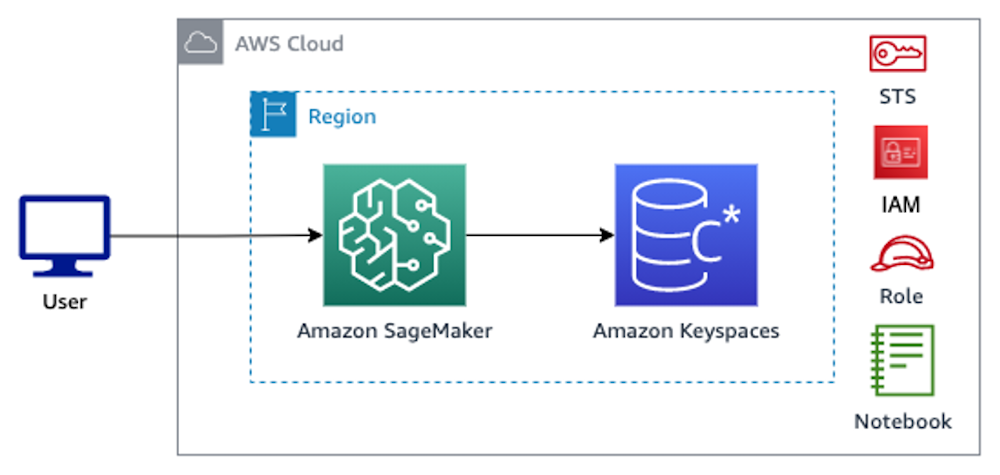

완료되면 다음 이미지와 같이 SageMaker를 Amazon Keyspaces와 통합하여 ML 모델을 교육할 수 있습니다.

이제 다음을 따를 수 있습니다. 단계별 지침 이 게시물에서는 SageMaker를 사용하여 Amazon Keyspaces에 저장된 원시 데이터와 ML 처리를 위해 검색된 데이터를 수집합니다.

사전 조건

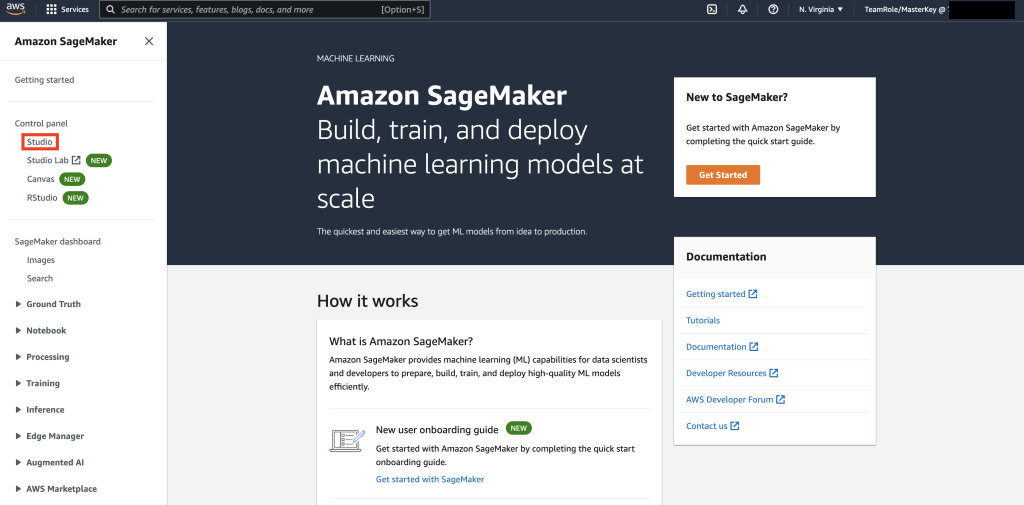

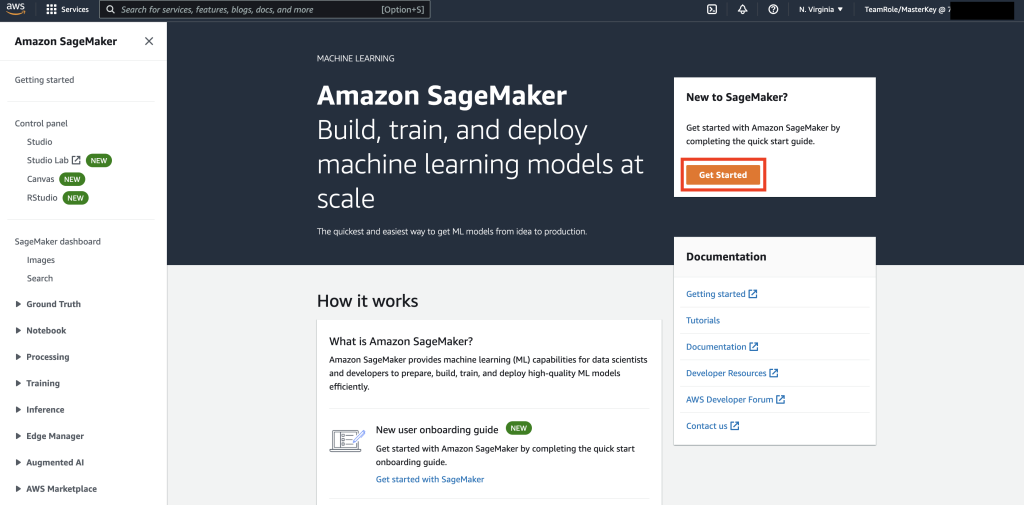

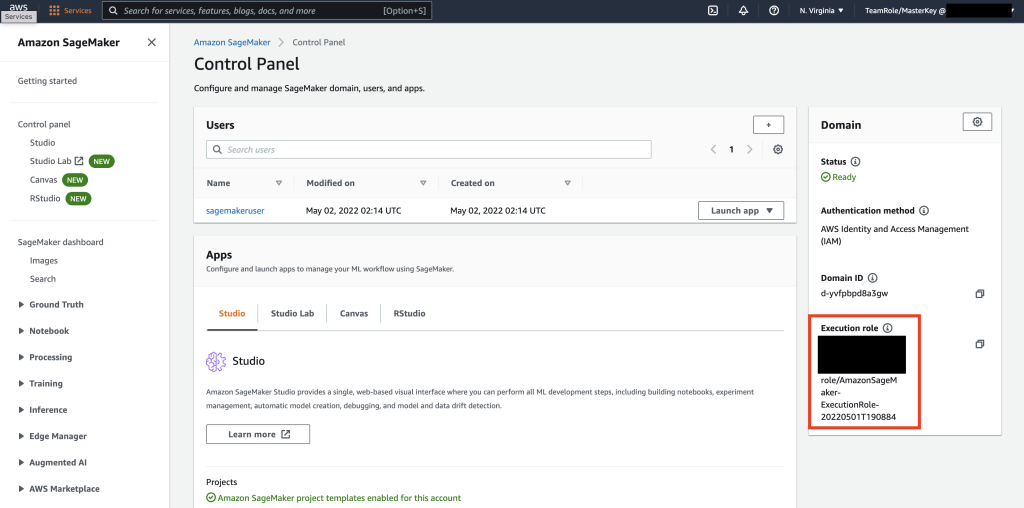

먼저 SageMaker로 이동합니다.

다음으로 SageMaker를 처음 사용하는 경우 다음을 선택합니다. 시작하기.

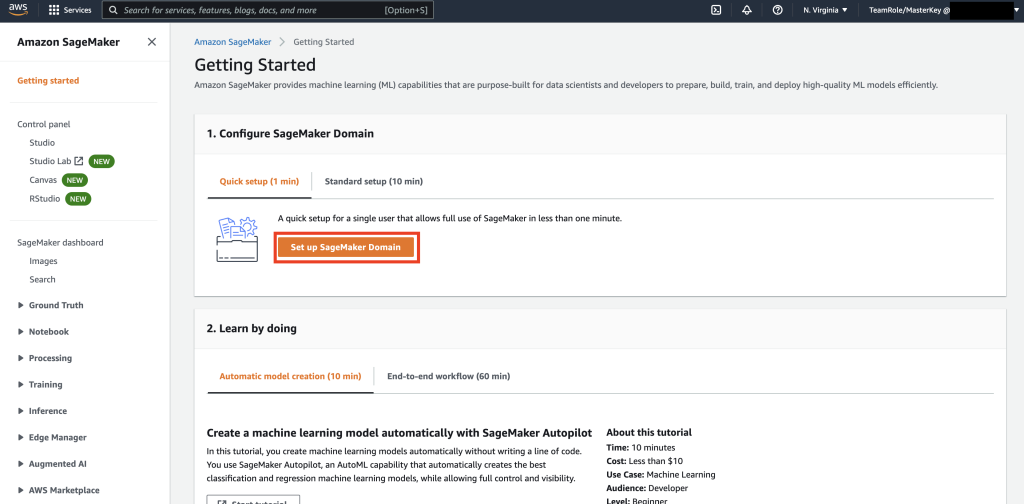

다음으로 SageMaker 도메인 설정.

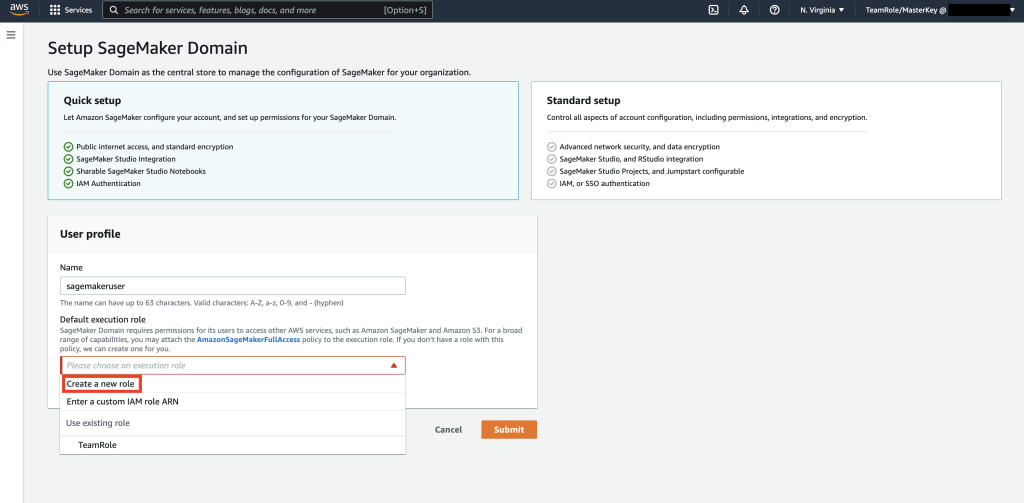

다음으로 Name으로 새 사용자 프로필을 만듭니다. 세이지메이커유저, 선택 새 역할 만들기 FBI 증오 범죄 보고서 기본 실행 역할 하위 섹션.

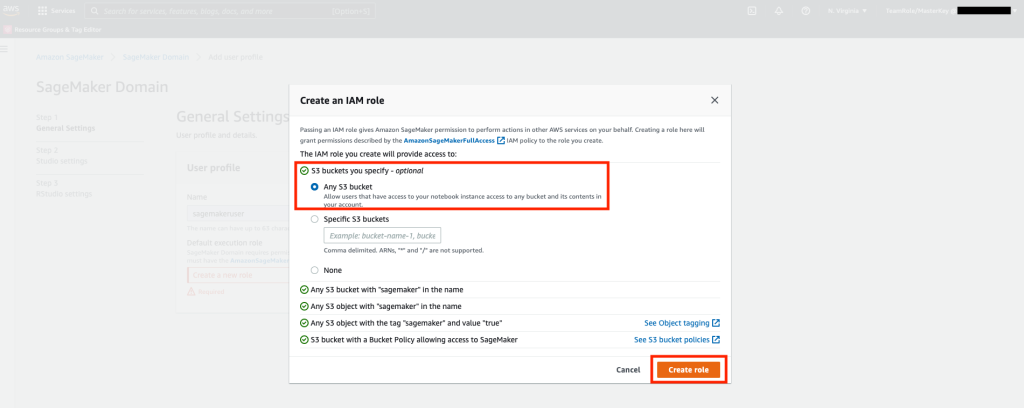

그런 다음 팝업 화면에서 아무거나 선택하십시오. Amazon Simple Storage Service(Amazon S3) 버킷을 선택하고 역할 생성을 선택합니다.

이 역할은 SageMaker가 역할의 임시 자격 증명을 사용하여 Keyspaces 테이블에 액세스할 수 있도록 다음 단계에서 사용됩니다. 이렇게 하면 노트북에 사용자 이름과 암호를 저장할 필요가 없습니다.

다음으로 다음과 연결된 역할을 검색합니다. 세이지메이커유저 요약 섹션의 이전 단계에서 생성되었습니다.

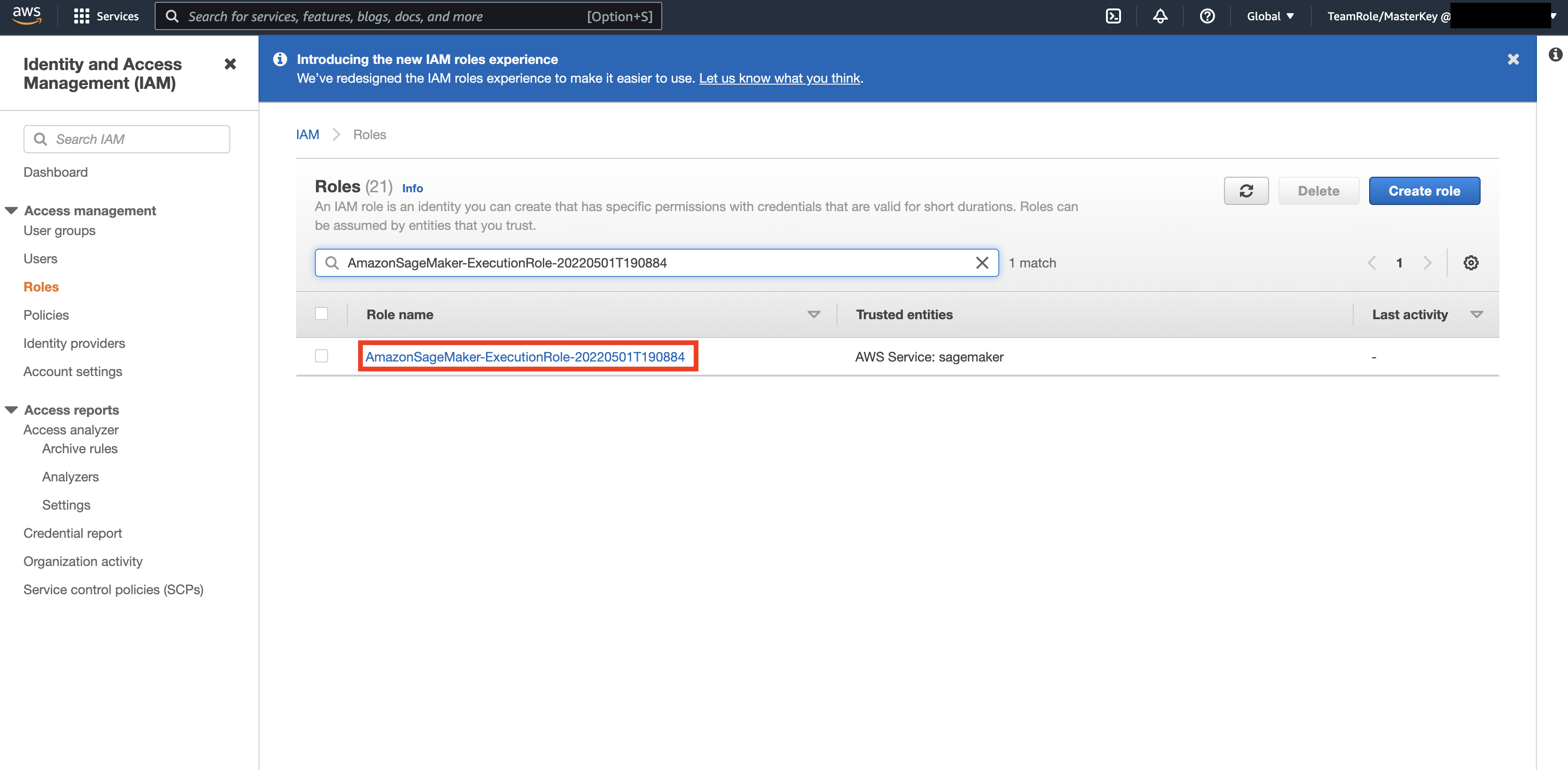

그런 다음 AWS Console 그리고 올려다봐 AWS ID 및 액세스 관리(IAM). IAM 내에서 역할로 이동합니다. 역할 내에서 이전 단계에서 식별된 실행 역할을 검색합니다.

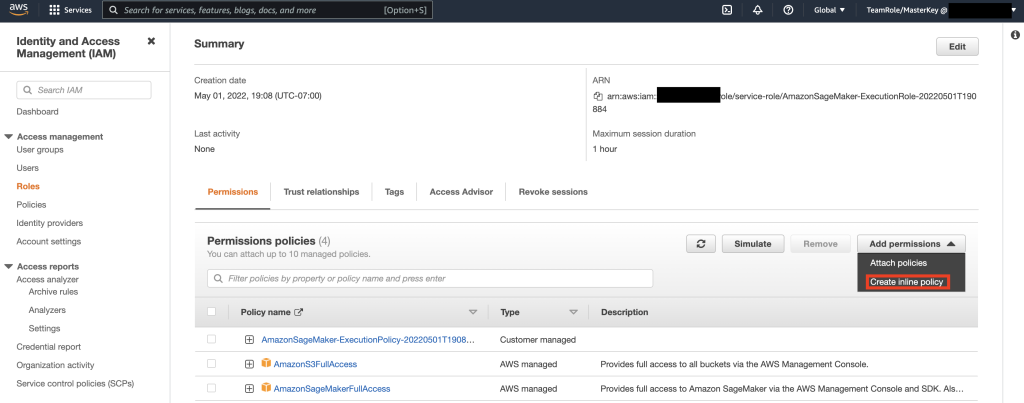

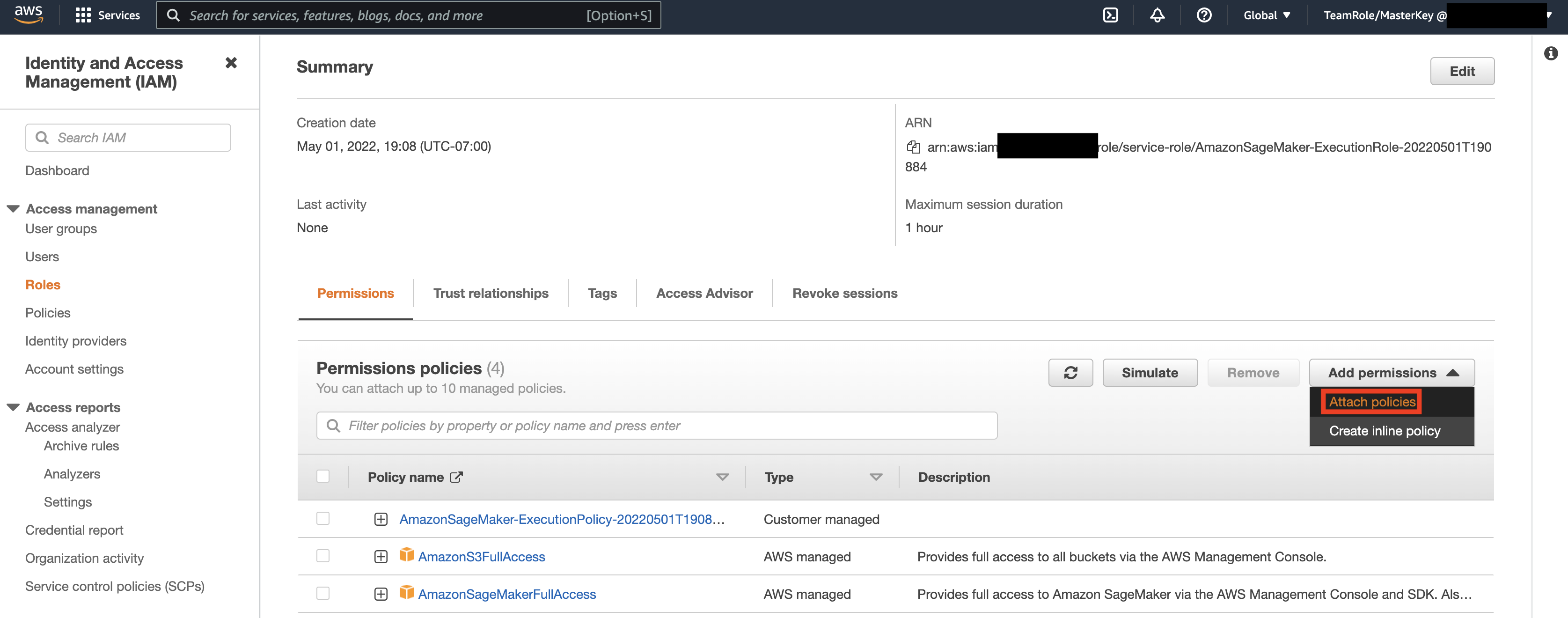

그런 다음 이전 단계에서 식별된 역할을 선택하고 권한 추가를 선택합니다. 표시되는 드롭다운에서 인라인 정책 생성을 선택합니다. SageMaker를 사용하면 비즈니스 요구 사항에 따라 사용자/응용 프로그램이 수행할 수 있는 작업을 제한하는 세분화된 수준의 액세스를 제공할 수 있습니다.

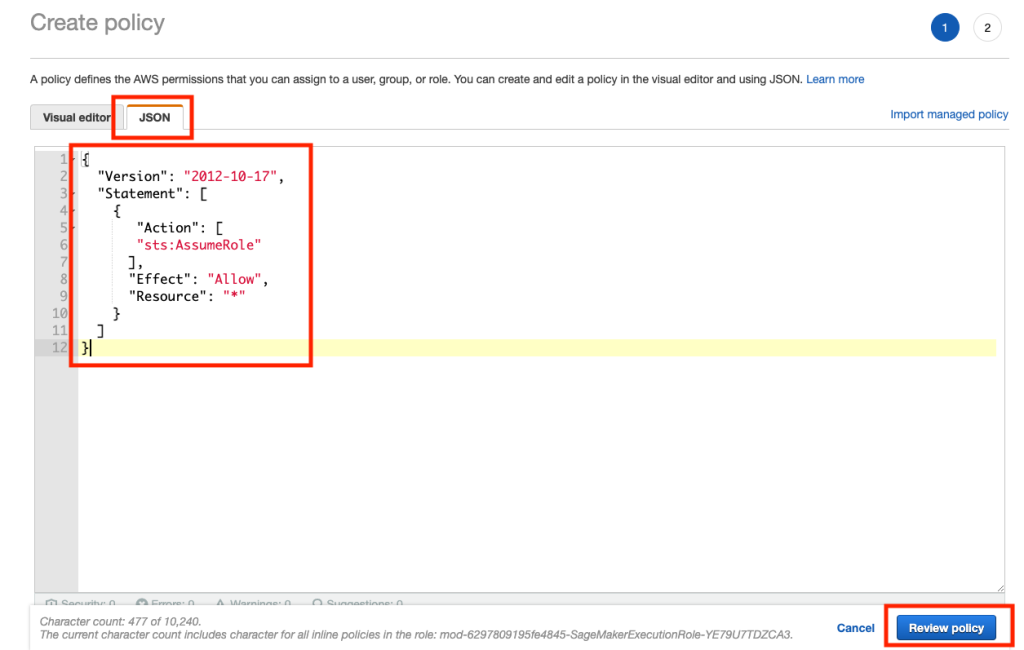

그런 다음 JSON 탭을 선택하고 Github의 참고 섹션에서 정책을 복사합니다. 페이지. 이 정책을 사용하면 SageMaker 노트북이 Keyspaces에 연결하고 추가 처리를 위해 데이터를 검색할 수 있습니다.

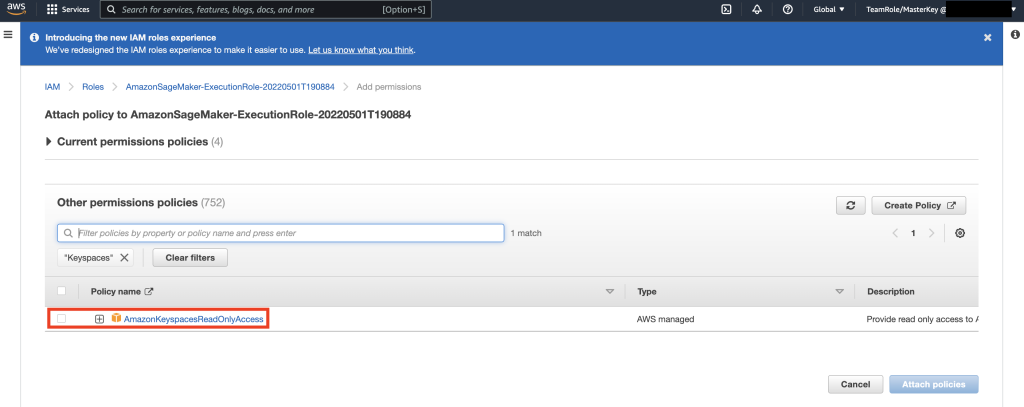

그런 다음 권한 추가를 다시 선택하고 드롭다운에서 정책 연결을 선택합니다.

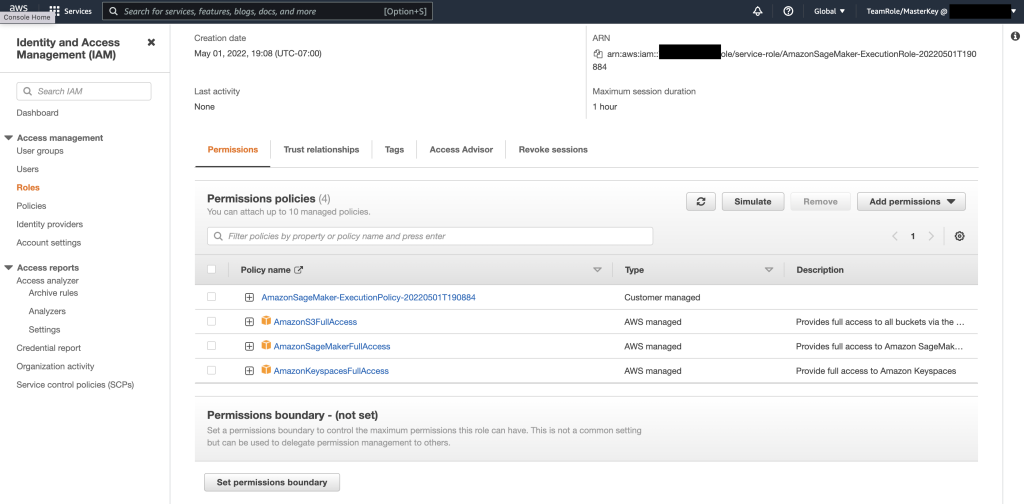

AmazonKeyspacesFullAccess 정책을 조회하고 일치하는 결과 옆의 확인란을 선택하고 정책 연결을 선택합니다.

권한 정책 섹션에 다음이 포함되어 있는지 확인하십시오. AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess, 새로 추가된 인라인 정책뿐 아니라.

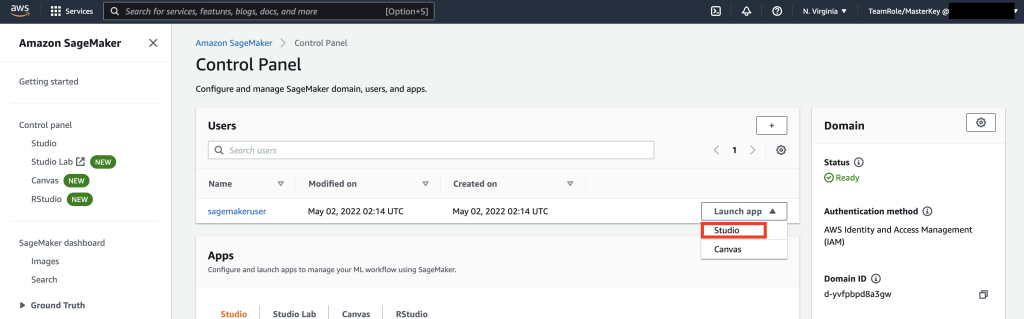

그런 다음 AWS 콘솔을 사용하여 SageMaker Studio로 이동하고 SageMaker Studio를 선택합니다. 일단 거기에서 앱 시작을 선택하고 스튜디오를 선택하십시오.

노트북 연습

SageMaker Notebook에서 Keyspaces에 연결하는 기본 방법은 다음을 사용하는 것입니다. AWS 서명 버전 4 프로세스(SigV4) 기반으로 임시 자격 증명 인증을 위해. 이 시나리오에서는 Keyspaces 자격 증명을 생성하거나 저장할 필요가 없으며 자격 증명을 사용하여 SigV4 플러그인으로 인증할 수 있습니다. 임시 보안 자격 증명은 액세스 키 ID와 보안 액세스 키로 구성됩니다. 그러나 여기에는 자격 증명이 만료되는 시기를 나타내는 보안 토큰도 포함됩니다. 이 게시물에서는 IAM 역할을 생성하고 임시 보안 자격 증명을 생성합니다.

먼저 드라이버(cassandra-sigv4)를 설치합니다. 이 드라이버를 사용하면 AWS 서명 버전 4 프로세스(SigV4)를 사용하여 API 요청에 인증 정보를 추가할 수 있습니다. 플러그인을 사용하면 IAM 사용자 및 역할을 사용하여 Amazon Keyspaces(Apache Cassandra용)에 액세스할 수 있는 단기 자격 증명을 사용자와 애플리케이션에 제공할 수 있습니다. 그런 다음 추가 패키지 종속성과 함께 필수 인증서를 가져옵니다. 결국 노트북이 Keyspaces와 통신하는 역할을 맡도록 허용합니다.

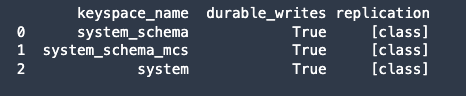

그런 다음 Amazon Keyspaces에 연결하고 Keyspaces에서 Pandas DataFrame으로 시스템 데이터를 읽어 연결을 확인합니다.

다음으로, 원시 데이터 세트에 대한 훈련을 위해 데이터를 준비합니다. 이 게시물과 연결된 python 노트북에서 다음에서 다운로드한 소매 데이터 세트를 사용합니다. 여기에서 지금 확인해 보세요., 처리합니다. 데이터 세트가 주어진 우리의 비즈니스 목표는 특정 메트릭 호출 RFM을 사용하여 고객을 클러스터링하는 것입니다. RFM 모델은 세 가지 정량적 요소를 기반으로 합니다.

- 최근성: 고객이 구매한지 얼마나 최근에.

- 빈도: 고객이 구매하는 빈도.

- 금전적 가치: 고객이 구매에 지출하는 금액.

RFM 분석은 일반적으로 1에서 5까지의 척도로 이 세 가지 범주 각각에서 고객의 순위를 매깁니다(숫자가 높을수록 더 나은 결과). "최고" 고객은 모든 범주에서 최고 점수를 받습니다. 우리는 pandas의 Quantile 기반 이산화 함수(qcut)를 사용할 것입니다. 샘플 분위수를 기반으로 하거나 기반으로 동일한 크기의 버킷으로 값을 이산화하는 데 도움이 됩니다.

이 예에서는 CQL을 사용하여 Keyspace 테이블에서 레코드를 읽습니다. 일부 ML 사용 사례에서는 동일한 Keyspaces 테이블에서 동일한 데이터를 여러 번 읽어야 할 수 있습니다. 이 경우 추가 비용이 발생하지 않도록 데이터를 Amazon S3 버킷에 저장하는 것이 좋습니다. 비용Amazon Keyspaces에서 읽기. 시나리오에 따라 다음을 사용할 수도 있습니다. 아마존 EMR 에 섭취 매우 큰 Amazon S3 파일을 SageMaker로 가져옵니다.

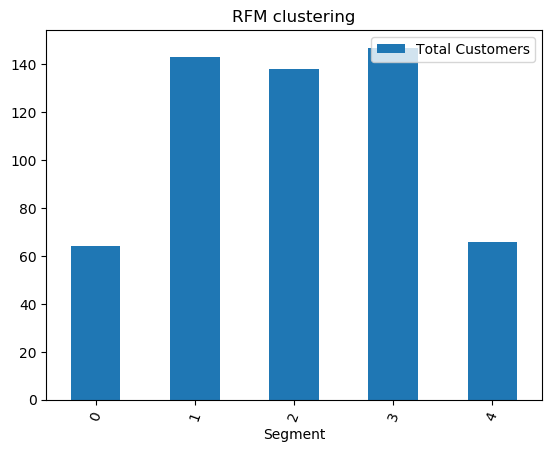

다음으로 KMeans 알고리즘을 사용하여 ML 모델을 학습하고 클러스터가 생성되었는지 확인합니다. 이 특정 시나리오에서는 생성된 클러스터가 인쇄되어 원시 데이터 세트의 고객이 데이터 세트의 다양한 속성을 기반으로 함께 그룹화되었음을 보여줍니다. 이 클러스터 정보는 타겟 마케팅 캠페인에 사용할 수 있습니다.

(선택 사항) 다음으로 ML 모델로 식별된 고객 세그먼트를 대상 마케팅을 위해 Amazon Keyspaces 테이블에 다시 저장합니다. 일괄 작업은 이 데이터를 읽고 특정 세그먼트의 고객에게 대상 캠페인을 실행할 수 있습니다.

마지막으로, 우리는 자원을 정리하다 추가 요금이 발생하지 않도록 이 자습서에서 생성되었습니다.

키스페이스 및 테이블 삭제를 완료하는 데 몇 초에서 몇 분이 소요될 수 있습니다. 키스페이스를 삭제하면 키스페이스와 해당 테이블이 모두 삭제되고 해당 테이블에 대한 요금 발생이 중지됩니다.

결론

이 게시물은 Amazon Keyspaces에서 SageMaker로 고객 데이터를 수집하고 고객을 세분화할 수 있는 클러스터링 모델을 훈련하는 방법을 보여주었습니다. 이 정보를 표적 마케팅에 사용할 수 있으므로 비즈니스 KPI를 크게 개선할 수 있습니다. Amazon Keyspaces에 대해 자세히 알아보려면 다음 리소스를 검토하십시오.

- Amazon Keyspaces를 데이터 원본으로 사용하여 기계 학습 모델 교육 (SageMaker 노트북)

- IntelliJ, PyCharm 또는 DataGrip IDE를 사용하여 데스크톱에서 Amazon Keyspaces에 연결

- Amazon 키스페이스용 CQL 언어 참조(Apache Cassandra용)

- 새로운 개발자 툴킷 Docker 이미지를 사용하여 Amazon Keyspaces(Apache Cassandra용)에 대한 명령줄 액세스를 설정하는 방법

- Amazon Keyspaces에 대한 자격 증명 및 액세스 관리(Apache Cassandra용)

- 다음을 사용하여 SageMaker에서 Amazon Keyspaces에 연결 서비스별 자격 증명

- 최근성, 빈도, 금전적 가치(RFM)

- Kaggle 코드 참조

저자에 관하여

바딤 랴코비치 San Francisco Bay Area에 있는 AWS의 수석 솔루션 설계자입니다. 그는 대기업에서 소규모 신생 기업에 이르기까지 다양한 조직과 협력하여 혁신을 지원하고 있습니다. 그는 또한 고객이 AWS에서 확장 가능하고 안전하며 비용 효율적인 솔루션을 설계하도록 돕고 있습니다.

바딤 랴코비치 San Francisco Bay Area에 있는 AWS의 수석 솔루션 설계자입니다. 그는 대기업에서 소규모 신생 기업에 이르기까지 다양한 조직과 협력하여 혁신을 지원하고 있습니다. 그는 또한 고객이 AWS에서 확장 가능하고 안전하며 비용 효율적인 솔루션을 설계하도록 돕고 있습니다.

파스 파텔 샌프란시스코 베이 지역에 있는 AWS의 솔루션 아키텍트입니다. Parth는 고객이 클라우드로의 여정을 가속화하고 AWS 클라우드를 성공적으로 채택할 수 있도록 안내합니다. 그는 ML 및 애플리케이션 현대화에 중점을 둡니다.

파스 파텔 샌프란시스코 베이 지역에 있는 AWS의 솔루션 아키텍트입니다. Parth는 고객이 클라우드로의 여정을 가속화하고 AWS 클라우드를 성공적으로 채택할 수 있도록 안내합니다. 그는 ML 및 애플리케이션 현대화에 중점을 둡니다.

램 파탕이 샌프란시스코 베이 지역에 있는 AWS의 솔루션 아키텍트입니다. 그는 농업, 보험, 은행, 소매, 의료 및 생명 과학, 숙박, 하이테크 업종의 고객이 AWS 클라우드에서 성공적으로 비즈니스를 운영할 수 있도록 도왔습니다. 그는 데이터베이스, 분석 및 ML을 전문으로 합니다.

램 파탕이 샌프란시스코 베이 지역에 있는 AWS의 솔루션 아키텍트입니다. 그는 농업, 보험, 은행, 소매, 의료 및 생명 과학, 숙박, 하이테크 업종의 고객이 AWS 클라우드에서 성공적으로 비즈니스를 운영할 수 있도록 도왔습니다. 그는 데이터베이스, 분석 및 ML을 전문으로 합니다.

- '

- "

- &

- 10

- 100

- 9

- 능력

- 소개

- 가속

- ACCESS

- 정확한

- 달성

- 행위

- 추가

- 농업

- 앞으로

- 연산

- All

- 아마존

- 분석

- 분석

- 다른

- API를

- API

- 앱

- 어플리케이션

- 어플리케이션

- 지역

- 주의

- 속성

- 인증

- 자동적으로

- 가능

- AWS

- 은행

- 만

- 블로그

- 경계

- 빌드

- 사업

- 사업

- 전화

- 캠페인

- 한

- 가지 경우

- 범주

- 증명서

- 요금

- 선택

- 분류

- 클라우드

- 암호

- 비교

- 컴퓨터

- 연결하기

- 연결

- 콘솔에서

- 비용 효율적인

- 수

- 국가

- 만들

- 만든

- 신임장

- 고객

- 고객

- 데이터

- 데이터 세트

- 데이터베이스

- 데이터베이스

- 제공

- 배달

- 의존

- 배포

- 배치

- 바탕 화면

- 결정

- 개발자

- 개발자

- 다른

- 도커

- 아래 (down)

- 운전사

- 드롭

- ...동안

- 용이하게

- 엔지니어

- 기업

- 장비

- 견적

- 예

- 실행

- 요인

- 먼저,

- 처음으로

- 함대

- 집중

- 따라

- 수행원

- 식품

- 시스코

- 기능

- 추가

- 일반적으로

- 생성

- 점점

- GitHub의

- 매우

- 그룹

- 여러 떼

- 안내서

- 건강

- 건강

- 도움

- 도움이

- 높은

- 더 높은

- 고도로

- history

- 방법

- How To

- 그러나

- HTTPS

- 통합 인증

- 영상

- 구현

- 개량

- 개선

- 포함

- 포함

- 색인

- 산업

- 정보

- 인프라

- 혁신

- 설치

- 보험

- 통합 된

- IT

- 일

- 여행

- 키

- 실험실

- 언어

- 넓은

- 시작

- 층

- 배우다

- 배우기

- 레벨

- 생명과학

- 링크드인

- 보기

- 충성스러운

- 기계

- 기계 학습

- 만든

- 유지하다

- 제작

- 관리

- 관리

- 구축

- 관리

- 마케팅

- 거대한

- 어울리는

- 회원

- ML

- 모델

- 모델

- 화폐

- 돈

- 모니터링

- 배우기

- 가장

- 여러

- 필요한

- 수첩

- 번호

- 운영

- 최적화

- 조직

- 기타

- 꾸러미

- 특별한

- 비밀번호

- 패치

- 지불

- 플러그인

- 정책

- 정책

- 인기 문서

- 가능한

- 가능성

- 예측

- Prepare

- 너무 이른

- 가격

- 일차

- 방법

- 프로세스

- 처리

- 프로덕트

- 생산력

- 프로필

- 장래가 촉망되는

- 제공

- 제공

- 매수

- 구매

- 정량적 인

- 빨리

- 이르기까지

- 살갗이 벗어 진

- 읽기

- 받다

- 최근에

- 권하다

- 기록

- 요청

- 필수

- 요구조건 니즈

- 자료

- 결과

- 소매

- 리뷰

- 위험

- 직위별

- 길

- 달리기

- 산

- 샌프란시스코

- SC

- 확장성

- 규모

- 과학

- 과학자

- 화면

- 검색

- 초

- 안전해야합니다.

- 보안

- 보안 토큰

- 분절

- 분할

- 세그먼트

- 서버리스

- 서비스

- 서비스

- 세트

- 공유

- 단기간의

- 표시

- 비슷한

- 단순, 간단, 편리

- 잠

- 작은

- So

- 소프트웨어

- 고체

- 솔루션

- 일부

- 전문적으로

- 스택

- 시작

- 신생

- 저장

- 저장

- 스튜디오

- 성공적으로

- SUPPORT

- 체계

- 시스템은

- 이야기

- 목표

- 대상

- 일시적인

- XNUMXD덴탈의

- 을 통하여

- 시간

- 시대

- 오늘

- 함께

- 토큰

- 툴킷

- 검색을

- 상단

- 교환

- 트레이닝

- 사용

- 사용 사례

- 사용자

- 가치

- 여러

- 버전

- 업종

- 시력

- 뭐

- 이내

- 없이

- 일하는

- 겠지

- 너의