Veel applicaties die bedoeld zijn voor het onderhoud van industriële apparatuur, handelsbewaking, wagenparkbeheer en route-optimalisatie zijn gebouwd met behulp van open-source Cassandra API's en stuurprogramma's om gegevens met hoge snelheden en lage latentie te verwerken. Zelf Cassandra-tafels beheren kan tijdrovend en duur zijn. Amazon Keyspaces (voor Apache Cassandra) laat je Cassandra-tabellen instellen, beveiligen en schalen in de AWS Cloud zonder extra infrastructuur te beheren.

In dit bericht leiden we je door AWS-services met betrekking tot het trainen van modellen voor machine learning (ML) met behulp van Amazon Keyspaces op een hoog niveau, en geven we stapsgewijze instructies voor het opnemen van gegevens van Amazon Keyspaces in Amazon Sage Maker en het trainen van een model dat kan worden gebruikt voor een specifieke use case voor klantsegmentatie.

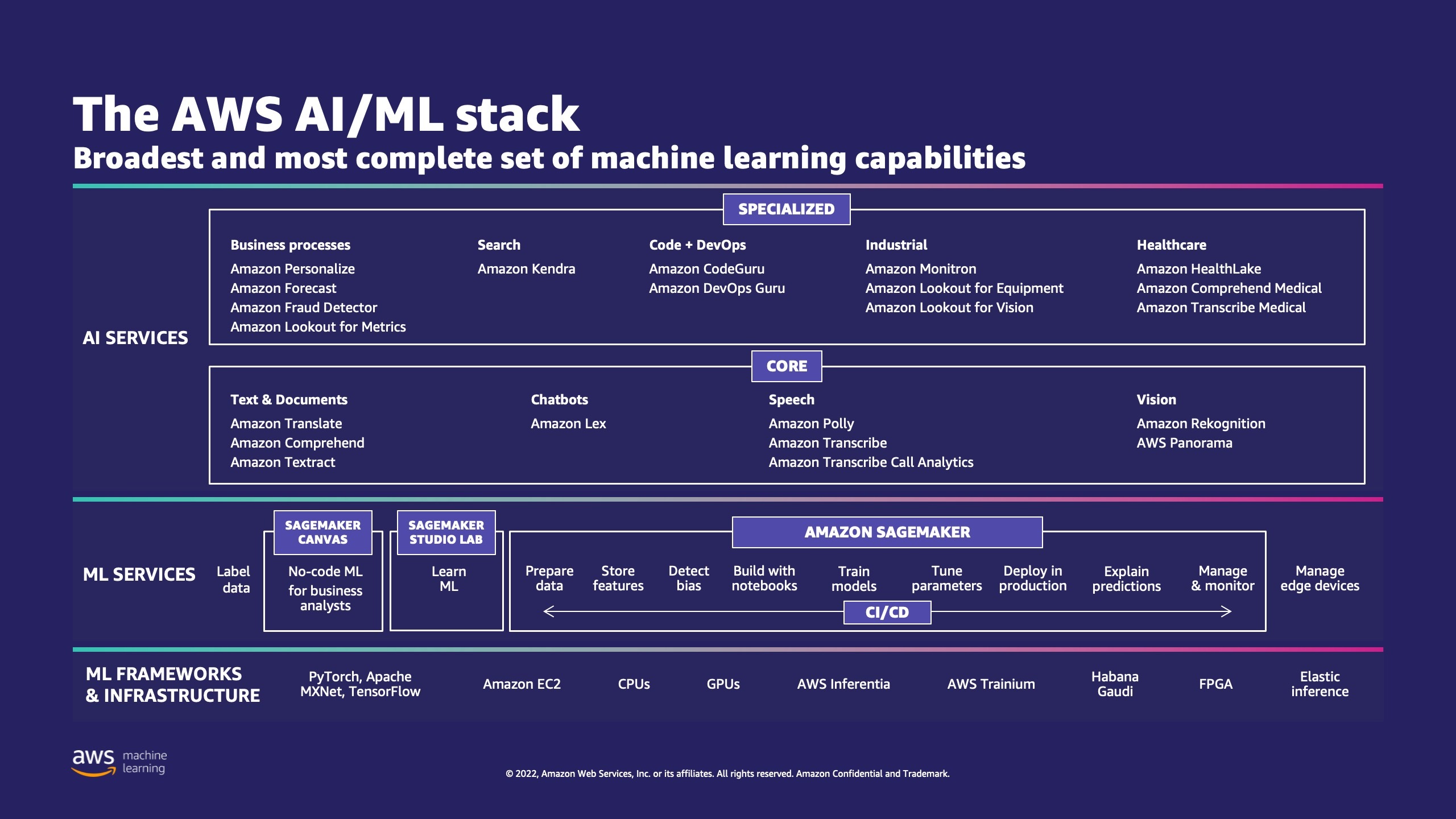

AWS heeft meerdere services om bedrijven te helpen bij het implementeren van ML-processen in de cloud.

AWS ML Stack heeft drie lagen. In de middelste laag is SageMaker, waarmee ontwikkelaars, datawetenschappers en ML-engineers ML-modellen op schaal kunnen bouwen, trainen en implementeren. Het verwijdert de complexiteit van elke stap van de ML-workflow, zodat u uw ML-use-cases gemakkelijker kunt implementeren. Dit omvat alles van voorspellend onderhoud tot computervisie om klantgedrag te voorspellen. Klanten bereiken met SageMaker een tot 10 keer hogere productiviteit van datawetenschappers.

Apache Cassandra is een populaire keuze voor leesintensieve use-cases met ongestructureerde of semi-gestructureerde gegevens. Een populair bedrijf voor voedselbezorging schat bijvoorbeeld de bezorgtijd en een retailklant kan vaak volharden in het gebruik van productcatalogusinformatie in de Apache Cassandra-database. Amazon-sleutelruimten is een schaalbare, zeer beschikbare en beheerde serverloze met Apache Cassandra compatibele databaseservice. U hoeft geen servers in te richten, te patchen of te beheren, en u hoeft geen software te installeren, onderhouden of gebruiken. Tabellen kunnen automatisch omhoog en omlaag worden geschaald en u betaalt alleen voor de resources die u gebruikt. Met Amazon Keyspaces kunt u uw Cassandra-workloads op AWS uitvoeren met dezelfde Cassandra-toepassingscode en ontwikkelaarstools die u vandaag de dag gebruikt.

SageMaker biedt een suite van ingebouwde algoritmen om datawetenschappers en ML-beoefenaars te helpen snel aan de slag te gaan met het trainen en implementeren van ML-modellen. In dit bericht laten we u zien hoe een retailklant de aankoopgeschiedenis van klanten in de Keyspaces-database kan gebruiken en verschillende klantsegmenten kan targeten voor marketingcampagnes.

K-betekent is een niet-gesuperviseerd leeralgoritme. Het probeert discrete groeperingen binnen gegevens te vinden, waarbij leden van een groep zo veel mogelijk op elkaar lijken en zo veel mogelijk verschillen van leden van andere groepen. U definieert de kenmerken die u door het algoritme wilt laten gebruiken om de overeenkomst te bepalen. SageMaker gebruikt een aangepaste versie van de web-schaal k-betekent clustering algoritme. In vergelijking met de originele versie van het algoritme is de versie die door SageMaker wordt gebruikt nauwkeuriger. Net als het originele algoritme schaalt het echter naar enorme datasets en levert het verbeteringen in de trainingstijd op.

Overzicht oplossingen

De instructies gaan ervan uit dat u SageMaker Studio zou gebruiken om de code uit te voeren. De bijbehorende code is gedeeld op AWS-voorbeeld GitHub. Door de instructies in het lab te volgen, kunt u het volgende doen:

- Installeer de nodige afhankelijkheden.

- Maak verbinding met Amazon Keyspaces, maak een tabel en neem voorbeeldgegevens op.

- Bouw een classificatie-ML-model met behulp van de gegevens in Amazon Keyspaces.

- Modelresultaten verkennen.

- Ruim nieuw gemaakte bronnen op.

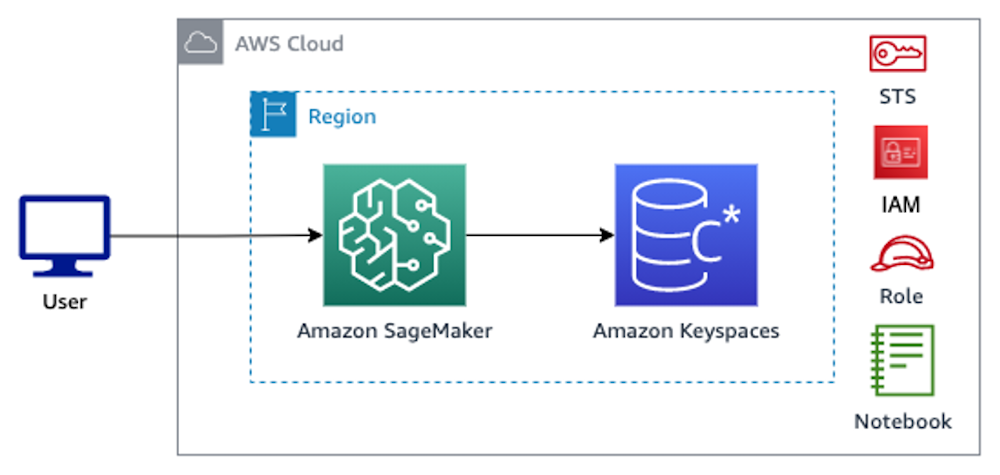

Eenmaal voltooid, heb je SageMaker geïntegreerd met Amazon Keyspaces om ML-modellen te trainen, zoals weergegeven in de volgende afbeelding.

Nu kun je de volgen stapsgewijze instructies in dit bericht om onbewerkte gegevens op te nemen die zijn opgeslagen in Amazon Keyspaces met behulp van SageMaker en de gegevens die zo zijn opgehaald voor ML-verwerking.

Voorwaarden

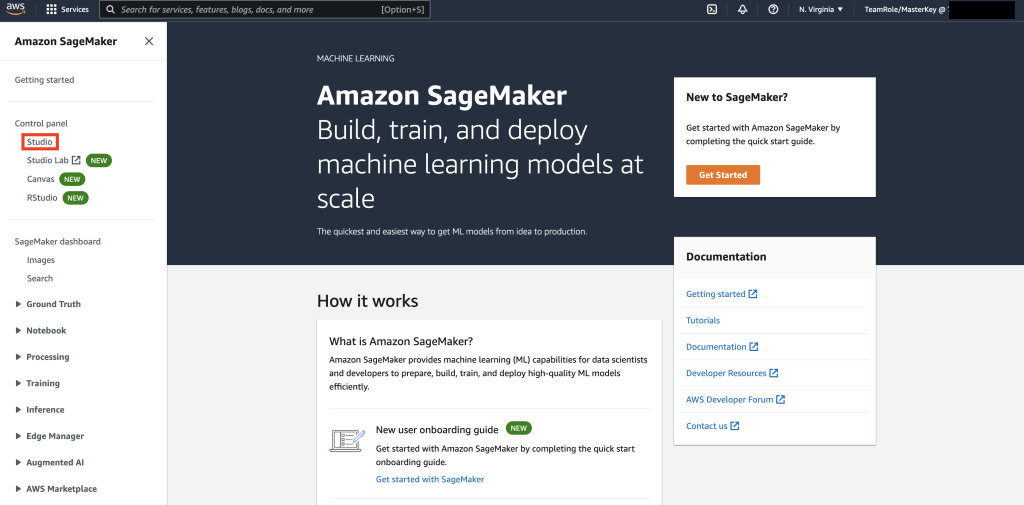

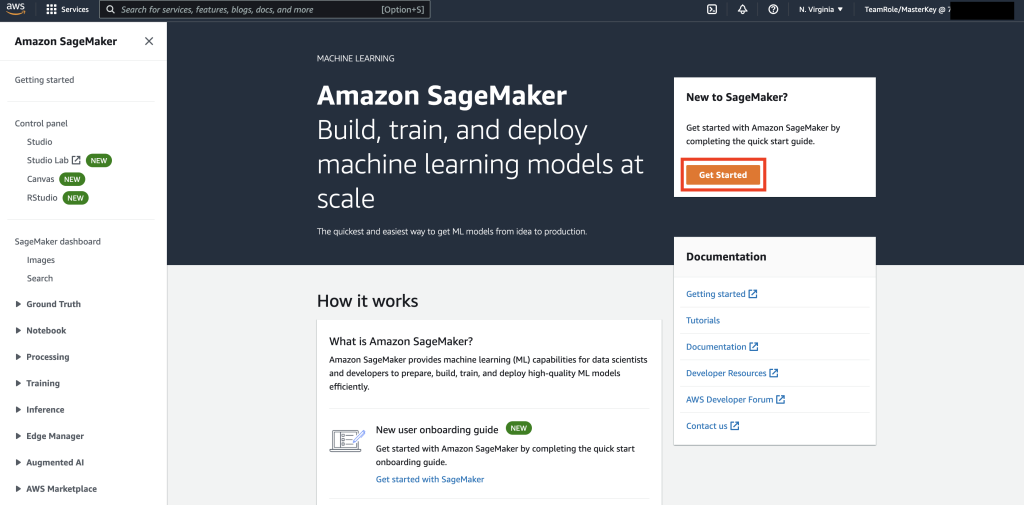

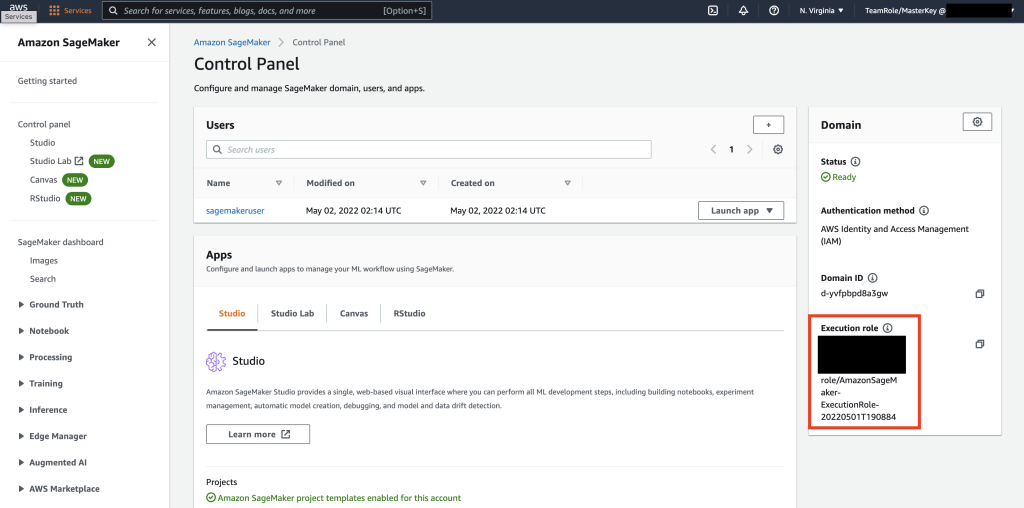

Navigeer eerst naar SageMaker.

Als dit de eerste keer is dat u SageMaker gebruikt, selecteert u Start nu.

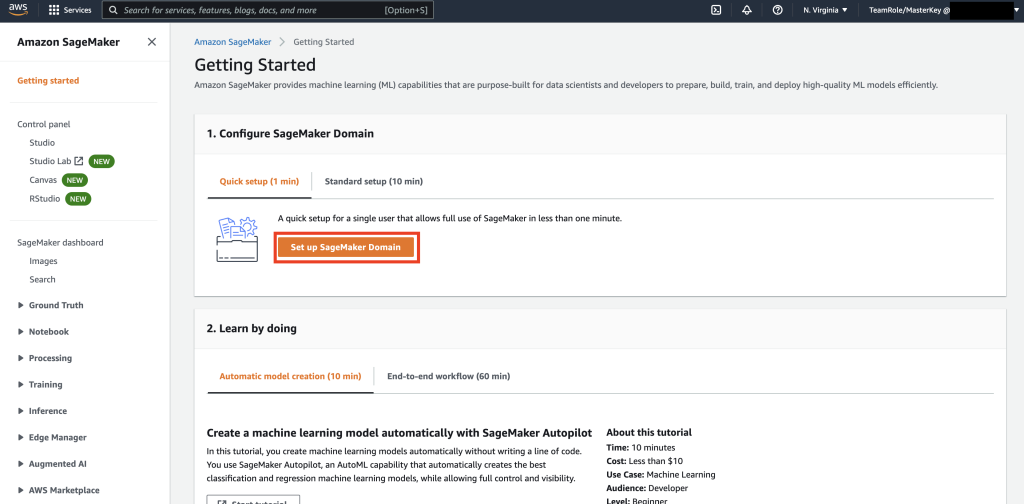

Selecteer vervolgens SageMaker-domein instellen.

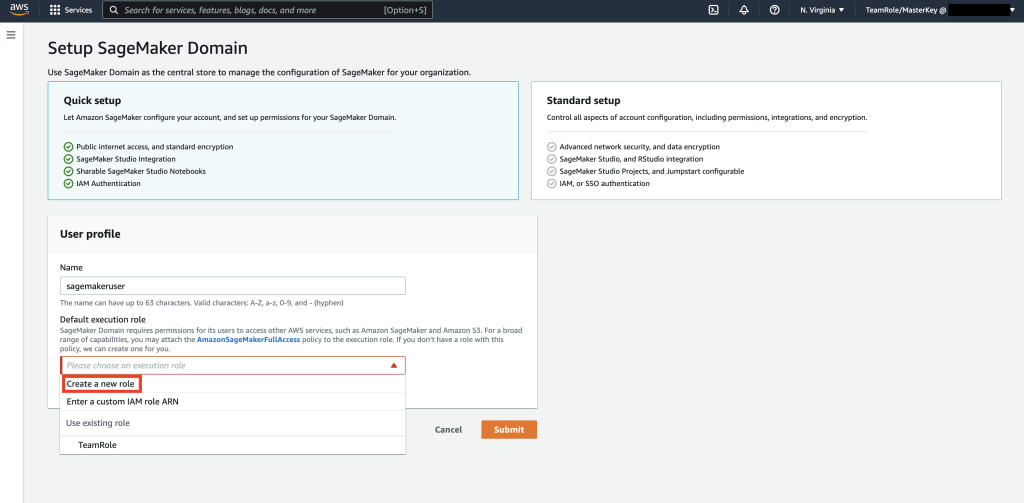

Maak vervolgens een nieuw gebruikersprofiel aan met Naam – sagemakergebruikerEn Select Maak een nieuwe rol in de Standaard uitvoeringsrol onderafdeling.

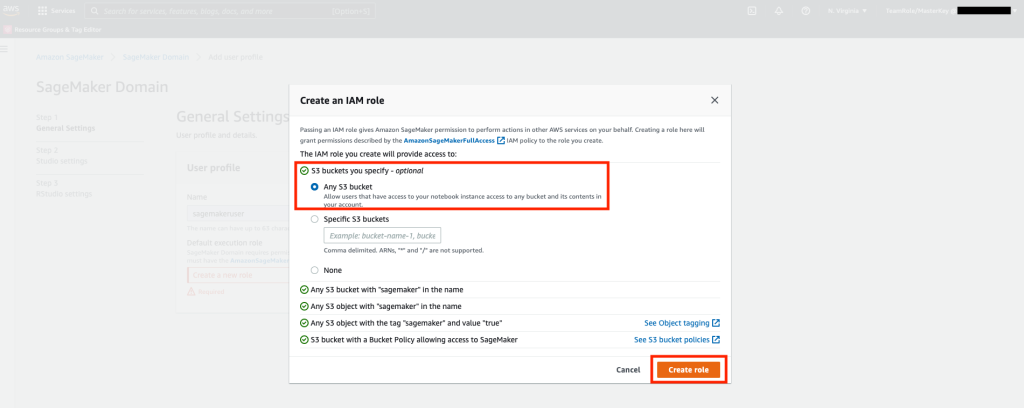

Selecteer vervolgens in het scherm dat verschijnt, willekeurig Eenvoudige opslagservice van Amazon (Amazon S3) bucket en selecteer Rol maken.

Deze rol wordt in de volgende stappen gebruikt om SageMaker toegang te geven tot Keyspaces Table met tijdelijke referenties van de rol. Dit elimineert de noodzaak om een gebruikersnaam en wachtwoord op te slaan in de notebook.

Haal vervolgens de rol op die is gekoppeld aan de sagemakergebruiker die in de vorige stap is gemaakt vanuit de samenvattingssectie.

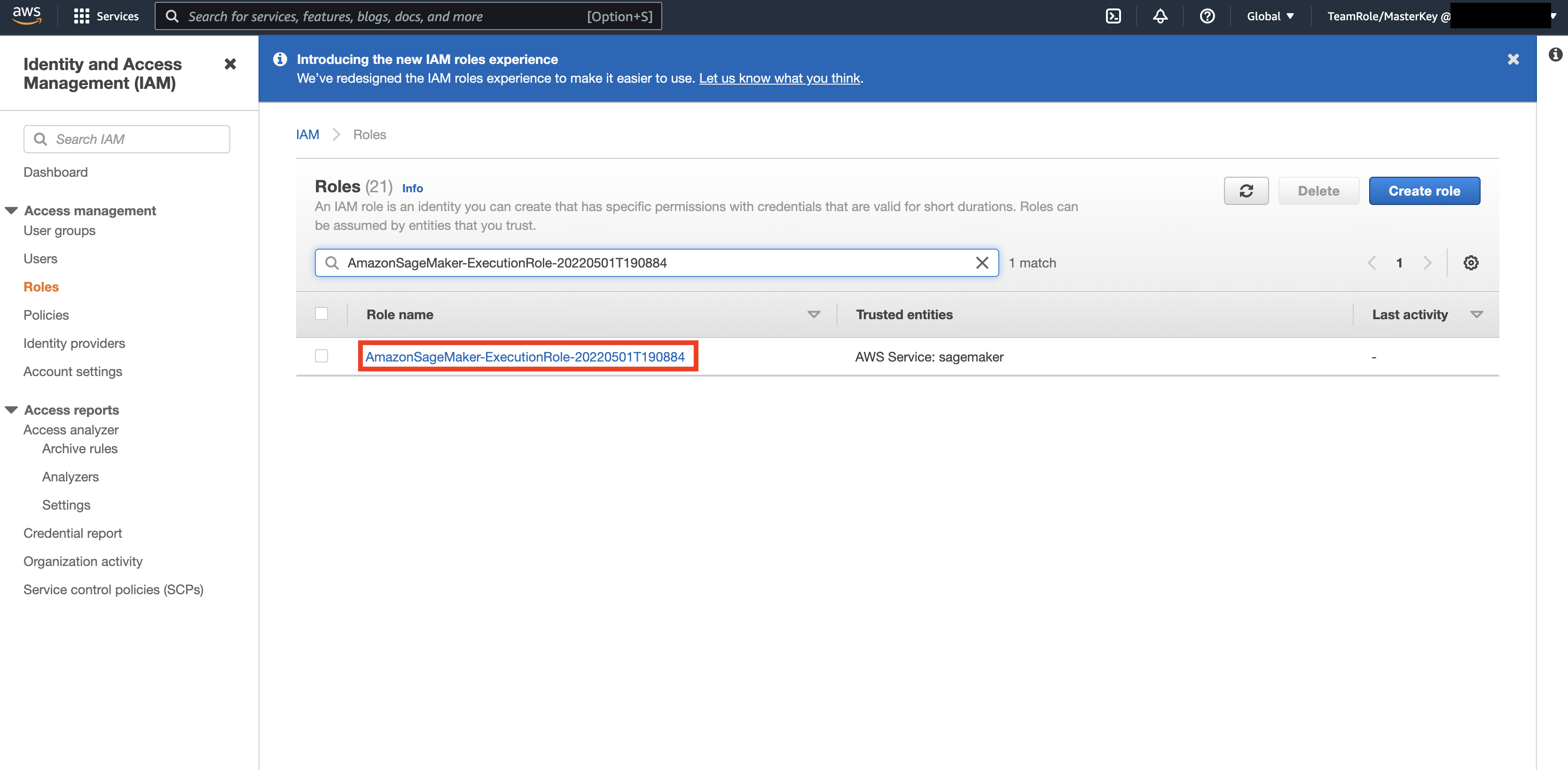

Navigeer vervolgens naar de AWS-console en kijk omhoog AWS identiteits- en toegangsbeheer (IAM). Navigeer binnen IAM naar Rollen. Zoek binnen Rollen naar de uitvoeringsrol die in de vorige stap is geïdentificeerd.

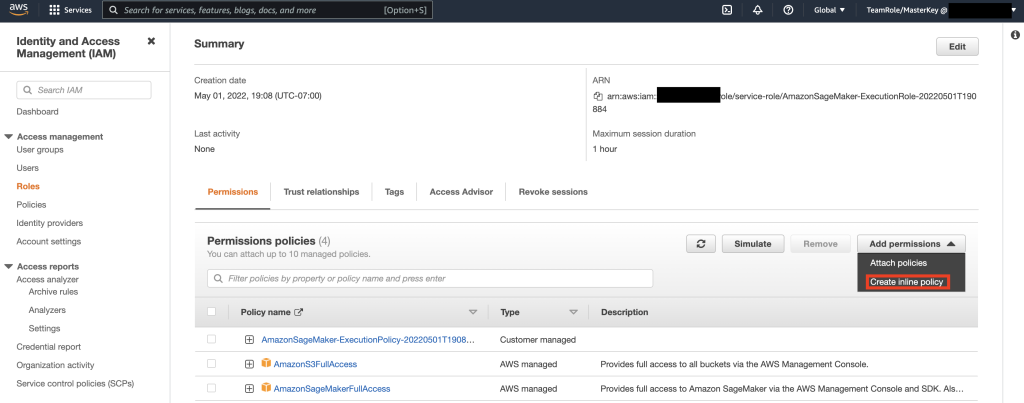

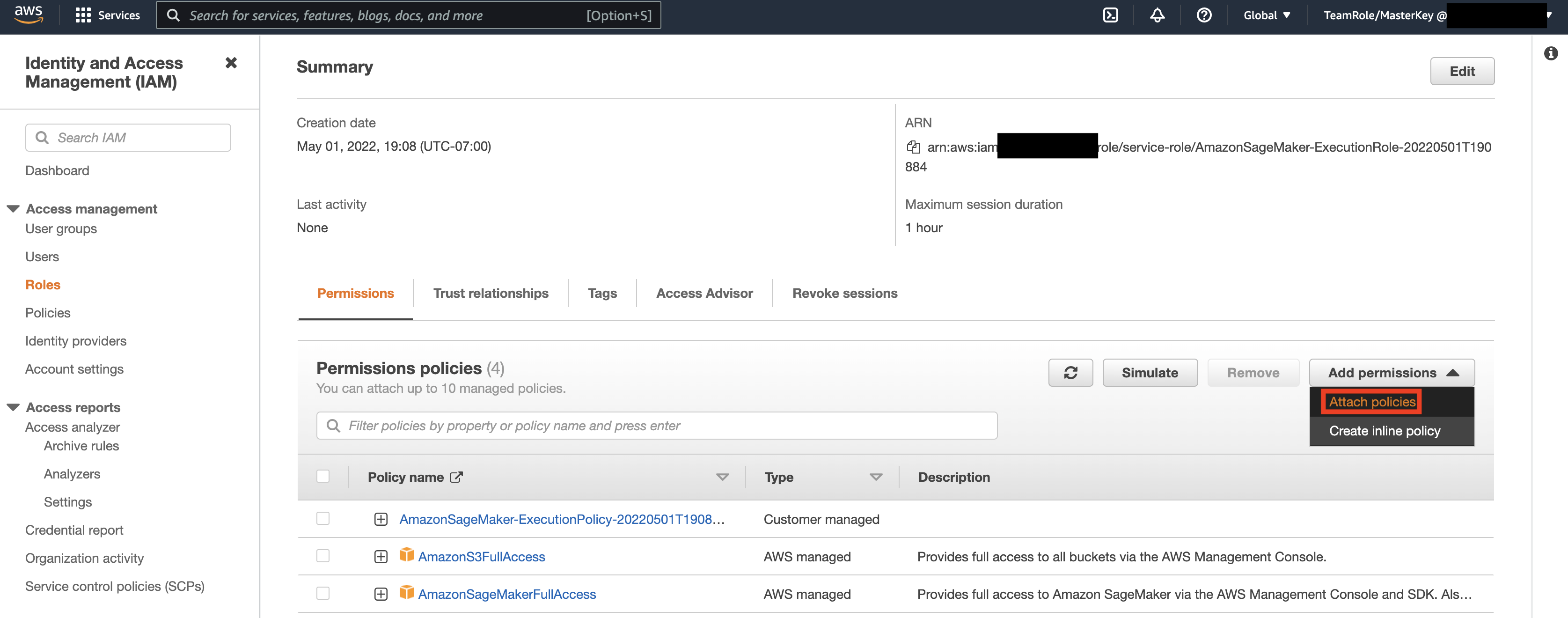

Selecteer vervolgens de rol die in de vorige stap is geïdentificeerd en selecteer Machtigingen toevoegen. Selecteer in de vervolgkeuzelijst die verschijnt Inline-beleid maken. Met SageMaker kunt u een gedetailleerd toegangsniveau bieden dat beperkt welke acties een gebruiker/toepassing kan uitvoeren op basis van zakelijke vereisten.

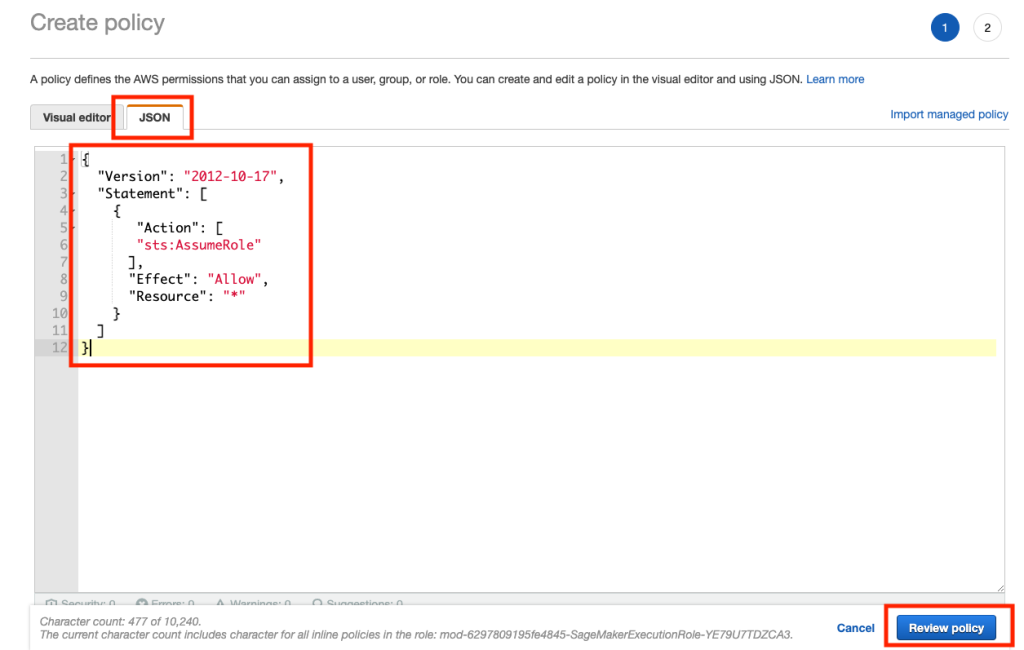

Selecteer vervolgens het JSON-tabblad en kopieer het beleid uit het gedeelte Opmerking van Github pagina. Met dit beleid kan de SageMaker-notebook verbinding maken met Keyspaces en gegevens ophalen voor verdere verwerking.

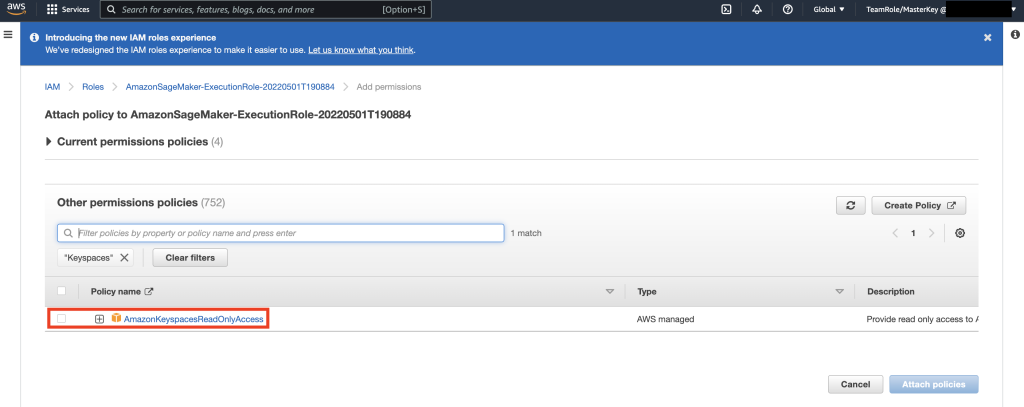

Selecteer vervolgens opnieuw machtigingen toevoegen en in de vervolgkeuzelijst en selecteer Beleid bijvoegen.

Zoek het AmazonKeyspacesFullAccess-beleid op, schakel het selectievakje naast het overeenkomende resultaat in en selecteer Beleid bijvoegen.

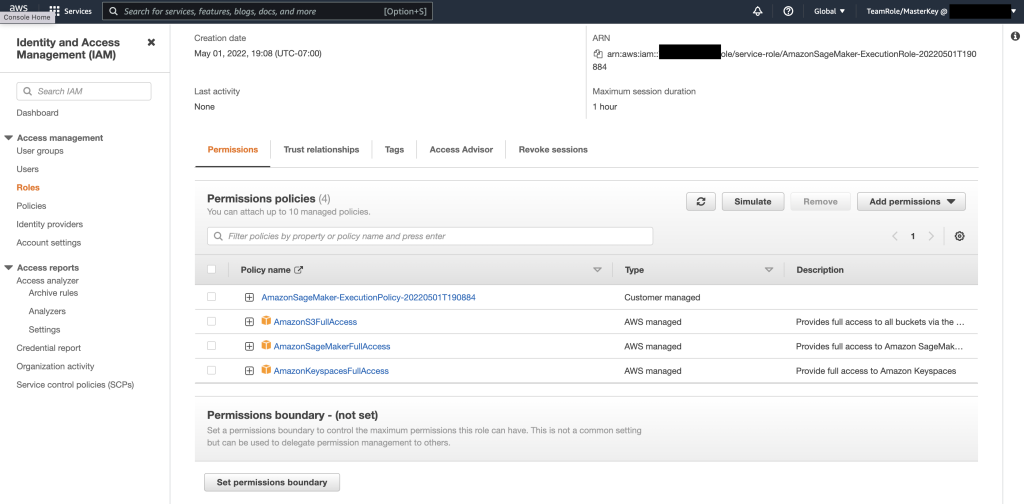

Controleer of de sectie machtigingenbeleid bevat: AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess, evenals het nieuw toegevoegde inline-beleid.

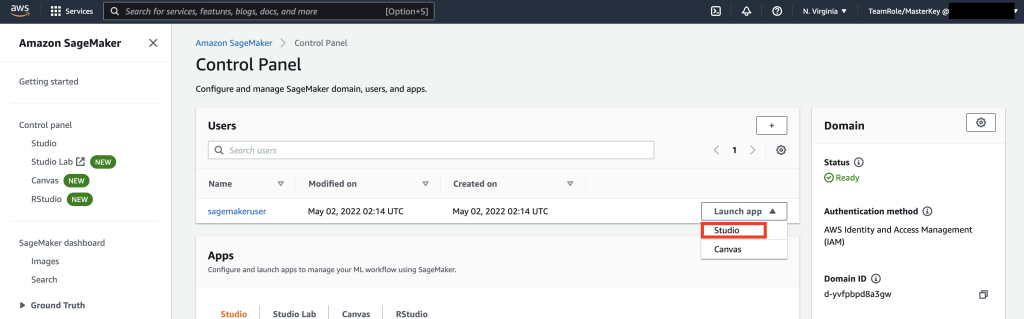

Navigeer vervolgens naar SageMaker Studio met behulp van de AWS-console en selecteer SageMaker Studio. Eenmaal daar, selecteer App starten en selecteer Studio.

Overzicht van notebooks

De beste manier om verbinding te maken met Keyspaces vanuit SageMaker Notebook is door gebruik te maken van: AWS Signature Versie 4-proces (SigV4) gebaseerde Tijdelijke referenties voor authenticatie. In dit scenario hoeven we GEEN Keyspaces-referenties te genereren of op te slaan en kunnen we de referenties gebruiken om te verifiëren met de SigV4-plug-in. Tijdelijke beveiligingsreferenties bestaan uit een toegangssleutel-ID en een geheime toegangssleutel. Ze bevatten echter ook een beveiligingstoken dat aangeeft wanneer de referenties verlopen. In dit bericht maken we een IAM-rol en genereren we tijdelijke beveiligingsreferenties.

Eerst installeren we een stuurprogramma (cassandra-sigv4). Met dit stuurprogramma kunt u authenticatie-informatie toevoegen aan uw API-verzoeken met behulp van het AWS Signature Version 4-proces (SigV4). Met behulp van de plug-in kunt u gebruikers en applicaties voorzien van inloggegevens voor de korte termijn om toegang te krijgen tot Amazon Keyspaces (voor Apache Cassandra) met behulp van IAM-gebruikers en -rollen. Hierna importeert u een vereist certificaat samen met aanvullende pakketafhankelijkheden. Uiteindelijk laat je de notebook de rol op zich nemen om met Keyspaces te praten.

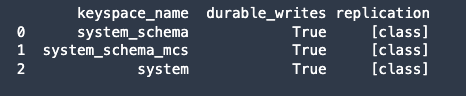

Maak vervolgens verbinding met Amazon Keyspaces en lees systeemgegevens van Keyspaces in Pandas DataFrame om de verbinding te valideren.

Bereid vervolgens de gegevens voor op training op de onbewerkte dataset. Gebruik in het python-notebook dat aan dit bericht is gekoppeld een winkelgegevensset die is gedownload van hier, en verwerken. Ons bedrijfsdoel gezien de dataset is om de klanten te clusteren met behulp van een specifieke metrische oproep RFM. Het RFM-model is gebaseerd op drie kwantitatieve factoren:

- Recentheid: hoe recent een klant een aankoop heeft gedaan.

- Frequentie: hoe vaak een klant een aankoop doet.

- Monetaire waarde: hoeveel geld een klant uitgeeft aan aankopen.

RFM-analyse rangschikt een klant numeriek in elk van deze drie categorieën, meestal op een schaal van 1 tot 5 (hoe hoger het getal, hoe beter het resultaat). De "beste" klant zou in elke categorie een topscore krijgen. We gebruiken de op Quantile gebaseerde discretisatiefunctie (qcut) van panda's. Het helpt om waarden te discretiseren in emmers van gelijke grootte op basis van of op basis van voorbeeldkwantielen.

In dit voorbeeld gebruiken we CQL om records uit de Keyspace-tabel te lezen. In sommige ML-gebruiksgevallen moet u mogelijk dezelfde gegevens meerdere keren uit dezelfde Keyspaces-tabel lezen. In dit geval raden we u aan uw gegevens op te slaan in een Amazon S3-bucket om extra kosten te voorkomen kostens lezen van Amazon Keyspaces. Afhankelijk van uw scenario, kunt u ook gebruik maken van Amazon EMR naar inslikken een zeer groot Amazon S3-bestand in SageMaker.

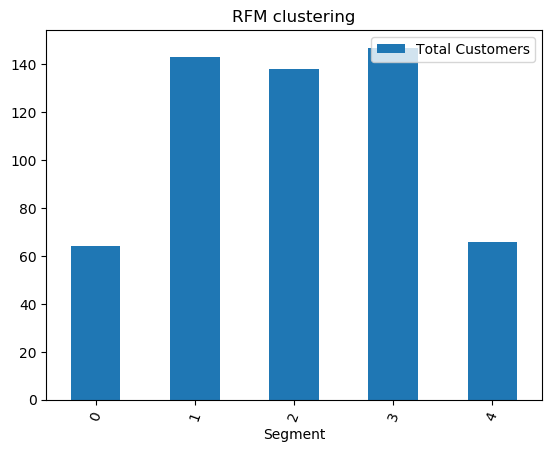

Vervolgens trainen we een ML-model met behulp van het KMeans-algoritme en zorgen we ervoor dat de clusters worden gemaakt. In dit specifieke scenario zou je zien dat de gemaakte clusters worden afgedrukt, wat aangeeft dat de klanten in de onbewerkte dataset zijn gegroepeerd op basis van verschillende attributen in de dataset. Deze clusterinformatie kan worden gebruikt voor gerichte marketingcampagnes.

(Optioneel) Vervolgens slaan we de klantsegmenten die zijn geïdentificeerd door het ML-model terug naar een Amazon Keyspaces-tabel voor gerichte marketing. Een batchtaak zou deze gegevens kunnen lezen en gerichte campagnes kunnen voeren naar klanten in specifieke segmenten.

Eindelijk, wij ruim de middelen op gemaakt tijdens deze zelfstudie om extra kosten te voorkomen.

Het kan enkele seconden tot een minuut duren om het verwijderen van keyspace en tabellen te voltooien. Wanneer u een sleutelruimte verwijdert, worden de sleutelruimte en alle tabellen verwijderd en worden er geen kosten meer aan verbonden.

Conclusie

Dit bericht liet je zien hoe je klantgegevens van Amazon Keyspaces in SageMaker kunt opnemen en een clustermodel kunt trainen waarmee je klanten kunt segmenteren. U kunt deze informatie gebruiken voor gerichte marketing, waardoor uw bedrijfs-KPI aanzienlijk verbetert. Raadpleeg de volgende bronnen voor meer informatie over Amazon Keyspaces:

- Machine learning-modellen trainen met Amazon Keyspaces als gegevensbron (SageMaker-notitieboekje)

- Maak verbinding met Amazon Keyspaces vanaf uw bureaublad met behulp van IntelliJ, PyCharm of DataGrip IDE's

- CQL-taalreferentie voor Amazon Keyspaces (voor Apache Cassandra)

- Hoe u de opdrachtregeltoegang tot Amazon Keyspaces (voor Apache Cassandra) instelt met behulp van de nieuwe Docker-image van de ontwikkelaarstoolkit

- Identiteits- en toegangsbeheer voor Amazon Keyspaces (voor Apache Cassandra)

- Verbinding maken met Amazon Keyspaces vanuit SageMaker met servicespecifieke referenties

- Recentheid, frequentie, geldwaarde (RFM)

- Kaggle-codereferentie

Over de auteurs

Vadim Lyakhovitsj is Senior Solutions Architect bij AWS in de San Francisco Bay Area en helpt klanten bij de migratie naar AWS. Hij werkt samen met organisaties variërend van grote ondernemingen tot kleine startups om hun innovaties te ondersteunen. Hij helpt klanten ook bij het ontwerpen van schaalbare, veilige en kosteneffectieve oplossingen op AWS.

Vadim Lyakhovitsj is Senior Solutions Architect bij AWS in de San Francisco Bay Area en helpt klanten bij de migratie naar AWS. Hij werkt samen met organisaties variërend van grote ondernemingen tot kleine startups om hun innovaties te ondersteunen. Hij helpt klanten ook bij het ontwerpen van schaalbare, veilige en kosteneffectieve oplossingen op AWS.

Deel Patel is Solutions Architect bij AWS in de San Francisco Bay Area. Parth begeleidt klanten om hun reis naar de cloud te versnellen en hen te helpen met het succesvol adopteren van AWS-cloud. Hij richt zich op ML en Applicatie Modernisering.

Deel Patel is Solutions Architect bij AWS in de San Francisco Bay Area. Parth begeleidt klanten om hun reis naar de cloud te versnellen en hen te helpen met het succesvol adopteren van AWS-cloud. Hij richt zich op ML en Applicatie Modernisering.

Ram Pathangi is Solutions Architect bij AWS in de San Francisco Bay Area. Hij heeft klanten in de sectoren landbouw, verzekeringen, bankwezen, detailhandel, gezondheidszorg en levenswetenschappen, gastvrijheid en hi-tech geholpen om hun bedrijf succesvol te runnen op de AWS-cloud. Hij is gespecialiseerd in Databases, Analytics en ML.

Ram Pathangi is Solutions Architect bij AWS in de San Francisco Bay Area. Hij heeft klanten in de sectoren landbouw, verzekeringen, bankwezen, detailhandel, gezondheidszorg en levenswetenschappen, gastvrijheid en hi-tech geholpen om hun bedrijf succesvol te runnen op de AWS-cloud. Hij is gespecialiseerd in Databases, Analytics en ML.

- Coinsmart. Europa's beste Bitcoin- en crypto-uitwisseling.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. GRATIS TOEGANG.

- CryptoHawk. Altcoin-radar. Gratis proefversie.

- Bron: https://aws.amazon.com/blogs/machine-learning/train-machine-learning-models-using-amazon-keyspaces-as-a-data-source/

- '

- "

- &

- 10

- 100

- 9

- vermogen

- Over

- versnellen

- toegang

- accuraat

- Bereiken

- acties

- Extra

- landbouw

- vooruit

- algoritme

- Alles

- Amazone

- analyse

- analytics

- Nog een

- api

- APIs

- gebruiken

- Aanvraag

- toepassingen

- GEBIED

- aandacht

- attributen

- authenticatie

- webmaster.

- Beschikbaar

- AWS

- Bankieren

- Baai

- Blog

- grens

- bouw

- bedrijfsdeskundigen

- ondernemingen

- Bellen

- Campagnes

- verzorging

- gevallen

- Categorie

- certificaat

- lasten

- keuze

- classificatie

- Cloud

- code

- vergeleken

- computer

- Verbinden

- versterken

- troosten

- kostenefficient

- kon

- Land

- en je merk te creëren

- aangemaakt

- Geloofsbrieven

- klant

- Klanten

- gegevens

- gegevensset

- Database

- databanken

- levert

- levering

- Afhankelijk

- implementeren

- het inzetten

- desktop

- Bepalen

- Ontwikkelaar

- ontwikkelaars

- anders

- havenarbeider

- beneden

- bestuurder

- Val

- gedurende

- gemakkelijk

- Ingenieurs

- bedrijven

- uitrusting

- schattingen

- voorbeeld

- uitvoering

- factoren

- Voornaam*

- eerste keer

- VLOOT

- richt

- volgen

- volgend

- eten

- Francisco

- functie

- verder

- algemeen

- voortbrengen

- het krijgen van

- GitHub

- sterk

- Groep

- Groep

- Guides

- Gezondheid

- Gezondheidszorg

- hulp

- het helpen van

- Hoge

- hoger

- zeer

- geschiedenis

- Hoe

- How To

- Echter

- HTTPS

- Identiteit

- beeld

- uitvoeren

- verbetering

- het verbeteren van

- omvatten

- omvat

- index

- industrieel

- informatie

- Infrastructuur

- innovaties

- installeren

- verzekering

- geïntegreerde

- IT

- Jobomschrijving:

- sleutel

- laboratorium

- taal

- Groot

- lancering

- lagen

- LEARN

- leren

- Niveau

- Bio

- Kijk

- loyaal

- machine

- machine learning

- gemaakt

- onderhouden

- MERKEN

- beheer

- beheerd

- management

- beheren

- Marketing

- massief

- matching

- Leden

- ML

- model

- modellen

- monetair

- geld

- Grensverkeer

- meer

- meest

- meervoudig

- noodzakelijk

- notitieboekje

- aantal

- besturen

- optimalisatie

- organisaties

- Overige

- pakket

- bijzonder

- Wachtwoord

- Patch

- Betaal

- inpluggen

- beleidsmaatregelen door te lezen.

- beleidsmaatregelen

- Populair

- mogelijk

- potentieel

- voorspellen

- Voorbereiden

- vorig

- prijs

- primair

- processen

- verwerking

- Product

- produktiviteit

- Profiel

- veelbelovend

- zorgen voor

- biedt

- inkomsten

- aankopen

- kwantitatief

- snel

- variërend

- Rauw

- lezing

- ontvangen

- onlangs

- adviseren

- archief

- verzoeken

- nodig

- Voorwaarden

- Resources

- Resultaten

- <HR>Retail

- beoordelen

- Risico

- Rol

- weg

- lopen

- heilige

- San Francisco

- SC

- schaalbare

- Scale

- WETENSCHAPPEN

- wetenschappers

- scherm

- Ontdek

- seconden

- beveiligen

- veiligheid

- beveiligingstoken

- segment

- segmentatie

- segmenten

- Serverless

- service

- Diensten

- reeks

- gedeeld

- korte termijn

- getoond

- gelijk

- Eenvoudig

- slaap

- Klein

- So

- Software

- solide

- Oplossingen

- sommige

- specialiseert

- stack

- gestart

- Startups

- mediaopslag

- shop

- studio

- Met goed gevolg

- ondersteuning

- system

- Systems

- Talk

- doelwit

- doelgerichte

- tijdelijk

- De

- Door

- niet de tijd of

- keer

- vandaag

- samen

- teken

- toolkit

- tools

- top

- handel

- Trainingen

- .

- gebruiksgevallen

- gebruikers

- waarde

- divers

- versie

- verticals

- visie

- Wat

- binnen

- zonder

- werkzaam

- zou

- Your