Amazon SalieMaker Gegevensbeheerder is een op de gebruikersinterface gebaseerde tool voor gegevensvoorbereiding die helpt bij het uitvoeren van gegevensanalyse, voorverwerking en visualisatie met functies om gegevens sneller op te schonen, te transformeren en voor te bereiden. De vooraf gebouwde stroomsjablonen van Data Wrangler helpen gegevensvoorbereiding sneller te maken voor gegevenswetenschappers en machine learning (ML)-beoefenaars door u te helpen bij het versnellen en begrijpen van best practice-patronen voor gegevensstromen met behulp van gemeenschappelijke gegevenssets.

U kunt Data Wrangler-stromen gebruiken om de volgende taken uit te voeren:

- Data visualisatie – Het onderzoeken van statistische eigenschappen voor elke kolom in de dataset, het bouwen van histogrammen, het bestuderen van uitbijters

- Gegevens opschonen – Verwijderen van duplicaten, laten vallen of vullen van items met ontbrekende waarden, verwijderen van uitschieters

- Gegevensverrijking en feature-engineering – Kolommen verwerken om meer expressieve functies te bouwen, een subset van functies selecteren voor training

Dit bericht zal u helpen Data Wrangler te begrijpen met behulp van de volgende voorbeeld vooraf gebouwde stromen op: GitHub. De repository toont gegevenstransformatie in tabelvorm, tijdreeksgegevenstransformaties en samengevoegde gegevenssettransformaties. Elk vereist een ander type transformaties vanwege hun fundamentele aard. Standaardgegevens in tabelvorm of dwarsdoorsnede worden verzameld op een specifiek tijdstip. Tijdreeksgegevens worden daarentegen herhaaldelijk in de loop van de tijd vastgelegd, waarbij elk volgend gegevenspunt afhankelijk is van de waarden uit het verleden.

Laten we eens kijken naar een voorbeeld van hoe we de voorbeeldgegevensstroom kunnen gebruiken voor tabelgegevens.

Voorwaarden

Data Wrangler is een Amazon Sage Maker functie beschikbaar binnen Amazon SageMaker Studio, dus we moeten het Studio-onboardingproces volgen om de Studio-omgeving en notebooks te laten draaien. Hoewel u kunt kiezen uit een aantal authenticatiemethoden, is de eenvoudigste manier om een Studio-domein te maken het volgen van de Snelle start instructies. De Snelstart gebruikt dezelfde standaardinstellingen als de standaard Studio-opstelling. U kunt er ook voor kiezen om aan boord te gaan met AWS IAM Identiteitscentrum (opvolger van AWS Single Sign-On) voor authenticatie (zie Aan boord van Amazon SageMaker Domain met IAM Identity Center).

Importeer de dataset en stroombestanden in Data Wrangler met Studio

In de volgende stappen wordt beschreven hoe u gegevens in SageMaker importeert om door Data Wrangler te worden gebruikt:

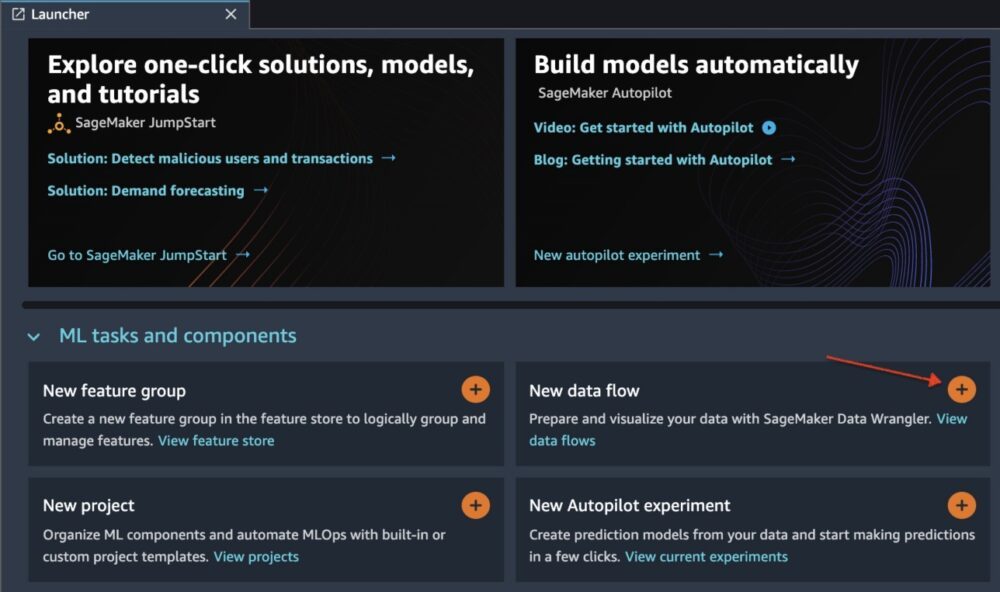

Initialiseer Data Wrangler via de Studio UI door te kiezen voor Nieuwe datastroom.

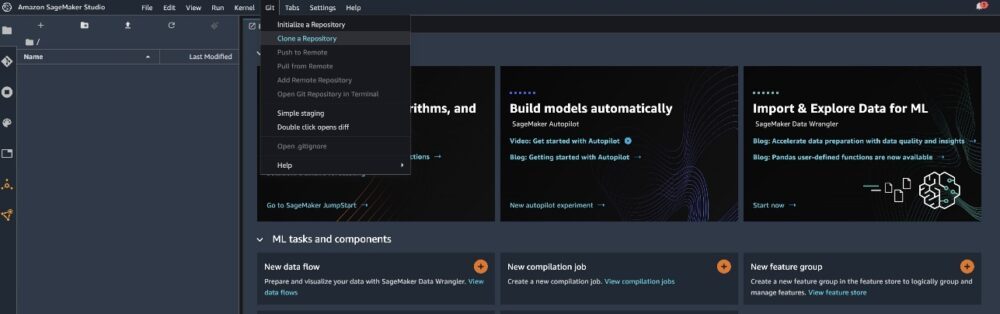

Kloon het GitHub repo om de stroombestanden naar uw Studio-omgeving te downloaden.

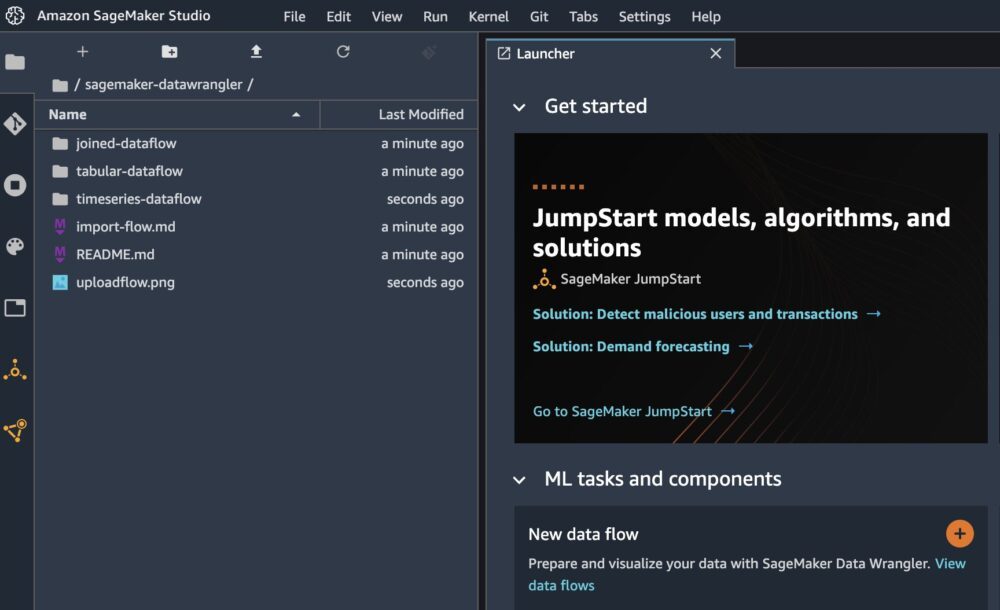

Wanneer de kloon is voltooid, zou u de inhoud van de repository in het linkerdeelvenster moeten kunnen zien.

Kies het bestand Hotel-boekingen-classificatie.flow om het stroombestand in Data Wrangler te importeren.

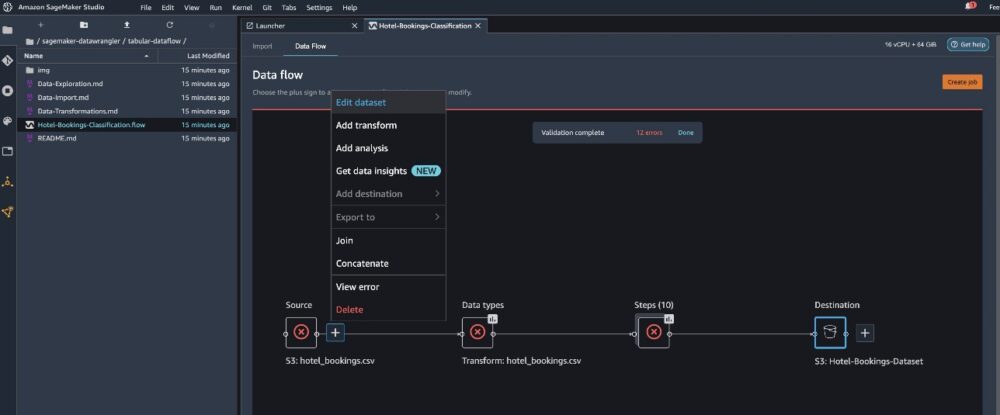

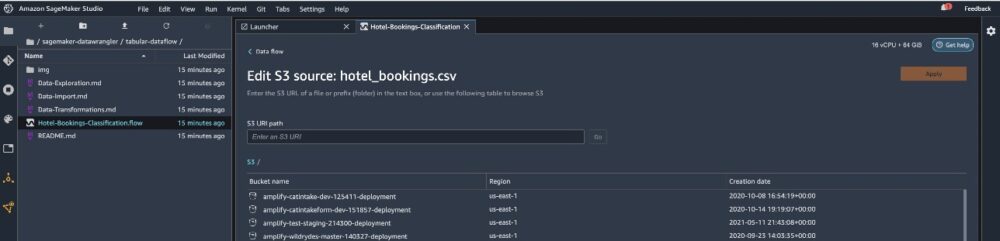

Als u de tijdreeks of samengevoegde gegevensstroom gebruikt, wordt de stroom onder een andere naam weergegeven. Nadat de stroom is geïmporteerd, zou u de volgende schermafbeelding moeten zien. Dit toont ons fouten omdat we ervoor moeten zorgen dat het stroombestand naar de juiste gegevensbron verwijst in Amazon eenvoudige opslagservice (Amazone S3).

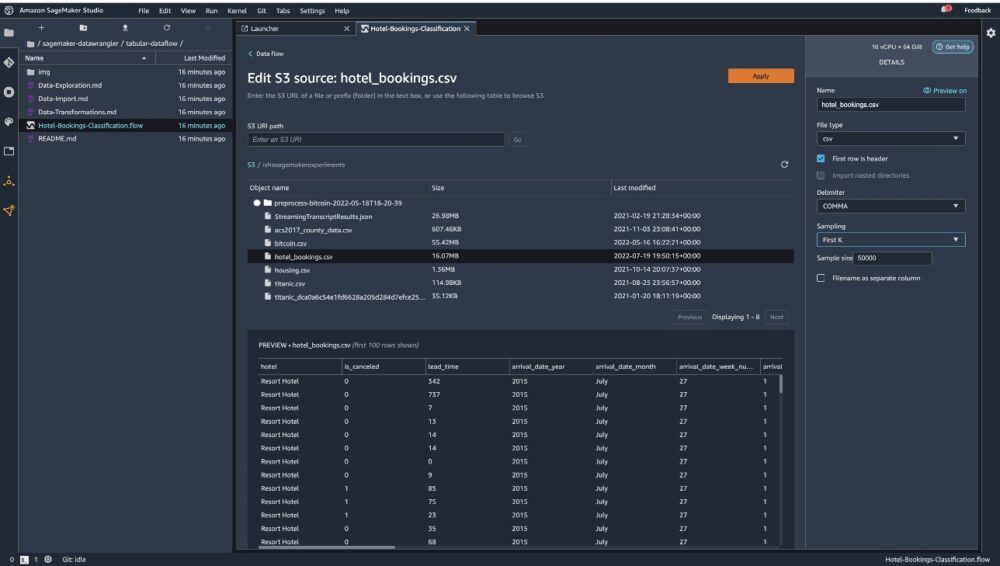

Kies Gegevensset bewerken om al je S3-emmers naar voren te halen. Kies vervolgens de dataset hotel_bookings.csv uit je S3-emmer om door de . te rennen gegevensstroom in tabelvorm.

Houd er rekening mee dat als u de samengevoegde gegevensstroom, moet u mogelijk meerdere datasets importeren in Data Wrangler

Zorg ervoor dat in het rechterdeelvenster: KOMMA wordt gekozen als scheidingsteken en monsterneming is ingesteld op Eerste K. Onze dataset is klein genoeg om Data Wrangler-transformaties op de volledige dataset uit te voeren, maar we wilden benadrukken hoe je de dataset kunt importeren. Als je een grote dataset hebt, overweeg dan om steekproeven te gebruiken. Kiezen import om deze dataset in Data Wrangler te importeren.

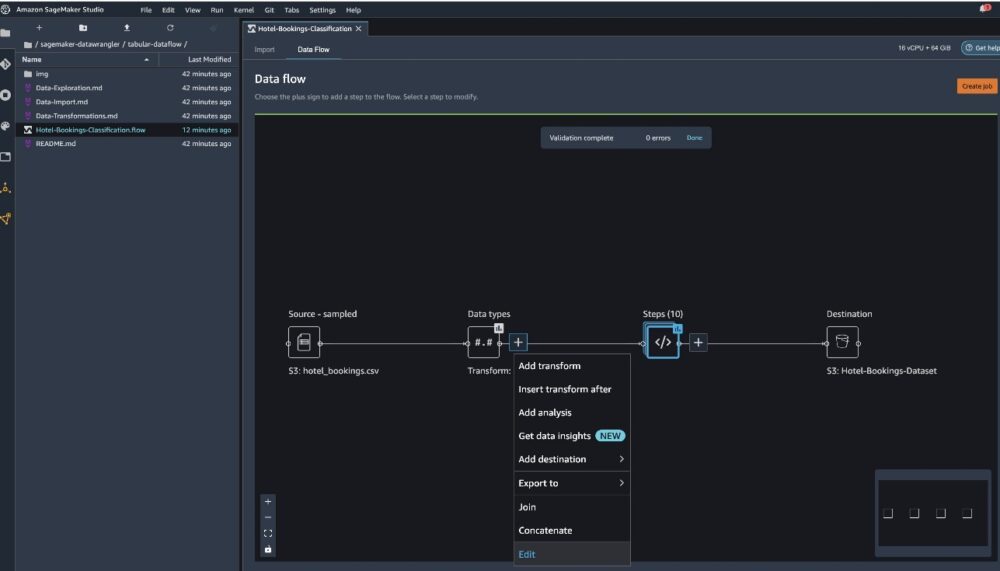

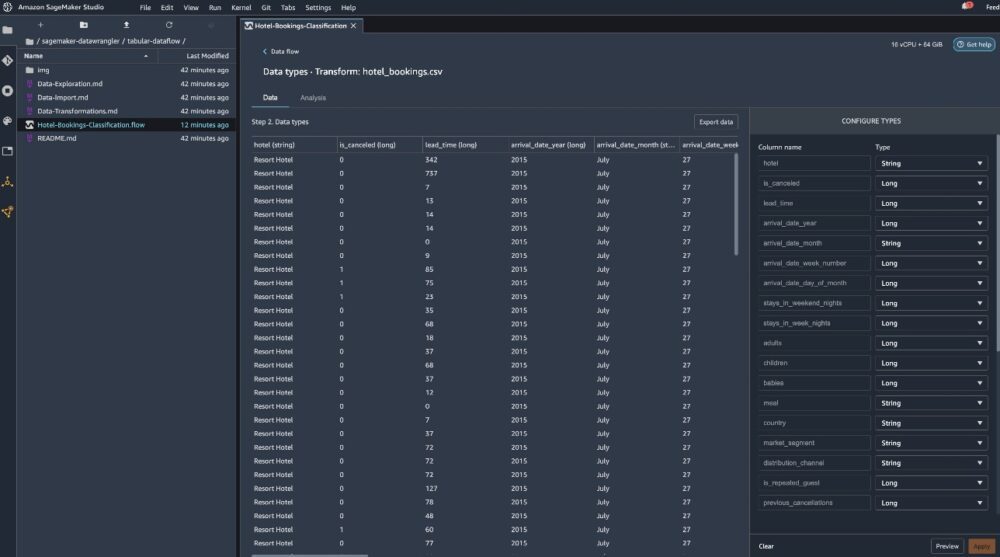

Nadat de dataset is geïmporteerd, valideert Data Wrangler automatisch de dataset en detecteert het de datatypes. U kunt zien dat de fouten zijn verdwenen omdat we naar de juiste dataset verwijzen. De stroomeditor toont nu twee blokken die laten zien dat de gegevens zijn geïmporteerd uit een bron en dat gegevenstypen worden herkend. U kunt indien nodig ook de gegevenstypen bewerken.

De volgende schermafbeelding toont onze gegevenstypen.

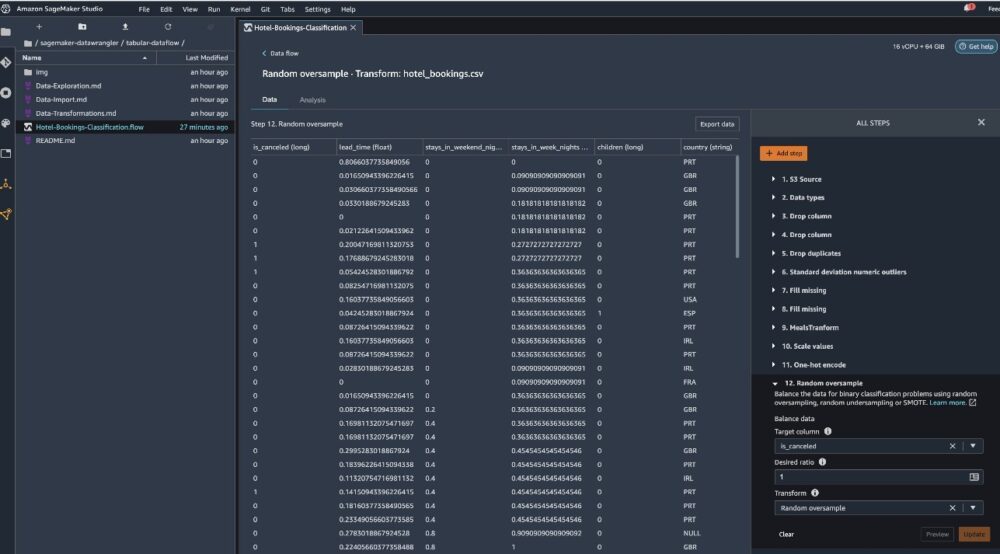

Laten we eens kijken naar enkele van de transformaties die zijn uitgevoerd als onderdeel van deze tabelvormige stroom. Als u de gebruikt tijdreeksen or toegetreden datastromen, bekijk enkele veelvoorkomende transformaties op de GitHub repo. We hebben enkele verkennende basisgegevensanalyses uitgevoerd met behulp van rapporten met gegevensinzichten die de doellekkage en collineariteit in de gegevensset bestudeerden, tabeloverzichtsanalyses en snelle modelleringscapaciteit. Verken de stappen op de GitHub repo.

Nu laten we kolommen vallen op basis van de aanbevelingen van het Data Insights and Quality Report.

- Voor doellekkage, drop reserveringsstatus.

- Voor overbodige kolommen, drop dagen_in_wachtlijst, hotel, gereserveerd_kamertype, aankomstdatum_maand, reserveringsstatus_datum, baby's, en aankomstdatum_dag_van de maand.

- Op basis van lineaire correlatieresultaten, kolommen laten vallen aankomstdatum_week_nummer en aankomstdatum_jaar omdat de correlatiewaarden voor deze functie(kolom)paren groter zijn dan de aanbevolen drempel van 0.90.

- Op basis van niet-lineaire correlatieresultaten, daling reserveringsstatus. Deze kolom was al gemarkeerd om te worden verwijderd op basis van de doellekanalyse.

- Numerieke waarden verwerken (min-max schaling) voor lead_time, stay_in_weekend_nights, stay_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, en vereiste_auto_parkeerplaatsen.

- One-hot codeer categorische variabelen zoals maaltijd, is_herhaalde_gast, marktsegment, toegewezen_kamer_type, deposit_type, en klant type.

- Breng de doelvariabele in evenwicht Willekeurige oversample voor klassenonevenwichtigheid. Gebruik de snelle modelleringsmogelijkheid om uitbijters en ontbrekende waarden te verwerken.

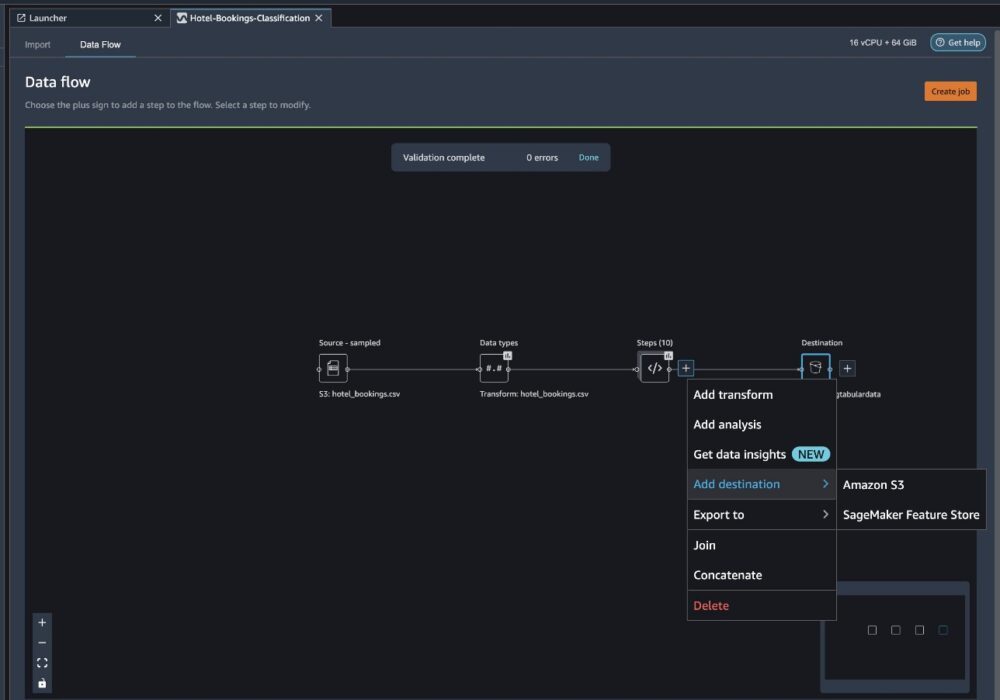

Exporteren naar Amazon S3

Nu hebben we de verschillende transformaties doorlopen en zijn we klaar om de gegevens naar Amazon S3 te exporteren. Met deze optie wordt een SageMaker-verwerkingstaak gemaakt, die de Data Wrangler-verwerkingsstroom uitvoert en de resulterende gegevensset opslaat in een opgegeven S3-bucket. Volg de volgende stappen om de export naar Amazon S3 in te stellen:

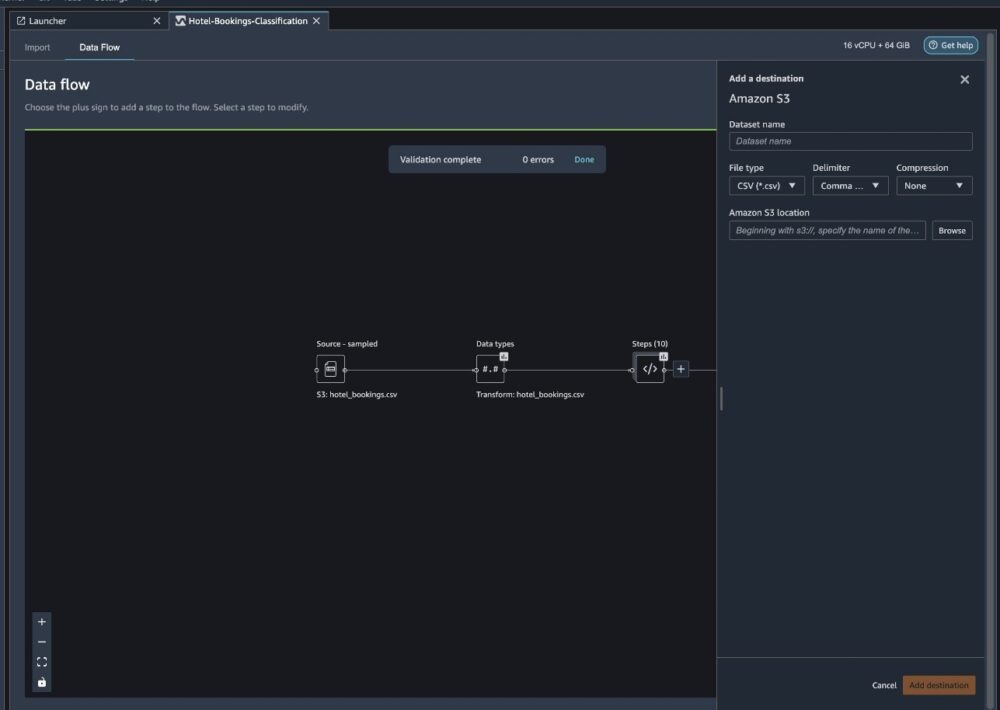

Kies het plusteken naast een verzameling transformatie-elementen en kies Bestemming toevoegendan Amazon S3.

- Voor Naam dataset, voer bijvoorbeeld een naam in voor de nieuwe dataset

NYC_export. - Voor Bestandstype, kiezen CSV.

- Voor Delimiter, kiezen komma.

- Voor Samendrukking, kiezen Geen.

- Voor Amazon S3-locatie, gebruik dezelfde bucketnaam die we eerder hebben gemaakt.

- Kies Bestemming toevoegen.

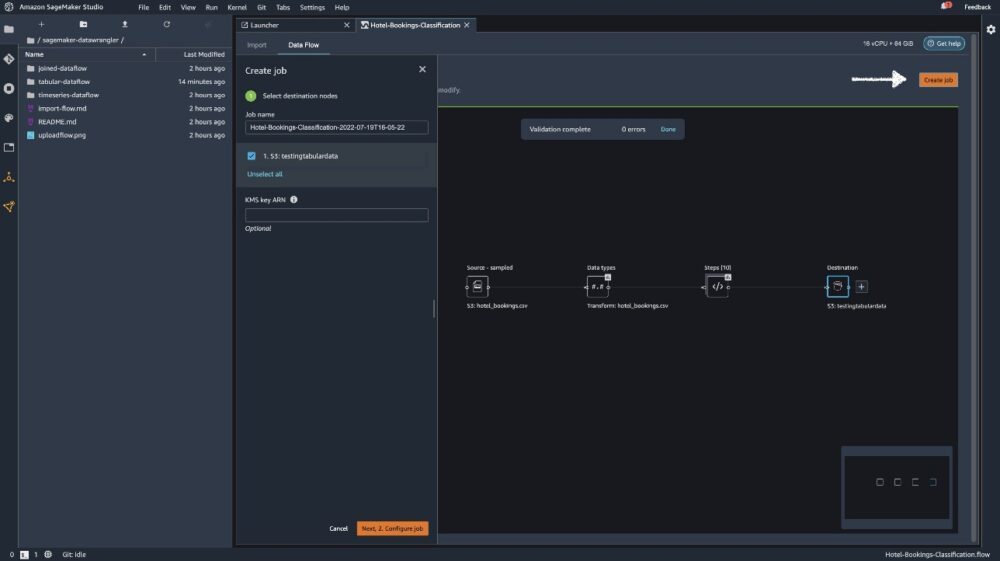

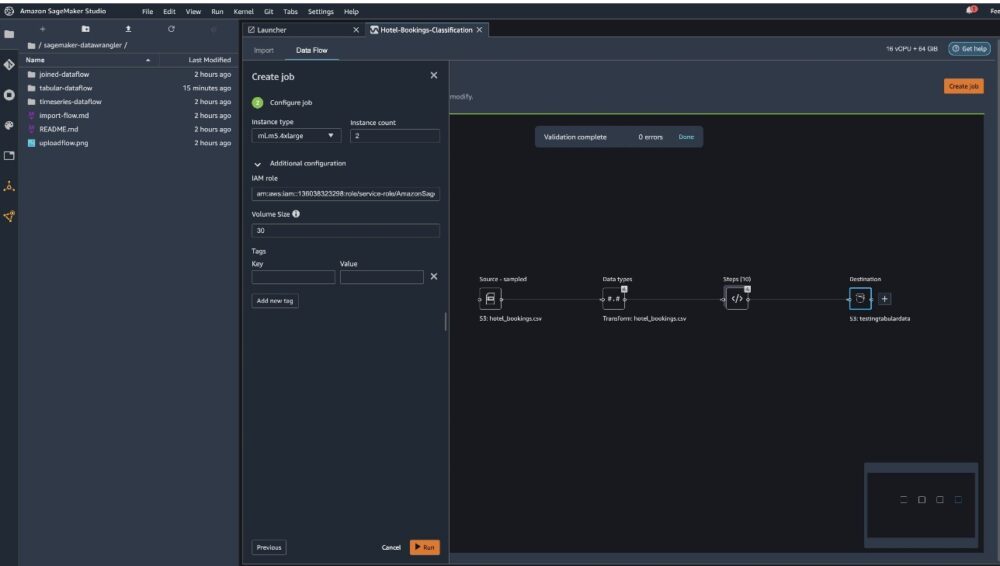

Kies Baan creëren.

Voor Taaknaam, voer een naam in of behoud de automatisch gegenereerde optie en kies bestemming. We hebben maar één bestemming, S3:testingtabulardata, maar u hebt mogelijk meerdere bestemmingen uit verschillende stappen in uw workflow. Verlaat de KMS-sleutel ARN veld leeg en kies Volgende.

Nu moet u de rekencapaciteit voor een taak configureren. U kunt alle standaardwaarden voor dit voorbeeld behouden.

- Voor Instantietype, gebruik ml.m5.4xlarge.

- Voor Aantal exemplaren, gebruik 2.

- Je kunt verkennen Aanvullende configuratie, maar behoud de standaardinstellingen.

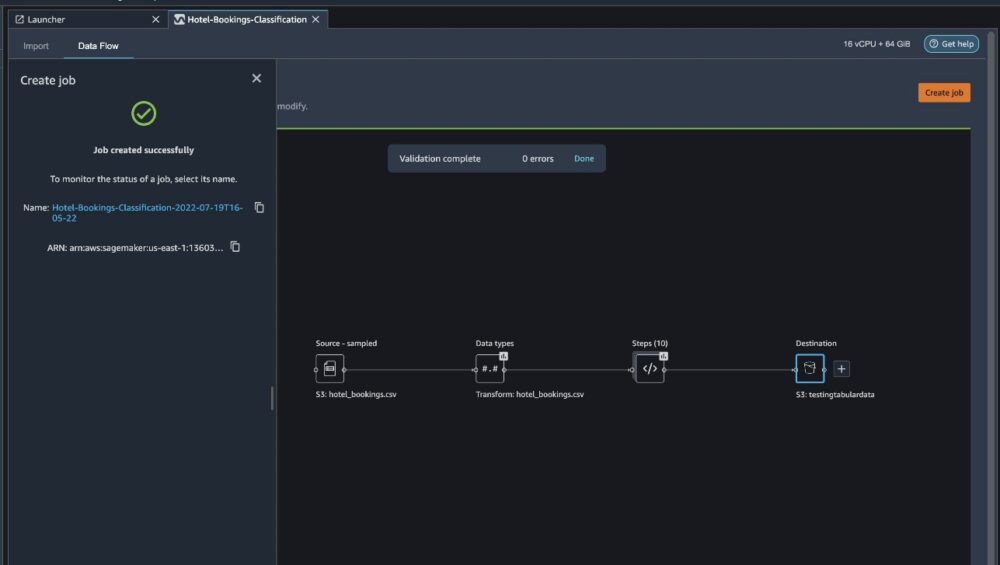

- Kies lopen.

Nu is uw taak begonnen en duurt het enige tijd om 6 GB aan gegevens te verwerken volgens onze Data Wrangler-verwerkingsstroom. De kosten voor deze klus bedragen ongeveer $2 USD, omdat ml.m5.4xlarge $0.922 USD per uur kost en we er twee gebruiken.

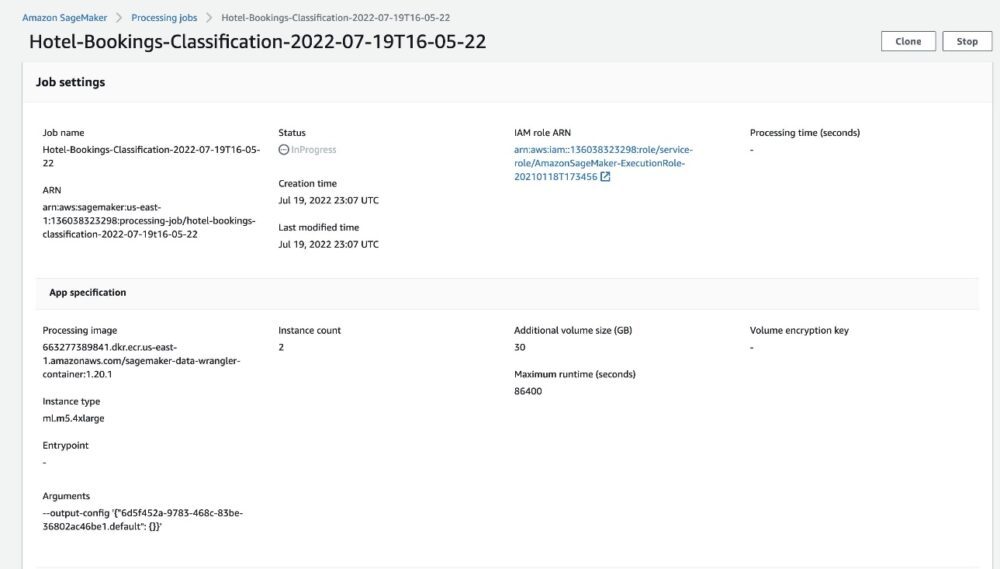

Als u de taaknaam kiest, wordt u doorgestuurd naar een nieuw venster met de taakdetails.

Op de pagina met taakdetails kunt u alle parameters van de vorige stappen zien.

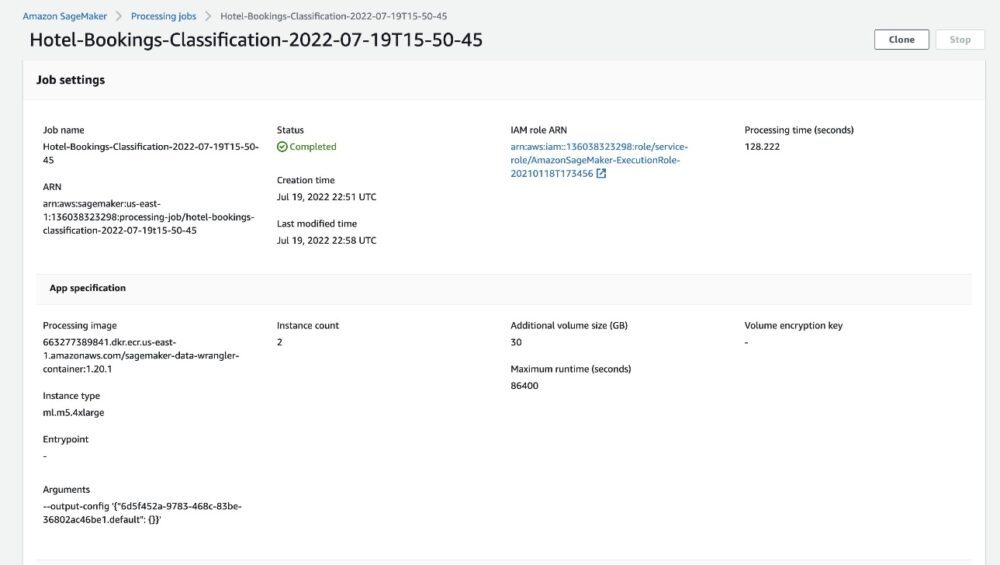

Wanneer de taakstatus verandert in Voltooid, kunt u ook de Verwerkingstijd (seconden) waarde. Deze verwerkingstaak duurt ongeveer 5-10 minuten om te voltooien.

Wanneer de taak is voltooid, zijn de trein- en testuitvoerbestanden beschikbaar in de bijbehorende S3-uitvoermappen. U kunt de uitvoerlocatie vinden in de configuraties van de verwerkingstaak.

Nadat de Data Wrangler-verwerkingstaak is voltooid, kunnen we de resultaten controleren die zijn opgeslagen in onze S3-bucket. Vergeet niet om de . te updaten job_name variabele met uw taaknaam.

U kunt deze geëxporteerde gegevens nu gebruiken voor het uitvoeren van ML-modellen.

Opruimen

Uw S3-buckets verwijderen en uw Data Wrangler-stroom om de onderliggende bronnen te verwijderen en ongewenste kosten te voorkomen nadat u het experiment hebt voltooid.

Conclusie

In dit bericht hebben we laten zien hoe u de vooraf gebouwde gegevensstroom in tabelvorm in Data Wrangler kunt importeren, deze kunt aansluiten op onze dataset en de resultaten kunt exporteren naar Amazon S3. Als uw gebruiksscenario's vereisen dat u tijdreeksgegevens manipuleert of meerdere gegevenssets samenvoegt, kunt u de andere vooraf gebouwde voorbeeldstromen in de GitHub repo.

Nadat u een vooraf gebouwde workflow voor gegevensvoorbereiding hebt geïmporteerd, kunt u deze integreren met Amazon SageMaker Processing, Amazon SageMaker-pijpleidingen en Amazon SageMaker Feature Store om de taak van het verwerken, delen en opslaan van ML-trainingsgegevens te vereenvoudigen. U kunt deze voorbeeldgegevensstroom ook exporteren naar een Python-script en een aangepaste ML-gegevensvoorbereidingspijplijn maken, waardoor uw releasesnelheid wordt versneld.

We raden u aan om onze GitHub-repository om hands-on te oefenen en nieuwe manieren te vinden om de nauwkeurigheid van het model te verbeteren! Ga voor meer informatie over SageMaker naar de: Amazon SageMaker-ontwikkelaarsgids.

Over de auteurs

Ischa Dua is een Senior Solutions Architect gevestigd in de San Francisco Bay Area. Ze helpt AWS Enterprise-klanten groeien door hun doelen en uitdagingen te begrijpen, en begeleidt hen bij het ontwerpen van hun applicaties op een cloud-native manier, terwijl ze ervoor zorgen dat ze veerkrachtig en schaalbaar zijn. Ze is gepassioneerd door machine learning-technologieën en ecologische duurzaamheid.

Ischa Dua is een Senior Solutions Architect gevestigd in de San Francisco Bay Area. Ze helpt AWS Enterprise-klanten groeien door hun doelen en uitdagingen te begrijpen, en begeleidt hen bij het ontwerpen van hun applicaties op een cloud-native manier, terwijl ze ervoor zorgen dat ze veerkrachtig en schaalbaar zijn. Ze is gepassioneerd door machine learning-technologieën en ecologische duurzaamheid.

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- Amazon Sage Maker

- Amazon SageMaker-gegevens Wrangler

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- AWS-machine learning

- blockchain

- blockchain conferentie ai

- vindingrijk

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- diepgaand leren

- google ai

- machine learning

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- syntaxis

- zephyrnet